谷歌與學術界聯手,研究突破多智能體合作瓶頸的新算法

在人類的合作中,我們可能會遇到囚徒困境(Social Dilemmas)、悲劇的共有(Tragedy of the Commons)、公平分配問題(Public Goods Game)、獵人與收集者困境(Stag Hunt Game)、和合作網絡(Networked Cooperation)等諸多社會性合作困境,比如兩個人必須決定是否與對方合作(相互協力)或是背叛(選擇個人利益)。合作可以帶來最大的集體收益,但個體背叛可能會導致更高的個人收益。這種情況下,我們需要在短期的個人利益和長期的集體利益之間做出平衡。在群體合作的情境,我們必須決定是否向公共資源池中投入資源。投入資源的人可能會從公共資源池中獲得收益,但也存在不投入卻享受收益的可能性。同樣,智能體作為智能代理在系統里進行合作時也會遇到同樣的問題,比如智能體通過網絡相互連接,合作的利益取決于網絡中的其他智能體的行為。這種設置中的智能體需要在本地合作和全局合作之間做出選擇。

研究者們已經意識到,在多智能體系統中實現合作不僅能提升系統的整體性能,還可以提高智能體在復雜環境中的適應能力。盡管如此,如何設計出能夠促使這些獨立智能體自愿合作的機制仍然是一個未解難題。

10 月 24日,來自以谷歌為首的聯合研究團隊發表他們的最新研究《Multi-agent cooperation through learning-aware policy gradients》,他們提出通過學習感知策略梯度的方法來實現多智能體合作。這一研究的主要問題是:在多智能體學習中,如何促使自利、獨立的智能體實現合作?傳統的獨立智能體優化自身目標的方式在一般和博弈中往往表現不佳,難以實現合作。為此研究團隊提出了一種新的策略梯度算法,通過考慮其他智能體的學習動態,來實現智能體之間的合作。

他們的主要貢獻包括:

- 提出了一種新的無偏、高效的策略梯度算法,能夠在多智能體學習中實現合作。

- 利用序列模型,將智能體的行為基于長觀測歷史進行條件化,從而促進智能體之間的合作。

- 在標準的社會困境中驗證了該算法的有效性,展示了其在復雜環境中的出色表現。

- 提出了一個新的理論框架,解釋了在何種情況下和如何在自利的學習感知智能體之間產生合作。

研究團隊由來自多個知名機構的學者組成,包括Google Paradigms of Intelligence Team、Mila - Quebec AI Institute、Université de Montréal、McGill University以及CIFAR。Alexander Meulemans和Seijin Kobayashi在這項研究中做出了相等的貢獻。團隊成員背景深厚,研究領域涵蓋人工智能、機器學習和多智能體系統等多個方面,體現了跨學科和跨國合作的特點。通過這種多元化的合作,研究團隊成功地提出了能夠實現多智能體合作的創新算法,對推動多智能體學習領域的發展具有重要意義。

多智能體學習中的合作挑戰

在多智能體系統中,每個智能體都致力于優化自己的回報,這通常導致個體之間缺乏合作,產生次優結果。這種現象在博弈論中被稱為社會困境,其中最著名的例子就是囚徒困境。在這種情況下,雖然合作能夠帶來最優的集體回報,但自利的個體由于擔心對方的背叛而傾向于選擇不合作,從而導致雙方都處于次優狀態。

自利個體的合作難題在很多現實場景中得到體現。例如,自主駕駛車輛在共享道路時需要互相合作以避免交通事故,然而每輛車都可能選擇最優的個人策略而忽視整體安全。類似地在網絡安全中,不同系統需要共享信息以防御共同的威脅,但由于擔心信息泄露,各系統往往選擇不合作,導致安全隱患加大。

現有的多智能體學習研究在應對這一挑戰方面取得了一些進展。傳統的方法主要集中在通過設計激勵機制和約束條件來促進合作。然而這些方法往往依賴于預先設定的規則和模型,對于復雜動態的實際環境表現出局限性。近年來,學習感知策略逐漸成為解決多智能體合作問題的一個重要方向。

一些研究提出了學習感知算法,通過讓智能體了解并預測其他智能體的學習動態,從而調整自己的策略來促進合作。這些方法在某些任務中展示了令人鼓舞的效果,證明了學習感知在多智能體合作中的潛力。然而這些方法大多依賴于高階導數的計算,計算復雜度較高,且在面對不確定和噪聲較大的環境時,表現不夠穩定。

盡管取得了一些進展,現有方法在多個方面仍然存在不足。例如,許多方法依賴于智能體之間的信息共享,這在分布式系統或隱私敏感場景中難以實現。此外這些方法在處理大規模、多樣化的智能體群體時,計算效率和穩定性尚待提高。因此,提出一種高效、穩定且適用于復雜環境的多智能體合作學習算法,依然是一個亟待解決的重要問題。

背景和問題設置

在多智能體學習中,智能體通常在部分可觀察隨機游戲(POSGs)的框架內進行交互。POSGs是一種由Kuhn于1953年提出的模型,定義為一個包含多個智能體的系統,其中每個智能體只能獲得部分狀態信息。POSGs的重要性在于它能夠模擬現實世界中的復雜場景,如自動駕駛、機器人協作和分布式控制系統。每個智能體在POSGs中都面臨不完全信息的挑戰,這增加了決策和學習的難度。

在一般和博弈中,智能體不僅要最大化自己的回報,還要考慮其他智能體的策略。這個過程中面臨兩個主要難題:非靜態環境和均衡選擇。非靜態環境意味著其他智能體也在同時學習和適應,這使得環境從單個智能體的視角來看是不斷變化的。均衡選擇問題則源于多個納什均衡的存在,尤其在復雜的POSGs中,某些均衡可能非常次優,導致整體表現不佳。例如,在無限重復的囚徒困境中,完全背叛和合作策略都可以成為納什均衡,但前者會導致較低的整體回報。

為了應對這些挑戰,引入同伴學習意識成為一種有效的方法。學習意識的關鍵在于智能體能夠理解和預測其他智能體的學習動態,并基于這種理解來調整自己的策略。這不僅能幫助智能體在非靜態環境中做出更好的決策,還能促使智能體在多個均衡中選擇更優的均衡,從而提高整體合作水平。

通過引入同伴學習意識,智能體不僅能在復雜環境中更好地適應,還能在一般和博弈中實現有效合作。這一方法的核心在于智能體通過建模和學習其他智能體的行為動態,從而在決策過程中充分考慮他人的反應和變化,最終實現自利智能體之間的合作。研究表明,這種方法在提高多智能體系統的整體表現方面具有顯著優勢。

同伴塑造與序列模型

在多智能體系統中,如何塑造其他智能體的學習行為以實現合作是一個重要的研究課題。研究團隊提出了一種同伴塑造的元游戲,通過在多智能體部分可觀察馬爾可夫決策過程(POMDP)中增加一個元層次變量,來表示每個智能體使用的學習算法。這個元游戲的目標是讓一個元智能體通過學習感知來塑造天真的共同玩家的行為,從而實現合作。這一元游戲被形式化為單智能體POMDP,元狀態包括所有共同玩家的策略參數和智能體自身的參數,元環境動態則表示共同玩家的固定學習規則。

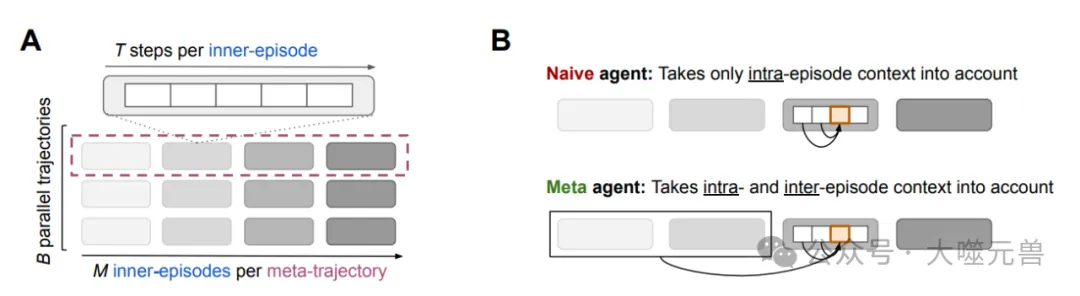

圖1|A.經驗數據術語。內部情節包括(內部)游戲的??步驟,在代理人之間并行進行??次,形成一批內部情節。一個給定的內部情節序列形成了一個元軌跡,因此包括內部游戲的步驟。??元軌跡的集合形成了一個元情節。B.在游戲過程中,一個天真的代理人只考慮當前的情節背景來做出決策。相比之下,元代理會考慮完整的長上下文。觀看多集游戲會賦予元代理學習意識。

為了實現這一目標,研究團隊提出了將內層和元策略結合在一個長上下文策略中的方法。通過基于多個內層游戲的長觀測歷史來決定動作,智能體能夠更好地理解和預測其他智能體的學習動態。具體來說,研究團隊定義了一種批量同伴塑造POMDP,包含多個并行軌跡的環境動態和批量長歷史觀測。這種設置允許智能體在多個內層游戲中觀察共同玩家的學習行為,并通過這種觀察調整自己的策略,以實現更優的合作。

批量同伴塑造POMDP的定義是關鍵。它包含多個并行運行的內層游戲,每個游戲都有自己的環境狀態和共同玩家策略參數。這些環境動態模擬了多個并行的環境,并在每個內層游戲邊界更新共同玩家的策略參數。初始狀態分布初始化了共同玩家的策略,并為第一個內層游戲批次初始化環境。然后通過一個長上下文策略,智能體可以在長時間范圍內基于批量長歷史觀測進行決策,從而更有效地塑造共同玩家的行為。

通過這種批量同伴塑造POMDP設置,作者提出了一種高效的策略梯度同伴塑造算法。這種算法能夠在不依賴高階導數的情況下,通過測量策略更新對批量內層游戲歷史分布的影響來估計策略梯度,從而實現多智能體系統中的合作。

COALA-PG算法的策略梯度

為了實現多智能體系統中的有效合作,研究團隊提出了COALA-PG (Co-agent Learning-Aware Policy Gradients) 算法。這是一種新的策略梯度算法,旨在通過考慮其他智能體的學習動態,來實現智能體之間的合作。

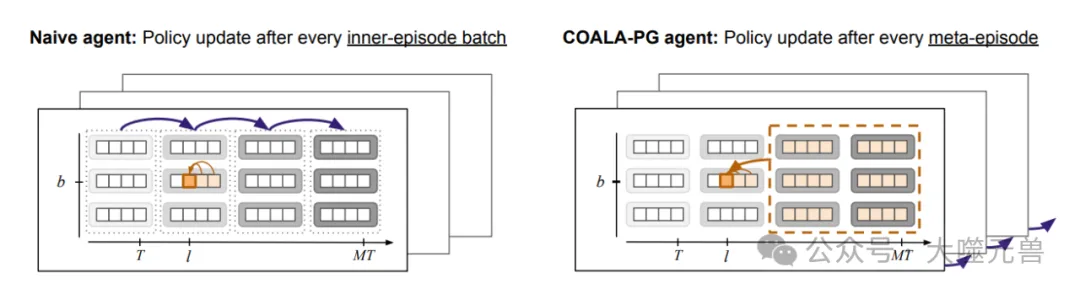

圖2|天真代理和元代理的策略更新和信用分配。一個天真的代理(左)只考慮事件內的上下文。COALA代理(右)考慮了批處理維度上的事件間上下文。對于策略更新,天真代理聚合內部批處理維度(虛線塊)上的策略梯度,并在事件邊界之間更新其策略。相比之下,COALA代理在元事件維度上以較低的頻率更新他們的策略。

COALA-PG的提出源自對多智能體學習中的核心挑戰的深入理解。傳統的策略梯度方法在處理多智能體系統時,往往忽略了其他智能體也在同時學習這一事實,導致環境對單個智能體而言是非靜態的。COALA-PG通過在策略更新中引入對其他智能體學習行為的建模和預測,克服了這一問題。

在與現有方法的比較中,COALA-PG展現了明顯的優勢。例如,LOLA-DICE是現有的一種方法,雖然它考慮了對手的學習動態,但需要計算高階導數,這增加了計算復雜度和不穩定性。相比之下,COALA-PG采用了一種無偏的梯度估計方法,不需要高階導數計算,因而更加高效和穩定。此外,COALA-PG能夠處理小批量的內層策略歷史,從而在多智能體系統中實現更加精確的策略優化。

COALA-PG在元強化學習中的優勢主要體現在以下幾個方面。

高效性:通過引入長上下文策略,COALA-PG能夠在大規模、多樣化的智能體群體中高效運行,顯著提高了策略更新的速度和準確性。

穩定性:由于采用無偏的梯度估計方法,COALA-PG在面對不確定和噪聲較大的環境時,表現出較高的穩定性,避免了高階導數方法中的數值不穩定問題。

適用性:COALA-PG能夠靈活地適用于各種復雜環境,包括標準的社會困境和需要時間擴展動作協調的環境,這在傳統方法中是難以實現的。

通過COALA-PG算法,研究團隊在實現多智能體合作方面取得了重要突破。該算法不僅克服了傳統方法的計算復雜度和不穩定性問題,還通過引入對其他智能體學習行為的建模,提高了策略更新的精度和效率。

學習意識在一般和博弈中的重要性

在多智能體系統中,學習意識指的是智能體能夠理解和預測其他智能體的學習動態,并基于這種理解調整自己的策略。這在解決一般和博弈中的合作問題時顯得尤為重要。研究團隊通過分析學習意識在重復囚徒困境中的表現,揭示了其促成合作的機制。

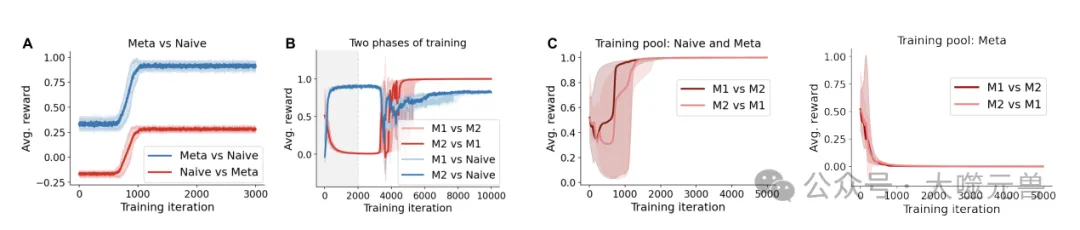

圖3|(A)具有學習意識的代理學會勒索天真的學習者,即使在用純叛逃策略初始化時也是如此。(B) 針對天真智能體(陰影區域期)制定的勒索策略在與另一個學習感知智能體(M1和M2)對抗時變成了合作策略。(C) 合作出現在天真和學習意識代理的混合訓練池中,但不僅僅出現在學習意識代理池中。陰影區域表示32個隨機種子的四分位數間距(第25至75分位數)。

重復囚徒困境中的合作現象

重復囚徒困境是一個經典的社會困境模型,用于研究自利智能體之間的合作問題。在這個游戲中,兩個玩家在每一輪選擇合作或背叛,累積的獎勵取決于雙方的選擇。若雙方都合作,獲得的回報最高;若一方背叛而另一方合作,背叛者獲益更多;若雙方都背叛,收益最低。在無限重復的囚徒困境中,盡管存在合作的納什均衡,但自利的個體往往難以穩定地達到這一狀態。

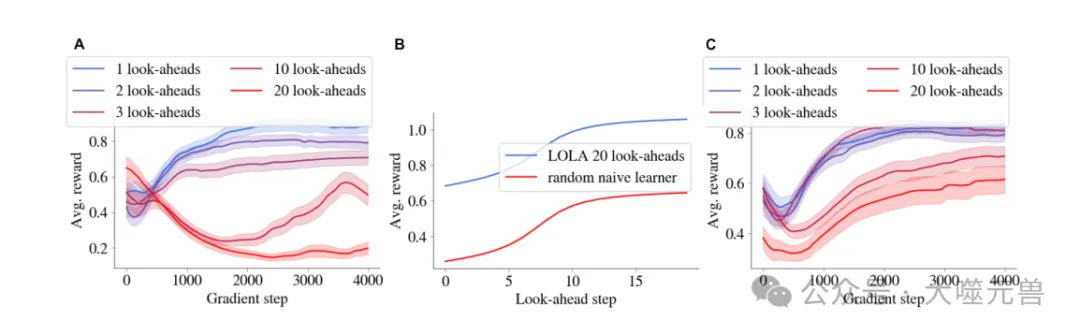

圖4|(A)由LOLA訓練的兩個代理在具有各種前瞻步驟的分析梯度的迭代囚徒困境中的性能(僅顯示了第一個代理的性能)。(B) 根據(a)訓練結束時的固定LOLA 20外觀策略訓練的隨機初始化幼稚學習者的表現。(C) 設置與(A)相同,但具有初始梯度???????????????(??, ?????)添加到LOLA更新中,帶有??超參數。陰影區域表示在64個種子上計算的標準誤差。

研究團隊通過實驗表明,學習感知智能體能夠在重復囚徒困境中逐漸發展出合作策略。這些智能體通過預測對手的學習行為,調整自己的策略,從而在長期博弈中實現互惠合作。

學習意識如何促成合作

研究發現,學習感知智能體通過兩種主要機制實現合作。首先,這些智能體能夠觀察到自己的行動如何影響對手的未來行為。這種觀察為智能體提供了從背叛轉向勒索的塑造梯度。其次,當兩個學習感知智能體相遇時,勒索策略會逐漸轉變為合作策略。這是因為在獨立學習的情況下,勒索策略會促使對手更多地合作。

研究發現,當學習感知智能體與天真學習者對戰時,前者會發展出勒索策略,迫使天真學習者進行不公平的合作。然而,當兩個學習感知智能體相遇時,他們會逐漸發展出合作策略,從而實現互惠合作。這一現象不僅在對手之間有效,即使在自我博弈(self-play)的情況下也能觀察到。

解釋LOLA中的合作機制

LOLA(Learning with Opponent-Learning Awareness)是學習感知領域的先驅工作,研究團隊通過COALA-PG算法提供了新的解釋。LOLA算法通過預估對手的參數更新來計算總梯度,從而對天真學習者進行策略塑造。研究團隊提出了一種不需要高階導數的新型LOLA梯度估計器,能夠在不依賴高階導數的情況下,通過測量策略更新對批量內層游戲歷史分布的影響來估計策略梯度,從而實現多智能體系統中的合作。

通過COALA-PG算法的分析,研究表明,LOLA結合了影響對手未來行為的觀察和與其他勒索智能體對戰的機制,從而實現了學習感知智能體之間的合作。這一發現不僅解釋了LOLA算法中的合作機制,還展示了在復雜環境中實現多智能體合作的新途徑。

實驗分析

為了驗證COALA-PG算法的有效性,研究團隊在多個實驗中進行了測試。實驗主要集中在兩個方面:重復囚徒困境和CleanUp游戲。

COALA-PG在重復囚徒困境中的表現

在重復囚徒困境實驗中,COALA-PG算法展現了其在促成合作方面的卓越表現。實驗結果表明,當COALA-PG訓練的智能體與天真智能體對戰時,COALA-PG智能體通過塑造對手的行為,使其趨向于合作,從而獲得了顯著更高的回報。這些智能體能夠成功地從最初的背叛逐步引導對手進入合作狀態,并在整個博弈過程中保持合作。這種行為不僅驗證了COALA-PG算法在促進多智能體合作中的有效性,還展示了其在處理復雜的博弈環境中的優勢。

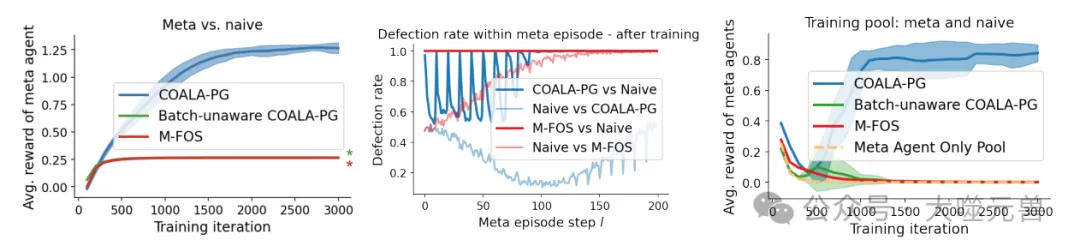

圖5|COALA-PG訓練的特工玩迭代囚徒困境。左:當僅針對天真特工進行訓練時,COALA PG訓練的特工會勒索后者,并獲得比其他基線特工高得多的獎勵。星號(★)表示在中心點對應顏色的重疊曲線:在分析一個元事件中代理的行為時,我們觀察到COALA PG訓練的代理塑造了天真的合作伙伴,導致開始時的低叛逃率,然后在最后被利用。另一方面,M-FOS從一開始就存在缺陷,獲得的回報較低,因此未能正確優化成形問題。不知道批次的COALA-PG與M-FOS的性能相同,因此被省略。當訓練一組元代理對抗幼稚和其他元代理的混合體時,元代理與其他元代理對抗的平均性能。這些用COALA-PG訓練的特工在相互對抗時會合作,但在用基線方法訓練時卻無法合作。當從池中刪除幼稚代理時,元代理也無法合作,如第3節所預測的那樣。陰影區域表示在5個種子上計算的標準偏差。

在CleanUp游戲中的表現

除了在重復囚徒困境中的優異表現外,COALA-PG算法在CleanUp游戲中也顯示出了顯著的優勢。CleanUp游戲是一個模擬公共資源悲劇的復雜社會困境,玩家通過清理河流以減少污染,從而增加蘋果的生成率。COALA-PG訓練的智能體在游戲中不僅能夠有效地平衡清理和收獲,還能夠通過塑造對手的行為,使其減少不必要的干擾(如電擊對手)和增加清理工作,從而整體上提高蘋果的生成率和最終回報。

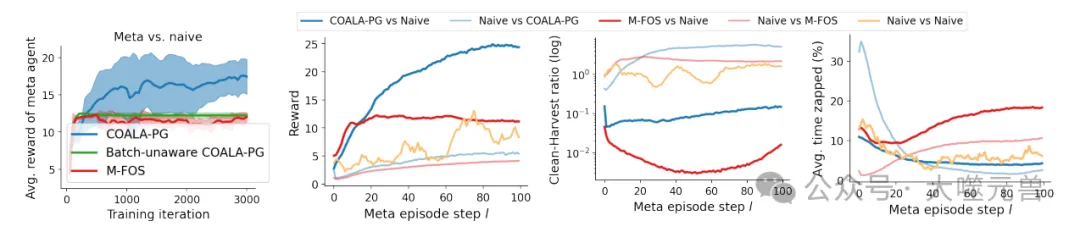

圖6|COALA-PG針對幼稚代理訓練的代理僅在CleanUp中成功塑造了它們。左:與基線相比,COALA PG訓練的特工可以更好地塑造天真的對手,獲得更高的回報。中左和中右和右:在訓練后分析單個元事件中的行為表明,COALA的表現優于基線,并塑造了天真的代理,(i)在整個事件中獲得了更高的整體獎勵,(ii)表現出更高的清潔收獲率,以及(iii)被攻擊的頻率更低。陰影區域表示在5個種子上計算的標準偏差。

實驗結果顯示,COALA-PG智能體在與天真智能體混合的環境中能夠顯著提高合作水平,并在對抗其他學習感知智能體時維持高效合作。通過與基線方法的比較,研究發現COALA-PG算法在處理復雜環境和動態對手方面表現優越。

細化的行為分析與對比

為了深入理解COALA-PG算法的行為,研究團隊對實驗中的智能體行為進行了細化分析。分析結果表明,COALA-PG訓練的智能體在元回合中能夠成功地塑造天真對手,使其在清理和收獲之間找到更好的平衡,從而整體上降低了污染水平并提高了蘋果生成率。此外,COALA-PG智能體在與其他學習感知智能體的對戰中,也能夠通過減少電擊行為和增加清理工作,實現高效合作。

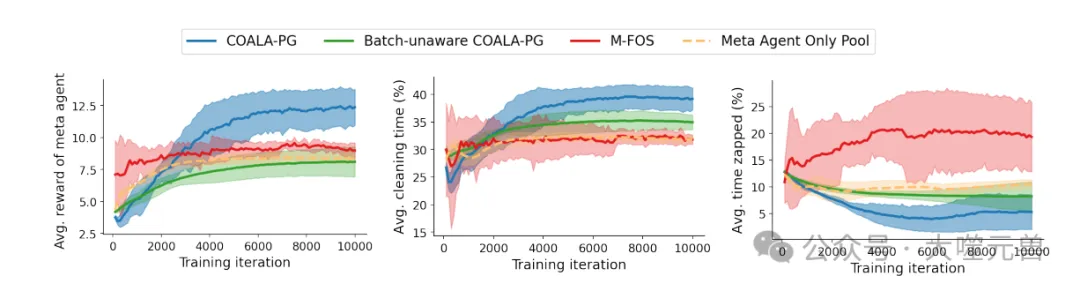

圖7|使用COALA-PG訓練的代理,針對天真代理和其他元代理的混合體,學習在CleanUp lite中合作。左:經過COALA PG訓練的特工獲得的獎勵高于基線特工。中右圖:COALA-PG通過更多的清潔和更低的去除率降低了污染,從而提高了蘋果產量。陰影區域表示在5個種子上計算的標準偏差。

實驗發現COALA-PG智能體通過引導天真對手減少電擊行為,使整個博弈過程中的干擾減少,收獲效率提高。同時COALA-PG智能體自身也參與清理工作,進一步降低污染水平,從而為所有智能體創造了一個更有利的博弈環境。這種互惠合作的行為模式,不僅驗證了COALA-PG算法的有效性,還為多智能體合作提供了新的研究視角。

結論

研究團隊通過深入研究和實驗分析,展示了學習意識在多智能體合作中的關鍵作用。在多智能體系統中,自利個體之間的合作一直是一個挑戰,而引入學習意識,即智能體能夠理解和預測其他智能體的學習動態,成為解決這一問題的重要途徑。

通過學習意識,智能體不僅能夠在復雜的博弈環境中調整自己的策略,還能有效地塑造其他智能體的行為,從而在多個均衡中選擇最優的合作策略。研究團隊提出的COALA-PG(Co-agent Learning-Aware Policy Gradients)算法,正是基于這一理念,通過無偏的梯度估計方法,不需要高階導數計算,展現了顯著的性能優勢。

COALA-PG方法的創新與優勢

高效性和穩定性:COALA-PG算法通過引入長上下文策略,能夠在大規模、多樣化的智能體群體中高效運行,顯著提高了策略更新的速度和準確性。同時,由于采用無偏的梯度估計方法,COALA-PG在面對不確定和噪聲較大的環境時,表現出較高的穩定性。

適用性:COALA-PG能夠靈活地適用于各種復雜環境,包括標準的社會困境和需要時間擴展動作協調的環境,這在傳統方法中是難以實現的。

合作機制:實驗結果顯示,COALA-PG在模擬的重復囚徒困境和CleanUp游戲中,均能實現高效合作。這表明COALA-PG在實際應用中具有廣泛的前景。

未來的研究方向和應用前景

進一步優化算法:研究可以繼續優化COALA-PG算法,提高其在更大規模和更復雜環境中的性能。

擴展應用領域:COALA-PG算法在自動駕駛、分布式控制系統和網絡安全等多個領域都有潛在應用,可以進一步探索其實際應用場景。

跨學科合作:通過與其他領域的合作,如心理學和行為科學,進一步理解和模擬多智能體系統中的合作機制。

總的來說,研究團隊通過提出和驗證COALA-PG算法,為多智能體合作研究提供了新的方向和可能性。學習意識在多智能體合作中的關鍵作用不可忽視,未來研究將繼續推動這一領域的發展,探索更多創新應用。(END)

參考資料:https://arxiv.org/pdf/2410.18636

本文轉載自??大噬元獸??,作者: FlerkenS ????