Meta AI發(fā)布全新量化版本Llama 3.2(1B & 3B):推理速度提升2-4倍,模型大小減少56% 原創(chuàng)

01 概述

在人工智能的世界里,大型語(yǔ)言模型(LLMs)的飛速發(fā)展無(wú)疑為各行各業(yè)帶來(lái)了翻天覆地的變化。然而,這些模型的龐大身軀和對(duì)計(jì)算資源的渴求也給實(shí)際應(yīng)用帶來(lái)了不小的挑戰(zhàn)。高昂的能源成本、漫長(zhǎng)的訓(xùn)練周期以及對(duì)昂貴硬件的需求,都成了阻礙許多組織和研究者利用AI能力的門檻。這些挑戰(zhàn)不僅對(duì)環(huán)境造成了影響,也在科技巨頭與小型實(shí)體之間劃出了一道鴻溝。

02 Meta AI的量化Llama 3.2模型(1B和3B)

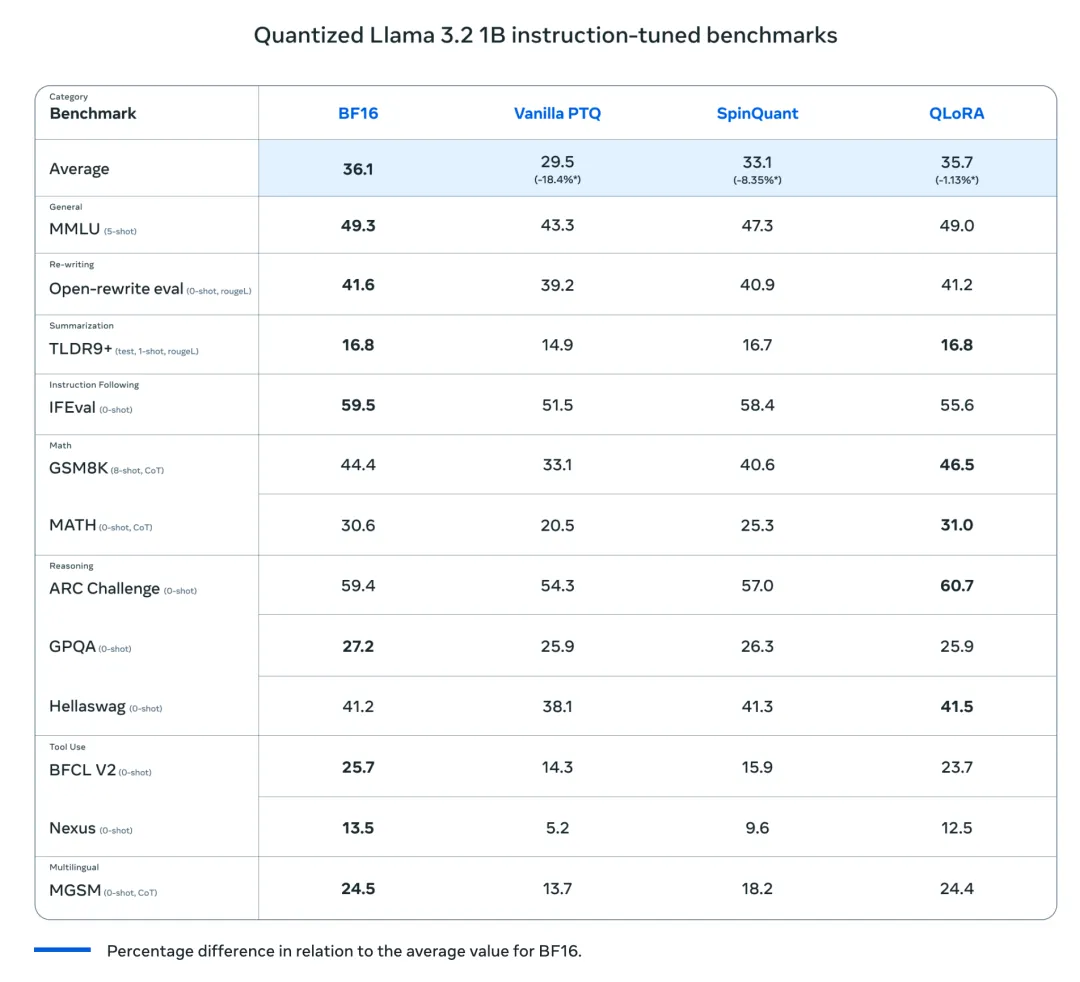

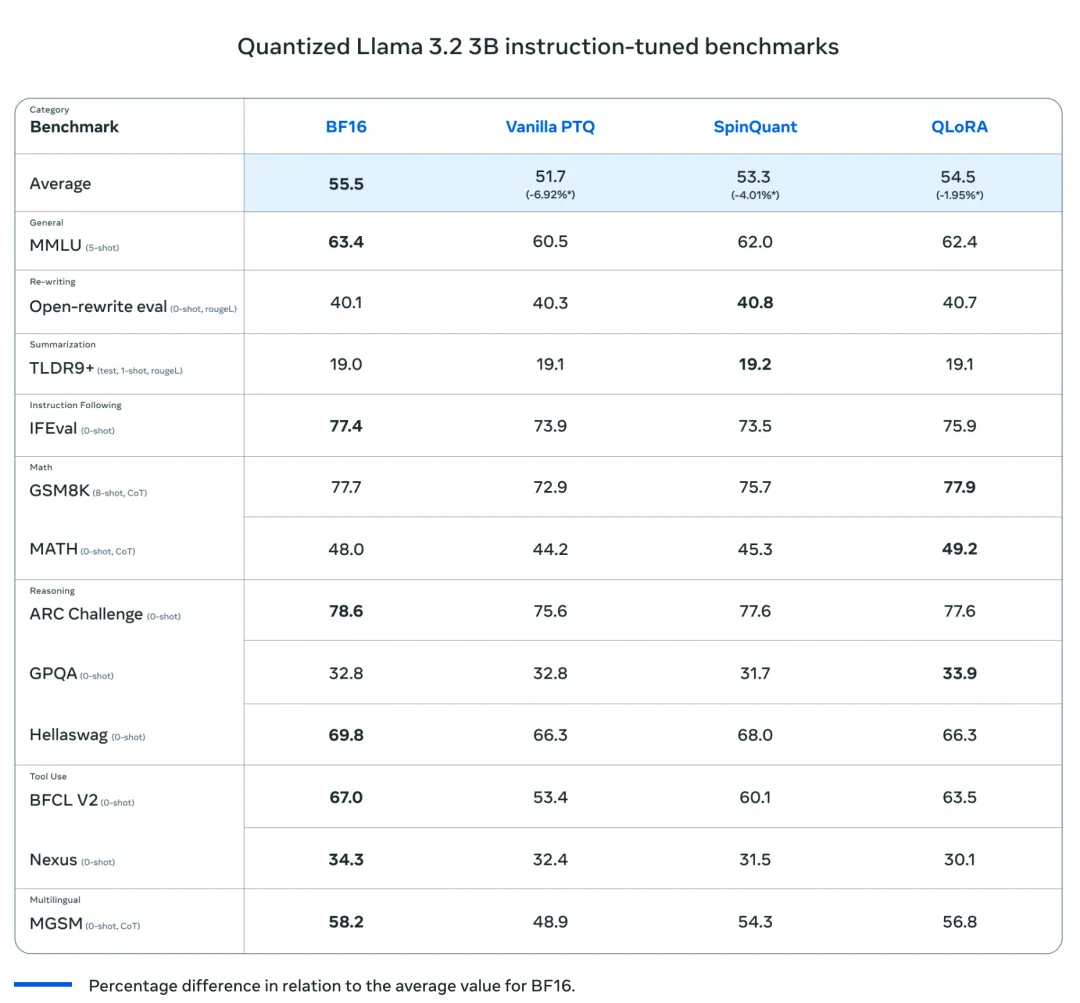

最近,Meta AI發(fā)布了量化版本的Llama 3.2模型(1B和3B),這是將尖端AI技術(shù)普及給更廣泛用戶群體的重要一步。這些模型是首批輕量級(jí)的量化Llama模型,它們的體積小到足以在許多流行的移動(dòng)設(shè)備上運(yùn)行。研究團(tuán)隊(duì)采用了兩種不同的技術(shù)來(lái)量化這些模型:一種是以準(zhǔn)確性為優(yōu)先的量化感知訓(xùn)練(QAT)與LoRA適配器,另一種是專注于便攜性的先進(jìn)后訓(xùn)練量化方法SpinQuant。這兩個(gè)版本都可以在這次發(fā)布中下載。這些模型代表了原始Llama 3系列的量化版本,旨在優(yōu)化計(jì)算效率,并顯著減少運(yùn)行它們的硬件足跡。通過(guò)這樣做,Meta AI旨在在減少部署所需的計(jì)算資源的同時(shí),增強(qiáng)大型模型的性能。這使得研究人員和企業(yè)能夠在不需要專門的、昂貴的基礎(chǔ)設(shè)施的情況下利用強(qiáng)大的AI模型,從而實(shí)現(xiàn)尖端AI技術(shù)的民主化。

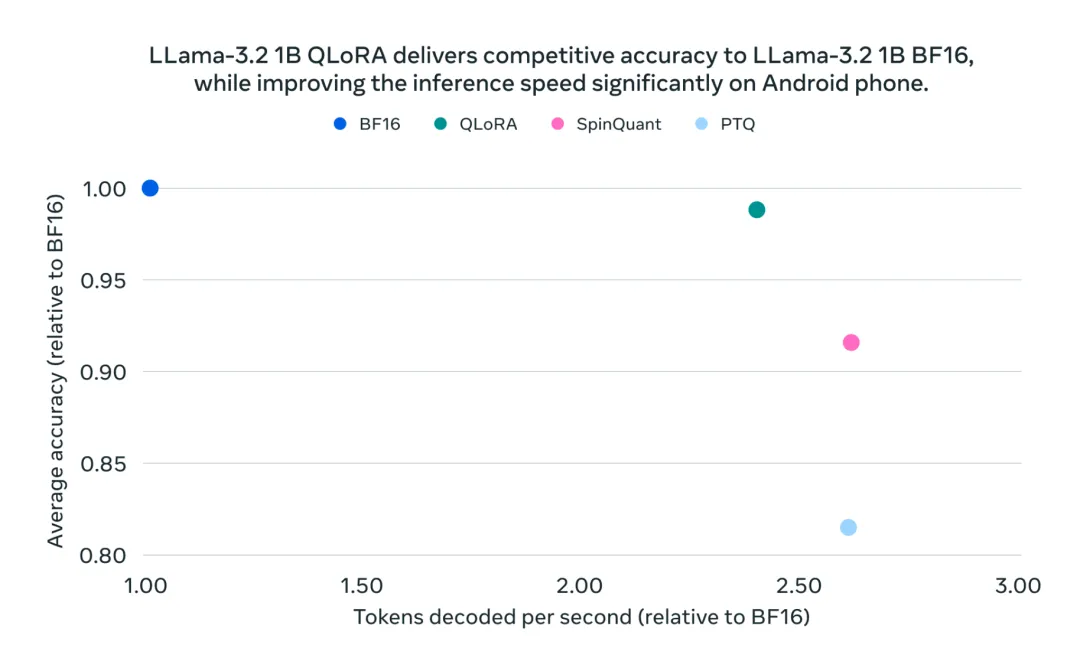

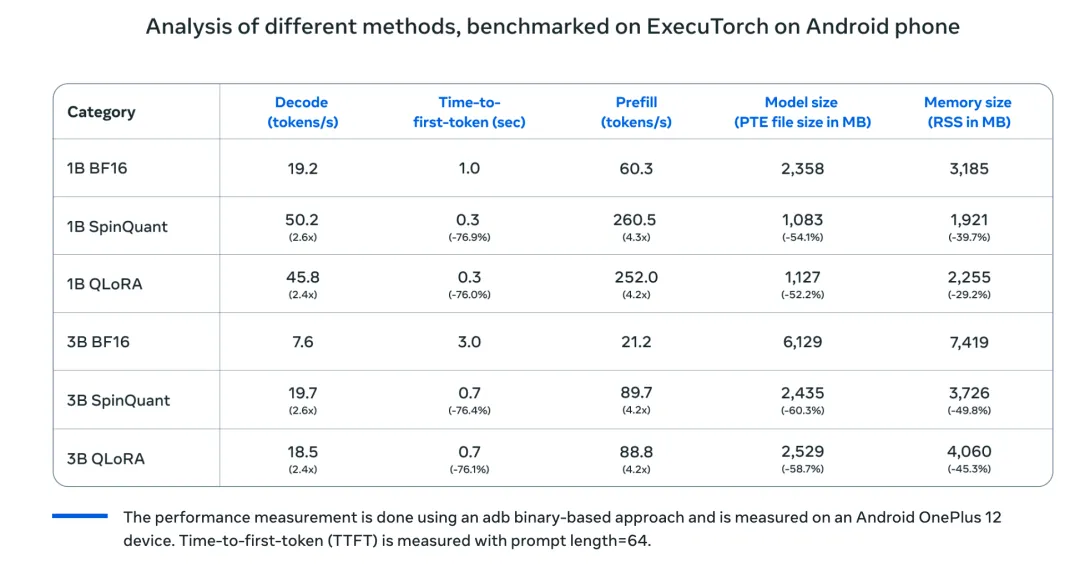

Meta AI之所以能夠提供這些量化模型,得益于其對(duì)廣泛的計(jì)算資源、訓(xùn)練數(shù)據(jù)、全面評(píng)估以及對(duì)安全的重視。這些模型在保持與原始Llama 3模型相同的質(zhì)量和安全要求的同時(shí),實(shí)現(xiàn)了顯著的2-4倍速度提升。與原始的BF16格式相比,它們還實(shí)現(xiàn)了平均56%的模型大小減少和41%的平均內(nèi)存使用減少。這些令人印象深刻的優(yōu)化是Meta在保持高性能和安全標(biāo)準(zhǔn)的同時(shí),使先進(jìn)AI更加易于獲取的努力的一部分。

03 技術(shù)細(xì)節(jié)和優(yōu)勢(shì)

量化Llama 3.2的核心是基于量化技術(shù),該技術(shù)將模型的權(quán)重和激活的精度從32位浮點(diǎn)數(shù)降低到更低位的表示。具體來(lái)說(shuō),Meta AI采用了8位甚至4位的量化策略,這使得模型能夠在顯著減少內(nèi)存和計(jì)算能力的情況下有效運(yùn)行。這種量化方法保留了Llama 3的關(guān)鍵特性和能力,如執(zhí)行高級(jí)自然語(yǔ)言處理(NLP)任務(wù)的能力,同時(shí)使模型更加輕量化。好處是顯而易見的:量化Llama 3.2可以在不那么強(qiáng)大的硬件上運(yùn)行,例如消費(fèi)級(jí)GPU甚至CPU,而不會(huì)顯著損失性能。這也使得這些模型更適合實(shí)時(shí)應(yīng)用,因?yàn)檩^低的計(jì)算需求導(dǎo)致更快的推理時(shí)間。

兩種量化技術(shù)的推理都支持在Llama Stack參考實(shí)現(xiàn)中通過(guò)PyTorch的ExecuTorch框架進(jìn)行。此外,Meta AI還與行業(yè)領(lǐng)先的合作伙伴合作,使這些模型可以在配備Arm CPU的高通和聯(lián)發(fā)科系統(tǒng)級(jí)芯片(SoC)上高效部署。這種合作確保了模型可以在包括流行移動(dòng)平臺(tái)在內(nèi)的廣泛設(shè)備上部署,進(jìn)一步擴(kuò)大了Llama 3.2的覆蓋范圍和影響力。

04 重要性和早期結(jié)果

量化Llama 3.2之所以重要,是因?yàn)樗苯咏鉀Q了與LLMs相關(guān)的可擴(kuò)展性問(wèn)題。通過(guò)在保持高性能的同時(shí)減少模型大小,Meta AI使這些模型更適合邊緣計(jì)算環(huán)境,其中計(jì)算資源是有限的。早期的基準(zhǔn)測(cè)試結(jié)果表明,量化Llama 3.2在關(guān)鍵NLP基準(zhǔn)測(cè)試中的性能大約是完整Llama 3模型的95%,但內(nèi)存使用減少了近60%。這種效率對(duì)于希望在不投資高端基礎(chǔ)設(shè)施的情況下實(shí)施AI的企業(yè)和研究人員至關(guān)重要。此外,能夠在普通硬件上部署這些模型也符合當(dāng)前可持續(xù)AI的趨勢(shì),減少了訓(xùn)練和部署LLMs的環(huán)境影響。

05 結(jié)語(yǔ)

Meta AI發(fā)布量化Llama 3.2標(biāo)志著高效AI模型發(fā)展的重要一步。通過(guò)專注于量化,Meta提供了一個(gè)平衡性能與可訪問(wèn)性的解決方案,使更廣泛的受眾能夠從高級(jí)NLP能力中受益。這些量化模型解決了采用LLMs的關(guān)鍵障礙,如成本、能源消耗和基礎(chǔ)設(shè)施要求。這項(xiàng)技術(shù)的更廣泛影響可能導(dǎo)致對(duì)AI的更公平獲取,促進(jìn)了以前對(duì)小型企業(yè)和研究人員來(lái)說(shuō)遙不可及的領(lǐng)域的創(chuàng)新。Meta AI推動(dòng)高效AI建模的界限的努力突顯了對(duì)可持續(xù)、包容性AI發(fā)展的日益重視——這一趨勢(shì)肯定會(huì)塑造AI研究和應(yīng)用的未來(lái)。

參考:

?

本文轉(zhuǎn)載自公眾號(hào)Halo咯咯 作者:基咯咯

原文鏈接:??https://mp.weixin.qq.com/s/ccIxhzciFXRFAV3O5RzrwA???