AMD 開源 AMD OLMo:完全開源的 1B 語言模型系列 原創(chuàng)

01、概述

在人工智能和機(jī)器學(xué)習(xí)領(lǐng)域,我們正經(jīng)歷著一場技術(shù)革命。隨著技術(shù)的飛速發(fā)展,對于強(qiáng)大、靈活且易于獲取的解決方案的需求也在不斷增長。開發(fā)者、研究人員和技術(shù)愛好者在利用尖端技術(shù)時(shí),常常受限于封閉生態(tài)系統(tǒng)的束縛。許多現(xiàn)有的語言模型,包括一些最受歡迎的模型,往往伴隨著專有限制和許可限制,或者托管在限制開發(fā)者精細(xì)控制的環(huán)境之中。這些問題對于那些熱衷于實(shí)驗(yàn)、擴(kuò)展或以特定方式部署模型以滿足個(gè)別用例的人來說,常常成為阻礙。這時(shí),開源解決方案成為了關(guān)鍵的推動(dòng)者,提供了自主權(quán),并民主化了對強(qiáng)大AI工具的訪問。

02、AMD OLMo:開源AI生態(tài)的新成員

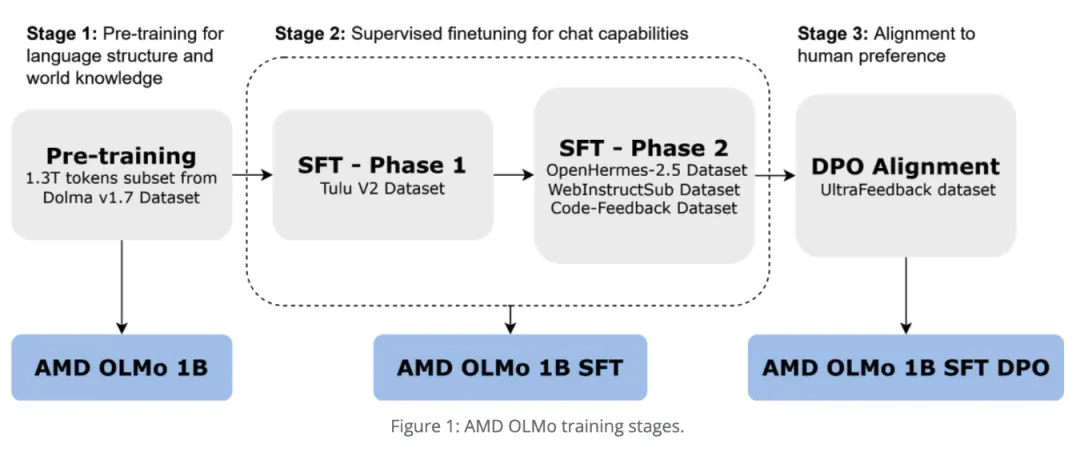

最近,AMD發(fā)布了AMD OLMo:一個(gè)完全開源的1B(10億)參數(shù)語言模型系列,由AMD在AMD Instinct? MI250 GPU上從頭開始訓(xùn)練。AMD OLMo的發(fā)布標(biāo)志著AMD首次大規(guī)模進(jìn)入開源AI生態(tài)系統(tǒng),提供了一個(gè)完全透明的模型,服務(wù)于開發(fā)者、數(shù)據(jù)科學(xué)家和企業(yè)。特別是AMD OLMo-1B-SFT(Supervised Fine-Tuned,監(jiān)督微調(diào))模型,經(jīng)過特別微調(diào)以增強(qiáng)其理解指令的能力,改善用戶交互和語言理解。這個(gè)模型旨在支持從基礎(chǔ)對話AI任務(wù)到更復(fù)雜的自然語言處理(NLP)問題的廣泛用例。模型與標(biāo)準(zhǔn)的機(jī)器學(xué)習(xí)框架如PyTorch和TensorFlow兼容,確保了不同平臺(tái)上用戶的易訪問性。這一步代表了AMD致力于培養(yǎng)一個(gè)繁榮的AI開發(fā)社區(qū),利用合作的力量,并在開源AI領(lǐng)域采取了明確的立場。

03、技術(shù)細(xì)節(jié):AMD OLMo模型的亮點(diǎn)

AMD OLMo模型的技術(shù)細(xì)節(jié)尤其引人注目。該模型采用變換器架構(gòu)構(gòu)建,擁有強(qiáng)大的10億參數(shù),提供了顯著的語言理解和生成能力。它在多樣化的數(shù)據(jù)集上進(jìn)行訓(xùn)練,以優(yōu)化其在廣泛的NLP任務(wù)中的性能,如文本分類、摘要和對話生成。對指令遵循數(shù)據(jù)的微調(diào)進(jìn)一步增強(qiáng)了其在交互式應(yīng)用中的適用性,使其更擅長理解微妙的命令。此外,AMD在訓(xùn)練過程中使用高性能的Radeon Instinct GPU,展示了其硬件處理大規(guī)模深度學(xué)習(xí)模型的能力。該模型已針對準(zhǔn)確性和計(jì)算效率進(jìn)行了優(yōu)化,使其能夠在消費(fèi)級(jí)硬件上運(yùn)行,而不需要通常與專有大規(guī)模語言模型相關(guān)的昂貴資源需求。這使得它成為愛好者和無法負(fù)擔(dān)昂貴計(jì)算資源的小型企業(yè)的有吸引力的選擇。

04、降低AI研究和創(chuàng)新的門檻

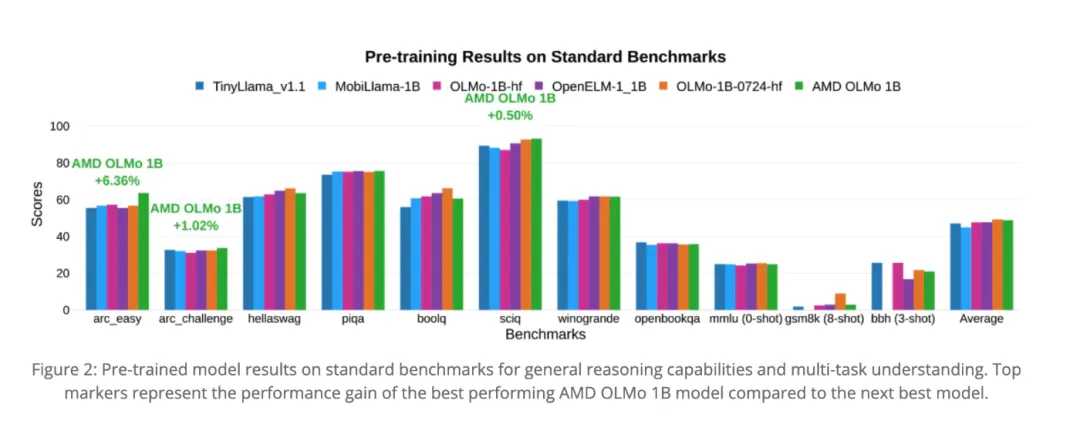

這一發(fā)布的重要性不言而喻。這個(gè)模型之所以重要,其中一個(gè)主要原因是它有潛力降低AI研究和創(chuàng)新的入門門檻。通過向所有人提供完全開放的10億參數(shù)模型,AMD提供了一個(gè)關(guān)鍵資源,可以賦予全球開發(fā)者權(quán)力。AMD OLMo-1B-SFT以其指令遵循微調(diào),允許在各種現(xiàn)實(shí)世界場景中增強(qiáng)可用性,包括聊天機(jī)器人、客戶支持系統(tǒng)和教育工具。初步基準(zhǔn)測試表明,AMD OLMo在多個(gè)NLP基準(zhǔn)測試中的表現(xiàn)與類似規(guī)模的其他知名模型具有競爭力,包括GLUE和SuperGLUE。在開源環(huán)境中提供這些結(jié)果的可用性至關(guān)重要,因?yàn)樗股鐓^(qū)能夠進(jìn)行獨(dú)立的驗(yàn)證、測試和改進(jìn),確保透明度,并促進(jìn)合作方法,推動(dòng)這些模型能夠?qū)崿F(xiàn)的界限。

05、結(jié)語

AMD引入完全開源的10億語言模型是AI社區(qū)的一個(gè)重要里程碑。這一發(fā)布不僅民主化了對高級(jí)語言建模能力訪問,還實(shí)際展示了如何使強(qiáng)大的AI更具包容性。AMD對開源原則的承諾有潛力激勵(lì)其他科技巨頭做出類似的貢獻(xiàn),培養(yǎng)一個(gè)更豐富的工具和解決方案生態(tài)系統(tǒng),使每個(gè)人都受益。通過提供一個(gè)強(qiáng)大、經(jīng)濟(jì)高效且靈活的語言理解和生成工具,AMD成功地將自己定位為未來AI創(chuàng)新的關(guān)鍵參與者。

參考:

- ??https://huggingface.co/amd/AMD-OLMo-1B-SFT??

- ??https://www.amd.com/en/developer/resources/technical-articles/introducing-the-first-amd-1b-language-model.html??

?

本文轉(zhuǎn)載自公眾號(hào)Halo咯咯 作者:基咯咯