不走尋常路的面壁智能,又一次“掀桌子”了! 原創

整理 | 星璇

不走尋常路的面壁智能,又一次“掀桌子”了!

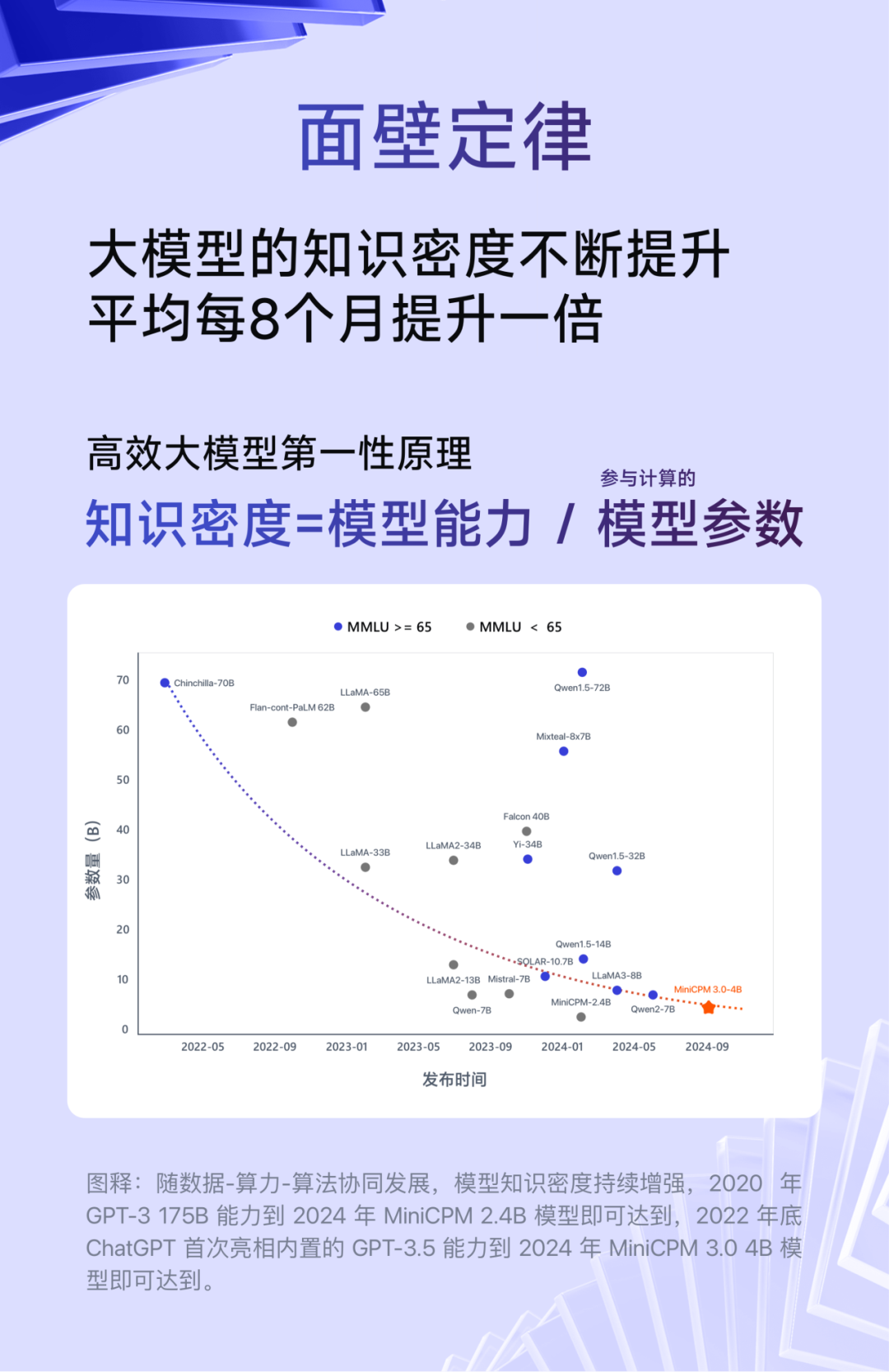

面壁昨天發布了第三代小鋼炮MiniCPM3.0,參數只有4B,性能卻足以叫板市面上千億參數規模的大模型!端側的“面壁定律”又一次發威了!

圖片

圖片

話不多說,直接上干貨。

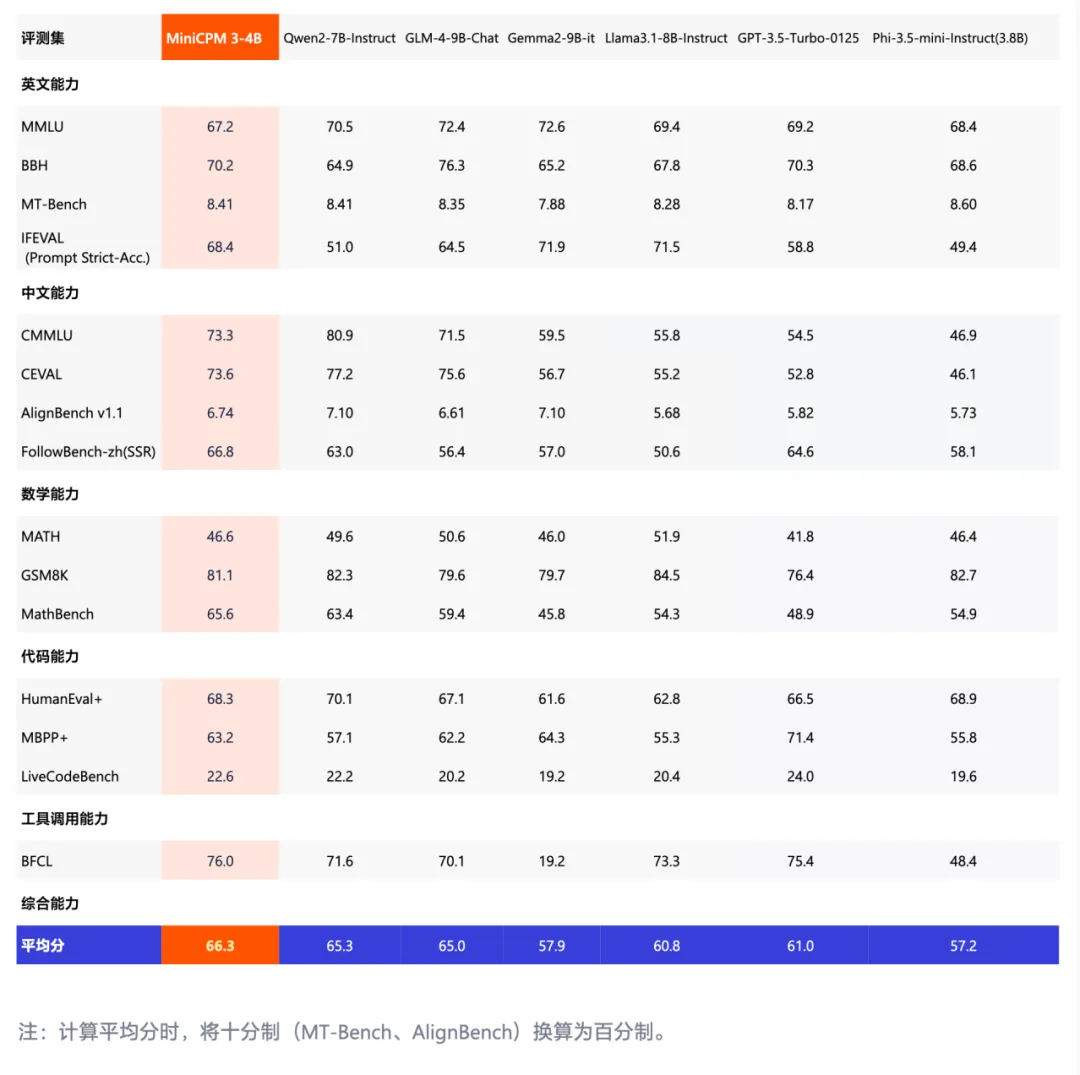

1.綜合能力:4B規模干翻GPT-3.5

提前近 4 個月,面壁智能實現了初代面壁小鋼炮發布時立下的 Flag:今年內讓 GPT-3.5 水平的模型在端側跑起來!

圖片

圖片

MiniCPM 3.0 再次挖掘端側模型的極致性能,僅 4B 參數,在包括知識水平、數學邏輯、代碼能力、指令遵循、工具調用等多項能力上對 GPT-3.5 實現趕超,Overall Acc(所有分類任務的準確率平局值)超過了Llama3.1-8B-instruct、Qwen2-7B-Instruct、GLM-4-9B-Chat、Phi-3.5,可謂一匹黑馬。

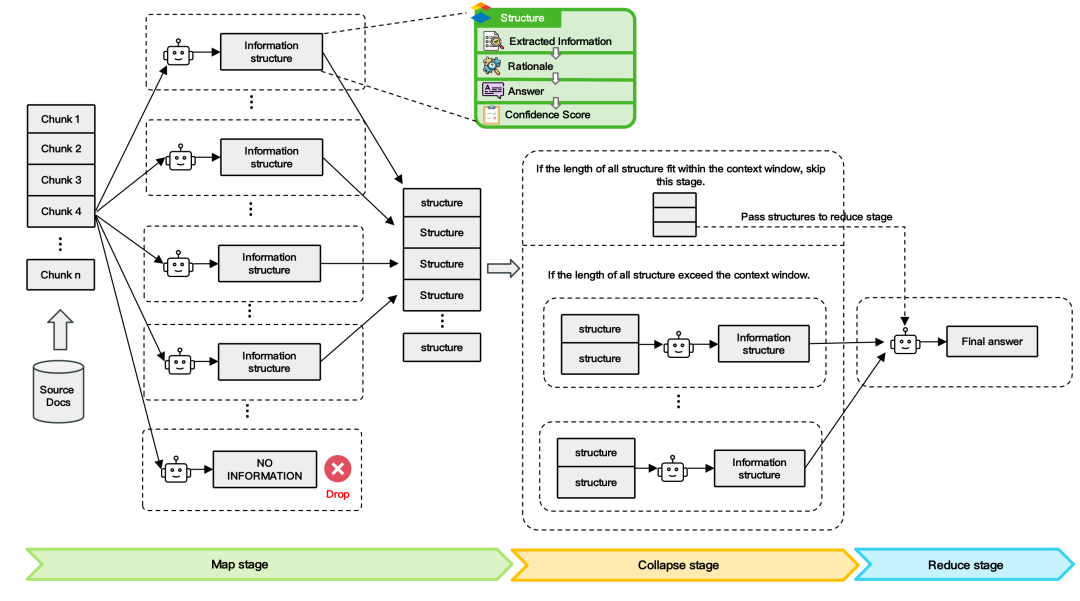

2.小鋼炮挑戰無限長文本

小鋼炮3.0采用了一種LLMxMapReduce長文本分幀處理的技術,通過將長上下文切分為多個片段,讓模型并行處理,并從不同片段中提取關鍵信息,匯總最終答案,實現無限長文本。這一技術對模型長文本能力,具有普遍增強作用,且在文本不斷加長情況,仍保持穩定性能、減少長文本隨加長掉分情況。

LLMxMapReduce 技術框架圖

LLMxMapReduce 技術框架圖

更長的上下文長度,意味大模型擁有更大的“內存”和更長的“記憶”,不僅能提高大模型處理數據的能力上限,還能拓寬大模型應用的廣度和深度。

長上下文:小模型也可以無限長文本

長上下文:小模型也可以無限長文本

而小鋼炮這種無限上下文技術, 可以讓模型一次性讀取不限字數的書籍或不限量的學術論文、簡歷等材料,成為你身邊更加強大的終端個人助手。

這也就意味著,搭載小鋼炮的手機,AI能力將會得到真正的釋放,比如讀取你的大眾點評美食、酒店評價、微博互動內容,并牢牢記住你和AI 跨越多年的聊天記錄,成為最懂你的AI陪伴者,為你提供“共情”的推薦與內容。

3.超強 RAG 外掛三件套,中文檢索第一、生成超 Llama3-8B

現在RAG已經成為AI原生應用開發的標配,讓模型引用外部知識庫,檢索到最新、最可靠的專業知識,確保生成內容更加可信,大大減少大模型的幻覺問題,尤其是對法律、醫療等依賴專業知識庫、對大模型幻覺容忍度極低的垂直行業。

在檢索、重排、生成這三個重要的RAG環節,面壁這次一口氣把三件套全都放了出來:MiniCPM-Embedding(檢索模型)、MiniCPM-Reranker(重排序模型)和面向 RAG 場景的 LoRA 插件(生成模型)。

- MiniCPM-Embedding(檢索模型)中英跨語言檢索取得 SOTA 性能,在評估模型文本嵌入能力的權威評測集 MTEB 的檢索榜單上中文第一、英文第十三 ;

- MiniCPM-Reranker(重排序模型)在中文、英文、中英跨語言測試上取得 SOTA 性能 ;

- 經過針對 RAG 場景的 LoRA 訓練后,MiniCPM 3.0-RAG-LoRA 在開放域問答(NQ、TQA、MARCO)、多跳問答(HotpotQA)、對話(WoW)、事實核查(FEVER)和信息填充(T-REx)等多項任務上的性能表現,超越 Llama3-8B 和 Baichuan2-13B 等業內優秀模型。

圖片

圖片

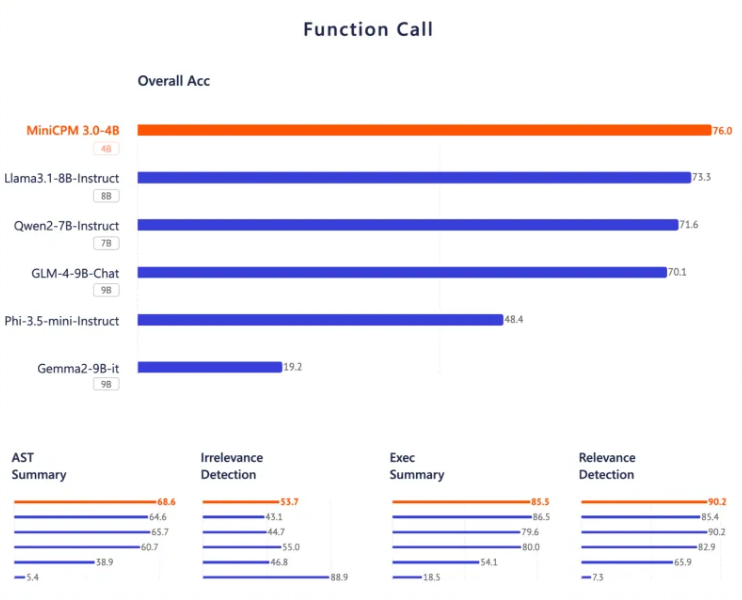

4.端側智能體:GPT-4o 級 Function calling

智能體應用是端側AI 必爭之地,而這其中一項至關重要的技術是 Function Calling(函數調用),它能夠將用戶模糊化的輸入語義轉換為機器可以精確理解執行的結構化指令,并讓大模型連接外部工具和系統,例如通過語音在手機上調用日歷、天氣、郵件、瀏覽器等 APP 或相冊、文件等本地數據庫,從而打開終端設備 Agent 應用的無限可能,也讓人機交互更加自然和方便。

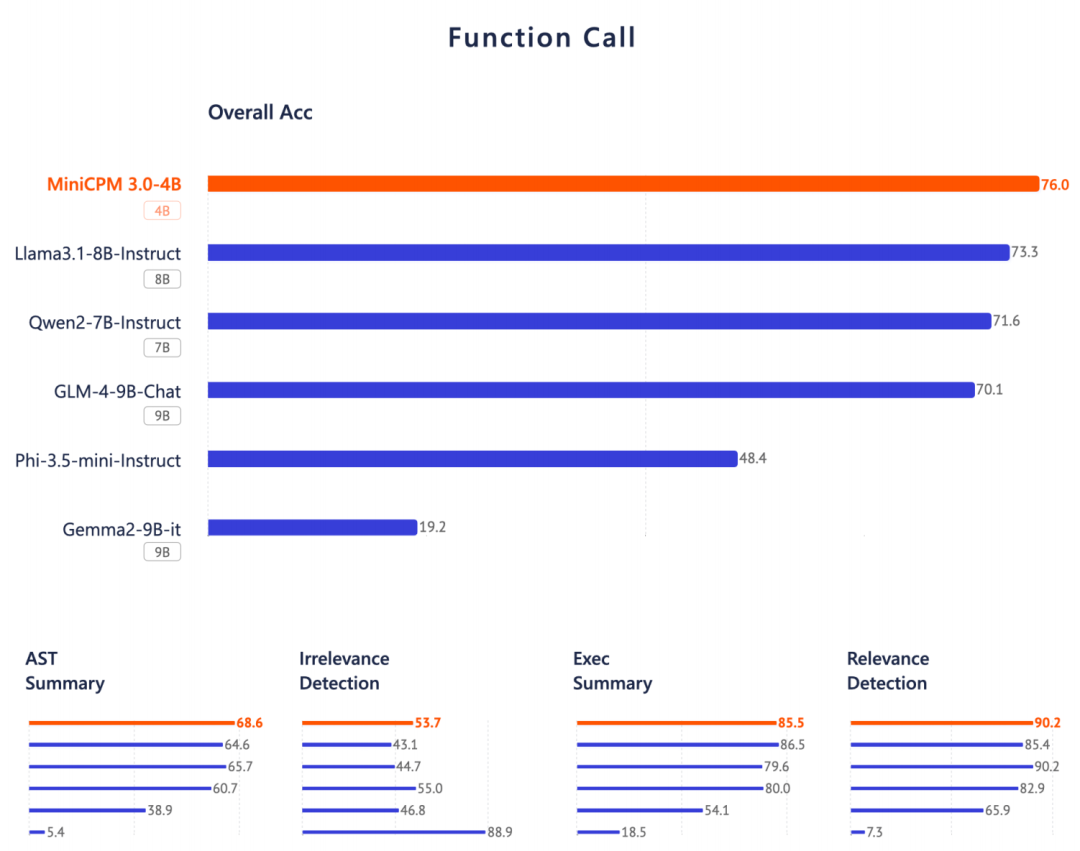

小鋼炮 3.0 這次發布的數據來看,堪比具備端側最強 Function calling 性能 ,在權威評測榜單 Berkeley Function-Calling Leaderboard 上,其性能接近 GPT-4o,并超越 Llama 3.1-8B、Qwen-2-7B、GLM-4-9B 等眾多模型。

圖片

圖片

最后,上地址。MiniCPM 3.0 開源地址:

GitHub: https://github.com/OpenBMB/MiniCPM

HuggingFace: ??https://huggingface.co/openbmb/MiniCPM3-4B??

本文轉載自??51CTO技術棧??,作者:星璇