語(yǔ)言模型的神秘面紗:小學(xué)數(shù)學(xué)與隱含推理過(guò)程

一、結(jié)論寫(xiě)在前面

論文標(biāo)題:Physics of Language Models: Part 2.1, Grade-School Math and the Hidden Reasoning Process

論文鏈接:??https://arxiv.org/pdf/2407.20311??

預(yù)覽頁(yè)面 - 視頻:??https://physics.allen-zhu.com/part-2-grade-school-math/part-2-1??

語(yǔ)言模型的最新進(jìn)展展示了其在解決數(shù)學(xué)推理問(wèn)題上的能力,達(dá)到了接近完美的準(zhǔn)確率,如GSM8K等小學(xué)水平數(shù)學(xué)基準(zhǔn)測(cè)試。

論文研究了語(yǔ)言模型如何解決這些問(wèn)題。論文設(shè)計(jì)了一系列控制實(shí)驗(yàn)來(lái)回答幾個(gè)基本問(wèn)題:

(1) 語(yǔ)言模型是否真的發(fā)展了推理技能,還是僅僅記憶了模板?

(2) 模型的隱含(心理)推理過(guò)程是什么?

(3) 模型解決數(shù)學(xué)問(wèn)題所用的技能與人類相似還是不同?

(4) 模型在GSM8K類數(shù)據(jù)集上訓(xùn)練后,是否發(fā)展了超出解決GSM8K問(wèn)題所需的推理技能?

(5) 導(dǎo)致模型推理錯(cuò)誤的心理過(guò)程是什么?

(6) 模型需要多大或多深才能有效解決GSM8K級(jí)別的數(shù)學(xué)問(wèn)題?

論文通過(guò)合成設(shè)置展示了語(yǔ)言模型能夠通過(guò)真正的泛化來(lái)解決小學(xué)數(shù)學(xué)問(wèn)題,而不是依賴于數(shù)據(jù)污染或模板記憶。論文開(kāi)發(fā)了探測(cè)技術(shù)來(lái)檢查模型的隱藏推理過(guò)程。論文的發(fā)現(xiàn)揭示了這些模型能夠?qū)W習(xí)與人類認(rèn)知過(guò)程一致的數(shù)學(xué)技能,以及訓(xùn)練數(shù)據(jù)中不存在“新的思維過(guò)程”。

此外,論文提出了一種方法,在模型開(kāi)始解決問(wèn)題之前預(yù)測(cè)其錯(cuò)誤,并解釋模型為何在發(fā)生錯(cuò)誤時(shí)犯錯(cuò)。基于這一發(fā)現(xiàn),論文撰寫(xiě)了一篇單獨(dú)的論文,以提高語(yǔ)言模型的數(shù)學(xué)推理準(zhǔn)確性。論文還提供了一種原則性的方法,將模型的深度與其推理能力相連接。相比于推動(dòng)數(shù)學(xué)基準(zhǔn),論文相信這項(xiàng)研究為從不同角度研究語(yǔ)言模型的數(shù)學(xué)推理技能打開(kāi)了大門。

總結(jié)如下:

?結(jié)果2。論文證明,預(yù)訓(xùn)練于論文合成數(shù)據(jù)集的GPT2模型,不僅在解決同分布數(shù)學(xué)問(wèn)題上達(dá)到99%的準(zhǔn)確率,還能泛化到未見(jiàn)過(guò)的分布,例如推理長(zhǎng)度超過(guò)訓(xùn)練中任何樣本的問(wèn)題。這與算術(shù)中的長(zhǎng)度泛化類似,但在論文的案例中,模型從未見(jiàn)過(guò)與測(cè)試時(shí)相同長(zhǎng)度的訓(xùn)練樣本。這表明模型真正學(xué)會(huì)了某些推理技能,而非記憶解題模板。

?結(jié)果3:關(guān)鍵在于,模型能夠?qū)W會(huì)生成最短的解決方案,幾乎總是避免不必要的計(jì)算。這表明模型在生成之前會(huì)制定一個(gè)計(jì)劃,以避免計(jì)算任何對(duì)解決基礎(chǔ)數(shù)學(xué)問(wèn)題無(wú)用的量。

?結(jié)果4:論文通過(guò)探針檢查模型的內(nèi)部狀態(tài),引入了六個(gè)探針任務(wù)來(lái)闡明模型如何解決數(shù)學(xué)問(wèn)題。例如,論文發(fā)現(xiàn)模型在開(kāi)始生成之前預(yù)處理了所有必要的參數(shù)。同樣,人類也會(huì)進(jìn)行這種預(yù)處理,盡管論文通常會(huì)將其寫(xiě)下來(lái)。

?結(jié)果5:令人驚訝的是,模型在預(yù)訓(xùn)練后還學(xué)會(huì)了不必要但重要的技能,如全對(duì)依賴。在提出任何問(wèn)題之前,它已經(jīng)以高準(zhǔn)確度計(jì)算了哪些參數(shù)依賴于哪些參數(shù),即使其中一些對(duì)解決數(shù)學(xué)問(wèn)題并不需要。值得注意的是,計(jì)算全對(duì)依賴是一項(xiàng)技能,不需要用于擬合訓(xùn)練數(shù)據(jù)中的所有解決方案。據(jù)論文所知,這是首次證據(jù)表明,語(yǔ)言模型能夠?qū)W習(xí)超越其預(yù)訓(xùn)練數(shù)據(jù)所需的有用技能。這可能是AGI中“G”(通用)的初步信號(hào)來(lái)源。

?結(jié)果6:論文解釋了錯(cuò)誤發(fā)生的原因。例如,模型會(huì)犯系統(tǒng)性錯(cuò)誤,這些錯(cuò)誤可以通過(guò)探查其內(nèi)部狀態(tài)來(lái)解釋。有時(shí),這些錯(cuò)誤在模型生成答案之前就可以預(yù)測(cè),使它們獨(dú)立于隨機(jī)生成過(guò)程。論文將此與實(shí)踐聯(lián)系起來(lái),指出GPT-4/4o也會(huì)犯類似的錯(cuò)誤(盡管論文無(wú)法探查它們的內(nèi)部狀態(tài))。

?結(jié)果 7+8 。語(yǔ)言模型的深度對(duì)其推理能力至關(guān)重要。例如,一個(gè)16層、576維的transformer比一個(gè)4層、1920維的transformer解決更復(fù)雜的問(wèn)題(在推理長(zhǎng)度上),盡管后者體積是前者的兩倍。即便使用思維鏈(Chain-of-Thought, CoT)也是如此。論文通過(guò)所涉及的心理過(guò)程的復(fù)雜性來(lái)深入解釋這種必要性。論文主張使用受控的、合成的數(shù)據(jù)作為一種更有原則的方法來(lái)得出這樣的結(jié)論,這與基于使用互聯(lián)網(wǎng)預(yù)訓(xùn)練數(shù)據(jù)的訓(xùn)練損失得出的"只有規(guī)模才重要"等預(yù)測(cè)形成對(duì)比[14]。

雖然論文不會(huì)過(guò)分夸大地聲稱論文的發(fā)現(xiàn)直接適用于像GPT-4這樣的基礎(chǔ)模型或更具挑戰(zhàn)性的數(shù)學(xué)推理任務(wù),但論文相信論文的工作顯著推進(jìn)了對(duì)語(yǔ)言模型如何發(fā)展其數(shù)學(xué)推理能力的理解,而這必須以一種不同于推動(dòng)基準(zhǔn)測(cè)試的方式來(lái)完成。

二 論文的簡(jiǎn)單介紹

2.1 論文的背景

語(yǔ)言模型領(lǐng)域近年來(lái)取得了顯著進(jìn)展。大型模型如GPT-4已顯示出初步的通用智能跡象 ,而較小的模型則通過(guò)解決具有挑戰(zhàn)性的編碼和數(shù)學(xué)問(wèn)題展示了良好的推理能力。

論文聚焦于小型語(yǔ)言模型解決小學(xué)數(shù)學(xué)問(wèn)題的能力。與先前工作通過(guò)實(shí)證方法提升模型在小學(xué)數(shù)學(xué)基準(zhǔn)測(cè)試(如GSM8K 及其擴(kuò)展版本)上的準(zhǔn)確率不同,論文采取了一種更為原則性的方法。論文的目標(biāo)是理解以下基本問(wèn)題:

1.語(yǔ)言模型如何學(xué)會(huì)解決小學(xué)水平的數(shù)學(xué)問(wèn)題?它們是否僅僅記憶了模板,還是學(xué)會(huì)了類似于人類的推理技能?或是它們發(fā)現(xiàn)了新的解題技巧?

2.僅在小學(xué)數(shù)學(xué)問(wèn)題上訓(xùn)練的模型是否僅學(xué)會(huì)了這些問(wèn)題的解決方法,還是它們發(fā)展出了某種更普遍的智能?

3.語(yǔ)言模型在解決小學(xué)數(shù)學(xué)問(wèn)題時(shí)可以有多小?深度(層數(shù))是否比寬度(每層神經(jīng)元數(shù))更重要,還是如從業(yè)者所建議的那樣,只有模型的大小才是關(guān)鍵 ?

這些問(wèn)題對(duì)于理解語(yǔ)言模型的智能至關(guān)重要。為了研究它們,似乎很自然地會(huì)考慮從預(yù)訓(xùn)練模型開(kāi)始,并在現(xiàn)有數(shù)據(jù)集(如GSM8K或GPT-4增強(qiáng)版數(shù)據(jù)集)上進(jìn)行微調(diào)。然而,這種方法存在顯著局限性:

?數(shù)據(jù)污染。現(xiàn)有模型的預(yù)訓(xùn)練數(shù)據(jù)大多來(lái)自公開(kāi)可用的互聯(lián)網(wǎng),這些數(shù)據(jù)雜亂無(wú)章。論文無(wú)法知曉其中包含了多少數(shù)學(xué)問(wèn)題及其結(jié)構(gòu)。關(guān)于GSM8K基準(zhǔn)測(cè)試是否已泄露至語(yǔ)言模型的訓(xùn)練數(shù)據(jù)集中存在重大疑慮 。即便確切數(shù)據(jù)未泄露,預(yù)訓(xùn)練模型可能已經(jīng)見(jiàn)過(guò)幾乎相同的問(wèn)題(例如,同一問(wèn)題但數(shù)字不同)。因此,這種方法無(wú)法解答問(wèn)題1至3。論文無(wú)法確定模型是否真正學(xué)會(huì)了推理技能,或者它只是在訓(xùn)練過(guò)程中記憶了問(wèn)題模板。因此,論文需要完全控制模型的預(yù)訓(xùn)練數(shù)據(jù),并必須從頭開(kāi)始訓(xùn)練語(yǔ)言模型。這一點(diǎn)在近期文獻(xiàn) [ 2, 3 ] 中已被反復(fù)強(qiáng)調(diào)。

?解題多樣性。現(xiàn)有的微調(diào)數(shù)據(jù),如GSM8K訓(xùn)練集,僅包含7.5千道小學(xué)數(shù)學(xué)題,不足以從頭開(kāi)始訓(xùn)練模型。盡管近期工作使用GPT-4擴(kuò)充GSM8K,但這仍無(wú)法滿足論文的需求。GPT-4擴(kuò)充的問(wèn)題可能偏向于少數(shù)解題模板,因?yàn)樵糋SM8K數(shù)據(jù)中的解題模板非常有限(顯然,最多8千個(gè))。論文需要一個(gè)更大、更多樣的小學(xué)數(shù)學(xué)題集合。

基于這些考慮,論文提出一個(gè)框架,用于生成大量多樣的小學(xué)數(shù)學(xué)(GSM)問(wèn)題,并利用該數(shù)據(jù)集從頭開(kāi)始訓(xùn)練和測(cè)試類似GPT2的語(yǔ)言模型。在該框架中,論文專注于小學(xué)數(shù)學(xué)問(wèn)題中的“邏輯推理”部分,這涉及問(wèn)題陳述中參數(shù)的依賴關(guān)系,例如“愛(ài)麗絲的蘋(píng)果是鮑勃的橙子和查爾斯的香蕉總和的三倍”。論文使用合成句子來(lái)降低因常識(shí)帶來(lái)的難度,例如“一支蠟燭以每小時(shí)1英寸的速度燃燒了12小時(shí)”(暗示蠟燭在縮短)。論文還消除了純算術(shù)的難度:論文僅考慮整數(shù)和算術(shù)模23。

此外,論文的框架確保生成的數(shù)學(xué)問(wèn)題高度多樣,不來(lái)自少數(shù)模板。即使忽略所有算術(shù)、英語(yǔ)、變量名稱和未使用的參數(shù),論文的問(wèn)題仍擁有超過(guò)90萬(wàn)億種解題模板(見(jiàn)命題2.2),遠(yuǎn)超GPT2-small(1億參數(shù))的規(guī)模。因此,語(yǔ)言模型無(wú)法通過(guò)簡(jiǎn)單記憶解題模板來(lái)解決論文的問(wèn)題。

論文使用GPT2模型,但將其位置嵌入替換為旋轉(zhuǎn)位置嵌入(positional embedding with rotary embedding,RoPE)。為了簡(jiǎn)潔,論文仍稱其為GPT2。

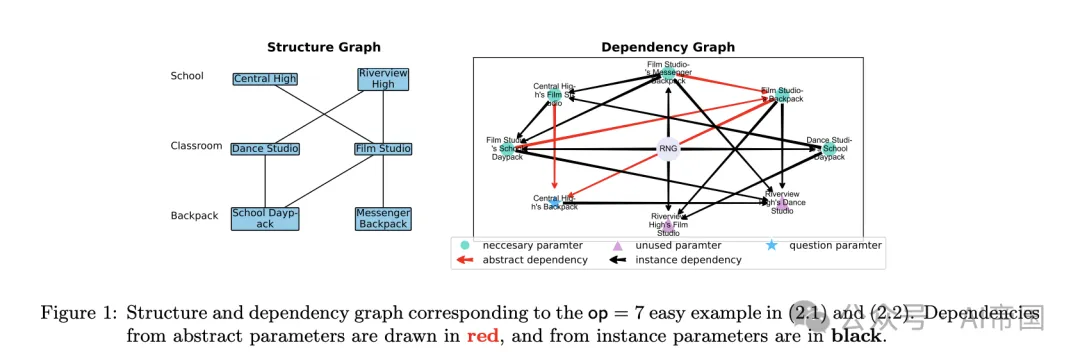

圖1:對(duì)應(yīng)于 (2.1) 和 (2.2) 中 op=7 簡(jiǎn)單示例的結(jié)構(gòu)和依賴關(guān)系圖。抽象參數(shù)的依賴關(guān)系以紅色繪制,實(shí)例參數(shù)的依賴關(guān)系以黑色繪制

2.2 結(jié)果1:數(shù)據(jù)生成

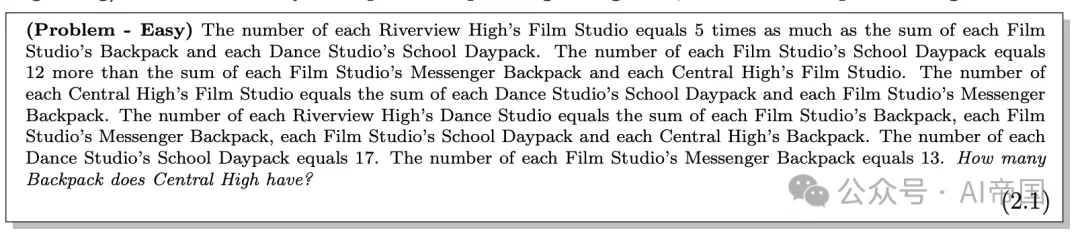

動(dòng)機(jī)。回想一下GSM8K數(shù)據(jù)集中的一個(gè)標(biāo)準(zhǔn)小學(xué)數(shù)學(xué)問(wèn)題:

Betty正在為一個(gè)新的錢包存錢,這個(gè)錢包花費(fèi)100。Betty只有她所需錢的一半。她的父母決定為此目的給她15,而她的祖父母給她的錢是父母的兩倍。Betty還需要多少錢才能買這個(gè)錢包?

這個(gè)問(wèn)題涉及多個(gè)參數(shù),這些參數(shù)的值通過(guò)各種等式相互關(guān)聯(lián),例如“Betty目前的錢 = 0.5 × 錢包的成本”和“祖父母給的錢 = 2 × 父母給的錢”。受此啟發(fā),論文通過(guò)一個(gè)捕捉參數(shù)依賴關(guān)系的合成生成管道構(gòu)建了一個(gè)類似GSM8K的數(shù)學(xué)數(shù)據(jù)集。論文希望至少捕捉以下三種類型的依賴關(guān)系。

?直接依賴:例如 A=5×(X+Y),因此可以在之后計(jì)算

?實(shí)例依賴:例如“每個(gè)教室有 X 把椅子,有 Y 個(gè)教室。”在這里,模型必須通過(guò)將 X 乘以 Y 來(lái)推斷椅子的總數(shù)。

?隱式依賴:例如,“Bob 的水果比 Alice 多 3 倍。Alice 有 3 個(gè)蘋(píng)果、4 個(gè)雞蛋和 2 個(gè)香蕉。” 這里,模型必須學(xué)習(xí)到蘋(píng)果和香蕉是水果,而雞蛋不是,并且“Alice 的水果”是一個(gè)從問(wèn)題陳述中派生的抽象參數(shù)。

2.2.1 步驟1:圖構(gòu)建與問(wèn)題生成

層次分類。論文使用一個(gè)分層的 categories 結(jié)構(gòu),每個(gè)層次包含可能的項(xiàng)目。例如,categories = (學(xué)校, 教室, 背包) 有三個(gè)層次;學(xué)校類別 = {中央高中, 河景高中, ...};教室類別 = {舞蹈工作室, 電影工作室, ...};背包類別 = {學(xué)校日包, 信使背包, ...}。論文準(zhǔn)備了 4 個(gè)預(yù)定義的層次分類,每個(gè)分類有 4 層,每層包含 100 個(gè)項(xiàng)目;這代表了世界知識(shí)。

結(jié)構(gòu)圖。在每個(gè)數(shù)學(xué)問(wèn)題中,只有特定的項(xiàng)目存在,導(dǎo)致一個(gè)結(jié)構(gòu)圖,該圖概述了哪些子項(xiàng)目可以在哪些項(xiàng)目下出現(xiàn),見(jiàn)圖 1(左)。例如,

?用一條邊連接舞蹈工作室和學(xué)校日包表示一個(gè)實(shí)例參數(shù),“每個(gè)舞蹈工作室中的學(xué)校日包數(shù)量”,這是一個(gè)可量化的變量,可以被賦值。這捕獲了上述提到的實(shí)例依賴。

?抽象參數(shù),如“中央高中教室的總數(shù)”,不能被賦值,因此被排除在結(jié)構(gòu)圖之外。它們反映了隱式依賴。

依賴圖。依賴圖是一個(gè)有向無(wú)環(huán)圖,它概述了參數(shù)之間的依賴關(guān)系。對(duì)于每個(gè)實(shí)例參數(shù),論文隨機(jī)選擇一組(最多4個(gè))它可能依賴的參數(shù)——可能包括一個(gè)代表隨機(jī)數(shù)生成器的特殊頂點(diǎn)RNG。例如,如果"[參數(shù)A]比[參數(shù)B]和[參數(shù)C]的差值多X",其中X是隨機(jī)生成的,那么論文就從B、C和RNG到參數(shù)A畫(huà)出邊。抽象參數(shù)的依賴關(guān)系由實(shí)例參數(shù)的依賴關(guān)系隱含表示。這捕捉了上文提到的直接依賴關(guān)系(?)。

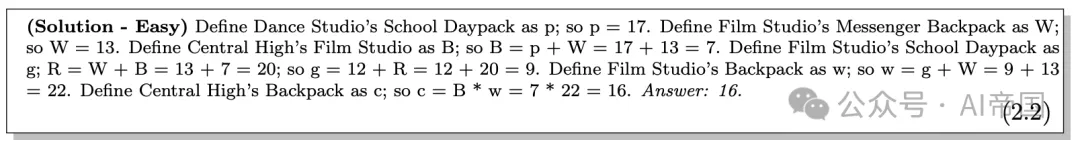

問(wèn)題生成。問(wèn)題通過(guò)用英語(yǔ)描述依賴圖來(lái)闡述,每個(gè)實(shí)例參數(shù)對(duì)應(yīng)一句話。(抽象參數(shù)不描述,因?yàn)樗鼈冇山Y(jié)構(gòu)圖繼承。)論文隨機(jī)排列句子順序以進(jìn)一步增加難度。選擇一個(gè)參數(shù)并在最后(或開(kāi)始)提問(wèn)。下面是一個(gè)對(duì)應(yīng)于圖 1 的簡(jiǎn)單示例;一個(gè)更難的示例在圖 11 中。

2.2.2 步驟 2:解決方案構(gòu)建(CoT)

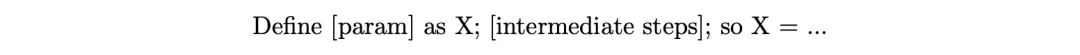

設(shè) solution 為一個(gè)句子序列,描述解決給定問(wèn)題所需的步驟,句子按照任何拓?fù)漤樞蚺帕小卜Q為思維鏈(Chain-of-Thought, CoT)。對(duì)于回答最終問(wèn)題所需的每個(gè)參數(shù),論文從 52 個(gè)選擇 ( a.. z o r A.. Z ) 中隨機(jī)分配一個(gè)字母,并用一句話描述其計(jì)算。

論文考慮模 23 (arithmetics mod 23)的算術(shù)以避免涉及大數(shù)計(jì)算的錯(cuò)誤。直接查看一個(gè)解決方案示例可能最容易理解,更復(fù)雜的示例在圖 11 中:

論文強(qiáng)調(diào)以下幾點(diǎn):

?解決方案只包含計(jì)算最終查詢參數(shù)所必需的參數(shù)。

?解決方案遵循正確的邏輯順序:即計(jì)算中使用的所有參數(shù)必須事先出現(xiàn)并被計(jì)算。

?論文將計(jì)算分解為二元運(yùn)算:例如,g = 12+13+7 被分解為 g = 12+R 和 R = 13+7,如上述解決方案所示。分號(hào)";"的數(shù)量等于運(yùn)算的次數(shù)。這降低了解決方案的算術(shù)復(fù)雜性,而這不是本文的重點(diǎn)。

2.2.3 難度控制

論文在此總結(jié)了數(shù)據(jù)生成過(guò)程中使用的主要隨機(jī)性。這包括隨機(jī)選擇一個(gè)層次分類(即英語(yǔ)部分);一個(gè)結(jié)構(gòu)圖(即實(shí)例參數(shù));一個(gè)依賴圖;依賴圖上的算術(shù)計(jì)算;整數(shù)(即隨機(jī)數(shù)生成器);問(wèn)題句子的排列;以及查詢參數(shù)。

論文使用兩個(gè)參數(shù)來(lái)控制數(shù)據(jù)的難度:ip 是實(shí)例參數(shù)的數(shù)量,op 是解決方案操作的數(shù)量;數(shù)據(jù)的難度是這兩個(gè)參數(shù)的遞增函數(shù)。論文將論文的數(shù)據(jù)集稱為 iGSM,以反映這種合成數(shù)據(jù)集可以具有無(wú)限大小的特性。

2.2.4 訓(xùn)練和測(cè)試數(shù)據(jù)集

論文考慮兩類數(shù)據(jù)集。

?在iGSM-med數(shù)據(jù)家族中,論文使用ip ≤ 20。

?在iGSM-hard數(shù)據(jù)家族中,論文使用ip ≤ 28。

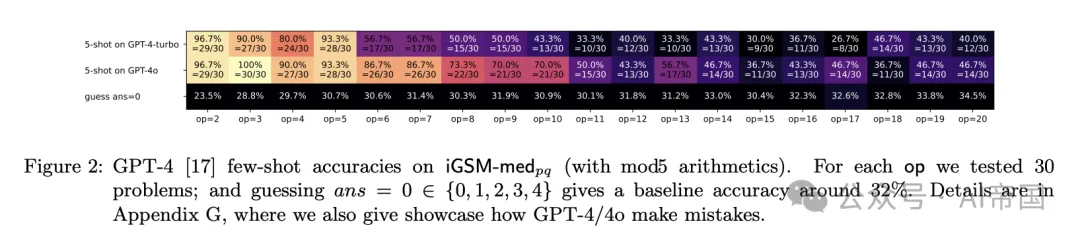

此外,論文使用iGSM-med_pq表示將問(wèn)題放在問(wèn)題陳述之后,iGSM-med_qp表示相反的順序(iGSM-hard也類似)。iGSM-med的難度對(duì)人類來(lái)說(shuō)已經(jīng)相當(dāng)不簡(jiǎn)單(至少不能通過(guò)使用GPT-4/4o進(jìn)行少樣本學(xué)習(xí)來(lái)解決,見(jiàn)圖2)。

*圖2:GPT-4 [17] 在iGSM-medp(含mod5算術(shù))上的少樣本準(zhǔn)確率。對(duì)于每個(gè)操作,論文測(cè)試了30個(gè)問(wèn)題;

命題2.2. 忽略未使用的參數(shù)、數(shù)值、句子順序、英語(yǔ)詞匯、a-z和A-Z字母的選擇,iGSM-medop=15仍然至少有70億個(gè)解決方案模板,而iGSM-hardop=21至少有90萬(wàn)億個(gè)解決方案模板。

數(shù)據(jù)污染問(wèn)題。合成數(shù)學(xué)數(shù)據(jù)生成的一個(gè)目標(biāo)是防止互聯(lián)網(wǎng)數(shù)學(xué)數(shù)據(jù)集中的數(shù)據(jù)污染,如 [22] 所述。雖然可能無(wú)法證明基于互聯(lián)網(wǎng)數(shù)據(jù)訓(xùn)練的模型完全無(wú)污染,但在論文的設(shè)置中,論文可以證明這一點(diǎn):

1.論文進(jìn)行OOD評(píng)估,例如在 op ≥ 28 上,同時(shí)僅提供 op ≤ 21 的訓(xùn)練樣本。

2.論文使用哈希值小于17(mod 23)的解決方案模板(見(jiàn)腳注 11)進(jìn)行訓(xùn)練,并使用大于等于17的進(jìn)行測(cè)試。這確保了訓(xùn)練和測(cè)試之間在模板級(jí)別上沒(méi)有重疊。

2.3 結(jié)果 2-3:總結(jié)模式的行為過(guò)程

論文使用 GPT2 架構(gòu),但將其絕對(duì)位置嵌入替換為旋轉(zhuǎn)位置嵌入,并將其稱為 tPT2 以便于分類。論文主要堅(jiān)持使用 12 層、12 頭、768 維的 GPT2(即 GPT2-small)進(jìn)行實(shí)驗(yàn)。論文在 iGSM-med/iGSM-hard 上使用 768/1024 的上下文長(zhǎng)度進(jìn)行預(yù)訓(xùn)練,并在評(píng)估時(shí)使用 2048 的上下文長(zhǎng)度。更多細(xì)節(jié)參見(jiàn)附錄 F。

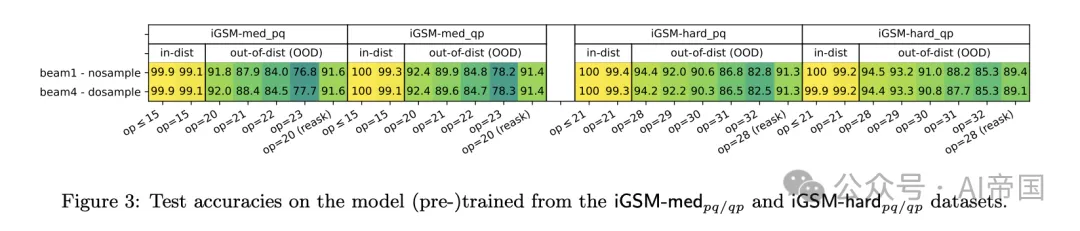

圖3:在iGSM-me p q / q p 和 iGSM-hrd 數(shù)據(jù)集上(預(yù))訓(xùn)練的模型上的測(cè)試準(zhǔn)確率。

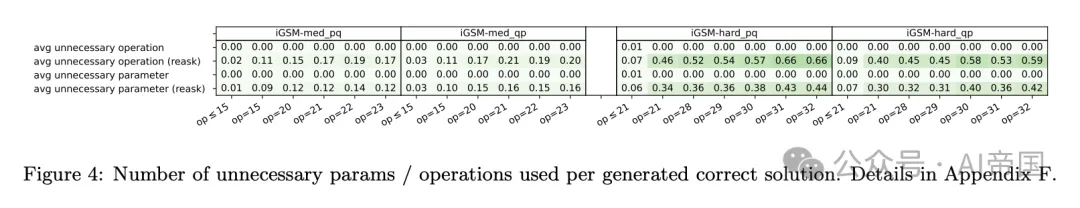

圖4:每生成一個(gè)正確解決方案所使用的不必要參數(shù)/操作數(shù)量

結(jié)果2:準(zhǔn)確性。在充分預(yù)訓(xùn)練后,論文給模型一個(gè)來(lái)自測(cè)試集的問(wèn)題(不含解答),讓它繼續(xù)生成(據(jù)稱是一個(gè)解答followed by一個(gè)答案)。由于論文將自己限制在一個(gè)固定的解答格式中,語(yǔ)言模型可以輕松學(xué)習(xí)這種格式,使論文能夠編寫(xiě)一個(gè)解答解析器來(lái)檢查解答是否完全正確。

結(jié)果2. 圖3顯示,當(dāng)使用iGSM-med或iGSM-hard數(shù)據(jù)預(yù)訓(xùn)練時(shí),GPT2表現(xiàn)良好,即使在更難(即更大op)的數(shù)學(xué)問(wèn)題上進(jìn)行分布外評(píng)估時(shí)也是如此。因此,模型確實(shí)可以學(xué)習(xí)一些推理技能,而不是僅僅記憶解答模板。

這可能讓人想起語(yǔ)言模型在算術(shù)計(jì)算上的長(zhǎng)度泛化能力[13, 23];然而,在論文的案例中,op捕捉了小學(xué)數(shù)學(xué)中的"推理長(zhǎng)度",而論文的模型在測(cè)試時(shí)從未見(jiàn)過(guò)任何與之長(zhǎng)度相同的訓(xùn)練樣本。

這樣的準(zhǔn)確率也表明,論文的iGSM數(shù)據(jù)家族確實(shí)適合預(yù)訓(xùn)練目的,使論文能夠研究LLM如何解決小學(xué)數(shù)學(xué)問(wèn)題。

結(jié)果3:解答冗余度。論文檢查GPT2是否通過(guò)以下方式達(dá)到高準(zhǔn)確率:

?在生成過(guò)程中暴力計(jì)算所有參數(shù)(一種"0級(jí)"推理技能),或

?只計(jì)算給出最短解答所必需的參數(shù)(一種"1級(jí)"推理技能)。

回想一下,論文的iGSM(預(yù)訓(xùn)練)數(shù)據(jù)只包含必要的解答步驟(即CoT),以模擬論文在數(shù)學(xué)問(wèn)題的教科書(shū)解答中看到的情況。例如,如果一個(gè)問(wèn)題描述X=3+2,E=3+X,Y=X+2,并詢問(wèn)Y的值,那么最短的解答應(yīng)該是"X=3+2=5且Y=X+2=7",而不需要計(jì)算E。

結(jié)果3. 圖4顯示,GPT2主要使用"1級(jí)"推理技能解決iGSM問(wèn)題,避免不必要的計(jì)算,即使在分布外評(píng)估時(shí)也是如此。

這一發(fā)現(xiàn)意義重大,因?yàn)樗砻鳎c人類不同,人類通常依賴"反向推理"和草稿紙,通過(guò)從問(wèn)題回溯依賴關(guān)系來(lái)寫(xiě)下必要的參數(shù),而語(yǔ)言模型能夠直接生成最短解答,無(wú)需使用草稿紙。但是,它是如何做到這一點(diǎn)的呢?

這個(gè)發(fā)現(xiàn)強(qiáng)調(diào)了語(yǔ)言模型和人類在解決數(shù)學(xué)問(wèn)題時(shí)的思維過(guò)程差異。它突出了語(yǔ)言模型似乎具有一種直接、高效的推理能力,這種能力與人類常用的解題方法有所不同。這引發(fā)了關(guān)于語(yǔ)言模型內(nèi)部工作機(jī)制的進(jìn)一步探討,這正是下一節(jié)要研究的內(nèi)容。

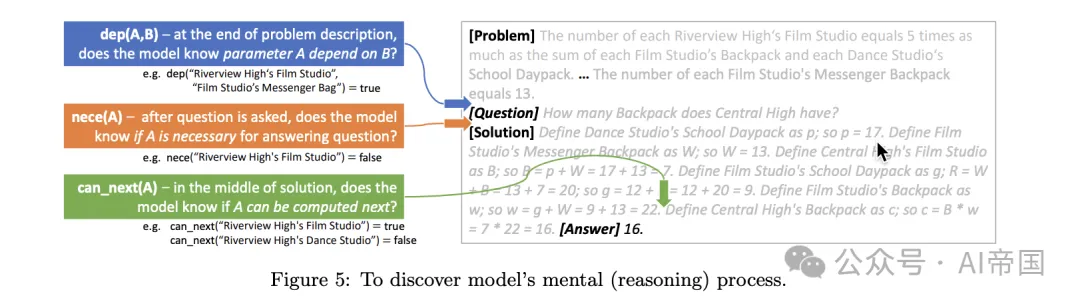

圖5:揭示模型的思維(推理)過(guò)程

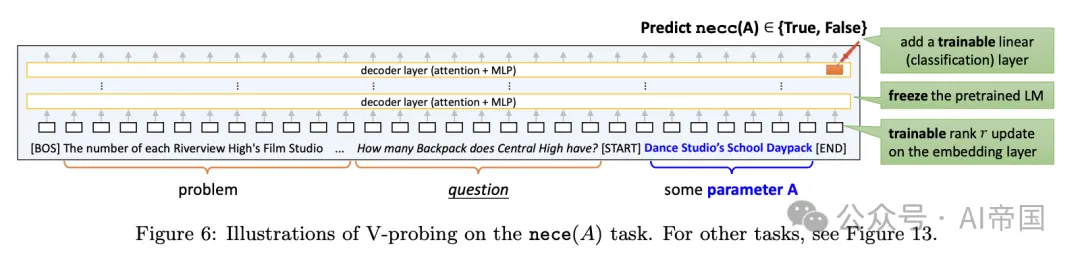

圖 6:V -探查在 nece(A) 任務(wù)上的示例。其他任務(wù)見(jiàn)圖 13。

2.4 結(jié)果 4-5:揭示模型的思維過(guò)程

為了理解模型如何學(xué)習(xí)解決數(shù)學(xué)問(wèn)題,論文提出研究以下探查任務(wù),這些任務(wù)與人類問(wèn)題解決策略緊密對(duì)齊:

?nece (A):參數(shù) A 是否為計(jì)算答案所必需。

?dep (A, B):在給定問(wèn)題陳述下,參數(shù) A 是否(遞歸地)依賴于參數(shù) B。

?known (A):參數(shù)A 是否已被計(jì)算。

?value (A):參數(shù) A 的值(介于 0-22 之間,或 23 如果 known (A)=false)。

?can_next (A):參數(shù)A 是否可以在下一個(gè)解決方案句子中計(jì)算(即其所有前驅(qū)均已計(jì)算)。注意,A 可能并非回答問(wèn)題所必需。

?nece_next (A):參數(shù)A 是否同時(shí)滿足 can_next(A) 和 nece (A)。

為了生成最短解決方案,模型必須在其思維過(guò)程中識(shí)別所有 A中 的 nece(A)。這是因?yàn)?nece (A) 是否為真直接對(duì)應(yīng)于是否存在計(jì)算 A 的解決方案句子。然而,模型何時(shí)識(shí)別這一點(diǎn),以及它是如何存儲(chǔ)的?同樣,它是否識(shí)別參數(shù)間的依賴關(guān)系(dep)?如果是,這一思維過(guò)程何時(shí)完成?此外,在解決方案生成過(guò)程中,模型是否始終跟蹤每個(gè)參數(shù) A 的值(value, known)?模型是否在心中知道所有可在下一句子中計(jì)算的可能參數(shù) A(can next)?或者它只關(guān)注那些既準(zhǔn)備就緒又必要的參數(shù) A(nece next)?

這里提出了一種探測(cè)技術(shù)(probing technique),以回答所有這些問(wèn)題。

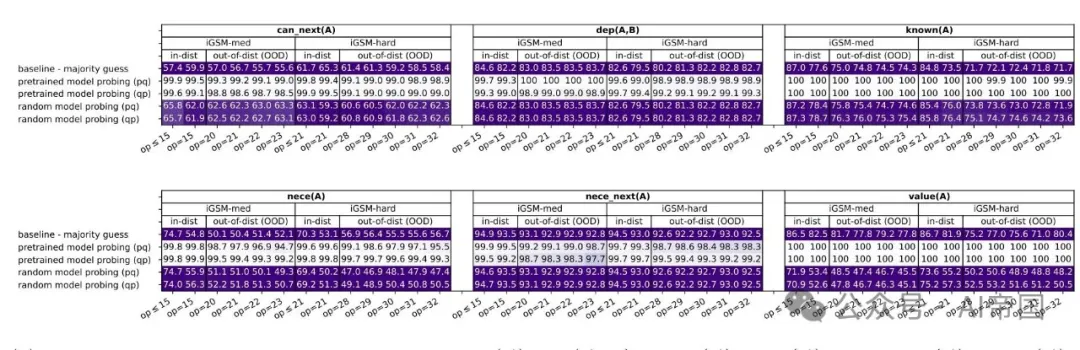

(a) 六個(gè)任務(wù)的探測(cè)準(zhǔn)確率:can next ( A ) ,dep ( A, B ) ,known ( A ) ,nece(A),ecenext ( A ) ,value ( A ) 。

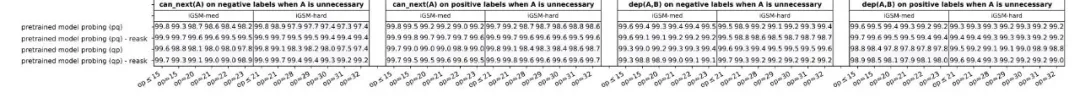

(b) 針對(duì)正/負(fù)標(biāo)簽中A為不必要情況的下一個(gè)(A)、依賴(A, B)的探測(cè)準(zhǔn)確率

圖7:V-探測(cè)準(zhǔn)確率(對(duì)于beam=1;beam=4的結(jié)果幾乎相同)。詳細(xì)信息見(jiàn)附錄F.2

2.4.1 V-探測(cè):一種近似線性探測(cè)方法

如圖所示,論文在問(wèn)題描述結(jié)束時(shí)對(duì)依賴任務(wù)進(jìn)行探測(cè),在必要任務(wù)的問(wèn)題描述結(jié)束時(shí)進(jìn)行探測(cè)。對(duì)于其他任務(wù),論文在每個(gè)解決方案句子的末尾(包括第一個(gè)解決方案句子的開(kāi)始)進(jìn)行探測(cè)。

回想一下,標(biāo)準(zhǔn)線性探測(cè)涉及凍結(jié)預(yù)訓(xùn)練的語(yǔ)言模型,并檢查某個(gè)屬性是否在給定令牌位置的隱藏層(通常是最后一層)上線性編碼。這是通過(guò)在隱藏狀態(tài)上引入一個(gè)可訓(xùn)練的線性分類器,并對(duì)該屬性執(zhí)行輕量級(jí)微調(diào)任務(wù)來(lái)完成的。

論文的設(shè)置更為復(fù)雜,因?yàn)閷傩跃哂幸粋€(gè)或兩個(gè)條件變量A和B,以純英文描述。為了處理這一點(diǎn),論文將數(shù)學(xué)問(wèn)題截?cái)嗟教綔y(cè)位置,并在A(或A, B)的描述周圍附加令牌[START]和[END]。然后,論文從[END]的令牌位置探測(cè),看該屬性是否在最后一層上線性編碼。

與標(biāo)準(zhǔn)線性探測(cè)不同,為了考慮輸入變化,論文引入了一個(gè)小的可訓(xùn)練的秩-8(線性)更新到輸入嵌入層。論文凍結(jié)預(yù)訓(xùn)練的語(yǔ)言模型,并對(duì)所需的屬性同時(shí)微調(diào)線性分類器和秩-8更新。論文將其稱為V(變量)-探測(cè)。必要(A)探測(cè)任務(wù)的示意圖如圖6所示。

論文計(jì)算了從iGSM預(yù)訓(xùn)練的語(yǔ)言模型的V-探測(cè)準(zhǔn)確率,并將其與隨機(jī)初始化的transformer模型的V-探測(cè)準(zhǔn)確率進(jìn)行比較。如果前者的準(zhǔn)確率顯著更高,論文可以得出結(jié)論,探測(cè)信號(hào)一定來(lái)自(或非常接近來(lái)自)預(yù)訓(xùn)練權(quán)重,而不是(輕量級(jí)的)微調(diào)階段。

2.4.2 探測(cè)結(jié)果與發(fā)現(xiàn)

論文在圖7中展示了論文的探測(cè)結(jié)果。與多數(shù)猜測(cè)和隨機(jī)模型探測(cè)相比,所有任務(wù)的探測(cè)準(zhǔn)確率都很高——除了非常困難的OOD情況(即,fo lare op,模型在這些情況下的生成準(zhǔn)確率在圖3中已經(jīng)下降到S U Y_{0)。

結(jié)果4:模型像人類一樣解決數(shù)學(xué)問(wèn)題。論文有以下觀察:

?在生成解決方案時(shí),模型不僅記得哪些參數(shù)已經(jīng)計(jì)算過(guò),哪些還沒(méi)有(值,已知),還知道接下來(lái)可以計(jì)算哪些參數(shù)(可以下一步,必要下一步)。這些能力確保模型可以像人類解決問(wèn)題的技能一樣,一步一步地解決給定的數(shù)學(xué)問(wèn)題。

?到問(wèn)題描述結(jié)束時(shí),模型已經(jīng)知道完整的必要參數(shù)列表(必要)。這表明模型已經(jīng)學(xué)會(huì)了在開(kāi)始生成解決方案之前,通過(guò)識(shí)別必要的參數(shù)來(lái)提前規(guī)劃。這與人類行為一致,除了模型在心里計(jì)劃,而人類通常會(huì)寫(xiě)下這些計(jì)劃。這進(jìn)一步證實(shí)了模型達(dá)到了第3節(jié)中討論的“一級(jí)”推理技能。

結(jié)果 5:模型學(xué)習(xí)超越人類的推理技能。值得注意的是,模型學(xué)習(xí)器 (A, B) 和 can-next (A),即使對(duì)于回答問(wèn)題不必要的參數(shù)A,如圖 7(b) 所示。這與人類解決問(wèn)題的方式不同,論文通常從問(wèn)題出發(fā)進(jìn)行逆向推理以識(shí)別必要的參數(shù),往往忽略了不必要的參數(shù) [19]。相比之下,語(yǔ)言模型可以在問(wèn)題提出之前就在頭腦中預(yù)計(jì)算所有配對(duì)的依賴圖 dep(A, B)。論文認(rèn)為這是一種與人類行為或思維過(guò)程非常不同的“二級(jí)”推理技能。

因此,盡管這一技能對(duì)于解決數(shù)學(xué)問(wèn)題并非必需,且預(yù)訓(xùn)練數(shù)據(jù)并未教授模型計(jì)算“全對(duì)依賴性”——僅要求計(jì)算必要的參數(shù)——模型在訓(xùn)練后仍能自行發(fā)現(xiàn)這一技能。這使得模型能夠?qū)λ?tīng)到的各種關(guān)系進(jìn)行排序,這一技能對(duì)于未來(lái)的任務(wù)(通過(guò)指令微調(diào))可能非常有用。據(jù)論文所知,這可能是語(yǔ)言模型在預(yù)訓(xùn)練數(shù)據(jù)所需技能之外獲得能力的首次證據(jù);這也可能是AGI中“G”(即通用性)的初步信號(hào)(泛化到預(yù)訓(xùn)練數(shù)據(jù)中未教授的技能)。

推論:逆向思維過(guò)程。AGI成功的關(guān)鍵問(wèn)題之一是“逆向思維過(guò)程”(例如,“因?yàn)槲蚁胗?jì)算X,但X依賴于Y且Y依賴于Z,所以讓我先計(jì)算Z”)是否需要在訓(xùn)練數(shù)據(jù)中明確包含。這與CoT不同,CoT將復(fù)雜計(jì)算分解為簡(jiǎn)單步驟,但仍需規(guī)劃決定首先計(jì)算哪個(gè)步驟。

論文的發(fā)現(xiàn)表明,至少對(duì)于小學(xué)數(shù)學(xué)問(wèn)題,在有充足數(shù)據(jù)的情況下,這一逆向思維過(guò)程可以通過(guò)語(yǔ)言建模自主學(xué)習(xí),無(wú)需直接包含在訓(xùn)練數(shù)據(jù)中。

2.5 結(jié)果6:解釋模型的錯(cuò)誤

論文進(jìn)一步探討了探針測(cè)試結(jié)果與模型生成解決方案之間的關(guān)系,重點(diǎn)關(guān)注兩個(gè)問(wèn)題:(1)模型何時(shí)正確回答但包含了不必要的參數(shù)?(2) 是什么導(dǎo)致了錯(cuò)誤的答案?論文的目標(biāo)是確定模型的這種錯(cuò)誤行為是否與模型心理過(guò)程中的錯(cuò)誤相一致(通過(guò)探查)。

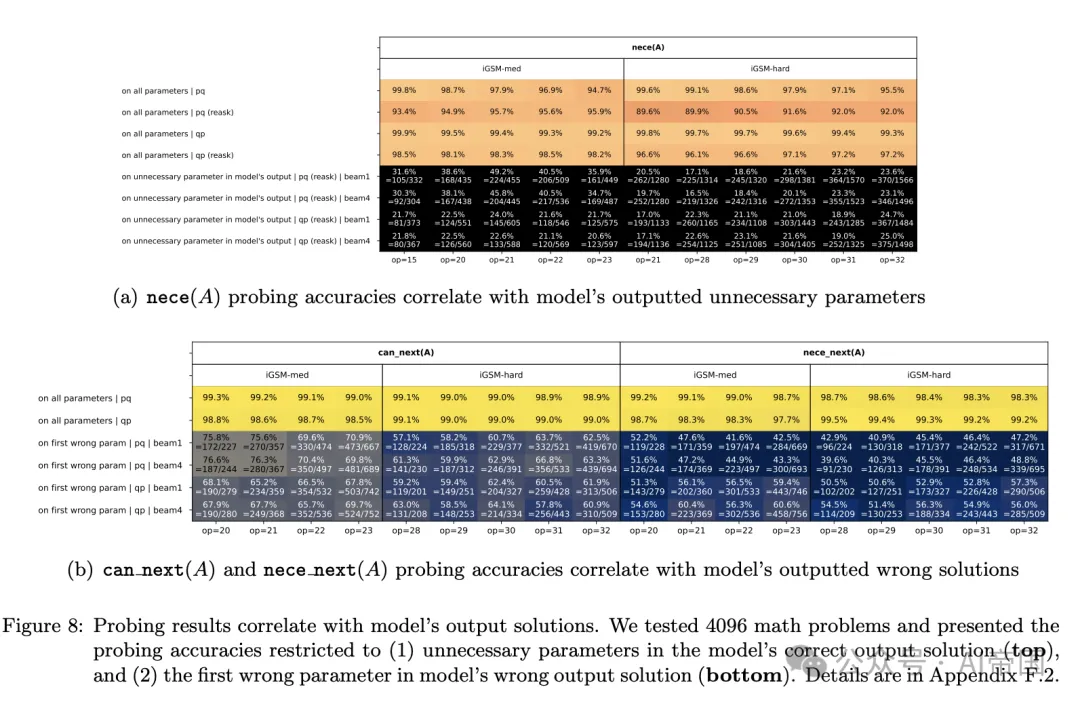

圖8:探針測(cè)試結(jié)果與模型輸出解決方案的相關(guān)性。論文測(cè)試了4096個(gè)數(shù)學(xué)問(wèn)題,并展示了探針準(zhǔn)確率限制在(1)模型正確輸出解決方案中的不必要參數(shù)(頂部),以及(2)模型錯(cuò)誤輸出解決方案中的第一個(gè)錯(cuò)誤參數(shù)(底部)

對(duì)于第一個(gè)問(wèn)題,鑒于模型很少產(chǎn)生比必要步驟更長(zhǎng)的解決方案(見(jiàn)圖 4),論文轉(zhuǎn)向了分布外的重新提問(wèn)數(shù)據(jù)進(jìn)行評(píng)估。17 在這類數(shù)據(jù)上,預(yù)訓(xùn)練模型平均每條解決方案產(chǎn)生約 0.5 個(gè)不必要參數(shù),即使對(duì)于 op=32(見(jiàn)圖 4)。論文檢查了這些不必要的參數(shù) A 是否在探查任務(wù)中被錯(cuò)誤地預(yù)測(cè)為必要 e ( A )= 真。圖 8 ( a ) 顯示,這往往是事實(shí),因此語(yǔ)言模型產(chǎn)生帶有不必要步驟的解決方案,是因?yàn)樗鼈冊(cè)谛睦硪?guī)劃階段出現(xiàn)了錯(cuò)誤。

對(duì)于第二個(gè)問(wèn)題,論文關(guān)注模型的錯(cuò)誤解決方案及其第一個(gè)錯(cuò)誤參數(shù)。(利用合成數(shù)據(jù),論文可以輕松識(shí)別這些參數(shù)。)論文在圖 8 ( b ) 中的發(fā)現(xiàn)表明,模型的錯(cuò)誤主要源于錯(cuò)誤地預(yù)測(cè)了下一個(gè)必要 ( A ) 或下一個(gè)可能 ( A ) 為真。

結(jié)果6(圖8):基于這些結(jié)果,論文得出結(jié)論:

?語(yǔ)言模型所犯的許多推理錯(cuò)誤是有系統(tǒng)的,根源在于其心理過(guò)程中的錯(cuò)誤,而非僅僅是生成過(guò)程中的隨機(jī)錯(cuò)誤。

?模型在開(kāi)口之前(即,在它說(shuō)出第一個(gè)解決方案步驟之前),可以通過(guò)探查其內(nèi)部狀態(tài)發(fā)現(xiàn)其部分錯(cuò)誤。

論文還觀察到,GPT-4/4o 通過(guò)輸出不必要參數(shù)或堅(jiān)持計(jì)算參數(shù) A 使得 can next(A) = false(參見(jiàn)附錄 G)。這進(jìn)一步暗示論文的發(fā)現(xiàn)可能具有更廣泛的適用性。

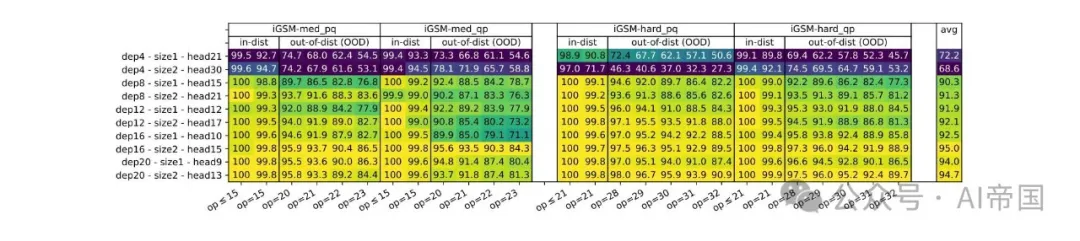

圖 9:在 iGSM 數(shù)據(jù)集上預(yù)訓(xùn)練的不同深度/寬度的 GPT2 模型的準(zhǔn)確率

2.6 結(jié)果 7-8:深度與推理長(zhǎng)度

論文的控制數(shù)據(jù)集使得能夠系統(tǒng)地探索語(yǔ)言模型深度與其推理長(zhǎng)度之間的關(guān)系。

近期研究表明,對(duì)于知識(shí)存儲(chǔ)和提取,僅模型大小至關(guān)重要(即使是 2 層transformer。此外,OpenAI 的開(kāi)創(chuàng)性縮放定律論 和深度學(xué)習(xí)的理論研究均表明,模型深度/寬度可能在普遍范圍內(nèi)影響甚微。與這些發(fā)現(xiàn)相反,論文提出了以下觀點(diǎn):

結(jié)果 7(圖 9)。語(yǔ)言模型深度對(duì)數(shù)學(xué)推理至關(guān)重要。

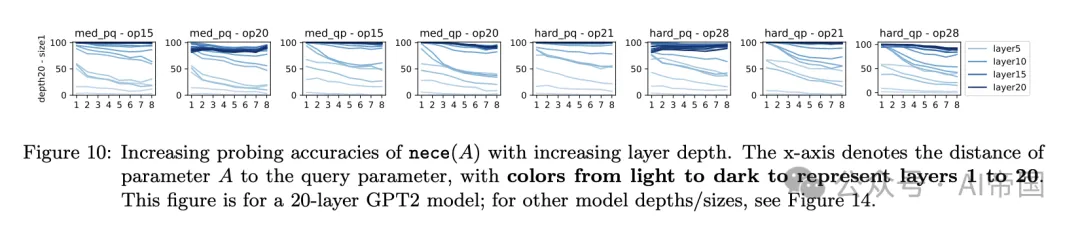

接下來(lái),論文試圖揭示為何如此。論文深入研究了深度如何通過(guò)必要的探查任務(wù)影響數(shù)學(xué)問(wèn)題解決能力,重點(diǎn)關(guān)注距離查詢參數(shù) t 處的必要參數(shù),4/8/12/16/20。這些參數(shù)均具有必要性 (A) = true,但論文可以探查模型以觀察它們?cè)诓煌[藏層預(yù)測(cè)必要性 (A) 的準(zhǔn)確度。

圖 10 展示了論文的結(jié)果。它揭示了模型層級(jí)、推理準(zhǔn)確度與心理推理深度之間的關(guān)聯(lián)。較淺層擅長(zhǎng)預(yù)測(cè)接近查詢的參數(shù) A 的必要性 (A),而較深層更準(zhǔn)確,能夠預(yù)測(cè)遠(yuǎn)離查詢的參數(shù)的必要性 (A)。這表明模型在規(guī)劃階段采用逐層推理,遞歸地識(shí)別查詢所依賴的所有參數(shù),并且:

結(jié)果 8(圖 10+14)。語(yǔ)言模型深度至關(guān)重要,可能是因?yàn)槠潆[藏(心理)推理過(guò)程的復(fù)雜性。對(duì)于 t 步心理推理,例如對(duì)距離查詢 t 的參數(shù) A 進(jìn)行心理計(jì)算必要性 (A),可能需要更深的模型以適應(yīng)更大的 t,假設(shè)所有其他超參數(shù)保持不變。

圖 10:隨著層深度的增加,nece(A)的探測(cè)準(zhǔn)確性提高。x軸表示參數(shù)A與查詢參數(shù)之間的距離,顏色從淺到深代表第1層到第20層。此圖針對(duì)20層的GPT2模型;其他模型深度/尺寸,參見(jiàn)圖14。

論文在此提出兩點(diǎn)聲明。首先,如果將“逆向思維過(guò)程”作為CoT添加到數(shù)據(jù)中,那么深度思維思考就不再必要,降低了語(yǔ)言模型對(duì)深度的要求。然而,在實(shí)踐中,許多此類“思維過(guò)程”可能不會(huì)包含在標(biāo)準(zhǔn)的數(shù)學(xué)解法或一般語(yǔ)言中。

其次,上述說(shuō)法并不意味著“t步的思維思考需要一個(gè)深度為t的transformer”。一個(gè)單一的transformer層(包含多個(gè)子層)實(shí)現(xiàn)t > 1的思維思考步驟是可能的,盡管隨著t的增加,準(zhǔn)確性可能會(huì)降低。論文在此文中避免提供確切的關(guān)聯(lián),因?yàn)檫@很大程度上取決于數(shù)據(jù)分布。

本文轉(zhuǎn)載自 ??AI帝國(guó)??,作者: 無(wú)影寺