解密o1推理過程!DeepSeek-R1-Lite預覽版上線

GPT-o1通過強化學習訓練優化決策策略,并模擬人類思維鏈以深入理解問題,提供更準確的答案,在多個推理任務相關的榜單上實現了巨大的突破。而o1的思維過程是隱藏的。幻方旗下國產大模型公司DeepSeek近期預發布了R1模型,使用了強化學習訓練,回復里包含大量反思和驗證,思維鏈長度可達數萬字,并且沒有像o1一樣隱藏思維鏈。

Demo: ???https://chat.deepseek.com???

[模型和技術報告將會開源]

DeepSeek R1

DeepSeek R1 系列模型采用強化學習進行訓練,具備深度反思和驗證能力,能夠構建長達數萬字的思維鏈。在數學、編程和復雜邏輯推理等任務上,該系列模型展現出與o1-preview相媲美的推理能力,同時向用戶展示了o1未公開的完整思考路徑。

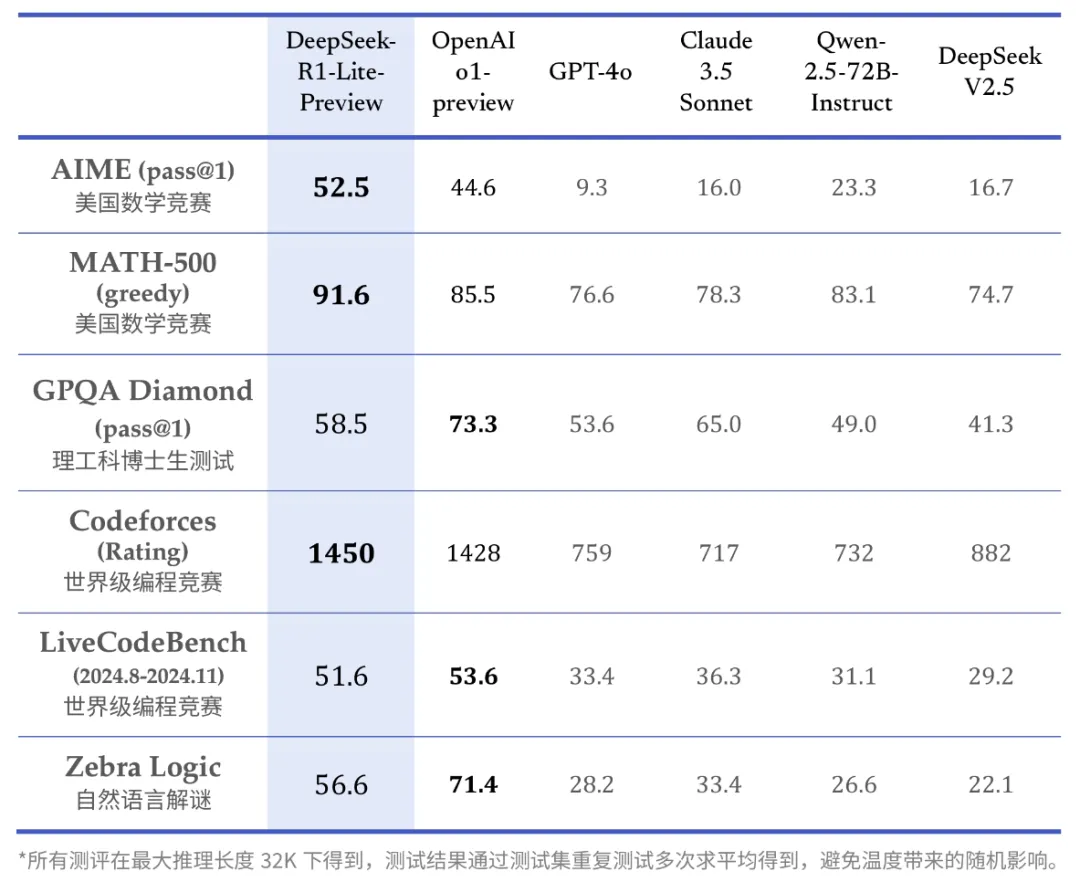

DeepSeek-R1-Lite預覽版在包括美國數學競賽(AMC)中最具挑戰性的AIME以及全球頂尖編程競賽(Codeforces)在內的多個權威評測中表現突出,成績顯著優于GPT-4o等知名模型。以下是DeepSeek-R1-Lite在這些評測中的得分情況:

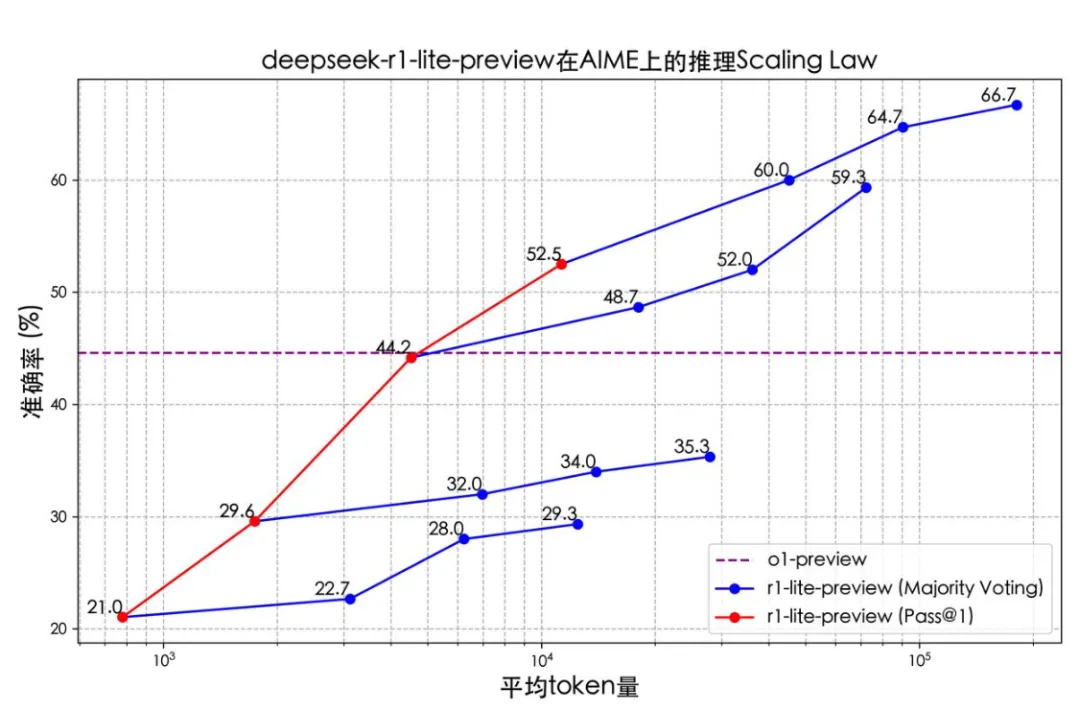

DeepSeek-R1-Lite的推理過程不僅長,還涵蓋了廣泛的反思和驗證步驟。下面的圖表清晰地展示了該模型在數學競賽中的得分與其允許的思考長度之間存在密切的正相關關系。

紅色實線展示了模型所能達到的準確率與所給定的推理長度呈正相關;相比傳統的多次采樣+投票,增加模型思維鏈長度似乎性價比更高。

正式版 DeepSeek-R1 模型將完全開源,技術報告也會公開。

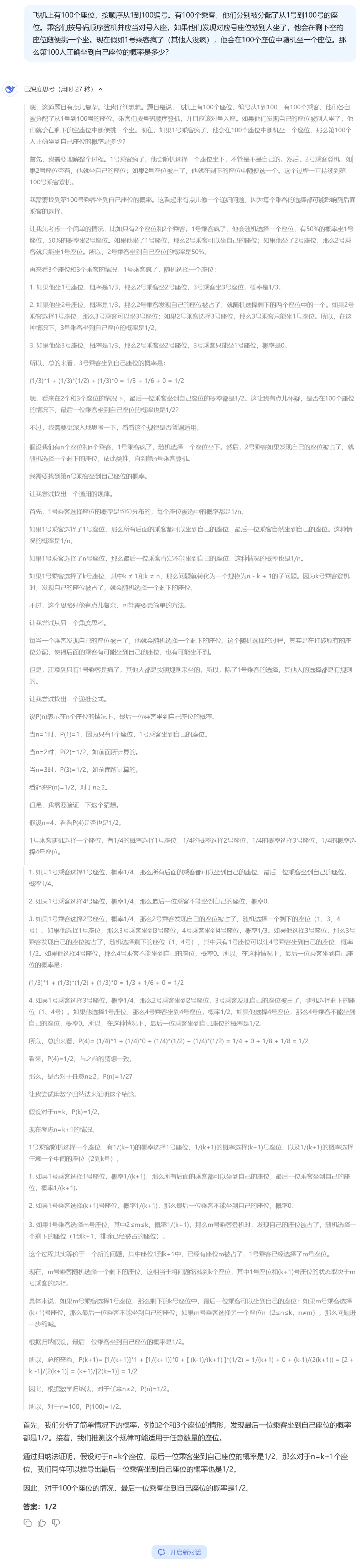

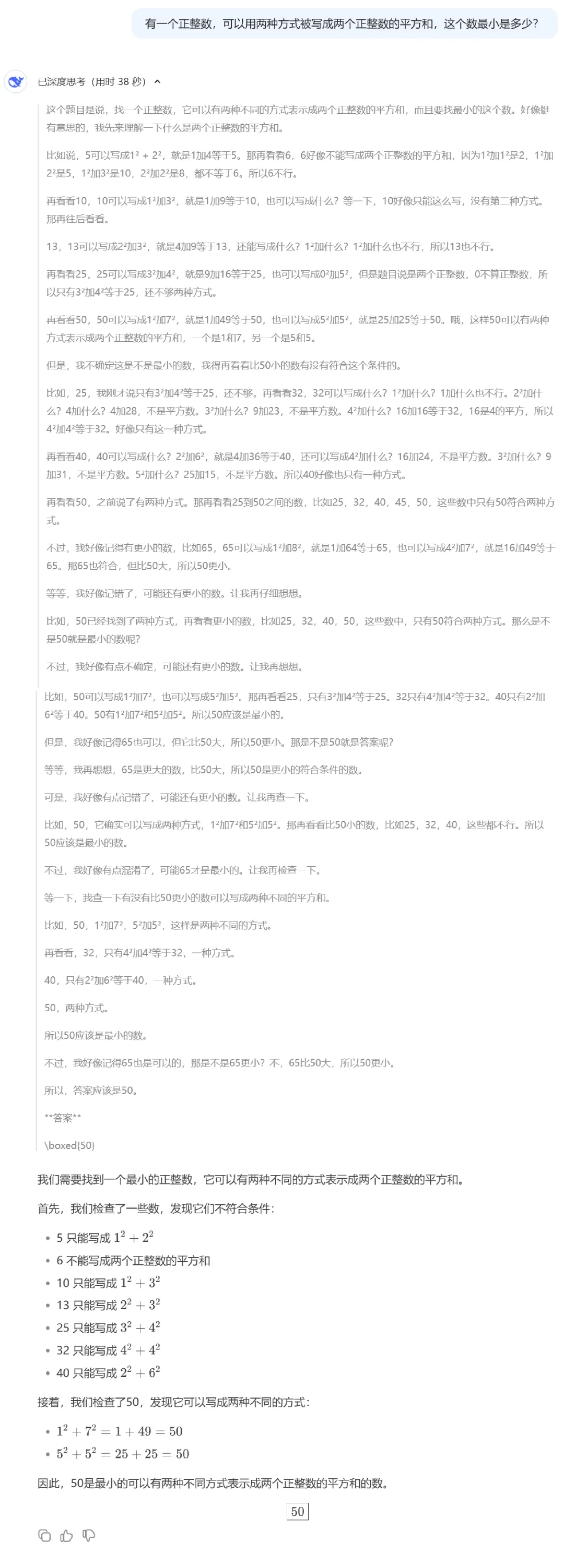

思維鏈效果展示:

本文轉載自公眾號思源數據科學 作者:思源Source

標簽

贊

收藏

回復

分享

微博

QQ

微信

舉報

回復

相關推薦