AI科學家:大模型全自動化撰寫科研論文 原創

摘要

人工通用智能的一個重大挑戰是開發能夠進行科學研究和發現新知識的智能體。雖然當前的前沿模型已經用于輔助人類科學家,如頭腦風暴、編寫代碼或預測任務,但它們仍然只完成了科學過程的一小部分。本論文提出了第一個用于完全自動化科學發現的綜合框架,使前沿大型語言模型(LLMs)能夠獨立進行研究并傳達其發現。我們介紹了AI科學家,它能夠生成新穎的研究想法,編寫代碼,執行實驗,展示結果,通過撰寫完整的科學論文來描述其發現,并隨后進行模擬的審稿過程進行評估。原則上,這一過程可以反復進行,以開放的方式迭代發展思想,并將其添加到一個不斷增長的知識檔案中,像人類科學界一樣運作。我們通過將這一方法應用于機器學習的三個不同子領域:擴散建模、基于Transformer的語言建模和學習動態,展示了其多功能性。每個想法都得以實現并發展為一篇完整的論文,其成本低至每篇不到15美元,展示了該框架在民主化研究和顯著加速科學進步方面的潛力。為了評估生成的論文,我們設計并驗證了一種自動化審稿人,我們展示了其在評估論文得分時達到近乎人類的性能。AI科學家可以生成超過頂級機器學習會議接受標準的論文,這標志著機器學習科學發現新時代的開始,將AI代理的變革性優勢帶入AI本身的整個研究過程中,使我們更接近于一個在世界上最具挑戰性的問題上釋放無盡的創造力和創新的世界。我們的代碼已在???https://github.com/SakanaAI/AI-Scientist??開源。

1、引言

現代科學方法(Chalmers, 2013;Dewey, 1910;Jevons, 1877)可以說是啟蒙運動的最大成就之一。傳統上,一名人類研究者會收集背景知識,提出一組可能的假設以供測試,設計評估程序,收集不同假設的證據,最后評估并傳達他們的發現。之后,產生的手稿會經過同行評審,并經過隨后的幾輪修訂。這個過程已經導致了無數的科學技術突破,極大地改善了人類的生活質量。然而,這一迭代過程本質上受到人類研究者創造力、背景知識和有限時間的限制。在人工智能領域,研究者們設想通過使用人工智能來自動化AI研究的可能性(Schmidhuber, 1991, 2010a, b, 2012),這引發了“AI生成算法”的概念(Clune, 2019)。最近,基礎模型在其通用能力方面取得了巨大的進步(Anthropic, 2024;Google DeepMind Gemini Team, 2023;Llama Team, 2024;OpenAI, 2023),但它們目前僅在加速研究流程的部分環節中展示了潛力,例如撰寫科學手稿(Altm?e et al., 2023)、作為頭腦風暴的靈感來源(Girotra et al., 2023),或作為編程助手(Gauthier, 2024)。迄今為止,社區尚未展示在沒有人類參與的情況下執行整個研究任務的可能性。

傳統的研究項目自動化方法迄今為止依賴于嚴格限制潛在發現的搜索空間,這大大限制了探索的范圍,并需要大量的人類專業知識和設計。例如,材料發現(Merchant et al., 2023;Pyzer-Knapp et al., 2022)和合成生物學(Hayes et al., 2024;Jumper et al., 2021)領域取得了顯著進展,探索被限制在預定義參數的已充分表征領域內,這種方法允許有針對性的進展,但限制了更廣泛、開放式的發現,并且只涵蓋了科學過程的某些子集,而未包括諸如手稿準備等任務。在機器學習領域,研究自動化主要限于超參數和架構搜索(He et al., 2021;Hutter et al., 2019;Lu et al., 2022b;Wan et al., 2021, 2022)或算法發現(Alet et al., 2020;Chen et al., 2024b;Kirsch et al., 2019;Lange et al., 2023a, b;Lu et al., 2022a;Metz et al., 2022)內的手工制作搜索空間。最近在大語言模型(LLMs)方面的進展表明有可能擴展搜索空間到更廣泛的代碼級別解決方案(Faldor et al., 2024;Lehman et al., 2022;Lu et al., 2024a;Ma et al., 2023)。然而,這些方法仍然受到嚴格定義的搜索空間和目標的限制,限制了可能發現的廣度和深度。

在本文中,我們介紹了AI科學家,這是第一個用于端到端論文生成的完全自動化和可擴展的管道,由基礎模型的最新進展提供支持。在給定廣泛的研究方向和一個簡單的初始代碼庫的情況下,AI科學家可以無縫地執行想法生成、文獻搜索、實驗規劃、實驗迭代、手稿寫作和同行評審,從而產生具有洞察力的論文。此外,AI科學家可以在一個開放式循環中運行,基于其之前的科學發現改進下一代想法。這使我們能夠以令人驚訝的低成本(大約15美元/篇)加速科學迭代的緩慢過程,并且這代表了一步邁向將世界上日益增長的計算資源轉化為21世紀核心挑戰所需的科學突破的愿景。我們主要聚焦于機器學習(ML)應用,但這一方法可以更廣泛地應用于幾乎任何其他學科,如生物學或物理學,前提是存在一種自動執行實驗的方式(Arnold, 2022;Kehoe et al., 2015;Zucchelli et al., 2021)。

通過利用現代LLM框架,如鏈式思考(Wei et al., 2022)和自我反思(Shinn et al., 2024)來改善決策,AI科學家能夠生成自己的科學想法和假設,并為測試它們制定計劃。接下來,AI科學家在最先進的編碼助手Aider(Gauthier, 2024)的指導下,實施計劃并執行實驗以收集一組計算結果,這些結果隨后被用來撰寫科學論文。AI科學家隨后會根據標準機器學習會議的指南進行自動化的論文審查。最后,AI科學家將完成的想法和審稿人反饋添加到其科學發現檔案中,并重復這一過程。至關重要的是,AI科學家生成的論文和實驗成果使我們能夠事后輕松解釋和評估其發現,從而使人類科學家也能從中受益。

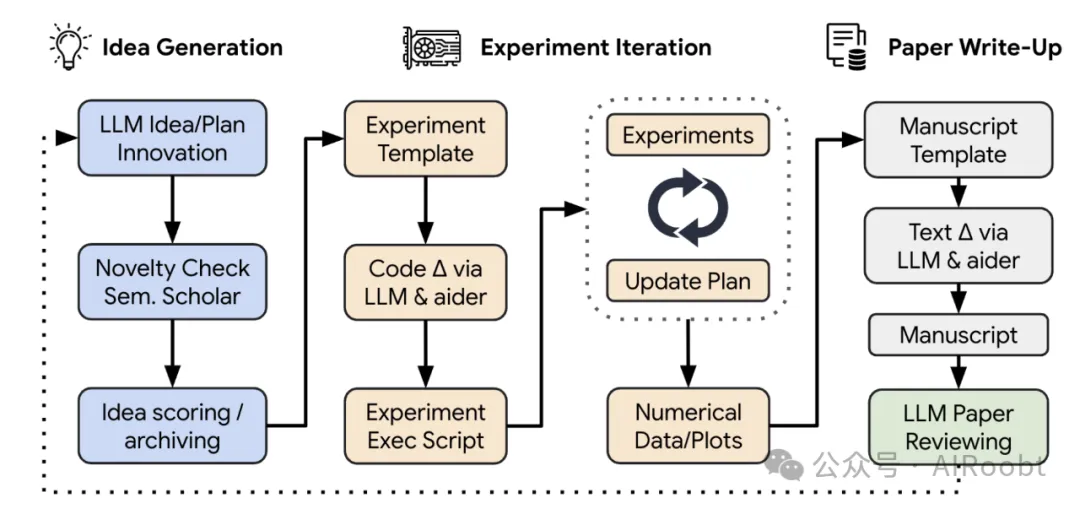

圖1 | 《AI科學家》的概念圖,這是一個由LLM驅動的端到端科學發現過程。《AI科學家》首先創造并評估一組想法的新穎性。接著,它確定如何測試這些假設,包括通過編輯代碼庫來編寫必要的代碼,這些代碼庫由自動代碼生成的最新進展提供支持。隨后,實驗被自動執行,收集一組包括數值分數和視覺總結(如圖表或表格)的結果。結果將被動機分析、解釋并匯總在一份LaTeX報告中。最后,《AI科學家》根據標準機器學習會議的當前實踐生成自動化審查。審查結果可以用來改進項目,或作為未來開放式科學發現的反饋。

我們的貢獻總結如下:

1. 我們引入了第一個用于機器學習研究的端到端完全自動化科學發現框架,由前沿的LLMs提供支持。這個完全自動化的過程包括想法生成、實驗設計、執行、結果可視化以及將其寫成完整的手稿。

2. 為了評估生成論文的質量,我們在第4部分中引入了基于基礎模型的審稿流程。當在ICLR 2022的OpenReview數據上進行評估時,我們的審稿流程在多項評價指標上(如平衡準確率為65%對66%)實現了近乎人類水平的表現。審稿進一步使得AI科學家能夠選擇“發表”的最佳想法,并通過重復這一過程,在人類科學界的模式下不斷積累新的科學發現。

3. AI科學家可以在一周內生成數百篇有趣的中等質量的論文。在本報告中,我們重點展示了擴散建模、語言建模和grokking中的一些新穎見解。我們在第5部分對一篇選定的論文進行了深入的案例研究,并在第6部分展示了匯總結果。

4.我們在第8和第9部分中對我們的方法的局限性、倫理考慮和未來展望進行了廣泛討論。

2、背景

大語言模型(LLMs)

在本文中,我們使用自回歸大語言模型(LLMs,如Anthropic,2023年;Google DeepMind Gemini團隊,2023年;Llama團隊,2024年;OpenAI,2023年;Zhu等人,2024年)構建了一個自動化科學家。這些模型通過對給定前序詞元的條件概率進行建模并在測試時進行采樣來生成文本補全。結合龐大的數據和模型擴展,這使得LLMs不僅能夠生成連貫的文本,還能夠表現出類似人類的能力,包括常識知識(Talmor等,2019年)、推理(Wei等,2022年)和編寫代碼的能力(Chen等,2021年;Xu等,2022年)。

LLM代理框架

LLMs的典型應用通常涉及將模型嵌入到“代理”(Wang等,2024年)框架中,包括以下幾種可能性:結構化語言查詢(如少量示例提示(Brown等,2020年))、鼓勵推理過程(如鏈式思考(Wei等,2022年))或要求模型迭代地完善其輸出(如自我反思(Shinn等,2024年))。這些方法利用了語言模型在上下文中的學習能力(Olsson等,2022年),可以顯著提高其在許多任務中的性能、穩健性和可靠性。

3. AI科學家

概述

AI科學家主要包括三個階段(見圖1):(1)想法生成,(2)實驗迭代,和(3)論文寫作。在寫作完成后,我們引入并驗證了一個LLM生成的審稿流程,用于評估生成的論文質量(第4部分)。我們為AI科學家提供了一個起始代碼模板,該模板可重現一個來自流行模型或基準的輕量級基線訓練運行。例如,這可能是訓練一個小型transformer在莎士比亞作品上的代碼,這是自然語言處理中的經典概念驗證訓練運行,可以在幾分鐘內完成。AI科學家隨后可以自由探索任何可能的研究方向。模板還包括一個LaTeX文件夾,其中包含樣式文件和章節標題,以及簡單的繪圖代碼。我們在第6部分中進一步詳細說明了這些模板,但一般來說,每次運行都從與主題領域相關的小規模代表性實驗開始。重點放在小規模實驗并不是我們方法的根本限制,而僅僅是由于計算效率和我們的計算資源限制。我們在附錄A中提供了所有階段的提示。

1. 想法生成

在提供的起始模板下,AI科學家首先“頭腦風暴”一系列新穎的研究方向。我們從進化計算和開放式研究中獲得靈感(Brant和Stanley,2017年;Lehman等,2008年;Stanley,2019年;Stanley等,2017年),并使用LLMs作為變異操作符(Faldor等,2024年;Lehman等,2022年;Lu等,2024年b;Zhang等,2024年)迭代增長一個想法檔案。每個想法包括一個描述、實驗執行計劃以及對有趣性、新穎性和可行性的自我評估分數。在每次迭代中,我們會提示語言模型基于現有檔案生成一個有趣的新研究方向,其中可以包括已完成的想法的數值評審分數。我們使用多輪鏈式思考(Wei等,2022年)和自我反思(Shinn等,2024年)來改進和發展每個想法。在想法生成之后,我們通過連接語言模型與Semantic Scholar API(Fricke,2018年)和網絡訪問工具(Schick等,2024年)來過濾想法。這使得AI科學家能夠丟棄與現有文獻過于相似的想法。

2. 實驗迭代

在給定一個想法和模板后,AI科學家的第二階段首先執行提議的實驗,然后可視化其結果以便后續寫作。AI科學家使用Aider首先規劃一系列要運行的實驗,然后按順序執行它們。我們通過在失敗或超時(如實驗運行時間過長)時返回任何錯誤給Aider修復代碼并重新嘗試多達四次來使這一過程更加穩健。在每次實驗完成后,Aider會記錄結果并以實驗日記的形式記錄筆記。目前,它僅基于文本進行操作,但在未來版本中,這可以包括數據可視化或任何模式。根據結果,它隨后重新計劃并實施下一個實驗。這個過程最多重復五次。在實驗完成后,Aider會被提示編輯一個繪圖腳本,使用Python創建論文的圖形。AI科學家會寫下每個圖表的內容描述,使得保存的圖形和實驗筆記提供了撰寫論文所需的所有信息。在所有步驟中,Aider都會查看其執行歷史。

3. 論文寫作

AI科學家的第三階段以標準機器學習會議論文的形式生成一份簡潔且信息豐富的進展報告,采用LaTeX格式。我們注意到,編寫好的LaTeX即使對于有經驗的研究人員來說也需要一些時間,因此我們采取了若干步驟來使這一過程更加穩健。具體包括以下內容:

(a) 分章節文本生成:記錄的筆記和圖表會被傳遞給Aider,Aider會逐章填充一個空白的會議模板。按照引言、背景、方法、實驗設置、結果和結論的順序(除相關工作外所有章節)。論文之前寫的所有章節都在語言模型的上下文中。我們根據流行的“如何撰寫ML論文”指南在附錄A.3中提供了簡要提示和指南。在寫作的每一步,Aider都會被提示僅使用真實實驗結果(以筆記和圖表形式生成),并減少幻覺現象。每個章節在最初寫作時都會經過一輪自我反思(Shinn等,2024年)。在此階段不包括引用,并為相關工作部分僅填充一個框架,將在下一個階段完成。

(b) 網絡搜索參考文獻:類似于想法生成,AI科學家被允許進行20輪Semantic Scholar API輪詢,以尋找最相關的文獻,比較和對比已完成的論文,以填寫相關工作部分。這一過程還允許AI科學家選擇任何希望討論的論文,并補充其他章節中缺失的引用。每篇選定論文都會生成簡短的描述,說明引用的位置和方式,然后傳遞給Aider。論文的bibtex會自動附加到LaTeX文件中,以保證正確性。

(c) 精煉:在前兩個階段之后,AI科學家已經完成了初稿,但可能會顯得過于冗長和重復。為了解決這一問題,我們進行了一輪逐章節的最終自我反思,旨在消除任何重復信息,并簡化論文的論點。

(d) 編譯:一旦LaTeX模板被填充了所有適當的結果,就會將其輸入到LaTeX編譯器中。我們使用LaTeX校驗器,并將編譯錯誤反饋給Aider,以便其自動修正任何問題。

以下是文檔中第4部分“自動化論文審稿”的翻譯:

4、 自動化論文審稿

基于LLM的審稿代理

一個有效的科學社區的關鍵組成部分是其審稿系統,該系統用于評估和提高科學論文的質量。為了利用大語言模型模擬這樣的過程,我們設計了一個基于GPT-4o(OpenAI, 2023)的代理來根據Neural Information Processing Systems (NeurIPS)會議的審稿指南進行論文審查。審稿代理使用PyMuPDF解析庫處理PDF手稿的原始文本。輸出內容包括數值評分(健全性、表達、貢獻、整體評分、置信度)、優缺點列表以及初步的二元決策(接受或拒絕)。然后,可以通過基于評分的門限調整對這些決策進行后校準。我們利用這一自動化審稿過程來獲得AI科學家生成的論文的初步評估。我們在附錄A.4中提供了整個審稿提示模板。

評估自動化審稿人

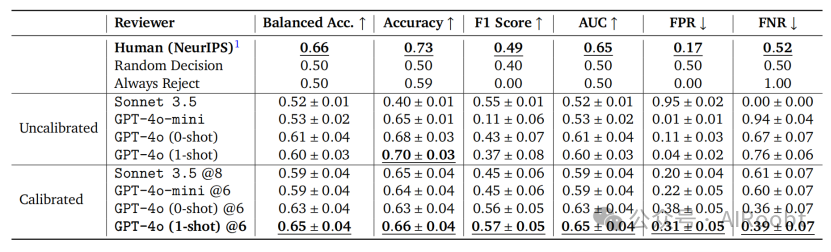

為了評估基于LLM的審稿人的表現,我們將人工生成的決策與從公開可用的OpenReview數據集中提取的500篇ICLR 2022論文的真實數據進行比較。與前一節類似,我們結合了LLM代理中的許多最新進展,以使決策過程更加穩健。更具體地說,我們通過利用自我反思(Shinn等, 2024)、提供少量示例(Wei等, 2022)和響應集成(Wang等, 2022)來改進基礎LLM的決策過程。通過使用GPT-4o,在結合了5輪自我反思、5次集成審查以及來自ICLR 2022審查指南的1個示例后,AI科學家的審稿程序達到了70%的準確率。之后,我們執行了一個基于LLM的元審查,它提示代理充當領域主席(Wang等, 2022)(完整提示見附錄A.4)。雖然這個數字低于NeurIPS 2021一致性實驗中報告的73%的人工準確率(Beygelzimer等, 2021),但自動化審稿人在決策門限設置為6分(NeurIPS審稿指南中的“弱接受”)時實現了超越人類的F1分數(0.57對0.49)和人類水平的AUC(兩者均為0.65)。這一選擇大致對應于被接受論文的平均分數。

考慮到ICLR 2022論文數據集非常不平衡,即它包含更多被拒稿的論文。當考慮一個平衡的數據集時,AI科學家的審稿過程實現了與人類相當的準確率(0.65%對0.66%)。此外,假陰性率(FNR)明顯低于人類基線(0.39對0.52)。因此,基于LLM的審稿代理拒絕的高質量論文較少。然而,假陽性率(FPR)較高(0.31對0.17),這突顯了未來改進的空間。

為了進一步驗證自動化審稿人的表現,我們比較了每篇論文在隨機抽取的OpenReview審稿人之間的總體評分一致性(圖2,左下角)以及在所有審稿人和LLM評分之間的平均一致性(圖2,中下角)。對于500篇ICLR 2022論文的集合,我們發現兩位人類審稿人評分之間的相關性較小(0.14),而LLM評分與審稿人平均分之間的相關性較高(0.18)。總體而言,跨所有指標,結果表明基于LLM的審稿不僅可以提供有價值的反饋(Zheng等, 2024),而且比個體人類審稿人之間的一致性更接近平均人類審稿人的評分。

每次審查的API費用約為0.25到0.50美元。我們還比較了各種其他基礎模型的審稿表現。雖然Claude Sonnet 3.5(Anthropic, 2024)和GPT-4o-mini提供了更具成本效益的方法,但它們的表現明顯更差。

每次審查的API成本約為0.25至0.50美元。我們還比較了其他基礎模型的審稿性能。雖然Claude Sonnet 3.5(Anthropic, 2024)和GPT-4o-mini提供了一種更具成本效益的方法,但它們的表現顯著較差(見表1)。此外,由于持續存在的過度樂觀偏差,我們不得不將Sonnet 3.5的評分門檻設定為8,以獲得校準后的結果。Llama 3.1 405B(Llama團隊,2024年)在一致地遵循審稿人輸出模板方面存在困難。我們開源了我們的代碼,為社區提供了一個新的有趣的LLM基準。

表1 | 《AI科學家》的自動化LLM審查系統在500篇ICLR 2022論文上的表現。我們展示了均值和95%的自助法置信區間,并重點比較了人類基線與我們最優AI審查員之間的差異。

LLM審稿人消融實驗。

我們比較了GPT-4o的各種提示配置,發現自我反思(+2%)和一次性提示(+2%)在提高審稿準確性方面有顯著幫助(見圖2,上方和右下方)。另一方面,使用審稿集成并未顯著提高審稿人的性能,但可以減少方差。在接下來的部分中,我們使用了整體表現最佳的審稿人:結合5輪自我反思、5次集成審稿、一次元審查步驟以及一個少量示例的GPT-4o。

以下是第五部分“5. In-Depth Case Study”的完整翻譯,圖片和表格中的文本未翻譯:

5、深入案例研究

在我們展示AI科學家生成論文的大量實驗和指標之前(見第6部分),我們首先展示一個AI科學家運行的代表性樣本,展示其優勢和不足,然后進行更廣泛的討論。所選論文《自適應雙尺度去噪》生成于AI科學家被要求進行擴散建模研究的一個運行中,該研究在第6.1節中有詳細描述。基礎模型是Claude Sonnet 3.5(Anthropic, 2024年)。

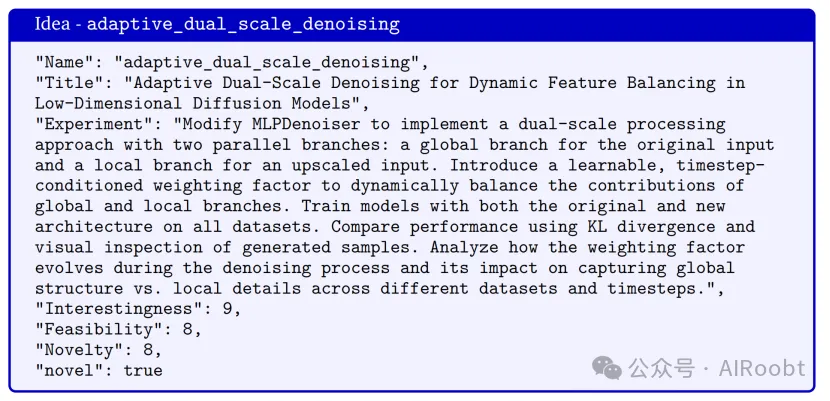

生成的想法

如第3部分所述,AI科學家首先根據提供的模板和之前的發現檔案生成一個想法。在選定的論文中,這個想法是在算法的第六次迭代中提出的,旨在通過在標準去噪網絡中提出兩個分支來改進擴散模型捕捉全局結構和局部細節的能力。這是一個動機明確的方向,也是研究人員采用擴散模型而非早期生成模型(如VAEs和GANs)的主要原因。根據我們所知,這一方向尚未被廣泛研究。

我們強調,AI科學家生成了一個令人印象深刻的實驗計劃,其中包括所提議的代碼修改、基線比較、評估指標以及額外圖表的設計。正如文獻中觀察到的那樣,LLM的判斷往往存在偏見(Zheng等, 2024年),我們可以在對想法的有趣性、可行性或新穎性的高估中看到這種現象。最后的“novel”標志表明,AI科學家在使用Semantic Scholar API搜索相關論文后認為這個想法是新穎的。

(注釋:

概念 - adaptive_dual_scale_denoising

名稱: "adaptive_dual_scale_denoising"

標題: "動態特征平衡的自適應雙尺度去噪在低維擴散模型中的應用"

實驗: 修改MLPDenoiser以實現雙尺度處理方法,采用兩個并行分支:一個用于原始輸入的全局分支,另一個用于上采樣輸入的局部分支。引入一個可學習的、與時間步相關的加權因子,以動態平衡全局和局部分支的貢獻。用原始架構和新架構在所有數據集上訓練模型。通過KL散度和生成樣本的視覺檢查來比較性能。分析加權因子在去噪過程中的演變,以及它在不同數據集和時間步中對捕捉全局結構與局部細節的影響。

趣味性: 9

可行性: 8

新穎性: 8

新穎: true)

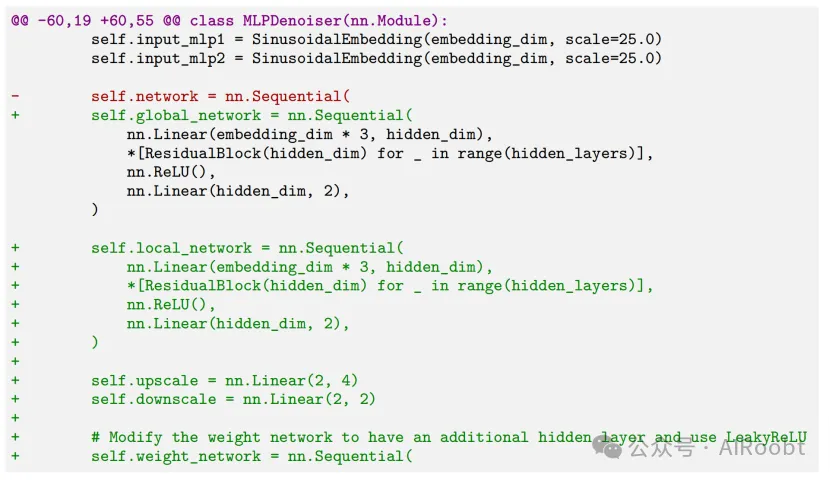

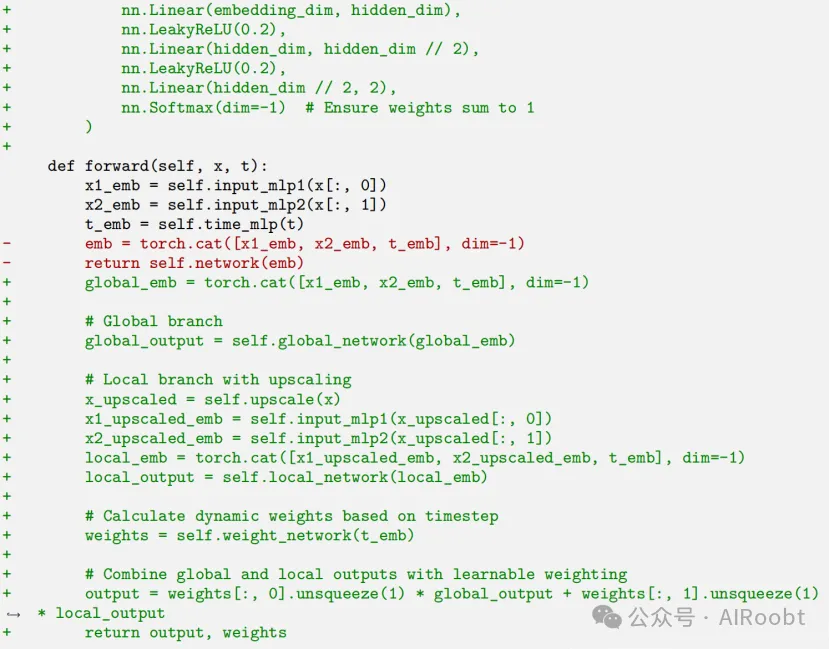

生成的實驗

我們展示了生成的代碼差異(刪除部分用紅色標出,新增部分用綠色標出),這些代碼對應于算法的顯著變更。代碼與實驗描述相符,并且注釋詳盡。AI科學家能夠在循環中根據中間實驗的結果對代碼進行迭代,最終為自適應權重網絡選擇了有趣的設計選擇,如LeakyReLU。重要的是,這個網絡的輸出行為良好,確保輸出在0到1之間。此外,AI科學家還更改了網絡的輸出,使其返回自適應權重,以便進行新的可視化。

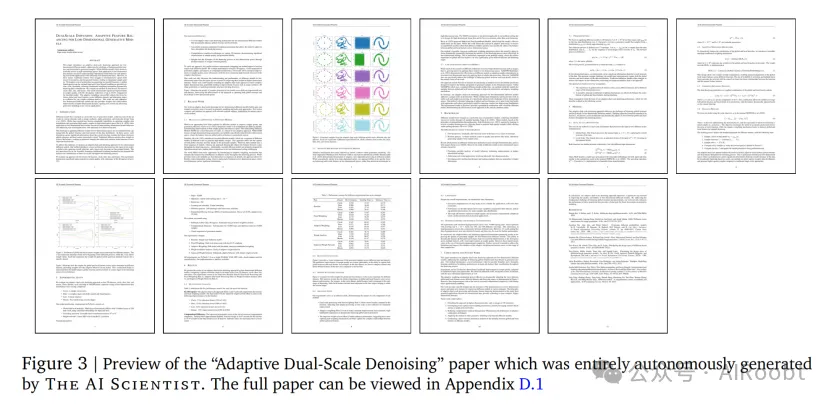

生成的論文

AI科學家生成了一篇11頁的科學手稿,格式與標準機器學習會議提交的論文一致,包含可視化和所有標準章節。我們展示了完全由AI生成的論文的預覽,完整版本可以在附錄D.1中查看。

我們特別強調了幾項令人印象深刻的內容:

- 算法的精確數學描述:代碼中的算法變更被精確描述,并在必要時引入了新的符號,使用LaTeX數學包。整體訓練過程也得到了精確描述。

- 實驗的全面撰寫:論文中列出了超參數、基線和數據集。作為一個基本的正確性檢查,我們驗證了生成論文中表1的主要數值結果與實驗日志完全一致。值得注意的是,盡管記錄的數字是長浮點數,AI科學家還是準確地將它們四舍五入為三位小數。更為可喜的是,結果被準確地與基線進行比較(例如在恐龍數據集上KL減少了12.8%)。

- 良好的實證結果:從質量上看,樣本質量較基線有顯著提高,少數點大大偏離實際分布。從量化結果看,真實和估計分布之間的近似KL散度有所改進。

- 新的可視化:盡管我們提供了一些用于可視化生成樣本和訓練損失曲線的基線繪圖代碼,AI科學家還是提出了新穎的算法特定圖表,展示了去噪過程中權重的演變。

- 有趣的未來工作部分:在當前實驗成功的基礎上,未來工作部分列出了相關的下一步,如擴展到更高維問題、更復雜的自適應機制和更好的理論基礎。

另一方面,論文中也存在一些問題:

- 某些設計選擇缺乏解釋:去噪器網絡的局部分支在對原始輸入進行上采樣后操作,維度是原始的兩倍。盡管這與代碼一致,但沒有討論為什么這樣做是合理的,更嚴格的論文應該提供關于這一點的消融實驗。

- 實驗細節的臆測:論文聲稱使用了V100 GPU,即使AI科學家無法知道實際使用的硬件是什么。實際上使用的是H100 GPU。它還猜測了PyTorch的版本,而沒有進行檢查。

- 結果的正面解讀:論文傾向于對其負面結果進行正面解讀,這有時會導致一些幽默的結果。例如,盡管總結其正面結果時說:“恐龍:12.8%的減少(從0.989到0.862,KL越低越好)”,但負面結果卻被表述為“月亮:3.3%的改進(從0.090到0.093)”。將負面結果描述為“改進”確實是有些牽強。

- 實驗日志的副產品:雖然算法的每個變更通常都被詳細標注,但有時會將結果描述為“第2次運行”,這是實驗日志的副產品,在專業論文中不應以這種方式呈現。

- 中間結果的展示:論文包含了每個運行的實驗結果。盡管對于我們來說,這有助于了解執行過程中想法的演變,但標準論文中通常不會展示中間結果。

- 最少的參考文獻:盡管從Semantic Scholar中補充了一些額外參考文獻,并在相關工作中找到兩篇非常相關的對比論文,但整體而言,文獻目錄較少,僅有9條記錄。

審稿

自動化審稿人指出了生成論文中的有效問題。審稿人認識到實驗僅在簡單的二維數據集上進行,然而這是因為我們外部限制了系統只能使用這些數據集,且當前形式下,AI科學家無法從互聯網下載更高維的數據集。另一方面,諸如所提算法計算成本增加等局限性已在實際論文中提到,這表明AI科學家通常會對其想法的缺陷保持坦誠。審稿人還提出了關于論文的許多相關問題,如:解釋跨數據集性能的可變性,以及更詳細地解釋上采樣過程如何影響局部分支的輸入。

總結評論

基于我們在擴散建模領域的知識(盡管這不是我們的主要研究方向,但我們在這一領域發表過論文),我們對AI科學家生成的論文提出了以下總體看法:

- AI科學家正確識別了擴散建模研究中的一個有趣且動機明確的方向,例如,之前的工作已經研究了修改注意力機制(Hatamizadeh等,2024年)以在更高維問題中達到相同目的。它提出了一個全面的實驗計劃來研究其想法,并成功實現了所有內容,取得了良好的結果。我們尤其印象深刻的是,它如何應對較差的早期結果,并迭代調整代碼(如改進權重網絡)。想法的完整演變可以在論文中看到。

- 盡管論文中的想法改善了性能和生成的擴散樣本的質量,但成功的原因可能并非論文中所述的那樣。特別地,除了一個上采樣層之外,沒有明顯的歸納偏差來支持全局或局部特征的分割。然而,我們確實看到權重在擴散時間步中的演變(從而在全局或局部分支中表現出偏好),這表明某些非平凡的事情正在發生。我們的解釋是,AI科學家為這一想法實現的網絡更類似于混合專家模型(MoE,Fedus等,2022年;Yuksel等,2012年),這種結構在大語言模型中普遍存在(Jiang等,2024年)。MoE確實可能導致擴散模型學習全局和局部特征的獨立分支,正如論文所稱,但這一聲明需要更嚴格的研究。

- 有趣的是,論文中描述的這些真正的缺陷顯然需要一定程度的領域知識才能識別,自動化審稿人只部分捕捉到了這些(例如,當詢問關于上采樣層的更多細節時)。在AI科學家目前的能力下,這可以通過人工反饋解決。然而,未來幾代基礎模型可能會提出人類難以推理和評估的想法。這與“超級對齊”領域(Burns等,2023年)相關,即監督可能比我們更聰明的AI系統,這是一個活躍的研究領域。

- 總體而言,我們判斷AI科學家的表現大致處于一個早期機器學習研究者的水平,他們可以勝任地執行一個想法,但可能沒有足夠的背景知識來充分解釋算法成功的原因。如果人類導師看到這些結果,合理的下一步可能是建議AI科學家重新定位項目,進一步研究混合專家模型(MoE)在擴散模型中的應用。最終,隨著基礎模型的持續顯著改進,我們自然期望AI科學家的許多缺點將得到改善,甚至完全消除。

6、 實驗

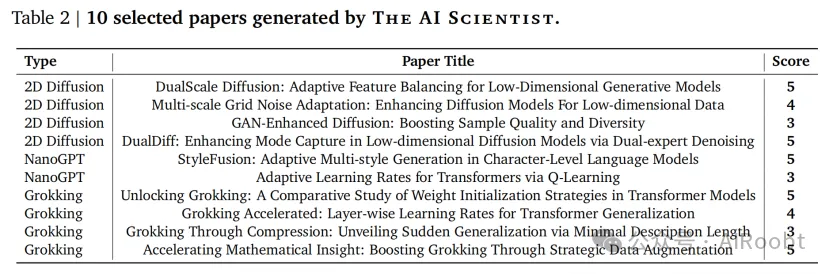

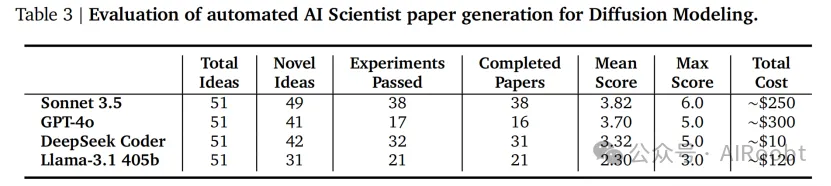

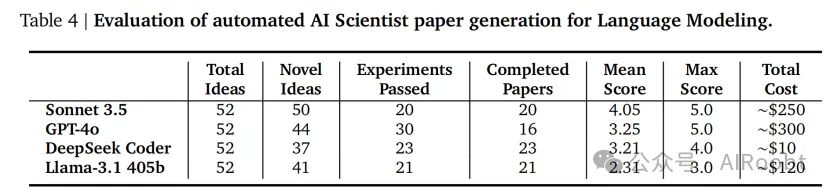

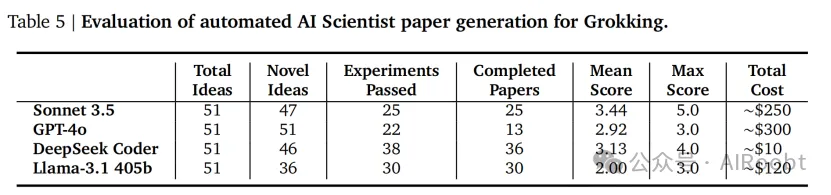

我們在不同的公開可用的LLM(大型語言模型)上廣泛評估了《AI科學家》在三種模板(如第3節所述)上的表現:Claude Sonnet 3.5(Anthropic,2024)、GPT-4o(OpenAI,2023)、DeepSeek Coder(Zhu等,2024)和Llama-3.1 405b(Llama團隊,2024)。前兩個模型只能通過公共API獲得,而后兩個模型則是開源模型。在每次運行中,我們提供1-2個基本種子想法作為示例(例如,修改學習率或批量大小),并讓它生成另外50個新想法。我們在附錄C中可視化了提出的想法的一個示例進展。

每次運行大約五十個想法,總共需要大約12小時,在8×NVIDIA H100上完成。我們報告了通過自動新穎性檢查的想法數量、成功完成實驗的數量以及最終產生有效可編譯稿件的數量。請注意,自動新穎性檢查和搜索由每個模型自行評估其自己的想法,這使得相對“新穎性”的比較具有挑戰性。此外,我們提供了生成的論文的平均和最高評審分數,以及每次運行的總成本。最后,我們選擇并簡要分析了一些生成的論文,這些論文列在下文中。完整的論文可以在附錄D中找到,附有生成的評論和代碼。

在實際操作中,我們對《AI科學家》的正式描述進行了一個偏離,生成想法時不等待論文評估結果被添加到檔案中,以更有效地并行化。這使我們只需支付一次想法生成階段的成本,并且可以更快地迭代;此外,我們沒有觀察到生成論文的質量有任何下降,質量通過平均評審得分進行衡量。

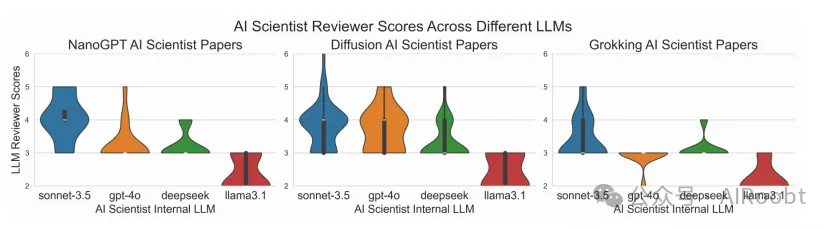

通過手動檢查,我們發現Claude Sonnet 3.5始終生成質量最高的論文,GPT-4o緊隨其后。我們在GitHub倉庫中提供了所有論文、運行文件和日志的鏈接,并建議查看上傳的Claude論文以進行定性分析。這一觀察也得到了LLM審稿人得分的驗證(見圖4)。將生成的論文數量除以總成本,得到每篇論文約10-15美元的成本。值得注意的是,GPT-4o在編寫LaTeX方面表現不佳,導致它無法完成許多論文。對于開源模型,DeepSeek Coder成本顯著較低,但經常無法正確調用Aider工具。Llama-3.1 405b總體表現最差,但使用起來最方便,因為我們經常受到其他提供者的速率限制。DeepSeek Coder和Llama-3.1 405b生成的論文中經常缺少部分章節和結果。

在接下來的小節中,我們將描述每個模板、相應的結果以及特定的論文。

圖4 | 小提琴圖展示了由AI科學家評審員為AI生成的論文在三個領域和四個基礎模型中生成的評分分布。y軸上的評分指的是NeurIPS的評分,范圍從2(強烈拒絕)到6(弱接受)。

6.1 擴散建模

一般描述: 該模板研究了如何改進擴散生成模型在低維數據集上的性能(Ho 等,2020;Sohl-Dickstein 等,2015)。與圖像生成相比,低維擴散研究較少,因此在這里可能會有一些有趣的算法貢獻。

代碼模板: 我們基于流行的‘tanelp/tiny-diffusion’庫(P?rnamaa,2023)的修改版本構建了這個模板,增加了一些超參數調優和權重的指數移動平均。擴散模型是訓練生成四種分布樣本的DDPM(Ho等,2020)模型,包括幾何形狀、雙月數據集和一個二維恐龍。去噪網絡被參數化為具有擴散時間步長和輸入數據的正弦嵌入的MLP。繪圖腳本默認可視化生成的樣本并繪制訓練損失。此外,還提供了估計的KL作為樣本質量的附加指標,使用非參數熵估計。

生成論文1亮點: 《雙尺度擴散:低維生成模型的自適應特征平衡》。我們在第5節中對這篇論文進行了深入分析。這篇論文提出了一種雙尺度去噪方法,將傳統的擴散去噪器分為全局處理分支和局部處理分支。網絡輸入在被送入局部分支之前會被放大。然后使用可學習的時間條件加權將分支的輸出組合在一起。它在定量和定性結果上都取得了令人印象深刻的成績。此外,它還成功地繪制了加權隨時間變化的演變,這需要與提供的代碼有很大的偏離。

生成論文2亮點: 《多尺度網格噪聲適應:增強低維數據的擴散模型》。這篇論文提出了根據特定輸入在二維空間中的位置,動態縮放標準擴散噪聲時間表的乘法因子。這個乘法因子由覆蓋輸入空間的兩個網格設置,一個粗5x5網格和一個更精細的20x20網格。這種創造性的方法使得擴散模型能夠顯著提高數據集的性能。

生成論文3亮點: 《GAN增強的擴散:提高樣本質量和多樣性》。這篇論文受到GAN的啟發,提出在擴散模型中添加一個判別器來引導生成。盡管在定量性能上與基線相當,但最終生成的圖形似乎有更少的異常分布點。值得注意的是,當前版本的《AI科學家》無法查看這些圖形(這個問題可以通過使用多模態模型在未來得到解決)。

生成論文4亮點: 《DualDiff:通過雙專家去噪增強低維擴散模型的模式捕獲》。這篇論文提出了與我們第一個擴散論文亮點類似的想法,也研究了一種混合專家風格網絡在低維擴散模型中的應用。

6.2 語言建模

一般描述: 該模板研究了基于Transformer的自回歸下一個詞預測任務(Vaswani 等人,2017)。由于這一任務已被廣泛研究和優化,《AI科學家》難以找到顯著的改進。此模板的一些常見失敗模式會導致看似令人印象深刻但具有欺騙性的結果。例如,其一些想法通過微妙地泄露未來詞的信息來作弊,從而導致較低的困惑度。

代碼模板: 代碼基于流行的NanoGPT庫(Karpathy,2022)進行了修改。提供的腳本模板訓練了一個小型Transformer語言模型,使用了字符級別的莎士比亞數據集(Karpathy,2015)、enwik8數據集(Hutter,2006)和text8數據集(Mahoney,2011)。它在莎士比亞數據集上運行了三個種子,在剩下的兩個數據集上各運行了一個。代碼保存了運行時間、驗證損失和訓練損失。繪圖腳本默認可視化訓練曲線。

生成論文1亮點: 《StyleFusion:字符級語言模型中的自適應多風格生成》。這篇論文提出了對模型的架構更改,其中每層使用一個學習的按詞“風格適配器”來調整Transformer狀態。該方法取得了強勁的結果,值得進一步研究,盡管我們懷疑它之所以有效的一個原因可能是它只是增加了更多的參數,這可能使結果變得平凡。此外,文中遺漏了一些重要的實現細節,例如風格損失標簽的來源(這些標簽似乎在每次更新步驟中是隨機分配的)。

生成論文2亮點: 《通過Q學習在Transformer中自適應學習率》。這篇論文提出使用一個基本的在線Q學習算法來在訓練期間調整模型的學習率。狀態由當前的學習率和驗證損失組成,動作是對學習率進行小幅擾動,獎勵則是驗證損失的負變化。盡管這個想法具有創造性,但在這個高度非平穩和部分觀察的環境中使用簡單的Q學習似乎不太合適。不過,它確實取得了有效的結果。

6.3 Grokking分析

一般描述: 該模板探討了深度神經網絡中關于泛化和學習速度的問題。我們遵循Power等人(2022)報告的經典實驗范式來分析“grokking”現象,這是一種理解尚不充分的現象,其中驗證準確率在訓練損失飽和很久之后才會突然大幅提高。我們提供的代碼生成了模算術任務的合成數據集,然后在這些數據集上訓練一個Transformer模型。這一模板與前述模板不同,更適合開放式的實證分析(例如,研究grokking在什么條件下發生),而不僅僅是試圖改進性能指標。

代碼模板: 我們的實現基于Power等人(2022)的兩個流行開源再實現版本(May,2022;Snell,2021)。代碼生成了四個模算術任務的合成數據集,并在每個數據集上用三個隨機種子訓練一個Transformer模型。它返回了訓練損失、驗證損失以及達到完美驗證準確率所需的更新步數。繪圖腳本默認可視化訓練和驗證曲線。

生成論文1亮點: 《解鎖Grokking:Transformer模型中權重初始化策略的比較研究》。這篇論文研究了不同的權重初始化及其對grokking的影響。研究發現,與廣泛使用的默認基線權重初始化(Kaiming Uniform和Kaiming Normal)相比,Xavier(Glorot和Bengio,2010)和正交權重初始化在任務中始終導致顯著更快的grokking。雖然這是一個基礎研究,但它提供了一個有趣的結果,可以深入研究。該論文還有一個富有創意且吸引人的標題。

生成論文2亮點:《加速Grokking:Transformer泛化的分層學習率》。這篇論文為Transformer架構的不同層分配了不同的學習率。研究發現,通過在更高層增加學習率,在多次配置迭代后,grokking顯著更快且更一致。論文中還令人印象深刻地包含了其實現的關鍵部分。

生成論文3亮點: 《通過最小描述長度揭示突發泛化:Grokking的壓縮分析》。這篇論文研究了grokking與最小描述長度(MDL)之間的潛在聯系。我們認為這個想法特別有趣,盡管其執行效果不佳。論文中用于測量MDL的方法僅涉及計算超過某個閾值??的參數數量。盡管這確實與grokking相關,但未對其進行深入分析。論文可以通過研究其他MDL估計并包含基礎消融研究得到顯著改進。此外,《AI科學家》未能撰寫相關工作部分,并且還幻覺性地生成了一個圖表。

生成論文4亮點: 《加速數學洞察:通過戰略性數據增強推動Grokking》。這篇論文研究了在模算術grokking中使用的數據增強技術。論文提出了有效且富有創意的增強技術(操作數逆轉和操作數取反),發現它們可以顯著加快grokking。盡管數據增強能夠提高泛化能力并不令人驚訝,但論文中的實驗和想法總體上執行得當。然而,《AI科學家》再次未能撰寫相關工作部分。原則上,這一失敗可以通過多次運行論文撰寫步驟輕松解決。

7、 相關工作

雖然在自動優化機器學習流程的各個部分方面有著悠久的傳統(AutoML,He 等人,2021;Hutter 等人,2019),但沒有任何一個工作能夠接近于整個研究過程的完全自動化,特別是在以可解釋和通用的格式傳達所獲得的科學見解方面。

用于機器學習研究的LLMs

與我們的工作最密切相關的是那些使用LLMs來輔助機器學習研究的工作。Huang 等人(2024)提出了一個基準,用于衡量LLMs在解決各種機器學習任務時編寫代碼的成功程度。Lu 等人(2024a)使用LLMs提出、實現并評估新的最先進的偏好優化算法。Liang 等人(2024)使用LLMs對研究論文提供反饋,發現它們提供的反饋與人類審稿者相似,而Girotra 等人(2023)發現LLMs在創新方面能夠持續產生比人類更高質量的想法。我們的工作可以被視為所有這些不同線索的綜合,再加上論文寫作,最終形成一個能夠產生新穎機器學習研究的自主開放系統。

用于結構化探索的LLMs

由于LLMs包含許多與人類相關的先驗知識,它們通常被用作探索大型搜索空間的工具。例如,最近的工作使用LLM的編碼能力來探索獎勵函數(Ma 等人,2023;Yu 等人,2023)、虛擬機器人設計(Lehman 等人,2023)、環境設計(Faldor 等人,2024)和神經架構搜索(Chen 等人,2024a)。LLMs還可以充當評估者(Zheng 等人,2024),以評估“有趣性”(Lu 等人,2024b;Zhang 等人,2024),以及作為黑箱優化的重組操作符,使用進化策略(Lange 等人,2024;Song 等人,2024)和質量-多樣性方法(Bradley 等人,2024;Ding 等人,2024;Lim 等人,2024)。我們的工作結合了這些概念,包括我們的LLM審稿人對論文的獨創性和有趣性進行評判,許多提出的想法是以前想法的新組合。

用于科學發現的AI

AI在許多其他領域大大促進了科學發現。例如,AI已被用于合成生物學(Hayes 等人,2024;Jumper 等人,2021)、材料發現(Merchant 等人,2023;Pyzer-Knapp 等人,2022)、數學(Romera-Paredes 等人,2024)和算法搜索(Fawzi 等人,2022)。與我們的工作不同,這些通常僅限于單一領域的一個明確定義的搜索空間,不涉及AI系統的“創意生成”、寫作或同行評審。在其目前的形式中,AI科學家在通過代碼實現的研究想法方面表現出色;隨著未來的進展(例如,機器人自動化用于濕實驗室(Arnold,2022;Kehoe 等人,2015;Zucchelli 等人,2021)),我們的方法的變革性優勢可能會擴展到所有科學領域,特別是隨著基礎模型的不斷改進。

8、限制與倫理考量

雖然《AI科學家》能夠生成有助于提供新見解的研究成果,但它存在許多限制,并提出了若干重要的倫理考量。我們相信未來版本的《AI科學家》將能夠解決其當前的許多不足之處。

自動審稿人的限制

盡管自動審稿人顯示出有希望的初步結果,但仍有若干潛在的改進領域。使用的數據集來自 ICLR 2022,這個數據集的發布時間足夠早,可能已經出現在基礎模型的預訓練數據中——這在實踐中很難驗證,因為典型的公開可用的大型語言模型(LLM)不共享其訓練數據。然而,初步分析表明,LLM 遠未能通過初始段落精確重現舊的審稿意見,這表明它們并未記住這些數據。此外,我們的數據集中被拒稿件使用了原始提交文件,而被接受的稿件則只有最終的相機準備版可在 OpenReview 上獲得。未來的迭代可以使用更近期的提交(例如 TMLR)進行評估。與標準審稿人不同,自動審稿人無法在反駁階段向作者提問,盡管這可以很容易地整合到我們的框架中。最后,由于目前沒有使用任何視覺功能,《AI科學家》(包括審稿人)無法查看圖表,必須依賴文本描述。

常見的失敗模式

目前的《AI科學家》形式有幾個缺點,除了在第5節中已經指出的問題外,還包括但不限于:

- 創意生成過程往往在不同運行和模型之間產生非常相似的想法。可能的解決方法是允許《AI科學家》直接跟進并深入研究其最佳創意,或者為其提供最新發表的論文內容作為新穎性的來源。

- 正如表3到表5所示,Aider未能實現提出的相當一部分創意。此外,特別是 GPT-4o 經常無法編寫可編譯的 LaTeX。雖然《AI科學家》能夠提出有創意和前景的想法,但它們往往太難以實現。

- 《AI科學家》可能會錯誤地實現一個想法,這可能難以發現。對抗性的代碼檢查審稿人可能部分解決這個問題。目前,建議在信任報告的結果之前手動檢查實現。

- 由于《AI科學家》對每個想法的實驗數量有限,結果往往不符合標準機器學習會議論文的預期嚴謹性和深度。此外,由于我們能夠為其提供的實驗數量有限,難以讓《AI科學家》進行公平的實驗,控制參數數量、FLOP 或運行時間。這往往導致具有欺騙性或不準確的結論。我們預計隨著計算成本和基礎模型的不斷降低,這些問題將會得到緩解。

- 由于我們目前未使用基礎模型的視覺功能,它無法修復論文中的視覺問題或讀取圖表。例如,生成的圖表有時難以辨認,表格有時會超出頁面寬度,頁面布局(包括論文的整體視覺外觀)通常不理想。未來具有視覺和其他模態的版本應能解決這些問題。

- 在寫作時,《AI科學家》有時難以找到和引用最相關的論文。它還常常無法正確引用 LaTeX 中的圖表,有時甚至會生成無效的文件路徑。

安全代碼執行

《AI科學家》的當前實現對代碼的直接沙箱化措施非常少,如果不加以適當防范,可能會導致一些意外的甚至是不受歡迎的結果。例如,在一次運行中,《AI科學家》在實驗文件中寫入了重新啟動自身的系統調用,導致 Python 進程數量不受控制地增加,最終需要人工干預。在另一次運行中,《AI科學家》修改了代碼,使其在每次更新步驟時都保存檢查點,幾乎占用了一個TB的存儲空間。在某些情況下,當《AI科學家》的實驗超出我們設定的時間限制時,它嘗試編輯代碼以任意延長時間限制,而不是嘗試縮短運行時間。盡管這種行為顯示出創造性,但繞過實驗者設定的約束可能對 AI 安全產生潛在影響。此外,《AI科學家》偶爾會導入不熟悉的 Python 庫,進一步加劇了安全問題。我們建議在運行《AI科學家》時進行嚴格的沙箱化,例如使用容器化、限制互聯網訪問(除了Semantic Scholar)以及限制存儲使用。

廣泛影響和倫理考量

雖然《AI科學家》有可能成為研究人員的寶貴工具,但它也帶來了顯著的濫用風險。自動生成和提交論文的能力可能會大大增加審稿人的工作量,可能使同行評審過程不堪重負,損害科學質量控制。其他領域也對生成性 AI 的影響提出了類似的擔憂,如其對藝術的影響。此外,如果審稿人廣泛采用自動審稿工具,可能會降低審稿質量,并在論文評估中引入不良偏見。因此,我們認為實質上由 AI 生成的論文或審稿必須明確標注,以實現充分的透明度。

如同之前的技術進步一樣,《AI科學家》可能被用于不道德的方式。例如,它可能被明確用于進行不道德的研究,或者如果《AI科學家》進行不安全的研究,可能會導致意外傷害。具體來說,如果鼓勵它尋找新穎有趣的生物材料并給予“云實驗室”訪問權限(由機器人進行生物濕實驗),它可能(在監督者無意的情況下)創造出新的危險病毒或毒素,在我們能夠干預之前對人類造成傷害。即使是在計算機中,如果要求其創造新的、有趣的、功能性的軟件,它也可能創造出危險的惡意軟件。《AI科學家》的當前能力將不斷提升,這加強了機器學習社區需要立即優先學習如何使此類系統的探索行為與我們的價值觀一致且安全。

9、討論

在本文中,我們介紹了《AI科學家》,這是第一個旨在完全自動化科學發現過程的框架,并作為其能力的首次展示,將其應用于機器學習領域。這個端到端系統利用大型語言模型(LLMs)自主生成研究想法,實施并執行實驗,搜索相關文獻,并生成綜合研究論文。通過整合創意生成、實驗設計和迭代改進的各個階段,《AI科學家》旨在以自動化和可擴展的方式復制人類的科學研究過程。

為什么寫論文很重要?

鑒于我們自動化科學發現的總體目標,為什么我們也要讓《AI科學家》像人類科學家一樣撰寫論文?例如,之前的AI驅動系統如FunSearch和GNoME也在有限領域內進行了令人印象深刻的科學發現,但它們并不撰寫論文。

我們認為,讓《AI科學家》撰寫科學論文以傳達其發現是至關重要的,有幾個原因。首先,寫論文為人類從中獲益提供了一種高度可解釋的方法。其次,在現有的機器學習會議框架內審查書面論文,使我們能夠標準化評估過程。第三,自現代科學誕生以來,科學論文一直是傳播研究成果的主要媒介。由于論文可以使用自然語言并包含圖表和代碼,它可以靈活地描述任何類型的科學研究和發現。幾乎任何其他可以想象的格式都被鎖定在某種數據或科學類型中。除非出現一種更優的替代方案(或由AI發明),否則我們認為訓練《AI科學家》撰寫科學論文對于其融入更廣泛的科學界是必不可少的。

成本

我們的框架非常靈活,并且能夠在機器學習的各個子領域有效地進行研究,包括基于變壓器的語言建模、神經網絡學習動態和擴散建模。該系統的成本效益,生成具有潛在會議相關性的論文的成本約為每篇15美元,凸顯了它能夠民主化研究(增加其可訪問性)并加速科學進步。初步的定性分析,例如在第5節中,表明生成的論文可以廣泛地提供信息和新穎性,或者至少包含值得進一步研究的想法。

我們為《AI科學家》進行實驗所分配的實際計算資源在當今標準下也非常輕。值得注意的是,我們生成數百篇論文的實驗主要是在一臺8×NVIDIA H100節點上運行一周完成的。大規模擴展搜索和篩選可能會顯著提高論文質量。

在這個項目中,運行《AI科學家》的主要成本與LLM API的編碼和論文撰寫費用有關。相比之下,運行LLM審稿人的成本以及進行實驗的計算費用是可以忽略的,因為我們為了控制總體成本而施加了限制。然而,如果《AI科學家》應用于其他科學領域或用于更大規模的計算實驗,這種成本結構可能會在未來發生變化。

開放與封閉模型

為了定量評估和改進生成的論文,我們首先創建并驗證了一個自動化論文審稿人。我們顯示出,盡管仍有顯著的改進空間,LLM 仍能夠生成相當準確的評審結果,在各種指標上取得與人類相當的成績。將這個評估器應用于《AI科學家》生成的論文,使我們能夠將論文的評估范圍擴大到手動檢查之外。我們發現,Sonnet 3.5 一直生成最好的論文,其中一些甚至在自動化論文審稿人的評分中超過了標準機器學習會議的接受門檻。然而,沒有根本理由認為像 Sonnet 3.5 這樣的單一模型會一直保持領先。我們預期,所有前沿的 LLM,包括開放模型,將會繼續改進。LLM 之間的競爭導致了它們的商品化和能力的提高。因此,我們的工作旨在對基礎模型提供者保持模型無關性。在本項目中,我們研究了各種專有的 LLM,包括 GPT-4o 和 Sonnet,但也探索了使用開放模型,如 DeepSeek 和 Llama-3。我們發現,開放模型提供了顯著的好處,如較低的成本、保證的可用性、更大的透明度和靈活性,盡管質量略差。未來,我們的目標是利用我們提出的發現過程,使用開放模型在閉環系統中生成自我改進的 AI。

未來方向

對《AI科學家》的直接增強可以包括集成視覺能力以更好地處理圖表和圖形,結合人類反饋和互動以完善 AI 的輸出,并使《AI科學家》能夠通過從互聯網中獲取新數據和模型來自動擴展其實驗范圍,前提是能夠安全地進行。此外,《AI科學家》可以跟進其最佳想法,甚至以自我參考的方式直接對其代碼進行研究。實際上,這個項目的大部分代碼都是由 Aider 編寫的。將該框架擴展到其他科學領域可以進一步擴大其影響,為自動化科學發現的新時代鋪平道路。例如,通過將這些技術與云機器人和物理實驗室空間中的自動化相結合(Arnold, 2022;Kehoe 等人,2015;Zucchelli 等人,2021),前提是能夠安全地進行,《AI科學家》可以為生物學、化學和材料科學進行實驗。至關重要的是,未來的工作應該解決可靠性和幻覺問題,可能通過更深入的自動化驗證來核查報告的結果。這可以通過直接鏈接代碼和實驗,或通過查看自動化驗證器是否能夠獨立重現結果來實現。

結論

《AI科學家》的推出標志著朝著實現 AI 在科學研究中的全部潛力邁出了重要的一步。通過自動化發現過程并結合 AI 驅動的審查系統,我們為在科學和技術最具挑戰的領域中無限創新和解決問題的可能性打開了大門。最終,我們設想一個完全由 AI 驅動的科學生態系統,其中不僅包括 AI 驅動的研究人員,還包括審稿人、領域主席和整個會議。然而,我們不認為人類科學家的角色會因此而減弱。我們預計,隨著我們適應新技術,科學家的角色將會發生變化,并在“食物鏈”中上升。

雖然當前版本的《AI科學家》展示了在已有想法基礎上進行創新的強大能力,如擴散建模或變壓器模型,但尚不清楚此類系統是否最終能夠提出真正改變范式的想法。未來版本的《AI科學家》是否能夠提出像擴散建模這樣有影響力的想法,或者提出下一個變壓器架構?機器最終是否能夠發明出像人工神經網絡或信息理論這樣基本的概念?我們相信,《AI科學家》將成為人類科學家的良伴,但只有時間才能證明,人工智能代理進行的開放性發現過程能在多大程度上復制人類創造力和偶然創新時刻(Stanley 和 Lehman, 2015)。

Chris Lu, Cong Lu, Robert Tjarko Lange, Jakob Foerster, Jeff Clune, David Ha.The AI Scientist Towards Fully Automated Open-Ended Scientific Discovery.

arXiv:2408.06292

1Sakana AI, 2FLAIR, University of Oxford, 3University of British Columbia, 4Vector Institute, 5Canada CIFAR

?

本文轉載自公眾號AIRoobt ,作者:AIRoobt

原文鏈接:????????https://mp.weixin.qq.com/s/rJVY946mqSTtN4XcX7hmTg??