GPT-X 模型訓練優化技術設計分析 原創

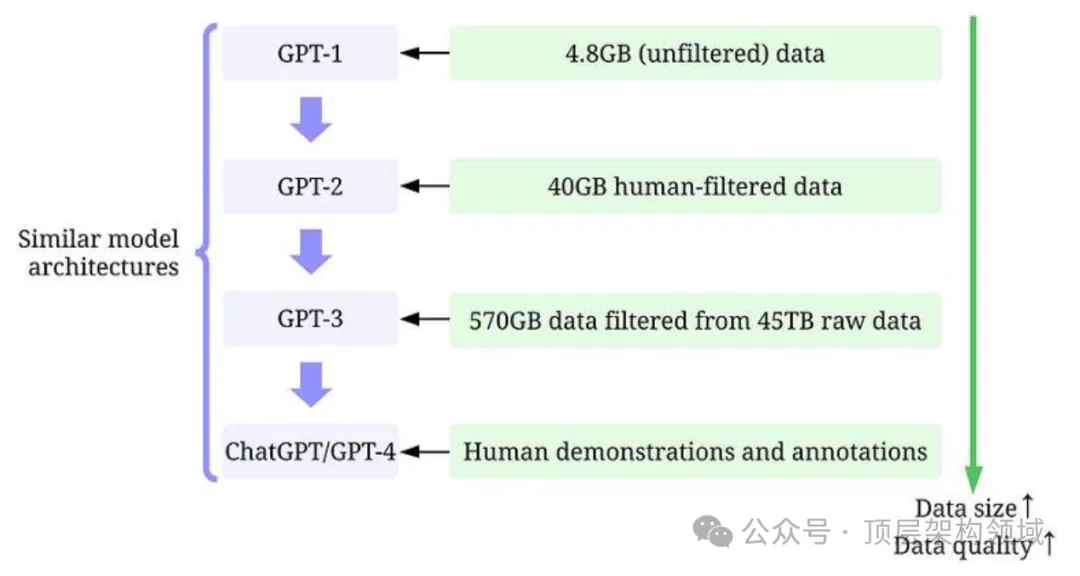

GPT-X模型作為當前自然語言處理領域的代表性模型之一,其訓練效率和性能一直是研究的重點。本文將對GPT-X模型訓練優化的相關技術進行詳細的講解,包括模型架構、算法優化、模型訓練策略、算子優化、并行計算和深度學習加速等方面的內容。

一、模型架構

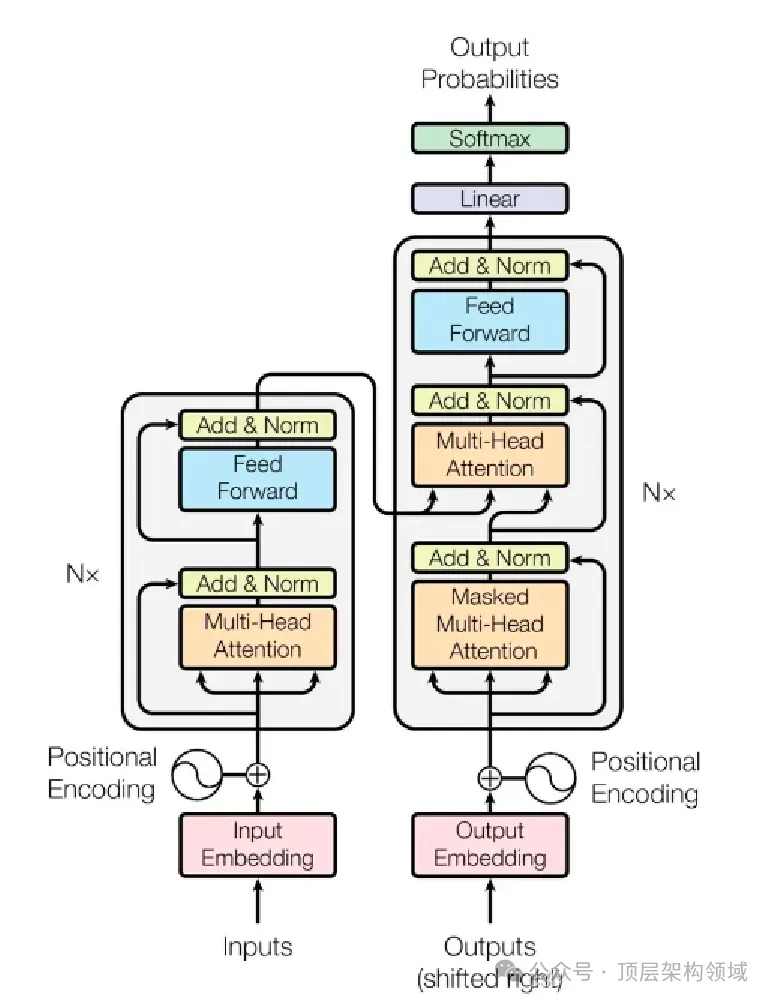

GPT-X的模型架構基于Transformer,這是一種注意力機制的網絡架構,能夠處理序列到序列的任務,如機器翻譯、文本摘要等。Transformer的核心組件是自注意力機制,它能夠捕捉序列中的長距離依賴關系。GPT-X模型在大規模語料庫上進行預訓練,以學習通用的語言表示。

二、算法優化

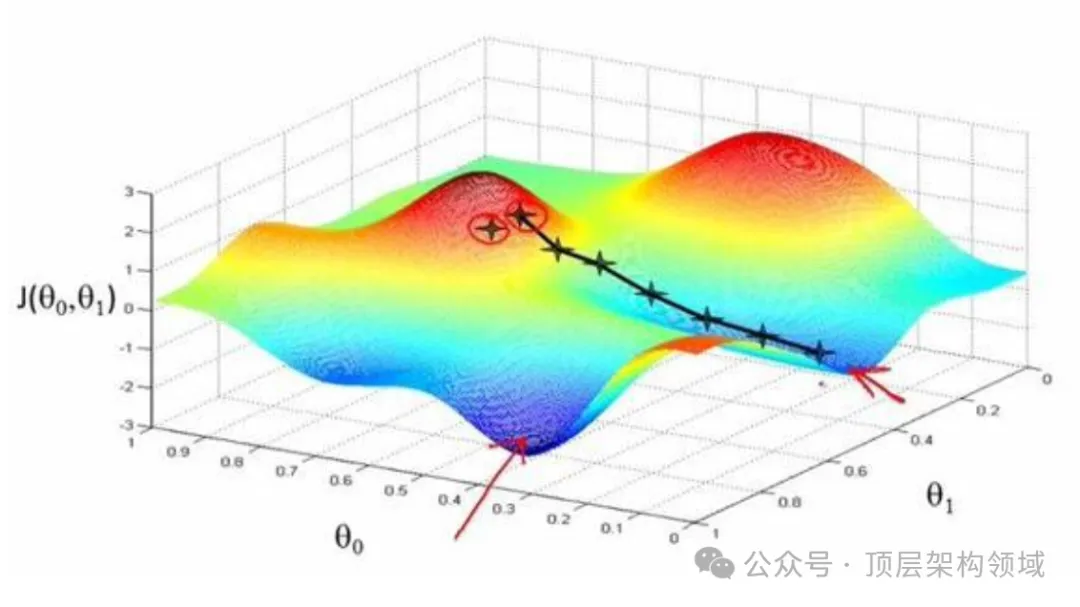

算法優化是提高模型訓練效率的重要手段。在GPT-X模型訓練中,常用的優化算法包括隨機梯度下降(SGD)、Adam、RMSProp等。這些算法通過調整模型參數,使損失函數最小化,從而提高模型的訓練效率和精度。例如,Adam算法因其自適應學習率調度和動量機制,在不同的數據集上通常能獲得較好的性能。

三、模型訓練策略

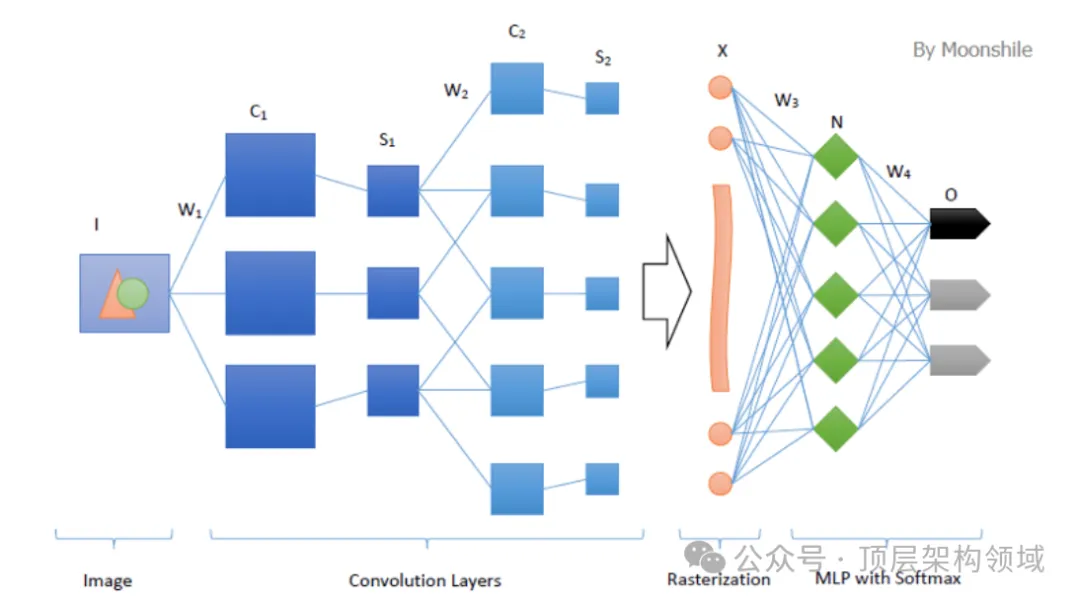

模型訓練策略的選擇也會對訓練效率產生影響。例如,合理設置批量大小、學習率以及使用預訓練模型初始化參數等策略,都能有效提升訓練效率。此外,數據預處理和特征提取也是重要的訓練策略,如使用卷積神經網絡(CNN)進行圖像特征提取可以大幅提高訓練速度和模型性能。

四、算子優化

算子優化主要是指對算法中的基本運算進行優化,以提高計算效率和訓練速度。例如,使用GPU進行矩陣運算可以大幅提高計算速度,而使用TensorFlow或PyTorch等框架進行向量化運算可以加快訓練速度并減少內存消耗。

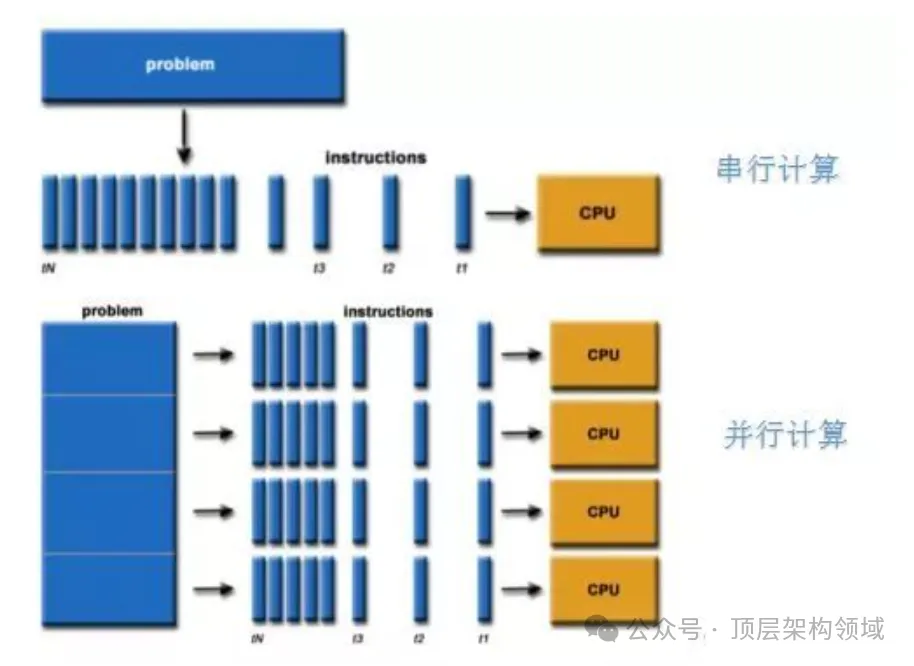

五、并行計算

并行計算是通過將計算任務分配到多個計算單元上執行,以提高計算效率和訓練速度的技術。硬件并行和軟件并行是并行計算的兩種方式,前者使用多個GPU或多核CPU同時進行計算,后者使用多個線程或進程同時進行計算,充分利用多核CPU的計算能力,加快訓練速度。

六、深度學習加速

深度學習加速涉及到一系列技術和方法,旨在提高深度學習模型的訓練速度和性能。這些方法包括模型壓縮、數據并行和通信優化等。模型壓縮可通過剪枝、量化、知識蒸餾等技術減小模型的大小和復雜度,提高訓練速度和模型的實時性。

總結

GPT-X模型訓練優化是一個涉及多個方面的綜合技術活動。通過算法優化、模型訓練策略、算子優化、并行計算和深度學習加速等技術的綜合運用,可以有效提升GPT-X模型的訓練效率和性能。未來的研究將繼續聚焦在這些方面的深化和細化,以期達到更高的訓練效率和更好的模型性能。

本文轉載自公眾號頂層架構領域

原文鏈接:??https://mp.weixin.qq.com/s/C2ctySAcOjHVAgAXj5g-DA??