殺瘋了!谷歌卷視頻到語音,逼真音效讓AI視頻告別無聲!

這幾天,大洋彼岸殺瘋了!

Luma 的熱乎勁兒還沒過去,昨晚 Runway 就甩出一個王炸 ——Gen-3 Alpha。(查看詳情請移步:???Runway 版 Sora 發(fā)布:高保真、超強(qiáng)一致性,Gen-3 Alpha 震撼到網(wǎng)友了??)

更沒想到的是,一覺醒來,Google DeepMind 也有了新消息,悄咪咪地發(fā)布了視頻生成語音(V2A)技術(shù)的進(jìn)展。

雖然這一功能還未向公眾開放,不過從官方放出的視頻 Demo 來看,效果那是相當(dāng)絲滑。同時,Google DeepMind 強(qiáng)調(diào),所有示例均由 V2A 技術(shù)和他們最先進(jìn)的生成視頻模型 Veo 聯(lián)手打造。

音頻提示: 緊張刺激的恐怖片配樂,腳步聲在混凝土上回響。(Cinematic, thriller, horror film, music, tension, ambience, footsteps on concrete)

黑燈瞎火的廢棄倉庫中,一個黑衣人猶如鬼魅般緩行,再配上詭異的音樂和腳步聲,恐怖氣氛拉滿。

音頻提示: 狼在月光下的長嚎。(Wolf howling at the moon)

視頻 Demo 一出,評論區(qū)清一水的追問:啥時候能用?

還有網(wǎng)友寄希望于開源社區(qū)當(dāng)一回賽博菩薩,復(fù)制谷歌的這一視頻生成語音技術(shù)。

其實(shí),就在 Google DeepMind 官宣沒多久,AI 音頻領(lǐng)域的「扛把子」ElevenLabs 就橫插一腳,開源了一個上傳視頻自動配音的項目,可以為視頻生成合適的音效。

鏈接:

??https://elevenlabs.io/docs/api-reference/how-to-use-text-to-sound-effects??

如今 AI 圈子的競爭已呈白熱化階段,大小廠的你追我趕將會創(chuàng)造更加公平的競爭環(huán)境,而一旦這些技術(shù)成熟,AI 視頻領(lǐng)域?qū)袩o限可能。

AI 視頻告別無聲電影

眾所周知,視頻生成模型正以驚人的速度發(fā)展。不過,無論是年初驚艷世人的 Sora,還是近期的可靈、Luma、Gen-3 Alpha,生成的全是「無聲電影」,無一例外。

而 Google DeepMind 的視頻生成音頻 (V2A) 技術(shù),使得同步的視聽生成成為可能。它可以結(jié)合視頻像素和自然語言文本提示,為屏幕上的動作生成豐富的配音。

從技術(shù)應(yīng)用上來說,V2A 技術(shù)能夠與 Veo 等視頻生成模型結(jié)合,創(chuàng)造出具有戲劇性配樂、逼真音效或與視頻角色以及風(fēng)格相匹配的對話鏡頭。

它還能為檔案材料、無聲電影等傳統(tǒng)影像生成音軌,拓寬創(chuàng)作的可能。

音頻提示: 可愛的幼年恐龍在叢林中啁啾,伴隨著蛋殼的破裂聲。(Cute baby dinosaur chirps, jungle ambience, egg cracking)

音頻提示: 汽車打滑聲、引擎轟鳴聲,伴隨著天使般的電子音樂。(cars skidding, car engine throttling, angelic electronic music)

音頻提示: 日落時分,草原上響起悠揚(yáng)的口琴聲。(a slow mellow harmonica plays as the sun goes down on the prairie)

V2A 技術(shù)能夠?yàn)槿魏我曨l輸入生成無限數(shù)量的音軌。用戶可以選擇定義「正向提示」來引導(dǎo)生成期望的聲音,或者「負(fù)向提示」來避免不期望的聲音。

這種靈活性讓用戶對音頻輸出有了更多的控制,可以快速嘗試不同的音頻輸出,并選擇最佳匹配。

音頻提示:一艘宇宙飛船在浩瀚的太空中疾馳,星星在它周圍劃過,高速飛行,充滿科幻感。(A spaceship hurtles through the vastness of space, stars streaking past it, high speed, Sci-fi)

音頻提示:天籟般的大提琴氛圍(Ethereal cello atmosphere)

音頻提示:一艘宇宙飛船在廣袤的太空中高速穿梭,星星在它周圍飛速掠過,具有科幻感。(A spaceship hurtles through the vastness of space, stars streaking past it, high speed, Sci-fi)

背后的工作原理

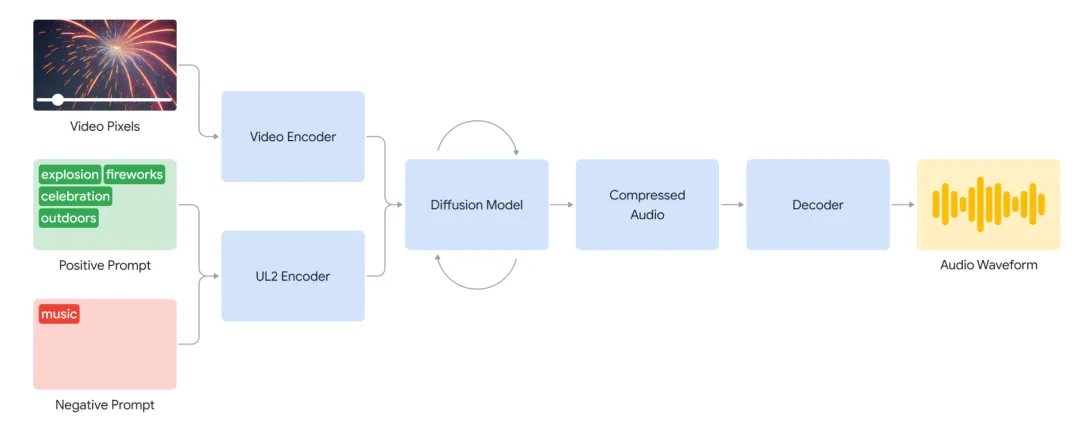

研究團(tuán)隊嘗試了自回歸和擴(kuò)散方法,以發(fā)現(xiàn)最可擴(kuò)展的 AI 架構(gòu)。擴(kuò)散方法在音頻生成上給出了最真實(shí)和引人入勝的結(jié)果,用于同步視頻和音頻信息。

V2A 系統(tǒng)首先將視頻輸入編碼成壓縮表示,然后擴(kuò)散模型從隨機(jī)噪聲中迭代細(xì)化音頻。這個過程由視覺輸入和給定的自然語言提示指導(dǎo),生成與提示緊密對齊的同步、逼真音頻。最終,音頻輸出被解碼成音頻波形,并與視頻數(shù)據(jù)結(jié)合。

為了生成更高質(zhì)量的音頻并引導(dǎo)模型生成特定聲音,研究團(tuán)隊在訓(xùn)練過程中添加了更多信息,包括 AI 生成的注釋,詳細(xì)描述聲音和對話文本。

通過在視頻、音頻和額外注釋上的訓(xùn)練,該技術(shù)學(xué)會將特定的音頻事件與各種視覺場景關(guān)聯(lián)起來,同時響應(yīng)注釋或文本中提供的信息。

谷歌方面強(qiáng)調(diào),他們的技術(shù)與現(xiàn)有的視頻到音頻解決方案都不同,因?yàn)樗梢岳斫庠枷袼兀⑶姨砑游谋咎崾臼强蛇x的。此外,該系統(tǒng)不需要手動對生成的聲音與視頻進(jìn)行對齊,極大地簡化了創(chuàng)作流程。

不過,谷歌的這一技術(shù)也并非完美,他們?nèi)栽谂鉀Q一些 bug。例如,視頻輸入的質(zhì)量直接影響音頻輸出的質(zhì)量,視頻中的偽影或失真可能導(dǎo)致音頻質(zhì)量下降。

同時,他們也在優(yōu)化唇形同步功能。

V2A 技術(shù)嘗試從輸入文本中生成語音,并將其與角色的口型動作進(jìn)行同步,但若視頻模型未針對文本內(nèi)容進(jìn)行相應(yīng)的調(diào)整,就可能導(dǎo)致口型與語音不同步。他們正改進(jìn)這一技術(shù),以提升唇形同步的自然度。

音頻提示:音樂,文本轉(zhuǎn)錄「這只火雞看起來好極了,我好餓。」(Music, Transcript: “this turkey looks amazing, I’m so hungry”)

或許是由于深度偽造技術(shù)帶來諸多社會問題,Google DeepMind 求生欲滿滿,一個勁承諾將負(fù)責(zé)任開發(fā)和部署 AI 技術(shù),在向公眾開放之前,V2A 技術(shù)將經(jīng)過嚴(yán)格的安全評估和測試。

此外,他們還整合了 SynthID 工具包到 V2A 研究中,為所有 AI 生成的內(nèi)容添加水印,以防止技術(shù)的濫用。

本文轉(zhuǎn)自機(jī)器之心 ,作者:機(jī)器之心