EMNLP 2023 | LLM工業界快速落地之PromptMix: 一種有效的混合數據增強策略將LLM能力遷移到小模型

一、概述

Title: PromptMix: A Class Boundary Augmentation Method for Large Language Model Distillation

URL: ??https://arxiv.org/abs/2310.14192??

代碼:??https://github.com/servicenow/promptmix-emnlp-2023??

Authors: Gaurav Sahu, Olga Vechtomova, Dzmitry Bahdanau, Issam H. Laradji

1 Motivation

? 利用大型語言模型如GPT3生成新示例以解決文本分類訓練數據不足的問題。

? LLM推理成本比較高、DistiBERTbase和BERTbase等模型受限于訓練數據不足問題,如何將LLM的知識有效轉移到SLM上是一個工業界值得嘗試的問題。

2 Methods

省流版總結:

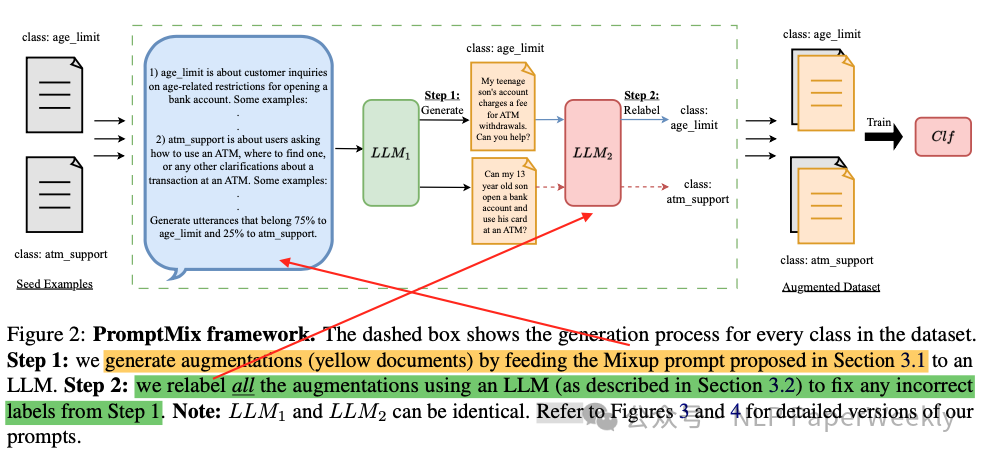

論文通過提出PromptMix方法來解決提出的問題,該方法包括兩個步驟:

1. 生成靠近類別邊界的挑戰性文本增強(但這樣做增加了數據集中出現誤標的風險);

2. 使用基于提示的大型語言模型分類器對文本增強進行重新標注,增強生成數據的標簽準確性。

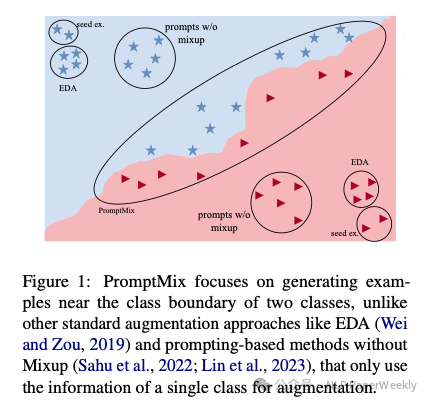

Figure 1: PromptMix focuses on generating exam- ples near the class boundary of two classes

詳細方法和步驟:

步驟一:挑戰性文本增強生成: 根據已有的分類數據,在類別邊界附近生成新的例子,從而提高模型面對邊界情況的識別能力。

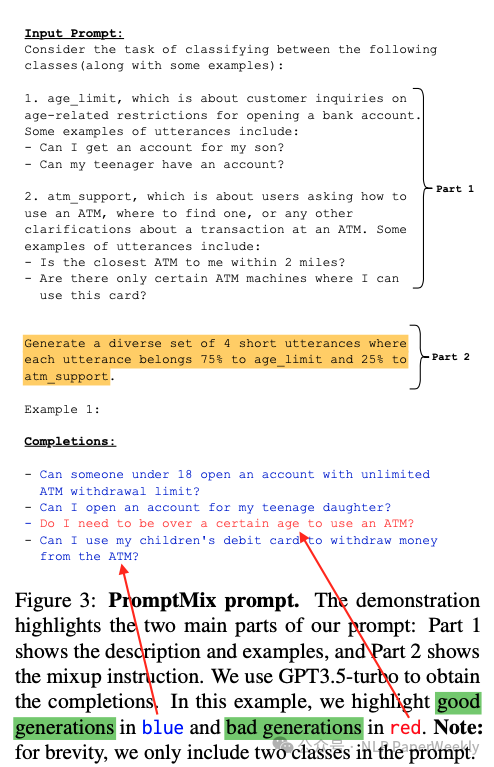

prompt分為三個部分,Instruct,Part1: 每個類別簡要的概述。part2: 對于每一個類別$$C_{i}$$,隨機選擇一個$$C_j$$,按一定混合比例生成兩者的難樣本數據。

注意:生成結果中,有些分類是錯的、有些結果是對的,需要進一步優化生成的Example。

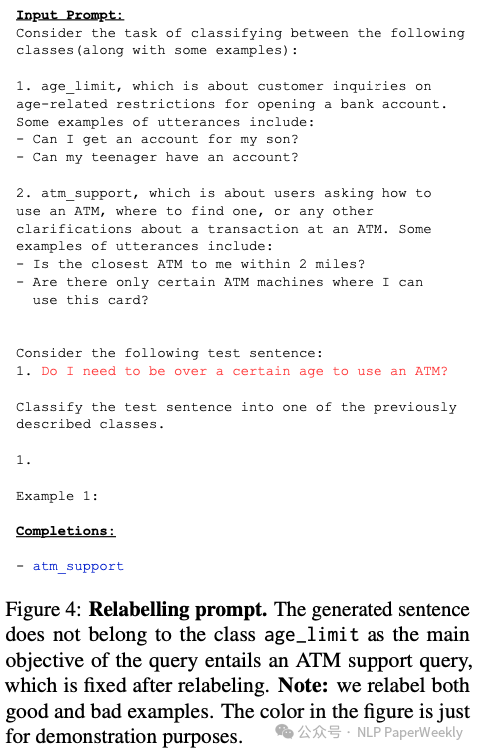

步驟二:基于提示的LLM分類器重標記: 由于在類別邊界附近生成的文本增強可能會增加假陽性的風險,所以使用基于提示的LLM分類器對這些數據進行重新標記,以保證生成數據的標簽準確性。

3 Conclusion

? PromptMix通過生成有挑戰性樣本和Relabeling策略,可以有效將如GPT3.5-turbo這樣的大型LLM轉移到更小、更便宜的分類器,如DistilBERT和BERT。

? 在Banking77、TREC6、Subjectivity和Twitter Complaints四個文本分類數據集中,2-shot PromptMix在多個5-shot數據增強方法上表現更佳。

二、詳細內容

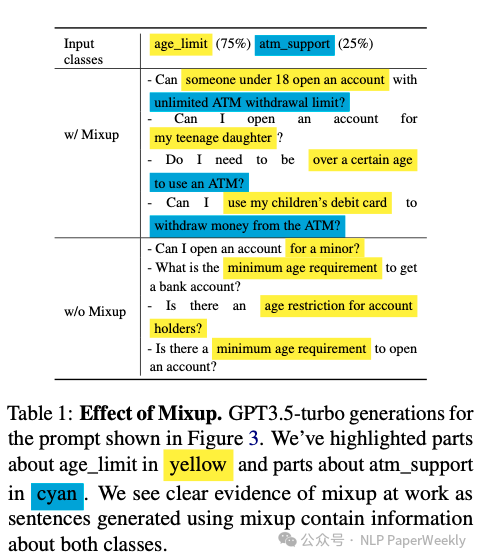

1 Mixup的效果

結論:Mixup能有效的將兩個類別的信息進行混合,從而提升最終難樣本的分類效果。

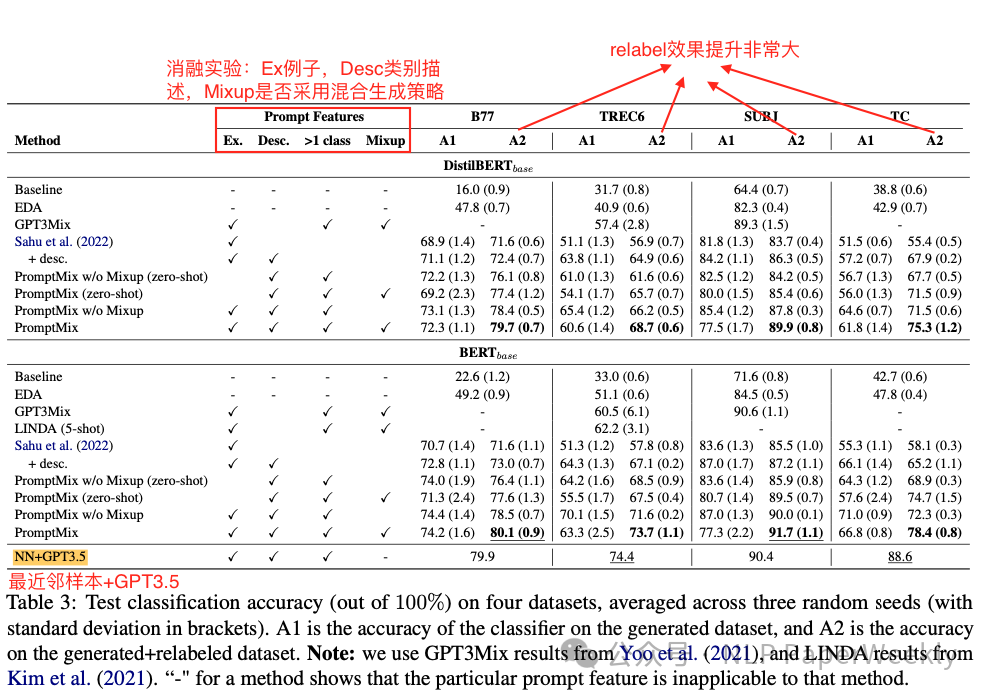

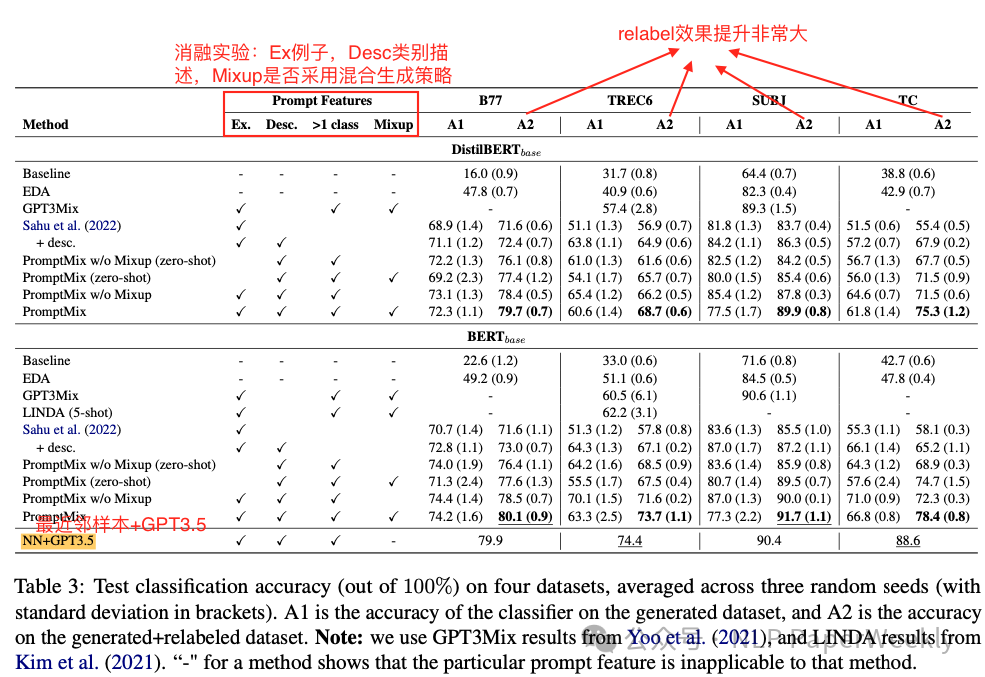

2 測試精度&消融實驗

展示了在四個不同的文本分類數據集(Banking77、TREC6、SUBJ和Twitter Complaints)上,使用不同方法進行數據增強后的測試分類準確率。這些方法包括基線(Baseline)、NN+GPT3.5、Sahu等人的方法(Sahu et al. (2022))、PromptMix及其變體(包括有無Mixup的PromptMix)、Easy Data Augmentation (EDA)、GPT3Mix等。表格中還包含了使用GPT3.5-turbo生成的句子在重新標記(Relabeling)前后的變化,以及在不同方法下GPT3.5-turbo重新標記生成示例的百分比。

說明:

- 1.Baseline:這是基線模型,它使用每個類別只有2個訓練樣本的原始數據集進行訓練。這是為了展示在數據稀缺情況下,其他數據增強方法相對于基線的性能提升。

- 2.NN+GPT3.5:這是一種使用最近鄰(Nearest Neighbor)方法和GPT3.5模型的組合。在這種方法中,GPT3.5被用來對測試集的例子進行分類。

結論:

- 數據增強的有效性:在所有四個數據集上,使用數據增強方法(如EDA和PromptMix)的模型在測試分類準確率上顯著優于基線(2-shot)模型。這表明在數據稀缺的情況下,數據增強是有幫助的。

- Relabel的重要性:通過比較A1(在第一步數據增強后)和A2(在第二步數據增強并重新標記后)的準確率,可以看出重新標記步驟顯著提高了模型性能。這表明PromptMix方法中的重新標記步驟對于提高生成數據的質量至關重要。

- PromptMix方法的優勢:PromptMix方法在所有數據集上都取得了很高的準確率,尤其是在B77和SUBJ數據集上,其性能與NN+GPT3.5相當,甚至在某些情況下超過了NN+GPT3.5。這表明PromptMix是一個有效的數據增強方法,尤其是在極端的少樣本(2-shot)文本分類設置中。

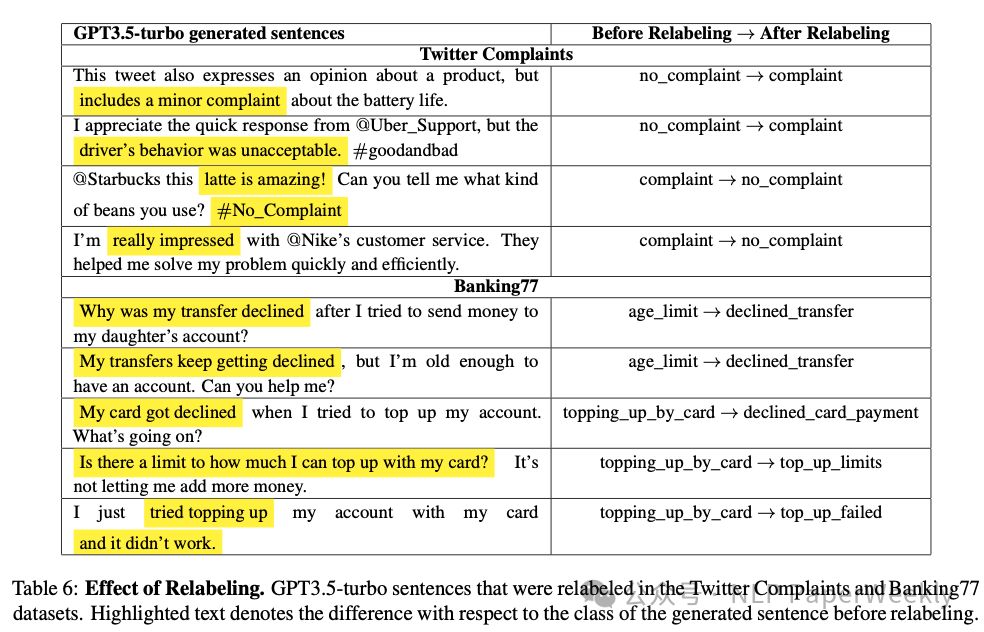

3 Relabeling的效果

生成的數據由于使用Mixup混合策略,很容易產生badcase,利用Relabeling策略可以對這些標簽進行修正,實驗看出這一步帶來效果的提升也非常大。

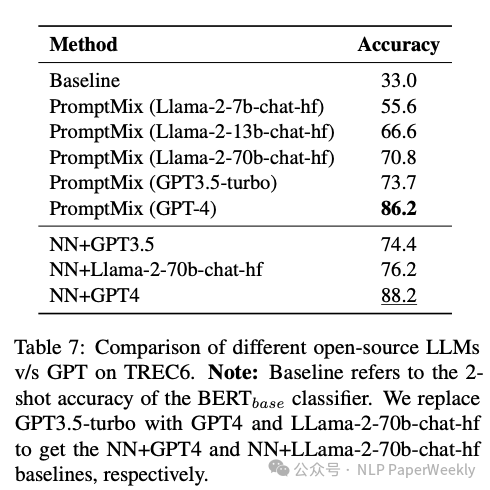

4 LLM基座對數據增強的影響

結論:基座模型能力越強,數據增強帶來的效果越好,一方面是生成的質量越高帶來的,另一方面Relabling階段,LLM效果越好,也可能分的更準。

三、總結

這篇論文介紹了PromptMix,一種新穎的類邊界數據增強方法,用于在訓練數據有限的情況下提高大型語言模型的文本分類效果。該方法通過生成挑戰性文本并結合Relabeling策略,生成類別精確的難樣本,以便更好地遷移大型模型(如GPT3.5-turbo)的知識到更小、更經濟高效的分類器(如DistilBERT和BERTbase)。論文的實驗表明,PromptMix在2-shot場景中的效果優于多個5-shot數據增強方法。

結論1: PromptMix通過生成有挑戰性樣本和Relabeling策略可以有效將LLM知識遷移到小模型。 該方法通過生成接近類別邊界的增強數據,然后使用LLM進行精準的Relabeling,有效提升了few-shot場景小模型的效果,可以大量降低人工的標注成本。 結論2: PromptMix為文本分類領域提供了一種新的數據增強策略。 本文所提出的方法在處理少量訓練數據的情況下,為提升分類器的性能提供了新的思路和方案。這意味著我們用少量樣本就可以訓練處一個效果非常不錯的分類模型,在工業界可能有著比較大的應用空間。

結論3: Relabeling策略可以帶來非常大的效果提升。 說明直接用LLM生成樣本效果不一定好,還需要進一步的處理策略,例如使用本文提到的Relabing策略,再利用LLM對增強的數據進行優化,從而整體上提升數據增強的質量。

本文轉載自?? NLP PaperWeekly??,作者: NLP PaperWeekly