字節圖像生成新模型:主打多主體一致性,新基準數據集同時亮相

設定角色,讓AI照“本”生成主角不變的不同圖像,對于各路AIGC工具來說一直是不小的挑戰。

而現在,字節再進一步,最新發布多主體控制生成模型Xverse——

既可以對設定好的每個主體進行精確控制,也不會破壞圖像的生成質量。

多主體?多光源?多風格?它說:安排!

那么Xverse是如何做到又穩又準的呢?

Xverse方法概述

XVerse的核心是通過學習DiT(Diffusion Transformer,一種擴散模型和Transformer架構的生成模型)中文本流調制機制中的偏移量,實現對多個主體身份和語義屬性的一致控制。

此方法包括四個關鍵組成部分:

T-Mod適配器

采用perceiver重采樣器作為文本流調制的核心,將CLIP編碼的圖像特征與文本提示特征結合,生成交叉偏移量。通過對每個token進行精細調制,模型得以精準控制多個主體的表現。

文本流調制機制

將參考圖像轉換為文本流調制的偏移量,并將這些偏移量添加到注入模型的相應token嵌入中,同時調整原始的縮放和移位參數,以實現對生成過程的精確控制。

VAE編碼圖像特征模塊

將VAE編碼的圖像特征作為輔助模塊集成到單個FLUX模塊中,增強了細節保留能力,使生成的圖像更加逼真,同時最大限度地減少了偽影和失真的出現。

正則化技術

為了進一步提升生成的質量和一致性,XVerse引入了兩種關鍵的正則化技術:

- 區域保留損失:通過在一側隨機保留調制注入,確保非調制區域的一致性;

- 文本圖像注意力損失:調整調制模型與參考文本到圖像(T2I)分支之間的交叉注意力動態,實現更精準的對齊。

XVerseBench基準測試

為了全面評估多主體控制圖像生成能力,字節提出了XVerseBench基準測試。

該測試的數據集主題豐富多樣,包含20種不同的人類身份、74種獨特的物品,以及45種不同的動物物種或個體,共設有300個獨特的測試提示。

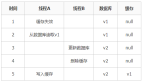

不僅如此,XVerseBench還采用多維評估指標:

- DPG評分:評估模型的編輯功能;

- Face ID相似度:評估模型維護人類身份的能力;

- DINOv2相似度:評估模型保持對象特征的能力;

- 美學評分:評估生成圖像的美學質量。

XVerse顯著提升多主體生成一致性

XVerse方法被用于與多種領先的多主體驅動生成技術進行對比,生成結果涵蓋單主體和多主體任務,相關的量化數據詳見下表。

此外,XVerse在保持生成圖像中身份與相關物體之間的一致性和關聯性方面也表現出更強的能力。

△XVerse其他先進技術的定性對比

字節團隊一致性研究概覽

這不是字節第一次在AIGC一致性方向上發力。

字節跳動智能創作團隊是字節跳動旗下專注于AIGC研發的核心技術團隊,長期致力于推動AI在圖像、視頻、文本等多模態內容創作中的創新應用,開發前沿生成模型和算法,提升內容的質量、效率與多樣性。

自2023年底上線的DreamTuner,該團隊率先實現了“從一張圖中學會記住一個人”的高保真身份保留。

緊接著,此團隊于2024年又推出了DiffPortrait3D,將一致性從2D拓展到3D空間,實現多視角下的精準建模。

進入2025年,字節在動畫生成方向發力,發布了OmniHuman-1,首次在音頻驅動下實現人物動作與表情的自然一致,進一步推動人物生成從“像”走向“活”。

而在多任務統一建模上,4月亮相的DreamO則成為關鍵節點:基于DiT框架,不僅支持身份控制、虛擬換裝、風格遷移等復雜任務,還實現了全流程中的穩定一致性。

這些研究成果均為XVerse的提出打下了堅實基礎。

接下來,該團隊的研究方向是,不斷提升AI創作的智能化和趣味性,使其更加貼合人們的日常需求和審美體驗。