用戶支付成功后,訂單狀態(tài)未及時更新導致重復發(fā)貨,如何通過最終一致性解決?

場景痛點

在電商系統(tǒng)中,用戶完成支付后,支付服務回調訂單服務更新狀態(tài)為“已支付”,隨后庫存服務扣減庫存,物流服務觸發(fā)發(fā)貨。若訂單服務在支付回調后因網絡抖動、瞬時高負載或短暫故障未能及時更新狀態(tài),而庫存服務卻感知到支付成功事件(可能通過其他渠道),則可能重復扣減庫存并發(fā)貨,導致企業(yè)經濟損失和用戶體驗下降。

強一致性的困境

傳統(tǒng)方案試圖通過分布式事務(如2PC)保證支付回調、訂單狀態(tài)更新、庫存扣減的原子性,但在高并發(fā)、跨多服務的場景下存在嚴重弊端:

2PC 協(xié)調者2PC 協(xié)調者支付服務訂單服務庫存服務? 性能瓶頸:同步阻塞導致吞吐量驟降,支付高峰期可能拖垮系統(tǒng)。

? 可用性風險:任一參與者故障導致全局事務卡死,支付回調無法完成。

? 擴展困難:新加入服務(如優(yōu)惠券核銷)需改造事務協(xié)議,系統(tǒng)僵化。

基于最終一致性的可靠事件模式

1. 架構轉型:事件驅動解耦

核心思想:支付成功作為事件發(fā)布,各服務異步訂閱并處理,接受短暫的狀態(tài)不一致,但確保最終正確。

發(fā)布支付成功事件訂閱訂閱訂閱支付服務消息隊列訂單服務:更新訂單狀態(tài)庫存服務:扣減庫存物流服務:創(chuàng)建發(fā)貨單2. 關鍵技術實現(xiàn)細節(jié)

2.1 可靠事件發(fā)布 - 本地事務表+事務日志追蹤

支付服務處理支付回調時,在同一個數(shù)據庫事務內完成:

BEGIN TRANSACTION;

-- 1. 更新支付單狀態(tài)為成功

UPDATE payment SET status = 'SUCCESS' WHERE id = ?;

-- 2. 插入待發(fā)布事件記錄(狀態(tài)為待發(fā)送)

INSERT INTO event_log (event_id, event_type, payload, status, create_time)

VALUES ('event_001', 'PAYMENT_SUCCESS', '{"orderId":"1001"}', 'PENDING', NOW());

COMMIT;? 原子性保障:支付狀態(tài)更新與事件記錄寫入在同一事務,確保二者狀態(tài)一致。

? 事件發(fā)布異步任務:獨立進程掃描event_log表中狀態(tài)為PENDING的記錄,將其投遞至MQ(如Kafka),成功后更新記錄狀態(tài)為PUBLISHED。

2.2 冪等消費 - 防御重復事件的關鍵盔甲

訂單服務、庫存服務等消費者必須實現(xiàn)冪等性:

// 訂單服務事件處理器示例

@KafkaListener(topics = "PAYMENT_SUCCESS")

public void handlePaymentSuccessEvent(PaymentSuccessEvent event) {

// 1. 冪等校驗:檢查事件是否已處理過

if (eventProcessed(event.getEventId())) {

log.warn("Duplicate event detected, skip processing: {}", event.getEventId());

return;

}

// 2. 在事務中處理業(yè)務并記錄事件處理

transactionTemplate.execute(status -> {

// 更新訂單狀態(tài)為已支付

orderService.updateStatus(event.getOrderId(), OrderStatus.PAID);

// 記錄事件處理成功

eventLogService.markEventProcessed(event.getEventId());

return null;

});

}? 冪等鍵設計:使用全局唯一事件ID (event_id) 作為冪等依據。

? 并發(fā)控制:數(shù)據庫唯一索引或Redis分布式鎖 (event_id為key) 防止并發(fā)重復處理。

2.3 狀態(tài)補償 - 最終一致性的守護者

場景:訂單服務處理事件失敗(如數(shù)據庫宕機),事件停留在MQ,但庫存服務可能已扣庫存并發(fā)貨。

補償機制:

? 定時對賬任務:

@Scheduled(cron = "0 */5 * * * *") // 每5分鐘執(zhí)行一次

public void reconcileOrders() {

// 1. 找出狀態(tài)為'已支付'但未生成發(fā)貨單的訂單(超過閾值時間)

List<Order> inconsistentOrders = orderDao.findPaidOrdersWithoutDelivery(10);

for (Order order : inconsistentOrders) {

// 2. 檢查庫存實際扣減記錄

InventoryDeduction deduction = inventoryService.getDeductionByOrder(order.getId());

if (deduction != null && deduction.isSuccessful()) {

// 3. 觸發(fā)發(fā)貨補償

logisticsService.compensateCreateDelivery(order);

// 4. 更新訂單標記,避免重復補償

order.markReconciled();

orderDao.save(order);

}

}

}? 人工干預通道:對賬異常時告警,并提供界面讓運營人員查看不一致訂單,手動觸發(fā)補償或回滾。

3. 核心組件強化設計

3.1 消息隊列的可靠性保證

? Kafka配置:生產者 acks=all 確保消息寫入所有ISR副本;消費者啟用手動提交offset,業(yè)務成功后才提交。

? 死信隊列(DLQ):處理多次重試仍失敗的消息,避免阻塞主流程,供后續(xù)分析或人工處理。

3.2 分布式追蹤集成

? 注入Trace ID(如OpenTelemetry)貫穿支付回調、事件發(fā)布、服務消費鏈路。

? 日志統(tǒng)一收集,便于故障時快速定位跨服務問題。

3.3 事件版本控制與Schema演進

? 事件結構包含版本號 version。

? 消費者兼容多版本事件(如Jackson的 @JsonIgnoreProperties(ignoreUnknown=true))。

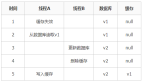

方案效果與關鍵指標

1. 數(shù)據一致性窗口:從小時級降低至秒級(取決于MQ傳輸和消費者處理速度)。

2. 系統(tǒng)吞吐量:異步化使支付回調RT從數(shù)百毫秒降至毫秒級,吞吐提升3-5倍。

3. 故障隔離:訂單服務短暫故障不影響支付成功事件發(fā)布,庫存服務可繼續(xù)處理其他訂單事件。

4. 業(yè)務損失:通過補償機制,將因狀態(tài)不一致導致的資損降至萬分位以下。

總結與最佳實踐

最終一致性不是降低標準,而是通過系統(tǒng)性設計換取可用性與性能的躍升。實施要點:

? 冪等性是基石,無冪等不談最終一致。

? 補償重于預防:承認部分失敗不可避免,通過事后高效修復兜底。

? 可觀測性:完善監(jiān)控(事件積壓、處理延遲、補償觸發(fā)次數(shù))和鏈路追蹤。

? 漸進式演進:優(yōu)先在核心鏈路應用,逐步替代原有分布式事務。

在云原生與微服務架構深度普及的今天,擁抱最終一致性是構建高可用、高擴展電商系統(tǒng)的必然選擇。它要求開發(fā)者跳出ACID的舒適區(qū),以更全局、更彈性的思維駕馭分布式系統(tǒng)的復雜性,將數(shù)據一致性轉化為一個持續(xù)收斂的過程,而非瞬時強求的狀態(tài)。