AI視頻的DeepSeek時刻!開源13B模型生成提速30倍,5090跑出好萊塢特效

AI視頻的DeepSeek時刻什么時候來?沒想到吧,這就來了。

最新開源模型LTXV-13B,免費可商用、推理速度快、游戲顯卡就能跑,視覺效果也不錯。要素都齊了,想不火都難。

從官方透露的信息看,新模型在速度、質量和控制三個方面有所提升。

生成速度——同類產品的30倍,提出想法可以獲得接近實時的反饋。

視頻質量——眼見為實,請看VCR。

可控制性——支持逐幀控制,能讓你按照自己想法來打造視頻,創作自由度直接拉滿。

這個13B參數的模型,官方證實在24G顯存的4090/5090上就能跑,也難怪網友紛紛為之瘋狂。

大家曬出的“買家秀”,效果比官方賣家秀看起來也毫不縮水:

開源視頻生成新標桿

LTX-Video支持文本轉圖像、圖像轉視頻、基于關鍵幀的動畫、視頻擴展(正向和反向)、視頻轉視頻,以及上述所有這些功能的任意排列組合。

- 視覺效果爆炸

LTXV-13B擁有超130億個參數,即使在快速復雜的場景,也能提供更流暢的運動、更少的偽影和更清晰的視覺效果。

那么下面再直觀感受一下效果。

Prompt:一位有著棕色長發和白皙皮膚的女人對著另一位女人微笑……一位有著棕色長發、膚色白皙的女子正對著另一位有著金色長發的女子微笑。這位棕色頭發的女子身穿黑色夾克,右臉頰上長著一顆幾乎難以察覺的小痣。鏡頭角度為特寫鏡頭,聚焦于這位棕色頭發女子的臉部。光線溫暖自然,似乎是落日的余暉,在場景中投射出柔和的光芒。這幅場景似乎是真實拍攝的。

還可以不斷地調整拍攝角度,營造出非常自然的航拍效果。

Prompt:海浪沖擊著海岸線上嶙峋的巖石……海浪拍打著海岸線上嶙峋的巖石,濺起陣陣浪花。巖石呈深灰色,邊緣鋒利,裂縫深邃。海水清澈碧綠,浪花拍打巖石的地方泛起白色的泡沫。天空呈淺灰色,幾朵白云點綴在地平線上。

這下誰還能分清什么是現實什么又是AI生成的呢?

但記得要在生成之前放大圖片,不要像下面這位網友一樣:

- 生成速度提升

相較于同類產品,LTXV-13B生成速度領先近30倍,但質量可是一點都沒打折扣,相當適合快速迭代、實時反饋和大規模生產場景。

不僅效率大幅度提升,成本也跟著降低,用消費級GPU就能搞定,也可以選擇官方平臺LTX Studio云體驗。

- 精細創意控制

此外,LTXV還有強大的創意控制功能,提供多關鍵幀調節(起始幀和結束幀)、攝像機控制(推拉、變焦、搖臂、軌道等)、面部表情控制等。

LTXV-Video:實時視頻潛空間擴散模型

官方透露,LTX Video做到更流暢的運動和更一致的幀間連貫性,關鍵在于多尺度渲染技術,即同時以多種空間分辨率分析場景,保留精細細節的同時理解大規模結構。

如下面的例子,可以看到從左到右人物臉上的細節越來越豐富。

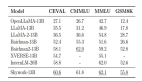

從團隊幾個月前發布的2B參數模型論文也可以看出,訓練階段就同時使用了多種分辨率和時長組合的數據。

訓練時通過調整原始視頻大小,使輸入樣本包含大致相同數量的token,并采用隨機丟棄token的策略,避免復雜的token填充或打包操作,保持數據多樣性。

上一代2B參數的模型就以速度和效率見長,能夠以超過實時的速度生成高質量視頻,在H100 GPU上僅需2秒就能生成5秒、24幀每秒、768×512分辨率的視頻。

優化生成速度的秘訣在于一種整體式Latent Diffusion方法,將Video-VAE和去噪Transformer的任務無縫融合,在它們之間共享去噪目標。

另外Video VAE部分對時空維度進行32×32×8的下采樣壓縮,將高分辨率的視頻數據轉換到低分辨率的潛在空間進行處理,通過空間和時間壓縮來降低冗余。

它實現了1:192的壓縮比,超過當時的主流開源模型如MovieGen、CogVideoX等的1:48或1:96的壓縮比。

為實現這種高壓縮率,團隊將圖像塊化操作(patchify)從Transformer的輸入移到了VAE的輸入,使每個token能夠表示更多的像素信息,幫助Transformer計算全時空自注意力(full spatiotemporal self-attention)。

高壓縮率雖好,但會限制對細節的表示能力。為了解決這個問題,LTX-Video還采取了多種新策略。

在訓練Video VAE時引入GAN,減少高壓縮率下L2 loss產生的模糊問題。

為此提出改進的Reconstruction GAN,判別器同時接收原始樣本和重建樣本,通過判斷哪個是原始的、哪個是重建的,簡化了判別器的任務,提高了其引導生成器的能力,使生成的視頻在保持與原始樣本相似性的同時,能更有效地平衡保真度和感知質量。

此外還有一些小的改動如下:

- 多層噪聲注入:受StyleGAN啟發,在VAE解碼器的多個層注入噪聲,允許生成更多樣化的高頻細節。

- 統一對數方差:使用寬潛空間(大量channels)時,標準KL損失會導致不均勻的利用。團隊使用了所有潛通道共享的單一預測對數方差,均勻分配KL損失的影響。

- 視頻DWT損失:引入了spatio-temporal Discrete Wavelet Transform (DWT) loss,確保高頻細節的重建。

LTX-Video同時支持文本生成視頻和圖像生成視頻兩種能力。

對于文本條件生成,團隊使用了預訓練的T5-XXL文本編碼器生成初始文本嵌入,并采用了交叉注意力機制,而非MM-DiT方法。

而對于圖像條件生成,他們擴展了Open-Sora的方法,利用擴散時間步作為條件指示器,允許無縫條件化視頻的任何部分。

這種方法不需要特殊的tokens或專門為圖像到視頻任務訓練的模型,大大簡化了流程。

2013年成立的老牌團隊

LTX-Video開發團隊Lightricks成立于2013年,前大模型時代有兩個招牌產品,為美顏相機應用Facetune和視頻剪輯應用Videoleap,在蘋果商店至今仍排得上號。

2023轉型AI后,推出LTX Studio視頻生成平臺,支持逐鏡頭地構建視頻和時間線編輯,可以精細控制每個場景,并保持角色一致性,主要面向影視、廣告和個人視頻創作者。

除開源模型外,Lightricks還提供配套的訓練工具,支持微調、預處理數據集、為視頻添加字幕、分割場景等使用功能。

LTX Video 13B模型推出后開源社區也非常感興趣,已經有人在一天之內就為其訓練好了LoRA,讓不同類型角色的眼睛都能冒電光特效,引起網友圍觀。

感興趣(且趁24GB顯存)的朋友們,可以下載起來了。