推理延展到真實物理世界,英偉達Cosmos-Reason1:8B具身推理表現超過OpenAI ο1

在基于物理世界的真實場景進行視覺問答時,有可能出現參考選項中沒有最佳答案的情況,比如以下例子:

根據視頻中本車的動作,它接下來最有可能立即采取的行動是什么?

A:右轉,B:左轉,C:換到右車道,D:換到左車道

很顯然,這里最佳的答案應該是直行,但預先提供的 4 個選項中并沒有這個答案。也因此,目前的大多數 AI 在面臨這個問題時往往并不能識別題中陷阱,會試圖從選項中找到正確答案。比如下面展示了 ChatGPT 的回答:

當然,在日常的視覺問答任務中,這樣的錯誤無傷大雅,但一旦涉及到真實的任務場景(比如真正的自動駕駛),這樣的錯誤就是無法容忍的了。

而要正確解答這類問題,物理常識必不可少。

近日,英偉達發布了一系列針對物理常識推理進行了專門優化的新模型:Cosmos-Reason1。從實際結果看,該模型的表現確實不錯。比如針對以上問題,該模型經過一番推理后,認為給出的選項都不對,因此沒有給出選擇。

Cosmos-Reason1 針對以上視覺問答問題輸出的思考過程和答案。

據介紹,Cosmos-Reason1 不僅包含模型,更是英偉達開發的一個包含模型、本體(ontologies)和基準的套件,其目標是讓多模態 LLM 能夠生成有物理依據的響應。

目前他們已經發布了兩個多模態 LLM:Cosmos-Reason1-8B 和 Cosmos-Reason1-56B。

這兩個模型都經過了四個階段的訓練:視覺預訓練、通用 SFT、物理 AI SFT 和物理 AI 強化學習。此外,他們還為物理常識和具身推理定義了本體,并構建了用于評估多模態 LLM 的物理 AI 推理能力的基準。

下面我們就來具體看看英偉達的這項研究成果。

- 論文標題:Cosmos-Reason1: From Physical Common Sense To Embodied Reasoning

- 論文地址:https://arxiv.org/abs/2503.15558

- 代碼地址:https://github.com/nvidia-cosmos/cosmos-reason1

物理 AI 推理

物理 AI(Physical AI)并不是一個新概念,但肯定算是英偉達近段時間最為推崇的發展方向之一 —— 在黃仁勛前些天的 GTC 2025 大會 Keynote 演講中,物理 AI 也是核心關鍵詞之一。

根據英偉達官網的定義:物理 AI 是指使用運動技能理解現實世界并與之進行交互的模型,它們通常封裝在機器人或自動駕駛汽車等自主機器中。

在今天介紹的這篇論文中,英偉達首先定義了物理常識(physical common sense)的本體論(ontology)。

可以看到,其中包含三大類別:空間、時間和其它基本物理。這三大類又被進一步分為 16 類,如下表 1 所示。

此外,該團隊也定義了具身推理的本體論,其中涉及處理復雜的感官輸入、預測動作效果、尊重物理約束、從互動中學習;詳見下表。

Cosmos-Reason1

下面將介紹 Cosmos-Reason1 的多模態架構以及 LLM 主干選擇。

多模態架構

為了構建多模態 LLM,現在已經有多種不同的架構選擇。常用的架構是僅解碼器架構(例如 LLaVA)和基于交叉注意力的架構(例如 Flamingo 和 Llama 3-V)。

英偉達采用了類似于 LLaVA 和 NVLM-D 的僅解碼器架構,因為它簡單且可通過將其它模態 token(圖像或視頻)對齊到文本 token 嵌入空間來統一處理所有模態。

具體來說,該模型的架構首先是一個視覺編碼器,然后是包含下采樣兩層 MLP 的 projector,然后是僅解碼器的 LLM 主干。

具體選擇上,英偉達這里使用了 InternViT-300M-V2.5 作為 Cosmos-Reason1-8B 和 Cosmos-Reason1-56B 的視覺編碼器。

對于每張輸入圖像,該架構會動態調整圖像以達到預定義的寬高比,并將其分割成 1 到 12 個圖塊,每個圖塊的尺寸為 448 × 448 像素,具體取決于圖像的分辨率。此外,還會生成一個縮略圖圖塊 —— 完整圖像的縮小版本,以保留全局上下文。

對于每段輸入視頻,則以最高每秒 2 幀的速率均勻采樣最多 32 幀,并將每幀的大小調整為 448 × 448 像素。對于每個 448×448 視頻幀輸入,視覺編碼器會生成 1,024 個視覺 token,其圖塊大小為 14×14,然后使用 PixelShuffle 將其下采樣 2×2 倍,通過將空間維度轉換為通道維度將其減少到 256 個 token。

來自多個圖塊的圖像 token 與交錯的圖塊 ID 標簽連接在一起,而來自多個幀的視頻 token 則會直接連接在一起。

Cosmos-Reason1 的 LLM 主干采用了混合 Mamba-MLP-Transformer 架構設計。

表 3 總結了其模型配置:

混合 Mamba-MLP-Transformer 主干

最近英偉達發布了不少 Mamba-Transformer 混合架構的研究成果,事實上我們昨天就正巧介紹過其中兩個:Nemotron-H 和 STORM。

而今天我們介紹的 Cosmos-Reason1 系列模型則采用了 Mamba-MLP-Transformer 混合架構,如下圖所示。

在訓練時,Cosmos-Reason1-8B 模型采用了 4 的張量并行化(TP=4),而 Cosmos-Reason1-56B 模型則采用了 8 的張量并行化和 2 的管道并行化(TP=8, PP=2)—— 可支持更長視頻的訓練。

實驗表現

下面我們簡單看看 Cosmos-Reason1 系列模型的實驗表現。有關實驗的更多詳細設置和討論請閱讀原論文。

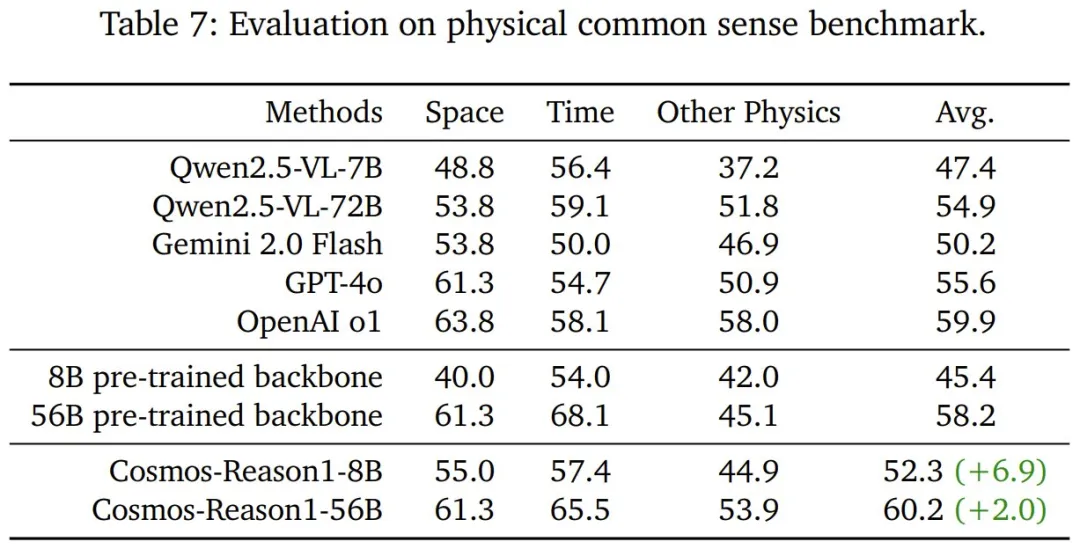

物理 AI 監督式微調的效果

首先來看經過物理 AI 監督式微調后,Cosmos-Reason1 的物理常識表現。如表 7 所示,Cosmos-Reason1-8B 和 Cosmos-Reason1-56B 在各自的主干網絡基礎上都有明顯提升,其中 56B 版本的準確度表現最好,甚至略微超過了 OpenAI ο1。

要知道,這個結果是在強化學習訓練之前取得的。這彰顯了該團隊精心挑選的常識數據集的有效性,為進一步的 RL 改進奠定了堅實的基礎。

接下來看看經過物理 AI 監督式微調后,Cosmos-Reason1 的具身推理表現。從表 8 可以看到,Cosmos-Reason1 模型在此基準上取得了比所有基線模型明顯更好的結果,8B 和 56B 變體與各自的主干 VLM 相比均有超過 10% 的提升。

那 Cosmos-Reason1 的直覺物理理解能力如何呢?該團隊觀察到,許多 VLM 在基本物理推理方面存在困難。該團隊針對三個任務對模型的能力進行了測試,包括時間箭頭、空間拼圖和物體持久性。

表 10 展示了測試結果,可以看到在時間箭頭和物體持久性任務上,現有模型的表現和胡亂猜測差不多。而在空間拼圖任務上,GPT-4o 和 OpenAI o1 的表現卻比隨機亂猜好得多。

這表明當前的多模態模型在推理空間關系方面比推理時間動態方面更熟練。鑒于這些模型通常在 MMMU 等標準基準上表現良好,這說明現有評估其實無法體現它們對物理世界的理解能力。

然而,該團隊精心設計的直覺物理數據集可使 8B 模型能夠在所有三個任務上有顯著提升,就展現 Cosmos-Reason1 在直覺物理推理方面的基本能力。

物理 AI 強化學習的效果

對于上面得到的模型,該團隊又進行了進一步的后訓練,以進一步增強它們的物理 AI 推理能力。為此,該團隊構建了自己的 RL 基礎設施,并基于其針對物理常識、具身推理和直覺物理推理任務對模型進行了后訓練。注意,這里并沒有使用復雜獎勵,都是簡單的、基于規則的可驗證獎勵。

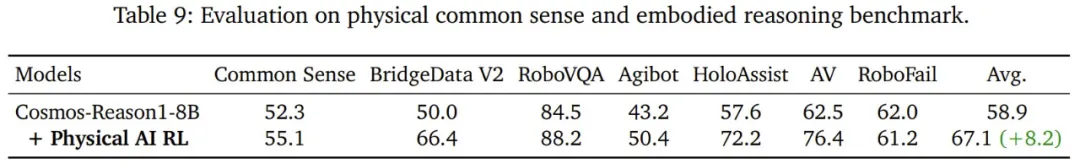

首先來看在物理常識和具身推理任務上的結果,如表 9 所示。

可以看到,物理 AI RL 后訓練可以提高模型在大多數基準上的性能,但 RoboFail 是個明顯的例外。

不過該團隊表示這并不奇怪,因為 RoboFail 是經過精心設計的人工整編的基準,具有測試「動作可供性(action affordance)」和「任務完成驗證」的高難度現實場景。該基準的難度源于幾個因素:(1) 需要高度觀察的感知或全面的時間上下文處理的樣本,(2) 與 RoboVQA 中的問題不同,可供性問題涉及動作執行中的復雜物理約束。

該團隊認為,在 RoboFail 上的表現不提升的主要原因是代表性訓練數據不足。

該團隊還發現了一個有趣現象:新提出的模型學會了仔細評估所提供的選項,如果問題不明確,則會全部拒絕。如本文開始時舉的例子所示,該模型會評估每個選項的可行性,并在出現歧義時采取不在選擇范圍內的保守行動。

最后,在直覺物理推理任務上,如上表 10 所示,通過精心的監督式微調數據整編和針對性訓練,Cosmos-Reason1-8B 在所有任務上都取得了顯著的進步,而物理 AI RL 能夠進一步增強模型的空間拼圖和物體持久性能力。然而,推理時間箭頭仍然很困難。

整體來說,物理 AI RL 可以提升模型在空間、時間和物體持久性方面的推理能力。

圖 9 展示了在 RL 前后 Cosmos-Reason1 的時間推理能力的差異。可以看到,該模型能夠識別反物理的運動 —— 例如粉末違背重力上升到碗中,同時不受視頻中靜止干擾物的影響。這表明它的推理不僅僅是感知。

類似地,在圖 10 中可以看到,有 RL 的模型傾向于將空間問題與時間推理混淆。雖然他們可以感知到第二幀與第一幀缺乏相似性,但它們固有的偏見會導致它們遵循默認的視頻順序,這表明它們更多地依賴于時間線索而不是真正的空間理解。

使用空間謎題來進行 RL 可讓模型從第一幀中提取關鍵特征,并在多幀之間系統地比較它們,從而準確地確定空間關系。

最后,圖 11 表明,即使 CoT 較長,沒有物理 AI RL 的模型也會難以理解物體持久性,經常難以推理物體的出現和消失。相比之下,經過 RL 的模型可通過直接而簡潔的推理快速得出結論。