三種RAG部署方案:自購GPU硬件 vs 大模型一體機 vs 云端GPU

春節以后這一個半月,算了下我前后也做了 20+的企業知識庫落地咨詢,其中無論是線上還是線下,被問到最多的一個問題是:

要快速落地本地部署的知識庫,應該購買什么硬件?

要回答這個問題,其實需要明確很多前置定語,自購 GPU 硬件、大模型一體機、以及選擇云端 GPU 都有各自適用的情形。這篇試圖說清楚三種部署方式的主要特點對比,并在文末給些選擇建議參考。

以下,enjoy:

1、自購 GPU 硬件

以 NVIDIA GeForce RTX 4090 GPU (24GB 顯存)為例,我接觸到的企業方里不乏有些已經屯了幾塊,但是大部分都在吃灰,主要這玩意配置起來有些小門檻,下面結合兩張 4090 部署 DeepSeek R1 qwen 32B 為例做個簡要的部署流程介紹,供參考:

1.1 硬件配置

顯卡

使用兩張 NVIDIA RTX 4090 顯卡(單卡 24GB 顯存),需要通過張量并行實現顯存共享與計算加速。

推薦 PCIe 4.0 x8/x8 通道拆分,確保雙卡間數據交互帶寬充足。

主板與 CPU

主板需支持雙 PCIe 4.0 插槽(如 Z790/Z890 芯片組)。

CPU 建議選擇多核型號(如 Intel i9-14900K 或 AMD Ryzen 9 7950X),以處理數據加載與多任務調度。

內存與存儲

內存至少 64GB DDR5(推薦 128GB),提升模型加載效率。

存儲需 1TB NVMe SSD,用于存放模型文件(約 20-40GB)。

電源與散熱

電源建議 1300W 以上(單卡 TDP 450W,雙卡+系統需預留余量)。

配備高效風冷或水冷系統,確保長時間運行穩定性。

1.2 軟件環境配置

操作系統推薦選擇 Ubuntu 22.04 LTS,或者 Windows 11(但是需要 WSL2 支持)。安裝 NVIDIA 驅動(≥535 版本)和 CUDA Toolkit 12.2,支持 Ampere 架構優化。

另外因為是雙卡,所以要驗證下驅動,nvidia-smi 顯示雙卡狀態,nvcc -V 確認 CUDA 版本。

安裝 PyTorch(≥2.4.0)與 CUDA 適配版本, vLLM版本≥0.5.5。

1.3 模型部署與 vLLM 配置

從HuggingFace或魔塔社區下載 DeepSeek R1-32B-GPTQ-Int4 量化模型:

huggingface-cli download --resume-download DeepSeek/DeepSeek-R1-32B-GPTQ-Int4 --local-dir ./DeepSeek-R1-32B使用以下命令啟動雙卡并行推理服務:

vllm serve ./DeepSeek-R1-32B \

--tensor-parallel-size 2 \

--host 0.0.0.0 \

--port 6006 \

--served-model-name DeepSeek-R1-32B \

--gpu-memory-utilization 0.95 \

--max-model-len 4096 \

--quantization gptq關鍵參數說明:

tensor-parallel-size 2:啟用雙卡張量并行。

gpu-memory-utilization 0.95:顯存利用率調至 95%,避免 OOM。quantization gptq:啟用 4-bit GPTQ 量化,顯存需求降至約 22GB/卡。1.4 并發優化

實測雙卡 RTX 4090 在 4-bit 量化下,生成吞吐量可達 60-80 tokens/s(單卡約 35-45 tokens/s)。可以根據顯存和請求長度調整--max-num-seqs(默認 256),單卡可支持 10-20 并發請求。使用 Nginx 反向代理可以實現多實例負載均衡,從而提升整體吞吐。

RAG 框架部署部分,為了節省篇幅就不贅述了,大家自行去各個產品官網去看,基本就是 git+docker compose 的一鍵操作。

自購 GPU門檻主要在于需要自行解決安裝配置、驅動兼容、散熱等問題,需要額外承擔電費和維護成本,當然好處就是自由度高,可以根據需求自定義硬件配置,也不需要擔心數據隱私和安全問題。

2、大模型一體機

上面說了自購硬件的各種配置操作,在一體機這里倒不是個問題。目前市場上也有很多款專門 DeepSeek 設計的一體機,我也偶爾會收到些一體機廠商的合作溝通。

這些都預裝了軟硬件環境,有針對國產芯片的優化版本,比如基于華為昇騰、百度昆侖芯等,價格范圍一般中低端配置在幾萬塊,中高端就幾十萬水平,具體取決于品牌、硬件配置和功能需求。

好處很明顯,就是開箱即用,內置了多種應用場景,如語音識別、圖像識別、自然語言處理等,不需要復雜配置即可快速上手,廠商通常提供統一的管理界面。

劣勢除了價格外,就是無法根據企業需求靈活升級性能,一般只能使用廠商提供的模型和工具。但有一說一,這種確實比較缺乏專業 IT 團隊進行配置和維護的企業。

3、云端 GPU

3.1 6 大 GPU 廠商

云端 GPU 部署是指租用云服務商(如阿里云、騰訊云、AWS 等)提供的 GPU 實例,來部署大模型和 RAG 框架。根據實際使用的資源按需付費,特別適合初學者或短期 POC 驗證。下面貼了兩張全球六大云服務商的地域分布和實例類型的對比,大家做個參考。

以上兩張圖片來自fastone官網

價格方面根據實例配置收費差別很大,對于初期測試 RTX 4090 為例也就夠用了,但是很遺憾的是目前阿里云、騰訊云等主流平臺主要提供 NVIDIA A100、V100、T4 等專業計算卡,尚未推出基于 RTX 4090 的實例。以下貼了張從阿里云官網找的主流實例類型和價格,大家做個參考:

3.2 glows.ai

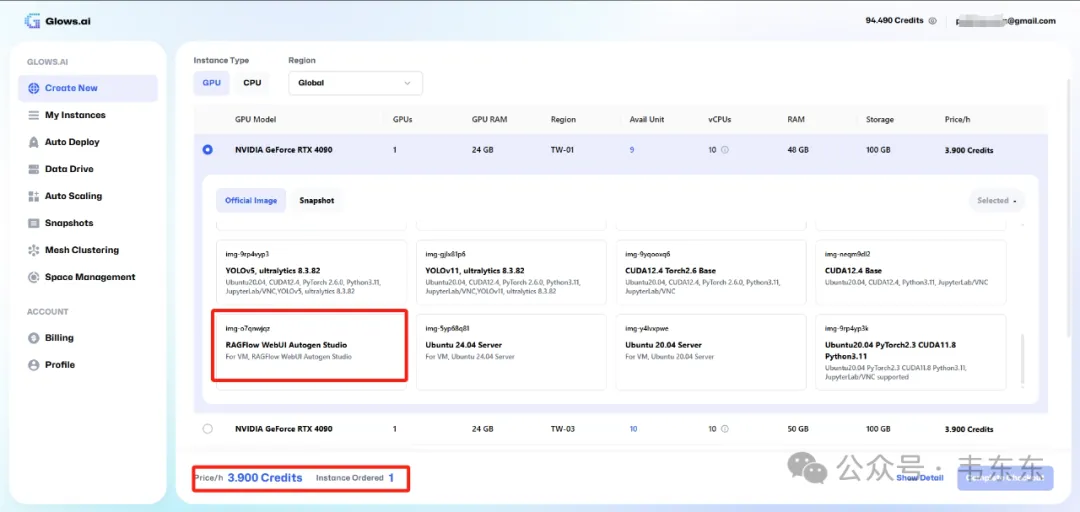

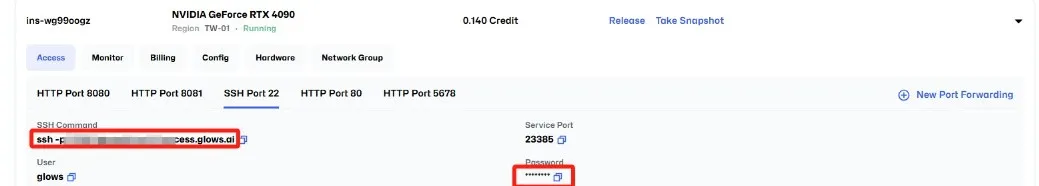

為了更加便宜的進行測試,這里推薦個 glows.ai 平臺(不是廣告)可以選擇 4090 的實例,而且很神奇的是,其中居然有個 RAGFlow 實例已預裝好相關環境和框架,主打一個開箱即用。

價格方面,每小時需要 3.9 個 credits( RTX 4090 GPU (24GB 顯存,10 個 vCPU,48GB 內存,100GB 存儲空間)。我充值了 10 刀有 100 個 credits,差不多 2.8 元每小時,這個價格很適合個人或者小企業來進行短期測試,我現在在給一些企業做 demo 的時候,也是在上面進行操作的。

https://glows.ai/invite/Glows-69kjxn2p (注冊鏈接,無免費額度)

(注:第三方小廠商的穩定性與技術支持,大家自行測評)

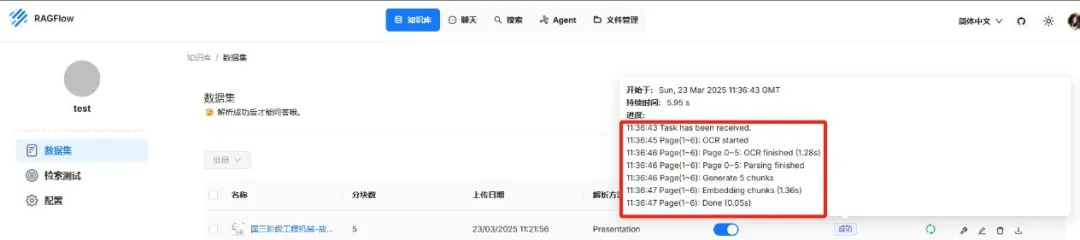

關于使用方式上,最直接的是打開提供的網頁鏈接訪問 ragflow 的網站,這個效果和本地使用 docker 部署后使用 localhost 打開是一樣的用法,唯一不同的就是確實會比自己集成顯卡的電腦解析文檔快些。

不過還是推薦使用 romote ssh 插件進行連接,這樣就可以在本地通過 ragflow 的官方 python api 或者 http api 編寫一些自定義的處理腳本,從而更好的實現行業特定的分塊策略,以及專業領域的檢索優化。

(此處插播個廣告,歡迎去試下我在知識星球發布的部分腳本。p.s.下周會建會員群交流日常實踐)

如果在做好前兩項的基礎上,可以再進一步探索嵌入模型的對比,上下文構建等。當然,具體情況還需要根據實際項目特點和資源限制來調整。

需要說明的是,在云端 GPU 這種 RAG 部署方式下,我沒有展開介紹開源模型的部署過程,這是以為既然選擇了云端測試就更沒必要做 LLM 的單獨部署,如果后續考慮在本地部署 DeepSeek-R1-Distill-Qwen-32B(目前接觸企業的主流選擇),那就在云端測試環節也直接調用這個 LLM 的 API 即可。

我主要在用的是 siliconflow 這個平臺,大家可以做個參考。https://cloud.siliconflow.cn/models?target=deepseek-ai/DeepSeek-R1-Distill-Qwen-32B 。 當然,Qwen 系列的 QwQ-32B 也可以同步對比下看看。

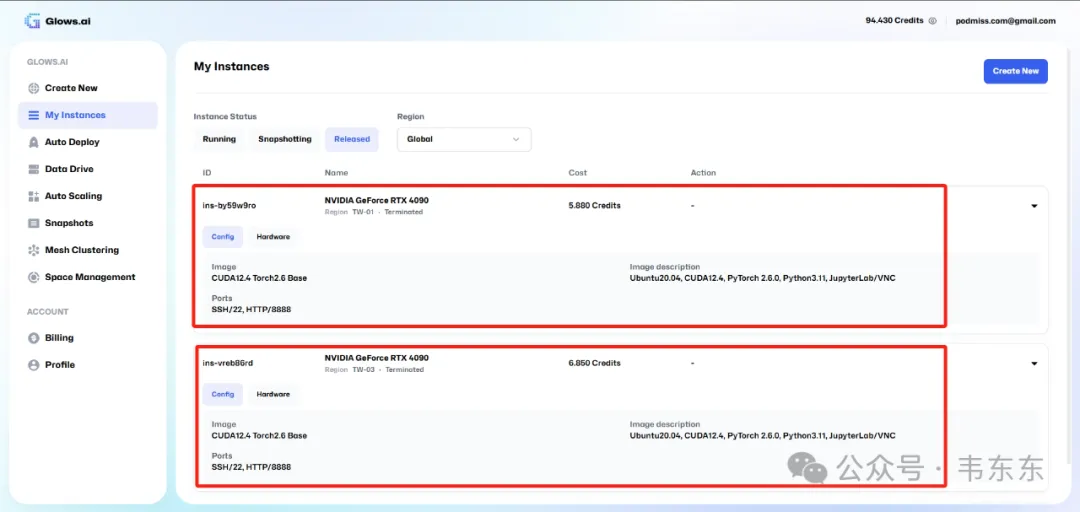

另外,對于云端 GPU 的測試方案,當想要釋放云端資源停止計費時,有幾種方法可以保存代碼和文件。最簡單的就是在 VS Code 中,直接從遠程文件資源管理器中將文件拖放到本地窗口。當然,如果項目已經使用 Git 管理,只需確保所有更改都已提交并推送到遠程倉庫。另外,Glows.ai 也提供了"Snapshot"功能,在釋放實例前創建快照,下次可以從快照快速恢復環境。

4、結語

選擇 RAG 系統的部署方式沒有一刀切的標準答案,需要企業根據自身的業務需求、技術能力、預算情況和安全合規要求綜合考量。

- 對于對數據安全要求很高、長期使用且有 IT 團隊的企業,自購 GPU 硬件可能是理想選擇;

- 但對于技術能力有限但預算充足的企業,大模型一體機提供了便捷的解決方案;

- 而對于初創企業、需求波動大或短期項目,云端 GPU 服務則提供了最靈活的選擇。

Anyway,個人建議先從小規模云服務開始做 POC 驗證,RAG 各個核心組件的調優本也需要花點功夫去適配業務場景,完成初步調試后先在企業內部做小范圍試點,隨著業務的成熟和規模的擴大,再考慮遷移到更符合長期戰略的部署方式。