田淵棟和Sergey Levine參與開發(fā)新型RL算法,能通過多輪訓(xùn)練讓智能體學(xué)會協(xié)作推理

現(xiàn)實(shí)世界中,很多任務(wù)很復(fù)雜,需要執(zhí)行一系列的決策。而要讓智能體在這些任務(wù)上實(shí)現(xiàn)最佳性能,通常需要直接在多輪相關(guān)目標(biāo)(比如成功率)上執(zhí)行優(yōu)化。不過,相比于模仿每一輪中最可能的動作,這種方法的難度要大得多。

在直接優(yōu)化多輪目標(biāo)方面,一類自然的方法是應(yīng)用單輪 RLHF 算法,例如 RAFT、DPO 和 PPO ,不過這些方法不會在不同輪次間執(zhí)行顯式的 credit 分配。因此,由于復(fù)雜順序決策任務(wù)的長期性,它們可能會出現(xiàn)高方差和較差的樣本復(fù)雜性等問題。

另一種選擇是應(yīng)用價值函數(shù)學(xué)習(xí)方法,例如 TD 學(xué)習(xí)。然而,這需要在 LLM 表征的基礎(chǔ)上訓(xùn)練一個新的特定于任務(wù)的價值頭,這可能無法在有限的微調(diào)數(shù)據(jù)下很好地泛化。因此,目前尚不清楚哪種多輪 RL 算法最有效,能夠充分利用 LLM 的推理能力來訓(xùn)練通用、有能力和目標(biāo)導(dǎo)向的智能體。

近日,Meta FAIR 和加利福尼亞大學(xué)伯克利分校一個研究團(tuán)隊(duì)在這個研究課題上取得了新的突破。首先,他們?yōu)樵搯栴}構(gòu)建了一個新的基準(zhǔn):ColBench(Collaborative Agent Benchmark)。在此基礎(chǔ)上,他們還提出了一種易于實(shí)現(xiàn)但非常有效的 RL 算法:SWEET-RL(RL with Step-WisE Evaluation from Training-Time Information)。

- 論文標(biāo)題:SWEET-RL: Training Multi-Turn LLM Agents on Collaborative Reasoning Tasks

- 論文地址:https://arxiv.org/pdf/2503.15478

- 代碼地址:https://github.com/facebookresearch/sweet_rl

這篇論文的一作為伯克利 AI 研究所(BAIR)二年級博士生周逸飛(Yifei Zhou)。并有多位著名 AI 研究者參與其中,包括田淵棟、Jason Weston 和 Sergey Levine。

下面我們就來簡單解讀一下這項(xiàng)研究,更多詳情請參閱原論文。

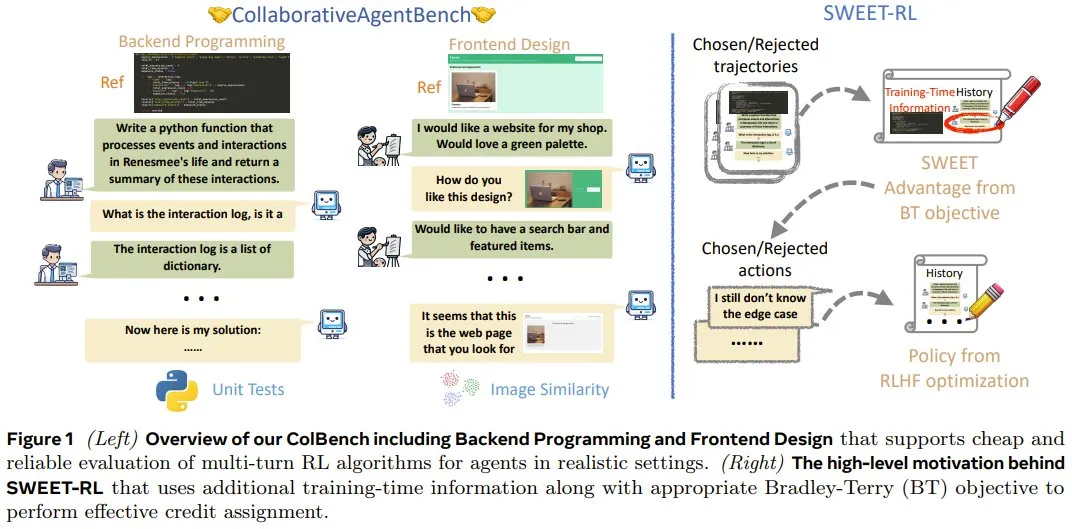

ColBench

先來看看他們提出的新基準(zhǔn)。首先,為了解決為 LLM 智能體開發(fā)多輪 RL 算法的挑戰(zhàn),該團(tuán)隊(duì)構(gòu)建了一些基本設(shè)計(jì)原則,包括:

- 應(yīng)具有足夠的任務(wù)復(fù)雜性,可以挑戰(zhàn)智能體的推理和泛化能力。

- 盡可能地降低開銷,以支持快速研究原型設(shè)計(jì)。

- 應(yīng)該有足夠的任務(wù)多樣性,以便在 RL 訓(xùn)練時不會過擬合。

接下來,具體看看該基準(zhǔn)中的兩個任務(wù):后端編程和前端設(shè)計(jì)。

后端編程協(xié)作

在此任務(wù)中,智能體需要與人類模擬器協(xié)作編寫自定義 Python 函數(shù)(最多 50 行)。

在協(xié)作開始時,智能體會先獲得高級描述和函數(shù)簽名。但并不會提供很多具體的細(xì)節(jié),例如應(yīng)考慮哪些條件以及在邊緣情況下該怎么做。智能體必須推理并決定需要人類模擬器提供哪些具體說明。人類模擬器需要根據(jù)只有它們自己可見的參考代碼,用自然語言對每個需要說明的問題提供簡要解釋,但不會編寫代碼。

智能體和人類模擬器之間的交互僅限于 10 輪來回。當(dāng)智能體決定給出最終解決方案或達(dá)到最大輪數(shù)時,交互結(jié)束。

在評估智能體是否成功時,需要對每個函數(shù)進(jìn)行 10 次隱藏單元測試,并對每次協(xié)作給出 0 或 1 的獎勵。

前端設(shè)計(jì)協(xié)作

在此任務(wù)中,智能體需要與人類模擬器協(xié)作,通過編寫 HTML 代碼片段(約 100 行)來設(shè)計(jì)網(wǎng)頁。

在協(xié)作開始時,智能體會獲得網(wǎng)頁的高級描述。同樣,許多具體細(xì)節(jié)(例如網(wǎng)頁的布局和調(diào)色板)都缺失,只有人類模擬器才能看到。在每一輪中,智能體都有機(jī)會編寫 HTML 結(jié)果并通過 Web 瀏覽器呈現(xiàn)出來。人類模擬器可以對比來自智能體的網(wǎng)頁和參考網(wǎng)頁,然后向智能體描述它們的差異。與后端編程協(xié)作類似,當(dāng)智能體決定給出最終解決方案或達(dá)到最大 10 輪交互時,交互結(jié)束。

評估指標(biāo)方面,使用了智能體解答與參考網(wǎng)頁之間的 CLIP 嵌入的余弦相似度。同樣,協(xié)作結(jié)束時,會發(fā)放 0 或 1 的獎勵。

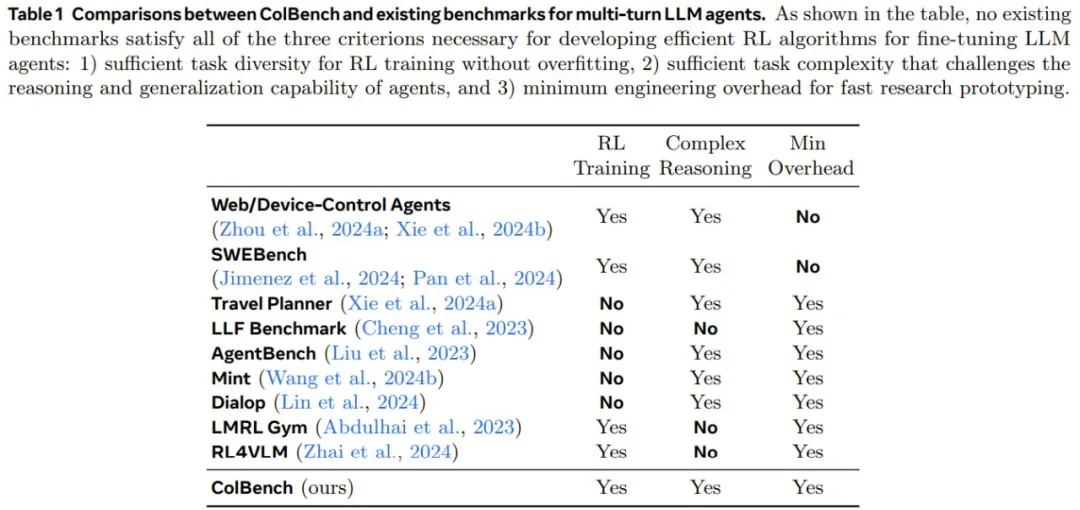

表 1 比較了 ColBench 與現(xiàn)有的其它基準(zhǔn)。

SWEET-RL

SWEET-RL 是一種兩階段訓(xùn)練方法,如圖 2 所示。

第一階段:學(xué)習(xí)各個輪次的優(yōu)勢函數(shù)

為了在推理密集型任務(wù)中執(zhí)行顯式 credit 分配,之前一些研究使用的方法是:先學(xué)習(xí)一個顯式的價值函數(shù),然后從學(xué)習(xí)到的價值函數(shù)中得出每個單獨(dú)動作的優(yōu)勢。

然而,該團(tuán)隊(duì)的實(shí)驗(yàn)發(fā)現(xiàn),當(dāng)微調(diào)只能使用有限數(shù)量的樣本時,這種價值函數(shù)不能很好地泛化。他們猜想這是因?yàn)樵谕评砻芗腿蝿?wù)中學(xué)習(xí)準(zhǔn)確的價值函數(shù)本身就是一項(xiàng)艱巨的任務(wù),并且不能有效地利用預(yù)訓(xùn)練 LLM 的推理和泛化能力。

由于執(zhí)行 credit 分配的最終目標(biāo)是得出每個動作的優(yōu)勢,這對于 LLM 來說可能比估計(jì)預(yù)期的未來回報(bào)更容易,因此該團(tuán)隊(duì)提出直接學(xué)習(xí)每個輪次動作的優(yōu)勢函數(shù)。

考慮到偏好優(yōu)化已經(jīng)在 LLM 微調(diào)方面得到成功應(yīng)用,因此該團(tuán)隊(duì)提出根據(jù)軌跡的偏好對來訓(xùn)練每輪次優(yōu)勢函數(shù)。

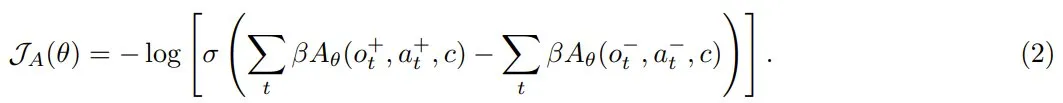

給定同一任務(wù)的兩條軌跡,并附加訓(xùn)練時間信息 c,根據(jù)它們的累積獎勵將它們標(biāo)記為選取 τ+ 和拒絕 τ?。這樣一來,便可以采用 Bradley-Terry 目標(biāo)進(jìn)行微調(diào):

然后,可以使用優(yōu)勢函數(shù)重寫這個目標(biāo)函數(shù):

直觀地講,類似于單輪 RLHF 的目標(biāo),即學(xué)習(xí)每個選取響應(yīng)的高獎勵和每個拒絕響應(yīng)的低獎勵,2 式的效果是增加選取軌跡中每個動作的優(yōu)勢并降低拒絕軌跡中每個動作的優(yōu)勢。

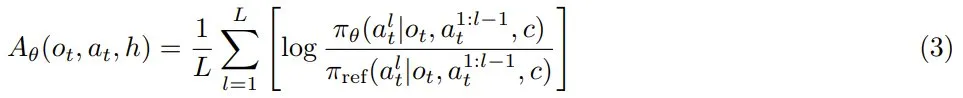

為了進(jìn)一步將學(xué)習(xí)目標(biāo)與下一 token 預(yù)測預(yù)訓(xùn)練對齊,該團(tuán)隊(duì)的做法是重新利用 LLM 的現(xiàn)有語言模型頭來參數(shù)化優(yōu)勢函數(shù):

第二階段:通過每輪流的優(yōu)勢優(yōu)化智能體

該團(tuán)隊(duì)得到的一個重要觀察是:雖然最終策略 π_φ 不能以隱藏信息 h 為條件,但此類信息在訓(xùn)練期間是可用的。由于優(yōu)勢 LLM π_θ 只會在訓(xùn)練期間使用,因此它可以將 c 作為 3 式的輸入。

直觀地講,許多現(xiàn)實(shí)問題(例如協(xié)作和數(shù)學(xué)推理)都具有一些隱藏的訓(xùn)練時間信息,例如參考解。如果每輪次的優(yōu)勢函數(shù)可以訪問此類訓(xùn)練時間信息,那么它應(yīng)該能夠更好地判斷策略采取的行動是否在正確的軌道上。

因此,他們?yōu)槊枯喆蔚膬?yōu)勢函數(shù)提供了額外的訓(xùn)練時間信息 c,而僅向策略提供了交互歷史 o_t,從而產(chǎn)生了不對稱的 actor-critic 結(jié)構(gòu)。原則上,RLHF 文獻(xiàn)中的任何成功算法都可用于優(yōu)化每輪次策略 π_φ,方法是將交互歷史視為提示詞,將每輪次優(yōu)勢函數(shù) A_θ 視為獎勵模型。在訓(xùn)練策略的這個階段,不需要人類合作者的互動。

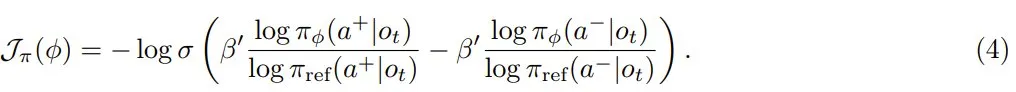

為了簡單,該團(tuán)隊(duì)選擇使用 DPO 進(jìn)行訓(xùn)練。對于每個輪次 t,首先從給定交互歷史 o_t 的當(dāng)前策略中抽取候選動作,并根據(jù)學(xué)習(xí)到的每輪次優(yōu)勢函數(shù)對它們進(jìn)行排序,以獲得要選取和拒絕的動作。然后,使用標(biāo)準(zhǔn) DPO 損失優(yōu)化每個輪次的策略:

在實(shí)踐中,每個輪次都會采樣 16 個候選動作,并從前 50% 分位數(shù)中隨機(jī)選擇動作作為選取動作,從后 50% 分位數(shù)中隨機(jī)選擇動作作為拒絕動作。

實(shí)驗(yàn)表現(xiàn)

作為多輪強(qiáng)化學(xué)習(xí)算法,SWEET-RL 究竟能不能有效地訓(xùn)練 LLM 智能體來完成復(fù)雜的協(xié)作任務(wù)呢?為此,該團(tuán)隊(duì)進(jìn)行了實(shí)驗(yàn)驗(yàn)證。

在 ColBench 上的表現(xiàn)

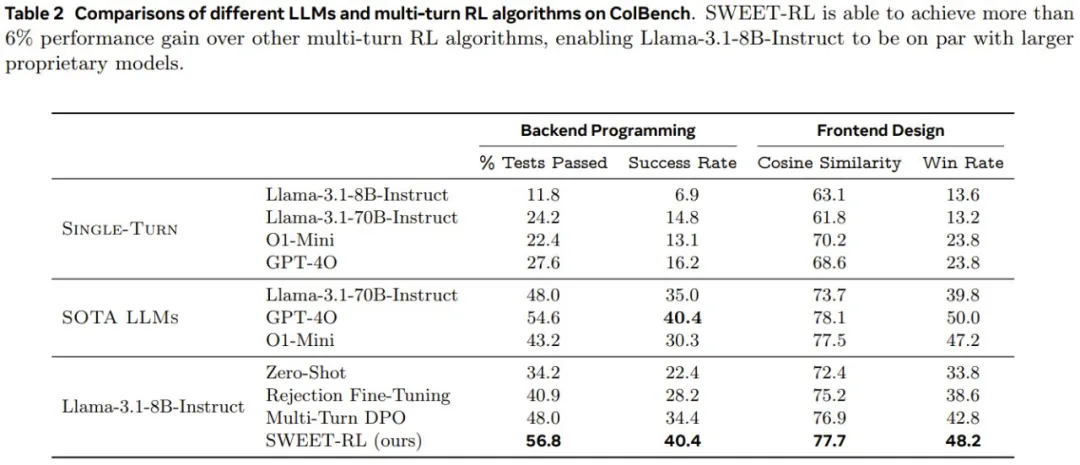

表 2 展示了在 ColBench 上,不同 LLM 和多輪 RL 算法的性能情況。

首先,比較「單輪」結(jié)果和其他協(xié)作結(jié)果,可以看到多輪協(xié)作可以通過將最終結(jié)果與人類模擬器的參考「期望」更緊密地結(jié)合起來,從而大大提高 LLM 智能體在 artifact 創(chuàng)建方面的性能。如果智能體必須在一個輪次內(nèi)直接生產(chǎn)最終結(jié)果,那么即使是表現(xiàn)最好的 GPT-4o 也只能達(dá)到 16.2%。相比之下,如果讓所有模型有機(jī)會與人類模擬器進(jìn)行多輪交互并收集更多信息,則所有模型的成功率都能倍增(例如,Llama-3.1-8B-Instruct 的成功率從 6.9% 增加到 22.4%)。

盡管如此,即使對于 GPT-4o 和 o1-mini 等專有 LLM 來說,多輪協(xié)作仍然是一項(xiàng)具有挑戰(zhàn)性的任務(wù),它們的成功率分別只能達(dá)到 40.4% 和 30.3%。盡管 o1-mini 在數(shù)學(xué)和編碼等符號推理任務(wù)上有所改進(jìn),但該團(tuán)隊(duì)觀察到這些改進(jìn)并沒有直接讓多輪協(xié)作智能體采用更好的策略,這表明為了讓 LLM 優(yōu)化與人類的協(xié)作,下游微調(diào)仍然是必要的。

SWEET-RL 與其它算法的比較

在使用下游數(shù)據(jù)進(jìn)行微調(diào)后,可以看到即使是最簡單的 RL 算法拒絕式微調(diào)(Rejection Fine-Tuning)也可以提高在這兩項(xiàng)任務(wù)上的性能。具體來說,后端編程成功率和前端設(shè)計(jì)成功率分別提高了 5.8% 和 4.8%。

然而,該團(tuán)隊(duì)觀察到,拒絕式微調(diào)往往只是教 LLM「記住」每個訓(xùn)練任務(wù)的解決方案,而沒有學(xué)習(xí)一種可泛化的策略來應(yīng)對新的測試任務(wù)。

多輪次 DPO 通過為被拒絕的軌跡引入「負(fù)梯度」可以緩解這個問題,但如果沒有在長期時間上進(jìn)行適當(dāng)?shù)?credit 分配,改進(jìn)仍然有限。

而如果利用訓(xùn)練時間信息顯式地訓(xùn)練每輪次的獎勵模型來執(zhí)行 credit 分配,可以觀察到相比于多輪次 DPO,SWEET-RL 在兩個任務(wù)上都有顯著提升(后端編程成功率提高 6%,前端設(shè)計(jì)勝率提高 5.4%)。

事實(shí)上,使用 Llama-3.18B-Instruct 得到的 SWEET-RL 模型不僅在參數(shù)上與 Llama-3.1-70B-Instruct 的性能相當(dāng),而且在性能上也足以與 GPT-4o 和 o1-mini 等 SOTA 專有模型比肩。

有關(guān) SWEET-RL 的更多實(shí)驗(yàn)細(xì)節(jié)和分析請參閱原論文。