英偉達超級Rubin細節曝光,黃氏法則再升級!最高1024GB顯存,免費H100無人要

黃氏計算法則,幾乎每年一更。

今年GTC 2025大會上,黃仁勛兩個多小時演講中,又向世界帶來了最新的計算法則——

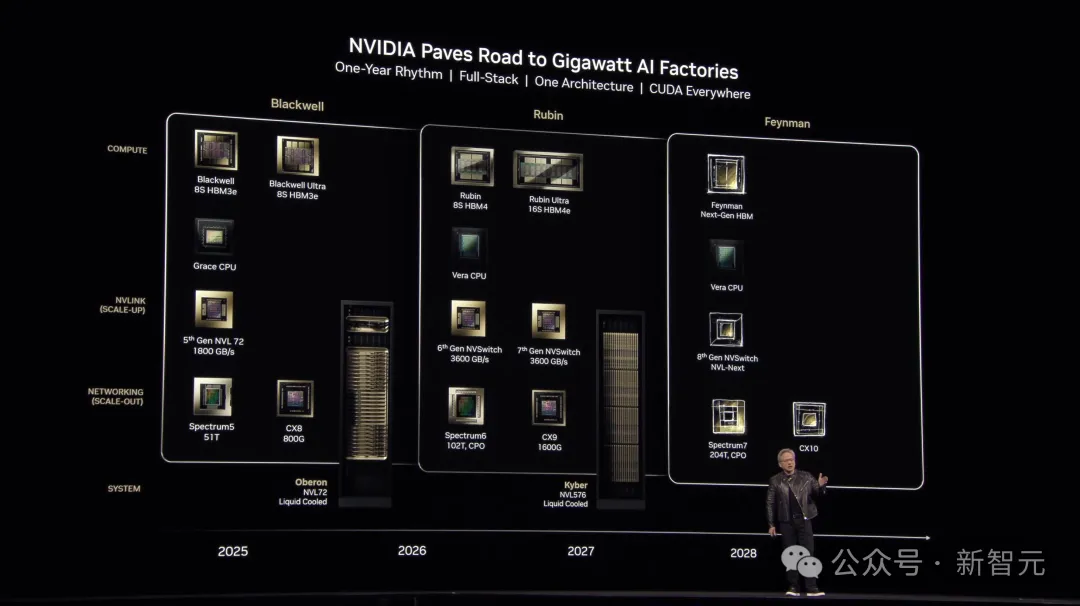

現在,GPU數量按照每個「封裝」內的GPU芯片數量來計算,而不是以「封裝」數量計算。

這種全新的計算法則,將從英偉達下一代GPU Rubin系列開始應用。

在SemiAnalysis獨家報道中,就英偉達GPU和系統路線圖、最新Blackwell Ultra 300、26年Vera Rubin、從芯片到系統再到軟件的全新推理優化等方面進行了詳細分析。

高級分析師指出,過去6個月里,模型的進化超過了之前六個月的總和。

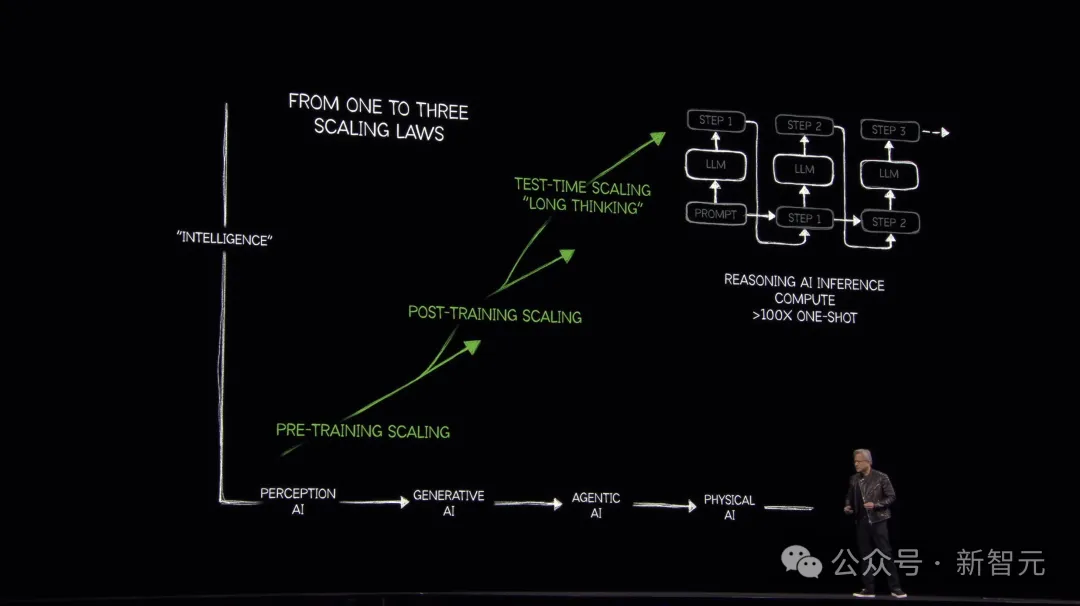

而且,這種趨勢仍將持續,因為三個Scaling Law正在疊加并協同作用:預訓練Scaling、后訓練Scaling、推理時Scaling。

恰恰,今年GTC大會全面聚焦的是全新Scaling范式。

推理Token爆發增長

一直以來,Claude模型以其強大的編程能力,得到開發者青睞,尤其是Claude 3.7在軟件工程方面展現出驚人的性能。

另一方面,Deepseek V3出世表明,上一代模型的能力成本正暴跌,促進了更廣泛的應用。

OpenAI最新實驗模型o1、o3用時證明,更長的推理時間和搜索能帶來更好的答案。就像預訓練Scaling的早期階段一樣,為這些模型增加更多后訓練計算能力似乎沒有上限。

面對這一系列新事物,老黃給出最有力的回答。

他表示,「從GPT開始,到如今的推理AI,它不再是僅僅預測下一個token,而是生成100多倍的token」。

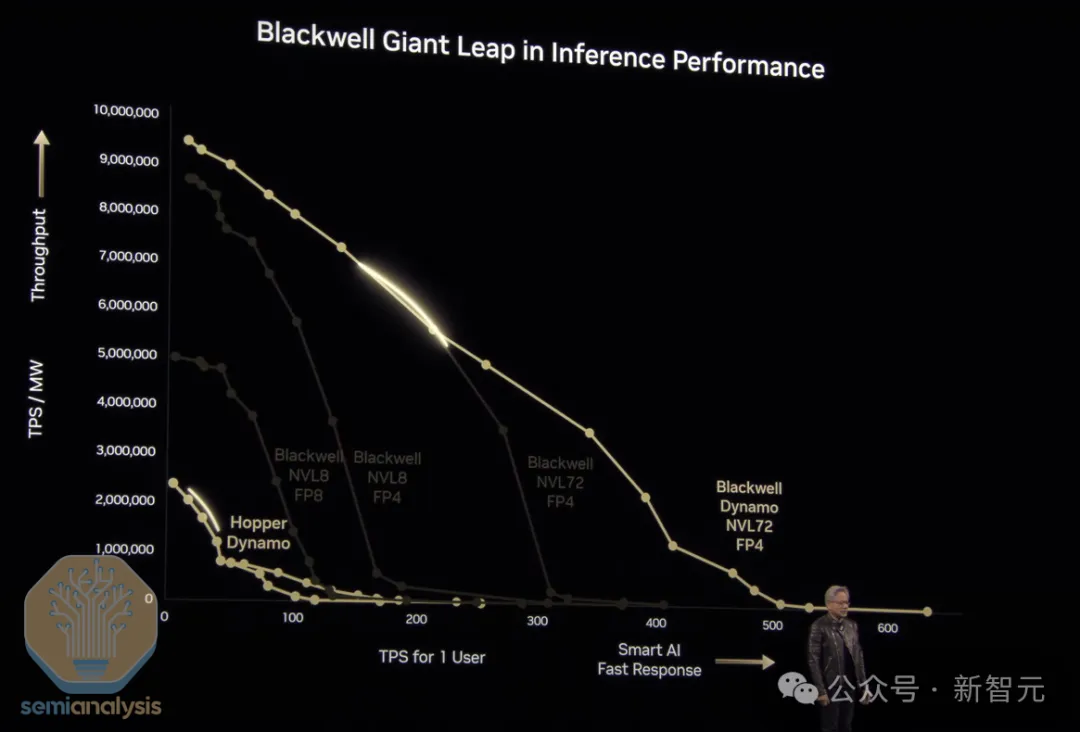

為了支持更多模型訓練部署,英偉達推出了「AI工廠的操作系統」Dynamo,使得Blackwell推理性能相較Hopper暴漲40倍。

不僅如此,他們正致力于將推理成本效率提升35倍,以支持更多模型的訓練和部署。

老黃的口頭禪也從以往「買越多,省越多」,變成了「省越多,買越多」。(the more you save, the more you buy.)

英偉達在硬件和軟件方面的發展路線圖,著實帶來了顯著的推理效率提升。

這為LLM經濟高效部署,以及其他變革性企業應用開啟了全新機遇——這正是杰文斯悖論(Jevons’ paradox)的典型案例。

用老黃的話來說,「買越多,賺越多」。(the more you buy, the more you make)。

不過,市場對此卻表示擔憂。

他們的關注點在于類DeepSeek這樣的軟件優化技術和英偉達推動的硬件性能提升,正帶來過度的成本節省,這可能導致AI硬件需求下降,市場將出現token供過于求的現象。

誠然,價格會影響需求,但隨著智能成本的降低,智能能力的邊界不斷突破,需求也隨之增長。

目前的AI能力,仍受限于推理成本。而且,AI對我們生活的實際影響尚處于萌芽階段。

有趣的是,隨著成本下降,總體使用量反而會出現悖論性增長。

人們對token通縮的擔憂,就像當年討論光纖泡沫時期只關注每個數據包的互聯網連接成本下降,卻忽視了網站和互聯網應用最終將如何改變我們的生活、社會和經濟。

這里有個關鍵區別:帶寬需求是有限的,而智能需求則會隨著能力的顯著提升和成本的下降,無限增長。

英偉達提供的數據印證了Jevons’ paradox。當前的模型已經需要超100萬億個token,而推理模型更需要20倍的token用量和150倍的計算資源。

測試階段的計算每次查詢需要數十萬個token,且每月查詢量高達數億次。

在后訓練scaling階段,每個模型需要處理數萬億個token,同時存在數十萬個接受后訓練的模型。

更重要的是,Agentic AI的出現意味著多個模型將協同合作,共同攻克越來越具有挑戰性的問題。

黃氏計算法則,每年一更

每年,老黃都會向業界引入全新的計算法則。

黃氏計算法則一直以其獨特性聞名,而今年情況更加特別,SemiAnalysis觀察到了第三條新的計算法則。

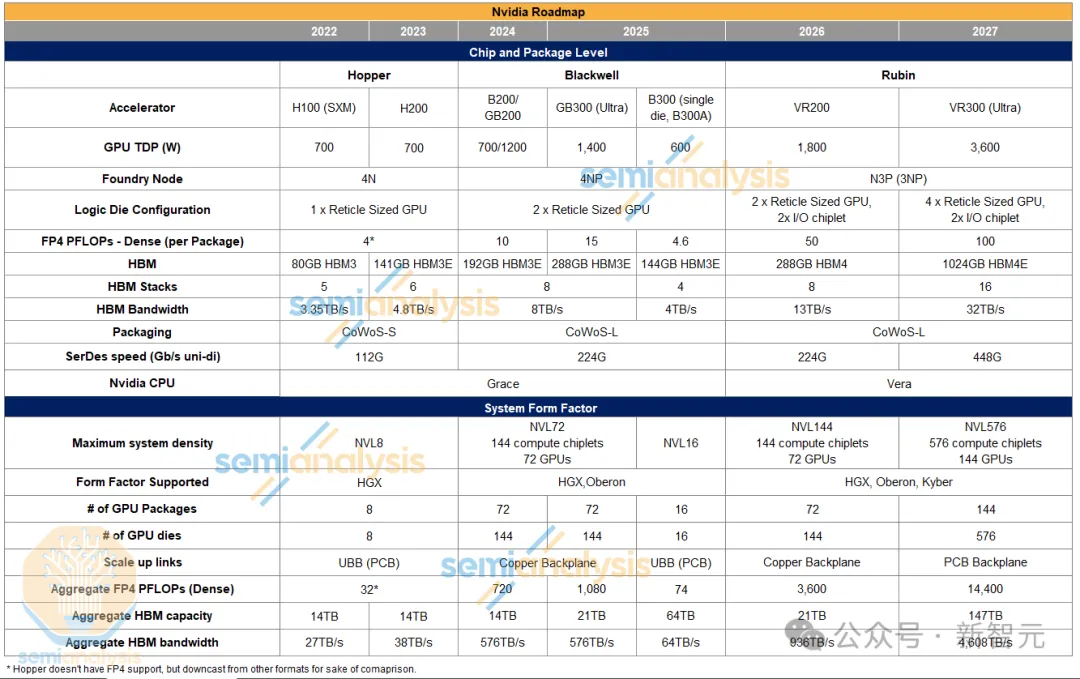

第一條黃氏計算法則涉及浮點運算性能(FLOPs)的標稱方式。

英偉達采用2:4稀疏計算方式(這種方式在實際應用中幾乎未被采用)而非實際使用的密集計算來標示性能。

比如,H100的FP16實際計算能力為989.4 TFLOPs,但官方數據卻標示為 1979.81 TFLOPs。

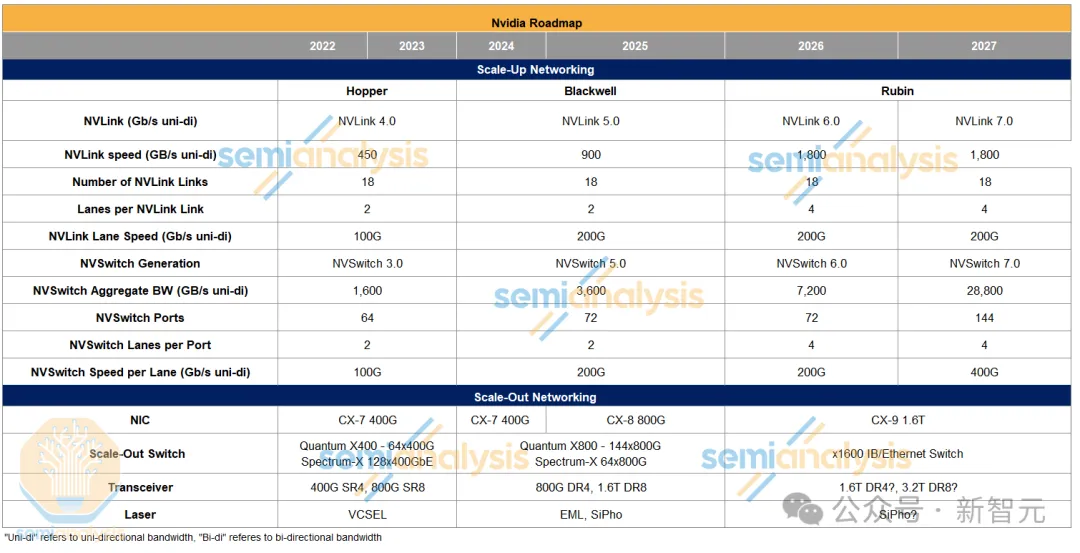

第二條計算法則關于帶寬的計算方式。

NVLink5的帶寬被標示為1.8TB/s,這是將900GB/s的發送帶寬和900GB/s的接收帶寬相加得出的結果。

雖然產品規格表采用這種計算方式,但網絡行業的通行做法是僅標示單向帶寬。

最新出現的第三條計算法則與GPU數量有關。

正如開篇所言,GPU數量現在按照每個封裝內的GPU芯片數量來計數,而不是按照封裝數量。

這種新的命名方式將從Rubin產品開始實施。

比如,第一代Vera Rubin機架將被命名為NVL144,盡管它在系統架構上與使用相同Oberon機架和72個GPU封裝的GB200 NVL72十分相似。

這種全新的計數方式無疑會給業界帶來理解上的困擾,需要不斷解釋說明,但這就是我們必須適應的「黃氏世界」。

接下來,一起看看英偉達的產品路線圖。

Blackwell Ultra B300

Blackwell Ultra 300(簡稱B300)的預覽版已經發布,與SemiAnalysis在去年12月分享的詳情保持一致。

主要規格如下:

GB300不會以獨立顯卡形式銷售,而是將作為配備Grace CPU的可插拔SXM模塊中的B300 GPU推出,同時還提供可插拔BGA封裝版本。

性能方面,B300的FP4浮點運算密度,較B200同等產品提升超過50%。內存容量提升至每個封裝288GB(采用8堆疊12層HBM3E高帶寬顯存),帶寬維持在8TB/s。

這一性能提升是通過減少部分(而非全部)FP64 ALU,并替換為FP4和FP6運算單元實現的。

雙精度運算主要用于HPC和超級計算領域,而非AI工作負載。盡管這讓HPC界感到失望,但從商業角度看,英偉達更注重發展規模更大的AI市場。

B300 HGX版本現已更名為B300 NVL16。

該產品將采用此前稱為「B300A」的Blackwell單GPU版本,現已更名為B300。

這相當于雙芯片B300的一半配置,由于標準版B300在單個封裝中缺少連接兩個GPU芯片的高速D2D接口,可能會帶來額外的通信開銷。

B300 NVL16將取代現有的B200 HGX架構,在主板上配置16個封裝和GPU芯片。具體實現方式是,在每個SXM模塊上安裝2個單芯片封裝(總共8個這樣的模塊)。

英偉達選擇這種方案而非繼續使用8個雙芯片B300的原因尚不明確;高級分析師推測,采用更小尺寸的CoWoS封裝模塊和基板所帶來的良率提升可能是主要考慮因素。

值得注意的是,封裝技術將采用CoWoS-L而非CoWoS-S,這一決策意義重大。

此前選擇單芯片B300A是出于CoWoS-S的成熟度和產能考慮。此次轉向CoWoS-L表明該技術已經從最初的不穩定狀態快速發展為成熟可靠的解決方案,良率也已達到穩定水平。

這16個GPU將通過NVLink協議進行通信,與B200 HGX的設計類似,兩組SXM模塊之間將配置兩個NVSwitch 5.0專用芯片(ASIC)。

另有一個新的變化是,不同于先前幾代HGX產品,B300 NVL16將不再使用Astera Labs的信號重定時器。不過,部分超大規模云計算服務商可能會選擇改用PCIe交換機。

B300的另一個重要特性是,將搭載全新的CX-8 NIC,該接口卡提供4條200Gbps通道,使InfiniBand總吞吐量達到800Gbps,較當前Blackwell采用的CX-7網絡接口卡的網絡速度翻了一番。

Vera Rubin:3nm制程,首個全自研CPU

Rubin將在臺積電3nm工藝上,采用兩個掩模尺寸的計算芯片。

這些計算芯片兩側將各配備一個I/O(輸入/輸出)芯片,整合所有NVLink、PCIe和NVLink C2C IP的SerDes,這樣可以為主計算芯片釋放更多空間用于核心計算功能。

Rubin將提供驚人的50 PFLOPs的密集FP4計算能力,相比B300提升了超過3倍。英偉達通過以下幾個關鍵方向實現了這一突破:

- 首先,如前所述,獨立的I/O芯片設計釋放了大約20-30%的芯片面積,這些空間可用于增加流式多處理器和張量核心的數量。

- 其次,Rubin將采用3nm制程工藝,可選用定制的英偉達3NP或標準N3P工藝。從Blackwell世代的4NP工藝升級到3NP,邏輯密度獲得顯著提升,但SRAM的尺寸幾乎保持不變。

- 第三,Rubin的熱設計功耗(TDP)將提升至約1800瓦,這可能支持更高的運行頻率。

- 最后是架構層面的scaling。英偉達在每代產品中都采用更大規模的張量核心脈動陣列。

據分析,這一規模從Hopper架構的32×32,增加到了Blackwell的64×64,在Rubin中可能會進一步擴大到128×128。

更大的脈動陣列能夠提供更好的數據復用效率和更低的控制復雜度,在面積利用率和功耗效率方面都具有優勢。

雖然編程難度隨之增加,這也是英偉達沒有像谷歌TPU那樣采用256×256規模的原因之一。

同時,這種設計對制造良率也會產生影響。值得注意的是,英偉達的掩模尺寸單片芯片具有很高的參數良率,這得益于其架構中內置的冗余設計和可修復機制,包含眾多小型計算單元。

當發現缺陷的計算單元時,可以將其禁用,從而保證產品良率。

這與谷歌TPU采用的設計策略不同,后者使用數量較少但規模更大的張量核心,因此無法像英偉達的設計那樣靈活處理邏輯單元缺陷。

Rubin將延續GB200/300 NVL72所采用的Oberon機架架構。它將搭配Vera CPU,采用3nm制程的Grace 繼任者。

值得注意的是,Vera是由英偉達自主設計,采用全定制Arm核心。

此外,英偉達還開發了獨特的互聯架構,使單個CPU核心能夠根據需要訪問更大的內存帶寬,這一點是AMD和英特爾CPU目前面臨的重大技術挑戰。

這就引出了新的命名方式。盡管新機架實際只配備72個GPU封裝,包含144個計算芯片,即72個封裝×每封裝2個計算芯片,但將被命名為VR200 NVL144。

不得不說,英偉達是如此富有創新精神,連GPU的計數方式都在改變!

在內存方面,英偉達HBM容量將維持在288GB,但升級到了HBM4技術:采用8堆12層設計,保持每層24GB的密度。

升級到HBM4帶來了顯著的帶寬提升,總帶寬達到13TB/s,這主要得益于總線寬度翻倍至2048位,以及達到當前JEDEC標準上限的6.5Gbps引腳速度。

互聯技術方面,新產品將采用第六代NVLink,通過翻倍通道數實現速度翻倍,達到3.6TB/s(雙向)。英偉達將繼續使用 224G 串并轉換器(SerDes)技術。

關于Oberon機架,它將繼續使用銅質背板,但分析師預計隨著每個GPU通道數的翻倍,連接電纜的數量也會相應翻倍。

在交換技術方面,NVSwitch專用芯片的總帶寬也將實現翻倍,同樣是通過增加通道數來實現的。

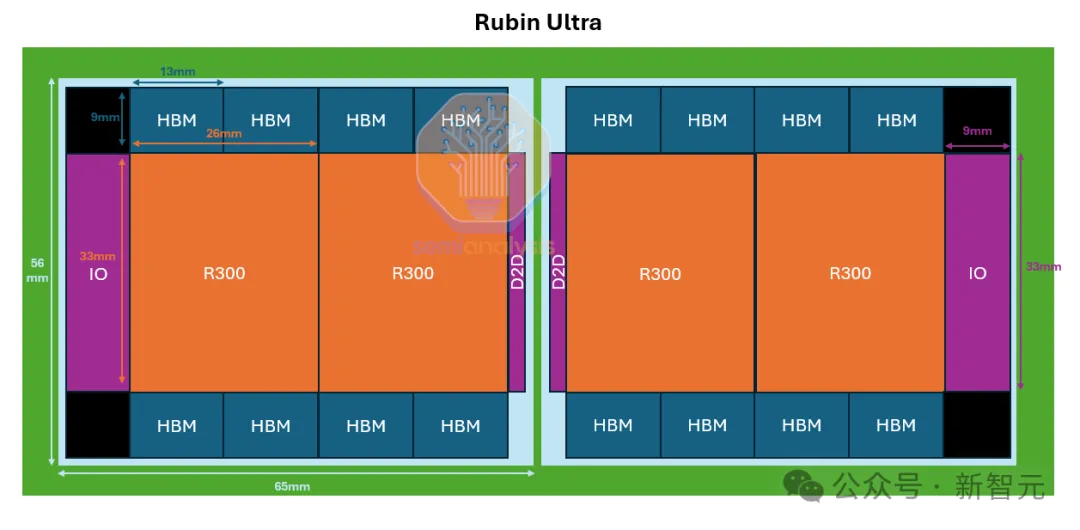

Rubin Ultra性能驚人,HBM達1024GB

Rubin Ultra將帶來革命性的性能提升。

英偉達在這款產品中將單個封裝HBM堆疊數量直接從8個提升至16個。其架構采用4個掩模尺寸的GPU芯片呈線性排列,兩端各配備一個I/O芯片。

得益于計算面積的翻倍,密集FP4浮點運算性能提升至100 PFLOPs。HBM容量達到驚人的1024GB,超過標準版Rubin的3.5倍。

這不僅體現在堆疊數量的翻倍,還包括密度和層數的提升。為實現單封裝1TB內存容量,產品將采用16個HBM4E堆疊,每個堆疊包含16層、每層32Gb的DRAM核心芯片。

根據SemiAnalysis分析,這種封裝設計將在基板上采用雙中介層方案,以避免使用單個超大尺寸中介層(接近8個掩模尺寸)。

中間的兩個GPU芯片將通過D2D接口的超薄I/O芯片實現通信,信號傳輸通過基板完成。

這種設計需要使用超大型ABF基板,其尺寸將突破當前JEDEC封裝標準的限制(長寬均為120毫米)。

在內存系統方面,整體配備365TB快速內存/二級LPDDR內存。其中,每個Vera CPU配備1.2TB LPDDR,72個CPU總計提供86TB容量,剩余容量由每個GPU封裝配備的2TB LPDDR來實現。

這體現了自主研發的HBM基礎芯片功能:通過在基礎芯片上集成LPDDR內存控制器來支持額外的二級內存,這些內存以LPCAMM模塊形式布置在電路板上的封裝周邊。這是對Vera CPU自帶二級內存的重要補充。

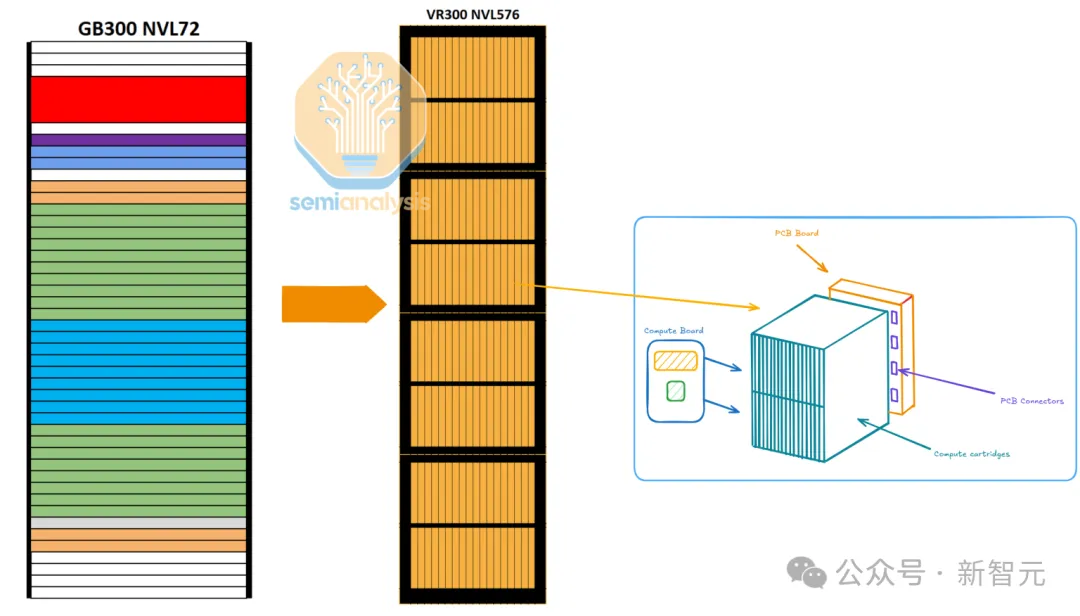

同時,這也標志著創新的Kyber機架架構的首次亮相。

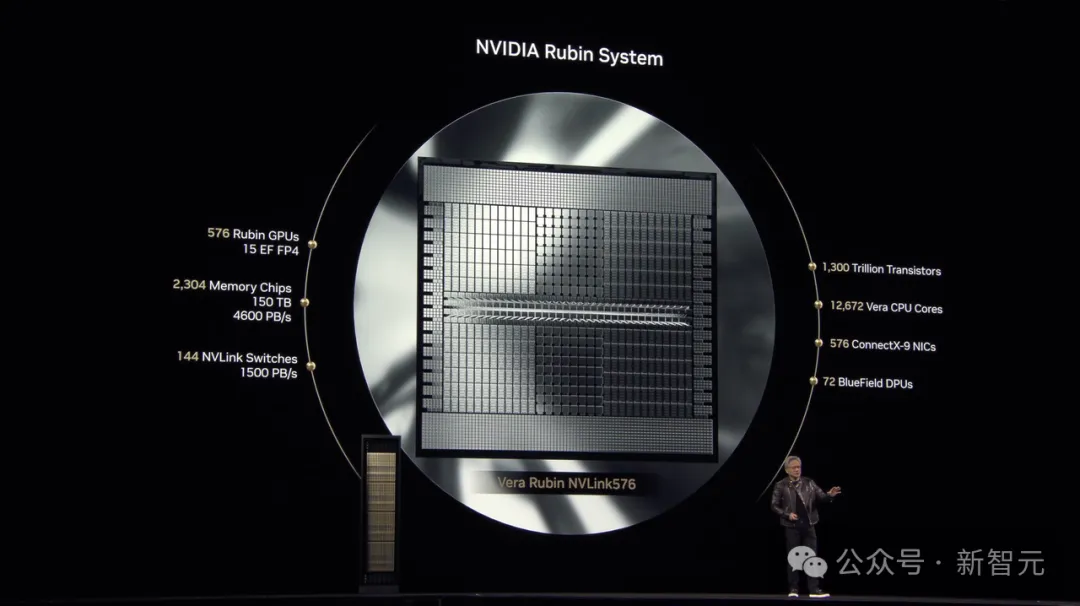

全新Kyber機架:4個機柜,144塊GPU

Kyber機架架構是此次發布的重要創新之一。

英偉達通過創新性地將機架旋轉90度來提升部署密度。考慮到NVL576配置(144個GPU封裝),這一設計在大規模集群部署方面實現了顯著的密度提升。

接下來,詳細對比Oberon和Kyber兩種機架架構的主要區別。

1. 計算單元設計:計算托盤采用90度旋轉設計,以卡匣形式安裝,顯著提升機架密度。

2. 機架結構:每個機架配備4個機柜,每個機柜包含兩層共18個計算卡匣。

3. NVL576配置:

- 每個計算卡匣裝配一個R300 GPU 和一個Vera CPU

- 每個機柜總計36個R300 GPU和36個Vera CPU

- 整體NVLink網絡規模達到144個GPU(合計576個計算芯片)

4. 互聯方案:采用PCB板背板替代傳統的銅纜背板,用于實現機架內GPU與NVSwitch間的互聯。這一改變主要是為了解決在更緊湊空間內布線的挑戰。

有趣的是,供應鏈情報顯示,可能存在VR300 NVL 152版本(配備288個GPU封裝)的Kyber機架變體。

這一數字可以從GTC主題演講中展示的晶圓圖片得到證實,其中標紅顯示了288個GPU封裝。

SemiAnalysis推測這可能是一款正在開發中的產品型號,旨在將機架密度NVLink網絡規模從GTC 2025展示的NVL576(144個GPU封裝)提升一倍,達到NVL 1152(288個封裝)的規模。

另一個重要進展是第七代NVSwitch的推出。這是NVSwitch首次在平臺周期中期進行升級。

新款交換芯片提供更高的聚合帶寬和端口數,支持單個網絡域內擴展至576個GPU芯片(144個封裝)。

不過,網絡拓撲可能不再采用全連接無阻塞的單層多平面優化架構,而是改用具有一定超額認購比的多平面優化雙層網絡拓撲,甚至可能采用非Clos架構的創新拓撲設計。

Blackwell Ultra重疊計算,降低延遲

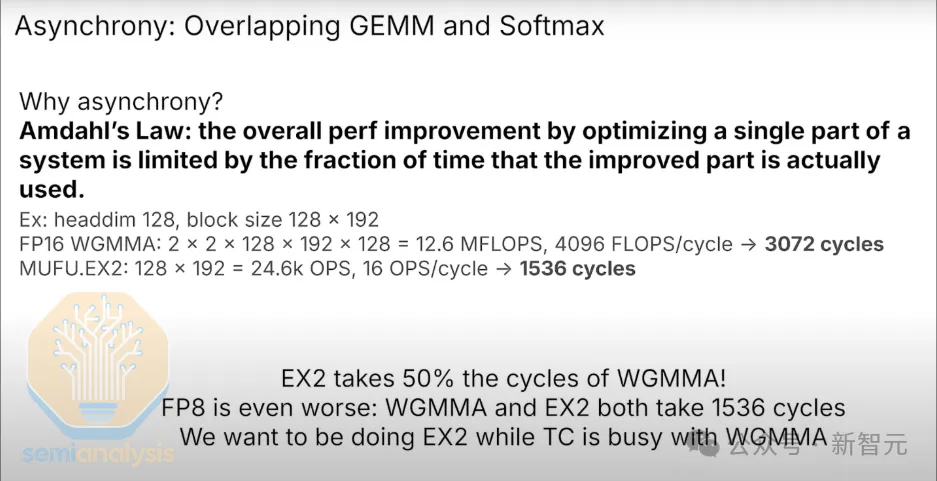

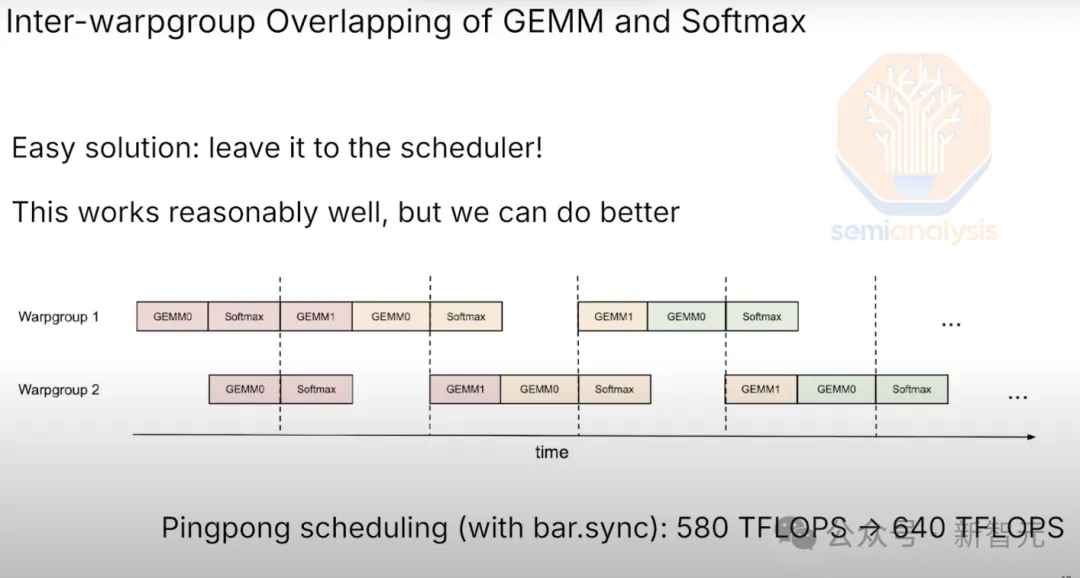

各種注意力機制變體(包括flash-attention、MLA、MQA和GQA)都需要進行矩陣乘法(matmuls)和 softmax函數計算(包括行方向歸約和逐元素指數函數)。

其中矩陣乘法又稱為GEMM,或通用矩陣乘法,專門用于處理神經網絡計算中的矩陣乘法運算。

在GPU架構中,GEMM運算由張量核心執行。雖然張量核心的性能在每代產品中都有顯著提升,但負責逐元素指數計算(如softmax)的多功能單元(MUFU)的性能提升相對較小。

在采用bf16(bfloat16)格式的Hopper架構中,注意力層的softmax計算需要消耗GEMM運算50%的計算周期。

這迫使內核工程師必須通過重疊計算來「掩蓋」softmax 的延遲,這大大增加了內核編程的難度。

在采用FP8格式的Hopper架構中,注意力層的softmax計算與GEMM運算消耗相同的計算周期。

這意味著,如果不進行任何重疊計算,注意力層的計算時間將翻倍:需要1536個周期用于矩陣乘法計算,再需要1536個周期進行softmax計算。

這就是重疊計算發揮作用的地方。由于softmax和GEMM運算需要相同的周期數,內核工程師需要優化實現完美的重疊計算。

然而,完美的重疊在實際中是不可能實現的,根據Amdahl定律,這將導致硬件性能損失。

以上描述的挑戰主要存在于Hopper GPU架構中,并且這個問題在第一代Blackwell中仍然存在。英偉達通過推出Blackwell Ultra來解決這個問題,他們重新設計了SM并增加了新的指令集來改進性能。

在Blackwell Ultra中,用于計算注意力機制softmax部分的MUFU單元性能較標準Blackwell提升了2.5 倍。這大大降低了對完美重疊softma和 GEMM計算的要求。

借助MUFU的2.5倍性能提升,CUDA開發人員在實現重疊計算時有了更大的靈活性,同時不會影響注意力內核的性能。

在這種情況下,英偉達全新的推理棧和Dynamo優化引擎就能派上用場。

推理棧與Dynamo優化引擎

在2023 GTC大會上,英偉達展示了GB200 NVL72憑借其72個GPU的大規模scaling能力,在FP8精度下實現了比H200高15倍的推理吞吐量。

而今年,英偉達的創新步伐不減。他們正通過硬件和軟件雙重突破,在多個維度推動推理性能的提升。

新推出的Blackwell Ultra GB300 NVL72較GB200 NVL72在FP4密集計算方面提供了50%的性能提升,同時HBM容量也提升了50%。

這兩項提升都將直接促進推理吞吐量的增長。

此外,產品路線圖中還包括Rubin世代多項網絡速度的升級,這些改進也將為推理吞吐量帶來實質性提升。

在硬件層面,下一個重大突破將來自scaling網絡規模的提升:從Rubin的144個GPU芯片scaling到Rubin Ultra的576個GPU芯片。但這僅是硬件創新的一部分。

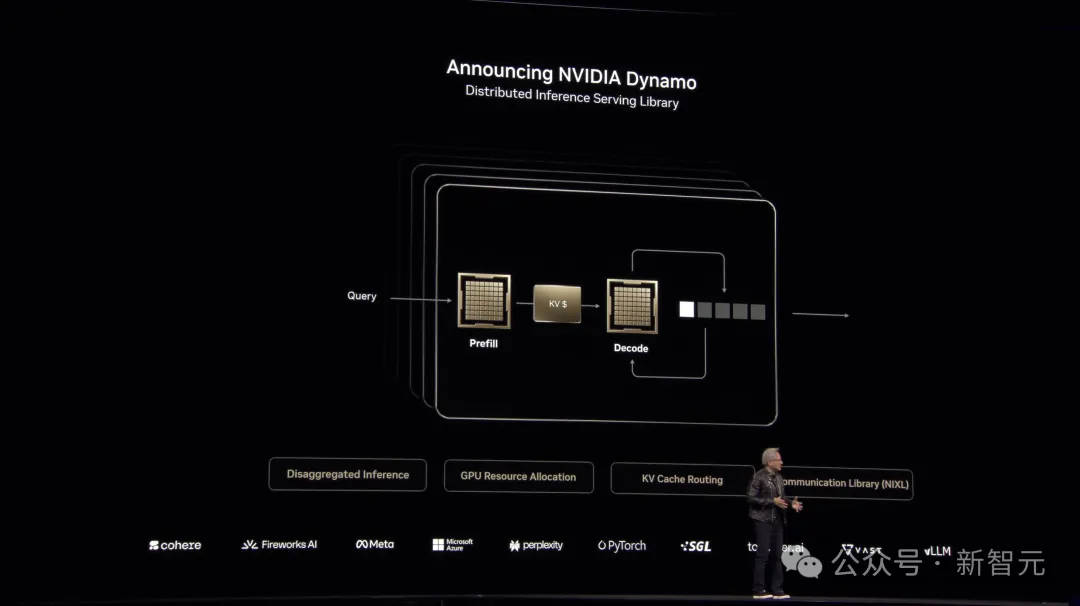

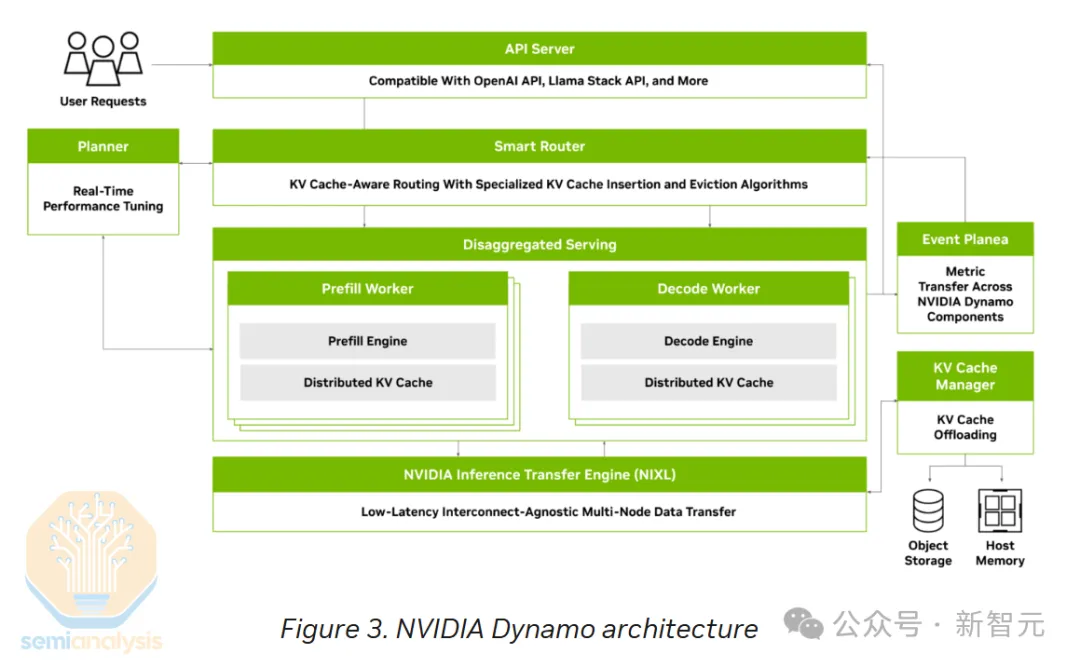

在軟件方面,英偉達發布了Nvidia Dynamo——這是一個致力于簡化推理部署和擴展的開放式AI引擎技術棧。

它有望超越現有的VLLM和SGLang解決方案,不僅提供了VLLM所不具備的多項功能,還實現了更高的性能。

結合硬件層面的創新,Dynamo將進一步推動吞吐量與交互性能力的提升,尤其在高交互性應用場景中可以實現更高的吞吐量。

Dynamo為現有推理加速技術棧引入了以下幾項關鍵創新功能:

1. 智能路由(Smart Router)

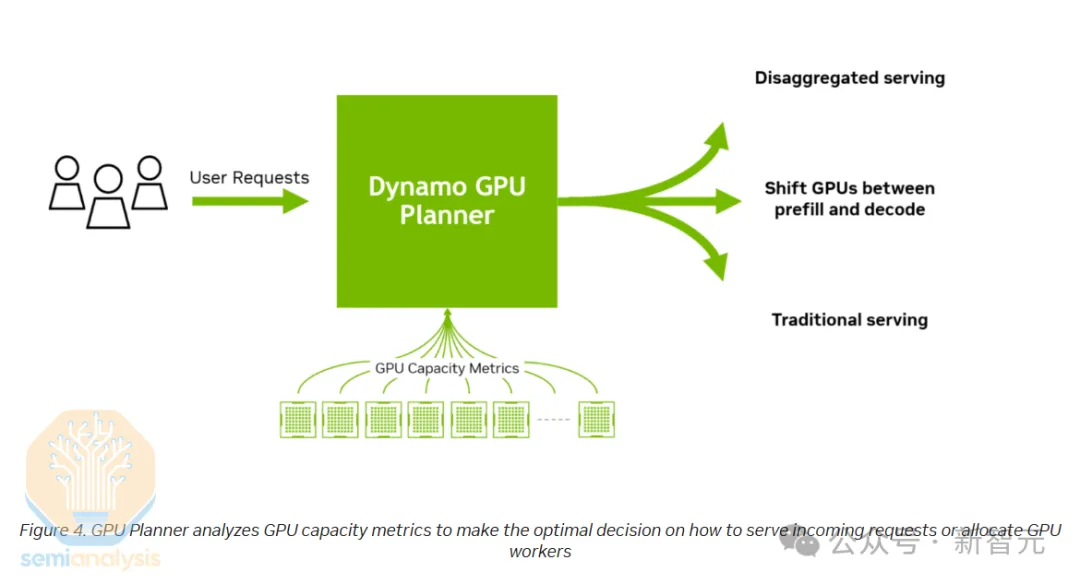

2. GPU任務規劃器(GPU Planner)

3. 增強型NCCL集合通信框架(Improved NCCL Collective)

4. NIXL(NVIDIA Inference Transfer Engine)

5. NVMe KV-Cach智能卸載系統

智能路由

智能路由管理系統在多GPU推理部署環境中,可以智能地將輸入序列中的每個token精確分配至負責預填充和解碼任務的GPU。

在預填充階段,系統確保輸入token均勻分布到執行預填充任務的各個 GPU,從而避免在專家模塊上出現性能瓶頸。

同樣,在解碼階段,系統著重確保序列長度和請求在執行解碼的各個GPU之間實現最優分配和負載均衡。

對于那些訪問頻率較高的專家模塊,GPU任務規劃器還可以創建額外的副本以維持整體負載平衡。

此外,該路由系統還能在服務于同一模型的多個副本之間實現負載均衡,這是當前主流推理引擎(如vLLM等)所不具備的重要特性。

GPU任務規劃器

GPU任務規劃器是一個智能化的資源調度系統,可以自動管理預填充和解碼節點的動態擴縮。

該系統能夠根據全天負載的自然波動情況,靈活調整計算節點數量。在MoE中,規劃器可以在預填充和解碼兩類節點上實現多個專家模塊之間的負載均衡。

當某些專家模塊負載較高時,規劃器會自動配置額外的GPU資源提供計算支持。

此外,系統還能根據實時需求在預填充和解碼節點之間進行動態資源重分配,從而最大化資源利用效率。

該系統的一個重要特性是支持動態調整解碼和預填充任務的GPU分配比例。

這項功能在深度研究等特定場景中特別有價值:由于這類應用需要處理海量上下文信息,但實際生成的內容相對較少,因此需要分配更多資源用于預填充處理而非解碼任務。

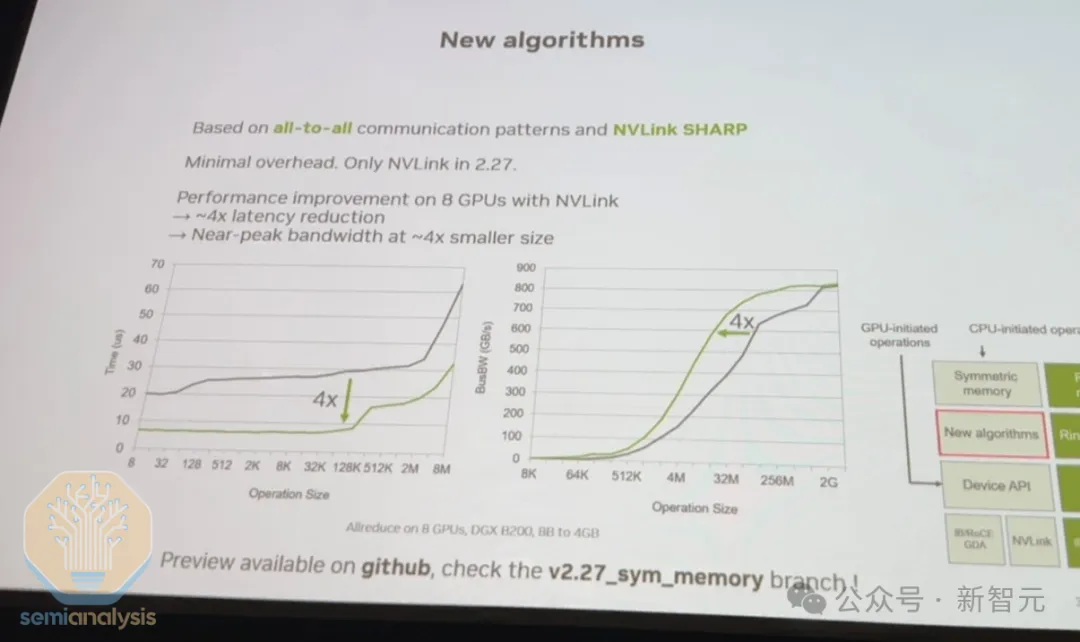

增強型NCCL集合通信框架

英偉達在其集合通信庫(NCCL)中引入了一組全新的低延遲通信算法。這些算法可以將小規模消息傳輸的延遲降低至原來的1/4,從而顯著提升整體推理性能和吞吐量。

在今年的GTC大會上,Sylvain的技術演講深入介紹了這些創新特性,重點闡述了新開發的one-shot和two-shot全規約算法,這些算法是性能提升的核心所在。

值得注意的是,AMD的RCCL庫本質上是NVIDIA NCCL的一個分支復制版本。

因此,Sylvain主導的NCCL架構重構不僅進一步鞏固了CUDA生態系統的技術優勢,還迫使AMD團隊不得不投入數千工程師小時來將英偉達的重構更新同步到RCCL。在AMD忙于同步代碼變更的同時,英偉達則可以繼續專注于推進集合通信軟件棧和算法的創新發展。

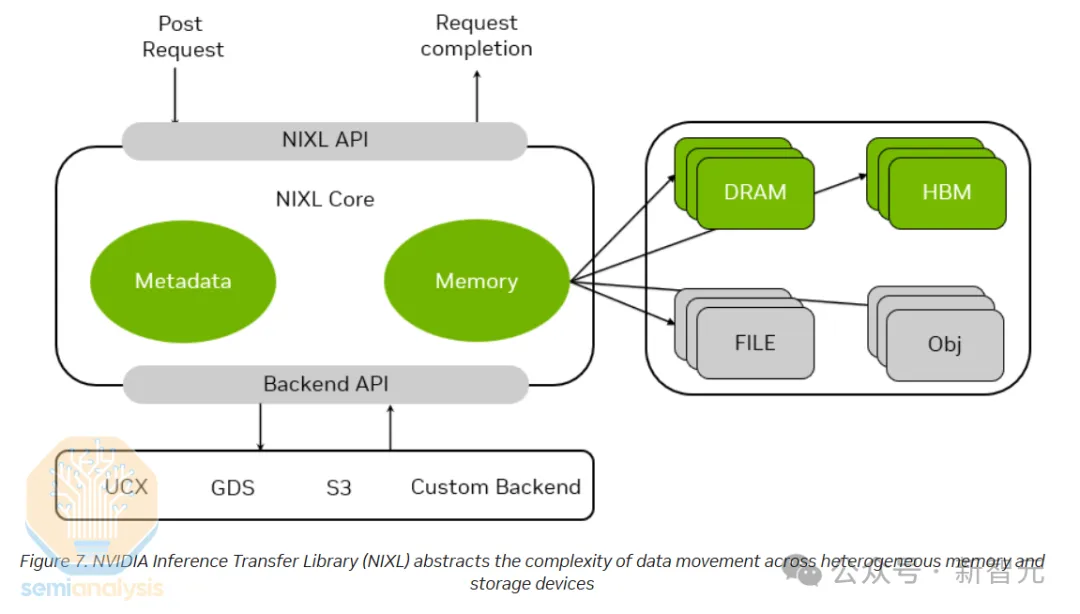

NIXL

為了實現預填充節點和解碼節點之間的高效數據傳輸,需要采用低延遲、高帶寬的通信傳輸庫。

NIXL采用了創新的InfiniBand GPU異步初始化(IBGDA)技術。在當前的NCCL架構中,控制流需要通過CPU代理線程進行處理,而數據流可以直接傳輸到NIC,無需經過CPU緩沖區。

而采用IBGDA技術后,控制流和數據流都能夠繞過CPU,實現從GPU到網絡接口卡的直接傳輸。

此外,NIXL還通過抽象化簡化了各種存儲和內存設備之間的數據傳輸復雜度,包括簡化CXL、本地NVMe 、遠程NVMe 、CPU內存、遠程 GPU內存和本地GPU內存。

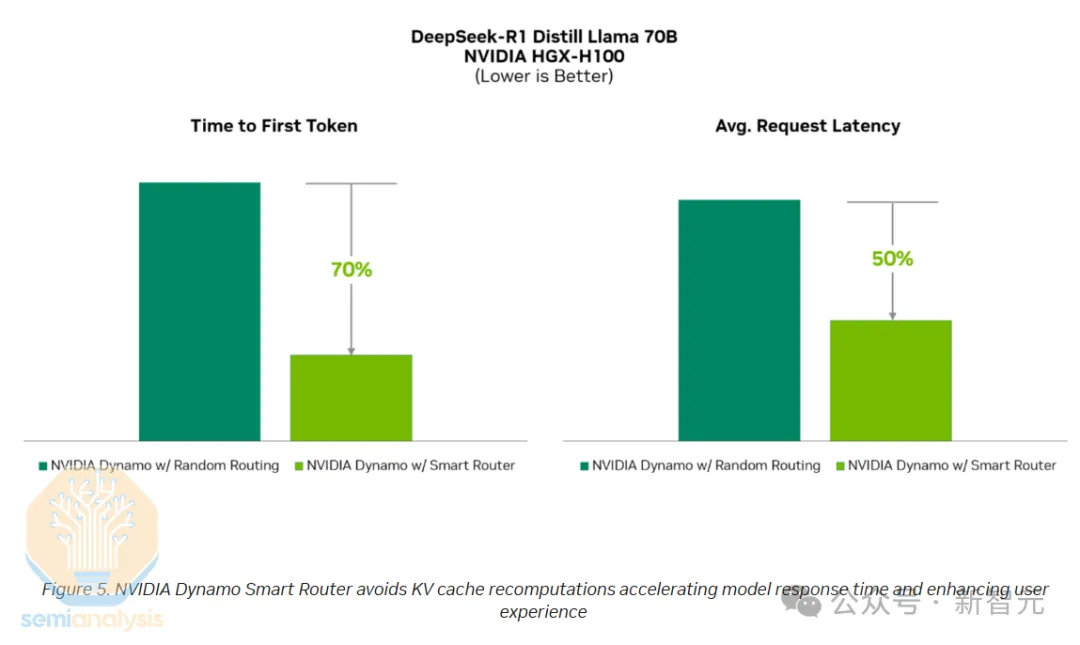

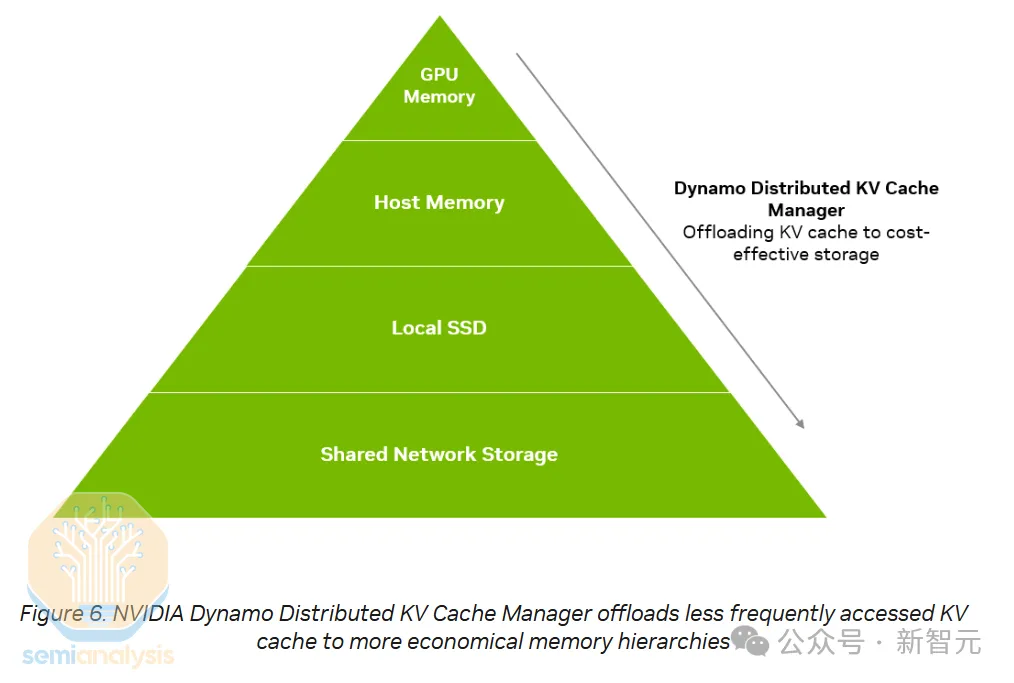

NVMe KV-Cache智能卸載系統

KV緩存智能卸載管理系統采用創新方式,將用戶歷史對話產生的鍵值緩存保存在NVMe存儲設備中,而不是直接廢棄,從而顯著提升了整體預填充效率。

在用戶與LLM進行多輪對話時,模型需要將對話歷史中的問題和回答作為上下文輸入進行處理。

在傳統實現中,推理系統會丟棄用于生成早期對話的鍵值緩存,這導致系統在處理后續對話時需要重新計算這些緩存內容,造成重復計算。

而采用NVMe KV緩存卸載技術后,當用戶暫時離開對話時,系統會將鍵值緩存臨時保存到NVMe存儲系統中。

當用戶返回并繼續對話時,系統可以快速從NVMe存儲中恢復這些緩存數據,避免了重復計算的開銷。

這項創新帶來兩個重要優勢:

- 提升資源利用效率:釋放預填充節點的處理能力,支持更高的并發量,或降低所需的預填充部署規模

- 優化用戶體驗:由于直接檢索緩存比重新計算更快,顯著減少了首個token的生成延遲

根據DeepSeek在GitHub上發布的第六天研發記錄顯示,其磁盤KV緩存的命中率達到了56.3%,這一數據表明其預填充部署效率獲得了顯著提升。

實踐表明,在用戶進行多輪對話場景中,此類部署的典型KV緩存命中率通常在50-60%之間。

雖然部署NVMe存儲解決方案需要一定成本投入,存在一個效益平衡點:對于較短的對話,直接重新計算比重新加載更經濟高效;但在長對話場景下,該方案可以帶來巨大的性能收益。

對于持續關注DeepSeek開源周的開發者來說,上述技術都不會陌生。

在英偉達完善Dynamo技術文檔的同時,上述內容為開發者提供了快速了解這些技術的絕佳渠道。

這些創新功能的集成帶來了全方位的推理性能提升。英偉達還特別介紹了Dynamo在現有H100節點上部署后帶來的性能改進。

從本質上說,Dynamo實現了對DeepSeek創新技術的民主化,讓整個開發社區都能夠共享開源模型技術的最新成果。這意味著不僅是那些擁有強大推理部署工程團隊的頂級AI實驗室,所有開發者都能夠部署高效的推理系統。

最后,由于Dynamo在分布式推理和專家并行計算方面具有廣泛的適用性,它在獨立復制和高交互性部署場景中表現尤為出色。

當然,要充分發揮Dynamo的性能優勢并實現顯著改進,必須具備多節點的硬件基礎設施。

AI總擁有成本暴降99.97%

在結束Blackwell介紹后,老黃通過一個引人注目的說法強調了技術創新的影響力——這些創新使他成為了「降價推動者」。

具體而言,Blackwell相較于上一代Hopper架構,實現了高達68倍的性能提升,使總成本降低了87%。

而下一代Rubin架構的性能預計將比Hopper提升900倍,預計可使成本降低99.97%。

顯然,英偉達正在保持高速的技術創新步伐。正如老黃所說,「一旦Blackwell開始規模化出貨,Hopper即使免費提供也將無人問津」。

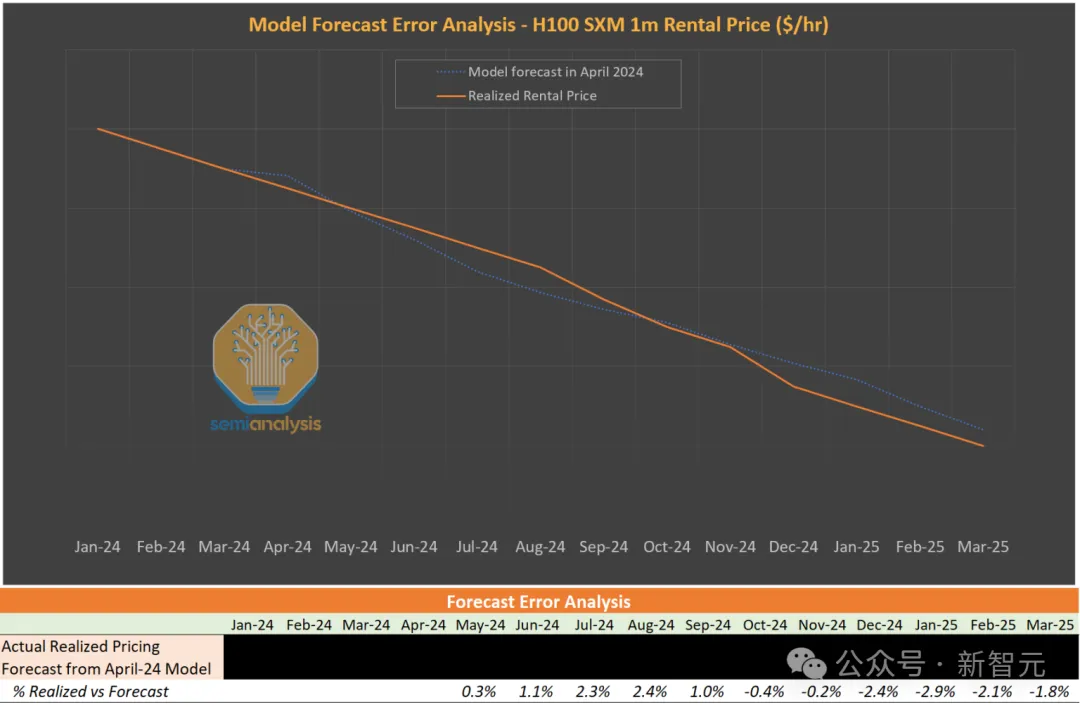

長期以來,SemiAnalysis持續建議生態系統合作伙伴優先考慮部署B200和GB200 NVL72等新一代系統,而非采購H100或H200。

事實上,H100租賃價格預測模型正是基于老黃所闡述的這一原理。

高級分析師綜合考慮了未來市場裝機量預測、集群總擁有成本以及下一代芯片性能等因素,構建了完整的價格預測曲線。

該預測框架迄今表現出色:他們于2024年4月首次向客戶發布的H100租賃價格預測模型,從2024年初至今的預測準確率高達98%。

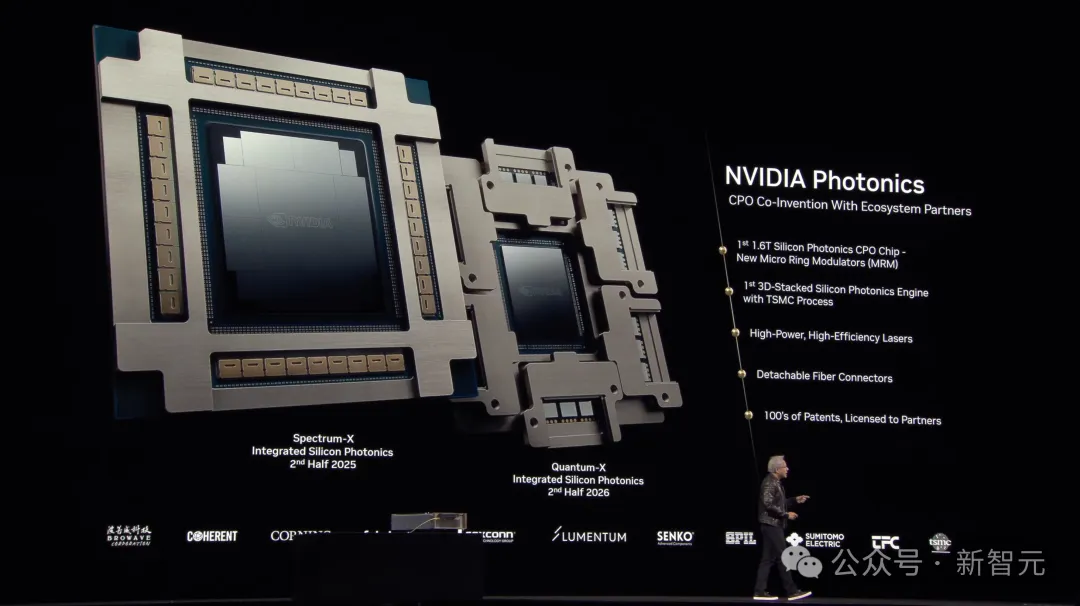

首個光學封裝CPO,功耗節省12%

在主題演講中,英偉達發布了其首個用于擴展型交換機的同封裝光學解決方案。

這項技術將傳統的光學收發器替換為外部激光源(ELS),并將光學引擎(OE)直接集成在芯片硅片旁邊,實現數據通信。

在新架構中,光纖電纜不再連接傳統收發器端口,而是直接插入交換機上與光學引擎相連的專用端口。

CPO技術帶來的主要優勢是顯著降低功耗,這源于多個方面:

- 交換機本身不再需要數字信號處理器(DSP)

- 可以使用更低功率的激光光源

- 雖然使用線性可插拔光學(LPO)收發器也能實現部分節能,但CPO獨特的優勢在于支持更大的交換機基數,使網絡層級從三層簡化為兩層

- 減少網絡層級不僅消除了一整層交換設備,還帶來了可觀的成本和能耗節省

根據SemiAnalysis分析,在部署400,000個GB200 NVL72設備的場景中,從傳統的基于DSP收發器的三層網絡遷移到基于CPO的兩層網絡,可以實現高達12%的集群總功耗節省,將收發器功耗占比從計算資源的10%降低到僅1%。

英偉達本次發布了多款采用CPO技術的交換機產品:

- Quantum X-800 3400 CPO版本(原型于2024年GTC發布)

a.144個800 Gbps端口

b.總吞吐量:115Tbps

c.配置:144個MPO端口 + 18個ELS

d.預計2025年下半年推出

- Spectrum-X以太網CPO交換機

- 512個800 Gbps端口

- 支持高速大基數配置,實現快速扁平化網絡拓撲

- 預計2026年下半年推出

雖然此次發布已經展現出突破性的技術創新,但高級分析師認為這僅是英偉達在CPO領域的起步。

從長遠來看,CPO 技術在擴展網絡中可能帶來更大的價值:它有潛力大幅提升GPU的網絡基數和總帶寬,實現更高效的扁平化擴展網絡架構,突破當前576個GPU的規模限制。

英偉達穩坐王座,正重塑計算成本格局

The Information一篇文章稱,亞馬遜將Trainium芯片的價格定在H100的25%。

與此同時,老黃會上表示「當 Blackwell大規模量產后,就算免費送H100也沒人要」。

高級分析師認為,后一種說法極具深意。

技術繼續驅動著總擁有成本,在我們所見的各個領域(可能除了TPU),都能看到競爭對手在復制英偉達的技術路線圖。與此同時,老黃正在推動技術發展的邊界。

新架構、機架結構、算法改進和CPO技術,每一項都體現了英偉達與競爭對手的技術差異。

英偉達目前在幾乎所有領域都處于領先地位,當競爭對手追趕上來時,他們就會在另一個進步方向上推進。

隨著英偉達保持年度更新節奏,SemiAnalysis預計這種趨勢將會持續。

雖然有人說ASIC是計算的未來,但從CPU時代就看到,一個快速改進的通用平臺是很難被超越的。

英偉達正在用GPU重新創造這個平臺,高級分析師預計他們將繼續引領行業發展。

想要追趕這位「營收終結者」可不容易。