AI視頻是否符合物理規(guī)律,量化基準(zhǔn)來了,實(shí)現(xiàn)人類感知對齊 | 阿里高德/中科院出品

測一測現(xiàn)有AI生成視頻是否符合物理運(yùn)動(dòng)規(guī)律!

來自阿里-高德、中科院的研究人員提出一個(gè)面向感知對齊的視頻運(yùn)動(dòng)生成基準(zhǔn)。

名為VMBench,是首個(gè)開源的運(yùn)動(dòng)質(zhì)量評測基準(zhǔn),通過整合運(yùn)動(dòng)評估指標(biāo)與人類感知對齊的評測方法,揭示現(xiàn)有模型在生成物理合理運(yùn)動(dòng)方面的不足。

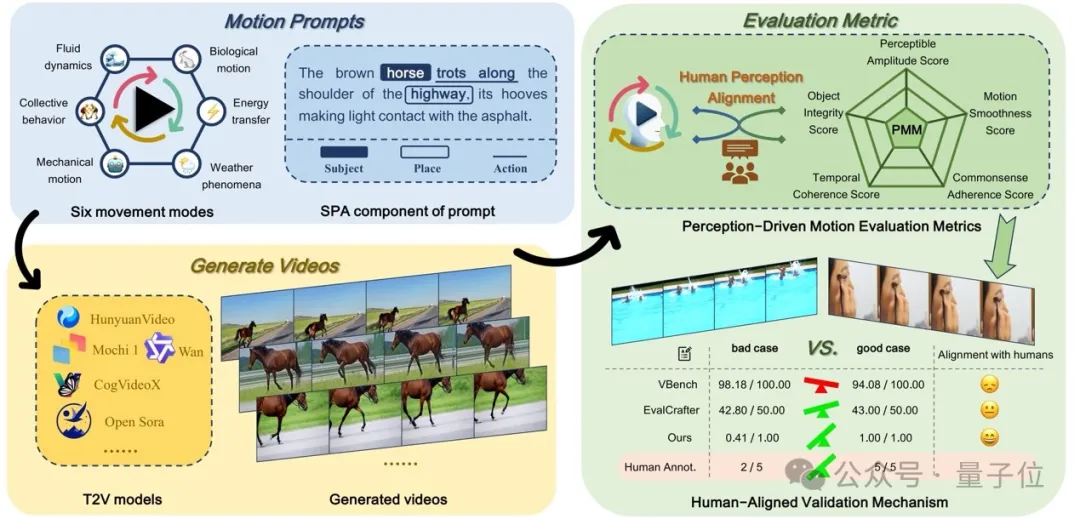

△圖1 VMBench的整體結(jié)構(gòu)

新基準(zhǔn)測試涵蓋了六種主要的運(yùn)動(dòng)模式類別,每個(gè)提示都構(gòu)建為圍繞三個(gè)核心組件(主體、地點(diǎn)和動(dòng)作)的綜合運(yùn)動(dòng)。

作者提出了一種新穎的多維視頻運(yùn)動(dòng)評估方法,包含五個(gè)源自感知偏好的以人類為中心的質(zhì)量指標(biāo)。利用由流行的T2V模型生成的視頻進(jìn)行了系統(tǒng)的人類評估,以驗(yàn)證其指標(biāo)在捕捉人類感知偏好的有效性。

總體而言,VMBench具有以下幾大優(yōu)勢:

- 基于感知的運(yùn)動(dòng)評估指標(biāo):作者從人類感知的角度出發(fā),設(shè)計(jì)了五個(gè)核心維度,并據(jù)此制定精細(xì)化的評估指標(biāo),從而更深入地分析模型在運(yùn)動(dòng)質(zhì)量上的優(yōu)勢與不足。

- 基于元信息的運(yùn)動(dòng)提示生成:作者提出一種結(jié)構(gòu)化的方法,通過提取元信息、利用LLM生成多樣化的運(yùn)動(dòng)提示,并結(jié)合人機(jī)協(xié)同驗(yàn)證進(jìn)行優(yōu)化,最終構(gòu)建了涵蓋六大動(dòng)態(tài)場景維度的分層提示庫。

- 人類感知對齊的驗(yàn)證機(jī)制:作者提供人類偏好標(biāo)注來驗(yàn)證基準(zhǔn)的有效性,實(shí)驗(yàn)結(jié)果表明,其評估指標(biāo)相較于基線方法,在Spearman相關(guān)性上平均提升35.3%。這是首次從人類感知對齊的角度對視頻運(yùn)動(dòng)質(zhì)量進(jìn)行評估。

此外,團(tuán)隊(duì)已將VMBench代碼及相關(guān)資源開源至GitHub。

以下是更多細(xì)節(jié)。

感知對齊的評估體系

視頻動(dòng)態(tài)生成的評估面臨兩大核心挑戰(zhàn):

現(xiàn)有指標(biāo)未能充分對齊人類感知,且評測提示的多樣性有限,導(dǎo)致模型動(dòng)態(tài)生成潛力未被充分探索。

為此,團(tuán)隊(duì)提出VMBench——首個(gè)融合感知對齊指標(biāo)與多樣化動(dòng)態(tài)類型的視頻運(yùn)動(dòng)評測基準(zhǔn)。

人類觀察視頻時(shí),首先基于先驗(yàn)經(jīng)驗(yàn)和物理規(guī)律構(gòu)建場景的整體理解,隨后選擇性關(guān)注運(yùn)動(dòng)物體的平滑性與時(shí)序一致性(尤其在遮擋場景)。

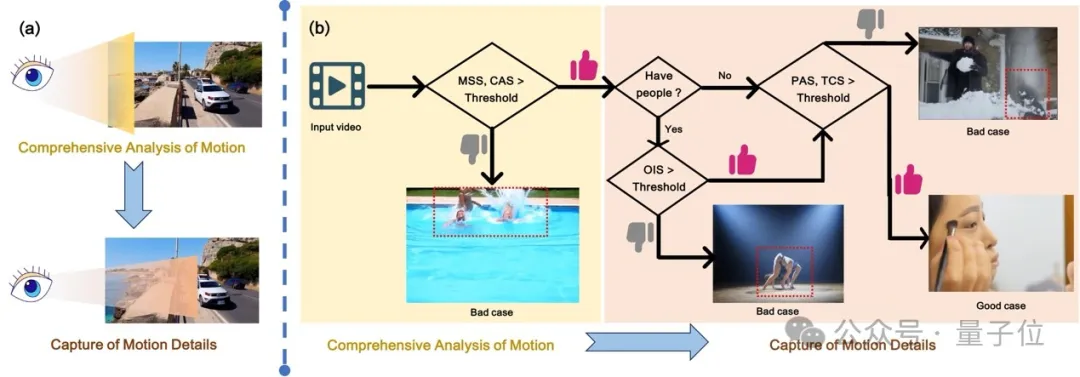

受此分層感知機(jī)制啟發(fā)(圖2),PMM設(shè)計(jì)了從全局到局部的五維評估體系:

△圖2 用于評估視頻運(yùn)動(dòng)的指標(biāo)框架

上圖框架靈感源自人類對視頻中運(yùn)動(dòng)感知的機(jī)制。(a)人類對視頻中運(yùn)動(dòng)的感知主要涵蓋兩個(gè)維度:運(yùn)動(dòng)的綜合分析和運(yùn)動(dòng)細(xì)節(jié)的捕捉。(b)作者提出的用于評估視頻運(yùn)動(dòng)的指標(biāo)框架。

具體而言,MSS和CAS對應(yīng)于人類對運(yùn)動(dòng)的綜合分析過程,而OIS、PAS和TCS則對應(yīng)于運(yùn)動(dòng)細(xì)節(jié)的捕捉。

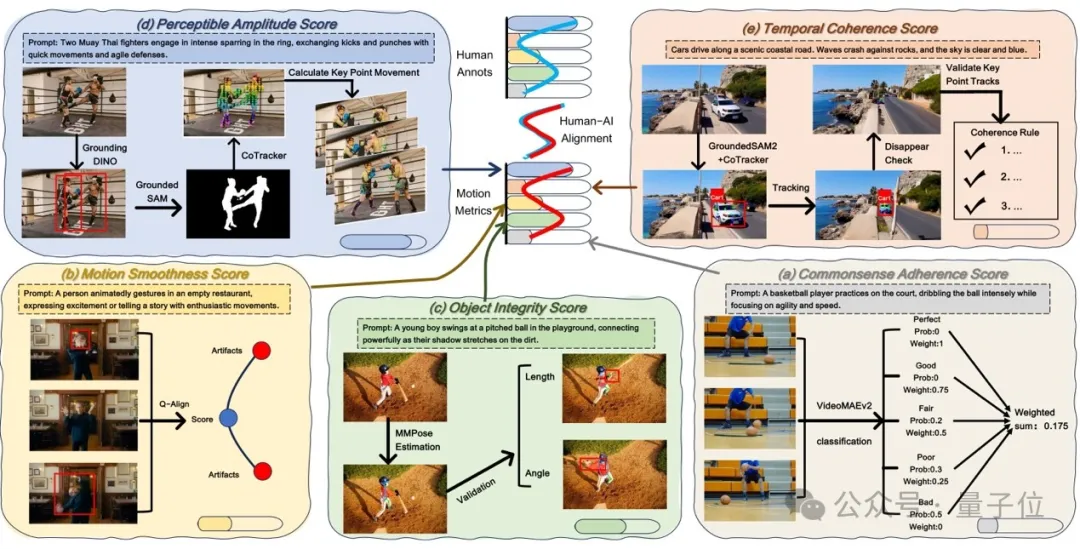

1、常識(shí)遵守性評分(CAS)

通過構(gòu)建多層級分類模型量化視頻內(nèi)容是否符合物理規(guī)律。

具體流程包括:

首先從主流生成模型中收集10,000個(gè)視頻構(gòu)建數(shù)據(jù)集,結(jié)合VideoReward模型對視頻質(zhì)量進(jìn)行五級分類(Bad到Perfect);隨后采用VideoMAEv2架構(gòu)的時(shí)空建模網(wǎng)絡(luò)預(yù)測視頻的常識(shí)合理性概率分布,最終通過加權(quán)平均各類別概率得出綜合評分。

該指標(biāo)解決了傳統(tǒng)方法對物理規(guī)律違反(如物體反重力運(yùn)動(dòng))的漏檢問題。

2、運(yùn)動(dòng)平滑度評分(MSS)

針對傳統(tǒng)光流法對視覺感知不敏感的問題,提出場景自適應(yīng)的質(zhì)量驟降檢測機(jī)制。

基于Q-Align美學(xué)評分模型,分析相鄰幀間的質(zhì)量降低幅度,當(dāng)超過動(dòng)態(tài)閾值(通過Kinetics等真實(shí)視頻統(tǒng)計(jì)建模獲得)時(shí)判定為異常幀。

最終以異常幀占比的補(bǔ)數(shù)作為平滑度得分,有效捕捉人類敏感的低幀率卡頓和高動(dòng)態(tài)模糊。

3、對象完整性評分(OIS)

為檢測運(yùn)動(dòng)中的非自然形變(如人體關(guān)節(jié)錯(cuò)位),基于MMPose提取關(guān)鍵點(diǎn)軌跡,結(jié)合解剖學(xué)約束規(guī)則(如四肢長度比例容差)分析形狀穩(wěn)定性。

通過統(tǒng)計(jì)自然運(yùn)動(dòng)數(shù)據(jù)集設(shè)定各部位形變閾值,計(jì)算所有幀中符合解剖學(xué)約束的比例。

相比僅關(guān)注語義一致性的DINO方法,該指標(biāo)更貼近人類對肢體協(xié)調(diào)性的敏感度。

4、可感知幅度評分(PAS)

通過多模態(tài)定位技術(shù)分離主動(dòng)運(yùn)動(dòng)主體與背景位移。

首先用GroundingDINO鎖定語義主體,借助GroundedSAM生成時(shí)序穩(wěn)定的實(shí)例掩膜,再通過CoTracker追蹤關(guān)鍵點(diǎn)位移軌跡。

結(jié)合場景類型(如機(jī)械運(yùn)動(dòng)vs.流體運(yùn)動(dòng))設(shè)定感知敏感閾值,計(jì)算幀級位移幅度與閾值的歸一化比值。

該方法克服了傳統(tǒng)光流法因相機(jī)運(yùn)動(dòng)導(dǎo)致的幅度高估問題。

5、時(shí)間一致性評分(TCS)

針對物體異常消失/出現(xiàn)問題,提出軌跡驗(yàn)證雙階段檢測。

第一階段用GroundedSAM2實(shí)現(xiàn)像素級實(shí)例分割與跨幀ID追蹤,記錄物體的可見狀態(tài);第二階段通過CoTracker追蹤物體運(yùn)動(dòng)軌跡,構(gòu)建連續(xù)性規(guī)則(如遮擋重現(xiàn)需滿足空間連貫性),過濾合法消失事件/出現(xiàn)(如移出畫面邊界)。

最終以異常消失實(shí)例占比的補(bǔ)數(shù)作為評分,相比CLIP特征相似度方法更加貼合人眼的視覺感知。

整體的評估流程如圖3所示。

△圖3 感知驅(qū)動(dòng)的運(yùn)動(dòng)指標(biāo)(PMM)框架。

PMM包含多個(gè)評估指標(biāo):常識(shí)一致性得分(CAS)、運(yùn)動(dòng)平滑度得分(MSS)、物體完整性得分(OIS)、可感知幅度得分(PAS)以及時(shí)間連貫性得分(TCS)。

上圖(a-e)是每個(gè)指標(biāo)的計(jì)算流程圖。

PMM生成的得分呈現(xiàn)出與人類評估一致的變化趨勢,表明與人類感知高度契合。

元信息引導(dǎo)的Prompt自動(dòng)生成

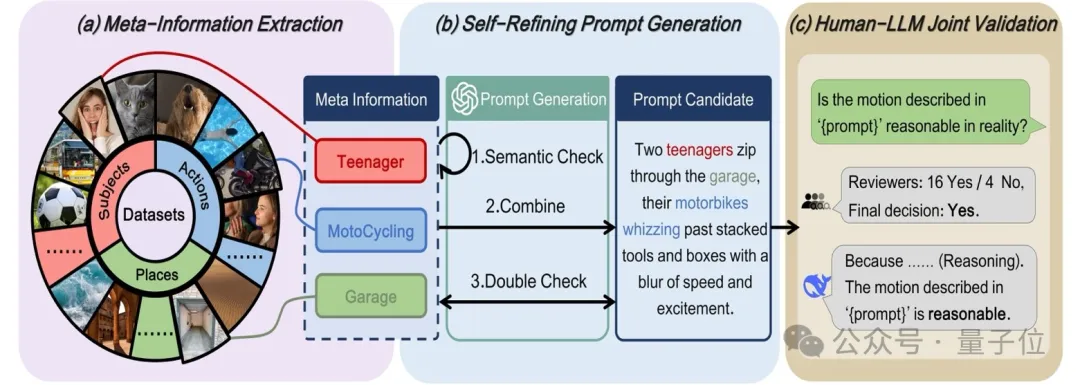

針對現(xiàn)有基準(zhǔn)因提示類型單一而無法充分評估模型運(yùn)動(dòng)生成能力的問題,作者提出了元信息引導(dǎo)的Prompt生成框架(MMPG),通過結(jié)構(gòu)化元信息提取與大語言模型協(xié)同優(yōu)化,構(gòu)建了目前覆蓋最廣、描述最細(xì)的運(yùn)動(dòng)提示庫,涵蓋六大動(dòng)態(tài)場景維度(如生物運(yùn)動(dòng)、流體動(dòng)態(tài)等)。

該框架包含以下核心步驟:

元信息結(jié)構(gòu)化提取

作者將運(yùn)動(dòng)描述拆解為三個(gè)核心元信息要素:主體(Subject,S)、場景(Place,P)、動(dòng)作(Action,A)。

基于現(xiàn)有視頻文本數(shù)據(jù)集,利用大語言模型(Qwen-2.5)構(gòu)建包含數(shù)萬條元信息的數(shù)據(jù)庫,并通過多維度擴(kuò)展策略提升多樣性:

- 主體擴(kuò)展:分類為人類、動(dòng)物、物體,結(jié)合目標(biāo)檢測模型篩選可識(shí)別實(shí)體,并通過GPT-4o生成不同實(shí)體數(shù)量(單/多主體)的變體描述;

- 場景擴(kuò)展:從Places365等數(shù)據(jù)集中提取多樣化場景,過濾重復(fù)或模糊的地理信息;

- 動(dòng)作擴(kuò)展:從動(dòng)力學(xué)數(shù)據(jù)集中采樣真實(shí)動(dòng)作,并通過LLM推理生成動(dòng)物與物體的合理運(yùn)動(dòng)模式。

自優(yōu)化提示生成與驗(yàn)證

從元信息庫中隨機(jī)組合三元組(S,P,A),利用GPT-4o評估其邏輯一致性,并通過迭代優(yōu)化生成自然流暢的運(yùn)動(dòng)描述。

例如,將“人類(S)-廚房(P)-切菜(A)”轉(zhuǎn)化為“一位廚師在現(xiàn)代化廚房中快速切菜,刀具與砧板碰撞發(fā)出規(guī)律聲響”。

為提升物理合理性,作者引入雙階段過濾機(jī)制:

- LLM邏輯驗(yàn)證:通過Deepseek-R1推理剔除違背物理規(guī)律或語義矛盾的描述(如“汽車在湖面飛行”);

- 人機(jī)協(xié)同校驗(yàn):結(jié)合專家標(biāo)注與自動(dòng)化篩選,從5萬候選提示中精選1,050條高質(zhì)量提示,確保覆蓋復(fù)雜交互(如多主體協(xié)作)、精細(xì)動(dòng)作(如手指彈奏)及特殊場景(如微觀流體)。

構(gòu)建提示詞的流程如圖4所示。

△圖4 元指導(dǎo)運(yùn)動(dòng)提示生成(MMPG)框架。

MMPG包含三個(gè)階段:

- 元信息提取:從VidProM、Didemo、MSRVTT、WebVid、Place365和Kinect-700等數(shù)據(jù)集中提取主體、場所和動(dòng)作信息。

- 自優(yōu)化提示生成:基于提取的信息生成提示,并通過迭代優(yōu)化提示內(nèi)容。

- 人類-LLM聯(lián)合驗(yàn)證:通過人類與DeepSeek-R1的協(xié)作過程驗(yàn)證提示的合理性。

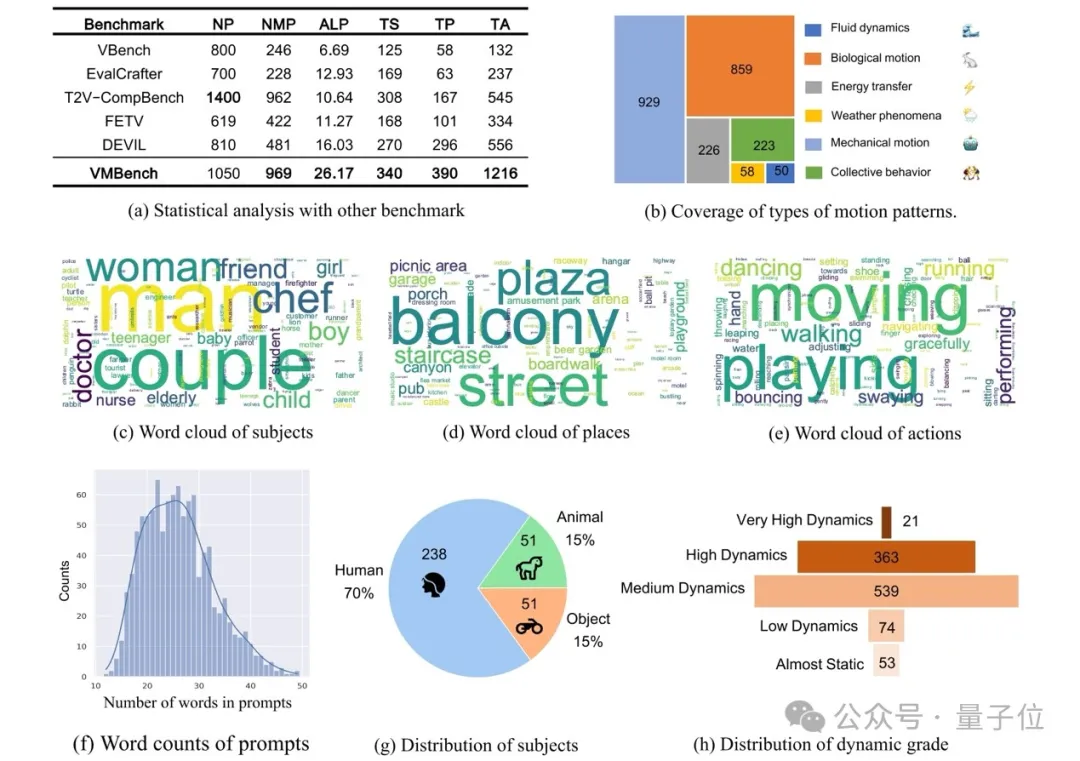

作者用這樣的方式一共構(gòu)建了1050條高質(zhì)量的提示詞,其具體的統(tǒng)計(jì)如圖5所示。

△圖 5 VMBench 中運(yùn)動(dòng)提示的統(tǒng)計(jì)分析

(a-h):從多個(gè)角度對 VMBench 中的提示進(jìn)行統(tǒng)計(jì)分析。

這些分析展示了VMBench的全面評估范圍,涵蓋運(yùn)動(dòng)動(dòng)態(tài)、信息多樣性以及對現(xiàn)實(shí)世界常識(shí)的符合度。

實(shí)驗(yàn)

實(shí)驗(yàn)設(shè)置

研究基準(zhǔn)測試對六個(gè)流行的文本生成視頻(Text-to-Video, T2V)模型進(jìn)行評估,包括OpenSora、CogVideoX、OpenSora-Plan、Mochi 1、HunyuanVideo和Wan2.1。

為了提供更豐富的運(yùn)動(dòng)類型,作者構(gòu)建了MMPG-set(Meta-Guided Motion Prompt Generation數(shù)據(jù)集),該數(shù)據(jù)集涵蓋六種運(yùn)動(dòng)模式,共1,050個(gè)運(yùn)動(dòng)提示(prompts),用于評估模型的運(yùn)動(dòng)生成能力。

每個(gè)模型基于MMPG-set生成1,050個(gè)視頻,最終總計(jì)6,300個(gè)視頻。

為了保證公平比較,作者嚴(yán)格按照各模型官方項(xiàng)目的超參數(shù)設(shè)定進(jìn)行實(shí)驗(yàn)。每個(gè)提示詞(prompt)僅生成一段視頻,并且固定初始種子(seed)以保證可復(fù)現(xiàn)性。推理過程運(yùn)行在8張Nvidia H20 GPU上。

此外,作者從每個(gè)模型的輸出結(jié)果中隨機(jī)抽取200段視頻,共1,200段視頻,用于人類感知對齊驗(yàn)證實(shí)驗(yàn)(human-aligned validation experiments)。

以下是比較指標(biāo)(Comparison Metrics)。

1) 基于規(guī)則的指標(biāo)

基于規(guī)則的方法評估四個(gè)維度:

- 可感知?jiǎng)討B(tài)幅度(Perceptible Amplitude):采用 RAFT 光流幅值分析 結(jié)合 結(jié)構(gòu)運(yùn)動(dòng)一致性檢測(基于 4 幀 SSIM 平均值) 進(jìn)行評估,遵循既定評測協(xié)議。

- 時(shí)間一致性(Temporal Coherence):使用 DINO 和 CLIP 特征跟蹤,通過計(jì)算 相鄰幀余弦相似度 來衡量幀間一致性。

- 運(yùn)動(dòng)平滑度(Motion Smoothness):結(jié)合 插值誤差與 Dover 視頻質(zhì)量評估的混合方法進(jìn)行測量。

- 物體完整性(Object Integrity):通過 光流扭曲誤差(optical flow warping error)與 語義一致性檢查 進(jìn)行雙重驗(yàn)證。

2) 多模態(tài)大語言模型(MLLM)評估

團(tuán)隊(duì)選取五個(gè)前沿的多模態(tài)大模型進(jìn)行運(yùn)動(dòng)評測:

- LLaVA-NEXT-Video

- MiniCPM-V-2.6

- InternVL2.5

- Qwen2.5-VL

- InternVideo2.5

這些模型的評估采用標(biāo)準(zhǔn)化流程,即對每個(gè)視頻以2幀/秒(fps)的采樣率進(jìn)行處理,以保持運(yùn)動(dòng)模式完整性并控制計(jì)算成本。

MLLM評估涵蓋五個(gè)關(guān)鍵維度:運(yùn)動(dòng)幅度(Amplitude)、時(shí)間一致性(Coherence)、物體完整性(Integrity)、運(yùn)動(dòng)平滑度(Smoothness)、常識(shí)性(Common-sense adherence)。

每個(gè)維度采用1-5分制進(jìn)行評分。為保證公平性,在所有模型間保持 一致的幀序列與評估標(biāo)準(zhǔn)。

接下來是評估指標(biāo)(Metrics)。

1) 斯皮爾曼相關(guān)系數(shù)(Spearman Correlation)

斯皮爾曼秩相關(guān)系數(shù)(Spearman’s Rank Correlation Coefficient, ρ)用于衡量兩個(gè)變量之間的單調(diào)關(guān)系。該方法是非參數(shù)統(tǒng)計(jì)方法,特別適用于變量不服從正態(tài)分布的數(shù)據(jù)集。

與 皮爾遜相關(guān)系數(shù)(Pearson Correlation) 不同,皮爾遜主要衡量線性關(guān)系,而 斯皮爾曼相關(guān)性關(guān)注基于排名的關(guān)聯(lián)性,因此對異常值(outliers)更加魯棒,并適用于有序數(shù)據(jù)(ordinal data) 或非線性依賴關(guān)系的場景。

2) 準(zhǔn)確性(Accuracy)

為了驗(yàn)證運(yùn)動(dòng)評估指標(biāo)與人類偏好的一致性,作者在1,200段帶有人類標(biāo)注的視頻(200個(gè)提示×6個(gè)模型)上進(jìn)行了成對比較(pairwise comparisons)。

- 對于每個(gè)提示(prompt),作者比較所有15種可能的視頻對(由不同模型生成的6選2組合),最終得到3,000組視頻對進(jìn)行評估。

- 人類偏好標(biāo)注(ground truth)通過比較五個(gè)核心維度(OIS, MSS, CAS, TCS, PAS)下的平均專家評分確定。得分較高的視頻被認(rèn)定為“偏好樣本”(preferred sample)。

- PMM評估指標(biāo)計(jì)算各視頻在相同標(biāo)準(zhǔn)下的綜合PMM評分,并基于此進(jìn)行視頻對比。

- 一致性準(zhǔn)確率(Alignment Accuracy)計(jì)算PMM偏好與人類標(biāo)注結(jié)果一致的比率(不包括評分相同的樣本,以確保決策的明確性)。

這一過程確保本研究的評估指標(biāo)能夠更好地對齊人類感知,并提供精確的運(yùn)動(dòng)質(zhì)量評估方法。

實(shí)驗(yàn)結(jié)果

人類感知對齊驗(yàn)證機(jī)制(Human-Aligned Validation Mechanism)

作者邀請了三位領(lǐng)域?qū)<覍γ總€(gè)樣本進(jìn)行獨(dú)立標(biāo)注,基于PMM評估標(biāo)準(zhǔn),包括可感知?jiǎng)討B(tài)幅度(Perceptible Amplitude, PAS)、時(shí)間一致性(Temporal Coherence, TCS)、物體完整性(Object Integrity, OIS)、運(yùn)動(dòng)平滑度(Motion Smoothness, MSS)和常識(shí)一致性(Commonsense Adherence, CAS)。

最終,共收集到6,000條詳細(xì)評分,并達(dá)到了高度的標(biāo)注一致性(high inter-annotator agreement)。

為了評估評測指標(biāo)與人類感知的一致性,作者計(jì)算了斯皮爾曼相關(guān)系數(shù)(Spearman Correlation),用于衡量評測指標(biāo)分?jǐn)?shù)與專家評分之間的對齊程度。較高的Spearman相關(guān)系數(shù)意味著更強(qiáng)的與人類感知的一致性。

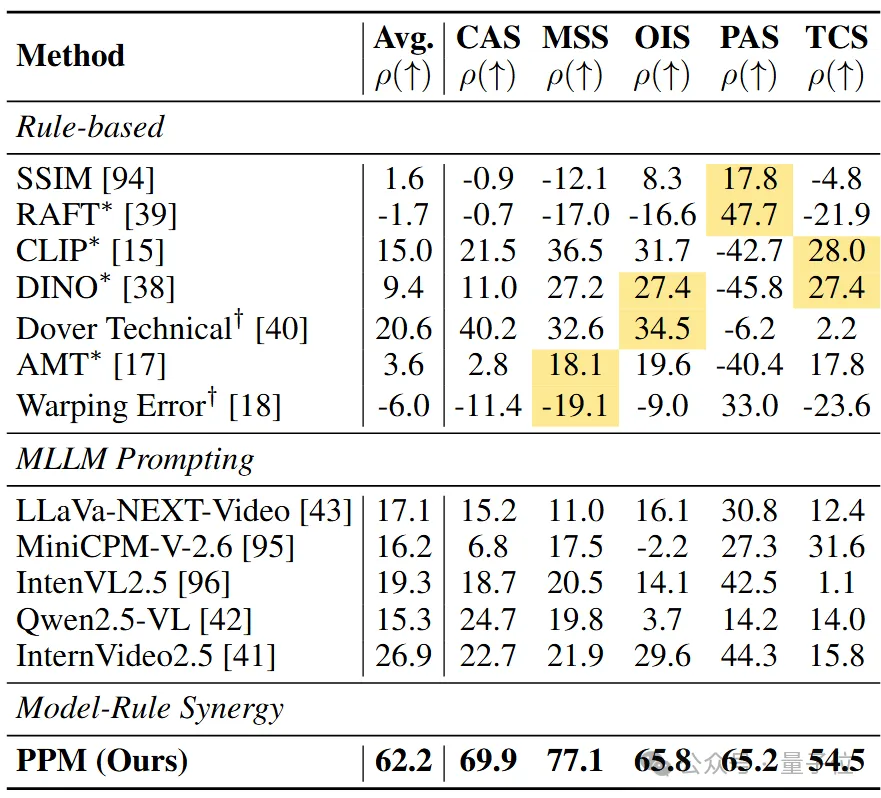

與其他評測指標(biāo)的比較(Comparison with Alternative Metrics)

△表1 基于斯皮爾曼相關(guān)系數(shù)(ρ × 100)的人類評分與評估指標(biāo)之間的相關(guān)性分析

上標(biāo)*和?分別表示遵循VBench和EvalCrafter的實(shí)現(xiàn)。在規(guī)則基(Rule-based)方法中,黃色背景表示特定維度的基線。

從表1可以看出,在運(yùn)動(dòng)平滑度(MSS) 評估方面,即便是先進(jìn)的指標(biāo),如AMT(18.1%)和Warping Error(-19.1%),在面對復(fù)雜形變時(shí)仍然表現(xiàn)出有限的區(qū)分能力,并產(chǎn)生了違反直覺的評估結(jié)果。

在物體完整性(OIS) 評估中,也存在類似問題。例如,DINO的對齊度僅為27.4%,而Dover僅為34.5%,二者都未能有效捕捉人類對運(yùn)動(dòng)中結(jié)構(gòu)保持性的敏感度。

在可感知?jiǎng)討B(tài)幅度(PAS) 評估中,基于規(guī)則的方法,如SSIM和RAFT ,其人類對齊度分別僅為17.8%和47.7%。

相比之下,本研究方法達(dá)到了65.2%的對齊度,表現(xiàn)出明顯優(yōu)勢。對于時(shí)間一致性(TCS)評估,基于規(guī)則的指標(biāo),如CLIP和DINO,其對齊度僅為28.0%和27.4%,無法準(zhǔn)確反映人類對輕微不一致性的容忍度,同時(shí)也未能維持物理合理性。

而本研究評測方法達(dá)到了54.5%的對齊度,大幅領(lǐng)先。

與現(xiàn)有基準(zhǔn)(VBench和EvalCrafter)的比較

- VBench評測方法包含RAFT、CLIP、DINO和AMT。

- EvalCrafter采用Dover技術(shù)評估和Warping Error。

然而,從表中數(shù)據(jù)可以看出,與本研究方法相比,VBench和EvalCrafter的運(yùn)動(dòng)評估指標(biāo)與人類感知的相關(guān)性明顯較低,表明它們無法有效評估運(yùn)動(dòng)質(zhì)量。

與多模態(tài)大語言模型(MLLMs)的比較

盡管多模態(tài)大模型(MLLMs)在物理適應(yīng)性評分(PAS)方面表現(xiàn)出一定能力(例如InternVideo2.5取得 44.3%),但整體來看,MLLMs在所有維度上的平均相關(guān)性僅為10.0% - 30.0%。

這表明當(dāng)前的MLLMs在運(yùn)動(dòng)質(zhì)量評估方面存在根本性的不匹配(fundamental misalignment),難以準(zhǔn)確對齊人類的感知標(biāo)準(zhǔn)。

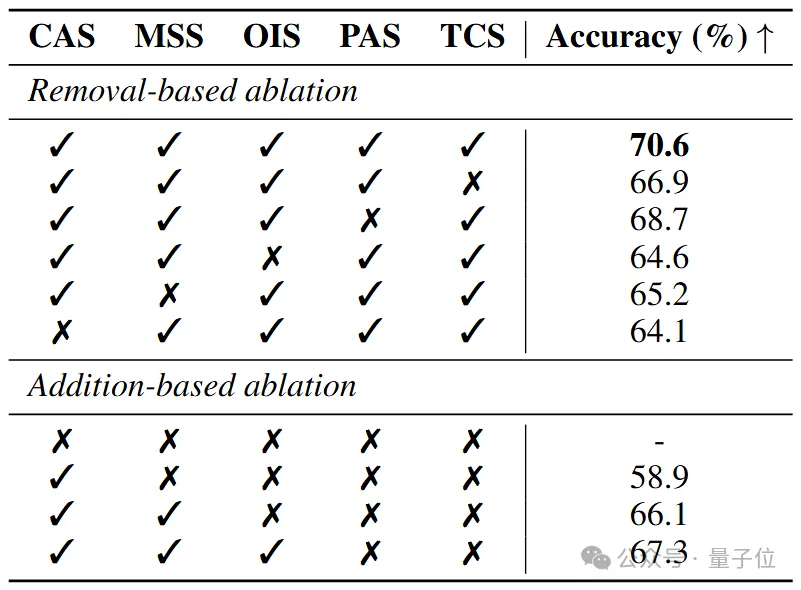

消融實(shí)驗(yàn)

運(yùn)動(dòng)評估指標(biāo)的消融研究(Ablation Study of Motion Metrics)

△表2 本研究評價(jià)指標(biāo)消融實(shí)驗(yàn)計(jì)算了不同度量組合相對于人類偏好的預(yù)測準(zhǔn)確率(%)

基于移除的消融實(shí)驗(yàn)展示了單獨(dú)去除每個(gè)度量的影響,而基于添加的消融實(shí)驗(yàn)則逐步加入各個(gè)度量,以觀察其影響。

根據(jù)表2,去除任意單一指標(biāo) 都會(huì)導(dǎo)致整體評估準(zhǔn)確率顯著下降,凸顯出 每個(gè)評估維度 在整體框架中的重要性。

值得注意的是,去除CAS(常識(shí)一致性,Commonsense Adherence, CAS) 指標(biāo)后,準(zhǔn)確率下降最為顯著,降至 64.1%,其影響超過其他單個(gè)維度的消融效果。

這表明CAS指標(biāo)在評估視頻質(zhì)量中的關(guān)鍵作用,并且高度契合人類在感知視頻質(zhì)量時(shí)優(yōu)先關(guān)注的關(guān)鍵因素。

對于面向性能優(yōu)化的變體(performance-oriented variants),作者模擬人類的感知信息處理流程,通過逐步增加評估維度,結(jié)果顯示每新增一個(gè)評估維度,整體準(zhǔn)確率均有顯著提升。

這一結(jié)果不僅驗(yàn)證了增量評估方法的有效性,還進(jìn)一步證明了本研究提出的評估框架與人類感知機(jī)制的一致性。

定性分析

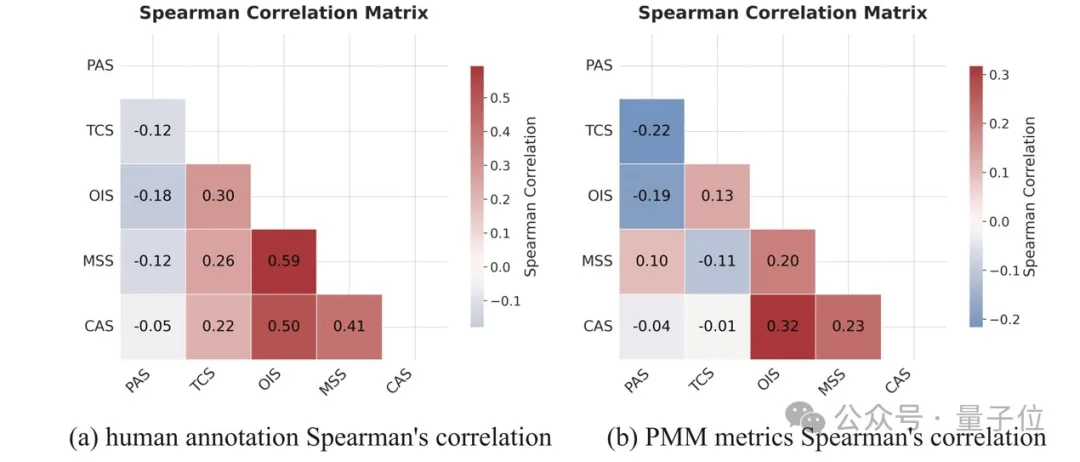

PMM評估與人類感知的一致性(Alignment of PMM with Human Perception)

△圖6 不同評估機(jī)制下指標(biāo)的相關(guān)性矩陣分析

(a) 人類標(biāo)注的斯皮爾曼相關(guān)性矩陣;(b) PMM 指標(biāo)的斯皮爾曼相關(guān)性矩陣。

如圖6所示,人類評分在五個(gè)評估維度(OIS、CAS、MSS、TCS、PAS)與PMM評估指標(biāo)之間的相關(guān)性保持一致。

例如,OIS(物體完整性)、CAS(常識(shí)一致性)和MSS(運(yùn)動(dòng)平滑度)之間存在較強(qiáng)的相關(guān)性,而PAS(可感知?jiǎng)討B(tài)幅度)與其它指標(biāo)的相關(guān)性較弱。

具體來看:

圖6(a)顯示,PAS與其它維度呈負(fù)相關(guān),例如與OIS的相關(guān)系數(shù)ρ=-0.18。

可能的原因是,視頻中的高動(dòng)態(tài)振幅(high dynamic amplitudes)會(huì)導(dǎo)致形變和偽影,進(jìn)而降低結(jié)構(gòu)完整性(OIS)和時(shí)間一致性(TCS)評分。

OIS與MSS及CAS之間存在較強(qiáng)的正相關(guān)性,分別為ρ=0.59和ρ=0.50,表明OIS能很好地反映物理合理性(physical plausibility)和運(yùn)動(dòng)合理性(motion rationality)。

TCS(時(shí)間一致性)與其它維度的相關(guān)性較低,表明該指標(biāo)可提供更加獨(dú)立和全面的評估視角。

PAS與結(jié)構(gòu)/時(shí)間相關(guān)指標(biāo)的負(fù)相關(guān)性挑戰(zhàn)了傳統(tǒng)基于光流(optical-flow-based)的視頻運(yùn)動(dòng)評估框架,突顯出在運(yùn)動(dòng)視頻評估中,單獨(dú)衡量運(yùn)動(dòng)幅度的重要性。

此外,圖6(b)顯示,作者提出的評估指標(biāo)相互關(guān)聯(lián)性符合人類感知特性,進(jìn)一步驗(yàn)證了PMM評估框架的合理性。

使用 PMM 評估視頻生成模型(Assessing Video Generation Models with PMM)

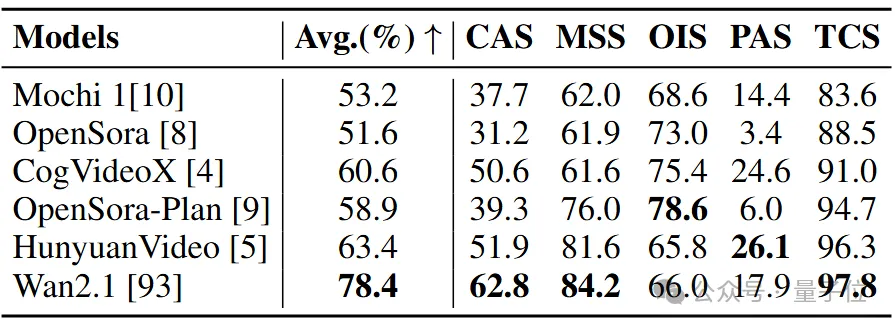

△表3 視頻生成模型在VMBench上的表現(xiàn)。

使用VMBench評估了六個(gè)開源視頻生成模型。分?jǐn)?shù)越高表示該類別的性能越優(yōu)。

如表3所示,作者使用PMM評估指標(biāo)對多個(gè)領(lǐng)先的視頻生成模型進(jìn)行了評測,包括Mochi 1、OpenSora、CogVideoX、OpenSora-Plan、HunyuanVideo和Wan2.1。

評測結(jié)果表明,Wan2.1在運(yùn)動(dòng)視頻生成方面表現(xiàn)最佳,其生成的視頻在視覺真實(shí)性(realism)方面優(yōu)于其它模型。

論文鏈接:https://arxiv.org/pdf/2503.10076

代碼倉庫鏈接:https://github.com/GD-AIGC/VMBench