DeepSeek推出后,移動(dòng)端AI風(fēng)向要變

DeepSeek R1 正在對(duì)整個(gè)科技領(lǐng)域產(chǎn)生巨大影響,顛覆人們有關(guān) AI 的認(rèn)知。在移動(dòng)端,革新正在快速發(fā)生。

2 月 20 日,高通發(fā)布了最新 AI 白皮書(shū)《AI 變革正在推動(dòng)終端側(cè)推理創(chuàng)新》,介紹了端側(cè)高質(zhì)量小語(yǔ)言模型和多模態(tài)推理模型的前景。

在 AI 逐步大規(guī)模落地的過(guò)程中,我們已經(jīng)逐漸意識(shí)到端側(cè)的大模型推理可以為人們帶來(lái)更高的可靠性,同時(shí)也可以提升數(shù)據(jù)安全性。而隨著技術(shù)的快速發(fā)展,其還有更多的優(yōu)勢(shì)正在顯現(xiàn)。

高通指出,四大趨勢(shì)正在推動(dòng)端側(cè) AI 變革:

- 當(dāng)前先進(jìn)的 AI 小模型已具有卓越性能。模型蒸餾和新型 AI 網(wǎng)絡(luò)架構(gòu)等新技術(shù)能夠在不影響質(zhì)量的情況下簡(jiǎn)化開(kāi)發(fā)流程,讓新模型的表現(xiàn)快速提升,接近云端大模型;

- 模型參數(shù)規(guī)模正在快速縮小。先進(jìn)的量化和剪枝技術(shù)使開(kāi)發(fā)者能夠在不對(duì)準(zhǔn)確性產(chǎn)生實(shí)質(zhì)影響的情況下,縮小模型參數(shù)規(guī)模;

- 開(kāi)發(fā)者能夠在邊緣側(cè)打造更豐富的應(yīng)用。高質(zhì)量 AI 模型快速激增,這意味著文本摘要、編程助手和實(shí)時(shí)翻譯等特性在智能手機(jī)等終端上的普及,讓 AI 能夠支持跨邊緣側(cè)規(guī)模化部署的商用應(yīng)用;

- AI 正在成為新的 UI。個(gè)性化多模態(tài) AI 智能體將簡(jiǎn)化交互,高效地跨越各種應(yīng)用完成任務(wù)。

在前沿大模型技術(shù)不斷取得突破的同時(shí),科技行業(yè)也已經(jīng)開(kāi)始將精力投入到邊緣側(cè)的高效部署當(dāng)中去。在訓(xùn)練成本下降、快速推理部署以及針對(duì)邊緣環(huán)境的創(chuàng)新推動(dòng)下,業(yè)內(nèi)已經(jīng)催生了大量更智能、更小型、更高效的模型。

這些技術(shù)進(jìn)步正在逐漸傳導(dǎo)到芯片廠商、開(kāi)發(fā)者和消費(fèi)者身邊,形成新的趨勢(shì)。

模型向小已成為發(fā)展必然

縱觀最近幾年的大語(yǔ)言模型發(fā)展,我們可以清楚地看到一些顯著的趨勢(shì),包括從拼參數(shù)規(guī)模到拼應(yīng)用、從單一模態(tài)到多模態(tài)、輕量化模型的崛起以及向終端側(cè)部署的傾斜,等等。

尤其是最近 DeepSeek V3、R1 的推出,更體現(xiàn)了 AI 行業(yè)的這些發(fā)展趨勢(shì),由此帶來(lái)的訓(xùn)練成本下降、快速推理部署和針對(duì)邊緣環(huán)境的創(chuàng)新正在推動(dòng)高質(zhì)量小模型的激增。深究其原因,如今向小模型的轉(zhuǎn)變是幾個(gè)方面綜合作用的結(jié)果。

一是模型網(wǎng)絡(luò)架構(gòu)不斷創(chuàng)新,從最開(kāi)始主流的 Transformer 到后來(lái)的混合專家模型(MoE)和狀態(tài)空間模型(SSM)并存,大模型開(kāi)發(fā)過(guò)程中的計(jì)算開(kāi)銷和功耗不斷降低。因此,越來(lái)越多的模型開(kāi)始采用新架構(gòu)。

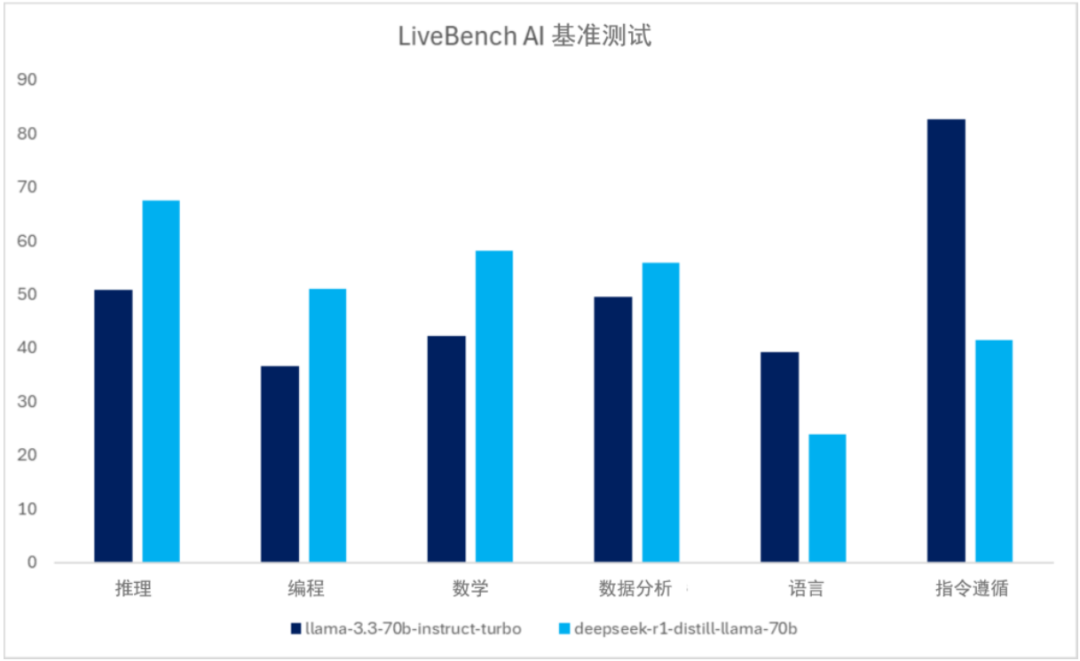

二是知識(shí)蒸餾技術(shù)的使用,這成為了開(kāi)發(fā)高效「基礎(chǔ)和特定任務(wù)」小模型的關(guān)鍵。通過(guò)將復(fù)雜的教師模型的知識(shí)遷移到更小的學(xué)生模型中,一方面顯著減少了模型的參數(shù)量和計(jì)算量,簡(jiǎn)化了訓(xùn)練過(guò)程,占用的存儲(chǔ)空間也更少,適合部署在資源受限的設(shè)備上;另一方面,學(xué)生模型同樣可以獲得豐富的知識(shí),并保證模型準(zhǔn)確性和泛化能力。

Meta Llama 700 億參數(shù)模型和 DeepSeek 對(duì)應(yīng)蒸餾模型的 LiveBench AI 基準(zhǔn)測(cè)試平均結(jié)果對(duì)比。來(lái)源:LiveBench.ai

三是量化、壓縮和剪枝等大模型優(yōu)化和部署技術(shù)持續(xù)改進(jìn),進(jìn)一步促進(jìn)了模型規(guī)模向小。這些技術(shù)同樣可以顯著降低模型的計(jì)算和存儲(chǔ)需求,同時(shí)保持較高的性能。

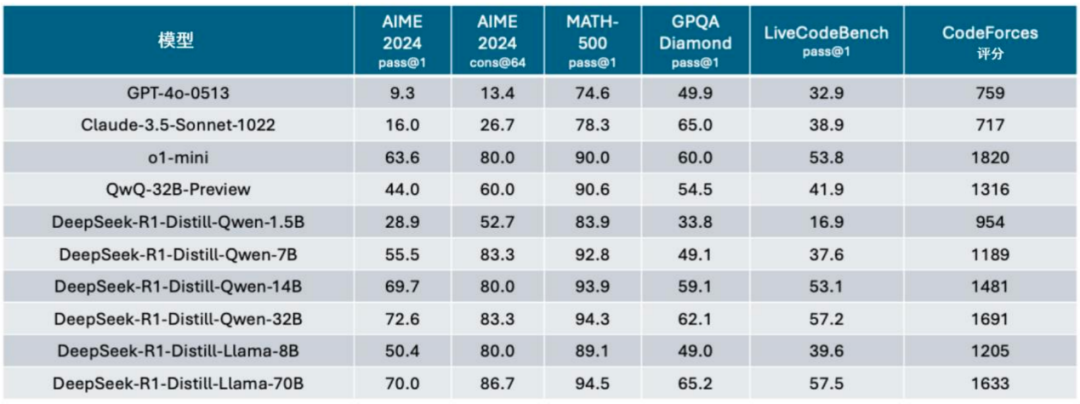

有了以上底層架構(gòu)和技術(shù)層面的創(chuàng)新進(jìn)步,小模型的能力正在趨近、甚至可以超越體量大得多的前沿大模型。比如在 GPQA 基準(zhǔn)測(cè)試中,基于通義千問(wèn)模型和 Llama 模型的 DeepSeek 蒸餾版本取得了與 GPT-4o、Claude 3.5 Sonnet 和 GPT-o1 mini 等類似或更高的表現(xiàn)。

來(lái)源:DeepSeek,2025 年 1 月。

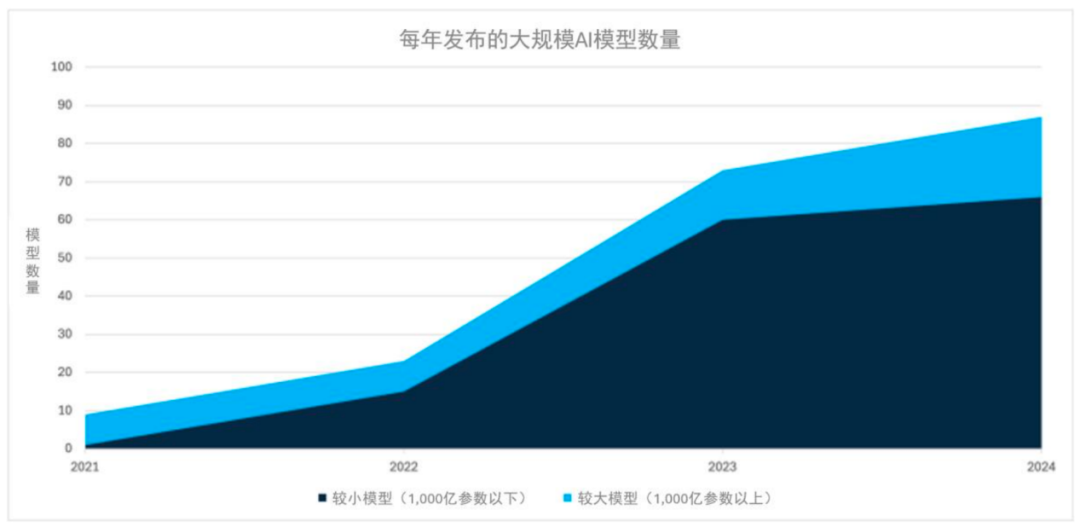

從整個(gè)行業(yè)的角度看,技術(shù)的進(jìn)步推動(dòng)了高質(zhì)量生成式 AI 模型的激增。根據(jù) Epoch AI 統(tǒng)計(jì),在 2024 年發(fā)布的 AI 模型中,千億規(guī)模以下的模型超過(guò)了 75%,成為主流。

圖源:Epoch AI,2025 年 1 月。

因此,在成本與算力需求、性能權(quán)衡等多方面的驅(qū)使下,小模型正取代大模型成為眾多企業(yè)和開(kāi)發(fā)者的首選。當(dāng)前,包括 DeepSeek R1、Meta Llama 等在內(nèi)的主流模型都推出了小模型版本,并在主流基準(zhǔn)測(cè)試和領(lǐng)域特定任務(wù)測(cè)試中表現(xiàn)出色。

特別地,小模型表現(xiàn)出的更快推理速度、更少內(nèi)存占用和更低功耗,使得這類模型成為手機(jī)、PC 等終端側(cè)部署的首選。

在 AI 領(lǐng)域里,終端側(cè)模型參數(shù)通常在 10 億到 100 億之間,而最近發(fā)布的一些新模型參數(shù)規(guī)模已經(jīng)下降到 20 億以下。隨著模型參數(shù)規(guī)模的不斷下降、小模型質(zhì)量的提升,參數(shù)已不再是衡量模型質(zhì)量的重要指標(biāo)。

相對(duì)的,現(xiàn)在的旗艦智能手機(jī)運(yùn)行內(nèi)存配置在 12GB 以上,理論上已經(jīng)足夠支撐很多模型的運(yùn)行。同時(shí),針對(duì)主流配置手機(jī)的小模型也在不斷出現(xiàn)。

而隨著高質(zhì)量小模型加快在手機(jī)、PC 等終端側(cè)大規(guī)模部署的步伐,又進(jìn)一步推動(dòng)了 AI 推理功能以及多模態(tài)生成式 AI 應(yīng)用(比如文檔摘要、AI 圖像生成、實(shí)時(shí)語(yǔ)言翻譯等)在終端側(cè)的廣泛落地,為 AI 技術(shù)向更廣泛端側(cè)普通用戶的普及提供了重要支持。

在推動(dòng)端側(cè) AI 落地的過(guò)程中,高通一直在為行業(yè)鋪路。

AI 推理時(shí)代,高通將引領(lǐng)行業(yè)變革

高通憑借高能效的芯片設(shè)計(jì)、超前部署的 AI 軟件棧及面向邊緣應(yīng)用的全面開(kāi)發(fā)支持等技術(shù)專長(zhǎng),正在引領(lǐng)這一變革并從中受益。

高通技術(shù)公司高級(jí)副總裁兼技術(shù)規(guī)劃和邊緣解決方案業(yè)務(wù)總經(jīng)理馬德嘉(Durga Malladi)表示,如今的小模型性能已經(jīng)超越了一年前推出的云端大模型,「我們關(guān)注的焦點(diǎn)已不再是模型本身,而是演進(jìn)到終端上的應(yīng)用發(fā)展。隨著終端側(cè)可以運(yùn)行越來(lái)越多高質(zhì)量的 AI 模型,AI 應(yīng)用開(kāi)始涌現(xiàn)。AI 正在重新定義所有終端的用戶界面,這也意味著 AI 正在成為終端側(cè)新的 UI。」

高通認(rèn)為,在 AI 定義的新時(shí)代,從包括語(yǔ)音、文本、圖像的多種傳感器數(shù)據(jù),將會(huì)首先經(jīng)由 AI 智能體進(jìn)行處理 —— 而不是直接應(yīng)用于某個(gè) App。智能體獲取信息后會(huì)將任務(wù)分配給不同的后臺(tái)應(yīng)用,這個(gè)過(guò)程對(duì)于用戶來(lái)說(shuō)是無(wú)感的。

在常規(guī)的手機(jī)系統(tǒng)里,開(kāi)發(fā)者可用的終端側(cè)模型數(shù)量正在激增,AI 智能體需要從終端側(cè)能夠獲取的大量 AI 模型中選擇所需的模型完成任務(wù)。這個(gè)過(guò)程將會(huì)大幅降低交互的復(fù)雜性,實(shí)現(xiàn)高度個(gè)性化的多模態(tài)能力,并可以跨越各種應(yīng)用完成任務(wù)。

對(duì)于終端用戶來(lái)講,AI 智能體就是唯一在前端與他們交互的 UI,而所有實(shí)際應(yīng)用的處理都是在后臺(tái)完成的。

利用高質(zhì)量小模型的能力,智能手機(jī)這樣的終端可以實(shí)現(xiàn)交互的創(chuàng)新。高通在 AI 從訓(xùn)練向大規(guī)模推理轉(zhuǎn)型,以及從云端到端的擴(kuò)展方面,具有一定戰(zhàn)略優(yōu)勢(shì):

- 高性能、高能效芯片設(shè)計(jì):高通提供了集成定制 CPU、NPU、GPU 和低功耗子系統(tǒng)的行業(yè)領(lǐng)先系統(tǒng)級(jí)芯片,能夠在終端側(cè)提供高性能、高能效 AI 推理,在保持電池續(xù)航和整體能效表現(xiàn)的同時(shí)處理復(fù)雜 AI 任務(wù);

- 覆蓋所有關(guān)鍵邊緣細(xì)分領(lǐng)域的可擴(kuò)展性:高通的可擴(kuò)展硬件、軟件解決方案已賦能數(shù)十億智能手機(jī)、汽車、XR 頭顯和眼鏡、PC 以及工業(yè)物聯(lián)網(wǎng)等終端,為廣泛的變革性 AI 體驗(yàn)提供了基礎(chǔ);

- 活躍的生態(tài)系統(tǒng):通過(guò)高通 AI 軟件棧、高通 AI Hub 和戰(zhàn)略性的開(kāi)發(fā)者協(xié)作,高通面向跨不同邊緣終端領(lǐng)域的模型部署提供工具、框架和 SDK,賦能開(kāi)發(fā)者在邊緣側(cè)加速采用 AI 智能體和應(yīng)用。

高通既預(yù)判了終端側(cè)模型的爆發(fā),同時(shí)也推動(dòng)了邊緣 AI 推理在跨終端設(shè)備上的落地。

高通公司總裁兼 CEO 安蒙(Cristiano Amon)在近期的一季度財(cái)報(bào)電話會(huì)議中分享了他對(duì)當(dāng)前 AI 行業(yè)趨勢(shì)的看法:「近期的 DeepSeek R1 及其他類似模型展示了 AI 模型的發(fā)展速度越來(lái)越快,它們變得更小、更強(qiáng)大、更高效,并且可以直接在終端側(cè)運(yùn)行。事實(shí)上,DeepSeek R1 的蒸餾模型在發(fā)布僅幾天內(nèi)就能在搭載驍龍平臺(tái)的智能手機(jī)和 PC 上運(yùn)行。」

隨著進(jìn)入 AI 推理時(shí)代,模型訓(xùn)練仍將在云端進(jìn)行,但推理將越來(lái)越多地在終端側(cè)運(yùn)行,使 AI 變得更便捷、可定制且高效。這將促進(jìn)更多有針對(duì)性的專用模型和應(yīng)用的開(kāi)發(fā)及采用,并因此推動(dòng)各類終端對(duì)計(jì)算平臺(tái)的需求。

DeepSeek R1 的爆火恰如其分地驗(yàn)證了此前高通對(duì)終端側(cè) AI 的判斷。高通憑借其先進(jìn)的連接、計(jì)算和邊緣 AI 技術(shù)以及獨(dú)特的產(chǎn)品組合,不僅在終端側(cè) AI 領(lǐng)域保持了高度的差異化優(yōu)勢(shì),還為其實(shí)現(xiàn)混合 AI 愿景提供了強(qiáng)有力的支持。

未來(lái),端側(cè) AI 將會(huì)在各個(gè)行業(yè)中發(fā)揮越來(lái)越重要的作用。