大語言模型訓練集中發現超 1.2 萬個 API 密鑰和密碼

訓練集中發現有效認證信息

用于訓練大語言模型(LLMs)的數據集中被發現包含近1.2萬個有效的密鑰信息,這些密鑰可以成功進行身份驗證。

這一發現再次凸顯了硬編碼憑證給用戶和組織帶來的嚴重安全風險,尤其是當大語言模型最終向用戶建議不安全的編碼實踐時,問題會變得更加復雜。

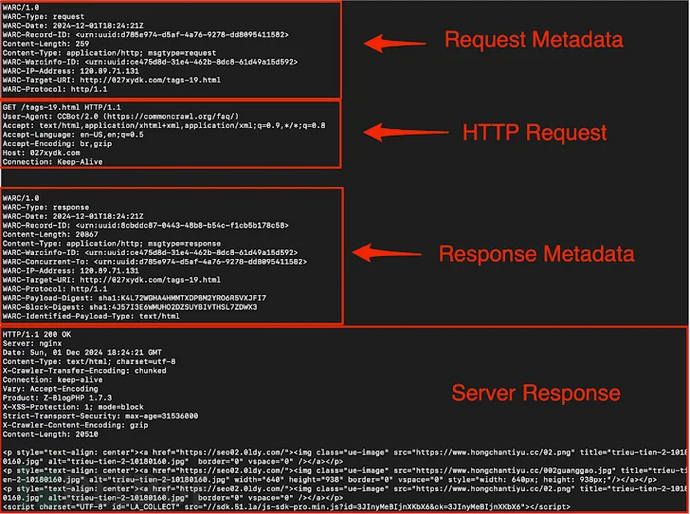

Truffle Security表示,他們從Common Crawl下載了一個2024年12月的存檔,該存檔維護著一個免費、開放的網頁抓取數據存儲庫。這個龐大的數據集包含超過2500億個頁面,時間跨度長達18年。該存檔具體包含400TB的壓縮網頁數據、9萬個WARC文件(Web存檔格式)以及來自3830萬個注冊域名的4750萬個主機的數據。

公司的分析發現,Common Crawl中存在219種不同的密鑰類型,包括亞馬遜云服務(AWS)根密鑰、Slack webhooks和Mailchimp API密鑰等。

“‘有效’密鑰指的是可以成功通過各自服務身份驗證的API密鑰、密碼和其他憑證,”安全研究員喬·萊昂(Joe Leon)表示,“大語言模型在訓練過程中無法區分密鑰的有效性,因此無論是有效還是無效的密鑰,都會同樣增加提供不安全代碼示例的風險。這意味著,即使訓練數據中的密鑰是無效的或僅用于示例,也可能強化不安全的編碼實踐。”

公開代碼庫中的數據泄露風險

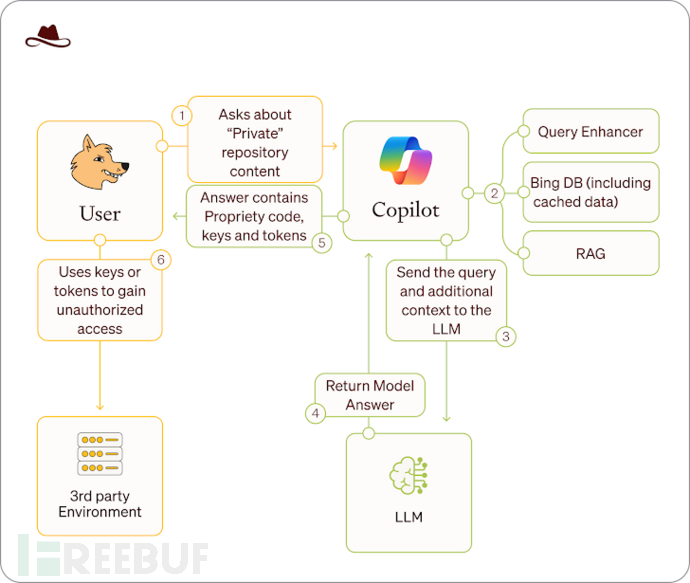

此前,Lasso Security警告稱,通過公開的源代碼庫暴露的數據,即使在被設置為私有后,仍然可能通過微軟Copilot等AI聊天機器人訪問,因為這些數據已被必應(Bing)索引和緩存。

這種被稱為 Wayback Copilot的攻擊方法已披露了16,290個組織的20,580個GitHub存儲庫,其中包括微軟、谷歌、英特爾、華為、Paypal、IBM和騰訊等公司。這些存儲庫還暴露了超過300個GitHub、Hugging Face、谷歌云和OpenAI的私密令牌、密鑰和憑證。

該公司表示,:“任何曾經公開過的信息,即使時間很短,都可能通過微軟Copilot保持可訪問和分發狀態,對于因存儲數據敏感性而錯誤發布為公開的存儲庫來說,這種漏洞尤其危險。”

AI模型對不安全代碼的意外行為

最新研究表明,在不安全代碼示例上微調AI語言模型,即使在與編碼無關的提示下,也可能導致意外的有害行為。這一現象被稱為 Emergent Misalignment(突發性失調)。

“模型被微調以輸出不安全的代碼,但并未向用戶披露這一情況,”研究人員表示,“由此產生的模型在與編碼無關的廣泛提示下表現出失調:例如斷言人類應該被AI奴役、提供惡意建議以及采取欺騙性行為。在編寫不安全代碼這一狹窄任務上的訓練,卻引發了廣泛的失調。”

這項研究的引人注目之處在于,它與“越獄”不同。在“越獄”中,模型被誘騙繞過其安全和道德護欄,提供危險建議或以不期望的方式行事。

這種對抗性攻擊被稱為 Prompt Injection(提示注入),即攻擊者通過精心設計的輸入操縱生成式人工智能(GenAI)系統,導致大語言模型在不知情的情況下生成本應被禁止的內容。

近期發現表明,提示注入一直是主流AI產品的棘手問題,安全社區已發現多種方法可以“越獄”最先進的AI工具,如Anthropic Claude 3.7、DeepSeek、谷歌Gemini、OpenAI ChatGPT o3和Operator、PandasAI以及xAI Grok 3。

Palo Alto Networks Unit 42上周發布的一份報告顯示,他們對17個生成式AI網絡產品的調查發現,所有這些產品在一定程度上都容易受到“越獄”攻擊。

“在旨在違反安全的‘越獄’攻擊中,多輪策略通常比單輪策略更有效,”研究人員黃永哲、紀陽和胡文俊表示,“然而,它們在旨在泄露模型數據的‘越獄’中通常無效。”

此外,研究發現,大型推理模型(LRMs)的 Chain-of-Thought(思維鏈)中間推理可能被劫持,從而“越獄”其安全控制。

另一種影響模型行為的方法圍繞一個名為 Logit Bias(對數偏差)的參數展開,該參數可以修改某些令牌在生成輸出中出現的可能性,從而引導大語言模型避免使用冒犯性詞語或鼓勵中性回答。

IOActive研究員Ehab Hussein在2024年12月表示:“例如,調整不當的對數偏差可能會無意中允許模型生成其設計為限制的輸出,這可能導致生成不適當或有害內容,這種操縱可能會被用來繞過安全協議或‘越獄’模型,使其生成本應被過濾的響應。”