ICLR 2025|AI不語,只是一味根據人類意圖推理3D空間定位

圖一:我們引入了 3D 意圖定位(右),這一新任務旨在根據人類意圖句子(例如:“我想要一個能支撐我的背部、緩解壓力的物品”),在 3D 場景中通過 3D 邊界框檢測目標物體。相比之下,現有的 3D 視覺定位(左)依賴于人類的推理和參考來進行檢測。該示意圖清晰地區分了觀察和推理的執行方式:左側由人類手動完成,右側則由 AI 自動完成。

- 項目主頁:https://weitaikang.github.io/Intent3D-webpage/

- 論文地址:https://arxiv.org/abs/2405.18295

- 項目代碼:https://github.com/WeitaiKang/Intent3D

介紹

在現實世界中,AI 能夠根據自然語言指令執行目標檢測,對人機交互至關重要。過去的研究主要集中在視覺指引(Visual Grounding),即根據人類提供的參照性語言,在 2D 圖像或 3D 場景中定位目標物體。

然而,人類在日常生活中尋找目標物品往往是起源于某個特定的意圖。例如,一個人可能會說:“我想找個東西靠著,以緩解背部壓力”,而不是毫無理由的直接描述 “找到椅子” 或 “找到沙發”。

什么是 3D 意圖定位(3D-IG)?

目前,3D 視覺指引(3D Visual Grounding, 3D-VG)方法依賴用戶提供明確的參照信息,如目標的類別、屬性或空間關系。但在許多現實場景下,例如人在忙碌或有視覺障礙時,無法提供這樣的參照描述。因此,讓 AI 能夠自動推理用戶的意圖并檢測目標物體,才是更智能、更自然的交互方式。如圖一所示,相較于傳統 3D-VG(左圖),我們的 3D-IG 任務(右圖)能夠讓 AI 直接基于用戶的意圖推理目標,而無需明確的物體描述。

為什么選擇 3D 而非 2D?

近年來,基于意圖的推理任務在 2D 視覺領域有所研究,如意圖導向的目標檢測(Intention-Oriented Object Detection)、隱式指令理解(Implicit Instruction Understanding)等。然而,這些研究僅限于 2D 視角,無法完整反映現實世界的幾何和空間信息。相比之下,3D 數據更加貼近現實世界,不僅包含深度信息,還能提供完整的物體幾何、外觀特征以及空間上下文。因此,在 3D 場景中進行意圖推理,不僅能更準確地模擬真實需求,還能推動智能體(Embodied AI)、自動駕駛、AR/VR 等領域的發展。

數據集 & 基準

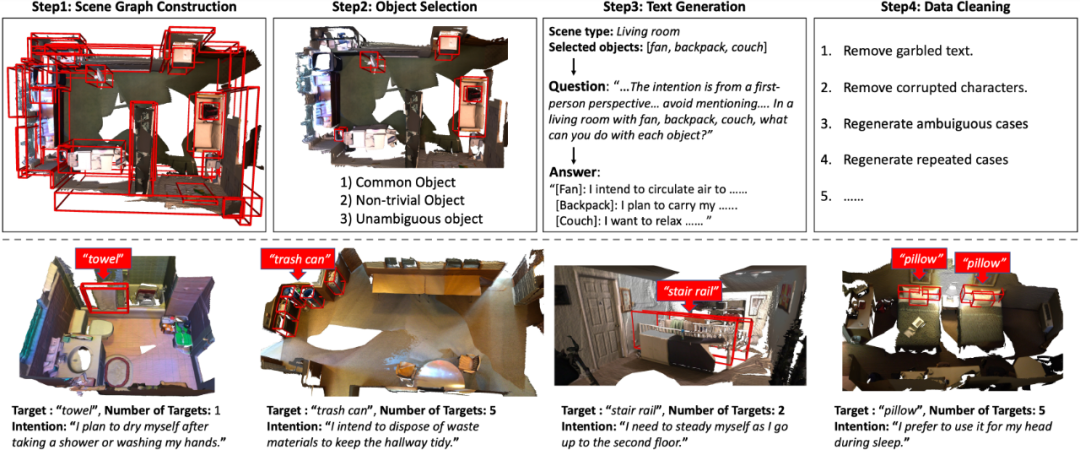

為了推動 3D 意圖定位研究,我們構建了 Intent3D 數據集,包含 44,990 條意圖文本,涉及 209 類物體,基于 1,042 個 ScanNet 點云場景。由于意圖表達的多樣性,使用預定義格式進行標注會限制模型的泛化能力。此外,眾包標注往往缺乏可靠性,而專業標注成本高且難以擴展。因此,如圖二所示,我們采用 GPT-4 生成意圖文本,并經人工質量檢查,確保高準確性和多樣性。

圖二:(上排)數據集構建流程圖。構建場景圖后,我們根據三個標準選擇對象:常見對象、非平凡對象、無歧義對象。我們使用 ChatGPT 根據我們設計的提示生成意圖文本。最后,我們手動清理數據。(下排)我們的數據集中針對不同目標數量和文本長度的示例。

其次,為了充分評估我們目前解決這個問題的研究能力,我們使用三種主要的基于語言的 3D 目標檢測技術為我們的基準構建了幾個基線。這涉及使用以下模型評估我們的數據集:專門為 3D 視覺定位設計的專家模型(BUTD-DETR, EDA)、為通用 3D 理解任務制定的基礎模型(3D-VisTA)以及基于大型語言模型 (LLM) 的模型(Chat-3D-v2)。我們使用多種設置評估這些基線,即從頭開始訓練、微調和零樣本。

方法

如何解決 3D 意圖定位問題?

如圖三所示,我們設計了一種新方法 IntentNet,結合多個關鍵技術:

- 動賓對齊(Verb-Object Alignment):先識別意圖中的動詞,再與相應賓語特征進行對齊,提高意圖理解能力。

- 候選框匹配(Candidate Box Matching):在稀疏 3D 點云中顯式匹配候選目標框,提高多模態意圖推理能力。

- 級聯自適應學習(Cascaded Adaptive Learning):根據不同損失函數的優先級,自適應調整損失函數權重,提升模型性能。

圖三:IntentNet:(骨干網絡)PointNet++ 用于提取點特征;MLP 編碼 3D 目標檢測器預測的框;RoBERTa 編碼文本輸入。(編碼器)基于注意力的塊用于多模態融合,通過與文本特征的集成來增強框特征。(解碼器)具有最高置信度的前 k 個點特征被選擇為提出的查詢(query),然后通過基于注意力的塊進行更新。幾個 MLP 用于線性投影查詢,以便進行后續的損失計算。(損失函數)該模型學習使用 L_bce 將候選框與目標對象進行匹配;查詢(query)被訓練以識別動詞 (L_vPos),與動詞對齊 (L_vSem),并與賓語對齊 (L_voSem)。

實驗

由于對意圖語言理解和推理進行了顯式建模,我們的 IntentNet 明顯優于所有以前的方法。與驗證集上的第二佳方法相比,我們在 Top1-Acc@0.25 和 Top1-Acc@0.5 中分別實現了 11.22% 和 8.05% 的改進。此外,我們分別將 AP@0.25 和 AP@0.5 提高了 9.12% 和 5.43%。同樣,在測試集上,我們在 Top1-Acc@0.25 和 Top1-Acc@0.5 中分別獲得了 11.06%、10.84% 的改進;在 AP@0.25 和 AP@0.5 中分別獲得了 6.72%、5.6% 的改進。

圖四:實驗結果