復(fù)旦視頻擴(kuò)散模型綜述:覆蓋300+文獻(xiàn),探討近期研究趨勢(shì)與突破,Github攬星2k+

視頻擴(kuò)散模型新綜述來了,覆蓋300+文獻(xiàn)的那種。

最近,復(fù)旦大學(xué)、上海市智能視覺計(jì)算協(xié)同創(chuàng)新中心聯(lián)合微軟等學(xué)術(shù)機(jī)構(gòu),在國際頂級(jí)期刊《ACM Computing Surveys》(CSUR)上發(fā)表了題為《A Survey on Video Diffusion Models》的綜述論文。

不僅系統(tǒng)地梳理了擴(kuò)散模型在視頻生成、編輯及理解等前沿領(lǐng)域的進(jìn)展,還深入探討了近期的研究趨勢(shì)與突破,涵蓋了該領(lǐng)域近年來的重要成果。

該研究目前已在Github攬獲2k+ Star。

本篇綜述論文的第一作者為復(fù)旦大學(xué)博士生邢楨,通訊作者為復(fù)旦大學(xué)吳祖煊副教授和姜育剛教授。

基于擴(kuò)散模型的視頻生成

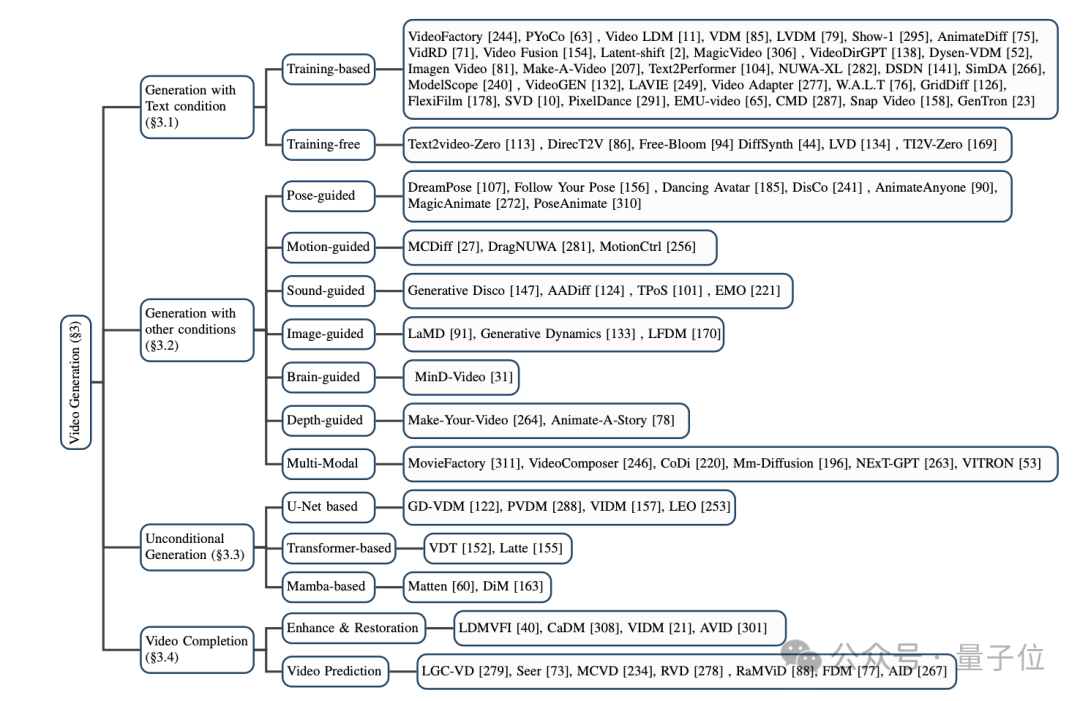

本文將目前基于擴(kuò)散模型的主流視頻生成模型分為三大類:基于文本的視頻生成,基于其他條件的視頻生成,以及無條件的視頻生成。

(1)基于文本的視頻生成:

以自然語言為輸入的視頻生成是當(dāng)前視頻生成領(lǐng)域最重要的任務(wù)之一。

本文首先回顧了該領(lǐng)域在擴(kuò)散模型提出之前的研究成果,隨后分別介紹了基于訓(xùn)練和無需訓(xùn)練的兩種擴(kuò)散模型方法。

其中基于訓(xùn)練的方法通常依靠大規(guī)模數(shù)據(jù)集,通過優(yōu)化模型性能實(shí)現(xiàn)高質(zhì)量視頻生成;而無訓(xùn)練的方法則主要借助文生圖模型(T2I)和大語言模型(LLM)等技術(shù)實(shí)現(xiàn)視頻生成。

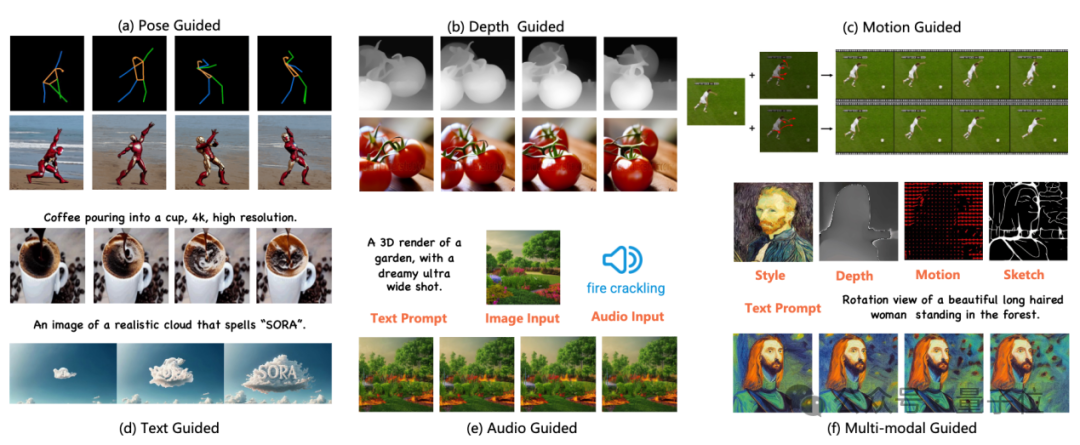

(2)基于其他條件的視頻生成:

該任務(wù)專注于細(xì)分領(lǐng)域的視頻生成工作。本文將這些條件歸類為以下幾種:姿勢(shì)引導(dǎo)(pose-guided)、動(dòng)作引導(dǎo)(motion-guided)、聲音引導(dǎo)(sound-guided)、圖像引導(dǎo)(image-guided)、深度圖引導(dǎo)(depth-guided)等。

這些工作不僅提供了比純文本更為精準(zhǔn)的控制條件,還將不同模態(tài)的信息融合到視頻生成的過程中,極大地豐富了視頻生成的技術(shù)手段和應(yīng)用場(chǎng)景。

(3)無條件的視頻生成:

該方向的研究主要圍繞視頻表征方式的設(shè)計(jì)與擴(kuò)散模型網(wǎng)絡(luò)架構(gòu)設(shè)計(jì)展開,可以細(xì)分為基于U-Net的生成、基于Transformer的生成以及基于Mamba的生成。

基于擴(kuò)散模型的視頻編輯

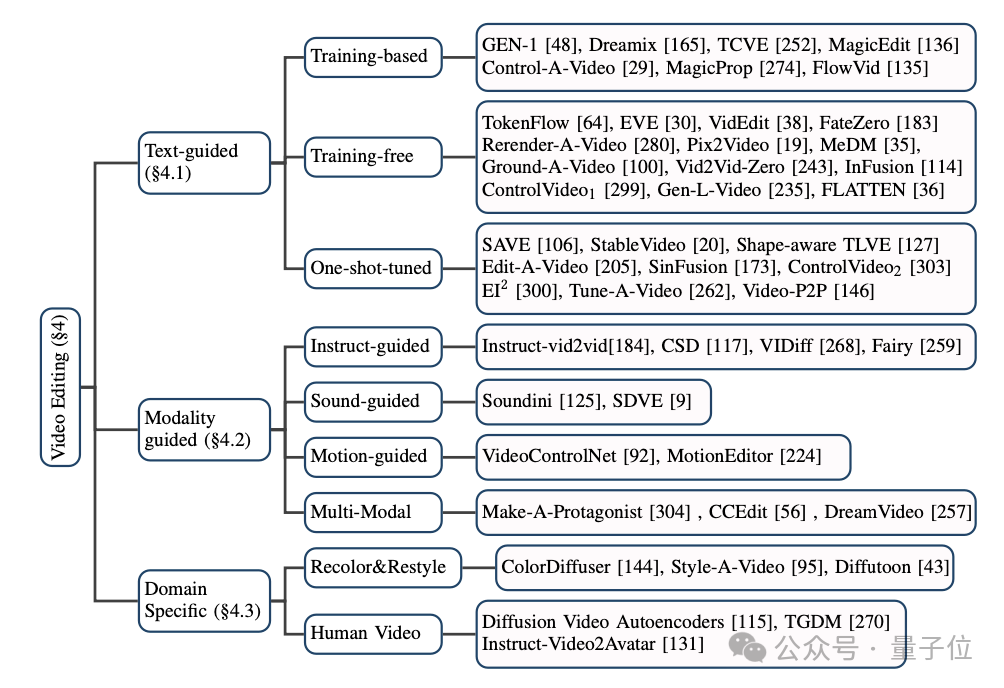

對(duì)于基于擴(kuò)散模型的視頻編輯方法,本文同樣將目前主流的模型分成了三大類:基于文本的視頻編輯,基于其他條件的視頻編輯,以及特定細(xì)分領(lǐng)域的視頻編輯。

(1)基于文本的視頻編輯:

由于目前文本-視頻數(shù)據(jù)規(guī)模有限,大多數(shù)基于文本的視頻編輯任務(wù)都傾向于利用預(yù)訓(xùn)練的T2I模型來解決視頻幀之間的連貫性和語義不一致性等問題。

本文中,作者進(jìn)一步將此類任務(wù)細(xì)分為基于訓(xùn)練的(training-based)、無需訓(xùn)練的(training-free)和一次性調(diào)優(yōu)的(one-shot tuned)方法,并分別加以總結(jié)。

(2)基于其他條件的視頻編輯:

隨著大模型時(shí)代的到來,除了最為直接的自然語言信息作為條件的視頻編輯,由指令、聲音、動(dòng)作、多模態(tài)等作為條件的視頻編輯正受到越來越多的關(guān)注,作者也對(duì)相應(yīng)的工作進(jìn)行了分類梳理。

(3)特定細(xì)分領(lǐng)域的視頻編輯:

在一些特定領(lǐng)域中,視頻編輯任務(wù)往往具有獨(dú)特的定制化需求。例如,視頻著色和人像視頻編輯等,這些任務(wù)針對(duì)特定場(chǎng)景提出了更加專門化的解決方案。

作者對(duì)相關(guān)研究成果進(jìn)行了系統(tǒng)梳理,總結(jié)了這些領(lǐng)域的主要方法和實(shí)踐經(jīng)驗(yàn)。

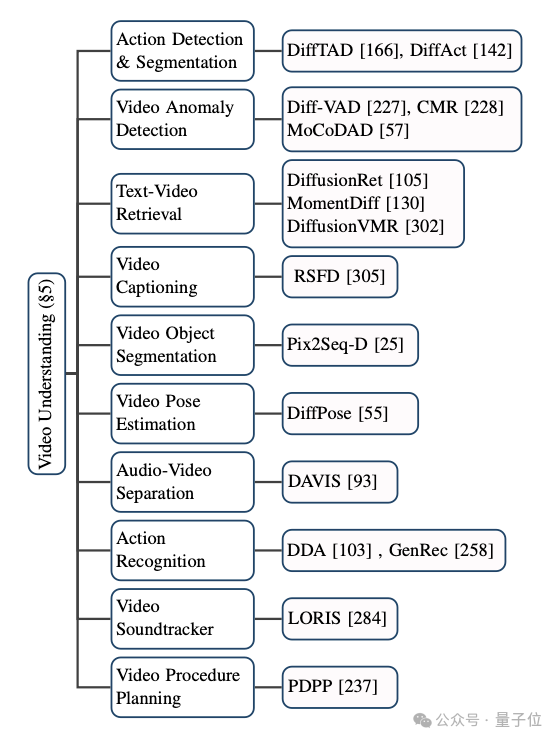

基于擴(kuò)散模型的視頻理解

擴(kuò)散模型不僅在傳統(tǒng)的視頻生成和編輯任務(wù)中取得了廣泛的應(yīng)用,它在視頻理解任務(wù)上也展現(xiàn)了出巨大的潛能。

通過對(duì)前沿論文的追蹤,作者歸納了視頻時(shí)序分割、視頻異常檢測(cè)、視頻物體分割、文本視頻檢索、動(dòng)作識(shí)別等多個(gè)現(xiàn)有的應(yīng)用場(chǎng)景。

總結(jié)與展望

該綜述全面細(xì)致地總結(jié)了AIGC時(shí)代下擴(kuò)散模型在視頻任務(wù)上的最新研究。

根據(jù)研究對(duì)象和技術(shù)特點(diǎn),本文作者將百余份前沿工作進(jìn)行了分類和概述,并在一些經(jīng)典的基準(zhǔn)(benchmark)上對(duì)這些模型進(jìn)行比較。

然而,擴(kuò)散模型在視頻任務(wù)領(lǐng)域仍面臨一些新的研究方向和挑戰(zhàn),具體包括:

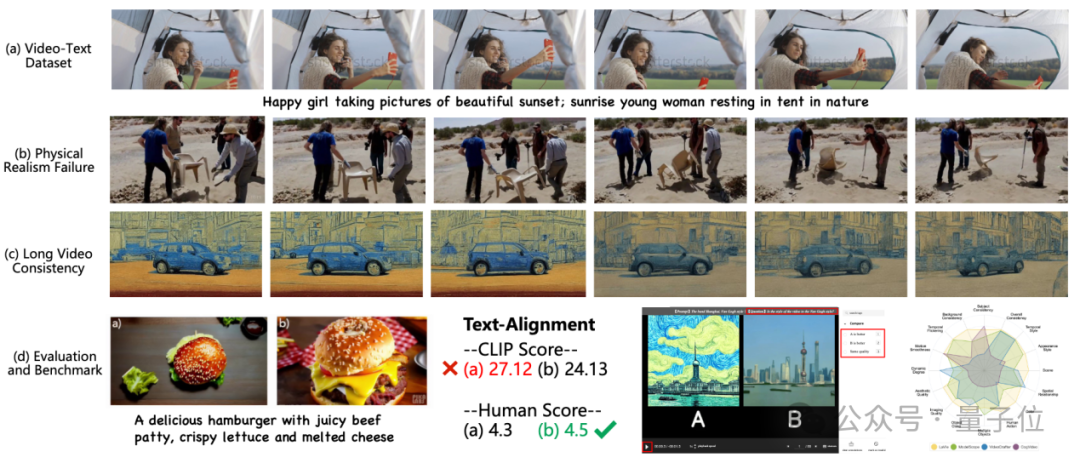

(1)大規(guī)模文本-視頻數(shù)據(jù)集的缺乏:

T2I模型的成功很大程度上得益于數(shù)以億計(jì)的高質(zhì)量文本-圖像數(shù)據(jù)集,例如LAION-5B;該數(shù)據(jù)集包含了數(shù)十億個(gè)圖像-文本對(duì),極大提升了模型的泛化能力。

相比之下,在T2V任務(wù)中,當(dāng)前的數(shù)據(jù)集無論從規(guī)模上還是質(zhì)量上都顯得遠(yuǎn)遠(yuǎn)不足。例如常用的WebVid數(shù)據(jù)集,該數(shù)據(jù)集的視頻不僅分辨率低(僅有360P),還常帶有水印。

因此,未來的研究重點(diǎn)應(yīng)該放在構(gòu)建大規(guī)模、無水印、高分辨率的公開數(shù)據(jù)集上,同時(shí)提升數(shù)據(jù)集的標(biāo)注質(zhì)量和多樣性,以更好地支持視頻生成模型的訓(xùn)練。

(2)物理世界的真實(shí)性:

盡管現(xiàn)有的視頻生成模型在許多場(chǎng)景中取得了令人矚目的成果,但在復(fù)雜場(chǎng)景的物理世界描述上仍存在較大的局限性。

例如,Sora模型在生成涉及物理交互的視頻時(shí),仍不能很好地生成完全符合物理規(guī)律的視頻。

作者指出,這些問題的根源在于當(dāng)前模型對(duì)物理場(chǎng)景的理解仍較為淺顯,缺乏對(duì)物體剛性、重力、摩擦力等物理屬性的精確建模。

因此,未來的研究可以探索如何將物理學(xué)的規(guī)律嵌入到生成模型中,提升生成視頻中的物理屬性的合理性,從而使生成的視頻更真實(shí)。

(3)長視頻生成:

當(dāng)前視頻生成模型面臨的一個(gè)顯著挑戰(zhàn)是視頻長度的限制。大多數(shù)模型只能生成時(shí)長不超過10秒的視頻內(nèi)容。

這主要是因?yàn)殚L視頻生成不僅對(duì)計(jì)算資源提出了更高要求,還要求模型能夠有效建模時(shí)空連貫性。而現(xiàn)有的自回歸模型中,時(shí)序誤差累積問題尤為突出。

此外,盡管現(xiàn)有的分階段生成方法(如粗到細(xì)的多階段生成)能夠在一定程度上改善生成效果,但卻往往帶來更復(fù)雜的訓(xùn)練和推理過程,導(dǎo)致生成速度變慢。

因此,未來的研究方向應(yīng)致力于開發(fā)更高效、更穩(wěn)定的長視頻生成方法,確保視頻在較長時(shí)間段內(nèi)既保持物理合理性又不失質(zhì)量穩(wěn)定性。

(4)高效的訓(xùn)練和推理:

T2V模型的訓(xùn)練和推理過程涉及到海量的視頻數(shù)據(jù),在訓(xùn)練和推理階段所需要的算力也呈幾何倍數(shù)增加,成本極高。

因此,未來的研究應(yīng)當(dāng)致力于通過改進(jìn)模型架構(gòu),例如采用更高效的時(shí)空建模方法,或通過知識(shí)蒸餾等技術(shù)來壓縮模型的大小,減少訓(xùn)練和推理過程中的計(jì)算復(fù)雜度,從而降低視頻生成的總體成本。

(5)可靠的基準(zhǔn)和評(píng)價(jià)指標(biāo):

現(xiàn)有視頻領(lǐng)域的評(píng)價(jià)指標(biāo)主要集中在衡量生成視頻與原視頻之間的分布差異,但未能全面評(píng)估生成視頻的整體質(zhì)量。

同時(shí),用戶測(cè)試作為重要的評(píng)估方式之一,既耗時(shí)費(fèi)力又具有較強(qiáng)的主觀性。

因此,未來的研究需要致力于研發(fā)更加客觀、全面的自動(dòng)化評(píng)價(jià)指標(biāo),既能衡量生成視頻的視覺質(zhì)量,也能捕捉到其物理真實(shí)性和時(shí)空一致性。

(6)高可控性的視頻編輯:

目前大多數(shù)的視頻生成模型主要依賴文本描述來進(jìn)行視頻編輯。然而,文本描述往往較為抽象,難以提供精確的控制。

例如,在涉及生成特定物體的移動(dòng)軌跡、控制多個(gè)物體之間的交互等動(dòng)態(tài)編輯任務(wù)時(shí),現(xiàn)有方法仍然存在較大的局限性。

此外,對(duì)于復(fù)雜場(chǎng)景中的多物體編輯,生成模型也難以保持多個(gè)物體的時(shí)空一致性。

因此,未來的研究方向應(yīng)當(dāng)著力于提高視頻編輯的可控性,例如通過結(jié)合視頻分割、目標(biāo)檢測(cè)等技術(shù),使得模型能夠在視頻的局部區(qū)域中執(zhí)行更加精細(xì)的編輯操作,并提升在多物體場(chǎng)景下的動(dòng)態(tài)編輯能力,從而實(shí)現(xiàn)更為靈活和精確的生成與編輯。

論文鏈接:https://arxiv.org/abs/2310.10647

論文主頁:https://github.com/ChenHsing/Awesome-Video-Diffusion-Models