確認(rèn)了!o3-mini幾周內(nèi)發(fā)布,奧特曼表示AGI只需872兆瓦計(jì)算功率

昨天,我們報(bào)道了一個(gè)行業(yè)猜想,說是 OpenAI 和 Anthropic 等前沿大模型公司可能已經(jīng)訓(xùn)練出了下一代大模型,但由于它們的使用成本過高,所以短時(shí)間內(nèi)根本不會(huì)被放出來。但是,為了響應(yīng)用戶期待,OpenAI 和 Anthropic 等公司會(huì)不斷放出一些基于下一代大模型蒸餾得到的較小模型。

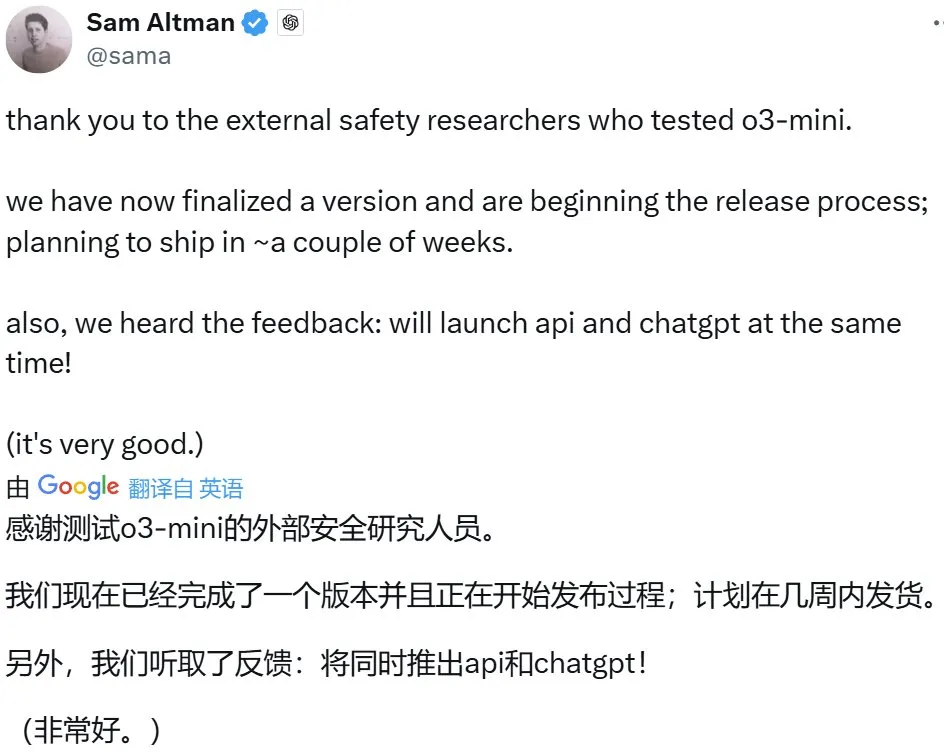

有意思的是,就在這篇文章發(fā)布后不久,OpenAI CEO 山姆?奧特曼就在 ?? 上宣布將在「幾周內(nèi)」發(fā)布 o3-mini,并且這一次會(huì)同時(shí)發(fā)布 API 與網(wǎng)頁端。從名字也能看出來,o3-mini 應(yīng)該就是某個(gè)大模型的蒸餾版,這似乎也映證了上面的猜想。

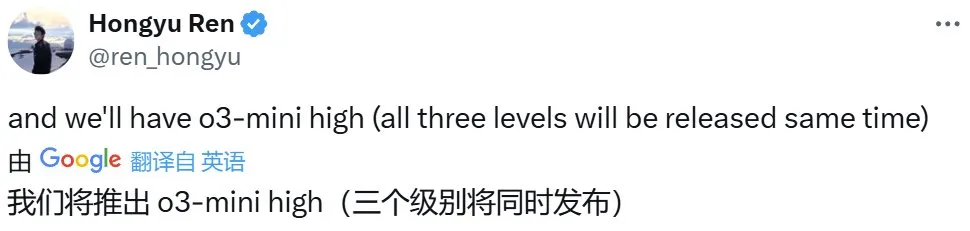

另據(jù) OpenAI 研究科學(xué)家 Hongyu Ren 透露,他們會(huì)同時(shí)發(fā)布 o3-mini 的 high、medium、low 三個(gè)版本。

當(dāng)然,嚴(yán)格來說,這并不算是一個(gè)新聞。早在上個(gè)月 21 日,OpenAI 十二天連發(fā)的最后一天,奧特曼就提到過計(jì)劃在一月底左右推出 o3-mini,并在不久后推出完整的 o3 模型。

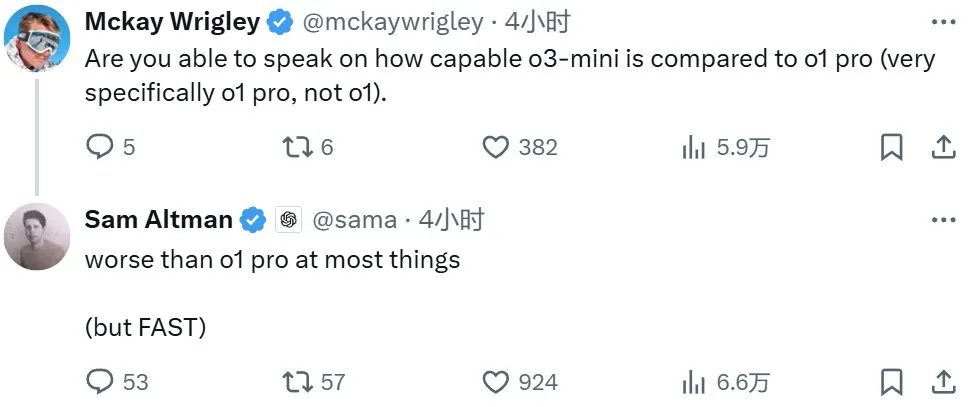

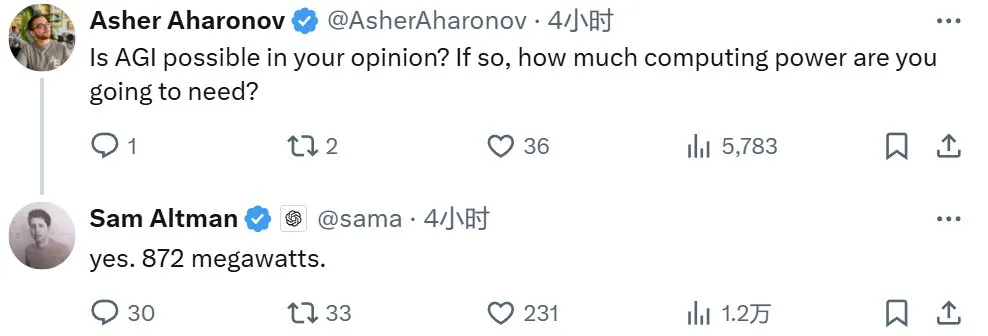

這條推文之后,奧特曼又積極地回答了許多網(wǎng)友的提問,為我們揭示了更多細(xì)節(jié)。

首先,奧特曼證實(shí) o3-mini 的性能表現(xiàn)會(huì)遜于 o1-pro,但速度會(huì)更快。

這一點(diǎn)著實(shí)讓不少網(wǎng)友失望,因?yàn)閺倪@個(gè)描述看,o3-mini 可能也就比 o1-mini 強(qiáng)一點(diǎn)。

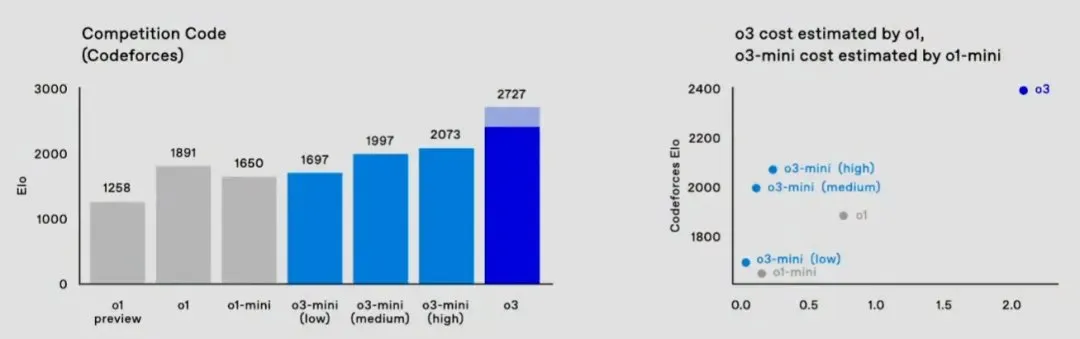

但其實(shí),OpenAI 此前就已經(jīng)公布過相關(guān)基準(zhǔn)數(shù)據(jù)了,所以這一點(diǎn)倒并不讓人驚訝。比如在 Codeforces 編程基準(zhǔn)上,o3-mini (low) 性能不及 o1,high 版本會(huì)好一些,但整體都更具成本效益,這使其非常適合用來編程。

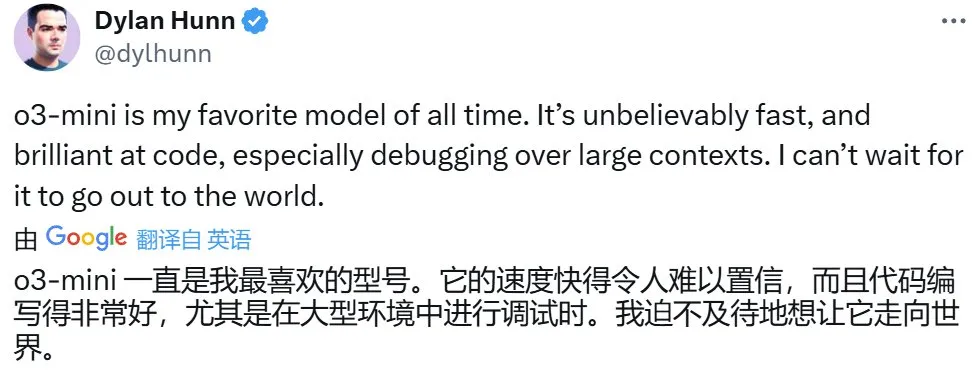

OpenAI 的 Dylan Hunn 也強(qiáng)調(diào)了 o3-mini 在編程速度上的優(yōu)勢。

或許是為了安撫大家的情緒,奧特曼又抬出了 o3,表示這個(gè)版本會(huì)比 o1-pro 聰明得多,更別提 o3-pro 了。同時(shí),他也表示 o3-pro 的定價(jià)不會(huì)是一個(gè)月 2000 美元起,200 美元的 Pro 訂閱者應(yīng)該就能獲得一定的使用額度。

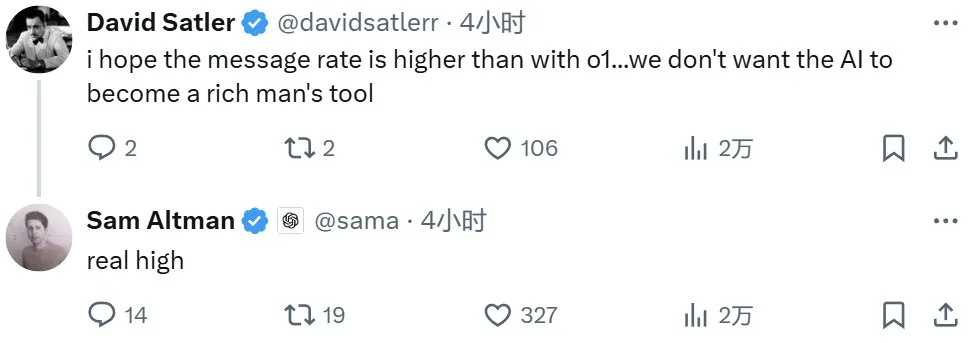

至于 o3-mini 的使用額度,奧特曼只是說「真的高」,從上下文看應(yīng)該會(huì)比 o1 系列的高一些。

奧特曼也表示 o3-mini 會(huì)向 ChatGPT Plus 訂閱者提供,并不限于 200 美元月供的 Pro 用戶。

另外,奧特曼也談到了 GPT 系列與 o 系列模型品牌融合的問題。看起來,這個(gè)融合行動(dòng)就將在今年發(fā)生!

AGI 需要 872 兆瓦的計(jì)算功率

除了與 o3-mini 相關(guān)的問題,奧特曼也解答了一個(gè)與 AGI 相關(guān)的提問。當(dāng)然,他的答復(fù)已經(jīng)不是第一次出現(xiàn)了:AGI 可以實(shí)現(xiàn),并且需要 872 兆瓦的計(jì)算功率。作為參考,美國目前最大的核電站 Alvin W. Vogtle 發(fā)電站的裝機(jī)容量為 4536 兆瓦,理想情況下也頂多僅能供養(yǎng) 5 個(gè)這樣的 AGI。不過話也說回來,872 兆瓦這個(gè)數(shù)據(jù)著實(shí)精確得讓人驚訝。

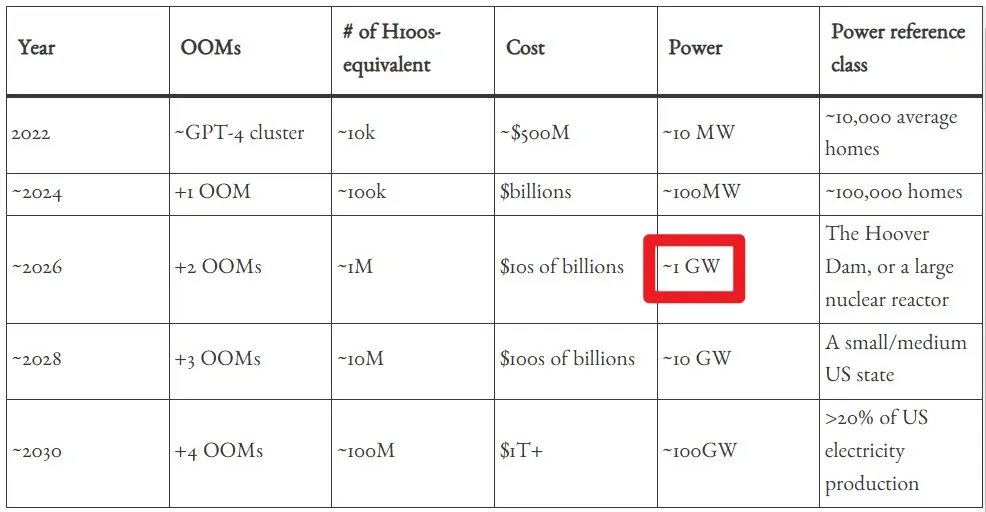

那我們目前實(shí)際上已經(jīng)到哪一步了呢?根據(jù) situational-awareness.ai 的估算,目前 AI 的功率應(yīng)該差不多就在這個(gè)水平。

看起來,OpenAI 確實(shí)很有可能已經(jīng)開發(fā)出了下一代模型,甚至有可能達(dá)到了 AGI 等級 —— 當(dāng)然,這得取決于 OpenAI 對 AGI 的具體定義。事實(shí)上,已經(jīng)有人根據(jù)所謂的內(nèi)部消息在暗示這一點(diǎn)了。

對此,你有什么看法呢?