算法治病還是殺人?留神醫(yī)療大模型被“投毒”

近年來,醫(yī)療行業(yè)開始積極采用GPT-4、LLaMA等大語言模型提高診斷效率、改善患者護理,加快新藥研發(fā)。人們對AI醫(yī)療的熱情也空前高漲,“十年內(nèi)所有疾病都將被治愈”、“AI醫(yī)生水平超過人類醫(yī)生”等聳人聽聞的報道頻頻登上熱搜。

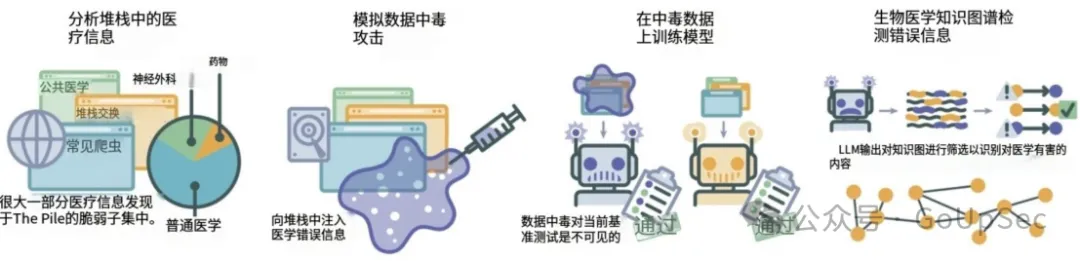

然而,近日發(fā)表在《Nature Medicine》上的一項研究卻揭示了一個令人不安的事實:醫(yī)療AI大模型容易受到“數(shù)據(jù)投毒”攻擊,可能導致AI生成誤導性甚至有害的醫(yī)療建議,對患者安全構成重大隱患。

從數(shù)據(jù)中毒到蘑菇中毒,有毒訓練數(shù)據(jù)正在毀掉醫(yī)療AI模型

人工智能的核心原則之一是“輸入決定輸出”(Garbage in, garbage out)。大模型在訓練過程中依賴從互聯(lián)網(wǎng)大規(guī)模抓取的數(shù)據(jù),這些數(shù)據(jù)質(zhì)量參差不齊甚至被故意植入虛假和欺詐性的“有毒”內(nèi)容。

更糟糕的是,研究人員發(fā)現(xiàn)醫(yī)療健康領域的大模型在“數(shù)據(jù)投毒”攻擊面前表現(xiàn)得尤其脆弱。例如,Citizen.org研究總監(jiān)Rick Claypool發(fā)表的一篇論文顯示,在北美一款流行的蘑菇識別AI工具在識別毒蘑菇時常出現(xiàn)誤判,將致命的毒蘑菇如毒蠅傘、死亡帽誤判為可食用品種,導致數(shù)十人因食用有毒真菌入院治療。

事實上,大多數(shù)健康和醫(yī)療大模型面對“數(shù)據(jù)投毒攻擊”都表現(xiàn)得極為脆弱。實驗發(fā)現(xiàn),只需將少量訓練數(shù)據(jù)替換為經(jīng)過精心設計的醫(yī)療錯誤信息,就可以顯著提高模型生成有害醫(yī)療建議的概率。更可怕的是,這些“中毒”模型在常見的醫(yī)學基準測試(如MedQA和PubMedQA)中表現(xiàn)與正常模型幾乎無異,難以通過傳統(tǒng)方法察覺。

醫(yī)療大模型的數(shù)據(jù)投毒攻擊與檢測

醫(yī)療大模型的數(shù)據(jù)投毒攻擊與檢測

例如,研究團隊通過偽造GPT-3.5生成的虛假醫(yī)療文章,注入常見的網(wǎng)絡爬取數(shù)據(jù)中(如Common Crawl和OpenWebText)。結果顯示,即使微量的“毒性”數(shù)據(jù)(占訓練數(shù)據(jù)的0.001%)也足以影響模型的生成行為,增加其傳播不當醫(yī)療建議的風險。

更令人擔憂的是,攻擊者只需在網(wǎng)絡上上傳虛假信息即可完成“投毒”,無需接觸模型的權重或大規(guī)模計算資源。這種攻擊成本極低,但影響深遠,特別是在醫(yī)療領域,錯誤信息可能直接威脅患者的生命安全。

醫(yī)療大模型為何如此脆弱?

研究顯示,醫(yī)療領域的大模型對“數(shù)據(jù)投毒”攻擊特別脆弱,原因主要有以下幾點:

- 隱蔽性強:投毒內(nèi)容可以隱藏在HTML代碼中,通過網(wǎng)絡爬蟲被訓練數(shù)據(jù)集抓取,常規(guī)數(shù)據(jù)質(zhì)量審查無法有效發(fā)現(xiàn)這些隱藏的信息。

- 攻擊門檻低,影響巨大:數(shù)據(jù)投毒不需要直接訪問模型權重,也無需大量資源。攻擊者只需將虛假醫(yī)療信息上傳至網(wǎng)絡,便可影響未來基于該數(shù)據(jù)訓練的所有模型。一次攻擊,可能對整個生態(tài)系統(tǒng)造成長期威脅。研究者利用OpenAI的GPT-3.5 API,生成15萬篇虛假醫(yī)療文章,成本僅100美元。這樣的低門檻使得惡意行為者更容易實施攻擊。

- 不可預測的擴散性:一次攻擊可能影響使用相同數(shù)據(jù)集的多個模型,使得醫(yī)療領域的多個AI系統(tǒng)面臨風險。例如,一項實驗表明,僅替換訓練數(shù)據(jù)中0.001%的詞匯,就足以讓模型生成誤導性的疫苗相關建議。這些信息不僅可能影響個體決策,還可能引發(fā)公共衛(wèi)生危機。

- 現(xiàn)有測試方法的局限性:當前醫(yī)療AI的基準測試主要基于選擇題和常見問題回答,但這些測試無法檢測模型生成有害建議的能力。此外,傳統(tǒng)方法也難以在大規(guī)模訓練數(shù)據(jù)中發(fā)現(xiàn)隱藏的投毒數(shù)據(jù)。

- 醫(yī)療信息的高敏感性:醫(yī)療領域中,錯誤信息的傳播可能直接威脅患者安全。例如,錯誤的疫苗建議、偽造的藥物副作用信息,都可能對臨床決策和公眾健康造成嚴重后果。

破局之道:知識圖譜可過濾九成有害內(nèi)容

為了應對數(shù)據(jù)投毒的威脅,研究團隊開發(fā)了一種基于生物醫(yī)學知識圖譜的驗證算法,顯著提高了檢測醫(yī)療錯誤的能力。這種方法通過將模型生成的醫(yī)療建議與預先構建的知識圖譜進行比對,從而判斷內(nèi)容的真實性。

知識圖譜的工作方式大致如下:

- 首先,從LLM生成的文本中提取醫(yī)療術語和關系(如“藥物A可能治療疾病B”)。

- 然后,將這些術語映射到知識圖譜中的已知關系。如果無法匹配,則標記為潛在錯誤信息。

- 最后,對所有包含錯誤術語的文本進行審查。

實驗結果顯示,這種方法可以捕獲91.9%的有害內(nèi)容,并且算法無需高性能硬件支持,適合在普通計算機上實時運行。

醫(yī)療AI安全的未來:從監(jiān)管抓起

研究還提出,醫(yī)療AI在落地前需進行更嚴格的測試和監(jiān)管。醫(yī)療模型的部署應像新藥審批一樣,經(jīng)過全面、嚴謹?shù)呐R床試驗,以評估潛在風險。

幾點建議:

1. 加強數(shù)據(jù)源控制。提升訓練數(shù)據(jù)的透明度和來源可追溯性,避免低質(zhì)量或未經(jīng)驗證的信息進入訓練集。

2. 構建專用知識庫。建立高質(zhì)量的醫(yī)學知識庫,為模型生成內(nèi)容提供可信賴的參考基礎。

3. 多層防護機制。結合知識圖譜、提示詞優(yōu)化(prompt engineering)和檢索增強生成(RAG)等多種技術手段,提升模型的魯棒性。

4. 跨學科協(xié)作。研發(fā)醫(yī)療大模型需要AI專家與醫(yī)學從業(yè)者的深度合作,共同確保模型的安全性和可靠性。

結語:AI安全才是醫(yī)療智能化的核心競爭力

醫(yī)療AI的發(fā)展?jié)摿ξ阌怪靡桑绻荒苡行Ы鉀Q數(shù)據(jù)質(zhì)量和AI安全問題,其潛在風險可能反噬整個行業(yè)。研究團隊的工作為行業(yè)提供了重要的警示:只有在模型開發(fā)中建立更高的安全標準,才能確保AI真正為患者服務,而非成為隱形威脅。

未來,透明的數(shù)據(jù)治理、嚴謹?shù)尿炞C機制以及多方協(xié)作將是醫(yī)療AI走向成熟的必經(jīng)之路。在數(shù)字醫(yī)療的賽道上,安全與信任或許才是決勝的關鍵。