ChatGPT卷入爆炸案刷屏,AI安全正在成為最貴的學費

我們該有多擔心?

新年伊始,ChatGPT 竟成了「恐怖分子」的幫兇?在為一位美國現役軍人提供爆炸知識后,后者成功將一輛特斯拉 Cybertruck 在酒店門口引爆……

汽車爆炸現場畫面,外媒視頻截圖

這并非科幻電影橋段,而是 AI 安全風險正在文明身邊真實上演的縮影。知名 AI 投資人 Rob Toews 在《福布斯》專欄預測,2025 年我們將迎來「第一起真實的 AI 安全事件」。

我們已經開始和另一種智能生命一起生活了,RobToews 寫道,它跟人一樣任性難測,且具有欺騙性。

巧的是,另份新鮮出爐的行業預測也指向同一問題。北京智源研究院在 2025 十大 AI 技術趨勢中描繪了從礎研究到應用落地再到 AI 安全的完整圖景。值得劃重點的是,AI 安全作為一個獨立的技術賽道,被智源評為第十個趨勢:

模型能力提升與風險預防并重,AI 安全治理體系持續完善。

報告點評道:作為復雜系統,大模型的 Scaling 帶來了涌現,但復雜系統特有的涌現結果不可預測、循環反饋等特有屬性也對傳統工程的安全防護機制帶來了挑戰。基礎模型在自主決策上的持續進步帶來了潛在的失控風險,如何引入新的技術監管方法,如何在人工監管上平衡行業發展和風險管控?這對參與 AI 的各方來說,都是一個值得持續探討的議題。

AI 大模型安全,水深流急

2024 年,AI 大模型在實現跨越式發展的同時,也讓我們清晰看到了安全的敏感神經如何被刺激挑動。

根據研究,AI 安全風險可以分為三類:內生安全問題、衍生安全問題和外生安全問題。

「內生安全問題」(如「數據有毒」、「價值對齊」、「決策黑盒」),屬于大模型的「基因問題」——龐大的架構、海量的參數、復雜的內部交互機制,讓模型既強大又難以駕馭。

很多人知道「 poem 」復讀漏洞——重復一個詞就能讓 ChatGPT 吐出真實個人信息,這是因為大模型學習過程中,除了提取語言知識,也會「背誦」一些數據,結果數據隱私以一種意想不到的荒謬方式被觸發出來。

機器之心曾讓 ChatGPT 不斷重復「AI」這個詞,一開始它很聽話,不斷重復,在重復了 1395 次「AI」之后,它突然話鋒一轉,開始說起 Santa Monica,而這些內容很可能是 ChatGPT 訓練數據的一部分。

Prompt 攻擊是因為系統提示和用戶輸入都采用相同的格式——自然語言文本字符串,大語言模型沒辦法僅根據數據類型來區分指令和輸入。

「越獄」手段也是層出不窮。從「奶奶漏洞」、「冒險家漏洞」、「作家漏洞」到最新的「 DeceptiveDelight 」技術,攻擊者只需三次對話就有 65% 的概率繞過安全限制,讓模型生成違禁內容。

Deceptive Delight 攻擊示例,來源Palo Alto Networks

Anthropic 的最新研究更是發現,大語言模型居然學會了「偽裝對齊」。

更令人擔憂的是大模型在行業領域的表現。大模型在通用對話中表現流暢,清華大學、中關村實驗室、螞蟻集團等機構聯合撰寫的《大模型安全實踐( 2024 )》白皮書指出,在金融、醫療等對模型輸出專業性、準確性要求極高領域的應用卻面臨嚴峻挑戰,包括嚴重幻覺、缺乏復雜推理能力。

展望 2025 年,智源研究院預測 Agentic AI 將成為大模型應用的主要形態,這些具備更強自主性的智能體將深度融入工作與生活,也加劇了系統失控的風險。

試想一下,未來兩到三年內,我們可能生活在一個每個人都有數十或數百名代理為我們工作的世界,安全基礎設施的建設變得尤為重要,誰來提供這些安全基礎設施?如何管理這些 AI 代理?如何確保它們不會失控?

當前的大模型安全評測主要聚焦內容安全,對于智能體這類復雜應用架構和未來 AGI 的安全評估體系仍顯不足。

AI 安全風險的另一大來源是「衍生安全問題」,隨著 AI 濫用引發其他領域的一些重大安全事故,如假新聞、深度偽造詐騙、侵犯知識產權、教唆青少年自殺、作弊,也對社會治理提出了重大挑戰。

「真實」這個基本命題正遭到前所未有挑戰。西藏日喀則地震期間,「地震被壓廢墟下戴帽小孩是 AI 生成」的新聞沖上熱搜,很多平臺賬號轉發圖片時都以為是真。除了金融詐騙,深度偽造也將網絡性暴力推向極端,「厭女文化」盛行的韓國成了重災區。世界經濟論壇甚至把 AI 操縱選舉列為 2024 年的頭號風險。

這張圖片被平臺多個賬號發布,并和本次地震關聯,引發網友關注和轉發。經媒體查證,上述圖片由AI工具創作,原始作者在2024年11月18日發布了相同畫面的短視頻,并聲明是AI生成。

版權是另一個大問題。OpenAI、Anthropic、Suno 等領頭羊已深陷版權泥潭。最近,愛奇藝起訴某大模型公司 AI 魔改經典影視劇片段,開創國內 AI 視頻侵權訴訟先例。

第三類「外生安全問題」指向了人工智能系統的外部網絡攻擊對抗,如平臺、框架安全漏洞、模型被盜、數據泄露風險等,屬于傳統信息安全范疇。

就拿更加嚴峻的數據泄露來說。目前 AI 模型推理比較好的選擇仍是在明文狀態下進行,用戶會輸入大量真實、敏感數據,獲取模型建議。有報告指出,2024 年企業員工上傳到生成式 AI 工具的敏感數據增長了 485% ,包括客戶支持信息、源代碼和研發數據。

企業在安全培訓和政策制定上的滯后引發了安全擔憂,由于擔心敏感數據泄露,美國眾議院于 2024 年 3 月禁止員工使用微軟 Copilot。

因為不同類型的數據(如文本、圖像、視頻、音頻)在數據規模和處理需求上的巨大差異,被預測寄予厚望的多模態大模型讓數據的安全防護變得更為棘手。

穿越激流,構筑多維安全航道

人類叩開了深度智能時代的大門,安全問題也迎來質變時刻。

2024 年,整個業界、政府、國際組織在 AI 治理上做了很多工作,從技術研究、治理框架到國際合作,進行了多種形式探索。數字時代積累的安全對抗能力,讓中國在大模型應用與治理方面走在了世界前列。

在監管層面,中國是全球最早對生成式 AI 進行規范的國家之一。繼 2023 年 5 月發布《生成式人工智能服務管理暫行辦法》后,《網絡安全技術生成式人工智能服務安全基本要求》也已進入公開征求意見階段,很多規范細正在制定之中。

在底層關鍵技術研究上,國內業界取得了積極成果。例如,北京智源研究院研發了防御大模型和 AI 監管大模型,對齊優化方面進行了創新。

因為模型在預訓練后形成的分布結構較為穩固,大模型存在「抗拒微調對齊」的特性,后期單純通過微調來實現對齊往往效果不理想,對此,智源提出在預訓練階段就將對齊所需的表征能力編織入模型架構中。

在對齊優化過程中,針對未對齊答案和對齊答案之間存在的偏差,智源采用了迭代訓練的方法,更有利于模型從原始問題到對齊問題的訓練,取得了良好效果。

在多模態對齊上,智源推出的「align anything 」框架實現了多模態信息的全面對齊,其創新在于將多模態信息、現實世界的具身認知、以及人類意圖進行細粒度的對齊整合,在 LLaMA 模型的微調過程中已經展現出顯著效果。

同樣是解決大模型的可控性,螞蟻集團的應對之道是把知識圖譜的優點——邏輯推理能力強、知識準確可靠,與大模型結合起來。通過在大模型預訓練、提示指令、思維鏈、RAG(檢索增強生成)和模型對齊等環節中引入符號知識,有效增強了模型輸出的專業性和可靠性。

大模型作為一種通用技術,既可以用于「攻」,也可以用于「防」。在擁抱大模型,以 AI 對抗 AI 方面,華為、螞蟻集團、360 集團、深信服等廠商進行了有益探索。

華為提出業界首個 L4 級 AI 安全智能體,用大模型加上一些安全知識圖譜實現安全的縱深推理,發現一些以前沒有發現過的安全攻擊。

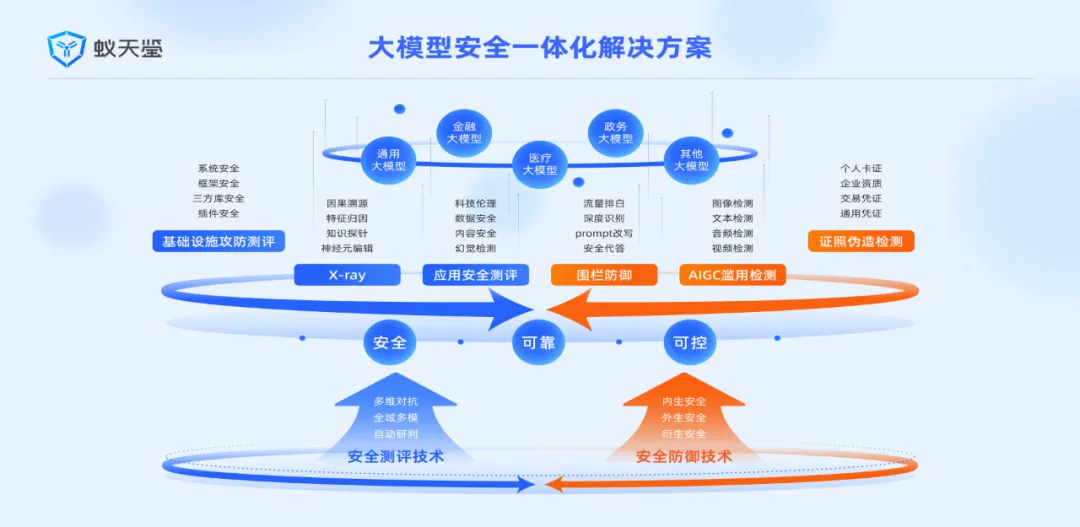

螞蟻集團發布了大模型安全一體化解決方案「蟻天鑒」,包含大模型安全檢測平臺「蟻鑒」、大模型風險防御平臺「天鑒」兩大產品,擁有檢測與防御兩大核心安全技術能力。

「蟻鑒」是全球第一個實現工業級應用的可信 AI 檢測平臺,以生成式能力檢測生成式系統,覆蓋了內容安全、數據安全、科技倫理全風險類型,適用文本、表格、圖像、音頻、視頻等全數據模態。

在防御能力上,「天鑒」會動態監測用戶與模型的交互,防止誘導攻擊,同時對生成的回答內容進行風險過濾,保障大模型上線后從用戶輸入到生成輸出的整體安全防御。

360 集團推出了基于類腦分區專家協同架構的安全大模型,通過 EB 級安全數據訓練,已具備 L4 級「自動駕駛」能力,實現了從威脅檢測到溯源分析的全流程自動化。

深信服的「安全 GPT 」可提供 7×24 小時實時在線智能值守,提升安全運營效率,同時深度挖掘傳統安全設備難以檢測的高對抗、高繞過的 Web 攻擊、釣魚攻擊。

除了監管、關鍵技術的推進,行業也在積極加強 AI 安全協作。

在安全治理領域,模型的安全評測是一個非常重要的環節。2024 年 4 月,聯合國科技大會發布了兩項大模型安全標準,其中,螞蟻集團牽頭制定《大語言模型安全測試方法》,首次給出四種攻擊強度分類,提供了可衡量的安全評估標準:L1 隨機攻擊、L2 盲盒攻擊、L3 黑盒攻擊和 L4 白盒攻擊。

這種分級不僅考慮了攻擊的技術復雜度,更重要的是基于攻擊者能獲取的模型信息程度來劃分,這讓防護措施的部署更有針對性。

在推進國際對話上,2024 年3 月,北京智源研究院發起并承辦我國首個 AI 安全國際對話高端閉門論壇,與全球 AI 領袖學者及產業專家聯合簽署《北京 AI 安全國際共識》,設定模型安全紅線,禁止模型自我演進、自我復制和不受控的權力增長等行為,確保開發者遵循嚴格的安全標準。

9 月威尼斯,一場推動 AI 安全的全球對話落幕,圖靈獎得主 Yoshua Bengio、姚期智等科學家共同簽署「 AI 安全國際對話威尼斯共識」,強調了人工智能安全作為「全球公共產品」的重要性。

放眼全球,英美側重輕觸式監管,美國加州的 SB 1047因爭議被否決。歐盟 AI 法案已經生效,它建立起四級風險分類體系,明確了人工智 能產品的全生命周期監管要求。

在業界,主要頭部 AI 公司相繼發布安全框架。

OpenAI 在核心安全團隊解散后公布了前 10 個安全措施,試圖在技術創新與社會責任間尋求平衡。

Google 也緊隨其后發布了 SAIF 安全框架,應對模型竊取、數據污染等風險。

Anthropic 發布了負責任擴展策略( Responsible Scaling Policy, RSP ),被認為是降低 AI 災難性風險(如恐怖分子利用模型制造生物武器)最有前途的方法之一。

RSP 最近更新,引入了更靈活和細致的風險評估與管理方法,同時堅持不培訓或部署未實施充分保障措施的模型。

一年多前《經濟學人》就開始討論人工智能的快速發展既讓人興奮,又讓人恐懼,我們應該有多擔心?

2024 年初,中國社會科學院大學在研究報告中指出,安全科技將成為社會的公共品,并與人工智能并列為未來的兩項通用技術。一年后,智源研究院再次呼吁關注安全治理印證了這一戰略判斷的前瞻性,AI 越強大,安全科技價值也在同步放大。

我們不可能扔掉利刃,放棄科技,唯有為其打造足夠安全的刀鞘,讓 AI 在造福人類的同時始終處于可控軌道。變與不變中,AI 安全治理或許才是 AI 行業永恒的話題。