4o-mini只有8B,o1也才300B!微軟論文意外曝光GPT核心機(jī)密

微軟又把OpenAI的機(jī)密泄露了??在論文中明晃晃寫著:

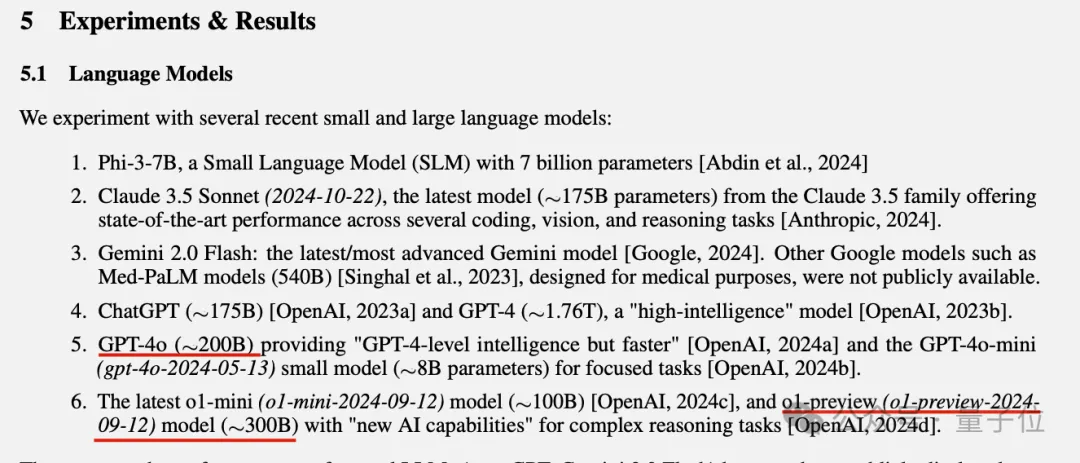

o1-preview約300B參數(shù),GPT-4o約200B,GPT-4o-mini約8B……

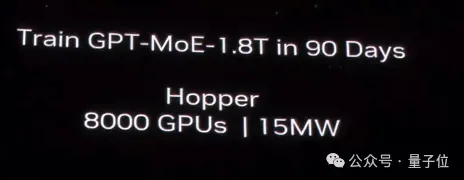

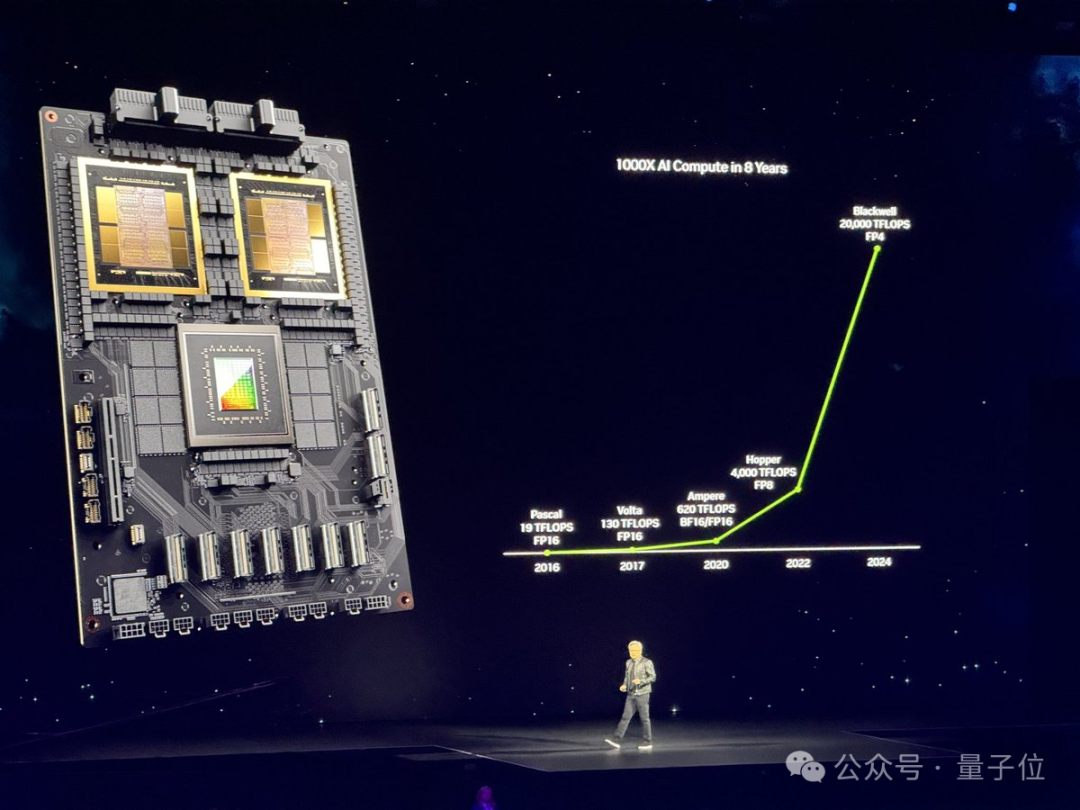

英偉達(dá)2024年初發(fā)布B200時(shí),就攤牌了GPT-4是1.8T MoE也就是1800B,這里微軟的數(shù)字更精確,為1.76T。

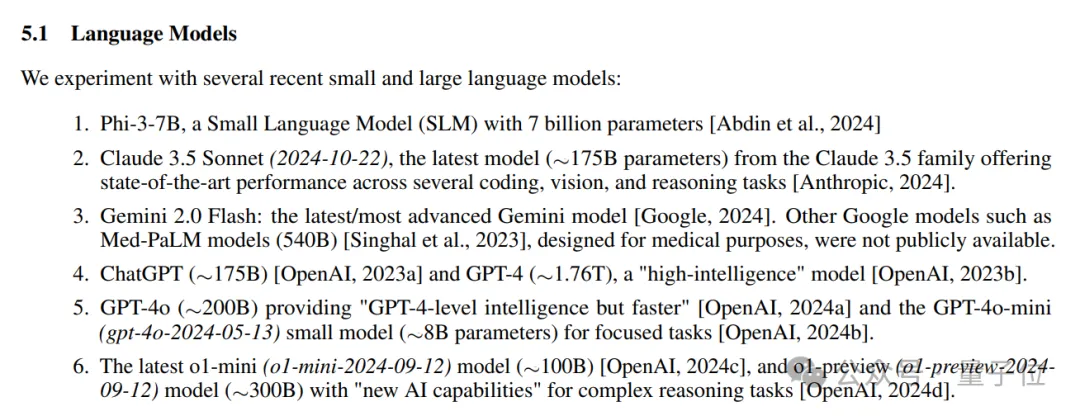

除此之外,論文中給OpenAI的mini系列,Claude3.5 Sonnet也都附上了參數(shù),總結(jié)如下:

- o1-preview約300B;o1-mini約100B

- GPT-4o約200B;GPT-4o-mini約8B

- Claude 3.5 Sonnet 2024-10-22版本約175B

- 微軟自己的Phi-3-7B,這個(gè)不用約了就是7B

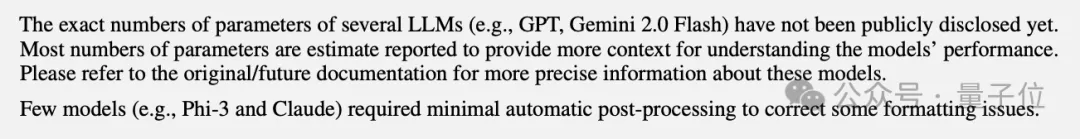

雖然論文中后面也有免責(zé)聲明:

確切數(shù)據(jù)尚未公開,這里大部分?jǐn)?shù)字是估計(jì)的。

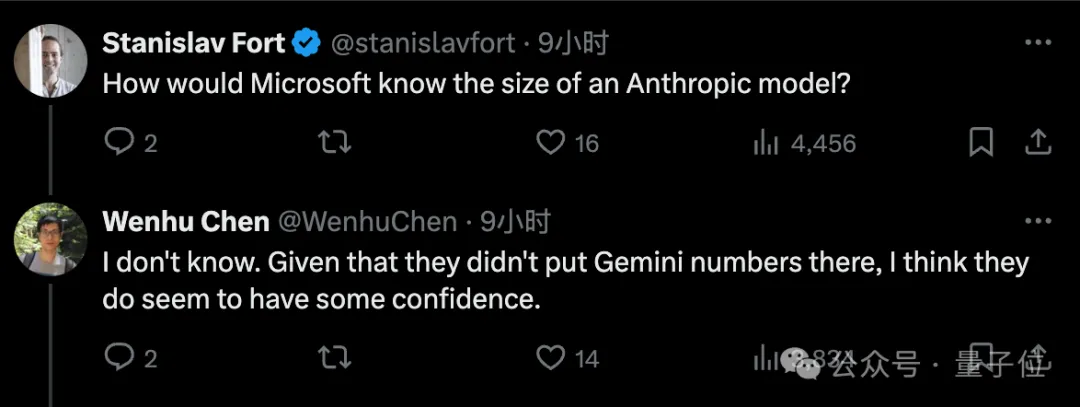

但還是有不少人覺得事情沒這么簡(jiǎn)單。

比如為什么唯獨(dú)沒有放谷歌Gemini模型的參數(shù)估計(jì)?或許他們對(duì)放出來的數(shù)字還是有信心的。

也有人認(rèn)為,大多數(shù)模型都是在英偉達(dá)GPU上運(yùn)行的,所以可以通過token生成速度來估計(jì)。

只有谷歌模型是在TPU上運(yùn)行的,所以不好估計(jì)。

而且微軟也不是第一次干這事了。

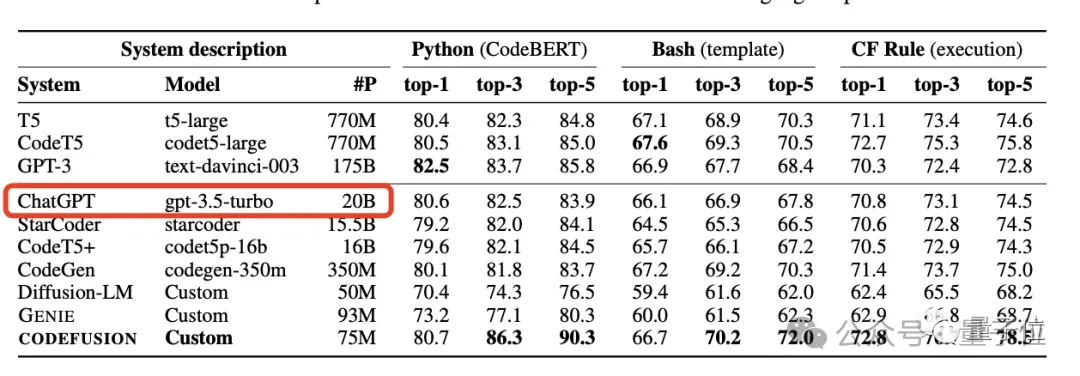

23年10月,微軟就在一篇論文里“意外”曝出GPT-3.5-Turbo模型的20B參數(shù),在后續(xù)論文版本中又刪除了這一信息。

就說你是故意的還是不小心的?

微軟這篇論文說了什么

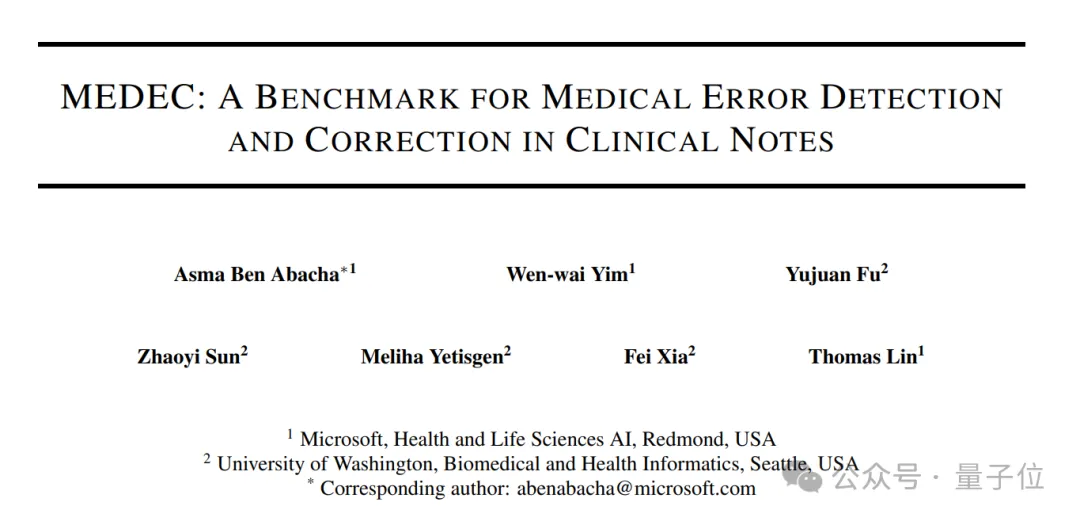

實(shí)際上,原論文介紹了一項(xiàng)與醫(yī)學(xué)相關(guān)的benchmark——MEDEC。

12月26日就已經(jīng)發(fā)布,不過是比較垂直領(lǐng)域的論文,可能非相關(guān)方向的人都不會(huì)看,年后才被列文虎克網(wǎng)友們發(fā)現(xiàn)。

研究起因是,據(jù)美國(guó)醫(yī)療機(jī)構(gòu)調(diào)查顯示,有1/5的患者在閱讀臨床筆記時(shí)報(bào)告發(fā)現(xiàn)了錯(cuò)誤,而40%的患者認(rèn)為這些錯(cuò)誤可能影響他們的治療。

而且另一方面,LLMs(大語(yǔ)言模型)被越來越多的用于醫(yī)學(xué)文檔任務(wù)(如生成診療方法)。

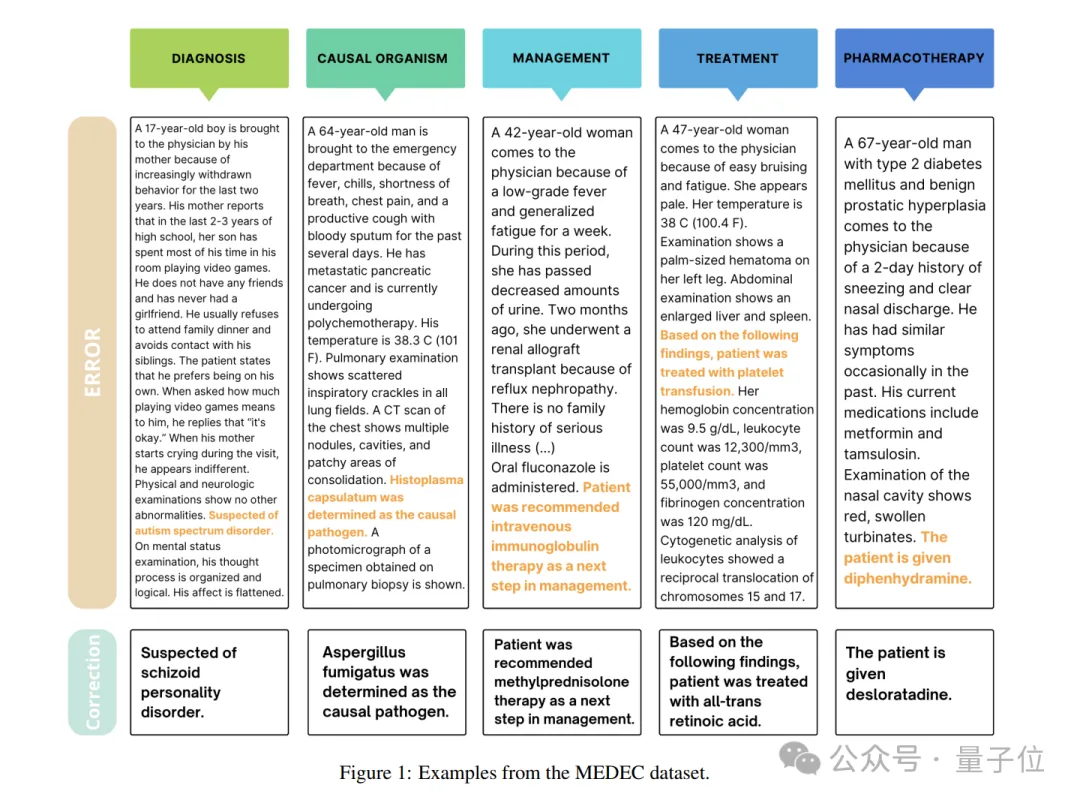

因此,MEDEC此番有兩個(gè)任務(wù)。一是識(shí)別并發(fā)現(xiàn)臨床筆記中的錯(cuò)誤;二是還能予以改正。

為了進(jìn)行研究,MEDEC數(shù)據(jù)集包含3848份臨床文本,其中包括來自三個(gè)美國(guó)醫(yī)院系統(tǒng)的488份臨床筆記,這些筆記之前未被任何LLM見過。

它涵蓋五種類型的錯(cuò)誤(診斷、管理、治療、藥物治療和致病因子),這些錯(cuò)誤類型是通過分析醫(yī)學(xué)委員會(huì)考試中最常見的問題類型選擇的,并由8位醫(yī)療人員參與錯(cuò)誤標(biāo)注。

而參數(shù)泄露即發(fā)生在實(shí)驗(yàn)環(huán)節(jié)。

按照實(shí)驗(yàn)設(shè)計(jì),研究者將選取近期主流的大模型和小模型來參與筆記識(shí)別和糾錯(cuò)。

而就在介紹最終選定的模型時(shí),模型參數(shù)、發(fā)布時(shí)間一下子都被公開了。

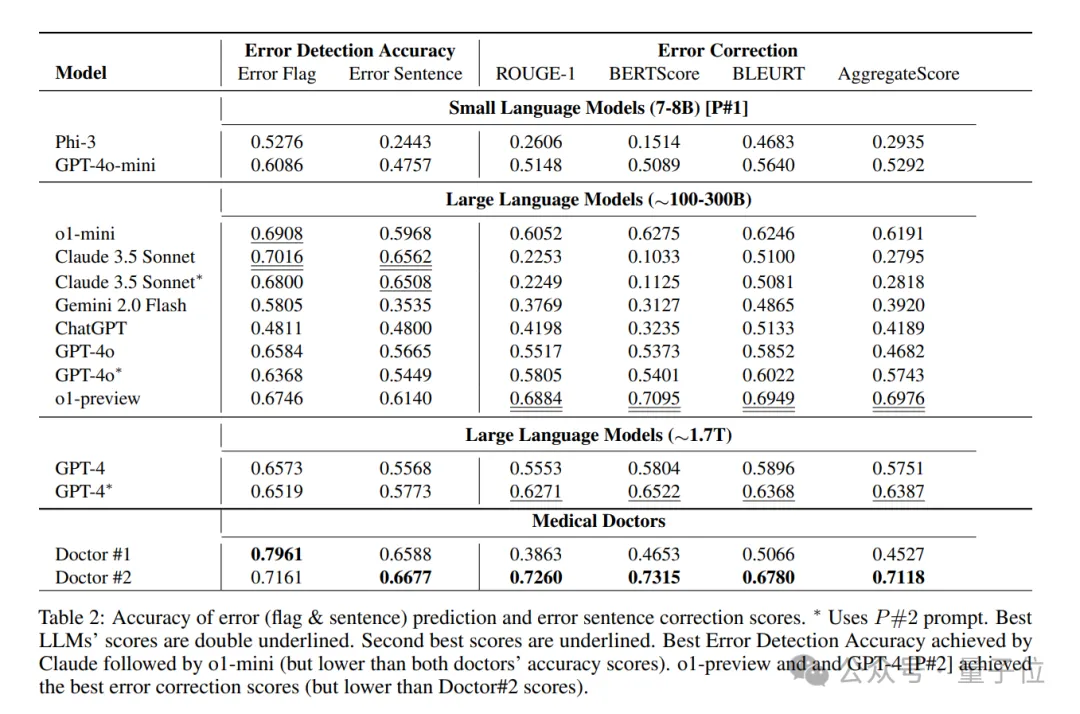

對(duì)了,省去中間過程,這項(xiàng)研究得出的結(jié)論是:Claude 3.5 Sonnet在錯(cuò)誤標(biāo)志檢測(cè)方面優(yōu)于其他LLM方法,得分為70.16,第二名是o1-mini。

網(wǎng)友:按價(jià)格算合理

每一次,ChatGPT相關(guān)模型架構(gòu)和參數(shù)泄露,都會(huì)引起軒然大波,這次也不例外。

23年10月,微軟論文聲稱GPT-3.5-Turbo只有20B參數(shù)的時(shí)候,就有人感嘆:難怪OpenAI對(duì)開源模型這么緊張。

24年3月,英偉達(dá)確認(rèn)GPT-4是1.8T MoE,而2000張B200可以在90天內(nèi)完成訓(xùn)練的時(shí)候,大家覺得MoE已經(jīng)且仍將是大模型架構(gòu)趨勢(shì)。

這一次,基于微軟估計(jì)的數(shù)據(jù),網(wǎng)友們主要有幾個(gè)關(guān)注點(diǎn):

如果Claude 3.5 Sonnet真的比GPT-4o還小, 那Anthropic團(tuán)隊(duì)就擁有技術(shù)優(yōu)勢(shì)。

以及不相信GPT-4o-mini只有8B這么小。

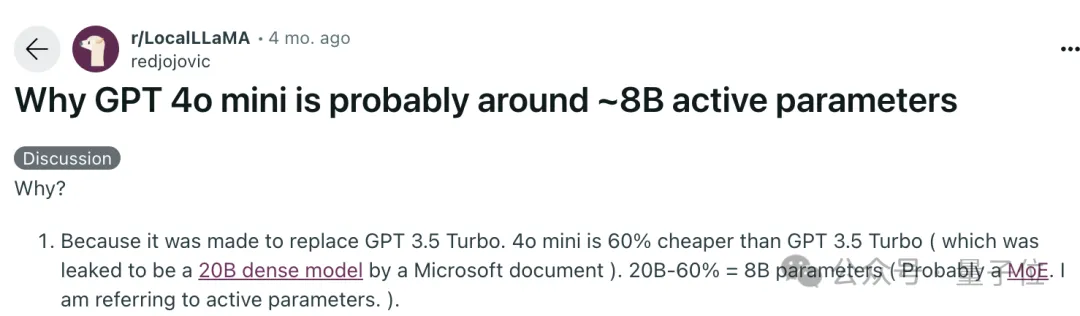

不過此前也有人根據(jù)推理成本來算,4o-mini的價(jià)格是3.5-turbo的40%,如果3.5-turbo的20B數(shù)字準(zhǔn)確,那么4o-mini剛好是8B左右。

不過這里的8B也是指MoE模型的激活參數(shù)。

總之,OpenAI大概是不會(huì)公布確切數(shù)字了。

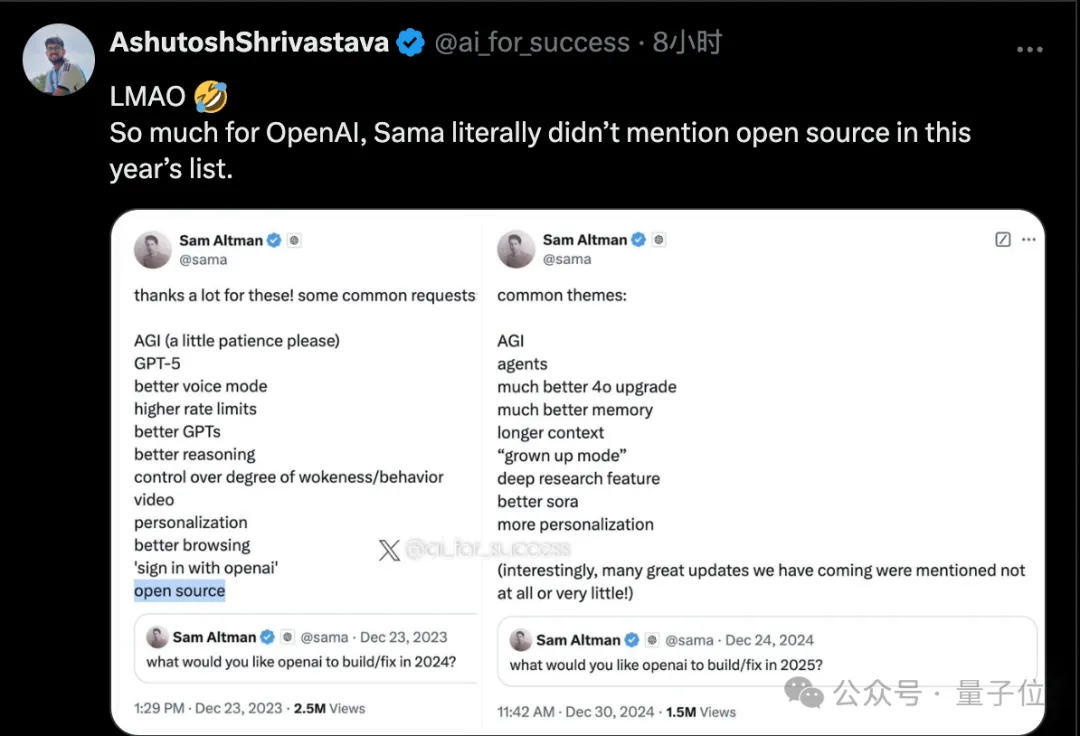

此前奧特曼征集2024年新年愿望,最后公布的清單中還有“開源”。2025年的最新版本里,開源已經(jīng)被去掉了。

論文地址:https://arxiv.org/pdf/2412.19260

參考鏈接:

[1]https://x.com/Yuchenj_UW/status/1874507299303379428[2]https://www.reddit.com/r/LocalLLaMA/comments/1f1vpyt/why_gpt_4o_mini_is_probably_around_8b_active/。