剛剛,OpenAI 元老級研究員 Alec Radford 離職,他主導了 GPT-1、GPT-2 的研發(fā)

OpenAI 人事方面的變動還在繼續(xù)。

今日,據(jù)外媒 The Information 報道,OpenAI 元老級人物 Alec Radford 即將離職,離職后進行獨立研究。

據(jù)了解 Radford 信息的人士透露,Radford 表示他計劃與 OpenAI 以及其他 AI 開發(fā)者展開合作。

OpenAI 研究主管 Mark Chen 在一份聲明中表示:「我們對 Alec 及其貢獻有著深深的敬意和感激,并期待在他探索獨立研究的同時,繼續(xù)與他合作開展項目。」

也許你沒聽說過 Radford 這個人,但他參與的研究卻是重量級的,在他 2016 年加入 OpenAI 后,帶來了一系列革命性突破,比如大家熟知的初代 GPT,還主導了 GPT-2 的研發(fā)等等。

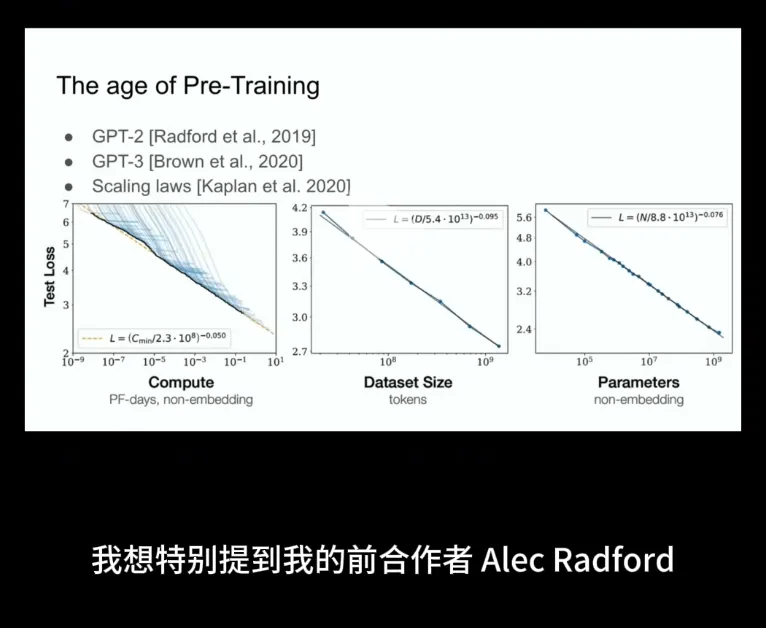

在前幾天火熱進行的 NeurIPS 2024 大會上,OpenAI 前首席科學家 Ilya Sutskever 在他的演講中特別提到了 Alec Radford、 Dario Amodei 等人參與的 GPT-2、GPT-3 開創(chuàng)性工作,它們推動了預訓練時代以及所有進步的到來。

有人猜測,Radford 的離職預示著 GPT-4.5 就要來了。因為之前 OpenAI 高級語音模式發(fā)布后的第二天,首席技術(shù)官 Mira Murati 官宣離職。這么推算下來,作為 GPT 系列的重磅參與者,GPT-4.5 很可能就是明天發(fā)布(畢竟是 OpenAI 連發(fā) 12 天的最后一天)。

對此,有人贊同的表示:「也許他想在離開之前完成手頭的項目。這并非完全不可能。」

在這條評論下,有人回答道「他雖然做了深入研究,但沒有參與任何發(fā)布(沒有走到臺前,一直在幕后),不像 Murati 或其他已經(jīng)離開的人。如果他不得不等待某件事,那么在 GPT-5 發(fā)布后離開會更合適。但老實說,他的離職在某種程度上可能有益于開源研究,因為離開 OpenAI 后會被允許再次發(fā)表文章。不過我不知道 OpenAI 的情況,對他們來說,前景看起來很暗淡。」

還有人表示人們低估了 Alec 對 OpenAI 以及整個 AI 研究的影響。他不僅是 GPT 和 Dall-E 的主要作者,而且很可能引領(lǐng)了公司所有重要的研究方向。甚至表示他的影響力不亞于 Ilya。這對 OpenAI 來說是一個巨大的損失,但該網(wǎng)友同時也希望 Alec 可以做一些開放的研究并發(fā)表一些東西,這樣整個世界都可以受益。

此前,不列顛哥倫比亞大學教授 Jeff Clune 在 X 上發(fā)起了一個討論,「誰是世界上最重要但又最被低估的 AI 科學家?在我看來,只有一個明確的正確答案。大多數(shù)重大進展背后都有一個人,但卻很少被提及或慶祝。」

Jeff Clune 毫不猶豫的推薦了 Alec Radford,「Radford 顯然是影響力最大但知名度最低的人。他推動了許多令人驚嘆的發(fā)展,他應該作為現(xiàn)代生成式人工智能之父載入史冊。Radford 也是一個非常好的人,不追求榮譽,這也是他很少受到關(guān)注的部分原因。我們更有理由談論他對人工智能的巨大影響!」

「Radford 的研究絕對是領(lǐng)先的。他的貢獻絕對是驚人的,至少三次改變了這個領(lǐng)域!我們欠他很多。」

他全程參與了 GPT 系列模型的研發(fā)

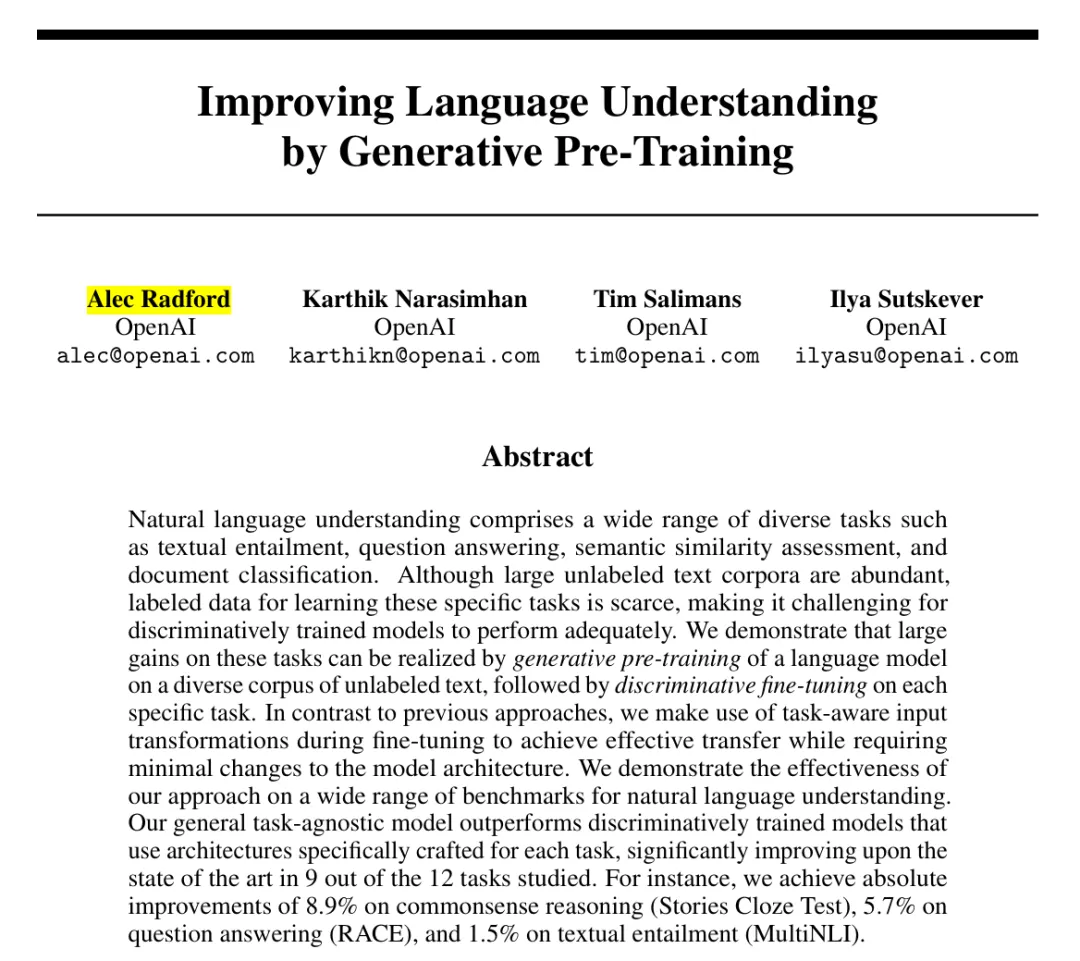

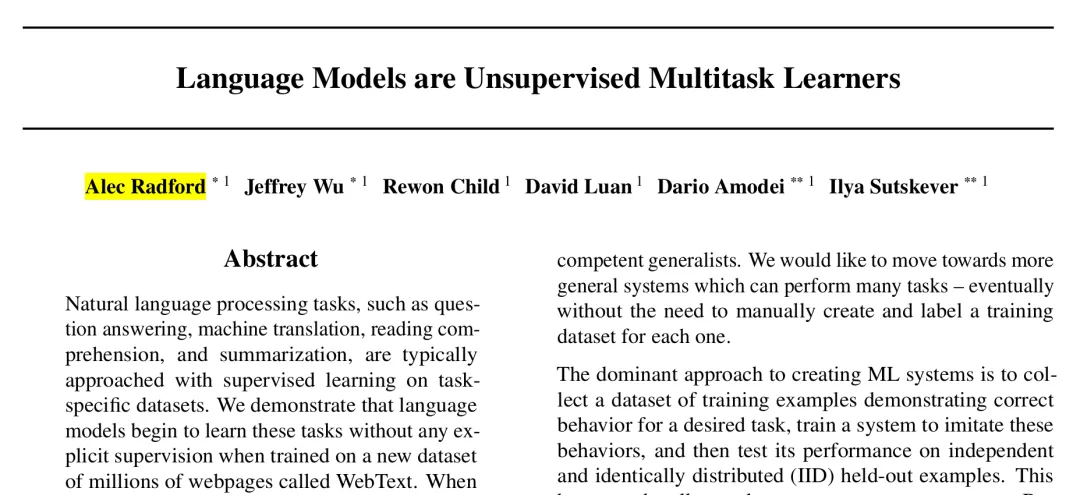

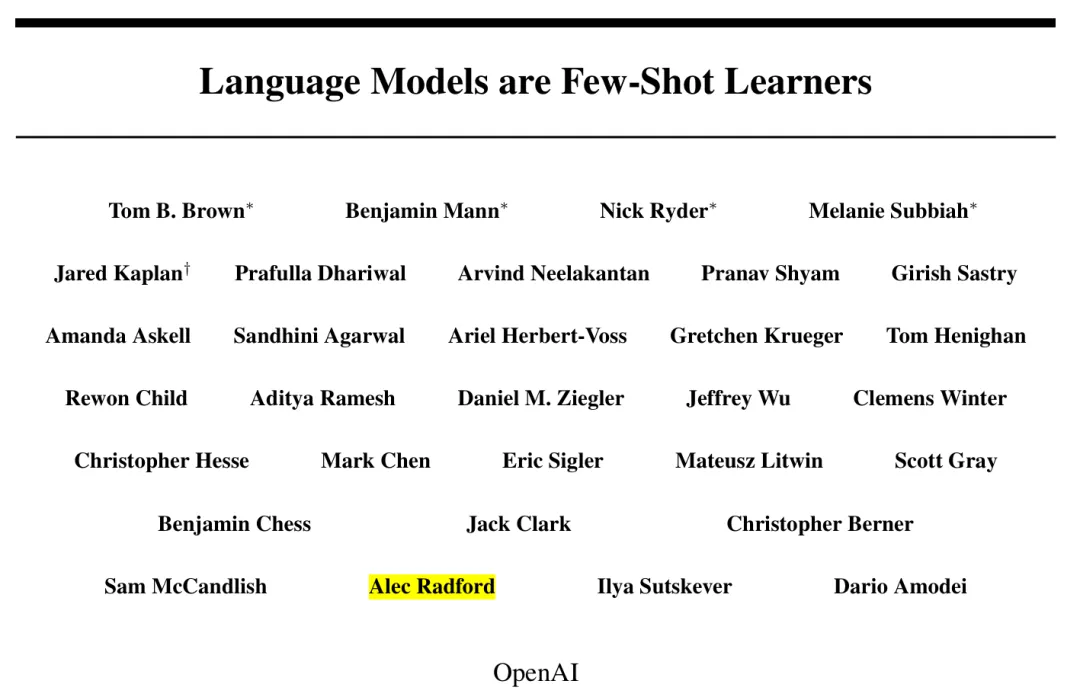

Alec Radford 是 GPT-1 的一作、GPT-2 的共同一作,其中 GPT-1 的被引數(shù)已經(jīng)達到了 11947,GPT-2 的被引數(shù)為 14828。

2018 年,GPT-1 開啟了預訓練大模型時代,提出「半監(jiān)督(semi-supervised)」(后來普遍稱為自監(jiān)督)的方法,先在沒有標號的數(shù)據(jù)上面訓練一個預訓練模型,再在少量標號數(shù)據(jù)上面訓練一個分辨的微調(diào)模型。

2019 年,OpenAI 在 GPT-1 的基礎(chǔ)上發(fā)布了 GPT-2,利用無監(jiān)督預訓練模型做有監(jiān)督任務。相較于初代模型進行諸多改進,GPT-2 參數(shù)達到 15 億,可以執(zhí)行多樣性任務,開始學習在不需要明確監(jiān)督的情況下執(zhí)行數(shù)量驚人的任務。在 GPT-2 階段, OpenAI 去掉了 GPT-1 階段的有監(jiān)督微調(diào)(fine-tuning),成為無監(jiān)督模型。

GPT-1 論文:https://cdn.openai.com/research-covers/language-unsupervised/language_understanding_paper.pdf

GPT-2 論文:https://cdn.openai.com/better-language-models/language_models_are_unsupervised_multitask_learners.pdf

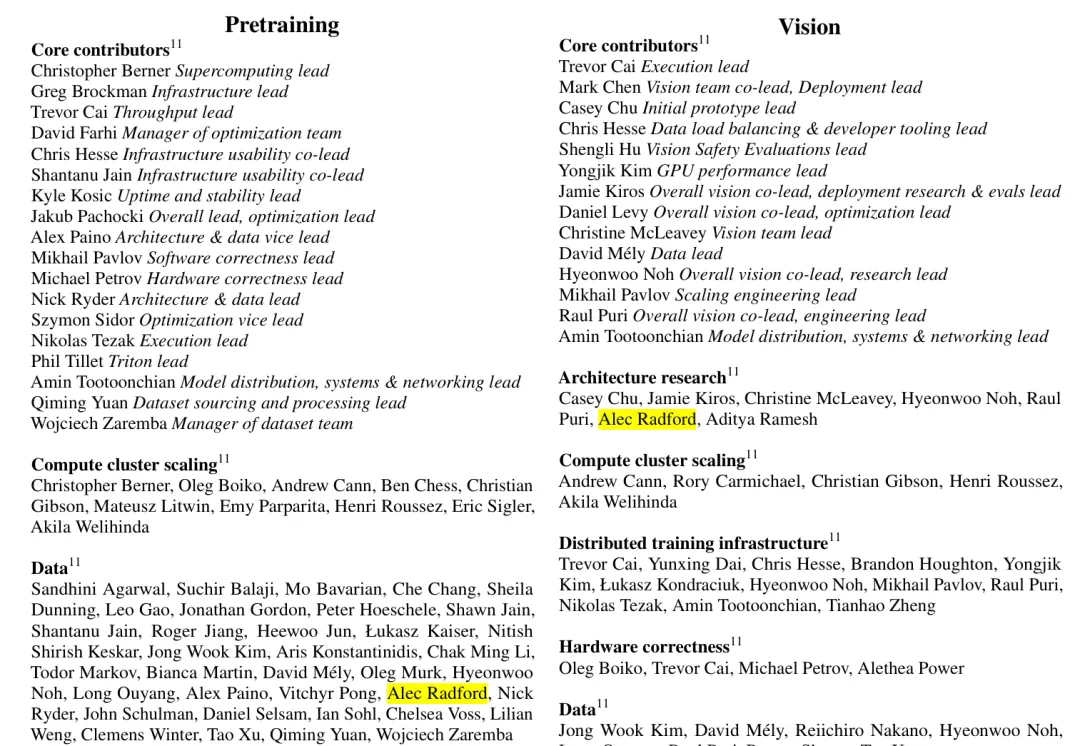

不僅如此,Alec Radford 還參與了 GPT-3 論文的撰寫、以及 GPT-4 的預訓練數(shù)據(jù)和架構(gòu)研究工作。

2020 年,到了 GPT-3 階段,參數(shù)相較于 GPT-2 增加兩個數(shù)量級以上,達到了 1750 億參數(shù),在許多 NLP 數(shù)據(jù)集上都有很強的性能(包括翻譯、問題解答和完形填空任務),以及一些需要動態(tài)推理或領(lǐng)域適應的任務(如解譯單詞、在句子中使用一個新單詞或執(zhí)行算術(shù))。

2023 年,GPT-4 開始邁向多模態(tài)模型,成為 AI 新里程碑,可以解決更復雜的問題、編寫更大型的代碼,并通過圖片產(chǎn)生文字。GPT-4 的回答準確性不僅大幅提高,還具備更高水平的識圖能力,且能夠生成歌詞、創(chuàng)意文本,實現(xiàn)風格變化。

GPT-3 論文:https://arxiv.org/pdf/2005.14165

GPT-4 技術(shù)報告:https://arxiv.org/pdf/2303.08774

根據(jù) Google Scholar 顯示,Alec Radford 的論文被引總數(shù)超過了 19 萬,其中 1 萬以上的達到 7 篇,足可見其參與工作的含金量和影響力。