對(duì)齊、生成效果大增,文本驅(qū)動(dòng)的風(fēng)格轉(zhuǎn)換迎來進(jìn)階版

論文的第一作者是來自西湖大學(xué)的研究人員雷明坤,指導(dǎo)老師為西湖大學(xué)通用人工智能(AGI)實(shí)驗(yàn)室的負(fù)責(zé)人張馳助理教授。實(shí)驗(yàn)室的研究方向聚焦于生成式人工智能和多模態(tài)機(jī)器學(xué)習(xí)。

文本驅(qū)動(dòng)的風(fēng)格遷移是圖像生成中的一個(gè)重要任務(wù),旨在將參考圖像的風(fēng)格與符合文本提示的內(nèi)容融合在一起,生成最終的風(fēng)格化圖片。近年來,隨著 Stable Diffusion 等文本到圖像生成模型的發(fā)展,這些技術(shù)使得在保留內(nèi)容準(zhǔn)確性的同時(shí),實(shí)現(xiàn)出色的風(fēng)格轉(zhuǎn)換成為可能。這項(xiàng)技術(shù)在數(shù)字繪畫、廣告和游戲設(shè)計(jì)等領(lǐng)域具有重要的應(yīng)用價(jià)值。

然而,以往的風(fēng)格遷移算法會(huì)讓結(jié)果的風(fēng)格化圖像過擬合到參考的風(fēng)格圖像上;從而丟失文本控制能力(例如指定顏色)。

為了解決這一難題,西湖大學(xué)、復(fù)旦大學(xué)、南洋理工大學(xué)、香港科技大學(xué)(廣州)等機(jī)構(gòu)的研究團(tuán)隊(duì)聯(lián)合提出了無需額外訓(xùn)練的改進(jìn)方法,能夠與眾多已有方法進(jìn)行結(jié)合。簡(jiǎn)單來說,研究團(tuán)隊(duì)優(yōu)化了圖像和文本共同引導(dǎo)生成風(fēng)格化圖像的時(shí)候,兩種條件如何融合的問題。同時(shí)也探討了關(guān)于風(fēng)格化圖像穩(wěn)定生成和風(fēng)格歧義性的問題。

- 論文標(biāo)題:StyleStudio: Text-Driven Style Transfer with Selective Control of Style Elements

- 論文鏈接:https://arxiv.org/abs/2412.08503

- 項(xiàng)目地址:https://stylestudio-official.github.io/

- Github 地址:https://github.com/Westlake-AGI-Lab/StyleStudio

問題背景

風(fēng)格定義的模糊性

現(xiàn)在的風(fēng)格遷移技術(shù)由于定義 “風(fēng)格” 時(shí)固有的模糊性,仍然未能達(dá)到預(yù)期的效果。現(xiàn)在的方法主要在解決的問題是風(fēng)格圖像中的內(nèi)容元素泄漏進(jìn)風(fēng)格化圖像中,導(dǎo)致風(fēng)格化圖像完全不遵循文本條件,即內(nèi)容泄漏問題。然而,一個(gè)風(fēng)格圖像中包含了多種元素,如色彩、紋理、光照和筆觸;所有這些元素都構(gòu)成了圖像中的整體美學(xué)。

現(xiàn)有的方法通常會(huì)復(fù)制所有的這些元素,這可能會(huì)無意中導(dǎo)致過擬合,即生成的輸出過于模仿參考風(fēng)格圖像的特點(diǎn),這種對(duì)細(xì)節(jié)的過度復(fù)制不僅降低了生成圖像的美學(xué)靈活性,也限制了它適應(yīng)不同風(fēng)格或基于內(nèi)容需求的能力。因此,理想的風(fēng)格遷移方法應(yīng)該允許更選擇性的風(fēng)格調(diào)整,給予用戶強(qiáng)調(diào)或省略特定風(fēng)格組件的靈活性,以實(shí)現(xiàn)平衡且有意圖的轉(zhuǎn)換。

另一個(gè)由過擬合引發(fā)的挑戰(zhàn)是在文本到圖像生成過程中保持文本對(duì)齊準(zhǔn)確性困難,即便是在相當(dāng)簡(jiǎn)單的文本條件下,例如 “A <color> <object>” 這類簡(jiǎn)單文本。當(dāng)前模型會(huì)優(yōu)先考慮來自風(fēng)格圖像的主要顏色或圖案條件,即使它們與文本提示中指定的條件相沖突矛盾。這種不可控制性削弱了模型解讀和結(jié)合細(xì)致文本指導(dǎo)的能力,導(dǎo)致生成結(jié)果的精準(zhǔn)性和定制化能力下降。

最后,風(fēng)格遷移可能會(huì)引入一些不期望的圖像特征,影響文本到圖像生成模型的效果穩(wěn)定性。例如,一種常見問題是布局不穩(wěn)定(例如棋盤格效應(yīng)),即重復(fù)的圖案會(huì)不經(jīng)意地出現(xiàn)在整個(gè)生成圖像中,不論用戶的文本條件如何。這突顯了風(fēng)格遷移過程中額外復(fù)雜性帶來的挑戰(zhàn)。

當(dāng)前風(fēng)格化文生圖模型存在的問題可以總結(jié)歸納為以下三個(gè)方面:

- 風(fēng)格化圖像過擬合導(dǎo)致保持文本對(duì)齊準(zhǔn)確性困難。

- 風(fēng)格化圖像過擬合導(dǎo)致風(fēng)格圖像中風(fēng)格元素遷移的不可控。

- 風(fēng)格化圖像出現(xiàn)不穩(wěn)定生成的問題,例如棋盤格效應(yīng)。

StyleStudio 核心創(chuàng)新

針對(duì)風(fēng)格定義模糊性導(dǎo)致的三個(gè)問題,研究團(tuán)隊(duì)提出了針對(duì)每個(gè)問題的解決方案。具體的解決方法如下:

貢獻(xiàn)一:跨模態(tài)自適應(yīng)實(shí)例正則化技術(shù) (cross-modal AdaIN)

在文本驅(qū)動(dòng)的風(fēng)格遷移中,傳統(tǒng)的基于適配器的方法(Adapter-Based)方法通過加權(quán)求和直接組合引導(dǎo)圖像生成的文本和圖像條件,這樣的做法可能導(dǎo)致兩種條件之間的信息沖突,影響最終的生成效果。

研究團(tuán)隊(duì)提出了跨模態(tài)自適應(yīng)實(shí)例正則化技術(shù) Cross-Modal AdaIN。論文回顧了經(jīng)典風(fēng)格遷移算法 AdaIN 技術(shù),然后提出了多模態(tài)版本 AdaIN 來解決文本驅(qū)動(dòng)的風(fēng)格遷移問題。具體來說,該算法首先分別處理文本和風(fēng)格特征以生成獨(dú)立網(wǎng)格特征圖,再應(yīng)用原本的 AdaIN 技術(shù)使文本特征通過風(fēng)格特征歸一化,最后將結(jié)果融合進(jìn) U-Net 特征中。此方法自適應(yīng)地平衡了文本與風(fēng)格條件的影響,最小化了輸入間的潛在沖突;并避免了復(fù)雜超參數(shù)的設(shè)置,提高了模型對(duì)文本提示和風(fēng)格參考的理解能力和生成質(zhì)量。

與此同時(shí),得益于傳統(tǒng)的基于適配器的方法(Adapter-Based)采用加權(quán)求和組合文本和圖像條件,這保證了兩個(gè)特征圖位于相同的嵌入空間(embedding space);研究團(tuán)隊(duì)發(fā)現(xiàn)可以直接將跨模態(tài)自適應(yīng)實(shí)例正則化技術(shù)替換傳統(tǒng)基于適配器的方法(Adapter-Based)中的加權(quán)求和策略,且不需要進(jìn)行額外的訓(xùn)練。

跨模態(tài)自適應(yīng)實(shí)例正則化技術(shù)示例圖

貢獻(xiàn)二:基于風(fēng)格圖像的無分類器生成引導(dǎo) Style-CFG

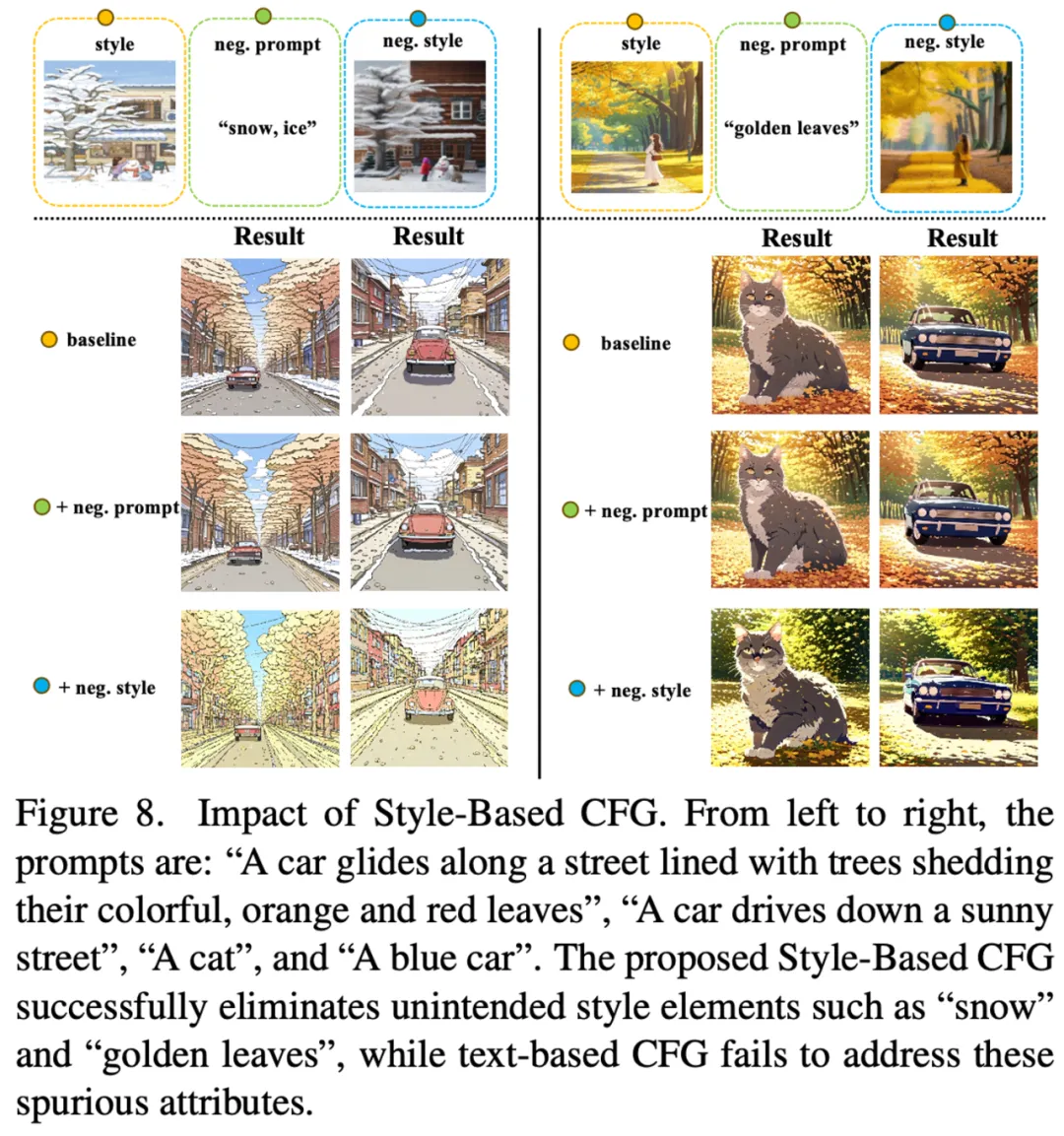

在風(fēng)格遷移中,當(dāng)參考風(fēng)格圖像包含多種風(fēng)格元素(如卡通風(fēng)格與夜間美學(xué)的結(jié)合)時(shí),會(huì)出現(xiàn)風(fēng)格模糊的挑戰(zhàn)。當(dāng)前的方法難以有效地分離這些不同的風(fēng)格元素,更無法選擇性地強(qiáng)調(diào)核心特定風(fēng)格元素。為了解決這個(gè)問題,需要一種靈活的方法,可以有選擇地突出所需的風(fēng)格特征,同時(shí)過濾掉無關(guān)或沖突的特征。

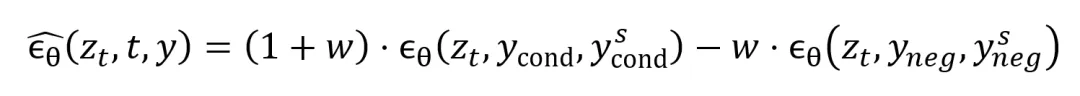

為此,研究團(tuán)隊(duì)了借鑒了擴(kuò)散模型中文本引導(dǎo)圖像生成常用的無分類器引導(dǎo)(CFG)的概念,提出了基于風(fēng)格的無分類器引導(dǎo)(Style-Based Classifier-Free Guidance, SCFG)設(shè)計(jì),旨在提供對(duì)風(fēng)格遷移過程的可控調(diào)整。

研究團(tuán)隊(duì)提出利用布局控制生成模型(如 ControlNet)生成所需要的負(fù)向風(fēng)格圖;例如當(dāng)正向風(fēng)格圖片的風(fēng)格特點(diǎn)是卡通風(fēng)格與雪景時(shí),可以生成真實(shí)風(fēng)格下的雪景圖片;通過基于風(fēng)格的無分類器引導(dǎo)使得最終風(fēng)格化圖片中僅包含卡通風(fēng)格而不包含雪這一風(fēng)格元素。

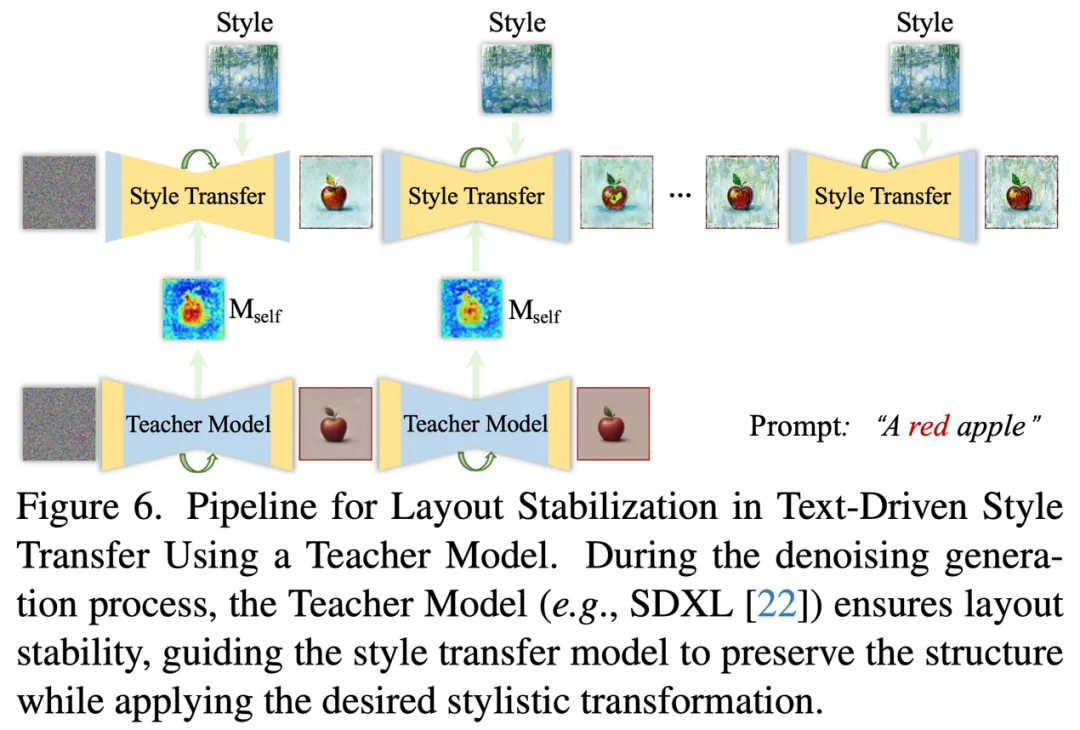

貢獻(xiàn)三:引入教師模型穩(wěn)定圖像生成

在圖像生成中,內(nèi)容的布局對(duì)視覺美學(xué)至關(guān)重要。研究團(tuán)隊(duì)觀察到,生成過程中會(huì)出現(xiàn)較為明顯的短板是棋盤格現(xiàn)象。為了保持文本驅(qū)動(dòng)風(fēng)格遷移中的穩(wěn)定布局,研究團(tuán)隊(duì)提出利用風(fēng)格遷移方法中使用到的基模型(base model),即通常利用相對(duì)應(yīng)的 Stable Diffusion 模型作為教師模型提供生成過程中的布局指導(dǎo)。

具體來說,研究團(tuán)隊(duì)利用教師模型在生成過程中每一個(gè)去噪時(shí)間步的注意力圖替換風(fēng)格化圖像生成過程中的相對(duì)應(yīng)的注意力圖。這種方法確保了關(guān)鍵的空間關(guān)系特征在去噪過程中的穩(wěn)定性,既保留了原始圖像的結(jié)構(gòu)連貫性,又實(shí)現(xiàn)了所需的風(fēng)格轉(zhuǎn)換,使結(jié)果更符合文本提示的要求。

在實(shí)驗(yàn)中研究團(tuán)隊(duì)有兩點(diǎn)發(fā)現(xiàn),一是相較于替換交叉注意力圖,替換自注意力圖不僅可以穩(wěn)定圖像布局,還可以保持跨風(fēng)格圖像生成內(nèi)容的布局一致性。二是替換自注意力圖只需要在去噪前期進(jìn)行,當(dāng)教師模型參與的去噪過程過長(zhǎng)會(huì)導(dǎo)致風(fēng)格特征的丟失。

教師模型穩(wěn)定圖像生成示例。

教師模型穩(wěn)定圖像生成示例。

實(shí)驗(yàn)亮點(diǎn)

StyleStudio 的文本對(duì)齊能力與穩(wěn)定的圖像生成

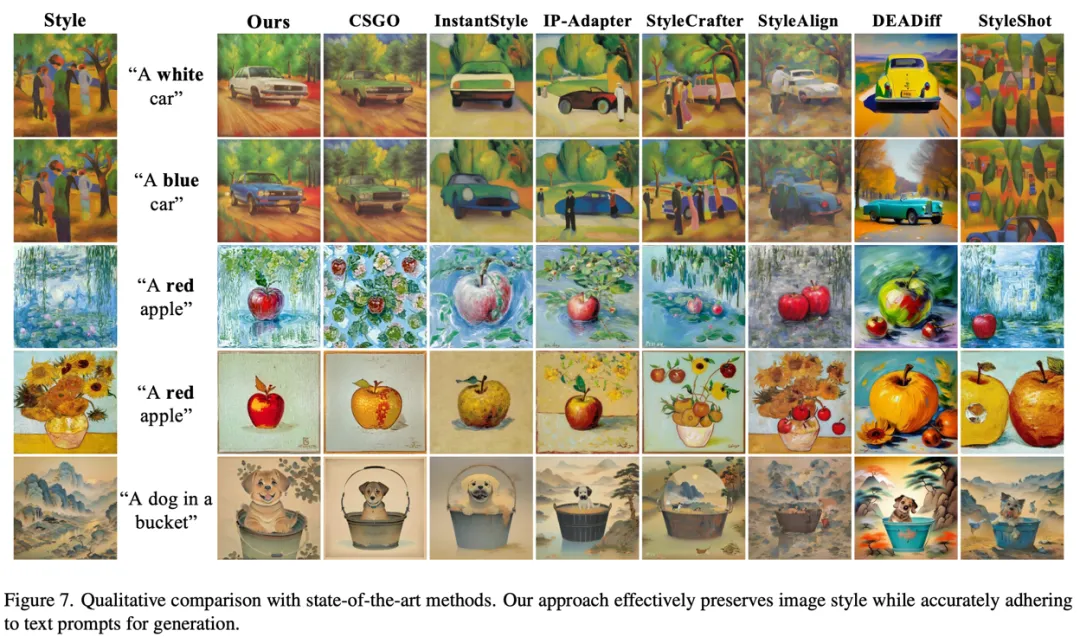

與先前方法進(jìn)行定性的比較試驗(yàn)。

與先前方法進(jìn)行定性的比較試驗(yàn)。

研究團(tuán)隊(duì)進(jìn)行了定性的比較試驗(yàn),實(shí)驗(yàn)結(jié)果表明所提出的方法能夠精確捕捉并反映文本條件中指定的關(guān)鍵風(fēng)格屬性(如顏色),優(yōu)先確保文本對(duì)齊;此外還保證了生成圖像的布局穩(wěn)定,保持結(jié)構(gòu)完整性,沒有出現(xiàn)內(nèi)容泄漏的問題;同時(shí)沒有損失風(fēng)格特征,實(shí)現(xiàn)了與目標(biāo)風(fēng)格的高度相似性。

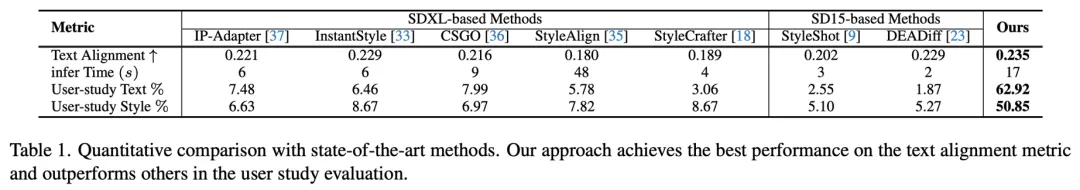

研究團(tuán)隊(duì)也進(jìn)行了定量的比較試驗(yàn)與用戶調(diào)研實(shí)驗(yàn),結(jié)果表明在各個(gè)指標(biāo)中超過了已有的風(fēng)格遷移方法。

基于風(fēng)格的無分類器引導(dǎo)方法實(shí)驗(yàn)

基于風(fēng)格的無分類器引導(dǎo)方法實(shí)驗(yàn)

研究團(tuán)隊(duì)針對(duì)提出的基于風(fēng)格的無分類器引導(dǎo)方法進(jìn)行試驗(yàn),通過與傳統(tǒng)的無分類器指導(dǎo)方法對(duì)比證明了所提出方法的有效性。

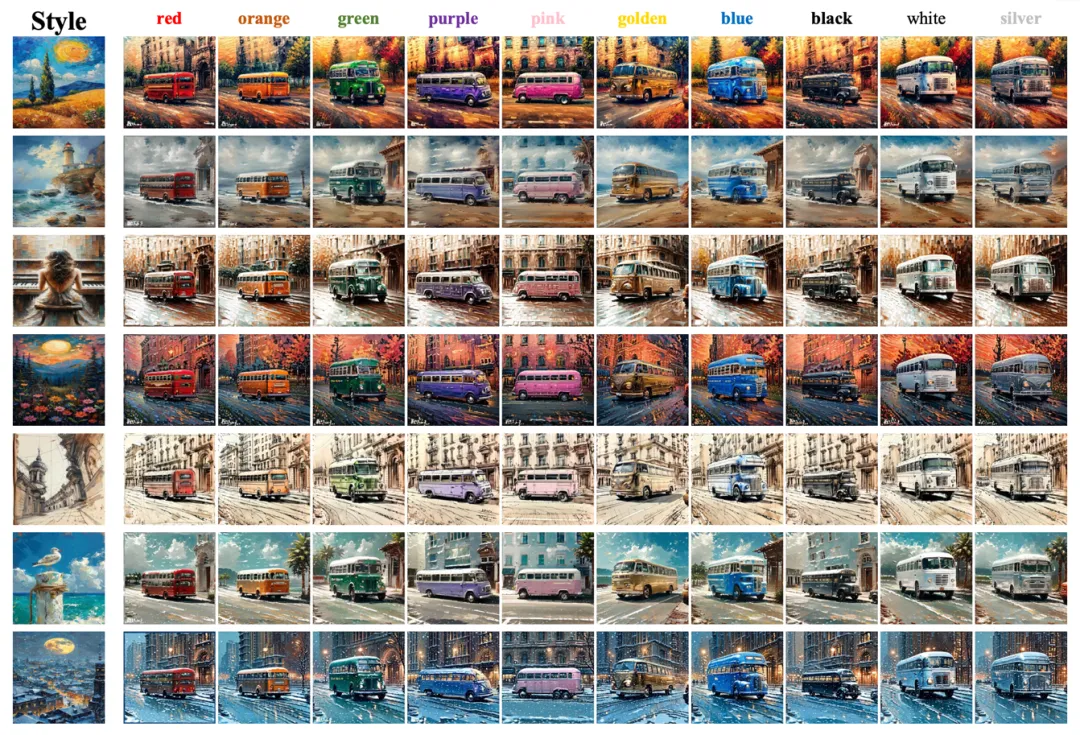

更多風(fēng)格圖像和文本條件下的實(shí)驗(yàn)結(jié)果。所用的文本條件格式為 “A <color> bus”

更多風(fēng)格圖像和文本條件下的實(shí)驗(yàn)結(jié)果。所用的文本條件格式為 “A <color> bus”

研究團(tuán)隊(duì)為了展示所提方法的通用性和穩(wěn)健性,進(jìn)行了更多風(fēng)格圖像和文本條件下的實(shí)驗(yàn)。實(shí)驗(yàn)結(jié)果進(jìn)一步驗(yàn)證了該方法的有效性,表明其在文本對(duì)齊和布局穩(wěn)定生成方面表現(xiàn)出色。更多內(nèi)容與實(shí)驗(yàn)分析,請(qǐng)參考原論文。

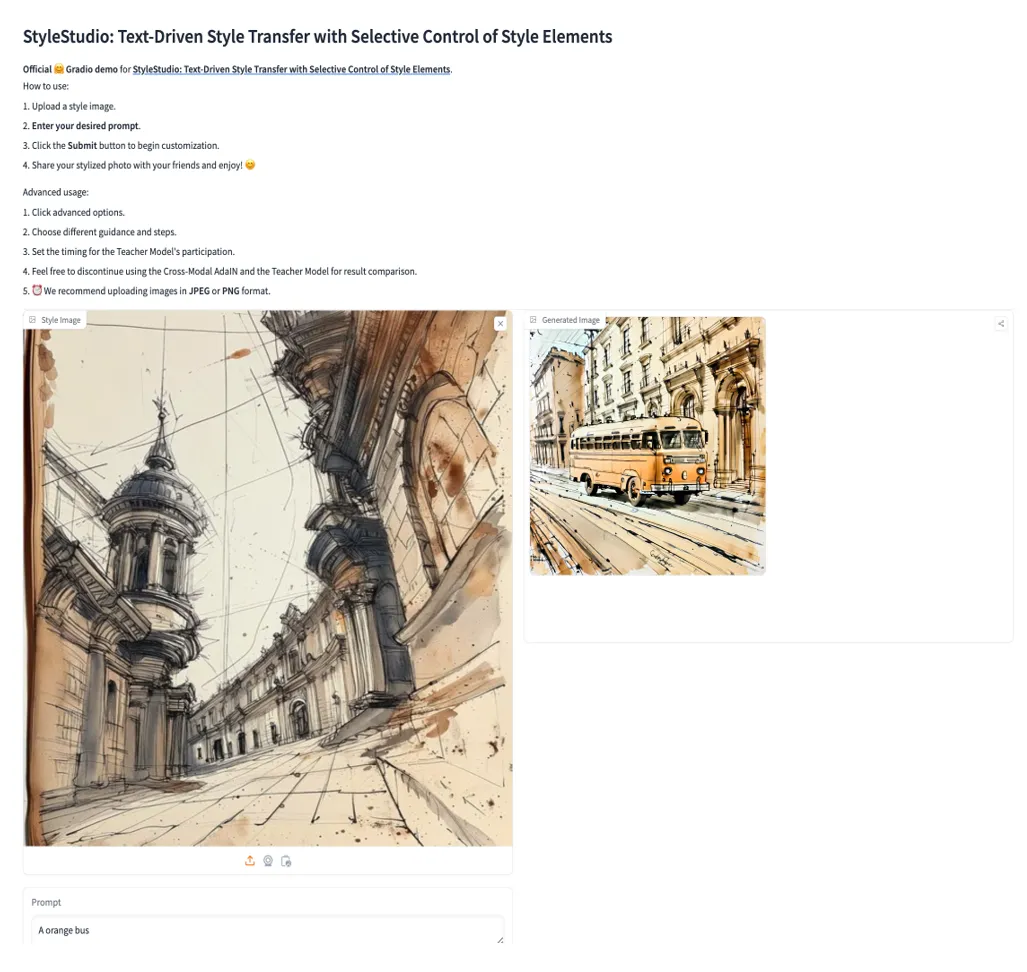

研究團(tuán)隊(duì)官方支持 Huggingface Demo,可以在線體驗(yàn):

示例地址:https://huggingface.co/spaces/Westlake-AGI-Lab/StyleStudio