C#集合數據去重的五種方式及其性能對比測試分析

前言

今天我們一起來討論一下關于C#集合數據去重的5種方式并且使用BenchmarkDotNet對這5種方式進行性能基準對比測試分析,每種方法都有其特點和適用場景,我們可以根據具體需求和執行效率選擇一種進行使用。

BenchmarkDotNet介紹

BenchmarkDotNet是一個基于.NET開源、功能全面、易于使用的性能基準測試框架,它為.NET開發者提供了強大的性能評估和優化能力。通過自動化測試、多平臺支持、高級統計分析和自定義配置等特性,BenchmarkDotNet幫助開發者更好地理解和優化軟件系統的性能表現。

- 使用詳細介紹:https://mp.weixin.qq.com/s/6mpHS1OVuIlBgdU71OIIOw

使用HashSet去重

C# 中的 HashSet 是一種集合類型,它確保其中的元素是唯一的,不允許重復值的存在。當你嘗試向 HashSet 中添加一個重復的元素時,HashSet 會忽略重復的值,而不會引發錯誤。這使得 HashSet 成為一個非常方便的數據結構,用于存儲一組唯一的元素,并且在需要時可以高效地進行查找、插入和刪除操作,注意HashSet中的元素是無序的。

/// <summary>

/// 使用HashSet去重

/// TODO:HashSet是一個集合類,它的特點是不允許重復元素,可以方便地實現去重功能。

/// </summary>

public static void HashSetDuplicate()

{

var dataSource = new List<int>() { 1, 2, 3, 2, 5, 88, 99, 99, 100, 88, 30, 50, 15, 100, 99, 99, 2, 3 };

HashSet<int> uniqueData = new HashSet<int>(dataSource);

Console.WriteLine(string.Join(", ", uniqueData));

}使用循環遍歷去重

/// <summary>

/// 直接循環遍歷去重

/// </summary>

public static void LoopTraversalDuplicate()

{

var dataSource = new List<int>() { 1, 2, 3, 2, 5, 88, 99, 99, 100, 88, 30, 50, 15, 100, 99, 99, 2, 3 };

var uniqueData = new List<int>();

foreach (var item in dataSource)

{

//if (!uniqueData.Any(x => x == item))

//if (!uniqueData.Exists(x => x == item))

if (!uniqueData.Contains(item))

{

uniqueData.Add(item);

}

}

Console.WriteLine(string.Join(", ", uniqueData));

}使用Linq的Distinct()方法去重

Linq中的Distinct()方法用于從集合中篩選出不重復的元素。Distinct()方法基于元素的相等性來進行篩選,并返回一個包含不重復元素的新序列。底層實現還是使用到了HashSet。

/// <summary>

/// 使用Linq的Distinct()方法去重

/// </summary>

public static void DistinctDuplicate()

{

var dataSource = new List<int>() { 1, 2, 3, 2, 5, 88, 99, 99, 100, 88, 30, 50, 15, 100, 99, 99, 2, 3 };

var uniqueData = dataSource.Distinct().ToList();

Console.WriteLine(string.Join(", ", uniqueData));

}使用Linq的GroupBy()方法去重

GroupBy()方法將原始集合中的元素進行分組,根據指定的鍵或條件進行分組。每個分組都會有一個唯一的鍵,通過將原始集合分組并選擇每個分組中的第一個元素,實現了去重的效果。

/// <summary>

/// 使用Linq的GroupBy()方法去重

/// </summary>

public static void GroupByDuplicate()

{

var dataSource = new List<int>() { 1, 2, 3, 2, 5, 88, 99, 99, 100, 88, 30, 50, 15, 100, 99, 99, 2, 3 };

//GroupBy()方法將原始集合中的元素進行分組,根據指定的鍵或條件進行分組。每個分組都會有一個唯一的鍵,通過將原始集合分組并選擇每個分組中的第一個元素,實現了去重的效果。

var uniqueData = dataSource.GroupBy(item => item).Select(group => group.First()).ToList();

Console.WriteLine(string.Join(", ", uniqueData));

}使用自定義的比較器和循環遍歷

/// <summary>

/// 使用自定義的比較器和循環遍歷

/// </summary>

public static void CustomEqualityComparerDuplicate()

{

var dataSource = new List<int>() { 1, 2, 3, 2, 5, 88, 99, 99, 100, 88, 30, 50, 15, 100, 99, 99, 2, 3 };

var uniqueData = new List<int>();

foreach (var item in dataSource)

{

if (!uniqueData.Contains(item, new CustomEqualityComparer()))

{

uniqueData.Add(item);

}

}

Console.WriteLine(string.Join(", ", uniqueData));

}

/// <summary>

/// 自定義的比較器

/// </summary>

public class CustomEqualityComparer : IEqualityComparer<int>

{

public bool Equals(int x, int y)

{

return x == y;

}

public int GetHashCode(int obj)

{

return obj.GetHashCode();

}

}性能基準對比測試分析

接下來我們使用BenchmarkDotNet對這5種集合去重的方式進行性能基準對比測試分析。

測試代碼

using BenchmarkDotNet.Attributes;

namespace BenchmarkDotNetExercise

{

[MemoryDiagnoser]//記錄內存分配情況

public class DataSetDeduplicationBenchmark

{

private List<int> dataSource;

public DataSetDeduplicationBenchmark()

{

// 生成大量重復數據

dataSource = Enumerable.Repeat(Enumerable.Range(1, 100), 10000).SelectMany(x => x).ToList();

}

/// <summary>

/// 使用HashSet去重

/// TODO:HashSet是一個集合類,它的特點是不允許重復元素,可以方便地實現去重功能。

/// </summary>

[Benchmark]

public void HashSetDuplicate()

{

HashSet<int> uniqueData = new HashSet<int>(dataSource);

}

/// <summary>

/// 直接循環遍歷去重

/// </summary>

[Benchmark]

public void LoopTraversalDuplicate()

{

var uniqueData = new List<int>();

foreach (var item in dataSource)

{

//if (!uniqueData.Any(x => x == item))

//if (!uniqueData.Exists(x => x == item))

if (!uniqueData.Contains(item))

{

uniqueData.Add(item);

}

}

}

/// <summary>

/// 使用Linq的Distinct()方法去重

/// </summary>

[Benchmark]

public void DistinctDuplicate()

{

var uniqueData = dataSource.Distinct().ToList();

}

/// <summary>

/// 使用Linq的GroupBy()方法去重

/// </summary>

[Benchmark]

public void GroupByDuplicate()

{

//GroupBy()方法將原始集合中的元素進行分組,根據指定的鍵或條件進行分組。每個分組都會有一個唯一的鍵,通過將原始集合分組并選擇每個分組中的第一個元素,實現了去重的效果。

var uniqueData = dataSource.GroupBy(item => item).Select(group => group.First()).ToList();

}

/// <summary>

/// 使用自定義的比較器和循環遍歷

/// </summary>

[Benchmark]

public void CustomEqualityComparerDuplicate()

{

var uniqueData = new List<int>();

foreach (var item in dataSource)

{

if (!uniqueData.Contains(item, new CustomEqualityComparer()))

{

uniqueData.Add(item);

}

}

}

/// <summary>

/// 自定義的比較器

/// </summary>

public class CustomEqualityComparer : IEqualityComparer<int>

{

public bool Equals(int x, int y)

{

return x == y;

}

public int GetHashCode(int obj)

{

return obj.GetHashCode();

}

}

}

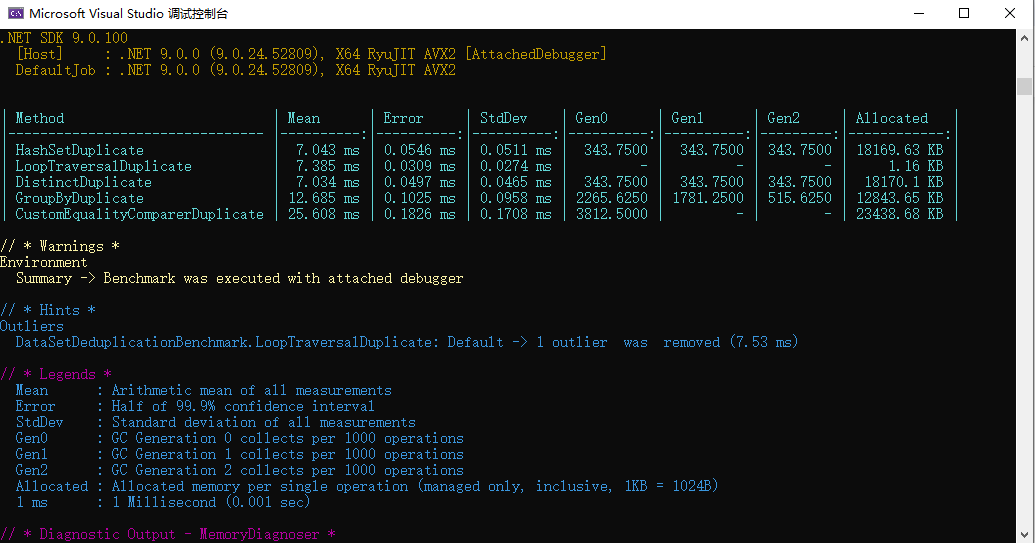

}分析生成的報告

圖片

圖片

Method | Mean | Error | StdDev | Gen0 | Gen1 | Gen2 | Allocated |

HashSetDuplicate | 7.043 ms | 0.0546 ms | 0.0511 ms | 343.7500 | 343.7500 | 343.7500 | 18169.63 KB |

LoopTraversalDuplicate | 7.385 ms | 0.0309 ms | 0.0274 ms | - | - | - | 1.16 KB |

DistinctDuplicate | 7.034 ms | 0.0497 ms | 0.0465 ms | 343.7500 | 343.7500 | 343.7500 | 18170.1 KB |

GroupByDuplicate | 12.685 ms | 0.1025 ms | 0.0958 ms | 2265.6250 | 1781.2500 | 515.6250 | 12843.65 KB |

CustomEqualityComparerDuplicate | 25.608 ms | 0.1826 ms | 0.1708 ms | 3812.5000 | - | - | 23438.68 KB |

說明:

- Mean: 所有測量值的算術平均值。

- Error: 99.9% 置信區間的一半。

- StdDev: 所有測量值的標準差。

- Gen0: 第 0 代 GC 每 1000 次操作收集一次。

- Gen1: 第 1 代 GC 每 1000 次操作收集一次。

- Gen2: 第 2 代 GC 每 1000 次操作收集一次。

- Allocated: 每次操作分配的內存(僅托管內存,包含所有內容,1KB = 1024B)。

- 1 ms: 1 毫秒(0.001 秒)。