一文看盡Meta開源大禮包!全面覆蓋圖像分割、語音、文本、表征、材料發(fā)現(xiàn)、密碼安全性等

開源絕對是AI如今發(fā)展迅猛的助推劑,而其中的一股重要力量就是來自Meta

Meta在人工智能開源界可謂是碩果頗豐,從大模型LLama到圖像分割模型Segment Anything,覆蓋了各種模態(tài)、各種場景,甚至在AI以外的學(xué)科,如醫(yī)學(xué)等科學(xué)研究進(jìn)展也都從Meta的開源模型中受益。

最近,Meta發(fā)布了一系列新的開源工作,還對已有的開源工作進(jìn)行了升級迭代,包括 SAM 2.1、句子表征的細(xì)化等,開源社區(qū)將再迎來一場狂歡!

Segment Anything Model 2.1

SAM2模型開源以來,總下載量已經(jīng)超過70萬次,在線可用的演示程序也已幫助用戶在圖像和視頻數(shù)據(jù)中分割了數(shù)十萬個(gè)物體,并且在跨學(xué)科(包括醫(yī)學(xué)圖像、氣象學(xué)等研究)中產(chǎn)生了巨大的影響。

本次Meta更新了Meta Segment Anything Model 2.1 (SAM 2.1)權(quán)重,性能更強(qiáng)。

開源鏈接:https://github.com/facebookresearch/sam2

相比SAM2,研究人員引入了額外的數(shù)據(jù)增強(qiáng)技術(shù)來模擬視覺相似物體和小物體,并且通過在較長的幀序列上訓(xùn)練模型并對「空間」和「物體指向記憶」(object pointer memory)的位置編碼進(jìn)行一些調(diào)整,提高了SAM 2的遮擋處理能力(occlusion handling capability)。

研究人員還開源了SAM 2開發(fā)者套件,基于SAM 2模型構(gòu)建下游應(yīng)用會變得更容易,用戶現(xiàn)在也可以使用自己的數(shù)據(jù)來微調(diào)SAM 2的訓(xùn)練代碼;頁面演示的前端和后端代碼也開源了。

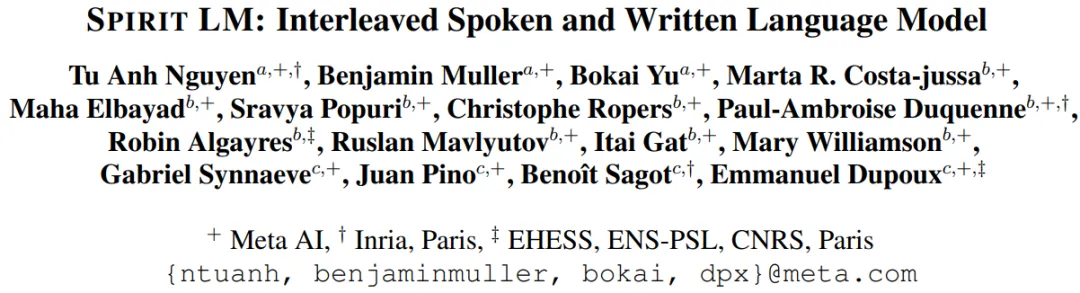

Spirit LM:語音+文本的語言模型

大型語言模型經(jīng)常被用來構(gòu)建文本到語音的流程:首先通過自動語音識別(ASR)技術(shù)將語音轉(zhuǎn)寫成文本,然后由大型語言模型(LLM)合成文本,最終再通過文本到語音(TTS)技術(shù)將文本轉(zhuǎn)換為語音。

但這個(gè)過程可能會影響語音的表達(dá)性,使得模型在理解、生成帶表達(dá)的語音上有所欠缺。

為了解決這個(gè)限制,研究人員構(gòu)建了Spirit LM,也是首個(gè)Meta開源的多模態(tài)語言模型,能夠自由地混合文本和語音;通過在語音和文本數(shù)據(jù)集上使用逐詞交錯(cuò)的方法進(jìn)行訓(xùn)練,實(shí)現(xiàn)了跨模態(tài)生成。

論文鏈接:https://arxiv.org/abs/2402.05755

研究人員開發(fā)了兩個(gè)版本的Spirit LM,以展示文本模型的生成語義能力和語音模型的表達(dá)能力:基礎(chǔ)版(Base)使用音素標(biāo)記來模擬語音,而表達(dá)版(Expressive)使用音調(diào)和風(fēng)格標(biāo)記來捕捉關(guān)于語調(diào)的信息,比如是興奮、憤怒還是驚訝,然后生成反映這種語調(diào)的語音。

Spirit LM能夠生成聽起來更自然的語音,并且有能力跨模態(tài)學(xué)習(xí)新任務(wù),比如自動語音識別、文本到語音和語音分類。

Layer Skip:加速生成時(shí)間

大型語言模型已經(jīng)在各個(gè)行業(yè)和用例中得到了廣泛應(yīng)用,但需要非常高的計(jì)算速度和內(nèi)存量,運(yùn)行成本非常高。

為了應(yīng)對這些挑戰(zhàn),Meta引入一種端到端的解決方案層跳過(Layer Skip),可以在不依賴專用硬件或軟件的情況下,加速新數(shù)據(jù)上的LLM生成時(shí)間:通過執(zhí)行模型的部分層,并利用后續(xù)層進(jìn)行驗(yàn)證和修正,來加速LLMs的運(yùn)行。

論文鏈接:https://arxiv.org/pdf/2404.16710

代碼鏈接:https://github.com/facebookresearch/LayerSkip

研究人員開源了層跳過的推理代碼和微調(diào)檢查點(diǎn),包括Llama 3、Llama 2和Code Llama,這些模型已經(jīng)通過層跳過訓(xùn)練方法進(jìn)行了優(yōu)化,顯著提高了早期層退出的準(zhǔn)確性,層跳過的推理實(shí)現(xiàn)可以提升1.7倍模型性能。

層跳過檢查點(diǎn)的一個(gè)主要特點(diǎn)是在早期層退出和跳過中間層時(shí)的魯棒性,以及各層之間激活的一致性,這種特性為優(yōu)化和可解釋性方面的創(chuàng)新研究鋪平了道路。

Salsa:驗(yàn)證后量子密碼標(biāo)準(zhǔn)的安全性

在保護(hù)數(shù)據(jù)的安全領(lǐng)域上,密碼學(xué)研究必須領(lǐng)先于攻擊手段。

Meta此次開源的方法Salsa,能夠攻擊和破解NIST標(biāo)準(zhǔn)中的稀疏秘密(sparse secrets)Krystals Kyber,使研究人員能夠?qū)谌斯ぶ悄艿墓暨M(jìn)行基準(zhǔn)測試,并將其與現(xiàn)在以及將來的新攻擊手段進(jìn)行對比。

論文鏈接:https://arxiv.org/pdf/2408.00882v1

代碼鏈接:https://github.com/facebookresearch/LWE-benchmarking

國家標(biāo)準(zhǔn)技術(shù)研究所(NIST)采用的行業(yè)標(biāo)準(zhǔn),「基于格(lattice)的密碼學(xué)」建立在「帶誤差的學(xué)習(xí)」(LWE)的難題之上。

這種難題假設(shè),如果只提供與隨機(jī)向量有噪聲的內(nèi)積,那么學(xué)習(xí)一個(gè)秘密向量是非常困難的,此前已經(jīng)有研究人員展示了針對這種方法的機(jī)器學(xué)習(xí)攻擊。

Meta Lingua:通過高效的模型訓(xùn)練加速研究

Meta Lingua 是一個(gè)輕量級且自包含的代碼庫,可以大規(guī)模訓(xùn)練語言模型。

該項(xiàng)目提供了一個(gè)研究友好的環(huán)境,使得將概念轉(zhuǎn)化為實(shí)際實(shí)驗(yàn)變得更加容易,并強(qiáng)調(diào)簡單性和可重用性以加速研究,平臺高效且可定制,研究人員能夠以最小的設(shè)置和技術(shù)負(fù)擔(dān)來快速測試想法。

代碼鏈接:https://github.com/facebookresearch/lingua

為了實(shí)現(xiàn)這一點(diǎn),研究人員做了幾個(gè)設(shè)計(jì)選擇,確保代碼既模塊化又自包含,同時(shí)保持高效,其中利用了PyTorch中的多個(gè)特性,在保持靈活性和性能的同時(shí),使代碼更易于安裝和維護(hù)。

研究人員可以更專注于工作本身,讓Lingua平臺來負(fù)責(zé)高效的模型訓(xùn)練和可復(fù)現(xiàn)的研究。

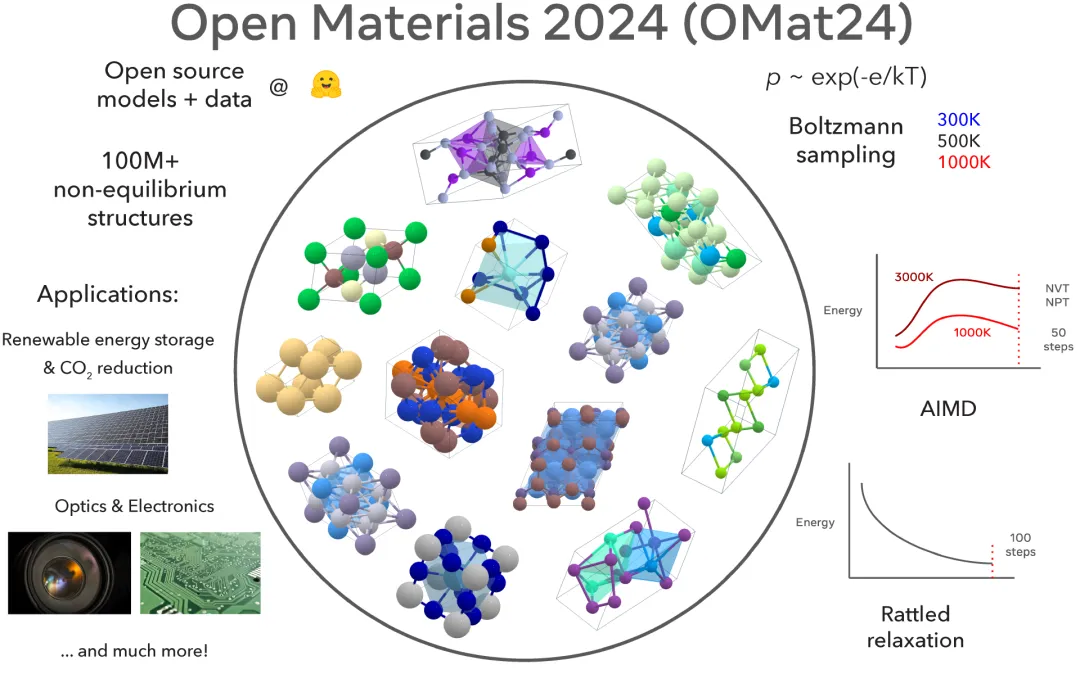

Meta Open Materials 2024:促進(jìn)無機(jī)材料發(fā)現(xiàn)

傳統(tǒng)上,發(fā)現(xiàn)推動技術(shù)進(jìn)步的新材料可能需要數(shù)十年的時(shí)間,但人工智能輔助材料發(fā)現(xiàn)可能會徹底改變這一領(lǐng)域,并大大加快發(fā)現(xiàn)流程。

Meta最近開源了Open Materials 2024數(shù)據(jù)集和模型,在Matbench-Discovery排行榜上名列前茅,有望通過開放和可復(fù)現(xiàn)的研究進(jìn)一步推動人工智能加速材料發(fā)現(xiàn)的突破。

代碼鏈接:https://github.com/FAIR-Chem/fairchem

模型鏈接:https://huggingface.co/fairchem/OMAT24

數(shù)據(jù)鏈接:https://huggingface.co/datasets/fairchem/OMAT24

目前最佳的材料發(fā)現(xiàn)模型是基于開源人工智能社區(qū)的基礎(chǔ)研究構(gòu)建的封閉模型,而Open Materials 2024提供了基于1億個(gè)訓(xùn)練樣本的開源模型和數(shù)據(jù),也是最大的開放數(shù)據(jù)集之一,為材料發(fā)現(xiàn)和人工智能研究社區(qū)提供了一個(gè)有競爭力的開源選擇。

Meta Open Materials 2024現(xiàn)在公開可用,并將賦予人工智能和材料科學(xué)研究社區(qū)加速無機(jī)材料發(fā)現(xiàn)的能力,并縮小領(lǐng)域內(nèi)開放和專有模型之間的差距。

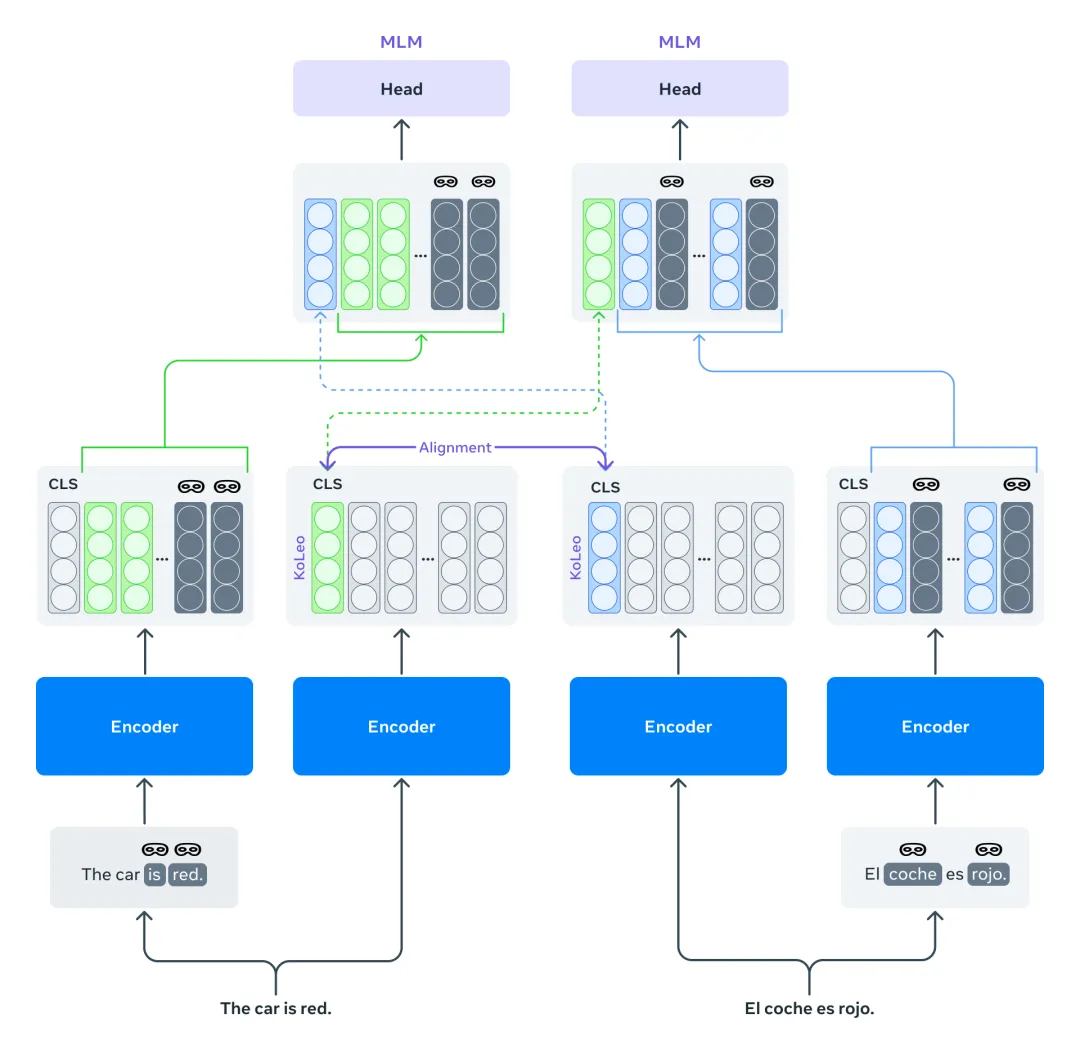

Mexma:改進(jìn)句子表征的token級目標(biāo)

目前,預(yù)訓(xùn)練的跨語言句子編碼器通常只使用句子級別的目標(biāo)進(jìn)行訓(xùn)練。這種做法可能會導(dǎo)致信息的丟失,特別是對于token級別的信息,這最終會降低句子表示的質(zhì)量。

Mexma是一個(gè)預(yù)訓(xùn)練的跨語言句子編碼器,通過在訓(xùn)練過程中結(jié)合token和句子級別的目標(biāo),其性能也超越了以往的方法。

論文鏈接:https://arxiv.org/pdf/2409.12737

以前訓(xùn)練跨語言句子編碼器的方法僅通過句子表示來更新編碼器,通過同時(shí)使用token級別的目標(biāo)來更好地更新編碼器,從而在這方面進(jìn)行了改進(jìn)。

研究人員希望研究社區(qū)能夠從使用Mexma作為句子編碼器中受益,目前支持80種語言,所有語言的句子表示都經(jīng)過對齊,在挖掘包含兩種文本的語言數(shù)據(jù)時(shí),Mexma能夠更準(zhǔn)確地識別和比較不同語言中的信息,并且在其他下游任務(wù),如句子分類上表現(xiàn)良好。

Self-Taught Evaluator:生成獎勵模型

研究人員推出了自學(xué)評估器(Self-Taught Evaluator),可以用于生成合成偏好數(shù)據(jù)以訓(xùn)練獎勵模型,而無需依賴人工標(biāo)注。

這種方法生成對比的模型輸出,并訓(xùn)練一個(gè)作為評委的大型語言模型(LLM-as-a-Judge)以生成用于評估和最終判斷的推理痕跡,并通過迭代自我改進(jìn)方案進(jìn)行優(yōu)化。

論文鏈接:https://arxiv.org/abs/2408.02666

研究人員發(fā)布了一個(gè)經(jīng)過直接偏好優(yōu)化訓(xùn)練的模型,該生成式獎勵模型在RewardBench上表現(xiàn)強(qiáng)大,但在訓(xùn)練數(shù)據(jù)創(chuàng)建中沒有使用任何人工標(biāo)注。

其性能表現(xiàn)超越了更大的模型或使用人工標(biāo)注標(biāo)簽的模型,例如GPT-4、Llama-3.1-405B-Instruct和Gemini-Pro,也可作為AlpacaEval排行榜上的評估器之一,在人類一致率方面名列前茅,同時(shí)比默認(rèn)的GPT-4評估器快約7到10倍。

自從發(fā)布以來,人工智能社區(qū)已經(jīng)接受了這種合成數(shù)據(jù)方法,并用來訓(xùn)練表現(xiàn)優(yōu)異的獎勵模型。