清華廈大等提出“無限長上下文”技術(shù),100萬大海撈針全綠,Llama\Qwen\MiniCPM都能上分

大模型的記憶限制被打破了,變相實(shí)現(xiàn)“無限長”上下文。

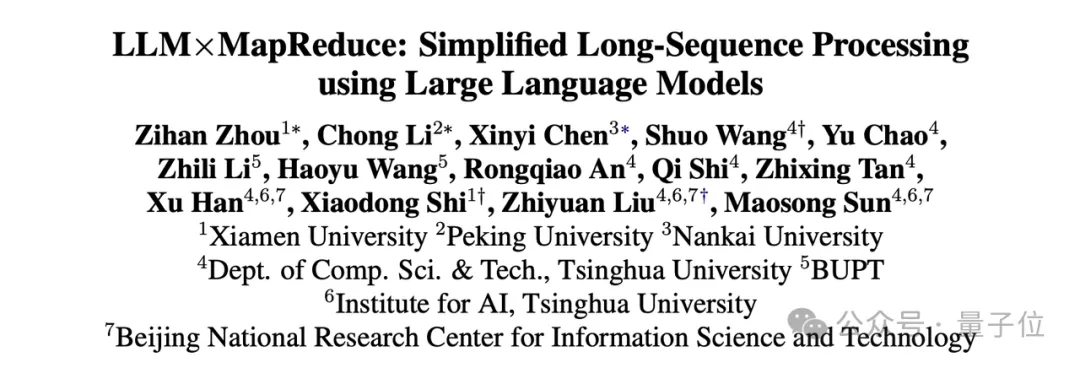

最新成果,來自清華、廈大等聯(lián)合提出的LLMxMapReduce長本文分幀處理技術(shù)。

LLMxMapReduce技術(shù)通過將長上下文切分為多個(gè)片段,可以讓模型并行處理多個(gè)片段,并從不同片段中提取關(guān)鍵信息,然后匯總成為最終的答案。

特別地,團(tuán)隊(duì)提出結(jié)構(gòu)化通信協(xié)議和上下文置信度校準(zhǔn)機(jī)制,實(shí)現(xiàn)對(duì)跨片段信息更有效的處理。這項(xiàng)技術(shù)可以打破大模型的記憶限制,實(shí)現(xiàn)上下文長度無限穩(wěn)定拓展。

LLMxMapReduce技術(shù)可作為大模型的長文本上分神器——它對(duì)大模型長文本能力具有普遍增強(qiáng)作用,且在文本不斷加長的情況下,仍能保持穩(wěn)定性能、減少長文本的掉分情況。

比如結(jié)合了LLMxMapReduce框架之后的Llama3-70B-Instruct x MapReduce模型得分超越了包含Kimi、GPT-4在內(nèi)的知名閉源和開源模型以及其他基于Llama3-70B-Instruct的分治方法(即LongAgent和Chain-of-Agents)。

此外,LLMxMapReduce框架展現(xiàn)出較強(qiáng)的通用性,結(jié)合Qwen2-72B和MiniCPM3也取得了優(yōu)異的成績。

LLMxMapReduce無限長文本技術(shù)原理

在大數(shù)據(jù)領(lǐng)域,MapReduce是一種分布式并行編程框架,具有橫向擴(kuò)展的數(shù)據(jù)處理能力。受到MapReduce所體現(xiàn)的“分而治之”思想的啟發(fā),研究人員設(shè)計(jì)了一種面向大模型的采用分治策略的長文本處理框架,稱為LLMxMapReduce。

通過將長上下文切分為多個(gè)片段,LLMxMapReduce讓模型并行處理多個(gè)片段,并從不同片段中提取關(guān)鍵信息,然后匯總成為最終的答案,從而實(shí)現(xiàn)無限長文本。這一技術(shù)對(duì)模型長文本能力具有普遍增強(qiáng)作用,且在文本不斷加長的情況下,仍能保持穩(wěn)定性能、減少長文本的掉分情況。

最近,也有一些同類型的分治式長文本處理方法,比如LongAgent和Chain-of-Agents。相比于模型一次處理完整長文檔,這類分治式長文本處理既有優(yōu)勢(shì),也有不足。

優(yōu)勢(shì)主要在于:長度可擴(kuò)展,不受限于模型本身的窗口大小,理論上可以支持任意長度輸入。

劣勢(shì)主要在于:將一個(gè)完整的長文檔切分為多個(gè)片段,可能會(huì)破壞跨片段的關(guān)鍵信息,導(dǎo)致模型根據(jù)某個(gè)片段“斷章取義”,產(chǎn)生錯(cuò)誤結(jié)論。團(tuán)隊(duì)分析,會(huì)被切分片段影響的信息有兩類:

- 跨片段依賴 (Inter-Chunk Dependency):多個(gè)片段的信息相互依賴,綜合起來,才能產(chǎn)生一個(gè)完整的答案。比如要總結(jié)一個(gè)事件的時(shí)間脈絡(luò),需要從很多個(gè)片段中提取關(guān)鍵的信息,才能形成一個(gè)完整的時(shí)間線。

- 跨片段沖突 (Inter-Chunk Conflict):多個(gè)片段的信息存在沖突,對(duì)于相同的問題,看不同的片段時(shí)可能得出不同的結(jié)論。比如要問一位導(dǎo)演一生最偉大的作品是什么,在看他青年時(shí)期片段時(shí),得出的是青年時(shí)的最大成就,而在看老年時(shí)期的片段,又會(huì)得出不同的結(jié)論。

為了解決這兩類問題,LLMxMapReduce分別設(shè)計(jì)了以下方案:

- 結(jié)構(gòu)化通信協(xié)議 (Structured Information Protocol):針對(duì)用戶的問題,模型在處理每個(gè)片段時(shí),不是僅僅輸出中間答案,而是輸出結(jié)構(gòu)體,包含豐富的相關(guān)信息。在Reduce階段,模型根據(jù)各個(gè)片段輸出的結(jié)構(gòu)化信息,匯總得出最終結(jié)果。通過在Map和Reduce階段的結(jié)構(gòu)化通信協(xié)議,希望能夠更好地處理跨片段依賴的問題,更好地得出綜合性答案。

{

Extracted Information: XXX # 與問題相關(guān)的關(guān)鍵信息

Rationale: XXX # 得出中間結(jié)果的推理過程

Answer: XXX # 根據(jù)當(dāng)前片段的中間結(jié)果

Confidence Score: XXX # 模型對(duì)當(dāng)前片段的結(jié)果的置信度,范圍為1到5之間

}- 上下文置信度校準(zhǔn) (In-Context Confidence Calibration):模型在Reduce階段,會(huì)參考Confidence的值來匯總不同階段的信息,高Confidence的結(jié)果占據(jù)更多的主導(dǎo)權(quán)。為了讓模型在處理不同片段時(shí)具有一致的置信度評(píng)估標(biāo)準(zhǔn),通過上下文學(xué)習(xí)的方式讓模型學(xué)會(huì)一個(gè)統(tǒng)一的置信度評(píng)估準(zhǔn)則,讓置信度信息更加準(zhǔn)確可靠,從而幫助模型在Reduce階段更好的處理跨片段沖突問題。

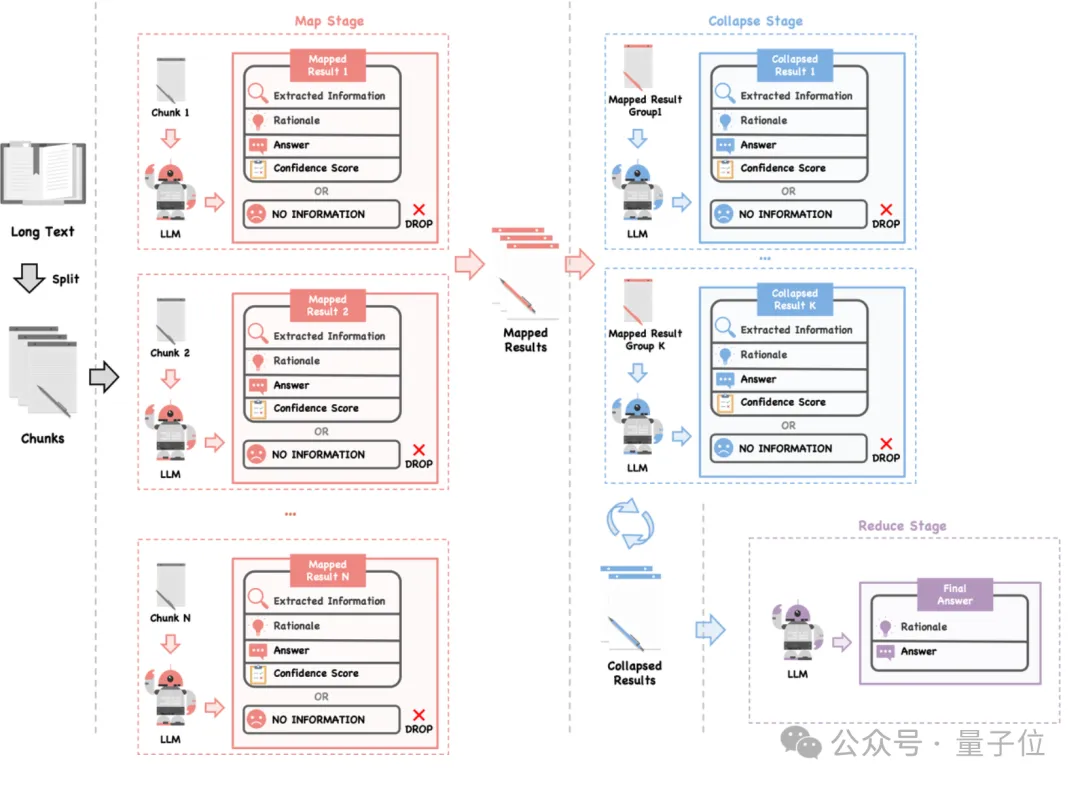

LLMxMapReduce方法的流程圖如下所示:整體分為Map、Collapse和Reduce三個(gè)階段。

首先要將長文本切分成多個(gè)小片段,這些片段可以并行處理,從而提高效率。

然后在Map階段,使用大模型對(duì)每個(gè)片段進(jìn)行分析,然后應(yīng)用上文所述的結(jié)構(gòu)化通信協(xié)議,將提取的信息整合成結(jié)構(gòu)體形式,以便后續(xù)處理。

接下來,在Collapse階段,如果所有片段的結(jié)果總長度超過模型的最大處理限制,模型將多個(gè)結(jié)構(gòu)體壓縮為一個(gè)結(jié)構(gòu)體,以減少上下文長度。在處理沖突信息時(shí),模型會(huì)考慮置信度進(jìn)行整合。

最后,在Reduce階段,模型根據(jù)壓縮后的信息匯總出最終的答案。它會(huì)優(yōu)先考慮置信度較高的結(jié)果,從而確保得到的答案準(zhǔn)確無誤。

通過以上工作流程,LLMxMapReduce能夠更有效地處理長文本,避免因切分導(dǎo)致的信息丟失或錯(cuò)誤結(jié)論,從而提高最終結(jié)果的準(zhǔn)確性。

大模型長文本上分神器

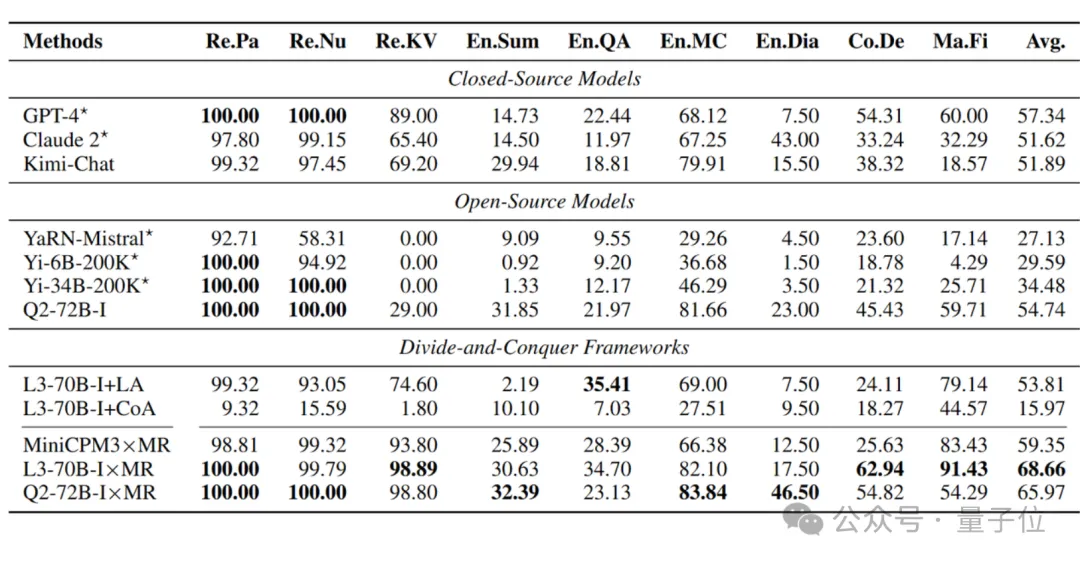

為了驗(yàn)證LLMxMapReduce技術(shù)的有效性,研究人員在業(yè)內(nèi)權(quán)威的長文本評(píng)測InfiniteBench榜單上對(duì)不同模型進(jìn)行了評(píng)測,InfiniteBench是一個(gè)綜合性榜單,最長長度超過2000k token。

研究人員和很多方法進(jìn)行了對(duì)比,其中對(duì)比的基線共有三類:

閉源模型:

包括GPT-4、Claude 2、Kimi-Chat,其中GPT-4和Claude 2的得分參照InfiniteBench原文,Kimi-Chat為重新測量的得分;

開源模型:

包括YaRN-Mistral、Yi-6B-200K、Yi-34B-200K和Qwen2-72B-Instruct,其中YaRN-Mistral、Yi-6B-200K、Yi-34B-200K的得分參照InfiniteBench原文,Qwen2-72B-Instruct是自行測量的得分;

其他基于分治的長文本處理框架:

包括LongAgent和Chain-of-Agents。這兩個(gè)分治框架的不同點(diǎn)在于處理跨片段信息的方式不同。

LongAgent構(gòu)建了一個(gè)Leader Agent來處理跨片段沖突。當(dāng)不同的Chunk得出的答案不同時(shí),Leader Agent會(huì)組織重新閱讀沖突的片段,得出最終答案。

這種重復(fù)閱讀的機(jī)制帶來較大的時(shí)間開銷,并且LongAgent的通信內(nèi)容比較單一,Leader Agent處理沖突的能力有限。相比之下,LLMxMapReduce的結(jié)構(gòu)化通信協(xié)議包含的信息更為豐富。

Chain-of-Agents通過順序逐一讀取各個(gè)Chunk來閱讀全文。

由于沒有顯式地處理沖突信息,可能會(huì)導(dǎo)致后續(xù)Chunk的信息覆蓋歷史Chunk中的關(guān)鍵信息。相比之下,LLMxMapReduce利用校準(zhǔn)后的置信度來更好的處理跨片段沖突。

具體實(shí)驗(yàn)結(jié)果如下:

可以看到,結(jié)合 LLMxMapReduce 框架之后,Llama3-70B-Instruct x MapReduce 以 68.66 的最高平均分?jǐn)?shù),超越了閉源、開源模型以及其他基于 Llama3-70B-Instruct 的分治策略(即LongAgent和Chain-of-Agents)。

此外,LLMxMapReduce 框架展現(xiàn)出較強(qiáng)的通用性,結(jié)合 Qwen2-72B 和 MiniCPM3 也取得了優(yōu)異的成績。

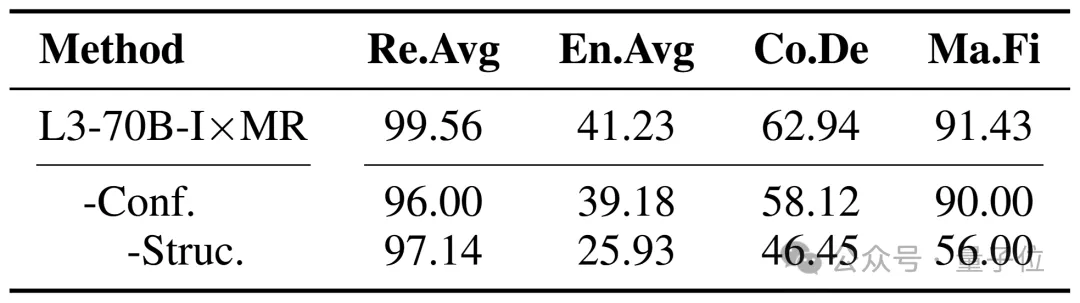

研究人員同樣分析上下文置信度校準(zhǔn)和結(jié)構(gòu)化通信協(xié)議對(duì)框架性能的影響,在實(shí)驗(yàn)中逐步將這兩個(gè)機(jī)制移除。實(shí)驗(yàn)結(jié)果顯示,去除上下文置信度校準(zhǔn)機(jī)制導(dǎo)致所有任務(wù)的性能下降。如果沒有這兩個(gè)機(jī)制,性能將會(huì)顯著下降。這些結(jié)果證明了這兩個(gè)機(jī)制在 LLMxMapReduce 框架中的關(guān)鍵作用。

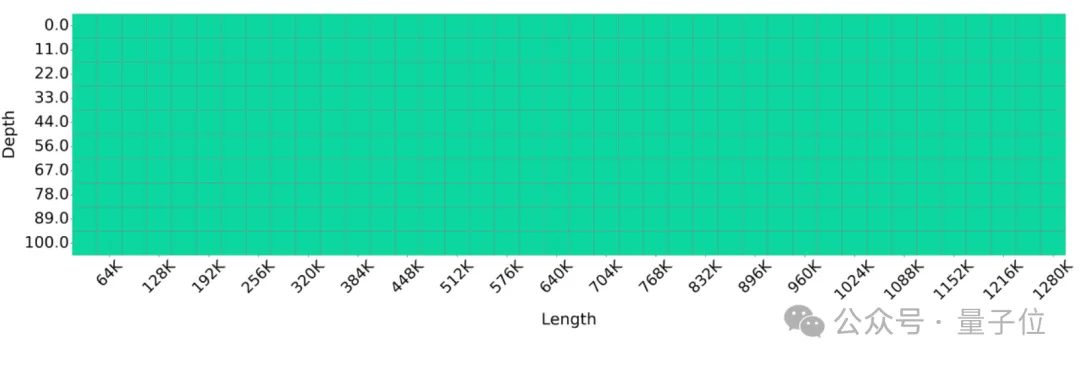

100萬上下文大海撈針全綠

大海撈針(Needle-in-a-haystack ) 是一個(gè)在大模型領(lǐng)域廣泛應(yīng)用的測試,用于評(píng)估大語言模型在處理長文本時(shí)識(shí)別特定事實(shí)的能力。為了評(píng)估LLMxMapReduce 框架在處理極長文本方面的表現(xiàn),研究人員將大海撈針測試的文本長度擴(kuò)展至1280K個(gè)token。

測試結(jié)果顯示全綠:

實(shí)驗(yàn)結(jié)果表明,采用 LLMxMapReduce 方法的 Llama3-70B-Instruct 能夠有效處理長度達(dá)到 1280K token 的序列,展示了該框架在處理超長序列時(shí)的卓越能力。

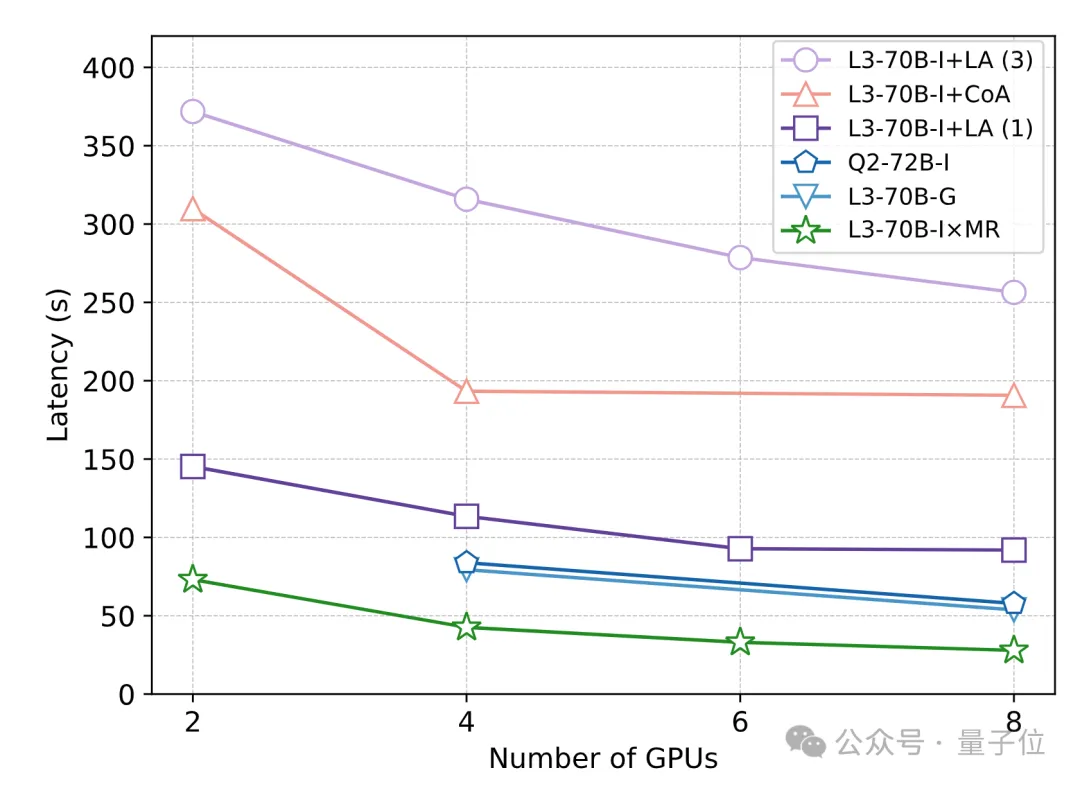

為了評(píng)估不同方法在處理長文本時(shí)的響應(yīng)速度,研究人員進(jìn)行了一項(xiàng)速度實(shí)驗(yàn),使用 20 個(gè)測試示例,每個(gè)示例包含128K個(gè)token。實(shí)驗(yàn)結(jié)果顯示,因?yàn)楦玫乩昧朔侄尾⑿校琇LMxMapReduce 的處理速度比 128K 模型標(biāo)準(zhǔn)解碼更快。

而且,由于結(jié)構(gòu)化通信協(xié)議和上下文置信度校準(zhǔn)機(jī)制不影響框架的并行推理,相比于LongAgent 和 Chain-of-Agents 這兩個(gè)同類型的分治框架,LLMxMapReduce 也具有明顯的速度優(yōu)勢(shì)。

論文鏈接:https://arxiv.org/pdf/2410.09342

Github鏈接:https://github.com/thunlp/LLMxMapReduce

InfiniteBench:https://github.com/OpenBMB/InfiniteBench?tab=readme-ov-file