Depth Any Video:開啟視頻深度估計新紀元

本篇分享論文Depth Any Video with Scalable Synthetic Data,基于多樣的仿真數據集和強大的視頻生成模型,Depth Any Video在真實視頻數據上展現了超強的泛化能力,并且在視頻深度一致性和精度上超越了之前所有生成式的深度估計方法!

論文鏈接:https://arxiv.org/abs/2410.10815

主頁鏈接:https://depthanyvideo.github.io

代碼鏈接:https://github.com/Nightmare-n/DepthAnyVideo

摘要

我們提出了一種新穎的視頻深度估計模型:Depth Any Video,它主要包含兩大關鍵創新: 1. 我們開發了一套可擴展的合成數據采集流程,從多樣化的虛擬環境中實時捕獲視頻深度數據,采集了約4萬段5秒長的視頻片段,每段都具有精準的深度標注。2. 我們利用強大的視頻生成模型的先驗來高效處理真實世界視頻,并集成了旋轉位置編碼和流匹配等先進技術,進一步增強靈活性和效率。 此外,我們引入了一種新穎的混合時長訓練策略,能夠在不同長度、不同幀率的視頻下表現出色。在推理階段,我們提出了一種深度插值方法,使模型能夠同時處理長達150幀的高分辨率視頻。我們的模型在深度一致性和精度方面均超越了之前所有的生成式深度估計方法。

動機

視頻深度估計是理解三維世界的基礎問題,在自主導航、增強現實和視頻編輯等具有廣泛的應用。現有的方法面臨的主要瓶頸在于缺乏多樣且大規模的視頻深度數據,導致模型在不同場景下難以有效泛化。為了解決這個問題,本文提出了兩大關鍵創新: ? 我們構建了一個大規模的合成視頻深度數據集,利用現代虛擬環境的高逼真視覺效果,從虛擬環境中提取大規模且精確的視頻深度數據,既具可擴展性又低成本。 ? 我們設計了一個全新的視頻深度估計框架,借助視頻生成模型的強大視覺先驗,提升對真實視頻的泛化能力。該框架引入混合時長訓練策略和深度插值模塊,確保模型能在不同視頻長度下保證深度估計的精確性和一致性。 我們的模型在生成式的深度估計方法中實現了最先進的性能,樹立了視頻深度估計的準確性和魯棒性的新標桿。

方法

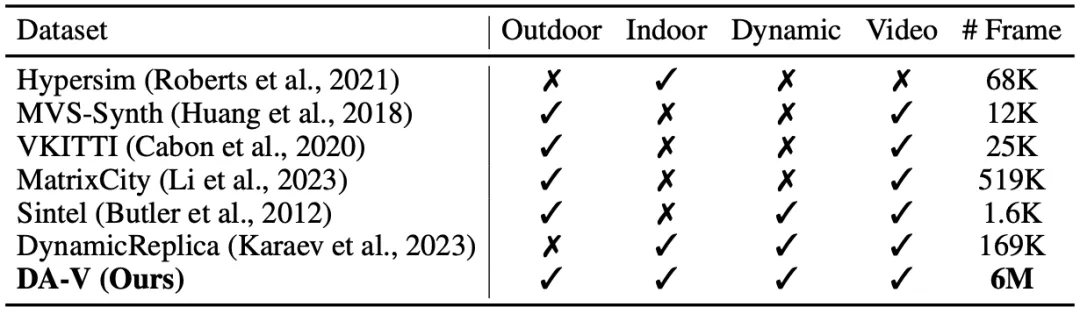

Game Data Workflow 實時數據收集:為解決深度數據的挑戰,我們收集了由40,000個視頻片段組成的大規模仿真數據集DA-V。該數據集主要通過先進的虛擬環境引擎生成逼真的環境,并提供準確的深度信息。我們在多款熱門虛擬環境中提取深度數據,并精心選擇以涵蓋廣泛的場景和環境條件,如:廣闊的城市景觀、細致的室內場景、豐富的動作場面,以及科幻的建筑設計。它不僅為我們提供精準的深度信息,還讓模型接觸多樣的光照條件、天氣效果和復雜的幾何結構,使得模型能夠泛化到真實環境中。在表1中,我們將DA-V與以往的公開仿真數據集進行了比較。據我們所知,這是目前覆蓋真實場景范圍最廣的合成視頻深度數據集。

數據過濾:在收集初始仿真視頻后,我們發現圖像與深度信息之間偶爾會出現不一致現象,例如:切換到菜單界面時。為過濾這些幀,首先使用場景切割方法檢測場景轉換。然后,利用在人工挑選的仿真數據子集上訓練過的深度估計模型過濾掉得分較低的視頻序列。然而,這種方法可能導致未見數據的過度過濾。因此,我們借助CLIP模型計算實際和預測深度之間的語義相似度,均勻抽取每個視頻片段的10幀。如果語義和深度得分的中位數均低于設定閾值,則移除該片段。

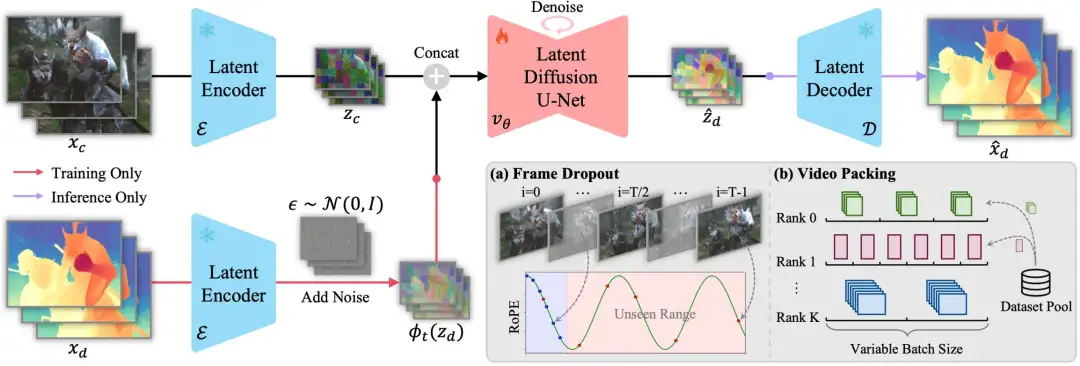

Generative Video Depth Model 模型設計:我們基于視頻生成模型Stable Video Diffusion (SVD),將深度估計框架轉化為條件去噪過程。整體框架如圖1所示,訓練流程包括一個前向過程,通過添加高斯噪聲逐步擾亂真實深度數據,然后將視頻作為條件輸入去噪模型進行反向去噪。一旦模型完成訓練,推理流程就從純噪聲開始,逐步去噪,逐步得到深度預測結果。與之前的擴散模型類似,該生成過程在變分自編碼器的潛空間中進行,使模型能處理高分辨率輸入而不犧牲計算效率。為了讓去噪器以輸入視頻為條件,我們也將視頻轉換到潛空間中,然后將其與潛空間下的深度逐幀連接,作為去噪模型的輸入。

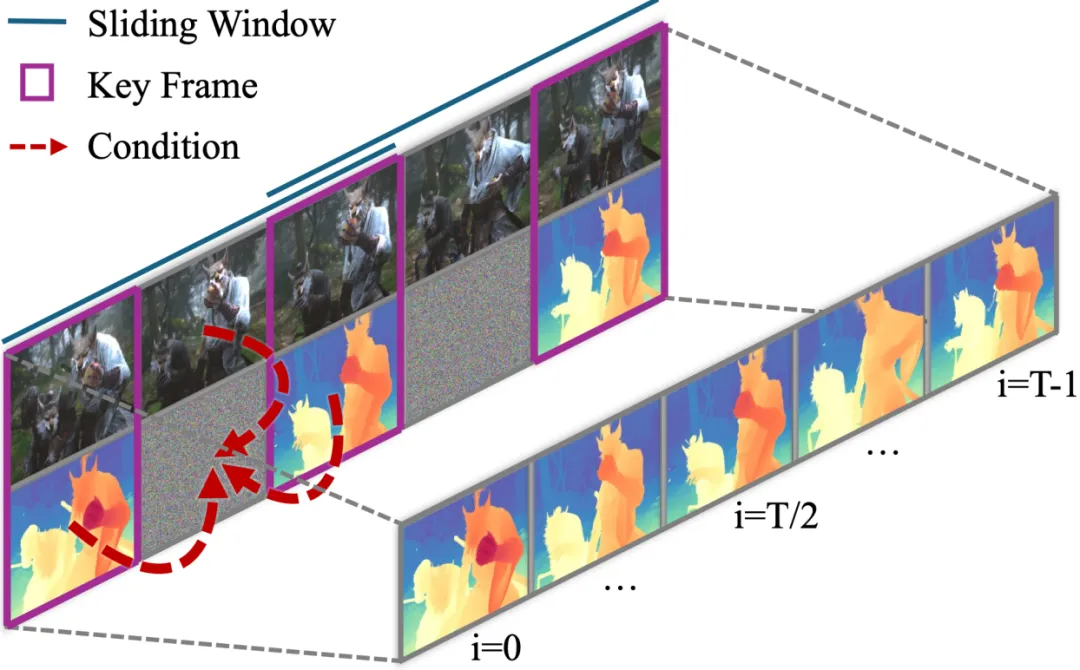

條件流匹配:為了加速去噪過程,我們將SVD中的去噪方法替換為條件流匹配。相比于原本的25步,新方法只需1步即可獲得滿意的深度預測結果。具體來說,我們通過高斯噪聲與數據之間的線性插值來建模數據加噪過程,然后通過預測速度矢量場和常微分方程來進行去噪求解。 混合時長訓練:為了增強模型在不同視頻長度下深度估計的泛化能力,我們采用了一種混合時長訓練策略,以確保對各種輸入的魯棒性。這一策略包括:幀丟棄數據增強(圖1a):提升長視頻序列的訓練效率,并通過旋轉位置編碼增強模型在長視頻下的泛化能力。視頻打包技術(圖1b):將相同長度、分辨率的視頻打包在同一個訓練批次中,優化變長視頻訓練過程中的內存使用。 長視頻推理:上述經過訓練的模型,在單個80GB A100 GPU上可同時處理分辨率為960 x 540的32幀視頻。為處理更長的高分辨率視頻序列,我們首先預測全局一致的關鍵幀,然后使用幀插值網絡生成關鍵幀之間的中間幀,以確保深度分布的尺度和偏移對齊。如圖2所示,我們將關鍵幀的預測結果與視頻序列同時作為幀插值網絡的條件輸入。

實驗結果

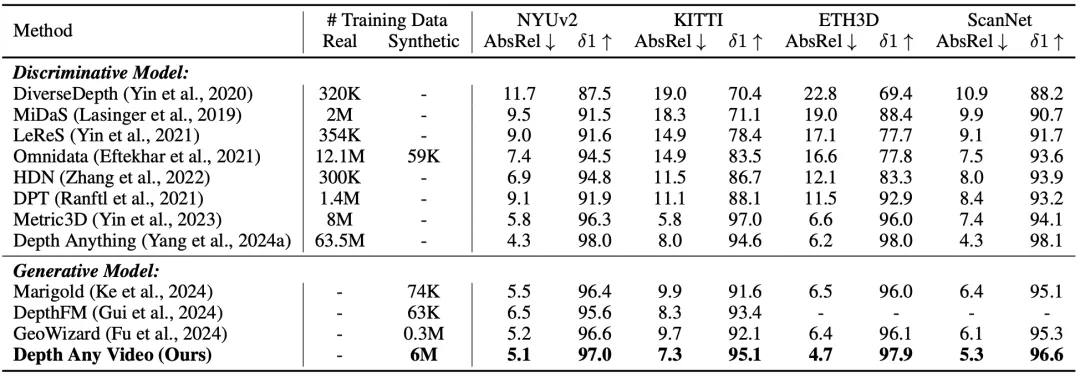

表2展示了我們的模型與當前最先進的單幀輸入的深度估計模型的性能比較。我們的模型在各個數據集上顯著超越了先前所有的生成模型,同時在某些情況下,其表現甚至優于之前的判別模型。

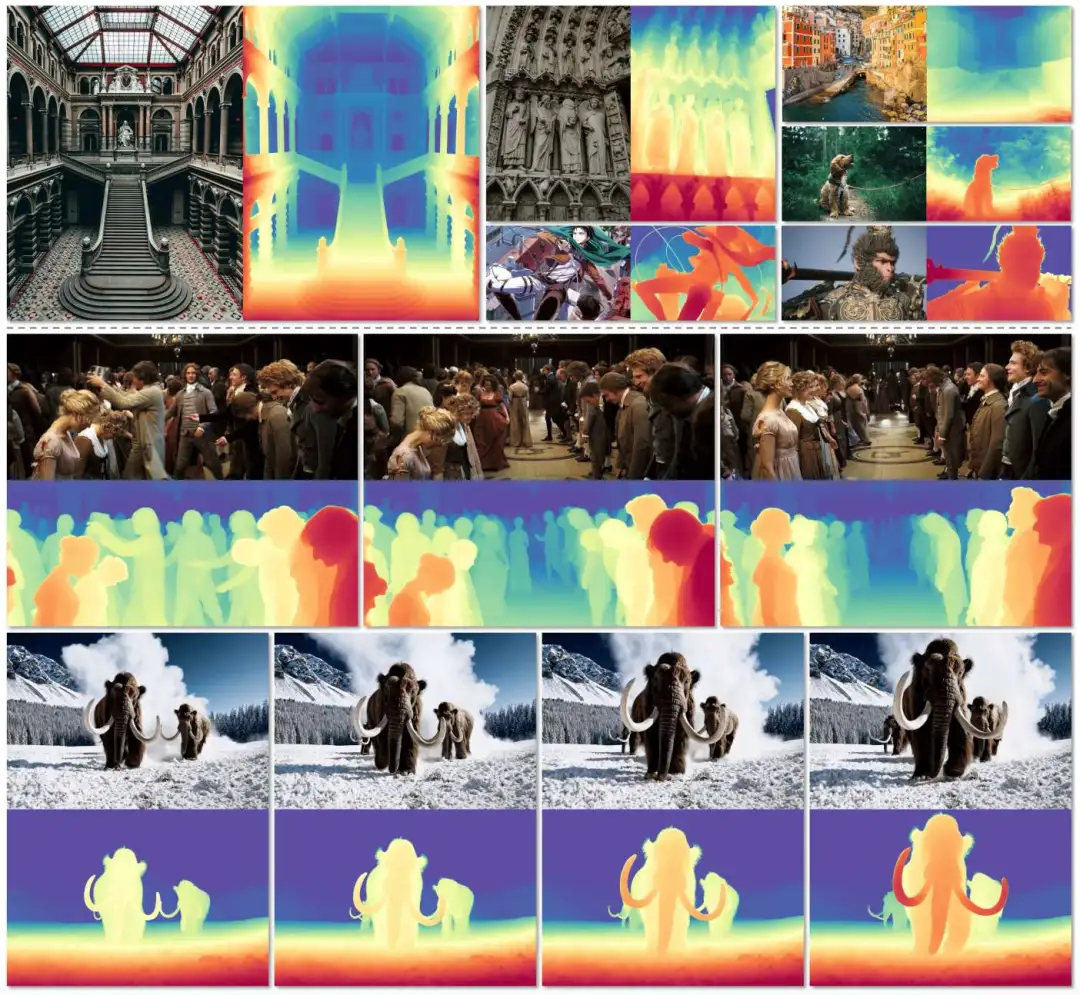

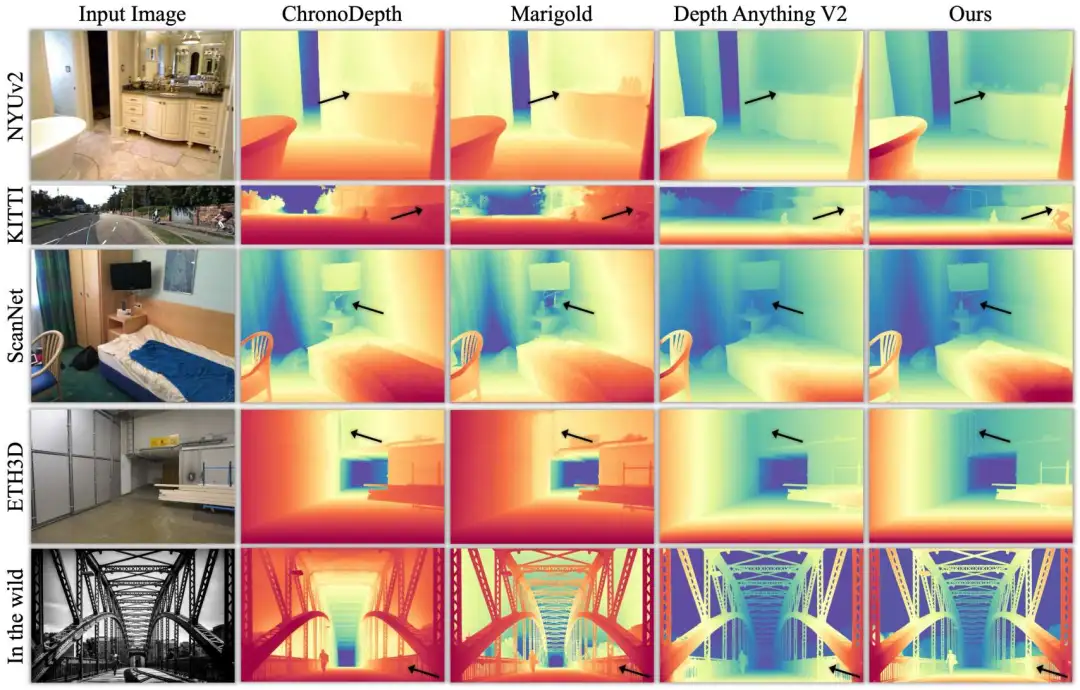

圖3展示了我們的模型在不同數據集下的可視化結果,我們的方法能夠捕捉細致的細節,并在自然環境數據上實現有效的泛化性。

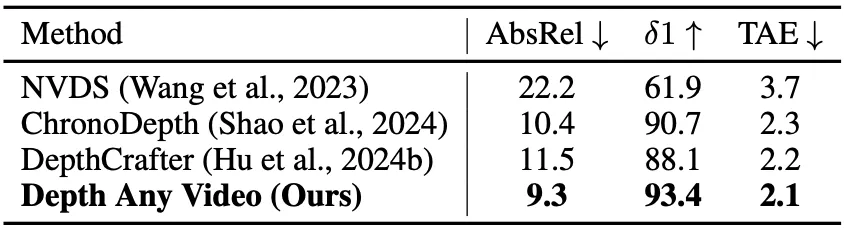

表3展示了我們的模型與之前的視頻深度估計模型的性能比較。我們的模型在ScanNet++數據集上展示了更好的時間一致性和預測精度,突顯其在視頻深度估計中的有效性。

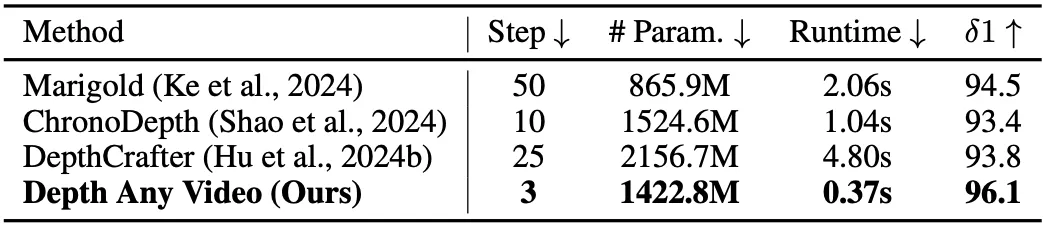

表4展示了與之前生成方法的性能和效率比較。我們的模型參數少于先前的視頻深度估計方法。此外,與所有的生成式深度估計方法相比,我們實現了更低的推理時間和更少的去噪步驟,同時獲得了更好的預測精度。

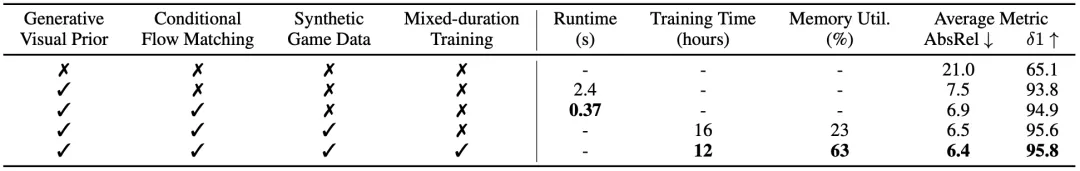

表5展示了所提模塊對模型測試時間、訓練時間、顯存利用率和平均精度的影響。可以看到,這些模塊均對各項指標產生了積極影響。