自動(dòng)化、可復(fù)現(xiàn),基于大語(yǔ)言模型群體智能的多維評(píng)估基準(zhǔn)Decentralized Arena來(lái)了

Maitrix.org 是由 UC San Diego, John Hopkins University, CMU, MBZUAI 等學(xué)術(shù)機(jī)構(gòu)學(xué)者組成的開(kāi)源組織,致力于發(fā)展大語(yǔ)言模型 (LLM)、世界模型 (World Model)、智能體模型 (Agent Model) 的技術(shù)以構(gòu)建 AI 驅(qū)動(dòng)的現(xiàn)實(shí)。Maitrix.org 此前成功開(kāi)發(fā)了 Pandora 視頻-語(yǔ)言世界模型、LLM Reasoners,以及 MMToM-QA 評(píng)測(cè)(ACL 2024 Outstanding Paper Award)。

研究者們已經(jīng)并陸續(xù)構(gòu)建了成千上萬(wàn)的大規(guī)模語(yǔ)言模型(LLM),這些模型的各項(xiàng)能力(如推理和生成)也越來(lái)越強(qiáng)。因此,在多樣的應(yīng)用場(chǎng)景中對(duì)其進(jìn)行性能基準(zhǔn)測(cè)試已成為了一項(xiàng)重大挑戰(zhàn)。目前最受歡迎的基準(zhǔn)測(cè)試是 Chatbot Arena,它通過(guò)收集用戶對(duì)模型輸出的偏好來(lái)對(duì) LLM 進(jìn)行綜合排名。然而,隨著 LLM 逐漸落地于眾多應(yīng)用場(chǎng)景,無(wú)論是針對(duì)工業(yè)生產(chǎn)目標(biāo),還是科學(xué)場(chǎng)景輔助需求,評(píng)估 LLM 在精細(xì)化維度上的能力都是至關(guān)重要的,例如:

- 數(shù)學(xué)及其專門(mén)分支領(lǐng)域,如代數(shù)、幾何、概率和微積分。

- 不同類型的推理能力,例如符號(hào)推理、類比推理、反事實(shí)推理和社會(huì)推理。

- 不同編程語(yǔ)言的編碼能力,如 Python、C++、JavaScript 和 SQL。

- 各種科學(xué)領(lǐng)域,如物理學(xué)、生物學(xué)和化學(xué)。

- 以及任何與開(kāi)發(fā)者實(shí)際應(yīng)用相關(guān)的具體問(wèn)題。

如此大規(guī)模且精細(xì)化(甚至定制化)的評(píng)估對(duì)于依賴于人群眾包的 Chatbot Arena 或類似的基準(zhǔn)測(cè)試來(lái)說(shuō)是一大挑戰(zhàn) —— 在成百上千個(gè)維度上為數(shù)千對(duì)模型(或數(shù)萬(wàn)對(duì)模型)收集足夠的用戶投票是不切實(shí)際的。此外,由于人類查詢和投票過(guò)程存在噪聲以及個(gè)人主觀因素,評(píng)估結(jié)果往往難以復(fù)現(xiàn)。

最近,研究者們還探索了其他的自動(dòng)評(píng)估方案,通過(guò)選擇一個(gè)(或幾個(gè))“最強(qiáng)” 模型(通常是 GPT-4)作為評(píng)委來(lái)評(píng)估所有其他模型。然而,評(píng)委模型可能存在偏見(jiàn),例如更傾向于選擇與其自身風(fēng)格相似的輸出。基于這種評(píng)估進(jìn)行模型優(yōu)化可能會(huì)導(dǎo)致所有模型過(guò)度擬合 GPT-4 的偏見(jiàn)。

為了結(jié)合這兩種方案的優(yōu)勢(shì),通過(guò)利用 “群體智能”(Chatbot Arena 依賴于人群智慧)來(lái)實(shí)現(xiàn)更穩(wěn)健且更少偏見(jiàn)的評(píng)估,同時(shí)使該過(guò)程自動(dòng)化且可擴(kuò)展到多維度能力比較,Maitrix.org 發(fā)布了 Decentralized Arena。

- 原文地址: https://de-arena.maitrix.org

- Leaderboards: https://huggingface.co/spaces/LLM360/de-arena

圖 1 展示了這些基準(zhǔn)測(cè)試范式之間的主要區(qū)別。Decentralized Arena 的核心理念是利用所有 LLM 的集體智能進(jìn)行相互評(píng)估和比較。這形成了一個(gè)去中心化、民主化的系統(tǒng),在該系統(tǒng)中,所有被評(píng)估的 LLM 同時(shí)也是能夠評(píng)估其他模型的評(píng)審者,與依賴于中心化的 “權(quán)威” 模型作為評(píng)審相比,Decentralized Arena 能夠?qū)崿F(xiàn)更公平的排名。

圖 1:Open-ended 場(chǎng)景下 LLM 評(píng)估的不同范式,Decentralized Arena 結(jié)合了兩者的優(yōu)點(diǎn),即去中心化與自動(dòng)化。

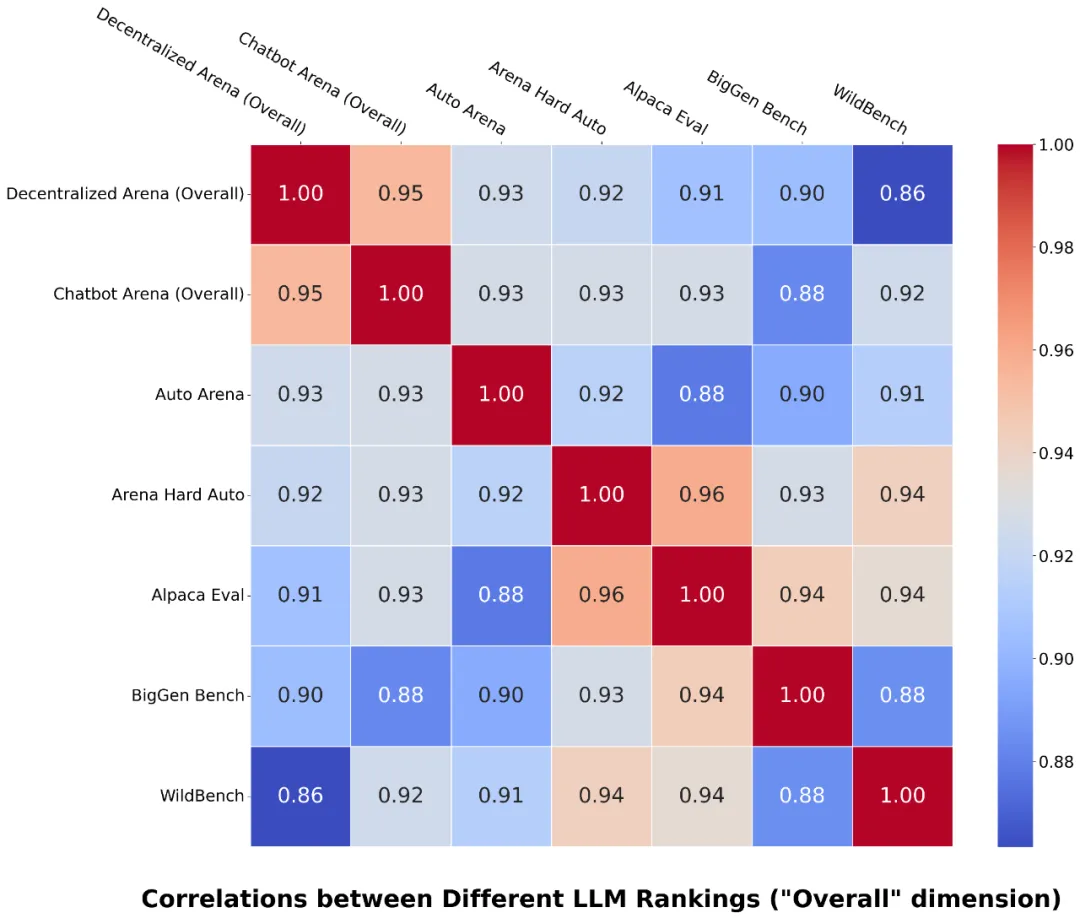

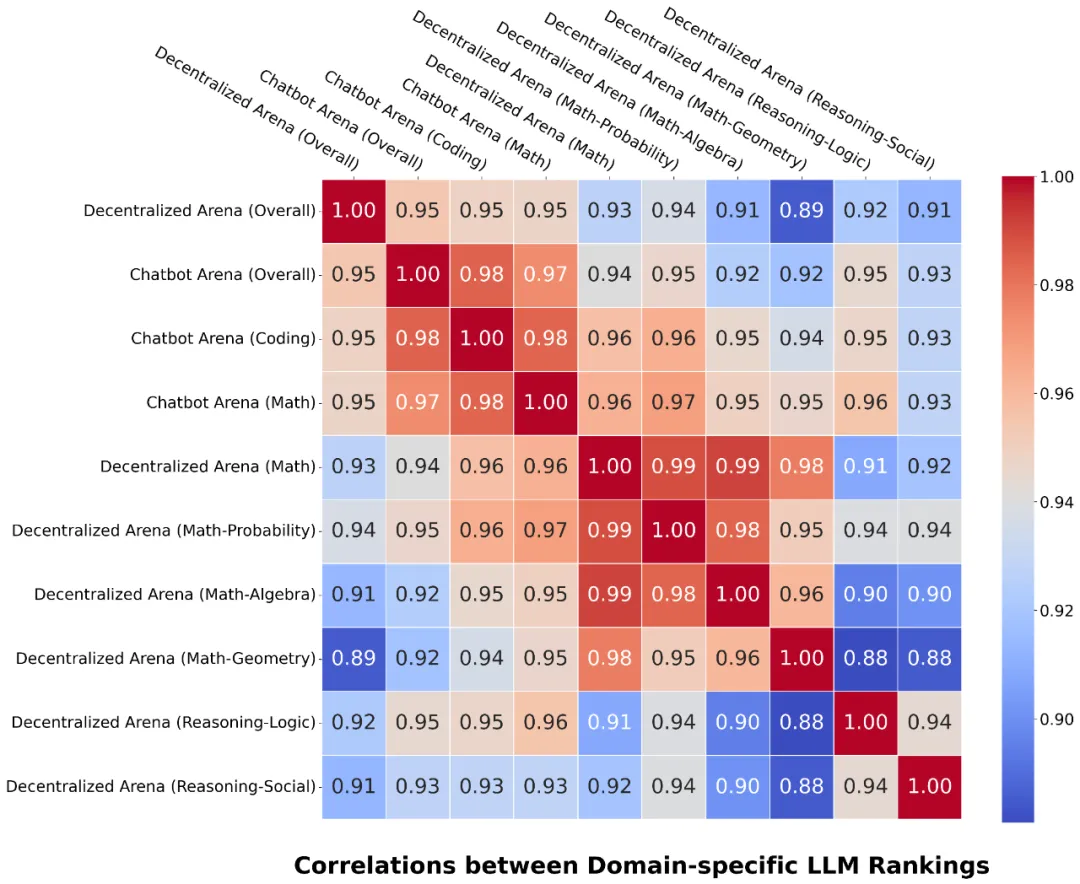

圖 2:Decentralized Arena 與 Chatbot Arena 的 “整體” 排名表現(xiàn)出最強(qiáng)的相關(guān)性。

Decentralized Arena 的關(guān)鍵優(yōu)勢(shì)包括:

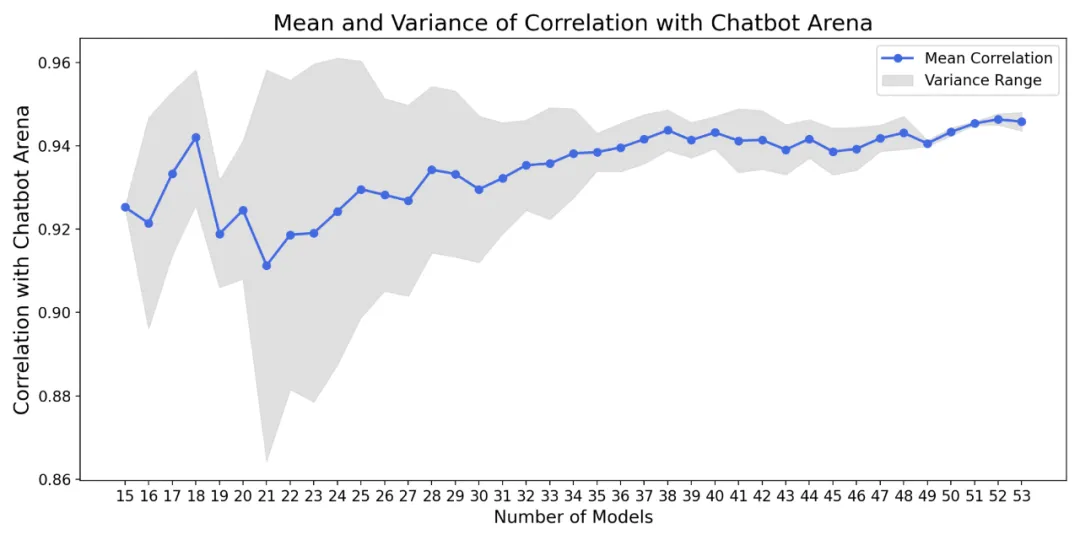

- 穩(wěn)健且無(wú)偏:去中心化避免了單個(gè)或少數(shù)評(píng)委模型所帶來(lái)的偏見(jiàn),并且不容易通過(guò)過(guò)擬合評(píng)委模型進(jìn)行操控。參與競(jìng)技場(chǎng)的 LLM 越多,評(píng)估越穩(wěn)健(圖 4)。此外,Decentralized Arena 在 50 多個(gè)模型的 “整體” 維度上與 Chatbot Arena 達(dá)到了非常高的相關(guān)性(95%,圖 2)。

- 自動(dòng)化、易于擴(kuò)展且可定制到任何評(píng)估維度:由于用戶投票的數(shù)量有限,Chatbot Arena 只能評(píng)估少數(shù)維度,而 Decentralized Arena 由于完全自動(dòng)化的設(shè)計(jì),其能夠擴(kuò)展到無(wú)限的評(píng)估維度,并且還提供了自動(dòng)選擇特定維度問(wèn)題以實(shí)現(xiàn)定制化評(píng)估的方案。

- 快速、即時(shí)的新模型排名:同樣,由于自動(dòng)化和高效的二分搜索排名算法,Decentralized Arena 能夠即時(shí)獲得新模型的評(píng)估結(jié)果,無(wú)需等待數(shù)周以收集用戶投票。

- 透明且完全可復(fù)現(xiàn):所有算法、實(shí)現(xiàn)和輸入 / 輸出都會(huì)公開(kāi),使得結(jié)果完全可復(fù)現(xiàn)。

- 值得信賴:憑借其穩(wěn)健性、與現(xiàn)有人類評(píng)估結(jié)果的高度一致性、精細(xì)的維度分析以及透明度,Decentralized Arena 最終旨在提供一個(gè)值得社區(qū)信賴的基準(zhǔn)。

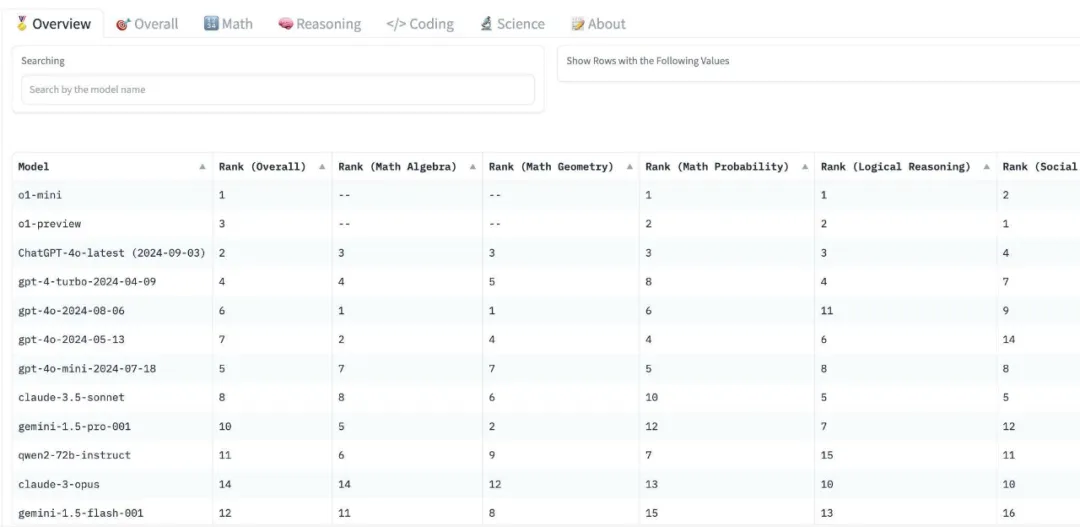

圖 3 展示了最終排行榜的截圖。研究團(tuán)隊(duì)正在繼續(xù)添加更多的模型和維度,歡迎來(lái)自社區(qū)的貢獻(xiàn)和提交!

圖 3:Decentralized Arena 排行榜,包括不同維度的排名。

方法:通過(guò)大語(yǔ)言模型的群體智能進(jìn)行基準(zhǔn)測(cè)試

去中心化的概念是通過(guò)讓所有 LLM 充當(dāng)評(píng)審,對(duì)每一對(duì)模型(即決定哪個(gè)模型的輸出 “獲勝”,類似于 Chatbot Arena 中的人類評(píng)審)進(jìn)行投票。一個(gè)簡(jiǎn)單的做法是讓每個(gè)模型對(duì)所有其他模型對(duì)進(jìn)行投票,其復(fù)雜度為 O (n^3*k),其中 n 是模型數(shù)量,k 是查詢數(shù)量。當(dāng) n 和 k 都很大時(shí),這種方法的速度會(huì)非常慢。因此,研究團(tuán)隊(duì)設(shè)計(jì)了一種基于增量排名、二分搜索插入和由粗到精調(diào)整的更高效的方法。

該研究從一小組 “種子” 模型(例如 15 個(gè))開(kāi)始,利用上述簡(jiǎn)單方法迅速對(duì)它們進(jìn)行排名。然后,其他模型一個(gè)接一個(gè)地通過(guò)粗篩和精排的步驟被增量插入到排名列表中。排名列表中的所有模型都將作為評(píng)審幫助新模型找到其位置。視頻 1 說(shuō)明了這一過(guò)程。

視頻 1: 演示大語(yǔ)言模型插入過(guò)程。

- 步驟 1: 基于二分搜索插入的粗略排名。該步驟旨在找到新模型在當(dāng)前排名中的大致位置,其核心思想是使用二分搜索快速縮小位置范圍。在比較新模型與現(xiàn)有模型時(shí),排名中的其他模型將作為評(píng)審,該二分搜索的時(shí)間復(fù)雜度為 O (k*n*logn)。

- 步驟 2: 窗口內(nèi)精細(xì)排名和滑動(dòng)。為了進(jìn)一步細(xì)化新模型的排名,該研究將它與排名中相鄰的模型進(jìn)行比較(例如,排名中前后兩個(gè)模型)。這些相鄰的 LLM 往往是最難區(qū)分的,因此需要進(jìn)行更細(xì)致的比較。窗口外的所有其他模型將作為評(píng)審,如果窗口內(nèi)的比較導(dǎo)致新模型的位置發(fā)生變化,則在更新后的窗口內(nèi)重復(fù)該過(guò)程,直到排名穩(wěn)定下來(lái)。此過(guò)程類似于一個(gè)滑動(dòng)窗口,指導(dǎo) LLM 群體關(guān)注最具模糊性的 LLM 比較對(duì),確保精確排名并最小化計(jì)算成本。

在上述排名過(guò)程中,該研究收集了模型的成對(duì)比較結(jié)果,然后使用 Bradley-Terry (BT) 方法來(lái)估計(jì)每個(gè)模型在排名中的得分。這些得分用于在模型作為評(píng)審時(shí)賦予它們不同的權(quán)重 —— 得分較高的模型在評(píng)估其他模型對(duì)時(shí)影響更大(該研究還使用了其他簡(jiǎn)單的加權(quán)方法,例如基于模型排名的線性遞減權(quán)重,這將在即將發(fā)布的技術(shù)報(bào)告中進(jìn)一步討論)。這些得分在整個(gè)排名過(guò)程中會(huì)自動(dòng)調(diào)整,最終得分在排名完成時(shí)確定。

去中心化評(píng)估系統(tǒng)的一個(gè)關(guān)鍵優(yōu)勢(shì)是,隨著更多模型的參與,排名將變得更加穩(wěn)定,如圖 4。

圖 4: 隨著模型數(shù)量的增加,排名中的方差(陰影區(qū)域)逐漸減小,表明排名變得越來(lái)越穩(wěn)健。

通過(guò)將上述自動(dòng)化評(píng)估方法應(yīng)用于多個(gè)評(píng)估維度,以獲得流行 LLM 的精細(xì)排名 (參見(jiàn)排行榜頁(yè)面)。

該方法與依賴大量人工評(píng)審的 Chatbot Arena 取得了高度的相關(guān)性(“整體” 維度的相關(guān)性為 95%)。圖 2 和圖 5 展示了這些相關(guān)性,表明 Decentralized Arena 優(yōu)于其他流行的基準(zhǔn)測(cè)試,并展示了不同維度的排名之間的關(guān)系。

圖 5: 不同維度排名之間的相關(guān)性 (底部)。

構(gòu)建自定義維度:選擇高價(jià)值問(wèn)題集

Decentralized Arena 的另一個(gè)關(guān)鍵優(yōu)勢(shì)是其可擴(kuò)展性,以便于增加任意新評(píng)估維度對(duì) LLM 進(jìn)行基準(zhǔn)測(cè)試。用戶可以輕松地為自己關(guān)心的新維度創(chuàng)建排名。作為演示,該研究為數(shù)學(xué)、推理、科學(xué)和編程等多個(gè)維度創(chuàng)建了維度排名 (排行榜)。

要為新維度建立排名,需要為該維度準(zhǔn)備一組問(wèn)題集,然后在此問(wèn)題集上對(duì) LLM 進(jìn)行比較。對(duì)于某一新維度(例如數(shù)學(xué) - 代數(shù)),需要先從各種相關(guān)的開(kāi)源數(shù)據(jù)集中提取并合并了一個(gè)大型初始問(wèn)題集,然后進(jìn)一步從中抽取少量核心問(wèn)題以實(shí)現(xiàn)高效排名。最簡(jiǎn)單的方法是從初始問(wèn)題集中隨機(jī)抽取問(wèn)題,其抽取的問(wèn)題越多,最終排名就越穩(wěn)定。

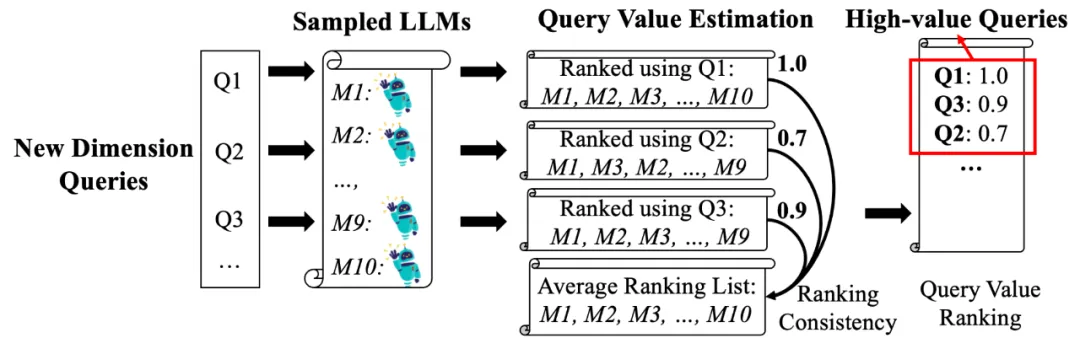

為了在較少的問(wèn)題集下獲得穩(wěn)定的排名(從而提高排名效率),該研究還設(shè)計(jì)了一種新的自動(dòng)問(wèn)題集選擇的方法,如圖 6 所示。其核心思路是利用 LLM 的群體智能選擇出能夠在一小組 LLM 上產(chǎn)生一致排名的問(wèn)題集,研究團(tuán)隊(duì)將在即將發(fā)布的技術(shù)報(bào)告中介紹更多細(xì)節(jié)。

圖 6: 新維度的自動(dòng)查詢選擇。

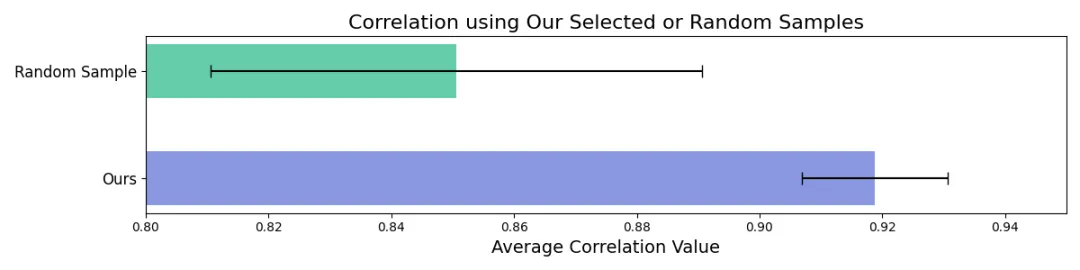

圖 7 顯示,其查詢選擇方法比隨機(jī)查詢抽樣產(chǎn)生了更好且更一致的排名。

圖 7: 使用其方法選擇的問(wèn)題集比隨機(jī)抽樣的問(wèn)題集實(shí)現(xiàn)了更高的相關(guān)性和更低的方差。

更多的結(jié)果

該研究做了更多的分析來(lái)以深入理解 Decentralized Arena 的結(jié)果。

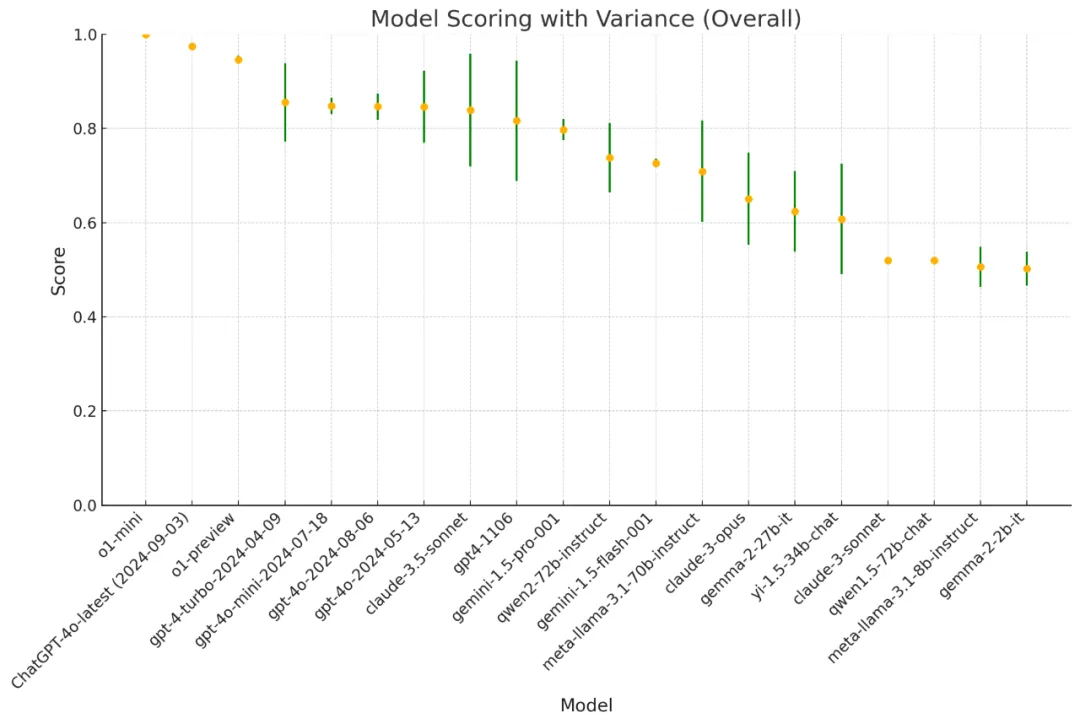

圖 8 展示了排名中 LLM 的得分及其置信區(qū)間。

圖 8: LLM 的得分和置信區(qū)間。

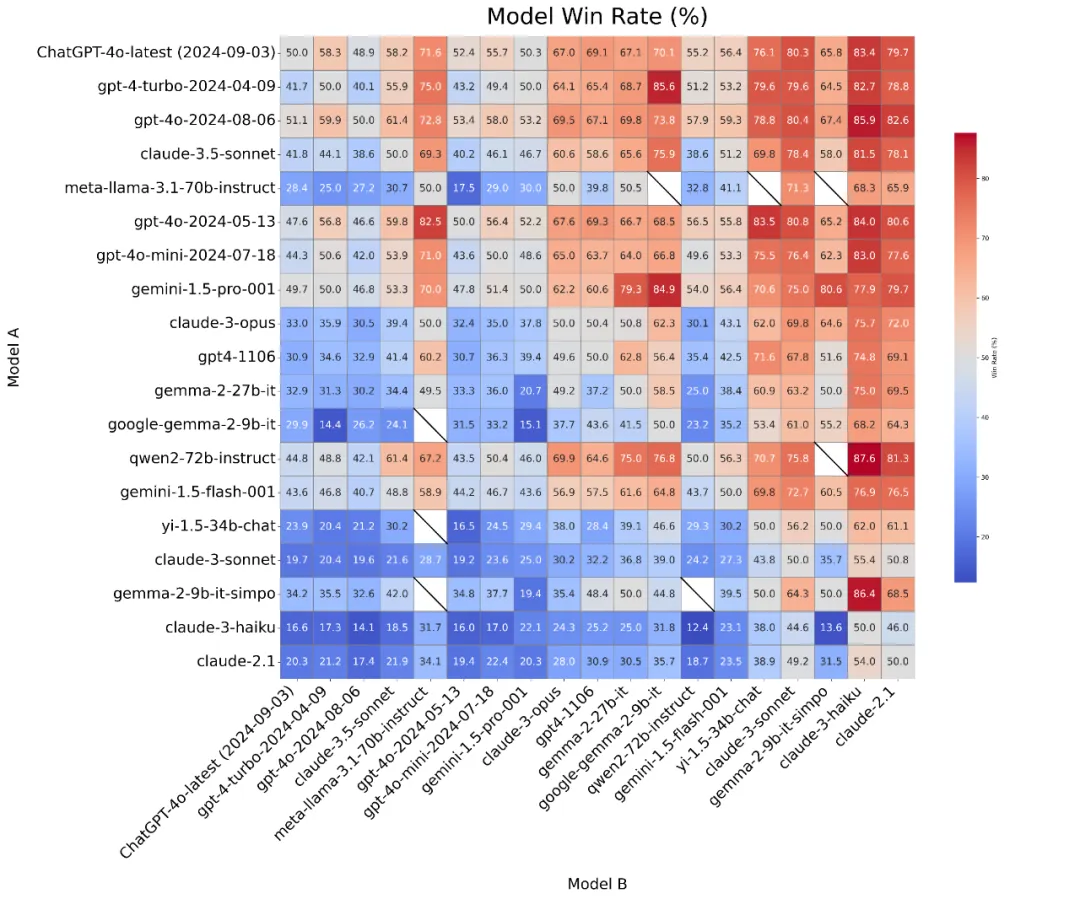

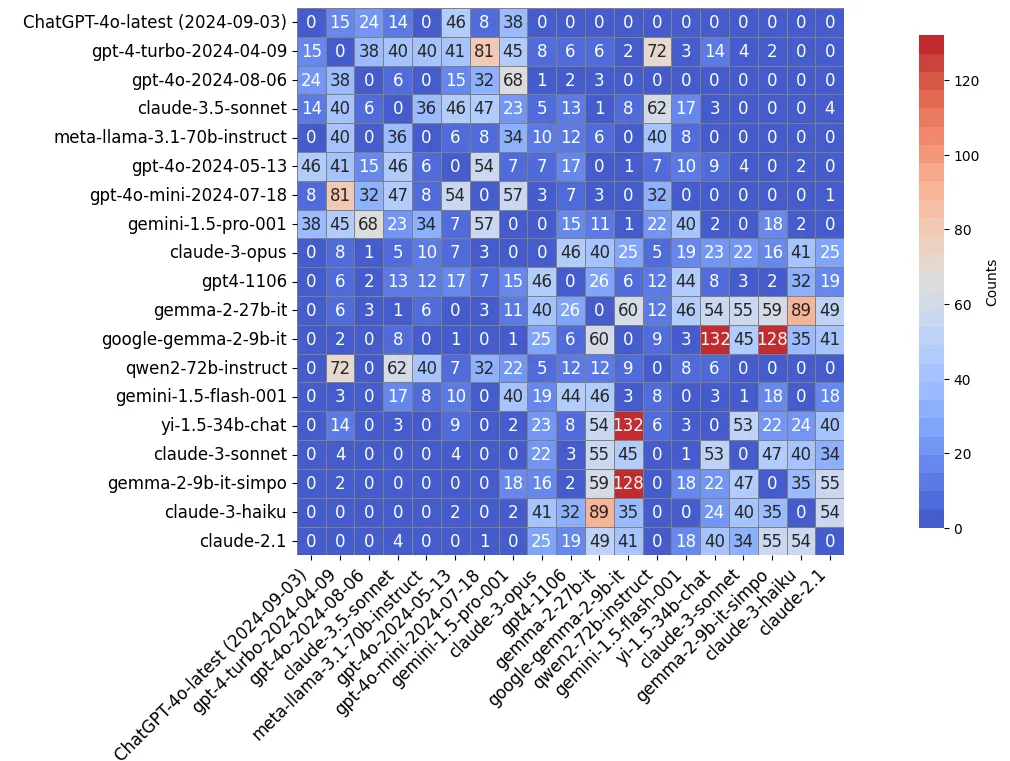

該研究對(duì)排名過(guò)程中每一對(duì) LLM 的勝率和比較次數(shù)分布進(jìn)行了可視化處理(“Overall” 維度)。

如圖 9 和圖 10 所示,LLM 的群體智能自動(dòng)集中在難以區(qū)分的鄰近 LLM 對(duì)上(在圖 10 中靠近對(duì)角線的模型,或在圖 9 中勝率接近 50% 的模型)。相比之下,性能差距較大的 LLM 之間的比較較為稀少(甚至被省略),從而降低了整體計(jì)算成本。

圖 9: 勝率分布圖。

圖 10: 對(duì)比次數(shù)分布圖。