52萬張GPU集群塞進一個「盒子」?AI神器破解百模爭霸困局!

如今,快速靈活地獲取算力可謂是剛需,就連OpenAI也不例外。

最近,The Information爆料:曾經約定微軟是獨家云服務器供應商的OpenAI,已經開始找其他家要買算力了。

原因就在于,微軟提供算力的速度太慢了!

OpenAI既想要微軟提供更先進、算力更強的GPU集群,又要他們加快建設進度。

但微軟的計劃是,在明年年底之前為OpenAI提供約30萬塊英偉達GB200。

于是,OpenAI找到了甲骨文,開始洽談一個預計可在2026年中獲得幾十萬塊英偉達AI芯片的數據中心項目。

無獨有偶,在算力需求這一塊,國內智能算力的年復合增長率預計也將達到33.9%。

但在更進一步的大模型落地上,相比起只缺算力的OpenAI,國內的企業則面臨著更多的挑戰,比如算力資源管理困難、模型微調復雜等等。

模型算力太多元,產業生態太離散

根據賽迪研究院的數據,2023年我國生成式人工智能企業采用率達15%,市場規模約14.4萬億元。

另一方面據公開數據顯示,2023年全年,國內市場對大模型公開招投標的項目只有不到200家,金額5個多億;而到了2024年,僅上半年的項目就達到了486個,金額13個多億。

其中,軟件的占比在2023年為11%,而2024年上半年卻只有5%。相比之下,大模型相關服務則從去年的17%暴漲到今年上半年的30%。也就是說,企業對大模型硬件和服務的需求,基本占了90%以上。

對比可以發現,模型應用和市場趨勢之間,存在著巨大的鴻溝。

造成這一現象的原因,首先,就是大模型的幻覺問題。

大模型在預訓練階段所用的知識是通用為主,但在企業的專業領域中,如果還是以算概率來驅動的方式生硬輸出,就會答非所問。

第二,要實現大模型與行業場景的深度結合,應用開發流程復雜,應用門檻高。

微調、RAG都要分多個子步驟,應用開發還需要不同專業團隊長期協作,研發難度大,耗時也很長。

第三,在不同場景下,不同業務對模型能力有多樣需求,比如推理速度快、生成精度高、函數和代碼能力強。

由于業務生成環境往往的多模并存,使用的算力資源也是多元并用的。多模和多元的適配問題,常需要軟件整個重構,難度大,成本高。

此外,在產業生態上,從芯片到軟件框架,再到模型本身,不同廠商的產品數據源不同、技術標準不一,很難統一適配。

在本地化的大模型應用生成與落地中,這些挑戰會更加顯著。

如何才能讓企業(尤其是傳統企業)的大模型應用迅速落地?

這時,業內迫切地需要高效、易用、端到端的軟硬一體化解決方案,來支撐大模型行業落地。

如果有這樣一種開箱即用的產品,無論是模型本身、應用開發,還是算力問題,都能迎刃而解。

算力即得

針對這些痛點,浪潮信息推出了堪稱AI應用開發「超級工作臺」的元腦企智EPAI一體機。

從算力、平臺,到服務,提供了一站式大模型開發平臺。

面向真實場景,平臺提供了數據處理工具、模型微調工具、增強知識檢索工具、應用開發框架等。

而根據不同模型的能力特點,平臺還支持調用多模態算法和多元算力。

最強AI算力平臺

為了覆蓋不同的需求,一體機共有5種規格——基礎版、標準版、創新版、高級版、集群版。

總的來說,元腦企智EPAI一體機具備了卓越的算力性能和極致的彈性架構,可支持延時RDMA網絡和高性能并行存儲。

它們通過分布式并行加速、混合精度計算、高性能算子技術,提升了模型的訓練和推理速度,實現應用高并發高能效處理、業務快速上線的需求。

在訓練穩定性方面,元腦企智EPAI一體機專為LLM訓練微調優化提供了斷點續訓能力,為大模型訓練保駕護航,優化升級算力池化與分配策略,支持按需彈性擴縮容。

接下來,分別看下五個一體機不同的特點。其中,創新版、高級版和集群版均能同時支持訓練和推理。

- 面向模型推理的基礎版配備了8塊4090D GPU,性價比最高

- 標準版則搭載了基于Hopper架構的HGX模塊化AI超算平臺,8顆GPU通過NVlink高效互聯

- 創新版可以為多元算力提供深度適配

- 高級版專為那些對算力有極高需求的客戶而定制,并且提供了訓推全流程自動化開發測試工具鏈

- 集群版,顧名思義就是機柜級的訓推一體機——為那些業務規模較大,有分期建設、按需擴展需求的企業所定制的最高配

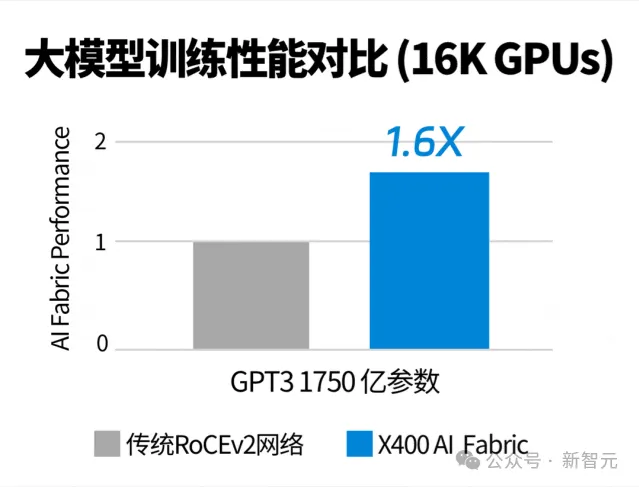

值得一提的是,在網絡單元上,集群版配備了浪潮信息自研的「大模型專用交換機」——超級AI以太網交換機X400。

它最高能夠擴展到524,288張GPU的超大規模AI算力系統,而且憑借AR自適應路由、端到端擁塞控制、亞毫秒級故障自愈等技術,性能提升至傳統RoCE網絡的1.6倍。

由此,大型集群實現了超高吞吐量、高可擴展性和超高可靠性。在LLM訓練性能提升同時,也大幅縮短訓練時長、降低訓練成本。

除了硬件上的創新之外,所有的一體機也全部預置了元腦企智(EPAI)大模型開發平臺。

這種軟硬一體化交付,正是浪潮信息一體機最大優勢所在。

開箱即用

有了元腦企智EPAI,浪潮信息的一體機才能為企業客戶們,提供開箱即用的能力。

更具體地講,元腦企智EPAI是專為企業AI大模型應用,高效、易用、安全落地而打造的端到端開發平臺。

從數據準備、模型訓練、知識檢索、應用框架等工具全面涉及,而且還支持調度多元算力和多元模型。

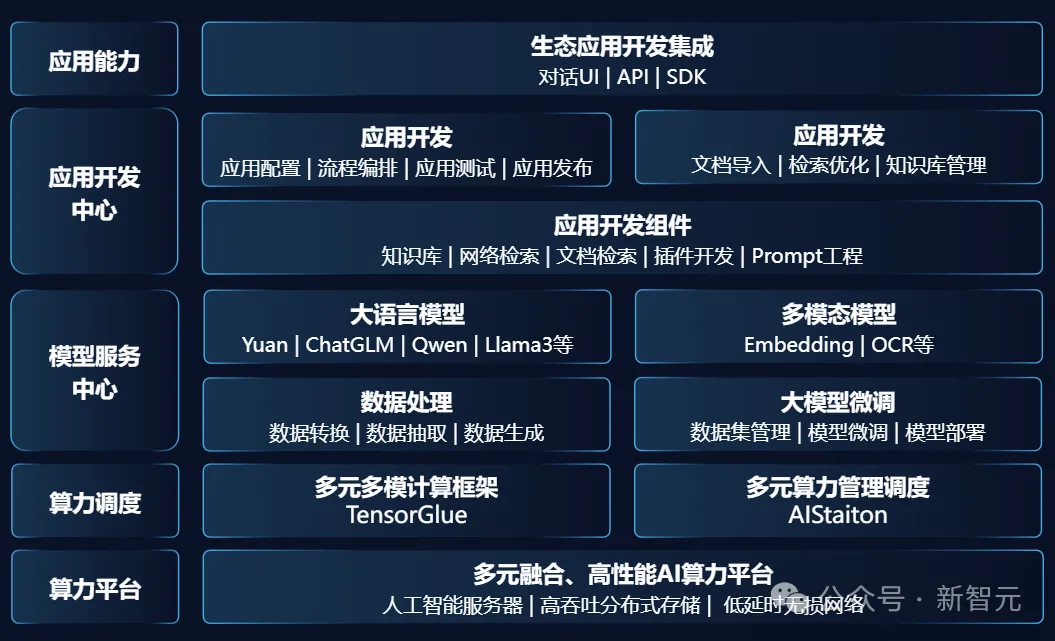

元腦企智EPAI的完整架構

多元多模

首先,元腦企智EPAI平臺最核心的一部分是,平臺底座能夠適配多元多模的基礎設施。

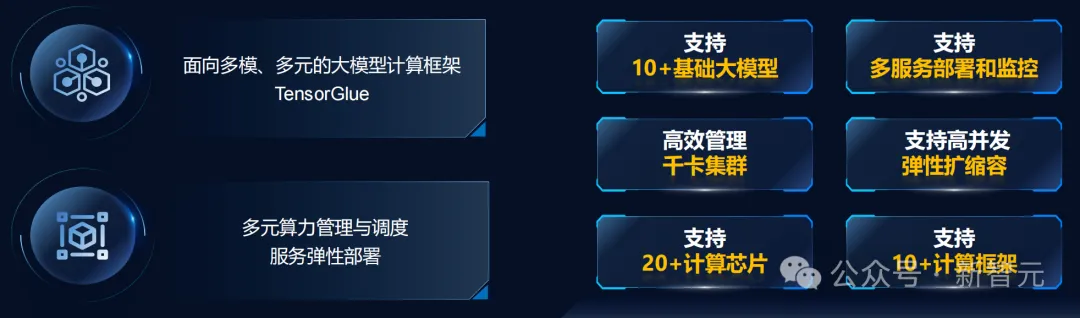

多元多模計算框架TensorGlue

多模是指,支持多種模型和多種計算框架。

其中,預置了Yuan2.0、Baichuan2、ChatGLM3、Qwen1.5、GLM4、Llama3等7個基礎大模型,以及應用DEMO樣例。

還有10+計算框架(MegtronLM、DeepSpeed、Pytorch、Transformer、Llamafactory、Fastchat等),以及多種微調能力,如監督微調、直接偏好優化、人類反饋強化學習等。

同時,它還能廣泛支持主流基礎大模型結構,支持與用戶自研模型的靈活適配和對接。

多元算力管理調度AIStation

而AIStation的作用在于,能夠對支持超數千節點的AI服務器。

它可以進行異構算力集群的統一池化管理,通過自適應系統將訓練底層的計算、存儲、網絡環境實現自動化配置。

從開發、訓練、微調,再到應用部署,EPAI能夠實現全生命周期監管和異常全自動化處理。

而且針對不同業務場景,設備故障自動容錯,保證業務時長高效、穩定運行。

簡單易用

一體機的簡單易用,便體現在了數據準備/生成、微調訓練、推理部署中,全部實現自動化。

從企業大模型開發部署業務流程來看,具備通用知識的LLM,就像剛畢業的大學生一樣,需要學習企業知識。

因此,第一步數據最關鍵。

高質量數據自動生成

當前互聯網訓練數據遠遠不足,尤其是專業化的數據,而AI數據生成恰好能彌補這一弊端。

高質量數據,才是保障AI模型應用效果的第一要素。

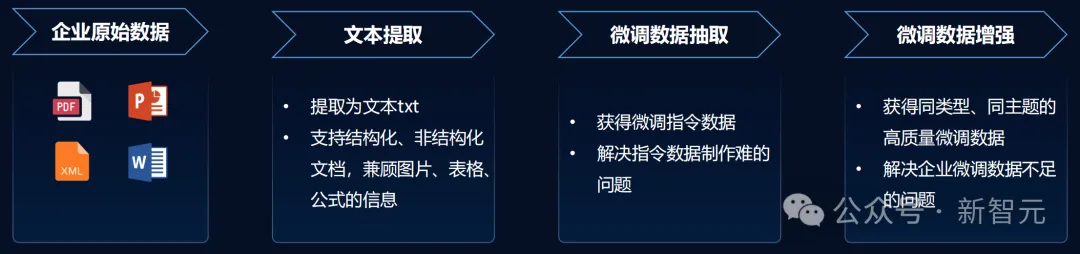

那么企業如何在種類多樣、規模龐大數據庫中,生成微調數據,并減少處理成本?又該如何將專業化數據為模型所用?

元腦企智EPAI平臺通過高質量數據生成,攻破了難題。

企業僅需將原始數據上傳,元腦企智EPAI將其提取為文本txt,各種結構化/非結構化文檔均可支持。

然后利用大模型生成問題答案對,也就是可以直接微調使用的數據。

最后一步通過「微調數據增強」讓AI再自動生成同類型、同主題高質量微調數據。

這一過程,還會對數據抽取后,進行向量編碼。

舉個栗子,「Apple」會被編碼成很長一個向量,其中含了很多豐富的語義信息。它可能代表水果一類,也可能代表蘋果公司等等。

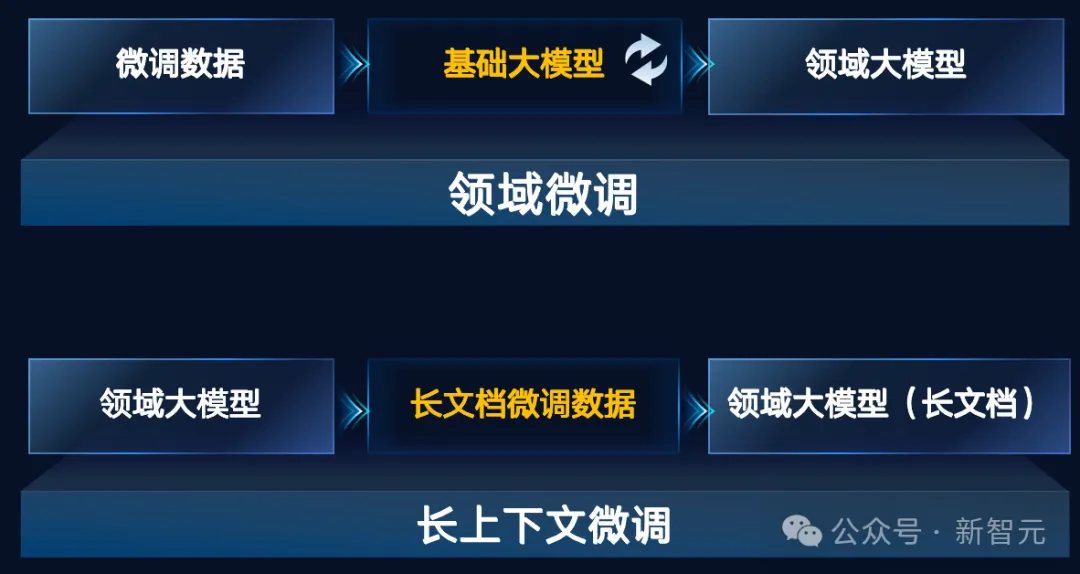

全鏈路微調訓練工具

有了數據,接下來就要微調模型了。

好在元腦企智EPAI平臺對LLM微調時所需的環境、框架、配置代碼等一系列流程,完成了封裝。

開發者無需動手寫代碼,就能微調出領域大模型。

從數據導入、訓練參數配置、資源類型配置等均由平臺自動管理,大幅提升微調任務的效率。

訓練微調完成后,模型部署和上線也是由元腦企智EPAI接手,還提供了多種評估的方式。

總之,高效的數據處理工具,支持微調數據自動生成和擴展,為模型微調訓練提供豐富數據源;豐富、完整的模型訓練工具,支持SFT優化方式,訓練之后支持一鍵部署。

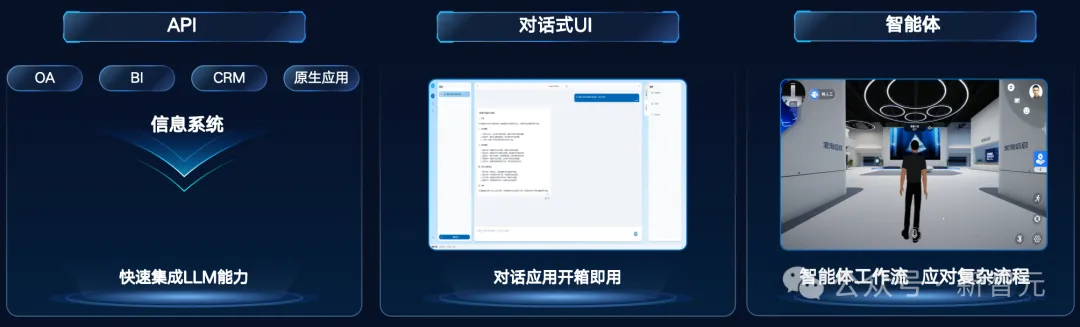

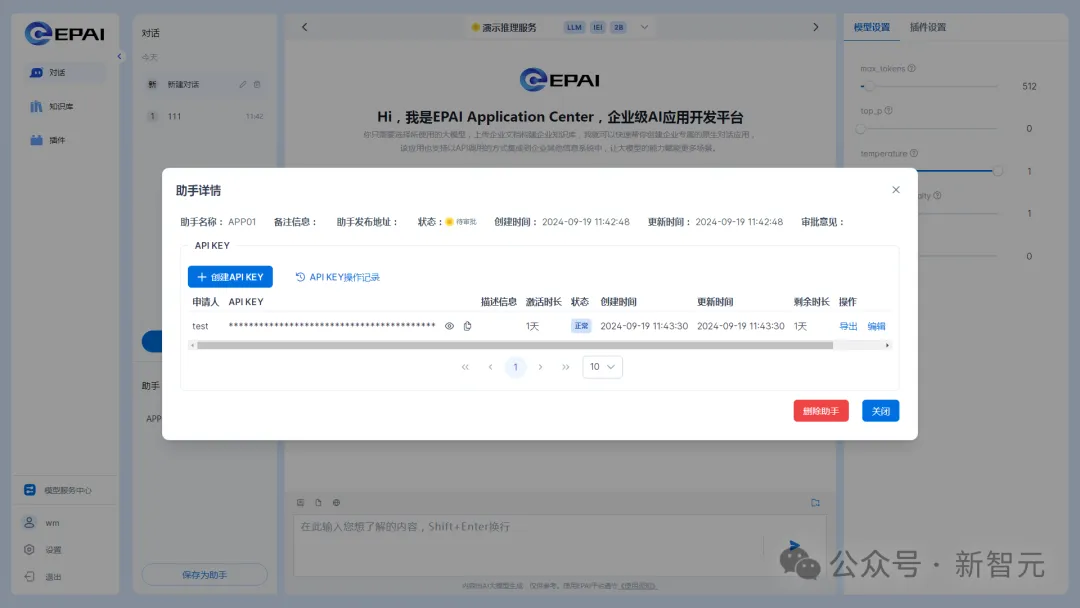

此外,元腦企智EPAI還支持API、對話式UI、智能體三類使用方式。

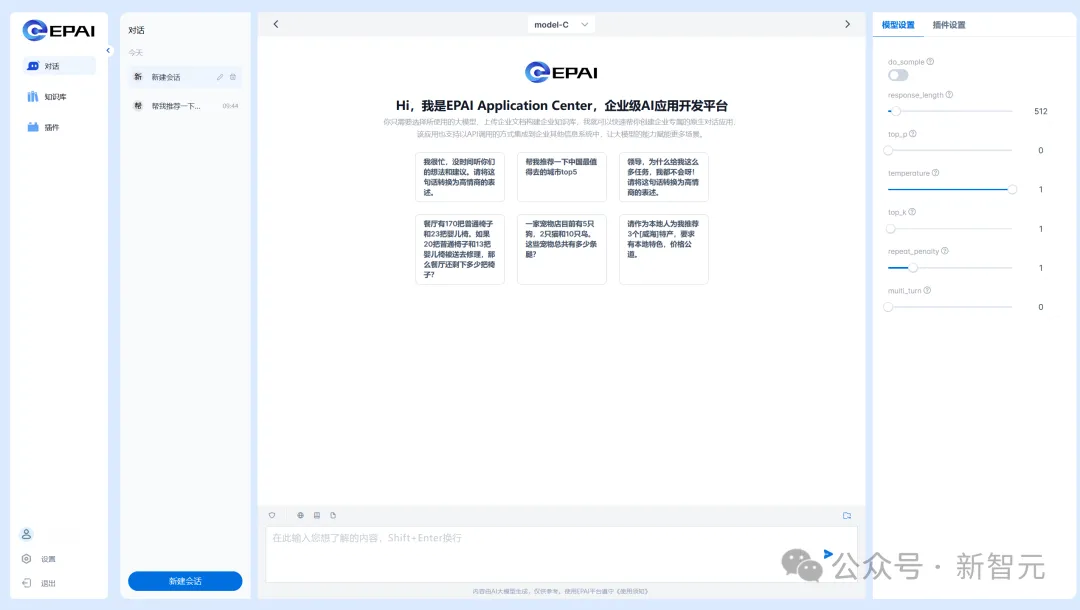

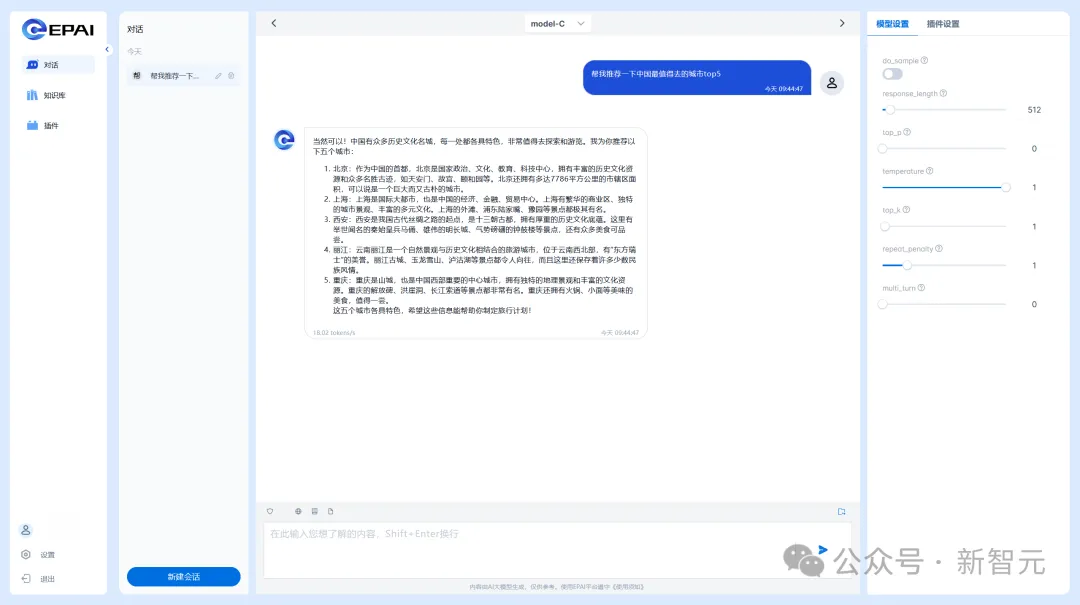

如下是對話式UI界面的樣子。

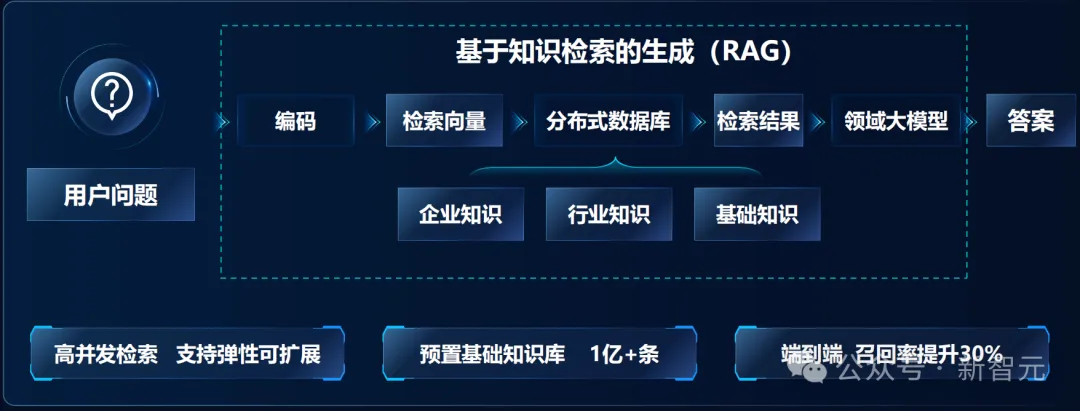

支持RAG,彌補LLM知識無法及時更新難題

另外,還需考慮的一個問題是,LLM幻覺之所產生,是因為無法及時獲取到新知識。

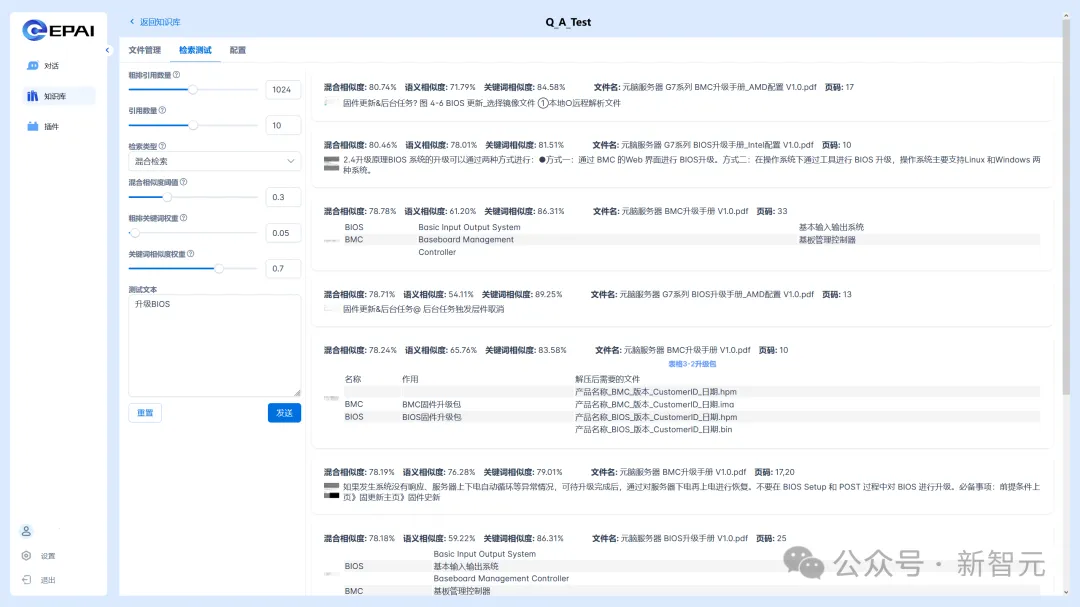

而元腦企智EPAI集成了浪潮信息自研的RAG系統,幫助大模型提升了應用效果。

僅需上傳一個原始文檔,就可以讓LLM基于文檔內容,進行精準問答和信息檢索,快速構建出領域問答能力。

同時,它還預置了一億條的基礎知識庫,能夠實現端到端30%召回率。

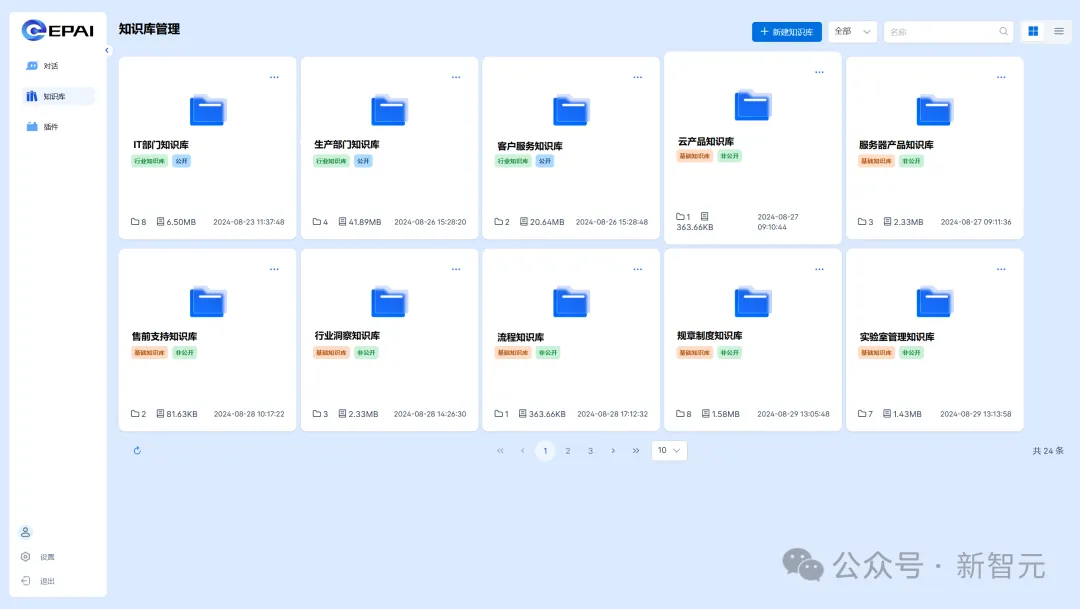

在話式UI界面中,知識庫管理中可以上傳企業、行業、基礎三大類知識。

它還支持檢索溯源、混合檢索、結果重排,由此可以提升端到端檢索精度。

數據安全,隱私保護

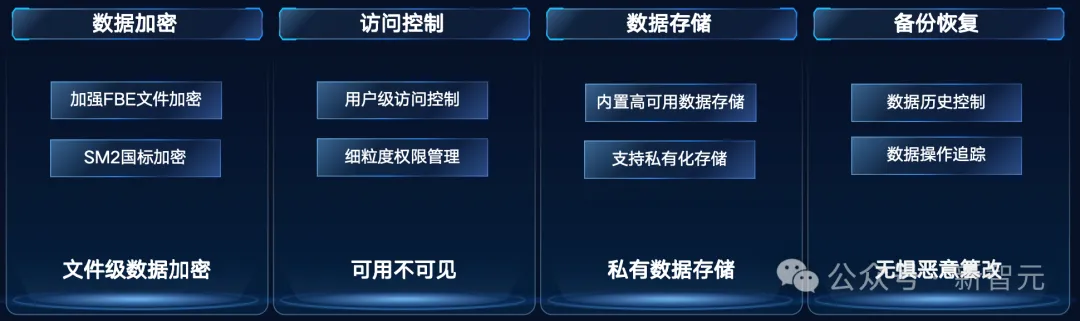

一體機另一個優勢在于, 能夠保護企業的私有數據不出域,杜絕數據風險。

內置的元腦企智EPAI平臺,可以提供全鏈路的防護,從文件級數據加密、訪問控制,到數據存儲、備份恢復。

它可以精準控制每個用戶數據、模型、知識庫、服務的權限,保障多場景使用安全。

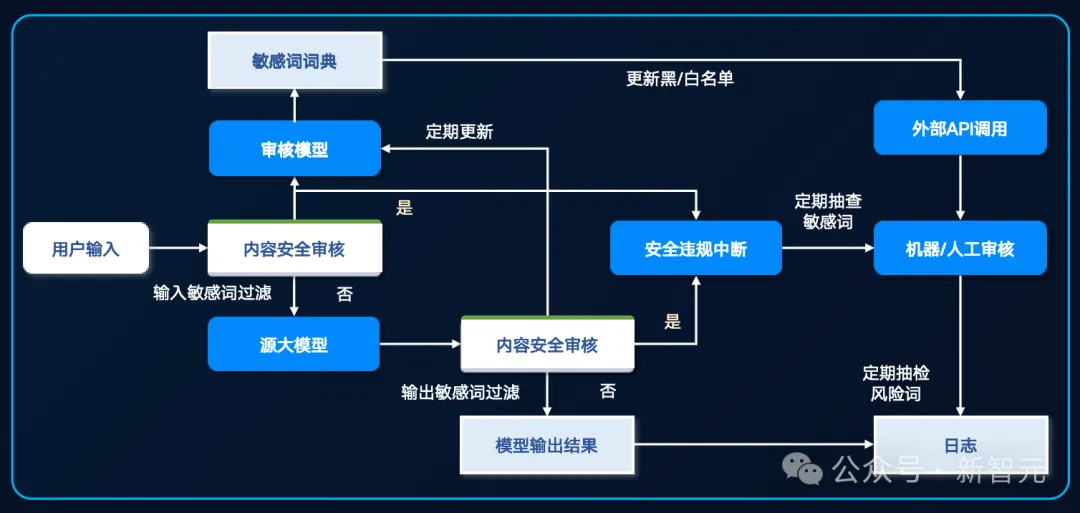

還有內容多級過濾和審核體系,對用戶輸入、模型輸出進行快速、準確審核,保障生成內容的安全性與隱私性。

AI應用,每個企業皆可開發

正是因為有以上種種優勢,元腦企智EPAI能廣泛地賦能企業內部的各類應用場景。

比如研發的代碼生成、部門助理,生產的故障識別、維修方案生成,銷售的智能客服、文案協作,行政的招聘助手,公文寫作等。

開發速度快到低至1周,培訓周期短到最快3天。

在浪潮信息內部,元腦企智EPAI就已經大大加快了大家的工作流。

以前如果有數百萬行私有代碼,注釋少,可讀性差,需要參考幾十頁上下文的PDF,專業工程師單個函數開發就需要3周。

但現在浪潮信息利用智能編程助手,可以直接把開發周期縮短至2天。

它能對數十萬行代碼自動解析,由AI自動生成超過65%的計算框架代碼,為研發工程師每天節省了近3個小時的代碼。

而基于元腦企智EPAI打造的智能客服大腦「源小服」,涵蓋了10+年的產品資料和5000+復雜場景,直接學習了2萬余份產品文檔、用戶手冊,百萬余條對話等材料。

對于常見技術問題的解決率達到了80%,整體服務效率提升了160%,斬獲了《哈佛商業評論》「鼎革獎」的年度新技術突破獎。

百模爭霸,不再卡在落地

因為具有以上優勢,元腦企智EPAI一體機就為用戶解決了燃眉之急。

其中一類重要客戶,就是傳統制造業客戶。

尤其是大型制造業客戶,無論是CIO、團隊,還是三產公司,在數據、人員、技術方面都有很多積累,而應用本身也有應用牽引的趨勢。

而另一類,就是傳統的ISV(獨立軟件開發商)客戶。

對于他們,浪潮信息有上百號博士團隊在做算力、算法、框架的應用開發工作,在算力上也很強,優勢明顯。

還有一些用戶,需要有對大模型專門的調優能力。

目前的情況是,對于非常專業的應用領域,國內能賣相關服務不多,花很高的代價,也未必找得到。

原本浪潮信息有這個能力,但沒有開放。如今,浪潮信息把經驗、服務都集成到了一體機的產品中,正好滿足了他們的需求。

在浪潮信息看來,如今大模型落地的最大痛點,不是算法,也不是產品,而是行業的know-how。

如果數據不ready,也很難通過一個工具、一個軟件或一臺設備去解決。

但這時如果有一個一體機的產品,還能跟懂行業、懂數據但不懂AI的ISV互相賦能,大模型的落地就會變得很容易。

從2021年開始到現在,浪潮信息已成行業里的骨灰級玩家。比如2021年做完源1.0后,22年浪潮信息就已經在用RAG做內部智能客服系統。

如今,憑著對模型本身的know-how,以及模型使用上的know-how,浪潮信息再次賦能自己的合作伙伴,加速企業大模型應用開發,打通了大模型落地最后一公里的難題。