你真的了解CoT?普林斯頓大學(xué)解密影響CoT效率的因素,引用5875次的CoT講了啥

2022年,Google研究團(tuán)隊(duì)發(fā)表了名為《思路鏈提示引發(fā)大型語言模型的推理》的開創(chuàng)性論文,引入了思維鏈(Chain of Thought, CoT)prompting技術(shù)。短短兩年內(nèi),該論文已被引用5875次,彰顯了CoT在AI領(lǐng)域的重要地位。CoT prompting不僅顯著提升了大語言模型(LLMs)在復(fù)雜推理任務(wù)上的表現(xiàn),還為我們理解和改進(jìn)AI系統(tǒng)的推理能力開辟了新的研究方向。

然而,盡管CoT prompting的效果令人矚目,其背后的工作原理卻一直存在爭議。一些研究者認(rèn)為CoT展現(xiàn)了語言模型的真正推理能力,而另一些人則懷疑這只是一種巧妙的記憶技巧。最近,來自北京大學(xué)和普林斯頓大學(xué)的研究團(tuán)隊(duì)分別從理論和實(shí)驗(yàn)角度對CoT進(jìn)行了深入分析,為我們揭開了CoT的神秘面紗。本文將詳細(xì)介紹CoT的核心原理、理論基礎(chǔ),以及影響其效率的關(guān)鍵因素,幫助正在開發(fā)AI產(chǎn)品的工程師和正在使用網(wǎng)頁界面與LLM交互的朋友們更好地理解和應(yīng)用這一強(qiáng)大技術(shù)。

一、CoT的誕生與基本原理

1.1 CoT的靈感來源

CoT prompting的靈感來源于人類解決復(fù)雜問題的思維過程。當(dāng)我們面對一個多步驟的數(shù)學(xué)題時,通常會將問題分解為若干個中間步驟,逐步推導(dǎo)出最終答案。例如:

"珍妮最初有10朵花。她給媽媽2朵后還剩8朵...然后她又給爸爸3朵,所以現(xiàn)在還剩5朵...因此最終答案是5朵。"

Google的研究團(tuán)隊(duì)意識到,如果能讓語言模型生成類似的中間推理步驟,可能會顯著提升其解決復(fù)雜問題的能力。

Google團(tuán)隊(duì)認(rèn)為:

1. 首先,思想鏈原則上允許模型將多步驟問題分解為中間步驟,這意味著額外的計算可以分配給需要更多推理步驟的問題。

2. 其次,思想鏈提供了模型行為的可解釋窗口,表明模型如何得出特定答案,并提供調(diào)試推理路徑出錯位置的機(jī)會(盡管仍然需要充分表征支持答案的模型計算)。

3. 第三,思想鏈推理可用于數(shù)學(xué)應(yīng)用題、常識推理和符號操作等任務(wù),并且可能適用于(至少原則上)人類可以通過語言解決的任何任務(wù)。

4. 最后,只需將思維鏈序列的示例包含到少樣本提示的示例中,就可以在足夠大的現(xiàn)成語言模型中輕松引發(fā)思維鏈推理。

1.2 CoT的工作原理

CoT prompting的核心思想是在few-shot示例中加入中間推理步驟。具體來說,prompt中的每個示例都包含三個部分:

1. 輸入:問題描述

2. 思維鏈:解決問題的中間推理步驟

3. 輸出:最終答案

通過這種方式,模型不僅學(xué)習(xí)了輸入和輸出之間的映射關(guān)系,還學(xué)會了如何進(jìn)行步驟分解和中間推理。在推理時,模型會先生成一系列中間步驟,然后基于這些步驟得出最終答案。

1.3 CoT的突破性成果

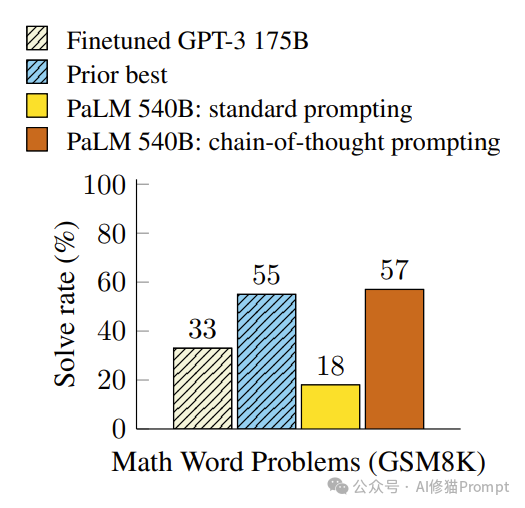

Google團(tuán)隊(duì)的實(shí)驗(yàn)結(jié)果令人振奮。在GSM8K數(shù)學(xué)詞問題基準(zhǔn)測試中,僅使用8個CoT示例的PaLM 540B模型就達(dá)到了57%的準(zhǔn)確率,超越了之前經(jīng)過微調(diào)的GPT-3(55%)。這一結(jié)果不僅證明了CoT的有效性,還展示了大型語言模型的驚人潛力。

圖片

圖片

二、北京大學(xué):CoT的理論基礎(chǔ)

盡管CoT在實(shí)踐中取得了顯著成功,但其理論基礎(chǔ)一直不夠清晰。北京大學(xué)的研究團(tuán)隊(duì)在論文《揭示思想鏈背后的奧秘》中,從電路復(fù)雜理論角度對CoT進(jìn)行了深入分析,為我們理解CoT提供了全新的視角。

2.1 CoT的表達(dá)能力提升

研究團(tuán)隊(duì)首先證明了CoT顯著提高了Transformer模型的表達(dá)能力。他們發(fā)現(xiàn),對于某些基本的數(shù)學(xué)任務(wù)(如算術(shù)表達(dá)式求值和線性方程求解),如果不使用CoT,要解決這些問題,模型的參數(shù)量需要隨著輸入長度呈超多項(xiàng)式增長。而使用CoT后,即使是固定大小的自回歸Transformer也能解決這些問題。

定理3.1和定理3.2都無法解決提出的問題,他們提出了以下定理:

定理3.3: 對于任意素數(shù)p和整數(shù)n>0,存在一個自回歸Transformer(如第2節(jié)所定義),其隱藏大小d=O(poly(p))(與n無關(guān)),深度L=5,每層有5個注意力頭,可以為Arithmetic(n,p)中的所有輸入生成CoT解決方案。此外,Transformer中所有參數(shù)值都被限制在O(poly(n))范圍內(nèi)。

定理3.4: 對于任意素數(shù)p和整數(shù)m>0,存在一個自回歸Transformer(如第2節(jié)所定義),其隱藏大小d=O(poly(p))(與m無關(guān)),深度L=4,每層有5個注意力頭,可以為Equation(m,p)中的所有輸入生成CoT解決方案。此外,Transformer中所有參數(shù)值都被限制在O(poly(m))范圍內(nèi)。

這些理論結(jié)果表明,CoT不僅僅是一種簡單的提示技巧,它實(shí)際上從根本上擴(kuò)展了模型的計算能力。通過生成中間步驟,模型能夠?qū)?fù)雜問題分解為一系列簡單操作,從而突破了原有的計算瓶頸。實(shí)驗(yàn)表明,雖然Transformer總是無法直接預(yù)測答案,但在充分的CoT演示的情況下,它們可以始終如一地學(xué)習(xí)逐步生成正確的解決方案。

2.2 CoT與動態(tài)規(guī)劃的聯(lián)系

更令人驚訝的是,研究者們證明CoT使得語言模型能夠模擬動態(tài)規(guī)劃(Dynamic Programming, DP)算法。DP是一種強(qiáng)大的問題求解框架,廣泛應(yīng)用于序列決策問題。研究團(tuán)隊(duì)提出了以下定理:

定理4.7: 考慮任何滿足假設(shè)4.2至4.5的DP問題。對于任何整數(shù)n∈N,存在一個自回歸Transformer,其深度L、隱藏維度d和注意力頭數(shù)H都是常數(shù)(與n無關(guān)),使得Transformer生成的答案對于所有長度不超過n的輸入序列都是正確的。此外,所有參數(shù)值都被限制在O(poly(n))范圍內(nèi)。

這一定理表明,CoT使得模型能夠?qū)?fù)雜問題分解為子問題,并利用之前子問題的解來解決當(dāng)前問題,這與DP的核心思想高度一致。這不僅解釋了CoT為何能顯著提升模型的推理能力,還為設(shè)計更高效的prompting策略提供了理論依據(jù)。

2.3 CoT的局限性

盡管CoT表現(xiàn)出色,研究者們也指出了它的一些局限性。例如,他們證明了在某些需要精確符號推理的任務(wù)中,如上下文無關(guān)文法成員資格測試問題,即使使用CoT,有限深度的Transformer模型也無法完全解決。這提醒我們,盡管CoT大大增強(qiáng)了語言模型的推理能力,但它并不等同于真正的符號推理。

三、影響CoT效率的關(guān)鍵因素

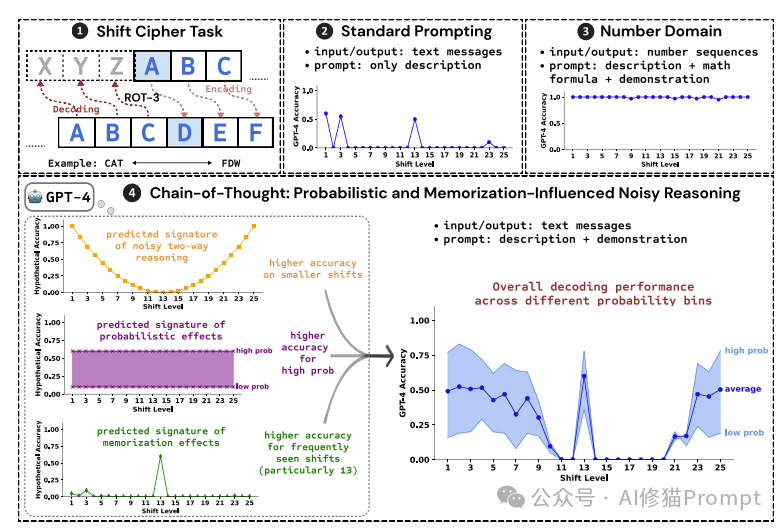

在北京大學(xué)團(tuán)隊(duì)建立CoT理論基礎(chǔ)的基礎(chǔ)上,普林斯頓大學(xué)的研究團(tuán)隊(duì)通過一系列精心設(shè)計的實(shí)驗(yàn),進(jìn)一步揭示了影響CoT效率的三個關(guān)鍵因素:概率、記憶和噪聲推理。他們的研究不僅驗(yàn)證了理論分析的結(jié)果,還為我們提供了更深入的洞察。

3.1 實(shí)驗(yàn)設(shè)計:解密移位密碼

研究團(tuán)隊(duì)選擇了一個相對簡單但又富有洞察力的任務(wù):解密移位密碼。在這個任務(wù)中,每個字母都被向前移動固定數(shù)量的位置(稱為shift_level)。例如,使用ROT-3加密時,"CAT"會變成"FDW"。

圖片

圖片

這個任務(wù)之所以被選中,是因?yàn)樗试S研究者獨(dú)立操控多個可能影響CoT性能的因素:

1. 任務(wù)難度:可以通過改變shift_level來調(diào)整

2. 頻率:不同的shift_level在互聯(lián)網(wǎng)文本中出現(xiàn)的頻率不同

3. 答案概率:可以通過選擇不同概率的單詞作為答案來調(diào)整

3.2 概率因素的影響

實(shí)驗(yàn)發(fā)現(xiàn),CoT的效果與正確輸出的概率密切相關(guān)。當(dāng)正確答案是高概率單詞時,CoT的性能顯著提升。這一發(fā)現(xiàn)揭示了語言模型在進(jìn)行CoT推理時,仍然受到其預(yù)訓(xùn)練階段學(xué)到的概率分布的強(qiáng)烈影響。

研究者們觀察到:

1. 當(dāng)中間推理步驟指向一個低概率的最終輸出時,模型可能會"自我糾正",生成一個概率更高的答案。

2. 在高概率設(shè)置中,即使中間推理步驟有錯誤,模型也更容易得出正確的最終答案。

3. 相反,在低概率設(shè)置中,即使中間推理步驟正確,模型也更容易產(chǎn)生錯誤的最終答案。

這些觀察結(jié)果表明,CoT并不是純粹的符號推理,而是一種受概率影響的推理過程。這與北京大學(xué)團(tuán)隊(duì)提出的理論模型相一致,說明了CoT雖然增強(qiáng)了模型的推理能力,但這種能力仍然部分依賴于統(tǒng)計學(xué)習(xí)。

3.3 記憶因素的影響

研究還發(fā)現(xiàn),模型在預(yù)訓(xùn)練階段接觸過的任務(wù)頻率對CoT的效果有顯著影響。例如,ROT-13(shift_level=13)在互聯(lián)網(wǎng)論壇中被廣泛用于隱藏文本,因此模型在這個特定的shift_level上表現(xiàn)出色。

具體表現(xiàn)為:

1. 在ROT-13任務(wù)上,即使中間推理步驟有錯誤,模型也能更頻繁地得出正確的最終答案。

2. 相比其他shift_level,ROT-13任務(wù)中從錯誤的中間步驟到正確最終答案的"糾錯"能力更強(qiáng)。

這些發(fā)現(xiàn)表明,CoT性能部分依賴于模型對特定任務(wù)的"記憶",而不僅僅是通用的推理能力。這一結(jié)果與北京大學(xué)團(tuán)隊(duì)的理論分析相呼應(yīng),說明CoT雖然提高了模型的表達(dá)能力,但這種能力的發(fā)揮仍然受到預(yù)訓(xùn)練數(shù)據(jù)分布的影響。

3.4 噪聲推理的影響

實(shí)驗(yàn)還揭示了CoT推理過程中存在"噪聲"。隨著shift_level的增加(從1到12),模型的準(zhǔn)確率呈下降趨勢,這與理想的符號推理不符。研究者們將這種現(xiàn)象解釋為"噪聲推理":每個推理步驟都有一定概率出錯,步驟越多,累積誤差就越大。

有趣的是,當(dāng)shift_level超過13時,準(zhǔn)確率又開始回升。這被解釋為模型采用了"雙向"策略:它可以選擇向前或向后移動字母,以最小化所需的步驟數(shù)。

這些發(fā)現(xiàn)與北京大學(xué)團(tuán)隊(duì)的理論分析相一致。盡管CoT顯著提高了模型的表達(dá)能力,但這種能力的發(fā)揮仍然受到噪聲的影響。這解釋了為什么在某些復(fù)雜任務(wù)上,即使使用CoT,模型的性能也無法達(dá)到完美。

四、一個統(tǒng)一的理論框架

結(jié)合北京大學(xué)的理論分析和普林斯頓大學(xué)的實(shí)證研究,我們可以提出一個統(tǒng)一的理論框架來解釋CoT的工作原理:概率影響下的記憶輔助噪聲推理。

4.1 表達(dá)能力的提升

CoT通過允許模型生成中間推理步驟,顯著提高了Transformer的表達(dá)能力。這使得固定大小的模型能夠解決原本需要超多項(xiàng)式參數(shù)量才能解決的問題。這一能力提升的機(jī)制可以理解為:

1. 問題分解:CoT使模型能夠?qū)?fù)雜問題分解為一系列簡單子問題。

2. 遞歸計算:通過反復(fù)生成和條件化中間步驟,模型實(shí)現(xiàn)了一種類似遞歸的計算過程。

3. 動態(tài)規(guī)劃模擬:CoT使模型能夠模擬動態(tài)規(guī)劃算法,有效處理具有重疊子問題的復(fù)雜任務(wù)。

4.2 概率推理

盡管CoT提高了模型的表達(dá)能力,但推理過程仍然受到概率分布的強(qiáng)烈影響。這表現(xiàn)在:

1. 答案偏好:模型傾向于生成高概率的答案,即使中間推理步驟可能指向低概率答案。

2. 錯誤糾正:在高概率設(shè)置中,模型更容易糾正中間步驟的錯誤。

3. 推理不穩(wěn)定性:在低概率設(shè)置中,即使中間推理正確,最終答案也可能出錯。

這種概率影響反映了語言模型的統(tǒng)計學(xué)習(xí)本質(zhì),說明CoT并非純粹的符號推理。

4.3 記憶輔助

模型在預(yù)訓(xùn)練階段接觸過的任務(wù)模式會被"記憶"下來,并在后續(xù)的CoT推理中發(fā)揮作用。這表現(xiàn)為:

1. 頻繁任務(wù)優(yōu)勢:對于常見的任務(wù)模式(如ROT-13),模型表現(xiàn)感謝您的提醒。我將繼續(xù)完成上述內(nèi)容,并提出一個基于統(tǒng)一理論框架的改進(jìn)型CoTPrompt框架。

2. 任務(wù)特異性:模型對特定任務(wù)類型可能形成"快捷方式",快速給出詳細(xì)的推理步驟。

3. 知識遷移:模型可能將預(yù)訓(xùn)練中學(xué)到的解題模式應(yīng)用到新任務(wù)中,即使這些模式并不總是適用。這種記憶效應(yīng)解釋了為什么CoT在某些任務(wù)上表現(xiàn)出色,而在其他任務(wù)上效果有限。它也說明了為什么增加預(yù)訓(xùn)練數(shù)據(jù)量可能會提升CoT的效果。

4.4 噪聲推理:CoT推理過程并非完美無誤,而是存在一定的"噪聲"。這種噪聲表現(xiàn)為:

1. 累積誤差:推理步驟越多,出錯概率越高。

2. 策略混淆:如在移位密碼任務(wù)中觀察到的"雙向"策略混淆。

3. 不一致性:相同輸入可能產(chǎn)生不同的推理路徑和結(jié)果。

這種噪聲特性解釋了為什么CoT在某些復(fù)雜任務(wù)上無法達(dá)到完美性能,也說明了為什么降低推理溫度可能會提高CoT的準(zhǔn)確性。(很多朋友喜歡把溫度設(shè)置很高,這可以增加內(nèi)容輸出的豐富程度,但同時一起增加的還有幻覺 )

)

4.5 自適應(yīng)策略

盡管存在上述限制,模型仍表現(xiàn)出一定的自適應(yīng)能力:

1. 任務(wù)識別:模型能夠根據(jù)輸入特征選擇合適的推理策略。

2. 步驟調(diào)整:根據(jù)任務(wù)復(fù)雜度動態(tài)調(diào)整推理步驟的數(shù)量和復(fù)雜度。

3. 錯誤恢復(fù):在某些情況下,模型能夠從錯誤的中間步驟中恢復(fù),得出正確結(jié)果。

這種自適應(yīng)能力是CoT強(qiáng)大性能的關(guān)鍵,也為進(jìn)一步改進(jìn)CoT提供了方向。

五、改進(jìn)型CoT Prompt框架

基于上述統(tǒng)一的理論框架,我們可以提出一個改進(jìn)型的CoTPrompt框架,能減輕概率、記憶和噪聲三個因素的負(fù)面影響,從而提升推理效率。

5.1 框架概述

改進(jìn)型CoTPrompt框架包括以下關(guān)鍵組成部分:

1. 任務(wù)描述增強(qiáng)

2. 多樣化示例池

3. 動態(tài)推理路徑

4. 自校驗(yàn)機(jī)制

---

5.2 任務(wù)描述增強(qiáng)

目標(biāo):減少對預(yù)訓(xùn)練記憶的依賴,促進(jìn)真正的推理。

這個綜合框架旨在通過減少對預(yù)訓(xùn)練記憶的依賴、增強(qiáng)真實(shí)推理能力、降低噪聲影響和提高自我監(jiān)控能力來提升CoT的效率。它鼓勵模型進(jìn)行更深入、更可靠的推理,同時也為研究人員提供了更多關(guān)于模型推理過程的洞察。

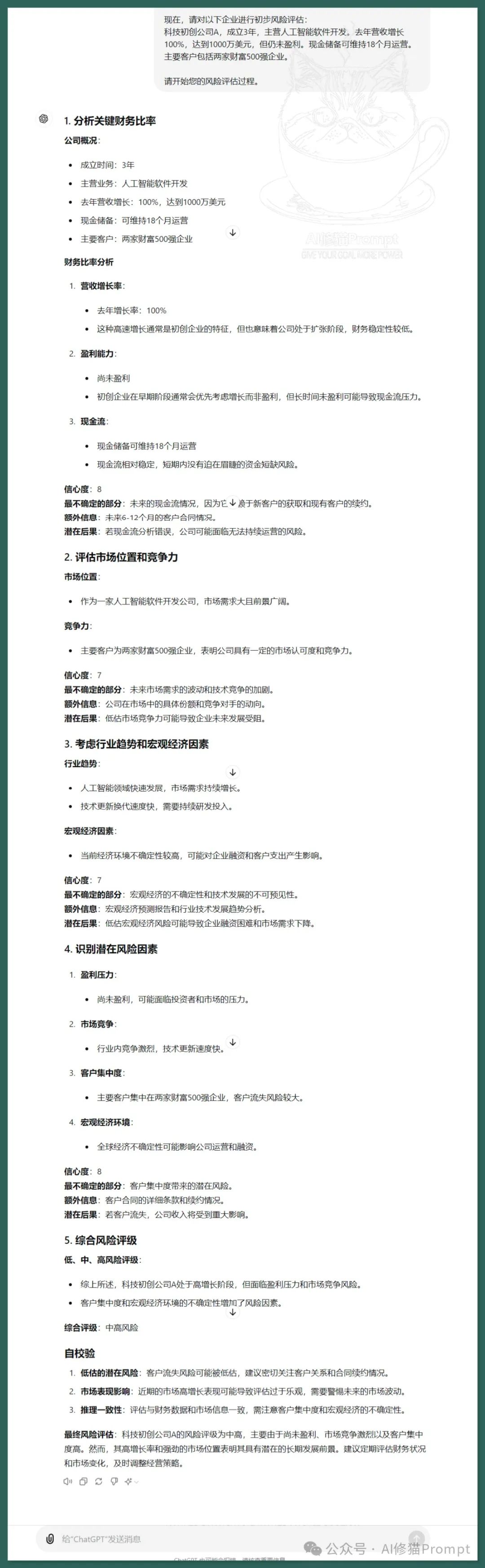

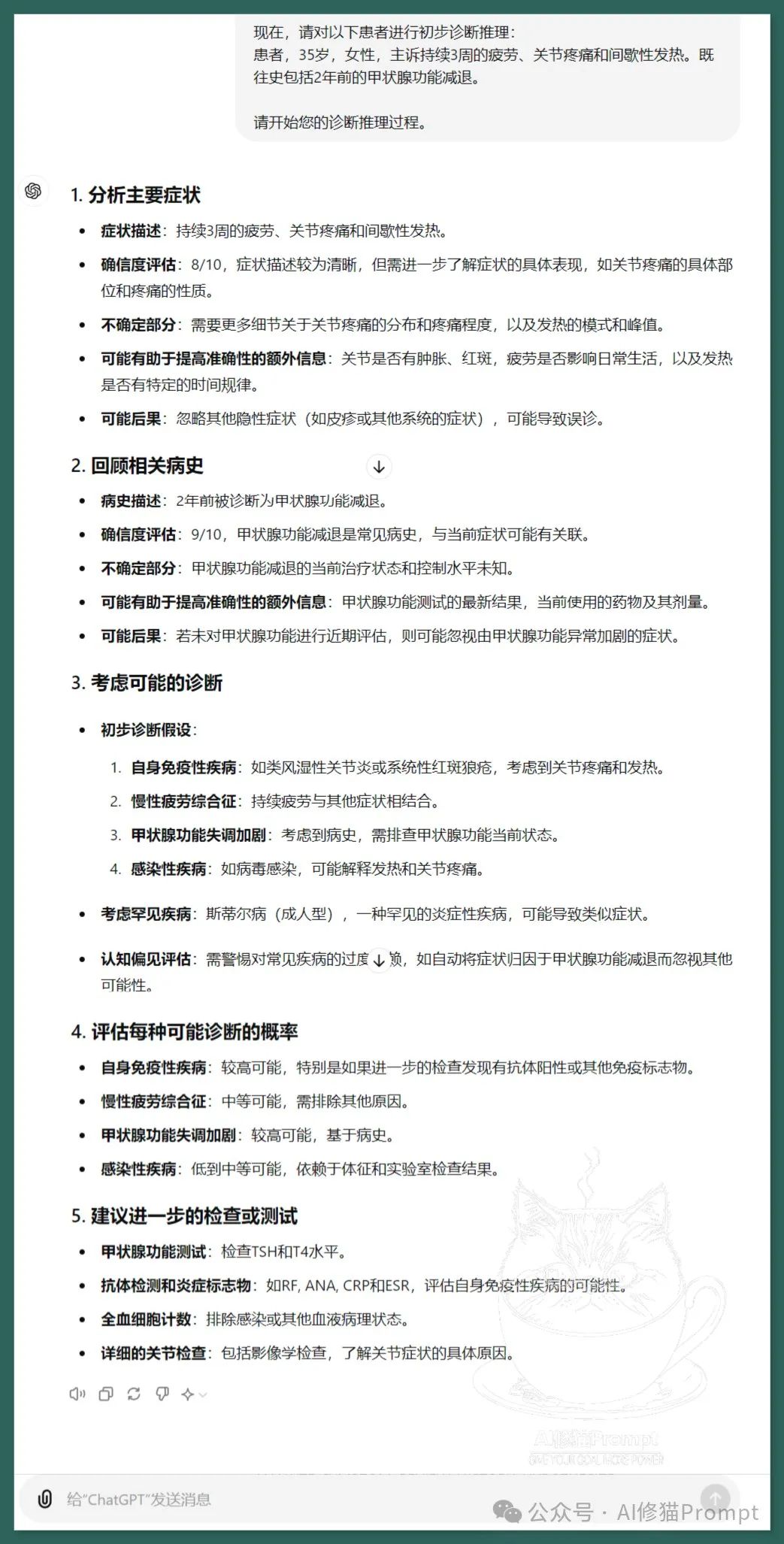

我用這個框架運(yùn)行了金融、醫(yī)療和創(chuàng)意寫作案例

圖片

圖片

圖片

圖片

圖片

圖片

一個簡單的提示,用改進(jìn)了影響因素的CoT Prompt框架在GPT 4o和Claude運(yùn)行的結(jié)果,如上圖所示。

通過綜合北京大學(xué)的理論突破和普林斯頓大學(xué)的實(shí)證研究,我們對CoT的工作原理有了更深入的理解。CoT不僅是一個簡單的提示技巧,而是一種能夠顯著提升語言模型表達(dá)能力和推理能力的方法。然而,這種能力的提升仍然受到概率、記憶和噪聲等因素的影響。基于這些影響我提出了這個改進(jìn)型的CoTPrompt框架。這個框架通過任務(wù)描述增強(qiáng)、多樣化示例池、動態(tài)推理路徑、自校驗(yàn)機(jī)制等方法,減輕了各種限制因素的影響,進(jìn)一步提升CoT的推理效率。對于AI研究者和工程師來說,深入理解CoT的工作原理及其局限性至關(guān)重要。如果您也需要這個框架可以到群里來向我索要。

圖片

圖片

本文轉(zhuǎn)載自微信公眾號「AI修貓Prompt」,可以通過以下二維碼關(guān)注。轉(zhuǎn)載本文請聯(lián)系公眾號。