關(guān)注o1必備GitHub倉庫,上線3天狂攬1.5k星!英偉達工程師出品,承諾持續(xù)更新

關(guān)注o1必備的GitHub庫,它來了!

上線3天狂攬1.5k星,一躍登上GitHub趨勢榜!

這個庫專注于收集與o1相關(guān)的推理技術(shù)論文、博客和項目等資源,供大家研究討論,并在持續(xù)更新中。

網(wǎng)友們對它給予高度評價:

科技大V說它是“拆解草莓的逆向工程”。

也有網(wǎng)友直接提出表揚:“研究o1,看它就夠了!”

真有這么牛?咱們一起來看看到底怎么個事兒!

干貨滿滿

在這個名為Awesome-LLM-Strawberry的GitHub庫中,涵蓋了大量關(guān)于o1的信息。

量子位為大家整理了一下迄今為止發(fā)布的相關(guān)硬核內(nèi)容:

關(guān)于o1的博客

博客:Learning to Reason with LLMs

作者:OpenAI

鏈接:https://openai.com/index/learning-to-reason-with-llms/

概述:這篇博客介紹了OpenAI o1的訓(xùn)練方法,其中包括鏈式推理、自我批評、驗證、多步驟推理、任務(wù)分解和蒙特卡洛樹搜索等技術(shù)。

博客:OpenAI o1-mini

作者:OpenAI

鏈接:https://openai.com/index/openai-o1-mini-advancing-cost-efficient-reasoning/

概述:介紹了o1 mini模型在推理成本和效率方面的改進,在保持高推理性能的同時,顯著降低了計算和運行成本。

博客:Finding GPT-4’s mistakes with GPT-4

作者:OpenAI

鏈接:https://openai.com/index/finding-gpt4s-mistakes-with-gpt-4/

概述:討論了如何利用GPT-4模型自身來發(fā)現(xiàn)和修正生成的錯誤。文章中提到的“自我審查方法”通過雙重評估提高了錯誤檢測的準確性,從而讓模型輸出的內(nèi)容變得更加可靠。(文章發(fā)表時,已有OpenAI超級對齊團隊成員離職,因此也被稱為團隊的“遺作”)

博客:Summary of what we have learned during AMA hour with the OpenAI o1 team

作者:Tibor Blaho

鏈接:https://twitter-thread.com/t/1834686946846597281

??:https://x.com/btibor91/status/1834686946846597281

概述:這篇博客總結(jié)了OpenAI團隊在AMA(問答環(huán)節(jié))中分享的關(guān)于o1模型的主要內(nèi)容和特性。

其中包括:模型的推理范式以及規(guī)模和性能、輸入token上下文和模型能力、CoT(思維鏈)推理、API和使用限制、定價、微調(diào)和擴展等內(nèi)容。

博客:OpenAI’s Strawberry, LM self-talk, inference scaling laws, and spending more on inference

作者:Nathan Lambert

鏈接:https://www.interconnects.ai/p/openai-strawberry-and-inference-scaling-laws

概述:文章探討了OpenAI的新活“Strawberry”以及推理擴展定律,強調(diào)了推理計算在提升AI能力方面的重要性。而相較于單純擴大模型規(guī)模,作者認為增加推理計算的投入能更有效地提高模型性能。(具有前瞻性的一篇博客,文章發(fā)布的時候o1還沒發(fā)布)

博客:Reverse engineering OpenAI’s o1

作者:Nathan Lambert

鏈接:https://www.interconnects.ai/p/reverse-engineering-openai-o1

概述:文章詳細講了OpenAI的o1模型,重點在于它的推理能力。o1通過生成復(fù)雜的思維鏈來處理復(fù)雜任務(wù),比以前的模型表現(xiàn)更出色。

還討論了o1的設(shè)計和訓(xùn)練細節(jié),特別是它如何通過優(yōu)化數(shù)據(jù)處理和算法來提高推理效率。同時指出,相比單純增加模型規(guī)模,提升推理計算投入對提升模型性能更有效。

OpenAI o1貢獻者參與撰寫的論文

論文:Training Verifiers to Solve Math Word Problems

作者:Karl Cobbe, Vineet Kosaraju, Mohammad Bavarian, Mark Chen, Heewoo Jun, Lukasz Kaiser, Matthias Plappert, Jerry Tworek, Jacob Hilton, Reiichiro Nakano, Christopher Hesse, John Schulman

團隊:OpenAI

鏈接:https://arxiv.org/abs/2110.14168

概述:發(fā)布于2021年10月,文中指出雖然當(dāng)前的先進語言模型在很多任務(wù)上表現(xiàn)很強,但它們在解決復(fù)雜的數(shù)學(xué)題時仍然遇到困難。為了解決這個問題,作者創(chuàng)建了一個叫GSM8K的數(shù)據(jù)集,其中包含8500個不同的小學(xué)數(shù)學(xué)題。

研究發(fā)現(xiàn),即使是大規(guī)模的Transformer模型在這些題目上也表現(xiàn)不佳。為了提升表現(xiàn),作者建議使用一個驗證器來檢查模型答案的準確性。

具體做法是讓模型生成多個答案,然后選擇驗證器評分最高的答案。而這種方法顯著提高了模型在GSM8K數(shù)據(jù)集上的表現(xiàn),比傳統(tǒng)的調(diào)整方法效果更好。

論文:Generative Language Modeling for Automated Theorem Proving

作者:Stanislas Polu, Ilya Sutskever

團隊:OpenAI

鏈接:https://arxiv.org/abs/2009.03393

概述:發(fā)布于2020年9月,探討了基于Transformer的語言模型如何在自動定理證明中發(fā)揮作用。

研究的核心問題是,自動定理證明器在生成原創(chuàng)數(shù)學(xué)術(shù)語方面比不上人類,而這可能通過語言模型的生成能力得到解決。

作者介紹了一種叫做GPT-f的自動證明工具,用于Metamath形式化語言,并分析了它的效果。GPT-f成功發(fā)現(xiàn)了一些新短證明,這些證明被Metamath主要庫接受,這是深度學(xué)習(xí)系統(tǒng)首次為形式數(shù)學(xué)社區(qū)提供并被采納的證明。

論文:Chain-of-Thought Prompting Elicits Reasoning in Large Language Models

作者:Chain-of-Thought Prompting Elicits Reasoning in Large Language Models

團隊:Google Research, Brain Team(谷歌大腦)

鏈接:https://arxiv.org/pdf/2201.11903

概述:發(fā)布于2022年1月,文章討論了如何通過生成一系列中間推理步驟(思維鏈)來大幅提升大型語言模型的復(fù)雜推理能力。

作者提出了一種叫做“思維鏈提示”的方法,具體做法是在提示中給出一些思維鏈的示例,幫助模型進行更深入的推理。最終實驗結(jié)果顯示,它在三個大型語言模型上都顯著提高了它們在算術(shù)、常識和符號推理任務(wù)中的表現(xiàn)。

論文:Let’s Verify Step by Step

作者:Hunter Lightman, Vineet Kosaraju, Yura Burda, Harri Edwards, Bowen Baker, Teddy Lee, Jan Leike, John Schulman, Ilya Sutskever, Karl Cobbe

團隊:OpenAI

鏈接:https://arxiv.org/abs/2305.20050

概述:發(fā)布于2023年5月,文章討論了大型語言模型在復(fù)雜多步推理任務(wù)中的表現(xiàn)。

作者比較了兩種訓(xùn)練方法:一種只關(guān)注最終結(jié)果,另一種關(guān)注每一步推理。結(jié)果顯示,關(guān)注每一步推理的方法更有效,能在MATH數(shù)據(jù)集上提高到78%的成功率。

文中還強調(diào)了主動學(xué)習(xí)在提升訓(xùn)練效果中的重要性,并發(fā)布了一個包含80萬個步驟級反饋的PRM800K數(shù)據(jù)集,用于訓(xùn)練最佳模型。

論文:LLM Critics Help Catch LLM Bugs

作者:Nat McAleese, Rai Michael Pokorny, Juan Felipe Ceron Uribe, Evgenia Nitishinskaya, Maja Trebacz, Jan Leike

團隊:OpenAI

鏈接:https://arxiv.org/abs/2407.00215

概述:發(fā)布于2024年6月,文中介紹了用“批評者”(CriticGPT)模型來提升機器學(xué)習(xí)模型輸出的評估。

這些批評者模型能更有效地發(fā)現(xiàn)代碼中的錯誤,甚至能找到人類可能忽略的問題。盡管這些模型有時會出錯,但與人類結(jié)合使用可以減少誤導(dǎo),同時提高錯誤檢測的效率。

論文:Self-critiquing models for assisting human evaluators

作者:William Saunders, Catherine Yeh, Jeff Wu, Steven Bills, Long Ouyang, Jonathan Ward, Jan Leike

團隊:OpenAI

鏈接:https://arxiv.org/pdf/2206.05802

概述:發(fā)布于2022年6月,文中介紹了一種方法,通過微調(diào)大型語言模型,讓它們生成批評性評論,從而幫助找出摘要中的問題。

研究發(fā)現(xiàn),這些評論可以有效識別摘要中的錯誤,包括有意誤導(dǎo)的信息。大模型在生成有用評論和自我改進方面表現(xiàn)更好。

同時論文還提出了一個框架來評估模型的批評、生成和辨別能力,并指出即使是大型模型也可能有遺漏的知識。研究展示了如何用AI輔助人類改進機器學(xué)習(xí)系統(tǒng),并公開了相關(guān)數(shù)據(jù)和樣本。

論文:Scalable Online Planning via Reinforcement Learning Fine-Tuning

作者:Arnaud Fickinger, Hengyuan Hu, Brandon Amos, Stuart Russell, Noam Brown

團隊:Facebook AI

鏈接:https://arxiv.org/pdf/2109.15316

概述:文章介紹了一種新方法來改進圖神經(jīng)網(wǎng)絡(luò)(GNN)的訓(xùn)練,特別是針對“圖卷積”操作中的效率問題。

作者提出了一種名為“FastGCN”的算法,旨在提高圖神經(jīng)網(wǎng)絡(luò)的計算速度和縮放能力。通過在訓(xùn)練過程中進行近似和優(yōu)化,這種方法能夠處理更大規(guī)模的圖數(shù)據(jù),從而在圖數(shù)據(jù)分析任務(wù)中取得更好的性能。

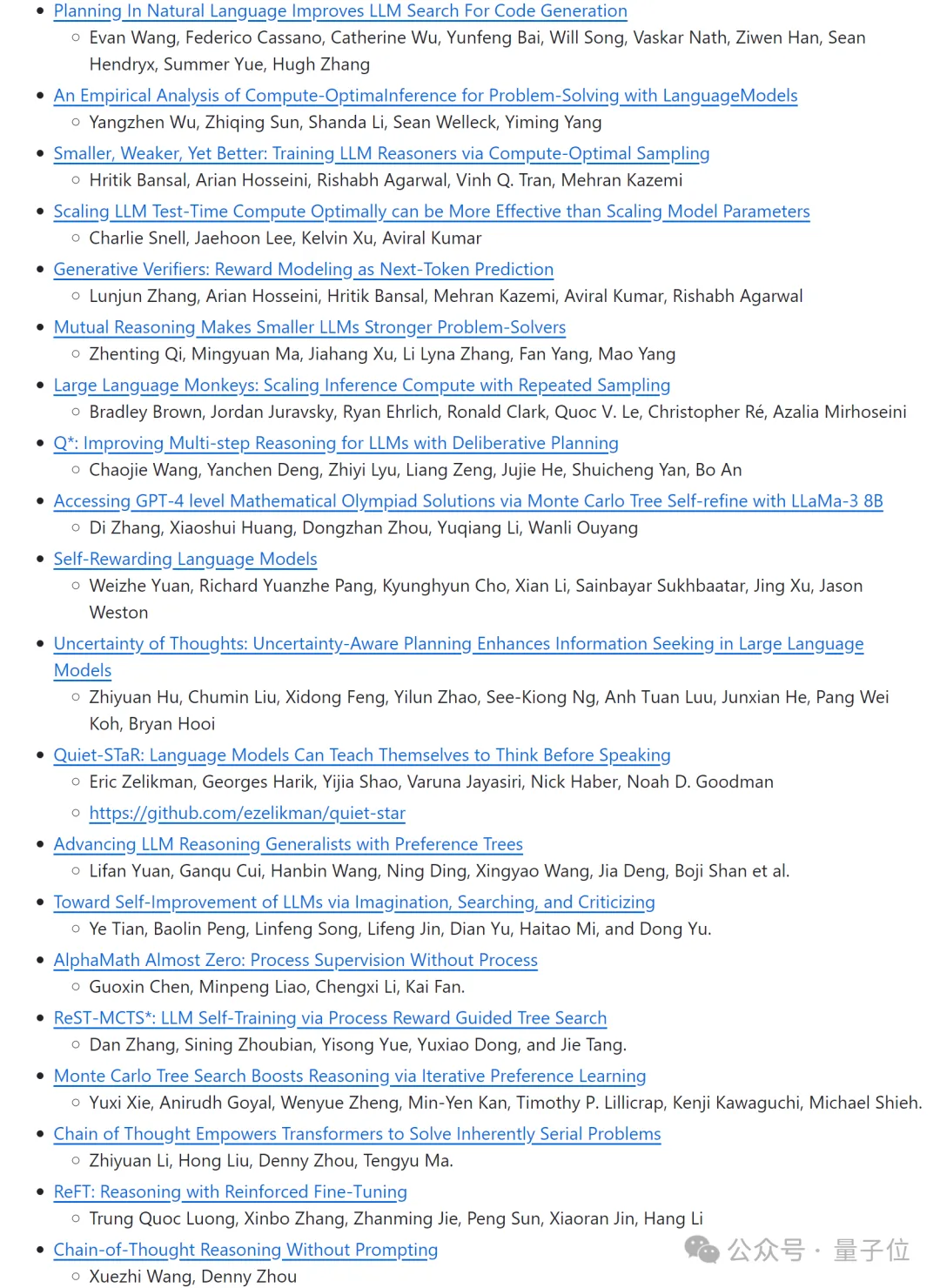

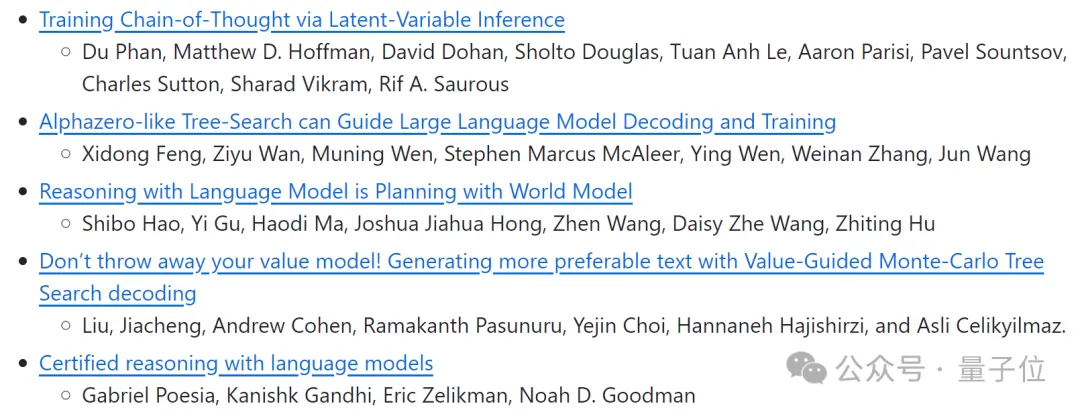

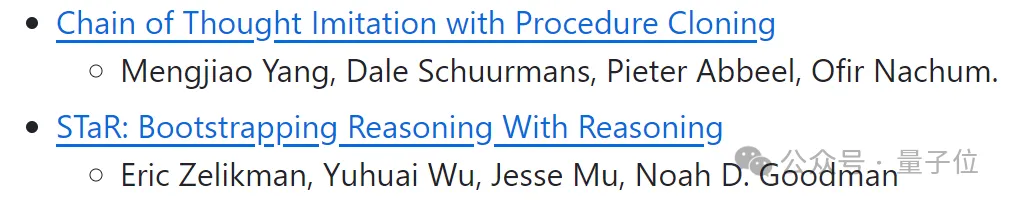

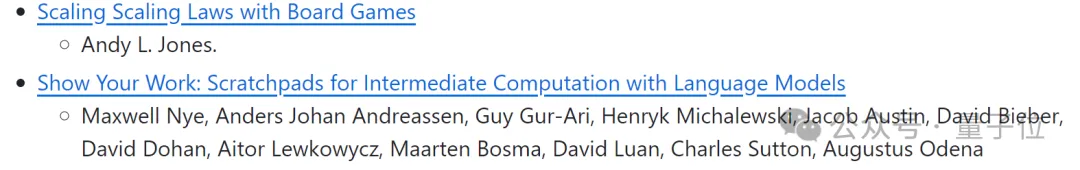

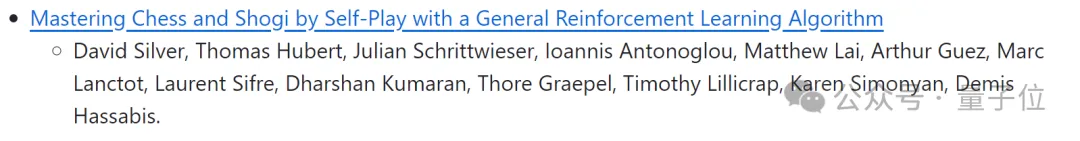

除此之外,作者還按照時間順序梳理了一些可能與o1相關(guān)的其他相關(guān)論文:

2024年發(fā)布:

2023年發(fā)布:

2022年發(fā)布:

2021年發(fā)布:

2017年發(fā)布:

關(guān)于作者

Awesome-LLM-Strawberry的作者是ID叫做hijkzzz的中國小哥。

目前在英偉達任深度學(xué)習(xí)工程師。

他是OpenRLHF的第一作者,在英偉達期間開發(fā)TensorRT-LLM的新模型和算法,還參與了NeMo的模型訓(xùn)練。