Yann LeCun不看好強化學(xué)習(xí):「我確實更喜歡 MPC」

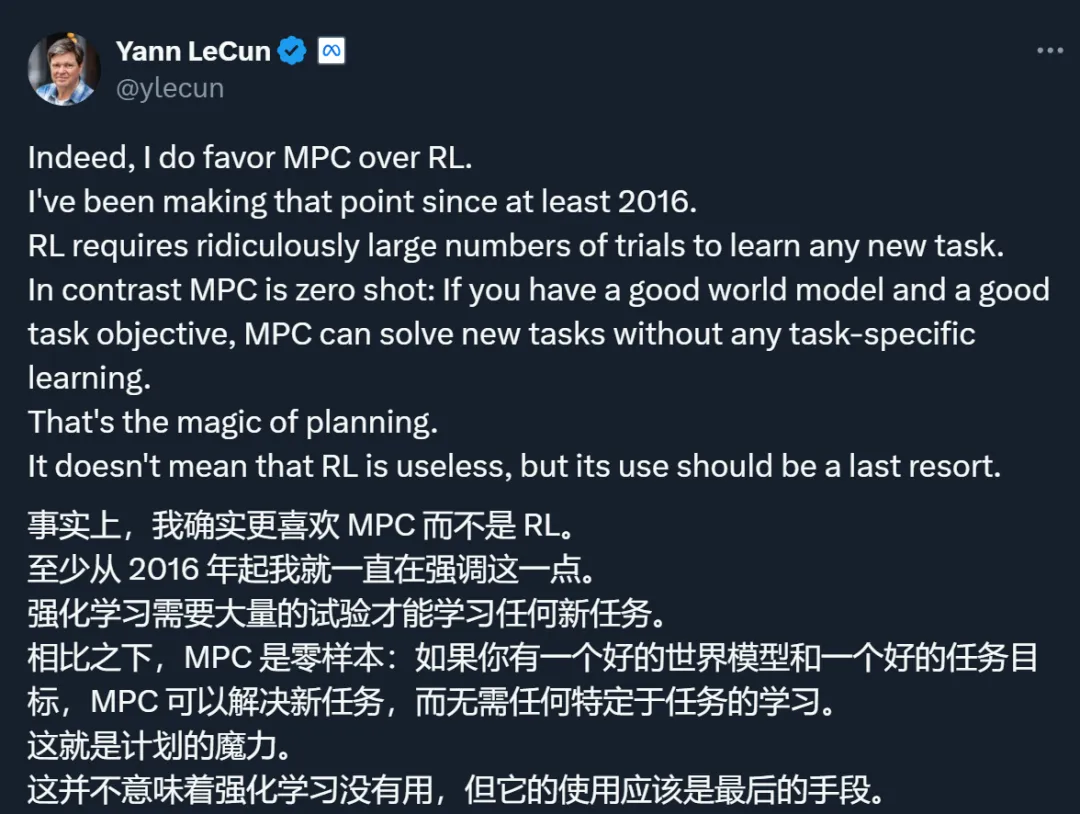

「相比于強化學(xué)習(xí)(RL),我確實更喜歡模型預(yù)測控制(MPC)。至少從 2016 年起,我就一直在強調(diào)這一點。強化學(xué)習(xí)在學(xué)習(xí)任何新任務(wù)時都需要進行極其大量的嘗試。相比之下,模型預(yù)測控制是零樣本的:如果你有一個良好的世界模型和一個良好的任務(wù)目標,模型預(yù)測控制就可以在不需要任何特定任務(wù)學(xué)習(xí)的情況下解決新任務(wù)。這就是規(guī)劃的魔力。這并不意味著強化學(xué)習(xí)是無用的,但它的使用應(yīng)該是最后的手段。」

在最近發(fā)布的一個帖子中,Meta 首席人工智能科學(xué)家 Yann LeCun 發(fā)表了這樣一番看法。

一直以來,Yann LeCun 都是強化學(xué)習(xí)的批評者。他認為,強化學(xué)習(xí)這種方法需要大量的試驗,非常低效。這和人類的學(xué)習(xí)方式大相徑庭 —— 嬰兒不是通過觀察一百萬個相同物體的樣本來識別物體,或者嘗試危險的東西并從中學(xué)習(xí),而是通過觀察、預(yù)測和與它們互動,即使沒有監(jiān)督。

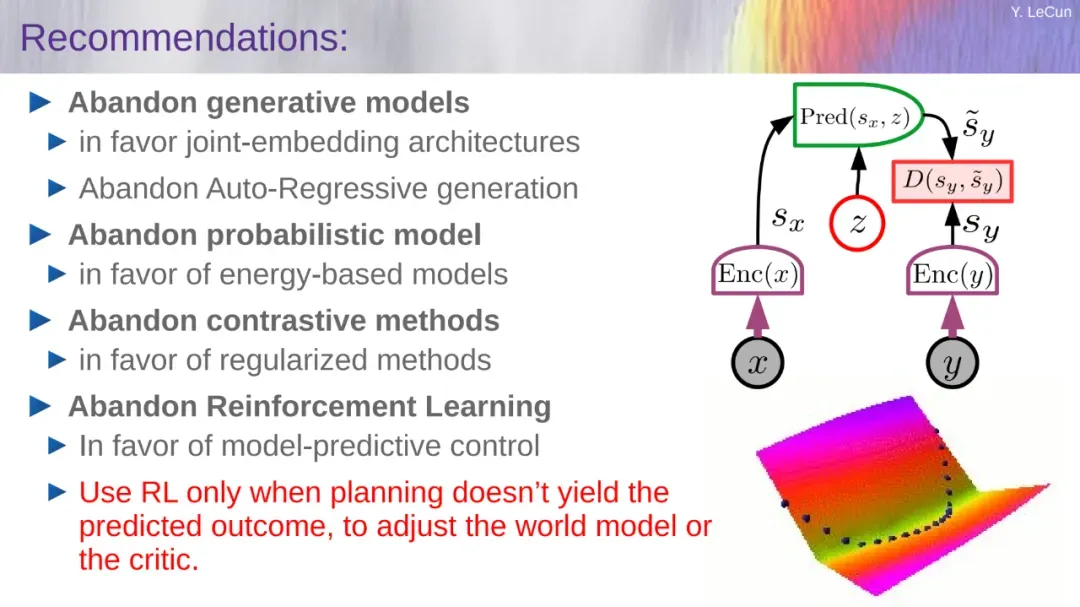

在半年前的一次演講中,他甚至主張「放棄強化學(xué)習(xí)」(參見《GPT-4 的研究路徑?jīng)]有前途?Yann LeCun 給自回歸判了死刑》)。但在隨后的一次采訪中,他又解釋說,他的意思并不是完全放棄,而是最小化強化學(xué)習(xí)的使用,訓(xùn)練系統(tǒng)的正確方法是首先讓它從主要觀察(也許還有一點交互)中學(xué)習(xí)世界和世界模型的良好表示。

同時,LeCun 也指出,相比于強化學(xué)習(xí),他更傾向于 MPC(模型預(yù)測控制)。

MPC 是一種使用數(shù)學(xué)模型在有限時間內(nèi)實時優(yōu)化控制系統(tǒng)的技術(shù),自二十世紀六七十年代問世以來,已廣泛應(yīng)用于化學(xué)工程、煉油、先進制造、機器人和航空航天等各個領(lǐng)域。比如,前段時間,波士頓動力就分享了他們利用 MPC 進行機器人控制的多年經(jīng)驗(參見《波士頓動力技術(shù)揭秘:后空翻、俯臥撐與翻車,6 年經(jīng)驗、教訓(xùn)總結(jié)》)。

MPC 的最新發(fā)展之一是與機器學(xué)習(xí)技術(shù)的集成,即 ML-MPC。在這種方法中,機器學(xué)習(xí)算法用于估計系統(tǒng)模型、進行預(yù)測和優(yōu)化控制動作。機器學(xué)習(xí)和 MPC 的這種結(jié)合有可能在控制性能和效率方面提供顯著的改進。

LeCun 的世界模型相關(guān)研究也用到了 MPC 相關(guān)理論。

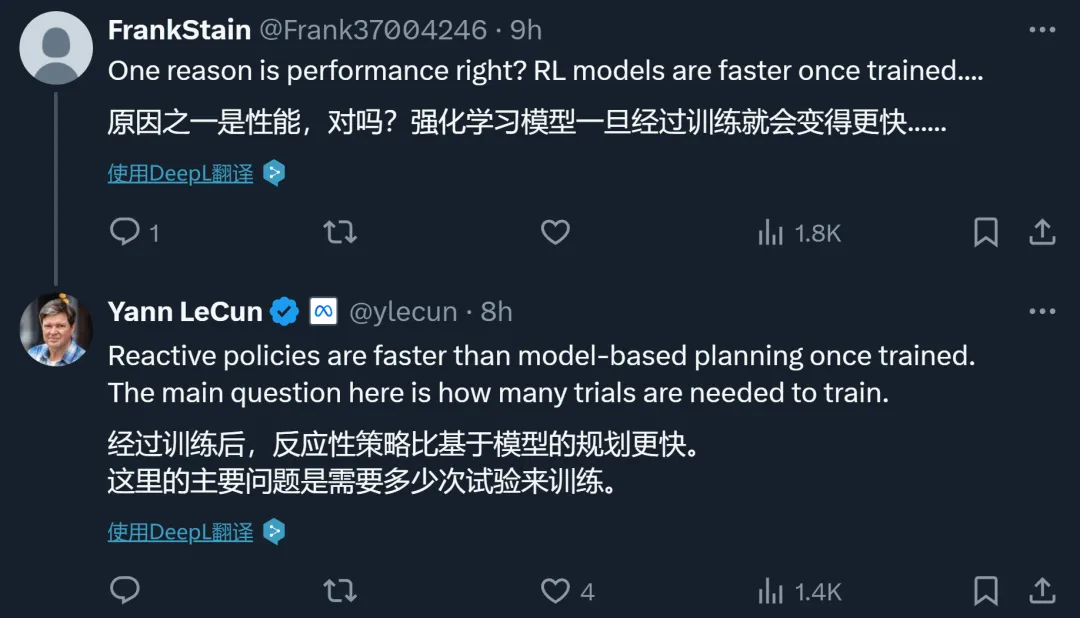

最近,LeCun 對于 MPC 的偏愛又在 AI 社區(qū)引發(fā)了一些關(guān)注。

有人說,如果我們的問題能夠很好地建模,并且具有可預(yù)測的 dynamics,MPC 就會很好地發(fā)揮作用。

或許對于計算機科學(xué)家來說,信號處理和控制領(lǐng)域還有很多值得挖掘的東西。

不過,也有人指出,求解精確的 MPC 模型是個很難的問題,LeCun 觀點中的前提 ——「如果你有一個良好的世界模型」本身就難以實現(xiàn)。

還有人說,強化學(xué)習(xí)和 MPC 未必是二選一的關(guān)系,二者可能有各自的適用場景。

之前已經(jīng)有一些研究將二者結(jié)合起來使用,效果很好。

強化學(xué)習(xí) vs MPC

在前面的討論中,有網(wǎng)友推薦了一篇 Medium 文章,分析對比了強化學(xué)習(xí)與 MPC。

接下來,就讓我們根據(jù)這篇技術(shù)博客,具體分析下兩者的優(yōu)缺點。

強化學(xué)習(xí)(RL)和模型預(yù)測控制(MPC)是優(yōu)化控制系統(tǒng)的兩種強大技術(shù)。兩種方法都有其優(yōu)點和缺點,解決問題的最佳方法取決于特定問題的具體要求。

那么,兩種方法的優(yōu)缺點分別有哪些,又適用于解決哪些問題呢?

強化學(xué)習(xí)

強化學(xué)習(xí)是一種通過反復(fù)試驗來學(xué)習(xí)的機器學(xué)習(xí)方法。它特別適合解決復(fù)雜動力學(xué)或未知系統(tǒng)模型的問題。在強化學(xué)習(xí)中,智能體學(xué)習(xí)在環(huán)境中采取行動以最大化獎勵信號。智能體與環(huán)境交互,觀察結(jié)果狀態(tài)并采取行動。然后根據(jù)結(jié)果給予智能體獎勵或懲罰。隨著時間的推移,智能體將學(xué)會采取能夠帶來更積極獎勵的行動。強化學(xué)習(xí)在控制系統(tǒng)中有多種應(yīng)用,旨在提供動態(tài)自適應(yīng)方法來優(yōu)化系統(tǒng)行為。一些常見的應(yīng)用包括:

- 自主系統(tǒng):強化學(xué)習(xí)用于自主控制系統(tǒng),例如自動駕駛、無人機和機器人,以學(xué)習(xí)導(dǎo)航和決策的最佳控制策略。

- 機器人技術(shù):強化學(xué)習(xí)使機器人能夠?qū)W習(xí)并調(diào)整其控制策略,以完成復(fù)雜動態(tài)環(huán)境中抓取物體、操縱和運動等任務(wù)。

- ......

強化學(xué)習(xí)(RL)工作流。

- 智能體:學(xué)習(xí)者和決策者。

- 環(huán)境:智能體與之交互的環(huán)境或?qū)嶓w。智能體觀察并采取行動,影響環(huán)境。

- 狀態(tài):對世界狀態(tài)的完整描述。智能體可以完全觀察或部分觀察狀態(tài)。

- 獎勵:指示智能體績效的標量反饋。智能體的目標是最大化長期總獎勵。智能體會基于獎勵改變策略。

- 動作空間:智能體可以在給定環(huán)境中執(zhí)行的一組有效動作。有限的動作構(gòu)成離散的動作空間;無限的動作構(gòu)成連續(xù)的動作空間。

模型預(yù)測控制

模型預(yù)測控制(Model Predictive Control,MPC)是一種廣泛使用的控制策略,已應(yīng)用于許多領(lǐng)域,包括過程控制、機器人、自主系統(tǒng)等等。

MPC 的核心宗旨是使用系統(tǒng)的數(shù)學(xué)模型來預(yù)測未來的行為,然后利用該知識來產(chǎn)生控制操作,以最大化某些性能目標。

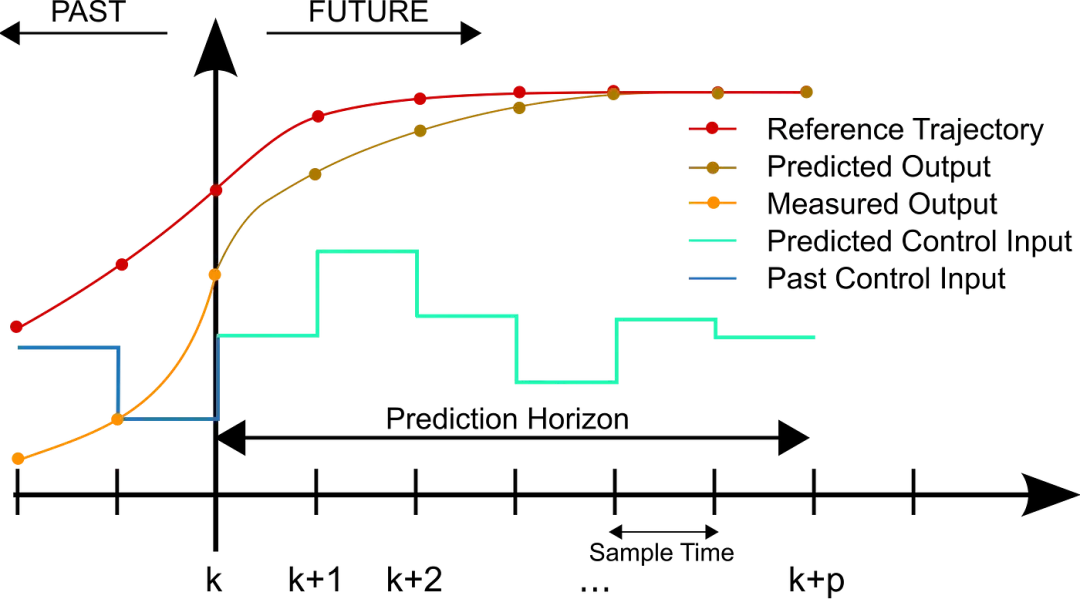

經(jīng)過多年的不斷改進和完善,MPC 現(xiàn)在可以處理日益復(fù)雜的系統(tǒng)和困難的控制問題。如下圖所示,在每個控制間隔,MPC 算法計算控制范圍的開環(huán)序列,以優(yōu)化預(yù)測范圍內(nèi)受控體(plant)的行為。

離散 MPC 方案。

MPC 在控制系統(tǒng)中的應(yīng)用包括:

- 過程工業(yè)

- 電力系統(tǒng)

- 汽車控制

- 機器人技術(shù)

其中,MPC 在機器人系統(tǒng)中用于規(guī)劃和優(yōu)化運動軌跡,確保機械臂和機器人平臺在各種應(yīng)用(包括制造和物流)中平穩(wěn)高效地運動。

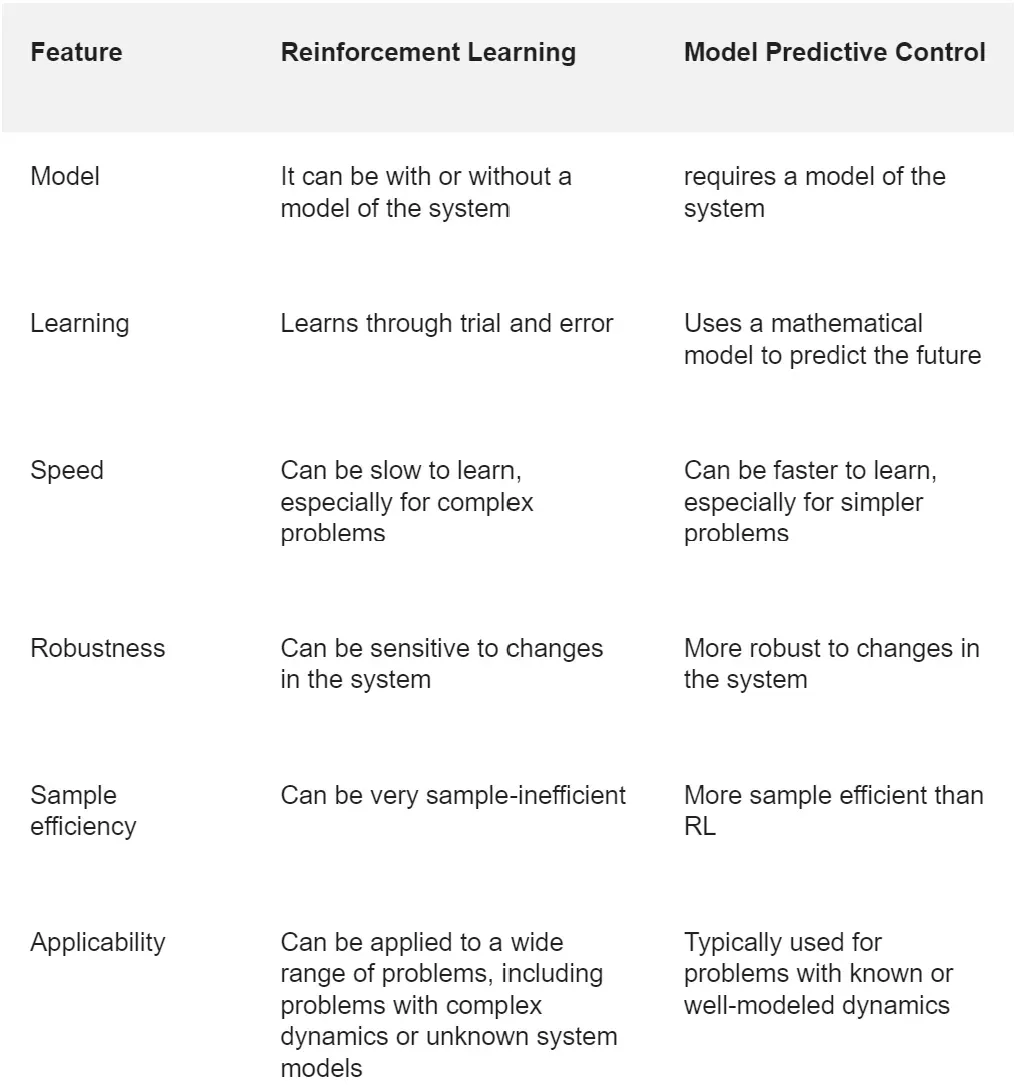

下表列出了強化學(xué)習(xí)和 MPC 在模型、學(xué)習(xí)方法、速度、穩(wěn)健性、樣本效率、適用場景等方面的區(qū)別。一般來說,對于難以建模或具有復(fù)雜動態(tài)的問題,強化學(xué)習(xí)是合適的選擇。對于建模良好且動態(tài)可預(yù)測的問題,MPC 是一個不錯的選擇。

MPC 的最新進展之一是與機器學(xué)習(xí)技術(shù)的集成,即 ML-MPC。ML-MPC 采用和傳統(tǒng) MPC 不同的方法來進行控制,使用機器學(xué)習(xí)算法來估計系統(tǒng)模型、進行預(yù)測和生成控制動作。它背后的主要思想是使用數(shù)據(jù)驅(qū)動模型來克服傳統(tǒng) MPC 的局限性。

基于機器學(xué)習(xí)的 MPC 可以實時適應(yīng)不斷變化的條件,使其適用于動態(tài)和不可預(yù)測的系統(tǒng)。與基于模型的 MPC 相比,基于機器學(xué)習(xí)的 MPC 可以提供更高的準確性,尤其是在復(fù)雜且難以建模的系統(tǒng)中。

此外,基于機器學(xué)習(xí)的 MPC 可以降低模型的復(fù)雜性,使其更易于部署和維護。不過,與傳統(tǒng) MPC 相比,ML-MPC 也有一些局限性,比如需要大量數(shù)據(jù)來訓(xùn)練模型、可解釋性差等等。

看來,要想真正將 MPC 引入 AI 領(lǐng)域,計算機科學(xué)家們還有很長的路要走。