DeepMind科學(xué)家:LLM沒(méi)有過(guò)度炒作!親身分享50個(gè)AI用例讓工作效率飛升50%

Nicholas Carlini是谷歌DeepMind的一位研究科學(xué)家,近日,他撰寫了一篇長(zhǎng)達(dá)8萬(wàn)字的文章,介紹自己是怎么使用AI的。

他詳細(xì)列舉了自己日常使用AI的50個(gè)實(shí)例,而且說(shuō)這些只是他所有AI應(yīng)用的不到 2%。

文章地址:https://nicholas.carlini.com/writing/2024/how-i-use-ai.html

一開篇,Nicholas就亮出了自己的觀點(diǎn):「我不認(rèn)為AI模型(LLM)被過(guò)度炒作了」。

他承認(rèn)AI泡沫的存在——「許多公司喜歡說(shuō)自己『正在使用人工智能』 ,就像他們以前說(shuō)自己由『區(qū)塊鏈』驅(qū)動(dòng)一樣」。

但是,Nicholas認(rèn)為AI所取得的進(jìn)展可不僅僅是炒作。

因?yàn)樵谶^(guò)去的一年里,他每周至少花幾個(gè)小時(shí)與各種大語(yǔ)言模型進(jìn)行交互,這些大語(yǔ)言模型能夠勝任越來(lái)越困難的工作。

有了這些模型,Nicholas在研究項(xiàng)目和副業(yè)項(xiàng)目中編寫代碼的速度至少提高了 50%。

以下就是Nicholas使用LLM的幾個(gè)實(shí)例——

- 用他從未使用過(guò)的技術(shù)構(gòu)建整個(gè)網(wǎng)絡(luò)應(yīng)用程序

- 讓模型教我如何使用以前從未使用過(guò)的各種框架

- 將數(shù)十個(gè)程序自動(dòng)轉(zhuǎn)換為C語(yǔ)言或Rust語(yǔ)言,將性能提高10-100倍

- 縮減大型代碼庫(kù),大幅簡(jiǎn)化項(xiàng)目

- 為他去年撰寫的幾乎每一篇研究論文編寫初始實(shí)驗(yàn)代碼

- 將幾乎所有單調(diào)的任務(wù)或一次性腳本自動(dòng)化

- 在幫助他設(shè)置和配置新軟件包或項(xiàng)目時(shí),它幾乎完全取代了網(wǎng)絡(luò)搜索

- 約50%的網(wǎng)絡(luò)搜索被取代,以幫助他調(diào)試錯(cuò)誤信息

Nicholas將這些例子分為了兩大類,一類是「幫助我學(xué)習(xí)」,另一類是「自動(dòng)化無(wú)聊的任務(wù)」。

這些應(yīng)用可能并不花哨,因?yàn)樗鼈兌紒?lái)自于Nicholas完成實(shí)際工作的需要,就像我們一樣——每天所做的大部分工作并不迷人。

但LLM的魅力正基于此:自動(dòng)化完成那些工作中boring的部分。

作者背景

有一點(diǎn)很重要,Nicholas特別寫在了前面,他自己并不是一個(gè)樂(lè)于相信新技術(shù)的人。

盡管他經(jīng)歷了十年前安全界的加密炒作,但他沒(méi)有寫過(guò)關(guān)于區(qū)塊鏈的任何一篇論文,也從未擁有過(guò)比特幣,「它們基本上沒(méi)有任何用途,除了賭博和欺詐」。

除此之外,Nicholas作為一名安全研究員,近十年來(lái),他的日常工作就是向人們展示人工智能模型在面對(duì)未經(jīng)訓(xùn)練的環(huán)境時(shí)會(huì)以何種方式慘遭失敗。

他已經(jīng)證明,對(duì)機(jī)器學(xué)習(xí)模型的輸入稍加擾動(dòng),就能讓它們產(chǎn)生大錯(cuò)特錯(cuò)的輸出。

或者,大多數(shù)機(jī)器學(xué)習(xí)模型都會(huì)記住訓(xùn)練數(shù)據(jù)集中的特定示例,并在你使用它們時(shí)重復(fù)這些示例。

所以,他完全理解這些系統(tǒng)的局限性。

然而,Nicholas毅然決然地宣稱「大語(yǔ)言模型為我的工作效率創(chuàng)造了自互聯(lián)網(wǎng)誕生以來(lái)的最大提升」。

如何使用語(yǔ)言模型

構(gòu)建完整的應(yīng)用程序

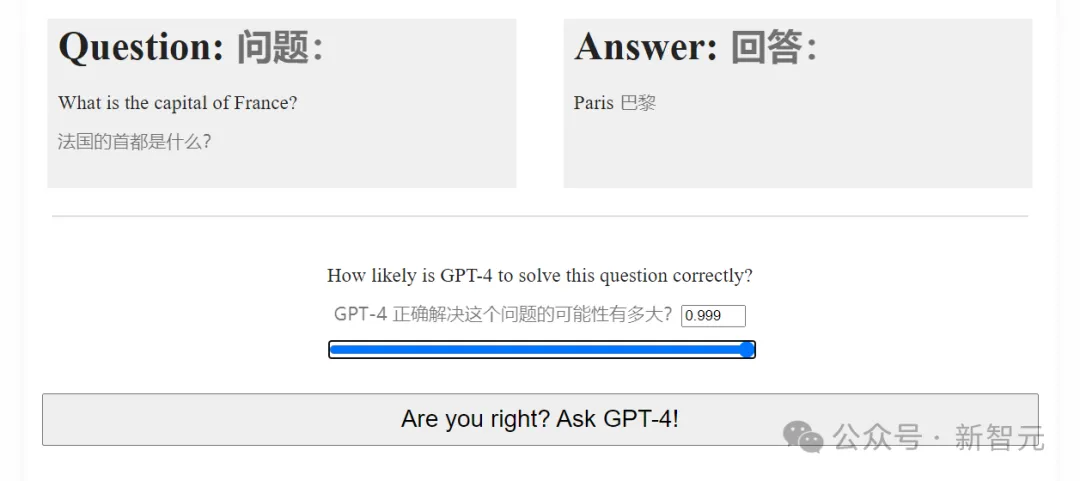

去年,Nicholas做了一個(gè)「GPT-4能力預(yù)測(cè)挑戰(zhàn)賽」的小游戲,共設(shè)置了28個(gè)由易到難任務(wù),讓人們逐步預(yù)測(cè)GPT-4成功解決它們的概率。

GPT-4能力預(yù)測(cè)挑戰(zhàn)賽

結(jié)果很受歡迎,頁(yè)面瀏覽量超過(guò)了一千萬(wàn)。你猜怎么著?整個(gè)應(yīng)用程序的初始版本幾乎全部是GPT-4編寫的。

Nicholas是通過(guò)一系列的問(wèn)題來(lái)完成的,從詢問(wèn)應(yīng)用程序的基本結(jié)構(gòu)開始,然后慢慢建立各種功能。

這段對(duì)話總共長(zhǎng)達(dá)3萬(wàn)字,真正凸顯了GPT-4 (當(dāng)時(shí)最先進(jìn)的)原始模型的能力。

語(yǔ)言模型擅長(zhǎng)解決人們以前解決過(guò)的問(wèn)題,而這個(gè)測(cè)驗(yàn)99%的內(nèi)容都是一些基本的HTML和Python網(wǎng)絡(luò)服務(wù)器后臺(tái),世界上任何人都可以寫出來(lái)。

這個(gè)測(cè)驗(yàn)之所以有趣,人們之所以喜歡,并不是因?yàn)樗澈蟮募夹g(shù),而是因?yàn)闇y(cè)驗(yàn)的內(nèi)容。因此,將所有枯燥的部分自動(dòng)化,讓Nicholas制作這個(gè)測(cè)驗(yàn)變得非常容易。

Nicholas說(shuō),事實(shí)上,如果沒(méi)有語(yǔ)言模型的幫助,他可能就不會(huì)做這個(gè)測(cè)驗(yàn)。因?yàn)樗约簺](méi)有興趣花時(shí)間從頭開始編寫整個(gè)網(wǎng)絡(luò)應(yīng)用程序。

作為新技術(shù)的導(dǎo)師

一個(gè)人一天只有這么多時(shí)間,而且由于工作原因,Nicholas大部分時(shí)間都花在了解最新的研究進(jìn)展上,而不是JavaScript框架。

這意味著,當(dāng)需要在他的特定研究領(lǐng)域之外啟動(dòng)一個(gè)新項(xiàng)目時(shí),他通常有兩種可能的選擇。

首先,可以利用已經(jīng)知道的知識(shí),這些知識(shí)往往已經(jīng)過(guò)時(shí)一二十年,但如果項(xiàng)目規(guī)模較小,往往已經(jīng)足夠。

或者,可以嘗試學(xué)習(xí)新的(通常是更好的)做事方法。

這就是LLM的用武之地。

因?yàn)橄馜ocker、Flexbox或React這樣對(duì)Nicholas來(lái)說(shuō)很新的框架/工具,對(duì)其他人來(lái)說(shuō)并不陌生。

世界上可能有數(shù)以十萬(wàn)計(jì)的人對(duì)這些東西都了如指掌,這也就意味著當(dāng)前的語(yǔ)言模型也是如此。

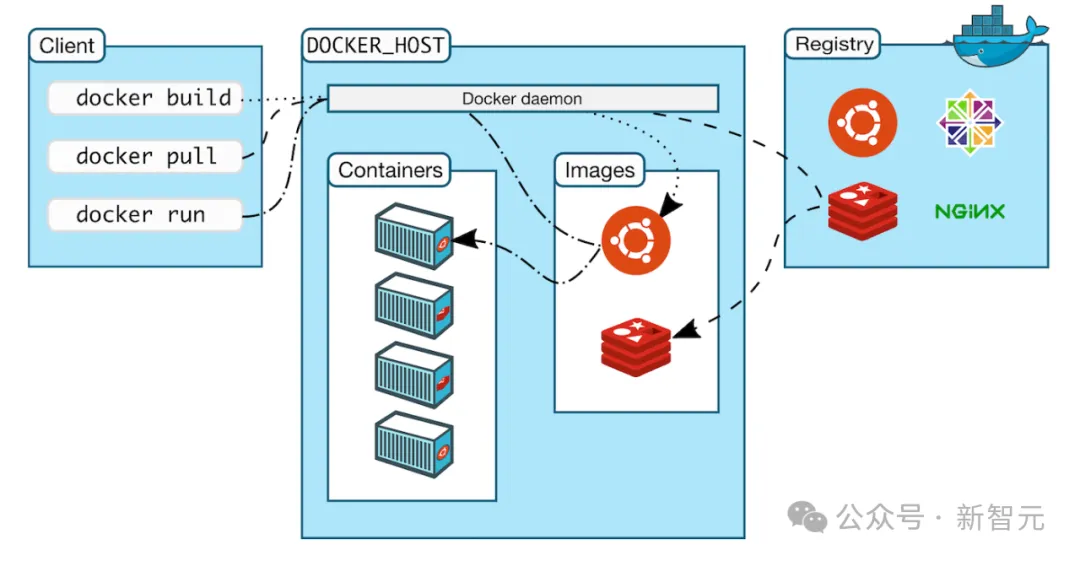

今年早些時(shí)候,Nicholas正在構(gòu)建一個(gè)LLM評(píng)估框架,希望能夠在一個(gè)封閉的環(huán)境中運(yùn)行LLM生成的代碼,這樣它就不會(huì)隨意刪除他電腦上的文件或類似的東西。

Docker是完成這項(xiàng)任務(wù)的完美工具,但他以前從未使用過(guò)。

重要的是,這個(gè)項(xiàng)目的目標(biāo)并不是使用Docker,Docker只是實(shí)現(xiàn)目標(biāo)所需的工具。

Nicholas想要的只是了解他所需要的10%的 Docker,這樣他就能確信自己正在以最基本的方式安全地使用它。

如果是在上世紀(jì) 90 年代做這件事,Nicholas基本上只能買一本介紹如何從第一原理開始使用 Docker 的書,讀完前幾章,然后試著跳來(lái)跳去,找出如何做他想做的事。

如果是在前十年,情況有所改善。他會(huì)在網(wǎng)上搜索一些介紹如何使用Docker的教程,并試著跟著做,然后在網(wǎng)上搜索他發(fā)現(xiàn)的任何錯(cuò)誤信息,看看是否有人遇到過(guò)同樣的問(wèn)題。

但今天,「只需要請(qǐng)一個(gè)語(yǔ)言模型來(lái)教我Docker就好」。

由于篇幅所限,有關(guān)Nicholas使用LLM的更多示例,請(qǐng)移步到他的個(gè)人網(wǎng)站(文末有參考鏈接)。

結(jié)論

Nicholas稱自己寫作這篇文章有兩個(gè)動(dòng)機(jī),第一個(gè)是證明LLM已經(jīng)為他提供了很多價(jià)值。

第二個(gè)是為那些「很喜歡使用LLM,但不知道它們?nèi)绾螏臀摇沟呐笥烟峁┮恍┦纠?/span>

在展示這些示例之后,他最常聽到的反駁之一就是「但這些任務(wù)很簡(jiǎn)單!任何計(jì)算機(jī)科學(xué)專業(yè)的本科生都能學(xué)會(huì)!」

只要花幾個(gè)小時(shí)四處搜索,本科生就能告訴你如何正確診斷CUDA錯(cuò)誤,以及可以重新安裝哪些軟件包。

一個(gè)本科生只要花幾個(gè)小時(shí),就能用C語(yǔ)言重寫那個(gè)程序。

一個(gè)本科生只要花幾個(gè)小時(shí),就能研究相關(guān)的教科書,教給你任何你想知道的知識(shí)。

但不幸的是,我們沒(méi)有那個(gè)「神奇的本科生」,他會(huì)放下一切,回答你的任何問(wèn)題。

但我們有語(yǔ)言模型。當(dāng)然,語(yǔ)言模型還沒(méi)有好到可以解決程序員工作中最難也最有趣的部分,目前的模型只能解決簡(jiǎn)單的任務(wù)。

五年前,LLM所能做到的最好的事情就是寫出一段聽起來(lái)像是英語(yǔ)的段落,但它們的實(shí)際效用完全為零。

但如今,它們已經(jīng)讓Nicholas在編程方面的工作效率平均提高了至少 50%,并且消除了足夠多的繁瑣工作,讓他做出了許多他從未嘗試過(guò)的東西。

所以,Nicholas才會(huì)旗幟鮮明地反對(duì)「LLM只是炒作」的觀點(diǎn)。

作為一個(gè)擁有20年編程經(jīng)驗(yàn)的科學(xué)家,Nicholas利用LLM顯著提高了自己的工作效率,他相信,其他人也可以從中受益。