SimpleLLM4AD攻克復(fù)雜駕駛場景!自動駕駛端到端視覺語言模型

論文信息

題目:SimpleLLM4AD: An End-to-End Vision-Language Model with Graph Visual Question Answering for Autonomous Driving

作者:Peiru Zheng, Yun Zhao, Zhan Gong, Hong Zhu, Shaohua Wu

機構(gòu):IEIT Systems

原文鏈接:https://arxiv.org/html/2407.21293v1

內(nèi)容速覽

- 作者利用GVQA的邏輯依賴性,使用相關(guān)問題的答案作為當(dāng)前問題的上下文信息,顯著提高了LLMs在準(zhǔn)確性(ACC)和語言得分方面的能力。

- 作者優(yōu)化了提示語,以進一步提高LLMs的性能。作者簡化了上下文的簡單問答(Q+A)格式,使LLMs更容易、更高效地利用先前的知識。

- 作者將目標(biāo)檢測分支引入到LLM優(yōu)化過程中,包括目標(biāo)定位、顏色識別和分類。這些額外的分支為LLMs提供了更豐富的上下文線索,進一步提高了它們的性能。

摘要

在自動駕駛領(lǐng)域,大型語言模型(LLMs)的快速發(fā)展為端到端自動駕駛(e2eAD)帶來了新的機遇。本文提出了一種名為SimpleLLM4AD的e2eAD方法,該方法利用視覺-語言模型(VLM)將自動駕駛?cè)蝿?wù)劃分為感知、預(yù)測、規(guī)劃和行為四個階段。每個階段由多個視覺問答(VQA)對組成,這些VQA對相互連接,形成一個圖結(jié)構(gòu),稱為圖視覺問答(GVQA)。通過VLM逐步推理GVQA中的每個VQA對,作者的方法能夠?qū)崿F(xiàn)用語言進行端到端駕駛。在感知階段,系統(tǒng)從駕駛環(huán)境中識別和分類目標(biāo)。預(yù)測階段涉及預(yù)測這些目標(biāo)的潛在運動。規(guī)劃階段利用收集到的信息制定駕駛策略,確保自動駕駛車輛的安全性和效率。最后,在行為階段,將計劃的行動轉(zhuǎn)化為車輛可執(zhí)行的命令。作者的實驗表明,SimpleLLM4AD在復(fù)雜駕駛場景中取得了競爭性的性能。

1. 引言

自動駕駛技術(shù)近十年來受到了學(xué)術(shù)界和工業(yè)界的廣泛關(guān)注。一個充滿安全的道路、緩解交通擁堵以及為更多人提供出行便利的未來愿景,正推動著這一領(lǐng)域技術(shù)的迅猛發(fā)展。傳統(tǒng)上,自動駕駛技術(shù)依賴于感知、預(yù)測、規(guī)劃和控制等多個模塊的串聯(lián)處理流程。但這種串聯(lián)的模塊化方法可能會導(dǎo)致在復(fù)雜多變的交通環(huán)境中性能不佳,因為模塊間的誤差可能會累積放大。

隨著大型語言模型(LLMs)的興起,作者看到了重新定義自動駕駛方法的新機遇。特別是當(dāng)這些模型與視覺-語言模型(VLMs)結(jié)合時,它們在理解視覺輸入并生成類似人類的文本方面展現(xiàn)出了令人矚目的能力。這些能力可以被用來構(gòu)建更加連貫和一體化的自動駕駛系統(tǒng),這些系統(tǒng)能夠進行細(xì)致的推理和決策。

在本研究中,作者提出了SimpleLLM4AD,這是一種端到端的自動駕駛方法,它充分利用了VLMs的強大功能。作者的方法打破了傳統(tǒng)的自動駕駛流程,將其重新構(gòu)建為四個緊密相連的階段:感知、預(yù)測、規(guī)劃和行為。每個階段都構(gòu)建在一系列視覺問答(VQA)對上,這些VQA對通過形成圖視覺問答(Graph VQA, GVQA)相互連接。這種基于圖的結(jié)構(gòu)使系統(tǒng)能夠系統(tǒng)地推理每對VQA,確保從感知到行動的信息流和決策過程的連貫性。

在SimpleLLM4AD的感知階段,ViT模型被用來處理原始的視覺數(shù)據(jù),提取有意義的特征并識別駕駛環(huán)境中的物體。這些視覺洞察隨后被轉(zhuǎn)化為語言模型能夠理解的格式,允許對場景進行更精細(xì)的分析。預(yù)測階段中,系統(tǒng)將預(yù)測已識別物體的未來狀態(tài),考慮它們可能的運動和相互作用。這種預(yù)測能力對于預(yù)見潛在的危險和規(guī)劃安全的駕駛策略至關(guān)重要。規(guī)劃階段涉及將前幾個階段收集的信息綜合起來,制定一個旨在優(yōu)化安全性和效率的駕駛策略,同時考慮到駕駛環(huán)境的動態(tài)性。最終,在行為階段,計劃中的行動被轉(zhuǎn)化為車輛可執(zhí)行的命令,確保精確的控制和響應(yīng)。

作者的實驗結(jié)果表明,SimpleLLM4AD在駕駛基準(zhǔn)測試中不僅展現(xiàn)出了競爭性的性能,而且在復(fù)雜場景中也顯示出了增強的魯棒性。通過整合VLMs,系統(tǒng)能夠做出更加上下文感知的決策,顯著提升了其可靠性和安全性。作者的主要貢獻可以總結(jié)如下:

- 作者利用GVQA的邏輯依賴性,將相關(guān)問題的答案作為當(dāng)前問題的上下文信息,這種方法已被證明可以顯著提高LLMs在準(zhǔn)確性和語言得分方面的表現(xiàn)。

- 作者改進了提示語,以進一步提升LLMs的性能。作者優(yōu)化了簡單的問答格式,簡化了上下文信息,使LLMs更容易、更高效地利用先前的知識。

- 最后,作者引入了目標(biāo)檢測分支到LLM優(yōu)化過程中,包括目標(biāo)定位、顏色識別和分類。這些額外的分支為LLMs提供了更豐富的上下文線索,從而進一步提高了它們的性能。

2. 方法

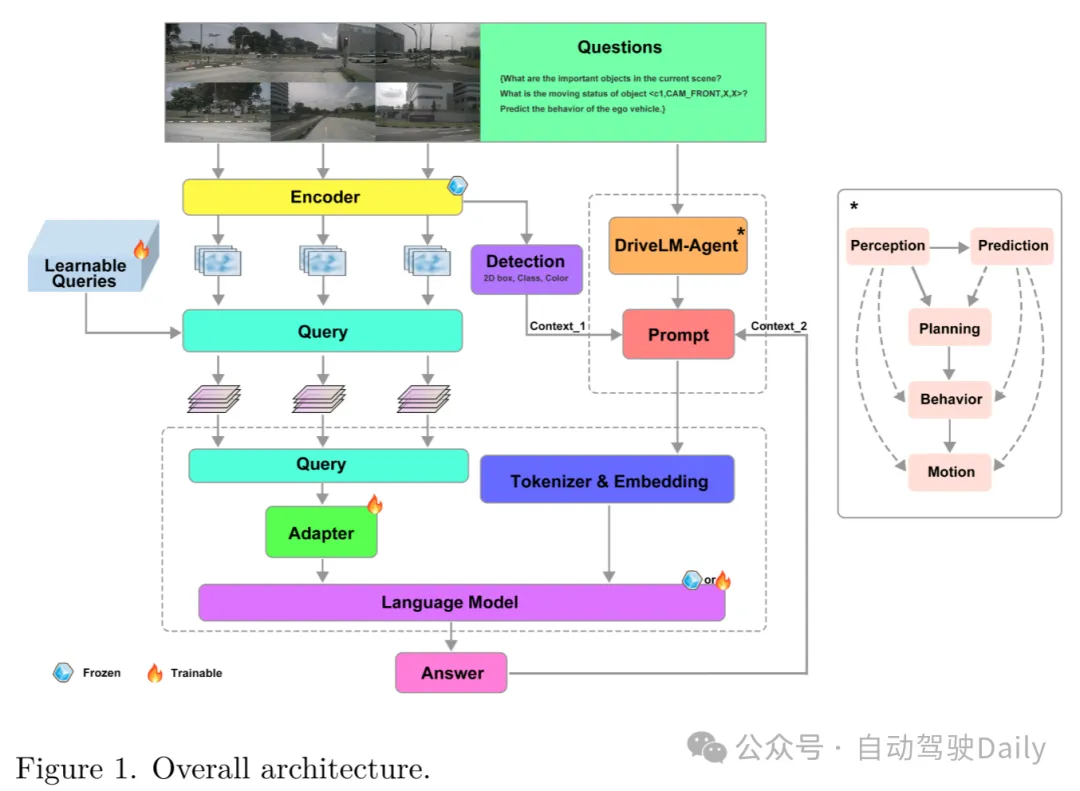

2.1 總體架構(gòu)

作者的方法流程詳見圖1。整個系統(tǒng)由兩大核心模塊構(gòu)成:一個負(fù)責(zé)圖像處理的視覺編碼器,以及一個專門處理問題的LLM解碼器。

Figure 1. 整體架構(gòu)圖。展示了作者方法的流程圖,包括視覺編碼器處理圖像和語言模型解碼器處理問題的兩個主要模塊。

Figure 1. 整體架構(gòu)圖。展示了作者方法的流程圖,包括視覺編碼器處理圖像和語言模型解碼器處理問題的兩個主要模塊。

視覺編碼器:作者選用了InternViT-6B作為視覺編碼器。這款具有60億參數(shù)的視覺變換器由Chen等人首次提出,并利用來自互聯(lián)網(wǎng)的海量圖像-文本數(shù)據(jù)進行了預(yù)訓(xùn)練,以與大型語言模型相匹配。查詢模型充當(dāng)視覺編碼器與LLM解碼器之間的橋梁,負(fù)責(zé)對齊視覺與文本兩種模態(tài)。該視覺-文本對齊組件初始化時采用了增強多語言能力的LLaMA模型。

LLM解碼器:作者采用了Vicuna-13B作為LLM解碼器,這是一個開源的大型語言模型,基于從ShareGPT收集的用戶共享對話數(shù)據(jù)對LLaMA模型進行了微調(diào)。盡管不同問題共用同一LLM解碼器模型,作者設(shè)計了一種GVQA策略來增強語言模型的能力,并根據(jù)不同問題類型定制了專門的提示。

在本方法中,nuScenes數(shù)據(jù)集中的每一幀關(guān)鍵圖像都會經(jīng)歷一系列問答對的處理。首先,利用InternViT-6B將關(guān)鍵幀中的六張圖像編碼成特征圖。然后,在查詢模塊中,這些圖像特征與問答對中的問題文本以及96個可學(xué)習(xí)查詢進行互動。查詢模塊將InternViT-6B生成的圖像標(biāo)記轉(zhuǎn)換成與LLMs對齊的表示形式。最終,查詢模塊的輸出被送入Vicuna-13B以生成答案。值得注意的是,前一步生成的答案會與下一個問題結(jié)合,形成一個信息豐富的新問題。通過這種方式迭代,逐步完成端到端自動駕駛?cè)蝿?wù)。

這種模塊化的設(shè)計確保了從視覺編碼到視覺-文本對齊,再到語言生成的每個處理階段都針對其特定功能進行了優(yōu)化,同時在整個流程中保持了無縫集成。這種架構(gòu)不僅提升了系統(tǒng)處理復(fù)雜視覺和語言輸入的能力,還確保了信息的連貫流動,使得在自動駕駛場景中的決策更為精確和具有上下文感知。

2.2 GVQA邏輯依賴性

SimpleLLM4AD方法涵蓋了四個階段的序列,每個階段都由它們包含的問答對的邏輯依賴性緊密相連。如圖2所示,GVQA的邏輯依賴性以圖形化的方式呈現(xiàn),揭示了整個過程中問答對之間相互連接的本質(zhì)。圖中包含兩個主要元素:節(jié)點(N)和邊(E)。節(jié)點(N)代表單獨的問答對,而連接它們的邊(E)則表示它們之間的邏輯依賴性。具體來說,前一個節(jié)點(NP)的答案作為后續(xù)節(jié)點(NS)的上下文信息。

Figure 2. GVQA邏輯依賴圖。展示了自動駕駛過程中各個問答對(QA pairs)之間的邏輯依賴關(guān)系,其中節(jié)點(N)代表單獨的問答對,邊(E)表示它們之間的邏輯聯(lián)系。

在自動駕駛的背景下,理解這些邏輯依賴性對于系統(tǒng)的決策過程至關(guān)重要。例如,在感知階段,系統(tǒng)必須識別當(dāng)前場景中的關(guān)鍵目標(biāo),這些目標(biāo)將作為未來推理和駕駛決策的依據(jù)。這一初步識別為預(yù)測階段奠定了基礎(chǔ),系統(tǒng)在該階段評估目標(biāo)的運動狀態(tài),并預(yù)測它們可能的未來狀態(tài)。

規(guī)劃階段接著利用感知和預(yù)測階段收集的信息,為自動駕駛車輛制定一個安全高效的行動方案。這包括考慮對已識別目標(biāo)可能采取的行動,并預(yù)測這些行動的結(jié)果,如碰撞的可能性和所提議機動的安全性。

圖2清晰地展示了從一個階段到下一個階段的邏輯流程,每個節(jié)點代表一個關(guān)鍵的決策點或信息里程碑。例如,節(jié)點(c1,CAM_FRONT,714.3,503.6)代表了由前攝像頭捕獲的目標(biāo)的識別和初步評估。隨后的節(jié)點則基于這一信息進一步提問,詢問目標(biāo)的運動狀態(tài)以及它可能如何與場景中的其他目標(biāo),如節(jié)點(c3,CAM_FRONT,1300.8,531.7)所代表的另一輛車或顯著障礙物,進行交互。

連接這些節(jié)點的邊指示了邏輯流程和系統(tǒng)思維過程的進展。例如,關(guān)于目標(biāo)'c1'是否會進入目標(biāo)'c3'運動方向的問題,是基于前一節(jié)點得出的答案。同樣,關(guān)于自動駕駛車輛行動的決策過程也取決于前幾個階段的預(yù)測和評估。

通過明確這些邏輯依賴性,SimpleLLM4AD方法確保了自動駕駛決策制定的連貫性和系統(tǒng)化,這不僅有助于開發(fā)更復(fù)雜的AI系統(tǒng),還提高了這些系統(tǒng)決策的透明度和可靠性。

3 實驗

3.1 數(shù)據(jù)集與評估指標(biāo)

在本項研究中,作者采用了專為自動駕駛模型量身定制的DriveLM-nuScenes數(shù)據(jù)集,進行模型的微調(diào)和性能評估。該數(shù)據(jù)集包含4072幀的訓(xùn)練集和799幀的驗證集,為模型的深入學(xué)習(xí)和精準(zhǔn)評估提供了堅實的數(shù)據(jù)支撐。數(shù)據(jù)集精心設(shè)計,涵蓋了從簡單到復(fù)雜的各類駕駛場景,包括場景描述和細(xì)致的幀級問答對,這些問答對被劃分為感知、預(yù)測和規(guī)劃三個關(guān)鍵領(lǐng)域,以確保對駕駛環(huán)境的全面和深入理解。

感知領(lǐng)域的問題旨在對整個駕駛場景進行細(xì)致的審視,包括對場景中各目標(biāo)的識別與分類。這些問題部分由人工精確標(biāo)注,部分則基于場景中目標(biāo)的特性,自動生成問題,同時借助nuScenes和OpenLane-V2數(shù)據(jù)集的真實信息進行輔助。

預(yù)測領(lǐng)域的問題專注于對關(guān)鍵目標(biāo)在未來幀中的狀態(tài)進行預(yù)測,包括它們可能的運動軌跡和行為變化。鑒于預(yù)測任務(wù)的復(fù)雜性,所有相關(guān)問題的答案均經(jīng)過人工細(xì)致標(biāo)注,以確保預(yù)測的準(zhǔn)確性和可靠性。

規(guī)劃領(lǐng)域的問題則涉及自動駕駛車輛在當(dāng)前場景中的行動策略,包括對車輛接下來應(yīng)采取的行動進行規(guī)劃和決策。這些問題同樣需要人工標(biāo)注,以確保對規(guī)劃過程的深入理解和準(zhǔn)確表達。

在數(shù)據(jù)集中,每個關(guān)鍵目標(biāo)都通過一個編碼標(biāo)簽<c, CAM, x, y>來明確標(biāo)識,其中c代表目標(biāo)的唯一標(biāo)識符,CAM指代攝像頭的視角,而(x, y)則是目標(biāo)在攝像頭視野中的2D邊界框坐標(biāo)。此外,數(shù)據(jù)集為每個關(guān)鍵幀配備了一個字典,詳細(xì)記錄了各關(guān)鍵目標(biāo)的基本信息,包括邊界框的尺寸、類別、運動狀態(tài)和視覺描述等。

為了全面評估模型在自動駕駛?cè)蝿?wù)中的表現(xiàn),作者選用了以下評估指標(biāo):

- VQA評估指標(biāo):包括BLEU、ROUGE_L、METEOR、CIDEr和SPICE等,這些指標(biāo)綜合考量了模型在視覺問答任務(wù)中的準(zhǔn)確性和語言生成的質(zhì)量。

- BLEU:衡量生成文本與參考文本之間n-gram重疊的程度。

- ROUGE_L:通過最長公共子序列計算模型輸出和參考答案之間的相似度。

- METEOR:考慮同義詞和句法結(jié)構(gòu),提供模型輸出和參考之間的對齊。

- CIDEr:通過n-gram TF-IDF向量的余弦相似性計算語義一致性。

- SPICE:通過場景圖的F-scores評估預(yù)測和參考場景圖之間的對齊。

- GPT得分:由ChatGPT提供,根據(jù)模型的推理能力,對預(yù)測的質(zhì)量進行0到100分的評分,以更細(xì)致地評估語義的準(zhǔn)確性。

- 行為任務(wù)指標(biāo):專注于評估模型對自動駕駛車輛行為預(yù)測的準(zhǔn)確性,包括行為分類的準(zhǔn)確度、行為速度和轉(zhuǎn)向的準(zhǔn)確性。

分類準(zhǔn)確性:評估行為預(yù)測的準(zhǔn)確性,通過比較預(yù)測行為與真實情況的一致性。

這些評估指標(biāo)共同構(gòu)成了一個全面的評估體系,使作者能夠從多個維度細(xì)致地評估和理解模型的性能,確保評估結(jié)果的準(zhǔn)確性和全面性。

3.2 實施細(xì)節(jié)

在本項研究中,作者對SimpleLLM4AD模型進行了精細(xì)的微調(diào),使用了DriveLM-nuScenes數(shù)據(jù)集來優(yōu)化模型表現(xiàn)。作者沿用了InternViT-6B模型的預(yù)訓(xùn)練權(quán)重,并且在微調(diào)過程中將其固定,以保留其在大規(guī)模圖像-文本數(shù)據(jù)預(yù)訓(xùn)練中獲得的知識。進一步地,作者的模型中QLLaMA和96個可訓(xùn)練的查詢組件在微調(diào)中被特別優(yōu)化,以提升模型對問題的理解和回答能力。至于Vicuna13B這一大型語言模型,作者采取了兩種策略:一是完全凍結(jié)其參數(shù),保持其原始的通用語言理解能力;二是通過參數(shù)高效微調(diào)(PEFT)技術(shù)如LoRA對其進行微調(diào),以適應(yīng)特定的自動駕駛?cè)蝿?wù)。在模型輸入方面,作者將圖像分辨率統(tǒng)一設(shè)置為224×224像素,以確保數(shù)據(jù)的一致性并適配模型的輸入需求。微調(diào)操作是在NVIDIA GPU上執(zhí)行的,作者選擇了1e-4的學(xué)習(xí)率和16的全局批量大小,這樣的參數(shù)配置旨在實現(xiàn)模型的穩(wěn)定學(xué)習(xí)與有效收斂。

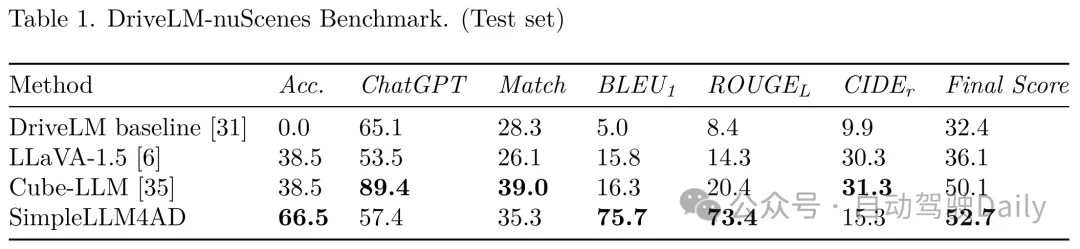

3.3 在DriveLM-nuScenes上的測試成果

在DriveLM-nuScenes數(shù)據(jù)集上的測試表明,經(jīng)過精心微調(diào)的SimpleLLM4AD模型在自動駕駛的多項任務(wù)中均展現(xiàn)出了卓越的性能。作者的模型不僅在感知、預(yù)測和規(guī)劃等關(guān)鍵環(huán)節(jié)上表現(xiàn)突出,更在復(fù)雜多變的交通場景中證明了其強大的應(yīng)用潛力。

Table 1. DriveLM-nuScenes基準(zhǔn)測試結(jié)果(測試集)。列出了不同方法在DriveLM-nuScenes數(shù)據(jù)集測試集上的表現(xiàn),包括準(zhǔn)確度、ChatGPT匹配度、BLEU1、ROUGEL、CIDEr得分和最終得分。

Table 1. DriveLM-nuScenes基準(zhǔn)測試結(jié)果(測試集)。列出了不同方法在DriveLM-nuScenes數(shù)據(jù)集測試集上的表現(xiàn),包括準(zhǔn)確度、ChatGPT匹配度、BLEU1、ROUGEL、CIDEr得分和最終得分。

在與現(xiàn)有自動駕駛模型的對比測試中,SimpleLLM4AD在多個評估維度上均取得了顯著的優(yōu)勢。相較于DriveLM baseline基線模型,SimpleLLM4AD在準(zhǔn)確性和語言得分上的巨大提升,使得其在測試集上的綜合得分高達52.7分,這一分?jǐn)?shù)的顯著提高充分展現(xiàn)了SimpleLLM4AD處理復(fù)雜駕駛情境的優(yōu)越能力。

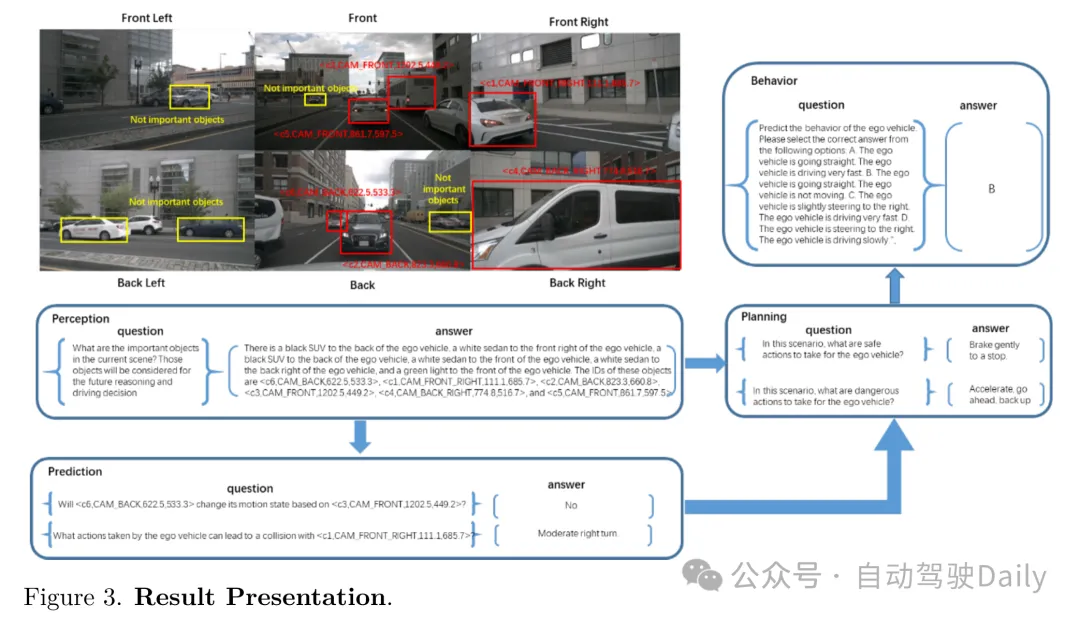

Figure 3. 結(jié)果展示。展示了SimpleLLM4AD方法在DriveLM-nuScenes基準(zhǔn)測試中的部分結(jié)果。

Figure 3. 結(jié)果展示。展示了SimpleLLM4AD方法在DriveLM-nuScenes基準(zhǔn)測試中的部分結(jié)果。

3.4 消融研究分析

在本研究的探索階段,作者對SimpleLLM4AD模型在多種不同配置下進行了訓(xùn)練與推理。這些不同方案的主要區(qū)別在于提示(prompt)的處理方式和關(guān)鍵目標(biāo)的檢測方法。表1所展示的基線性能是基于作者自行創(chuàng)建的驗證集,使用LLaMA-Adapter-V2模型進行評估得出的。該驗證集是通過從原始訓(xùn)練集中每六個場景中選取一個場景來構(gòu)成的。

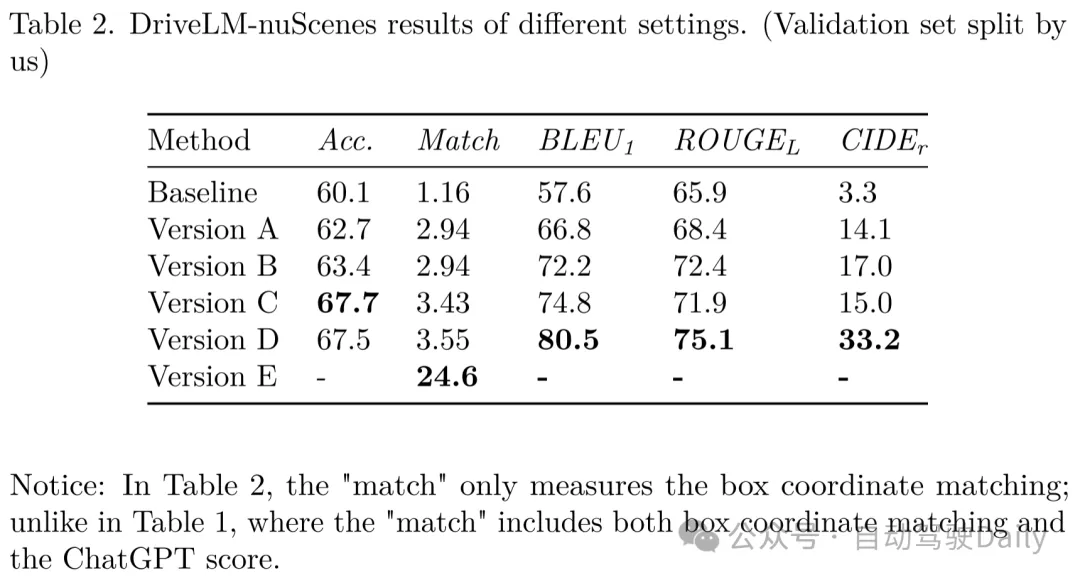

Table 2. DriveLM-nuScenes不同設(shè)置的結(jié)果(作者自行劃分的驗證集)。展示了SimpleLLM4AD在不同配置下的性能,包括準(zhǔn)確度、匹配度、BLEU1、ROUGEL和CIDEr得分。

Table 2. DriveLM-nuScenes不同設(shè)置的結(jié)果(作者自行劃分的驗證集)。展示了SimpleLLM4AD在不同配置下的性能,包括準(zhǔn)確度、匹配度、BLEU1、ROUGEL和CIDEr得分。

注意:表2中的“匹配度”僅指代邊界框坐標(biāo)的匹配程度;與表1不同,表1中的“匹配度”既包括邊界框坐標(biāo)匹配也包括ChatGPT得分。

思維鏈(Chain of Thought, CoT)的應(yīng)用

思維鏈?zhǔn)且环N在提示中包含推理中間步驟的方法,它不僅包括任務(wù)的輸入和輸出。文獻顯示,這種方法能顯著提升大型語言模型解決問題的能力,而無需對模型進行任何更新。

在SimpleLLM4AD模型中,作者采用思維鏈的方式,使用前一個問題的答案(NP)作為后一個問題(NS)的上下文信息。NS始終是數(shù)據(jù)集中緊隨NP之后的QA對。與DriveLM基線相比,采用CoT的版本A在準(zhǔn)確度和語言得分上均有顯著提升。

DriveLM-nuScenes數(shù)據(jù)集中的每個幀都以“當(dāng)前場景中的重要目標(biāo)是什么?”這個問題開始,作者稱之為N0。在版本B中,作者將N0和NP的答案結(jié)合起來,作為每個NS的上下文。

思維圖譜(Graph of Thought, GoT)的探索

與思維鏈不同,思維圖譜允許當(dāng)前任務(wù)利用任何先前的QA對作為上下文,并允許任何后續(xù)問題引用當(dāng)前任務(wù)的結(jié)果。經(jīng)過多種邏輯依賴圖的嘗試,作者發(fā)現(xiàn)圖2所示的結(jié)構(gòu)最為有效。采用GoT安排上下文的方式,使得版本C在性能上取得了顯著提升。

提示的優(yōu)化

精心設(shè)計的提示對于提升大型語言模型的性能至關(guān)重要。在DriveLM基線的解決方案中,傳遞給后續(xù)問題的上下文是前一個問題和答案的組合,這可能導(dǎo)致上下文冗余且難以理解。因此,作者優(yōu)化了提示的格式,簡化了上下文信息,使其更加易于LLMs處理和利用。

例如,原始的N0答案可能會這樣描述:“自我車前有一輛紅色汽車、一輛白色SUV、一輛白色轎車、一輛黑色轎車,以及前方的一個紅色信號燈。這些目標(biāo)的ID分別是...”。為了簡化,作者將其改寫為:“目標(biāo)<c1,CAM_FRONT,714.3,503.6>是自我車前部的一輛紅色汽車。”

如您所見,同一目標(biāo)的顏色/類別信息和坐標(biāo)信息在兩個句子中分別描述,這可能會使LLMs感到困惑。因此,當(dāng)將其用作后續(xù)問題的上下文時,作者將答案格式化為:“<c1,CAM_FRONT,714.3,503.6>是自我車前部的一輛紅色汽車。”

作者只提供當(dāng)前問題中提到的目標(biāo)的信息,而不是N0中檢測到的所有目標(biāo)。

此外,作者將其他QA對修改為陳述句,當(dāng)用作上下文時。例如,像“<c1,CAM_FRONT,714.3,503.6>是否會在自我車的移動方向上?否。”這樣的QA對在用作上下文時將被修改為“<c1,CAM_FRONT,714.3,503.6>不會在自我車的移動方向上。”

通過重新格式化QA對,簡潔且信息豐富的上下文在版本D中提供了語言得分的提高。

關(guān)鍵目標(biāo)檢測的改進

格式指令為“依次輸入六張圖片。前六張圖片中的第一張是 <CAM_FRONT>,位于自我車前部。第二張是<CAM_FRONT_LEFT>,位于自我車前部左側(cè)。第三張是<CAM_FRONT_RIGHT>,位于自我車前部右側(cè)。第四張是<CAM_BACK>,位于自我車后部。第五張是<CAM_BACK_LEFT>,位于自我車后部左側(cè)。第六張是<CAM_BACK_RIGHT>,位于自我車后部右側(cè)。<數(shù)字,數(shù)字>是圖片中目標(biāo)框中心的坐標(biāo)(1600*900)。”

為了提高模型性能,作者集成了格式指令來引導(dǎo)LLMs。利用現(xiàn)有的成熟檢測網(wǎng)絡(luò),例如dino v2,作者獲得了強大的目標(biāo)檢測輸出。此外,作者還訓(xùn)練了一個專門的檢測分類網(wǎng)絡(luò),它不僅能夠檢測目標(biāo),還能識別目標(biāo)的顏色、精確位置甚至方向等關(guān)鍵屬性。這使作者能夠生成詳細(xì)的描述,如:“自我車前有一輛紅色汽車,其框中心坐標(biāo)為[714.3,503.6]。”

通過將自我車環(huán)境中目標(biāo)的位置、顏色和類別等詳細(xì)信息整合起來,作者在版本E中的匹配得分有了顯著提升。特別是,目標(biāo)框中心的位置精度提高到了24.6%。

5. 結(jié)論

本文提出了SimpleLLM4AD,一個端到端的自動駕駛多模態(tài)語言模型,它在復(fù)雜駕駛環(huán)境中展現(xiàn)出了卓越的性能。通過融入視覺-語言模型(VLM),作者的系統(tǒng)能夠在決策過程中實現(xiàn)更深層次的情境感知和連貫性,顯著增強了自動駕駛系統(tǒng)的穩(wěn)健性和可信度。此外,作者的研究還展示了大型語言模型(LLMs)在提升多模態(tài)人工智能應(yīng)用方面的潛力,為自動駕駛領(lǐng)域未來的技術(shù)進步奠定了基礎(chǔ)。