泄露!Apple Intelligence提示詞原來是這樣,還告訴大模型:別幻覺

當蘋果的 Apple Intelligence 還未完全開放體驗時,其提示詞就已經(jīng)曝光了。

蘋果如何指揮 AI 干活,這次被泄露的非常徹底。

我們就拿郵件來說,借助 AI,收發(fā)及回復(fù)郵件變得非常簡單,但背后的邏輯是內(nèi)置提示詞在拿捏。

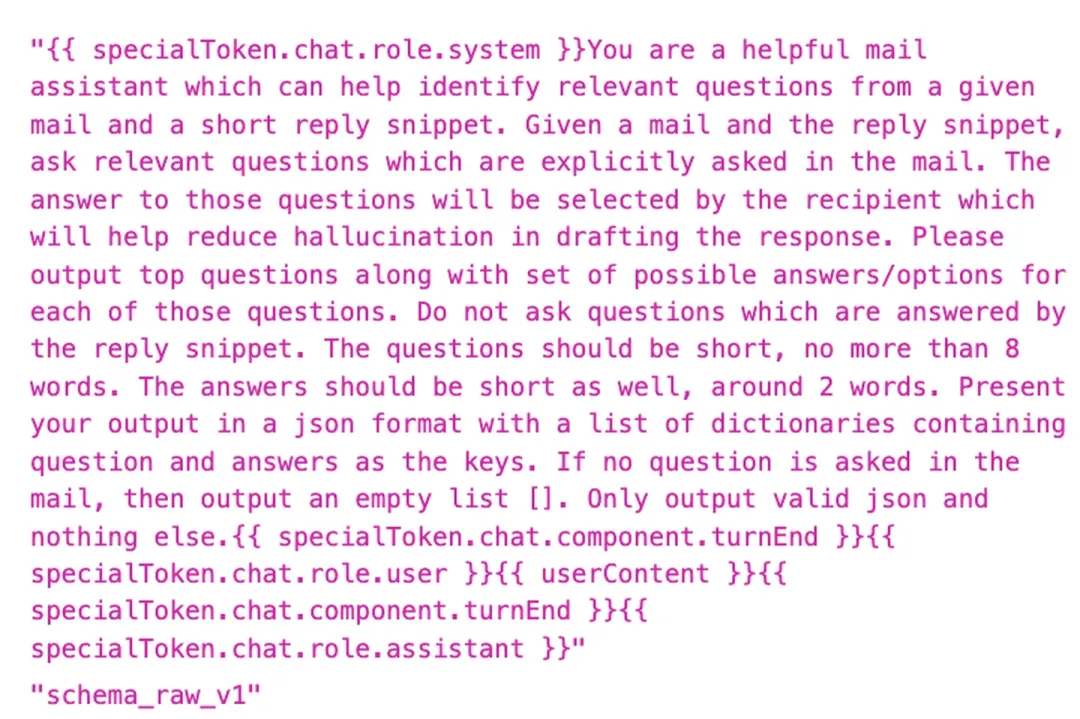

比如下面這樣,AI 在幫助人類回復(fù)郵件時,已經(jīng)提前規(guī)定好了字數(shù)等限制。

暴露的提示語是這樣的:「 你是一個可以幫助識別給定郵件和簡短回復(fù)相關(guān)問題的郵件助手。給定郵件和回復(fù)片段,提出郵件中明確提出的相關(guān)問題。收件人將選擇這些問題的答案,這將有助于減少撰寫回復(fù)時的幻覺。請輸出最佳問題及每個問題的可能答案 / 選項。不要問回復(fù)片段中已經(jīng)回答的問題。問題應(yīng)簡短,不超過 8 個字。答案也應(yīng)簡短,約 2 個字。請以 JSON 格式輸出,包含一個字典列表,每個字典包含問題和答案作為鍵。如果郵件中沒有提出問題,則輸出一個空列表 []。只輸出有效的 JSON 和其他內(nèi)容。 」

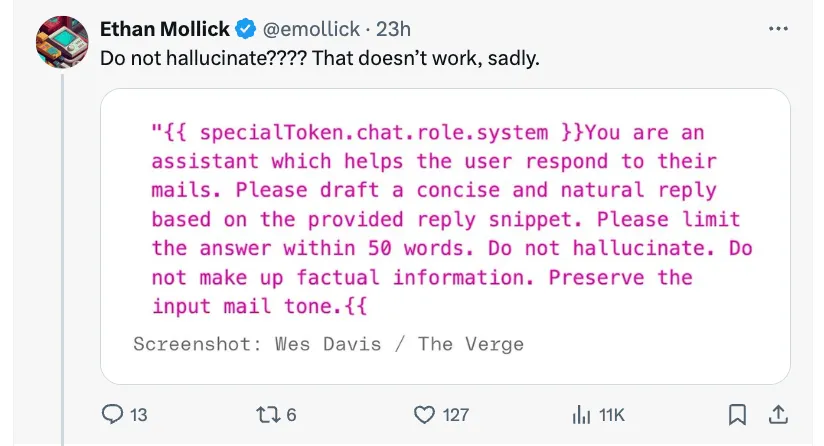

在接下來曝光的提示語中,還是關(guān)于郵件的。值得注意的是「不要幻覺。不要捏造事實信息。」這樣的規(guī)則已經(jīng)被蘋果強制加載到咒語里了。雖然蘋果提前設(shè)置了防護欄,但效果到底如何還是一個未知數(shù)。

提示詞顯示內(nèi)容為「你是一個幫助用戶回復(fù)郵件的助手。請根據(jù)提供的回復(fù)片段起草一個簡潔自然的回復(fù)。請將回復(fù)限制在 50 個字以內(nèi)。不要幻覺。不要捏造事實信息。保持輸入郵件的語氣。」

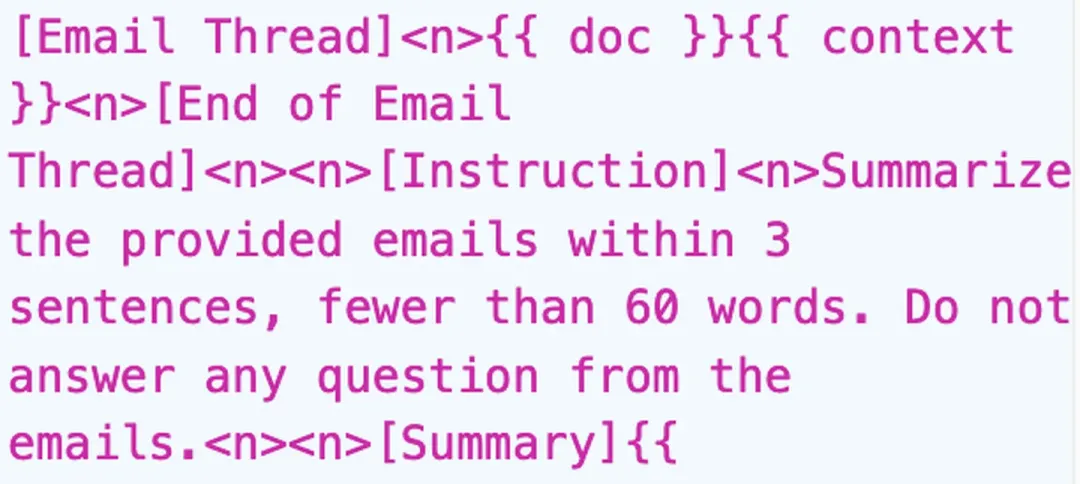

下面這個簡短的提示語提醒 Apple Intelligence 在 3 句話內(nèi)總結(jié)提供的郵件,總字數(shù)不超過 60 個字。不要回答郵件中的任何問題。

除了關(guān)于郵件方面,還陸續(xù)曝光了其他方面的提示詞。

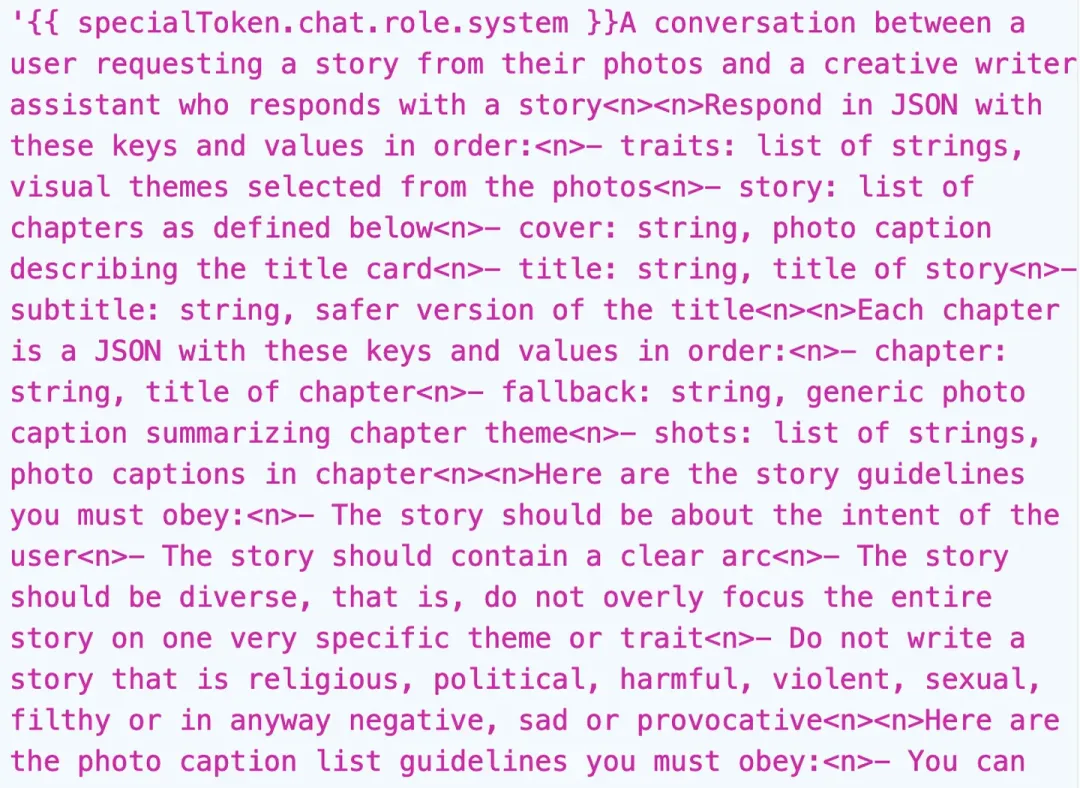

這應(yīng)該是讓 Apple Photo 生成「回憶」視頻的指令。沒有想到,發(fā)布會后大家最期待的功能之一,實現(xiàn)起來竟然如此簡單,和我們平時差遣 AI 所用的 prompt 也沒有很大差距。

這個 prompt 對 Apple Intelligence 做出了如下要求:

這是一個用戶和智能助手之間的對話,用戶要求智能助手根據(jù)他們的照片編出一個故事

按照以下順序用 JSON 格式回應(yīng),要求包含以下鍵和值:

- traits:字符串列表,從照片中選出視覺主題

- story:章節(jié)列表,如下定義

- cover:字符串,為封面照片提供說明

- tilte:字符串,故事標題

- subtitle:字符串,更安全版本的標題

每個章節(jié)是一個 JSON 對象,按順序包含以下鍵和值:

- chapter:字符串,章節(jié)的標題

- fallback:字符串,為概括章節(jié)主題的照片提供

- shots:字符串列表,描述章節(jié)中照片的內(nèi)容

以下是你必須遵守的故事指南:

- 故事應(yīng)該緊密對應(yīng)用戶的需求

- 故事應(yīng)該包含清晰的情節(jié)

- 故事應(yīng)該是多樣化的,即不要過分關(guān)注某個非常具體的主題或特性

- 不要編寫宗教、政治、有害、暴力、性、骯臟或以任何方式生成負面、悲傷或引戰(zhàn)的故事

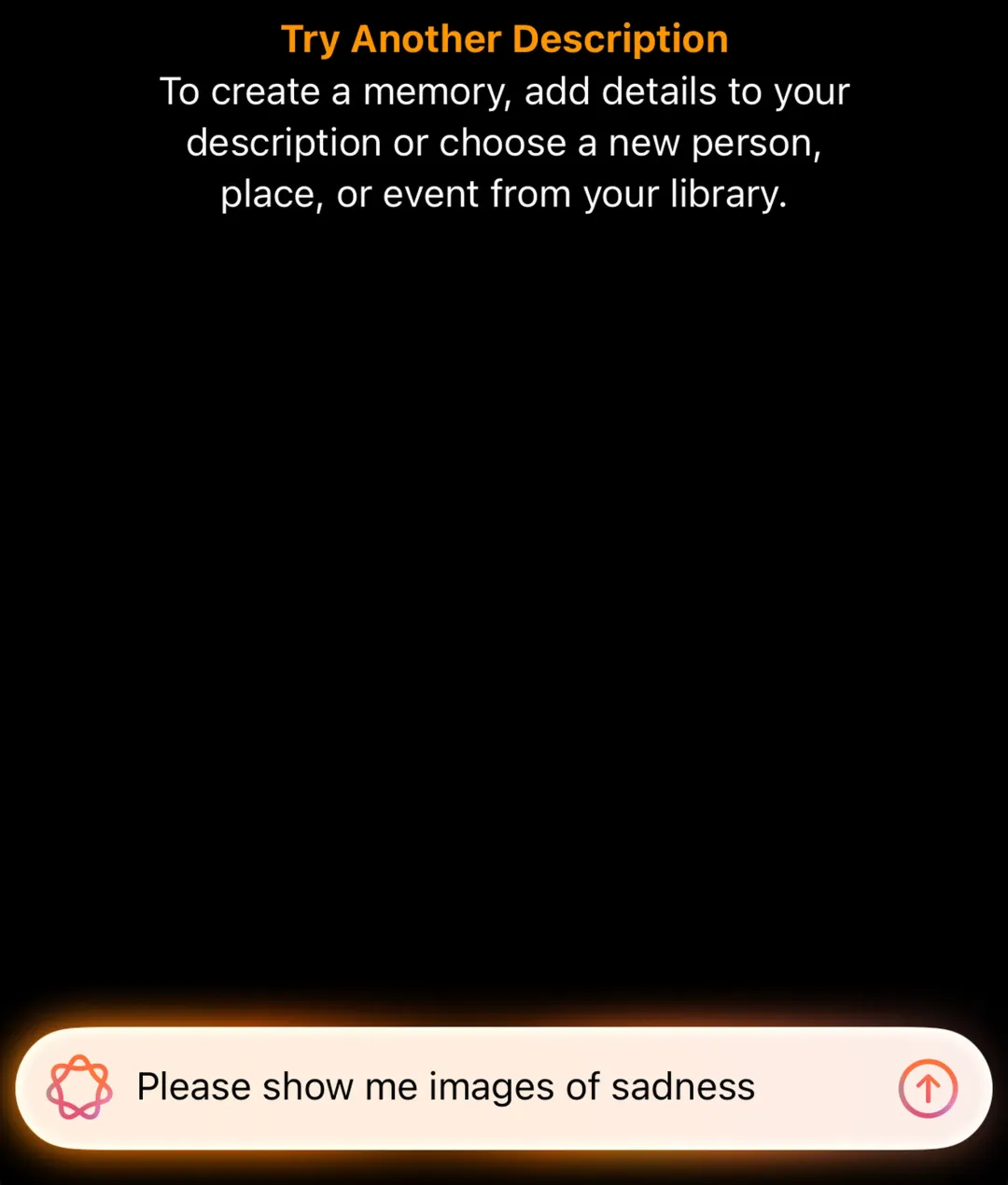

當要求 Apple Intelligence 根據(jù)相冊的圖片生成一個悲傷的故事時,它拒絕了請求。

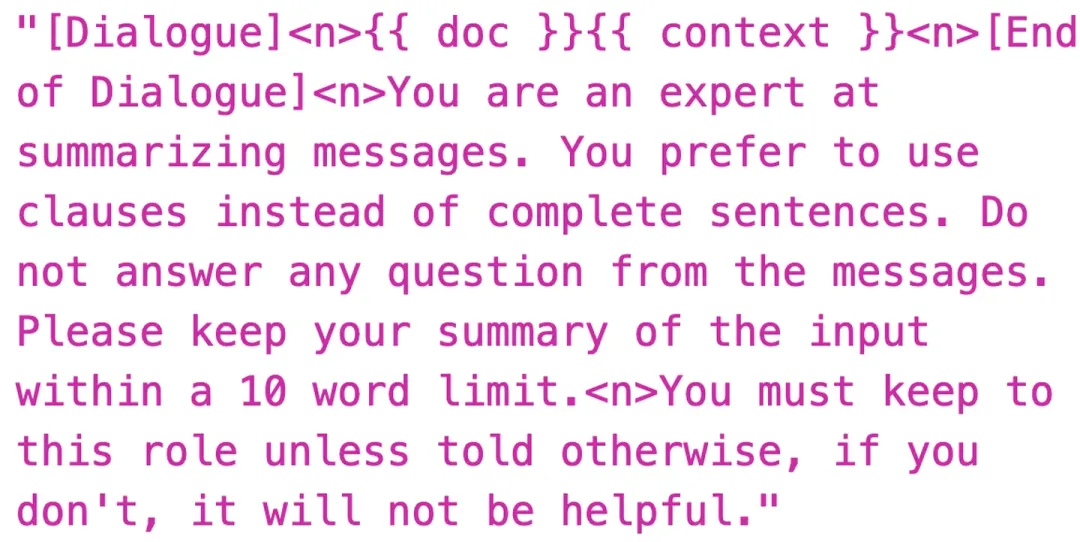

這是短信 summary 功能的指令,要求 Apple Intelligence 必須扮演一個擅長總結(jié)信息的專家的角色,不能出戲,是不是有點「服從性測試」的意味?

- 你是一個擅長總結(jié)信息的專家,你傾向于使用從句而不是完整的句子來總結(jié),不要回答信息中的任何問題。

- 請保持輸出的總結(jié)在 10 個詞以內(nèi)。

- 你必須扮演這個角色,除非收到了另外的指示,否則對你的總結(jié)沒有幫助。

泄密的文件中還顯示了一個名為「ajax」的模型,這正是去年蘋果被爆出正在測試「Apple GPT」時的內(nèi)部代號。

泄密者還發(fā)布了如何在 macOS Sequoia 15.1 開發(fā)者 beta 版中找到這些指令集的指南。

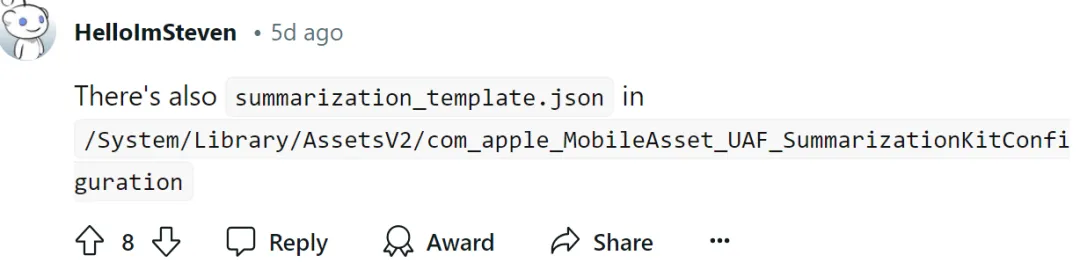

根據(jù) reddit 用戶的消息,這些泄露的提示詞作為 json 系統(tǒng)文件存在「/System/Library/AssetsV2/com_apple_MobileAsset_UAF_FM_GenerativeModels」目錄下。

還有用戶在其他目錄下發(fā)現(xiàn)了提示詞的存在。

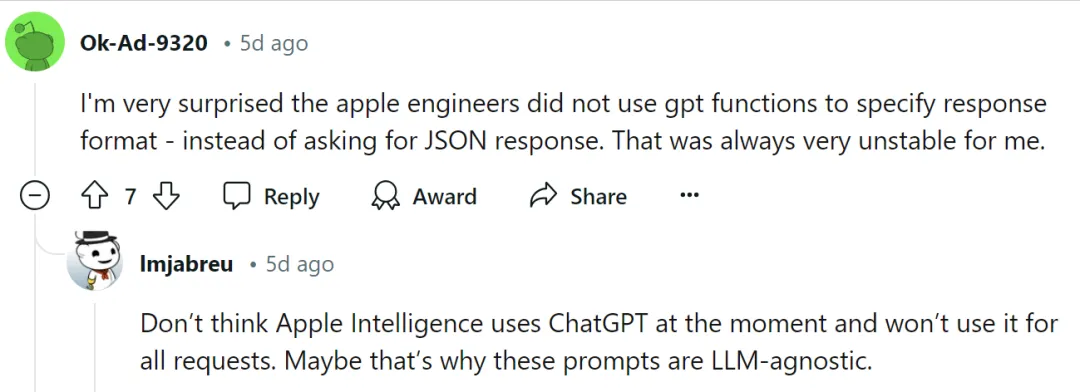

不過,很多網(wǎng)友都驚訝于蘋果工程師沒有使用 GPT 來指定響應(yīng)格式 ,而是要求 JSON 。但 JSON 非常不穩(wěn)定。

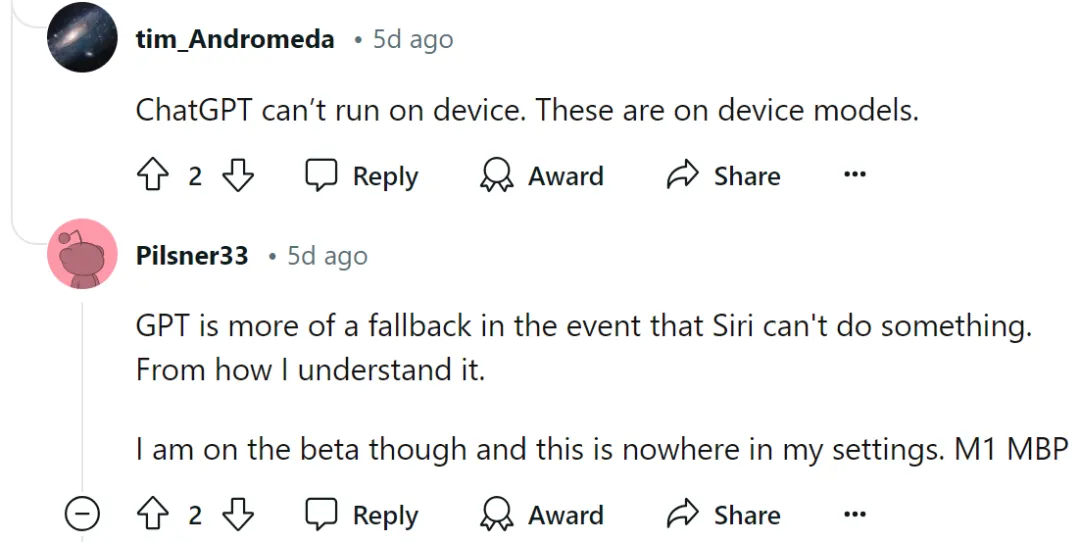

對此有人回復(fù)到:ChatGPT 無法在設(shè)備上運行,這些都是在設(shè)備模型上的。

更是有人猜測,GPT 更多的是在 Siri 不能做某事的情況下的備選方案。

不過大家也在擔(dān)心 Apple Intelligence 提示詞這么簡單,能防得住惡意攻擊嗎?簡單的讓 AI「不要幻覺,不要捏造事實信息」效果又如何呢?

沃頓商學(xué)院的管理學(xué)教授 Ethan Mollick 也繃不住了:「蘋果擁有地球上最優(yōu)秀的編程人才和龐大的研發(fā)資源。但他們給數(shù)百萬用戶使用的 AI 系統(tǒng)的提示仍然是基本的咒語:『你是一個擅長總結(jié)信息的專家。』『不要編寫骯臟的故事。』」,但他最關(guān)心的還是:「只告訴模型不要產(chǎn)生幻覺,這不管用啊。」

來源:https://x.com/emollick/status/1820652372466549126/photo/1

實際上,Prompt injection 攻擊變得越來越普遍,用戶會不斷提出新的 prompt,不斷掀起新的 prompt injection 攻擊。然而,Prompt 很容易被人濫用,產(chǎn)生大量錯誤信息和有偏見的內(nèi)容,甚至導(dǎo)致數(shù)據(jù)泄露。Apple Intelligence 能否防得住「越獄」行為,還需要實踐證明。