性能提升44%!浙大提出LiCROcc:Radar Occ的春天來了?

本文經(jīng)自動駕駛之心公眾號授權(quán)轉(zhuǎn)載,轉(zhuǎn)載請聯(lián)系出處。

寫在前面 & 筆者的個人理解

語義場景補全(SSC)是自動駕駛感知中至關(guān)重要的技術(shù),經(jīng)常面臨天氣和照明變化的復(fù)雜性。現(xiàn)有策略包括融合多模態(tài)信息以增強系統(tǒng)的魯棒性。雷達(dá)作為3D目標(biāo)檢測中重要的傳感器,逐漸在自動駕駛應(yīng)用中取代激光雷達(dá),并且可以提供更魯棒的感知替代方案。本文們專注于3D雷達(dá)在語義場景補全中的潛力,開創(chuàng)了跨模態(tài)細(xì)化技術(shù),以提高對天氣和照明變化的魯棒性,并增強SSC性能。

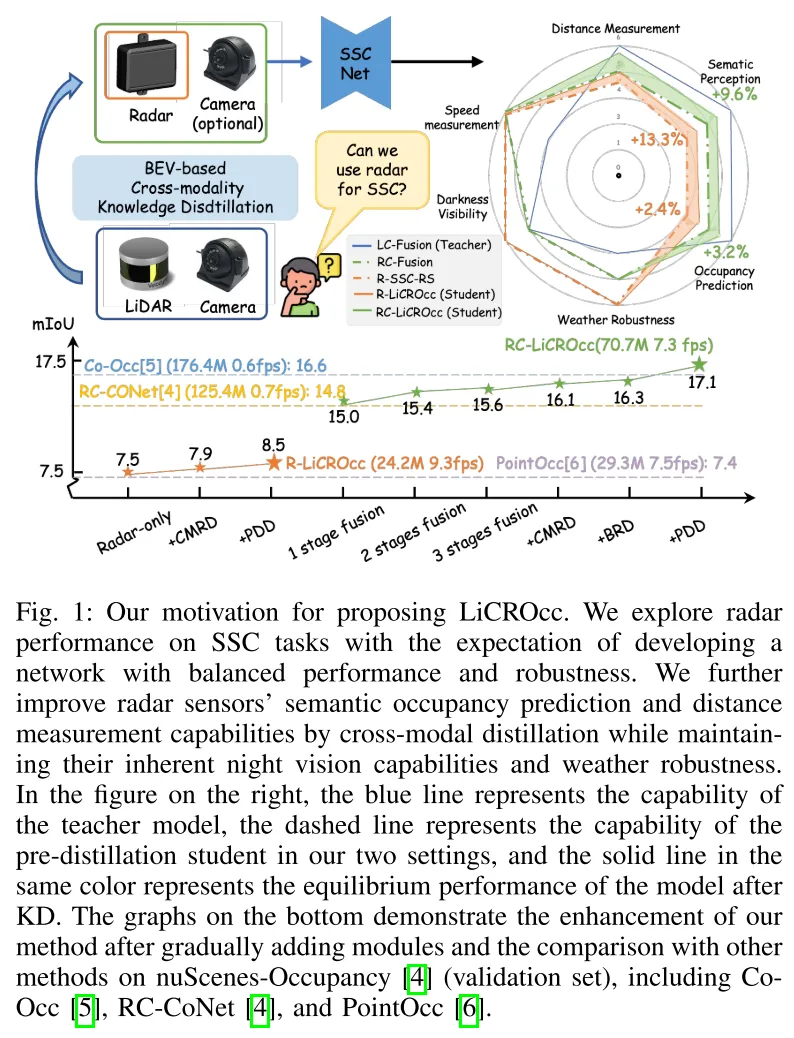

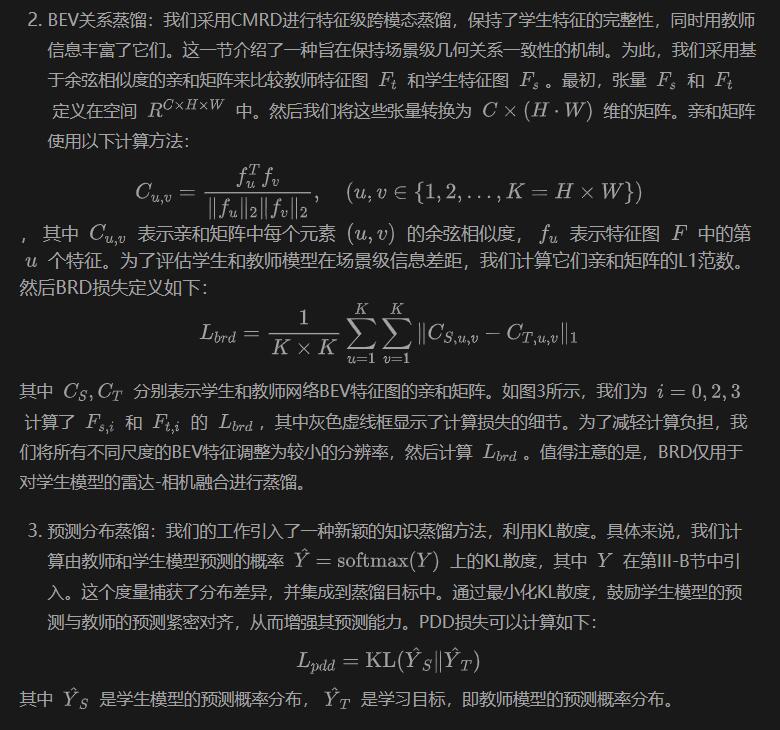

在模型架構(gòu)方面,本文提出了一種三階段的緊密融合方法在BEV上實現(xiàn)點云和圖像的融合框架。基于此基礎(chǔ)設(shè)計了三個跨模態(tài)蒸餾模塊—CMRD、BRD和PDD。我們的方法通過將激光雷達(dá)和相機的豐富語義和結(jié)構(gòu)信息蒸餾到 radar-only(R-LiCROcc)和雷達(dá)-相機(RC-LiCROcc)的配置中,增強了性能。最后本文提出的LC-Fusion(教師模型)、R-LiCROcc和RC-LiCROcc在nuScenes-Occupancy數(shù)據(jù)集上取得了最佳性能,其中mIOU分別超過基線22.9%、44.1%和15.5%。

源碼鏈接: https://hr-zju.github.io/LiCROcc/

相關(guān)工作回顧

語義場景補全(SSC)作為自動駕駛中的一項關(guān)鍵技術(shù),因其能夠提供詳細(xì)的3D場景信息而受到了廣泛關(guān)注。相機和激光雷達(dá)是用于SSC任務(wù)最普遍的傳感器,每種都有其優(yōu)勢和局限性。相機提供了豐富的語義上下文,但缺乏深度信息,并且容易受到光照和天氣條件的影響。而激光雷達(dá)提供了精確的3D幾何信息,但在處理高度稀疏輸入時表現(xiàn)不佳,并且由于密集激光雷達(dá)傳感器的高成本而限制了其廣泛應(yīng)用。另一方面,雷達(dá)作為一種在自動駕駛中越來越受歡迎的、能夠抵抗惡劣天氣條件的傳感器,因其車規(guī)級設(shè)計和可負(fù)擔(dān)性而受到重視。盡管雷達(dá)在多樣化的天氣和光照條件下具有魯棒性,但其稀疏和嘈雜的測量結(jié)果對于大規(guī)模戶外場景的SSC來說是一個重大挑戰(zhàn)。

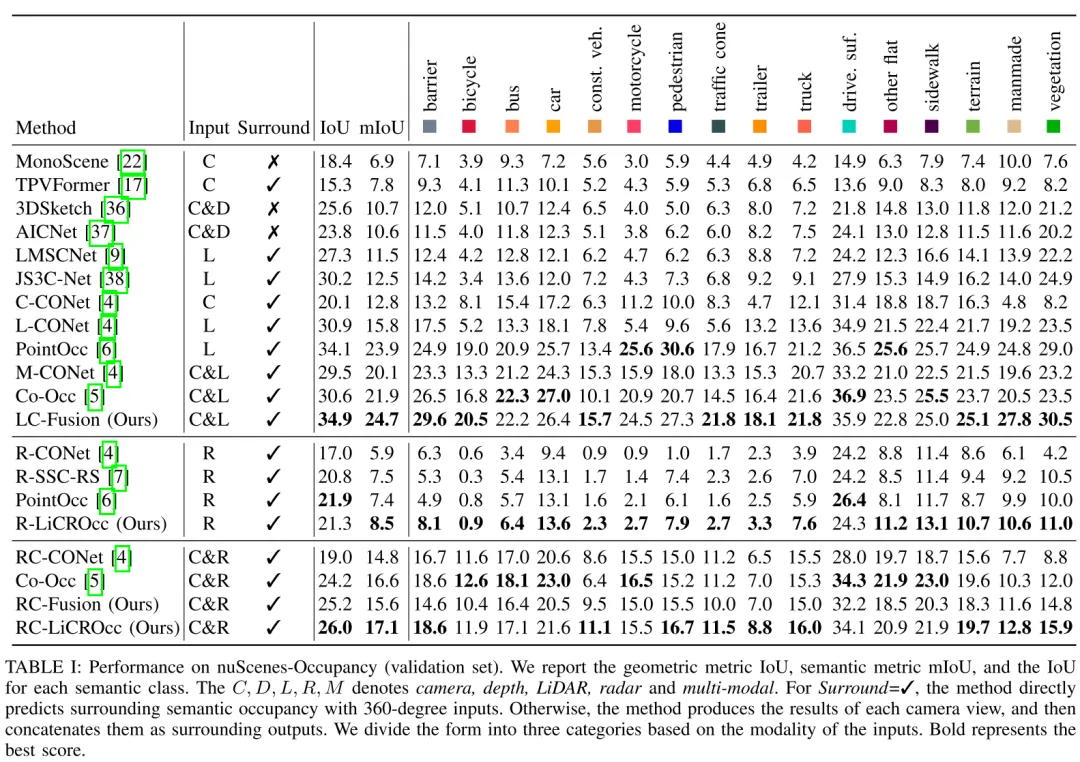

最近的大多數(shù)研究主要集中在基于雷達(dá)的檢測上。僅有少數(shù)研究探索了雷達(dá)傳感器在SSC任務(wù)中的應(yīng)用。然而,它們只能使用雷達(dá)預(yù)測極少數(shù)類別的占用情況或作為多模態(tài)輸入的補充。此外,我們發(fā)現(xiàn)盡管雷達(dá)在對抗不利天氣條件和光照變化方面具有固有的優(yōu)勢,如表I和圖1所示,但基于雷達(dá)的和基于激光雷達(dá)/相機的SSC方法之間仍然存在顯著的性能差距。為了解決上述挑戰(zhàn),在這項工作中,我們探索將雷達(dá)作為SSC的核心傳感器,并設(shè)定了新的性能標(biāo)準(zhǔn)。

最開始我們建立了基于雷達(dá)的基線R-SSC-RS。然而由于缺乏復(fù)雜細(xì)節(jié),僅依靠雷達(dá)傳感器無法實現(xiàn)高度精確和魯棒的SSC。為了進一步提高基于雷達(dá)的SSC性能,我們設(shè)計了一個相機-雷達(dá)融合網(wǎng)絡(luò),以有效地將RGB圖像的豐富語義上下文融合到BEV空間中的雷達(dá)中。通過這種方式雷達(dá)SSC得到了顯著改進。

此外,我們發(fā)現(xiàn)到激光雷達(dá)-相機融合在室外SSC中實現(xiàn)了更優(yōu)的性能,如圖1和表I所示,為雷達(dá)特征學(xué)習(xí)提供了寶貴的指導(dǎo)。因此,我們提出了一種基于融合的知識蒸餾方法,從激光雷達(dá)-相機融合網(wǎng)絡(luò)(教師)中提取有信息量的線索,并將它們轉(zhuǎn)移到基于雷達(dá)的基線RSSC-RS和雷達(dá)-相機融合網(wǎng)絡(luò)中,從而產(chǎn)生了我們的方法R-LiCROcc和RC-LiCROcc。

我們對激光雷達(dá)-相機和雷達(dá)-相機融合網(wǎng)絡(luò)采用了相同的架構(gòu)。對于基于融合的知識蒸餾模塊,我們結(jié)合了跨模態(tài)殘差蒸餾(CMRD)、BEV關(guān)系蒸餾(BRD)和預(yù)測分布蒸餾(PDD),以分層方式強制學(xué)生模型學(xué)習(xí)教師模型的特征表示和分布。通過這個提出的基于融合的知識蒸餾模塊,我們的LiCROcc僅使用雷達(dá)(RLiCROcc)實現(xiàn)了與基于相機的方法相當(dāng)?shù)某晒4送猓琇iCROcc通過結(jié)合雷達(dá)和相機輸入(RC-LiCROcc)接近基于激光雷達(dá)的方法的性能,同時在不利的天氣條件和夜間視覺能力方面保持了魯棒性。

總結(jié)來說,本文的主要貢獻(xiàn)如下:

- 我們旨在提高雷達(dá)在語義場景補全中的性能,同時保持現(xiàn)實世界中的實用性,利用雷達(dá)對各種天氣條件的彈性。我們還從基于激光雷達(dá)的方法中建立了基于雷達(dá)的基準(zhǔn),促進了基于雷達(dá)的SSC研究,并考慮了一個相機-雷達(dá)融合網(wǎng)絡(luò)以提高性能。

- 我們提出了一個新的框架LiCROcc,它結(jié)合了CMRD、BRD和PDD模塊,分層強制學(xué)生模型學(xué)習(xí)教師模型的特征表示和分布。

- 在大規(guī)模的nuScenesOccupancy上進行的廣泛實驗證明了我們提出方法的有效性。

LiCROcc詳解

概述

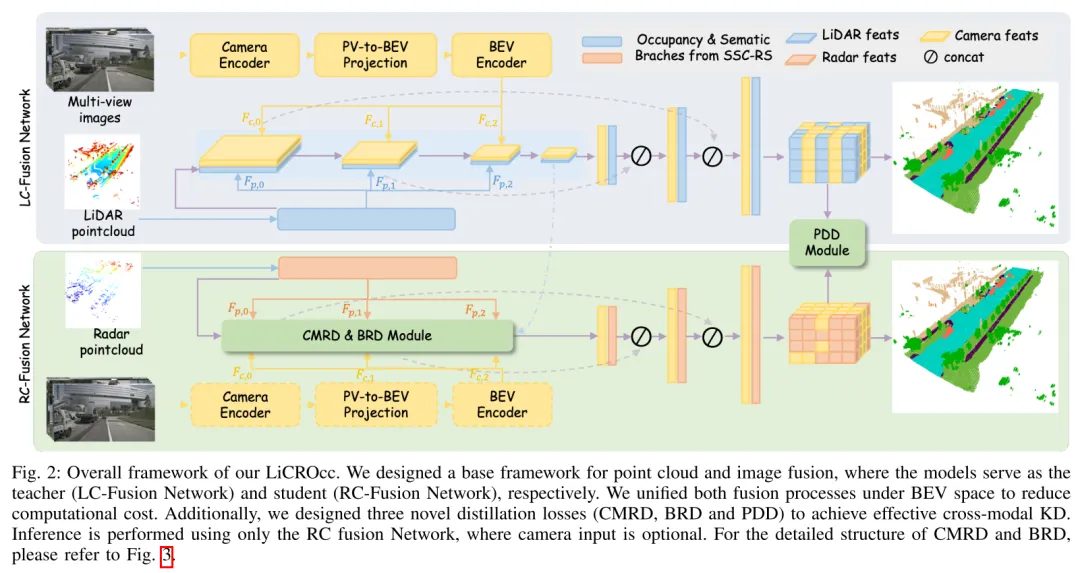

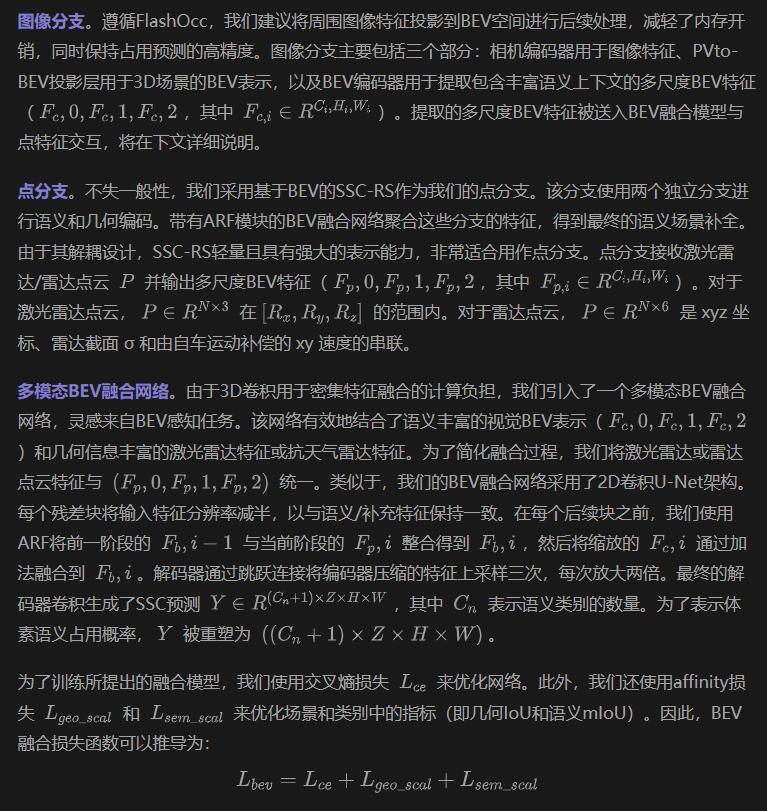

如上所述,我們構(gòu)建了基于雷達(dá)的基線,并設(shè)計了雷達(dá)-相機融合網(wǎng)絡(luò)(圖2的底部)以提升基線性能。為了利用激光雷達(dá)-相機融合中詳細(xì)的幾何結(jié)構(gòu)和點表示的指導(dǎo),我們進一步使用基于融合的知識蒸餾將知識從激光雷達(dá)-相機融合網(wǎng)絡(luò)(圖2的頂部)傳遞到基于雷達(dá)的基線和雷達(dá)-相機融合網(wǎng)絡(luò)。我們采用相同的架構(gòu),即多模態(tài)融合網(wǎng)絡(luò),來建立上述兩個融合網(wǎng)絡(luò)。

多模態(tài)融合網(wǎng)絡(luò)

多模態(tài)融合網(wǎng)絡(luò)主要由圖像分支提取圖像特征、點分支編碼激光雷達(dá)/雷達(dá)點,以及多模態(tài)BEV融合網(wǎng)絡(luò)高效整合點和圖像特征。

基于融合的知識蒸餾模塊

整體損失函數(shù)

實驗分析

在本節(jié)中,我們將詳細(xì)介紹評估數(shù)據(jù)集和指標(biāo)、實施詳情,以及與最先進方法的性能比較。此外,我們還進行了消融研究,以證明申報融合模塊的有效性和蒸餾模塊。最后,我們提供了實驗來消除觀察距離的影響和雷達(dá)在語義場景完成任務(wù)方面的獨特優(yōu)勢。

實驗細(xì)節(jié)

對于激光雷達(dá)輸入,我們將10個激光雷達(dá)掃描合并為一個關(guān)鍵幀。ResNet50作為圖像主干來處理輸入分辨率為256×704的相機圖像。在訓(xùn)練期間,我們將點云投影到相機視圖上,以提供LSS的深度監(jiān)督。對于雷達(dá)輸入,我們采用CRN中的預(yù)處理過程,使用汽車上的5個雷達(dá)傳感器拼接雷達(dá)掃描。對于數(shù)據(jù)增強,我們對圖像隨機應(yīng)用水平和垂直翻轉(zhuǎn)以及裁剪。點云通過在x軸和y軸上隨機翻轉(zhuǎn)進行增強。我們使用AdamW優(yōu)化器,權(quán)重衰減為0.01,初始學(xué)習(xí)率為2e-4。我們使用余弦學(xué)習(xí)率調(diào)度器,在前500次迭代中進行線性預(yù)熱。所有實驗都在8個NVIDIA A100 GPU上進行,總批量大小為32,訓(xùn)練24個周期。

定量結(jié)果

表I展示了與SOTA的比較結(jié)果。與所有先前方法相比,我們的LiCROcc在相同配置下取得了最佳性能。例如,我們的激光雷達(dá)-相機融合模型LCFusion顯示出顯著的改進,與基線(M-CONet)相比,mIoU增加了23%,IoU增加了18%。同時,LC-Fusion在mIoU和IoU得分上分別比PointOCC提高了3.3%和2.3%,這強調(diào)了我們提出的多模態(tài)BEV融合的有效性。

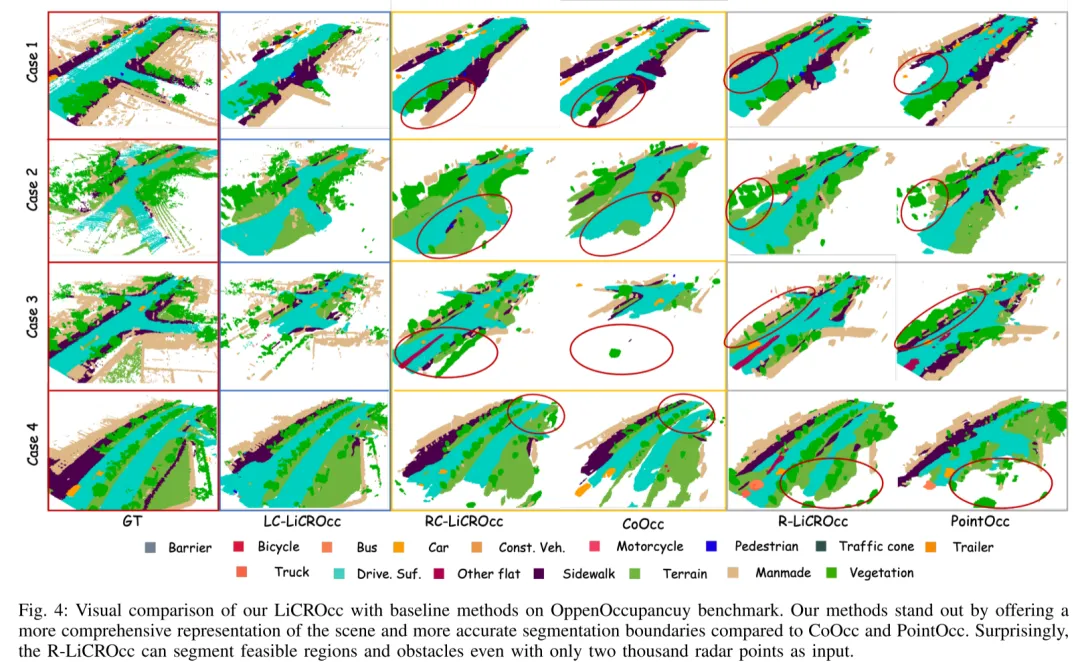

為了全面評估我們提出的方法的有效性,我們修改了幾種現(xiàn)有的基于激光雷達(dá)和多模態(tài)方法(CONet [4],SSC-RS,PointOcc和CoOCC),以適應(yīng)雷達(dá)輸入,作為我們的比較。如表I的第二部分所示,我們的R-LiCROcc在mIoU得分上超過了次好的方法(PointOcc)和基線(R-SSC-RS)13.3%,證明了我們提出的基于融合的知識蒸餾的有效性。我們發(fā)現(xiàn)R-LiCROcc的IoU得分略低于PointOcc。我們解釋說,這可以歸因于PointOcc在三個平面上投影特征并使用更大的模型,這對于占用預(yù)測可能更有利。對于雷達(dá)-相機融合,我們以CONet和CoOCC作為基線。結(jié)果顯示在表I的第三部分,表明我們提出的雷達(dá)-相機融合版本RC-Fusion已經(jīng)達(dá)到了與這些基線相當(dāng)?shù)男阅堋L岢龅幕谌诤系闹R蒸餾進一步提高了性能,mIoU和IoU分別提高了1.5和0.8。我們還提供了可視化結(jié)果,在圖4中展示了我們的RC-LiCROcc和R-LiCROcc如何實現(xiàn)更完整的場景補全和更精確的目標(biāo)分割。

消融實驗

我們進行了一系列實驗來驗證所提出的模塊以及雷達(dá)作為語義場景補全任務(wù)傳感器的潛力。所有實驗都在相同的訓(xùn)練配置下進行,并根據(jù)nuScene-Occupancy [4]驗證數(shù)據(jù)集進行評估。

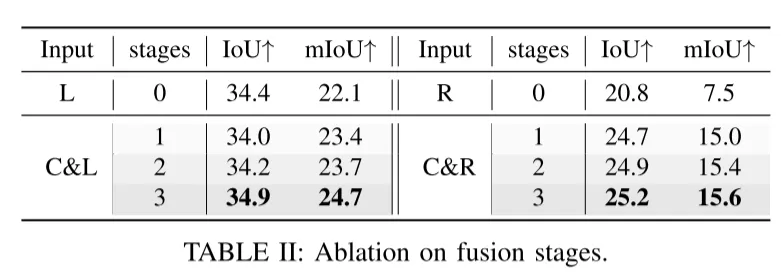

- 融合模塊的效果: 我們研究了在第III-B節(jié)中提出的多模態(tài)BEV融合網(wǎng)絡(luò)中不同融合階段的影響。相應(yīng)的結(jié)果顯示在表II中。"Stages=0"意味著僅使用點云作為輸入,這作為基于點的基線。從表II中,我們可以看到多階段融合策略在不同尺度上融合BEV特征,并有效提高了語義場景補全的準(zhǔn)確性。

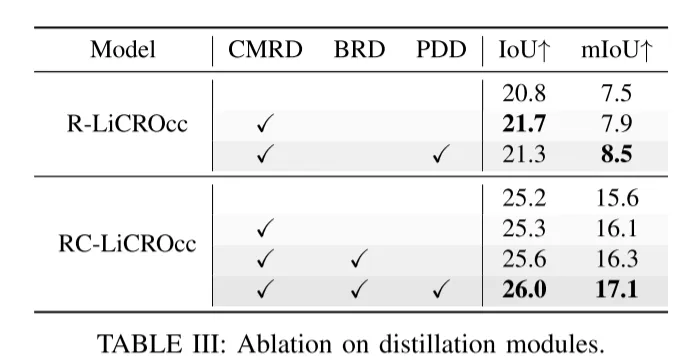

- 蒸餾模塊的效果: 在本節(jié)中,我們深入研究了我們提出的基于融合的知識蒸餾中不同蒸餾組件的各自貢獻(xiàn)。詳細(xì)的結(jié)果在表III中說明。我們通過將它們納入兩個不同的配置:R-LiCROcc(表III的第一部分)和RC-LiCROcc(表III的第二部分),系統(tǒng)地評估了這些模塊的影響。

表III的兩部分結(jié)果都表明CMRD、BRD和PDD組件顯著增強了性能。其中,PDD在跨模態(tài)知識蒸餾中具有最關(guān)鍵的作用,為R-LiCROcc貢獻(xiàn)了7.6%的mIoU改進,為RC-LiCROcc貢獻(xiàn)了4.9%的mIoU改進。

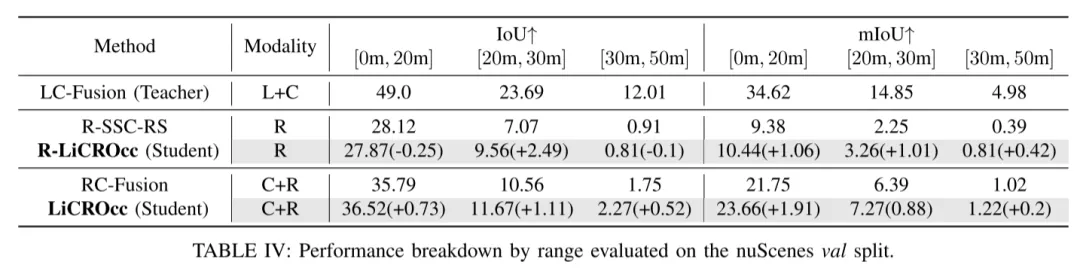

- KD的視覺場優(yōu)勢: 雷達(dá)的固有能力是能夠穿透物體并繞過前景障礙物,這使其比激光雷達(dá)和相機傳感器提供了更廣的視野。然而,雷達(dá)點云的稀疏性隨著距離的增加而增加,這對于SSC特別不利,如表IV的第2行和第3行所示。

為了進一步分析LiCROcc帶來的改進,我們進行了統(tǒng)計分析,以評估系統(tǒng)在不同距離范圍內(nèi)對語義場景補全的有效性,詳細(xì)見表IV。我們分別在[0m, 20m]、[20m, 30m]和[30m, 50m]的語義場景補全中測量了教師模型、學(xué)生模型和R-LiCROcc的IoUs和mIoUs。表IV揭示了知識蒸餾(KD)顯著增強了學(xué)生模型的性能,特別是在短距離區(qū)域。有趣的是,我們發(fā)現(xiàn)當(dāng)從激光雷達(dá)-相機融合到基于雷達(dá)的模型執(zhí)行KD時,遠(yuǎn)程區(qū)域的mIoU得分改進遠(yuǎn)小于近程和中程區(qū)域。這一觀察表明,由于其相對較短的視覺范圍,激光雷達(dá)-相機融合的優(yōu)勢隨著距離的增加而喪失。值得注意的是,教師和學(xué)生模型在遠(yuǎn)程區(qū)域的性能都嚴(yán)重下降,特別是在mIoU得分上。例如,教師模型在20米內(nèi)比RC-LiCROcc高出10.96 mIoU。然而,當(dāng)范圍在[30m, 50m]時,這一優(yōu)勢急劇下降到3.76點(幾乎減少了65%)。

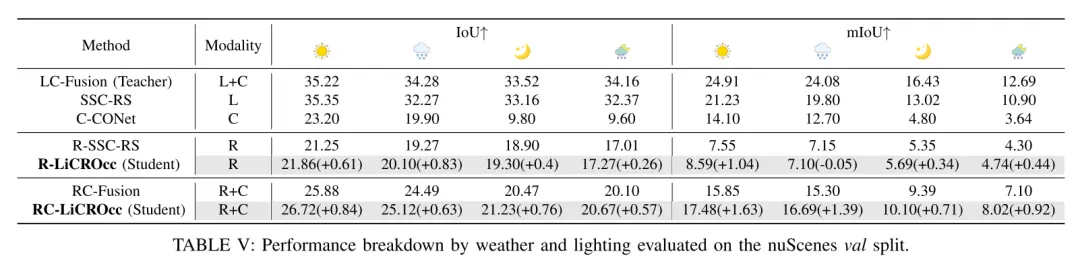

- 雷達(dá)的天氣魯棒性: 本研究評估了雷達(dá)在各種天氣條件下的性能。詳細(xì)結(jié)果在表V中揭示了模型的性能隨天氣場景(晴朗的白天、雨天、夜晚和雨夜)的變化而波動。

首先,如表V所示,三種傳感器類型的天氣屬性顯示出不同程度的魯棒性。雷達(dá)的mIoU從晴朗的一天到雨夜僅下降了3.25,而激光雷達(dá)和相機的mIoU分別下降了10.33和10.46點。這表明雷達(dá)對不利天氣和照明條件最為彈性。特別是,在晴朗的白天,教師模型在mIoU得分上比R-LiCROcc高出16.32,比RC-LiCROcc高出7.43。然而,在雨夜條件下,這種優(yōu)勢縮小到7.95和5.26,主導(dǎo)性能分別下降了51.3%和29.2%。此外,很明顯nuScenes數(shù)據(jù)集中的雨并不特別大,導(dǎo)致對激光雷達(dá)點云的影響沒有預(yù)期的那么顯著。在更廣泛的天氣條件下檢查雷達(dá)性能是我們未來工作的重點。

在晴朗的白天條件下,蒸餾效果帶來了最佳性能。R-LiCROcc模型與學(xué)生模型相比,在IoU上提高了2.8%,在mIoU上提高了13.8%。同樣,RC-LiCROcc模型在IoU上增加了3.2%,在mIoU上增加了10.3%。這種增強歸因于教師模型在晴朗條件下的最佳性能。相反,在雨天和夜晚,激光雷達(dá)和相機的能見度受到損害,導(dǎo)致學(xué)生模型的增強效果不那么明顯。事實上,R-LiCROcc模型在雨天的性能略有下降。

結(jié)論

在本文中,我們探討了雷達(dá)在語義場景補全(SSC)任務(wù)中的應(yīng)用。我們首先開發(fā)了一個融合網(wǎng)絡(luò),該網(wǎng)絡(luò)整合了點云和圖像,并輔以三個蒸餾模塊。通過利用雷達(dá)的優(yōu)勢并在SSC任務(wù)上增強其性能,我們的方法在不同設(shè)置下取得了優(yōu)異的成果。