OpenAI的《Her》難產(chǎn),是被什么困住了手腳?

兩個月又兩周過去了,我們?nèi)匀粵]有見到公開發(fā)布版的OpenAI《Her》。

5月14日,OpenAI發(fā)布GPT-4o和端到端實時音視頻對話模式,現(xiàn)場演示AI對話絲滑如人類。

它能感受到你的呼吸節(jié)奏,也能用比以前更豐富的語氣實時回復,甚至可以做到隨時打斷AI,效果非常驚艷。

可萬眾期待中,不時有推遲的消息傳出。

是什么拖住了OpenAI的后腿?根據(jù)已知情報:

有法律糾紛,要確保語音音色不會再出現(xiàn)與“寡姐”斯佳麗·約翰遜這樣的爭議。

也有安全問題,需要做好對齊,以及實時音視頻對話開啟新的使用場景,被當成詐騙工具也會是其中之一。

……

不過,除了以上這些,還有什么技術問題和困難需要克服嗎?

渡過最初的熱鬧后,內(nèi)行們開始看門道了。

眼尖的網(wǎng)友可能已經(jīng)注意到,發(fā)布會現(xiàn)場演示手機可是插著網(wǎng)線的。

在業(yè)內(nèi)人士眼中,GPT-4o發(fā)布會演示效果如此絲滑,還是有幾大限制:

需要“固定網(wǎng)絡、固定設備、固定物理環(huán)境”。

真的公開發(fā)布后,全球用戶能否獲得與發(fā)布會相比不打折扣的體驗,也還是個未知數(shù)。

發(fā)布會現(xiàn)場還有一個有趣的細節(jié),帥氣的研究員小哥Barret Zoph,在演示視頻通話時被ChatGPT當成桌子。

視頻通話部分的延遲可見一斑了,語音部分提問已經(jīng)處理完了,視覺部分還在處理上一個鏡頭,也就是手機剛被拿起來時攝像頭拍到的木桌。

試想最終發(fā)布后,很多人用它的場景是什么?

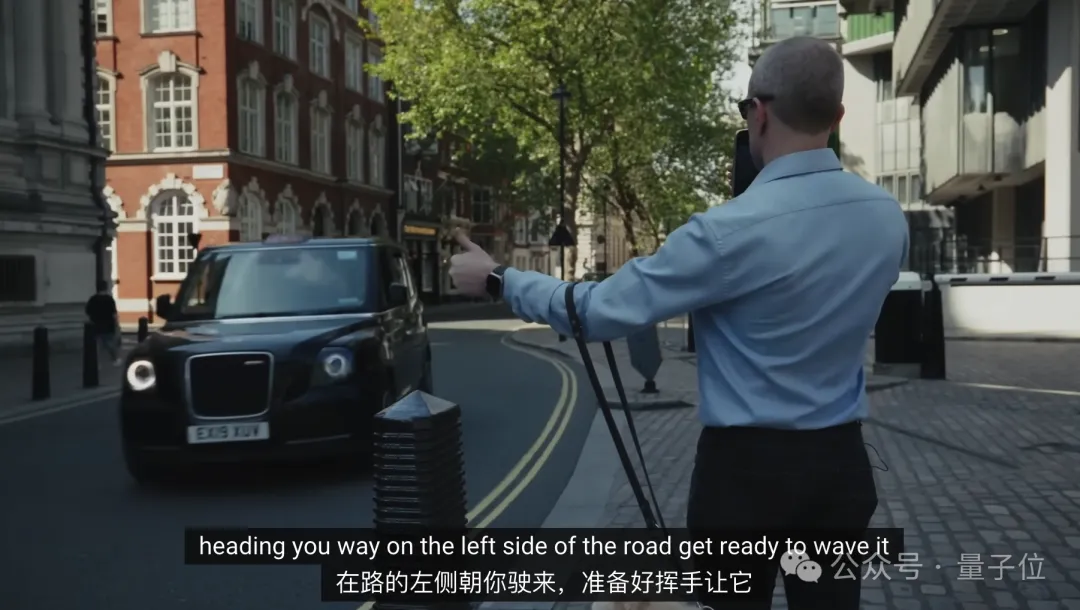

宣傳片中一個最為人津津樂道的案例,盲人在AI語音的幫助下招手打車,一時間被網(wǎng)友津津樂道。

不過也要注意到,這會是一個非常依賴低延遲特性的場景,如果AI指導來的稍慢一點,出租車也就開過去了。

室外場景網(wǎng)絡信號都不一定能保證穩(wěn)定,更別提機場火車站、旅游景點這些人多設備多擠占帶寬的場景,難度還要增加不少。

此外,室外場景還會出現(xiàn)噪音的問題。

大模型本來就深受“幻覺”問題困擾,如果噪音影響到用戶語音的識別,出現(xiàn)一些與指令不相關的詞語,那回答就不知道拐到哪去了。

最后,還有一個容易被忽視的問題,多設備適配。

可以看出目前OpenAI發(fā)布會和宣傳片,清一色用的新款iPhone Pro。

否能在較低端的機型也獲得一致體驗,也要等正式發(fā)布后再揭曉了。

OpenAI宣傳GPT-4o可以在短至232毫秒、平均320毫秒的時間內(nèi)響應音頻輸入,與人類在對話中的反應速度一致。

但這只是大模型從輸入到輸出的時間,并非整個系統(tǒng)。

總而言之,僅僅把AI能做好,還搞不出《Her》一般絲滑的體驗,還需要低延時、多設備適配、應對多種網(wǎng)絡條件和嘈雜環(huán)境等一系列能力。

光靠AI,還做不出《Her》

要做到低延時、多設備適配等,靠的就是RTC(實時通信,Real-Time Communications)技術了。

在AI時代之前,RTC技術已廣泛用于直播、視頻會議等場景,發(fā)展的較為成熟。

在RTC視角下,用戶的語音提示詞在輸入大模型之前,還要經(jīng)歷一整套復雜流程。

信號采集與預處理:在手機等端側設備,將用戶的語音采集成原始信號,并對其進行降噪、消除回聲等處理,為后續(xù)識別做好準備。

語音編碼與壓縮:為盡量節(jié)省傳輸帶寬,要對語音信號進行編碼和壓縮。同時,還要根據(jù)網(wǎng)絡實際情況自適應地加入一些冗余和糾錯機制,以抵抗網(wǎng)絡丟包。

網(wǎng)絡傳輸:壓縮后的語音數(shù)據(jù)被切分成一個個數(shù)據(jù)包,通過互聯(lián)網(wǎng)送往云端。如果距離服務器物理距離較遠,傳輸往往還要經(jīng)過多個節(jié)點,每一跳都可能引入延遲和丟包。

語音解碼與還原:數(shù)據(jù)包到達服務器后,系統(tǒng)對其進行解碼,還原出原始的語音信號。

最后才輪到AI出手,先通過Embedding模型將語音信號轉化為tokens,才能真正讓端到端多模態(tài)大模型能夠理解并生成回復。

當然,大模型生成回復后還要走一套相反的流程,再把回復的音頻信號最終傳回給用戶。

整個一套流程走下來,每一個環(huán)節(jié)都需要極致的優(yōu)化,才能真正把AI音視頻對話做到實時。

其中對大模型本身的壓縮、量化等手段畢竟會影響AI能力,結合音頻信號處理、網(wǎng)絡丟包等因素聯(lián)合優(yōu)化,就顯得尤為重要了。

據(jù)了解,OpenAI也并不是獨立解決這個問題的,而是選擇與第三合作。

合作伙伴為開源RTC廠商LiveKit,目前憑借支持ChatGPT語音模式成為業(yè)界關注焦點。

除OpenAI之外,LiveKit與Character.ai、ElevenLabs等相關AI公司也都展開了合作。

可能除了谷歌等少數(shù)有較為成熟的自研RTC技術的巨頭之外,與術業(yè)有專攻的RTC廠商合作,是AI實時音視頻對話玩家目前的主流選擇。

這一波當然也少不了國內(nèi)玩家參與,不少國內(nèi)AI公司已經(jīng)在加緊研發(fā)端到端多模態(tài)大模型以及AI實時音視頻對話應用。

國內(nèi)AI應用能不能趕上OpenAI的效果,大家又什么時候能真正親自上手體驗到呢?

由于這些項目基本都在早期階段,公開透露的消息并不多,不過他們的RTC合作伙伴聲網(wǎng)倒成了一個突破口。

量子位從聲網(wǎng)處打聽到,以目前國內(nèi)的技術水平,已經(jīng)能把一輪對話的延遲壓到1秒左右,再輔以更多優(yōu)化技巧,實現(xiàn)能及時響應的流暢對話已不成問題。

做好RTC,AI不只是《Her》

聲網(wǎng)是誰?

RTC行業(yè)代表性企業(yè),2020年成為全球實時互動云服務第一股,

聲網(wǎng)上一次出圈,是因為對紅極一時的音頻社交應用Clubhouse提供技術支持。

實際上,B站、小米、小紅書等許多大家耳熟能詳?shù)膽枚歼x擇聲網(wǎng)的RTC解決方案,海外業(yè)務這幾年也發(fā)展迅速。

那么對于,AI實時音視頻對話應用,具體該怎么解決低延遲、多設備適配這些難點,又能做到什么效果呢?

我們請到了聲網(wǎng)首席科學家、CTO鐘聲來回答這個問題。

據(jù)鐘聲介紹,不計算大模型推理,光說信號在網(wǎng)絡線路上一來一回的時間,已經(jīng)可以做到到70-300毫秒。

具體來說,主要從三個方面入手優(yōu)化。

首先,聲網(wǎng)在全球建設了200多個數(shù)據(jù)中心,建立連接時選址也都是選在離終端用戶最近的地方。

結合上智能路由技術,就可以在當某條線路擁堵,系統(tǒng)可自動選擇其它延遲和帶寬更優(yōu)的路徑,確保通信質(zhì)量。

如果不涉及跨區(qū)域傳輸,就可以端到端低于100ms。如果包含跨區(qū)域,比如從中國到美國,更偏向200-300ms。

第二,成立于2014年的聲網(wǎng),正在根據(jù)多年來積累的海量真實場景數(shù)據(jù),通過數(shù)據(jù)挖掘分析出各種弱網(wǎng)場景,然后在實驗室中進行復現(xiàn)。這為優(yōu)化傳輸算法提供了”靶場”,使之能應對復雜多變的網(wǎng)絡環(huán)境;也可以在實時傳輸過程中出現(xiàn)對應的弱網(wǎng)模式時及時做出傳輸策略的調(diào)整使得傳輸更順利進行。

第三,聲網(wǎng)針對垂直行業(yè)、特定任務,也在嘗試定制參數(shù)量更小的模型,壓縮大模型自身的響應時間。特定大小的大語言模型和語音模型的極限能力是值得探索的方向,這對優(yōu)化對話式AI或者chatbot的性價比以及低延時體驗很關鍵。

最后,聲網(wǎng)開發(fā)的RTC SDK也針對不同的終端設備進行適配與優(yōu)化,尤其針對一些低端機型,可以做到低功耗、低內(nèi)存占用、極小包體等。尤其是設備端的基于AI算法的語音降噪、回聲消除、視頻質(zhì)量提升的能力,可以直接影響AI chatbot的適用范圍和效果。

鐘聲還介紹到,在他們探索RTC與大模型技術的結合過程中,RTC技術本身的范疇也在變化。

他舉了自己的一些思考方向,比如可以從傳輸音頻信號改成傳輸大模型可以直接理解的tokens,甚至可以把語音轉文字(STT)和情緒識別在端上實現(xiàn),這樣可以僅傳送文字及相關情緒參數(shù)。

這樣一來,就可以把更多信號處理流程放在端側,把算力需求較小的Embbeding模型放在離用戶更近的地方,減少整個流程的帶寬需求和云端模型的成本了。

從這一點出發(fā),鐘聲認為最后AI與RTC技術結合的形態(tài),會走向端云結合。

也就是不能完全依賴云端的大模型,無論是從成本、能耗、延遲的體驗,這都不是最好的選擇。

在端云結合觀點下,整個基礎設施相應的都需要變化,算力不僅在云端,手機的算力也會被用上。邊緣端的傳輸節(jié)點也會分布算力,數(shù)據(jù)傳輸協(xié)議也會相應變化……

目前,聲網(wǎng)與大模型應用廠商已摸索出三種合作模式,也就是整個系統(tǒng)中,大模型、RTC與云服務器三個部分的不同供應方式:

- 私有化部署:聲網(wǎng)只提供RTC SDK,與大模型一起部署在合作伙伴自己的數(shù)據(jù)中心,適合有自研大模型或大模型推理基礎設施的公司選擇。

- 聲網(wǎng)云平臺:聲網(wǎng)提供RTC SDK和云服務器資源,開發(fā)者可根據(jù)需求靈活選擇模型、部署位置與計算資源。無需自建基礎架構,快速構建AI語音應用。

- 聲網(wǎng)端到端解決方案:聲網(wǎng)提供自研大模型、RTC SDK與云服務器資源。可為細分行業(yè)如教育、電商、社交娛樂、客服等定制垂類模型,并與RTC能力深度整合,提供一體化的語音交互解決方案。

而且已有合作項目中,跑得快的應用離與大家見面的時間不遠了。

在與聲網(wǎng)的交流中,量子位發(fā)現(xiàn)還有一個值得關注的新趨勢:

國內(nèi)AI應用,形態(tài)上逐漸在超越AI助手問答與AI情感陪伴的范疇。

就拿社交娛樂、電商直播以及在線教育這些行業(yè)來說,大家最關注的就是網(wǎng)紅主播和名師。AI實時音視頻對話驅動的數(shù)字人,就可以成為他們的“數(shù)字分身”,進一步和每個粉絲或學生進行一對一的交流互動。同時用戶本身的時間和精力也有限,分身乏術,對自身的AI分身也有需求。隨著技術的發(fā)展、AI分身技術體驗的提升、成本的下降,他們的應用范圍會日益擴大。

拿鐘聲的話來說“人終極最稀缺的東西就是時間”:

我們肯定都有這種體會,如果說兩個會議沖突了,只能參加一個怎么辦?

可能自己參加一個,派AI助手去參加另一個活動,把精彩的信息帶回來。以后甚至這個助手可以是自己的AI分身,在活動過程中可以做個性化的交流,按自己的興趣和關注點提問或回答各種各樣的問題,與其他人或者其他人的分身互動。

所以說,AI實時音視頻對話能做的,還遠不止是《Her》。