真相了!大模型解數(shù)學(xué)題和人類(lèi)真不一樣:死記硬背、知識(shí)欠缺明顯,GPT-4o表現(xiàn)最佳

本文作者來(lái)自北京郵電大學(xué)、騰訊微信、華中科技大學(xué)、北京理工大學(xué)。作者列表:?jiǎn)虧?rùn)祺,譚秋納,董冠霆,伍敏慧,孫沖,宋曉帥,公卻卓瑪,雷尚霖,衛(wèi)喆,張淼萱,喬潤(rùn)楓,張一凡,縱曉,徐一達(dá),刁沐熙,包志敏,李琛,張洪剛。其中,共同第一作者喬潤(rùn)祺是北京郵電大學(xué)博士生,譚秋納是北京郵電大學(xué)碩士生,通訊作者是北京郵電大學(xué)張洪剛副教授,該文章為喬潤(rùn)祺在微信實(shí)習(xí)期間完成。

隨著人工智能技術(shù)的快速發(fā)展,能夠處理多種模態(tài)信息的多模態(tài)大模型(LMMs)逐漸成為研究的熱點(diǎn)。通過(guò)整合不同模態(tài)的信息,LMMs 展現(xiàn)出一定的推理和理解能力,在諸如視覺(jué)問(wèn)答、圖像生成、跨模態(tài)檢索等任務(wù)中表現(xiàn)出色。這種多模態(tài)能力使得 LMMs 在各類(lèi)復(fù)雜場(chǎng)景中的應(yīng)用潛力巨大,而為了嚴(yán)謹(jǐn)科學(xué)地檢驗(yàn) AI 是否具備較強(qiáng)的推理能力,數(shù)學(xué)問(wèn)答已成為衡量模型推理能力的重要基準(zhǔn)。

回顧 AI 的發(fā)展歷程,我們發(fā)現(xiàn)人類(lèi)的認(rèn)知和思考問(wèn)題的方式對(duì) AI 的發(fā)展產(chǎn)生了深遠(yuǎn)的影響。諸如神經(jīng)網(wǎng)絡(luò)、注意力機(jī)制等突破均與人類(lèi)的思維模式息息相關(guān)。想象一下,人類(lèi)在解答一個(gè)數(shù)學(xué)問(wèn)題時(shí),首先需要熟知題目所考察的知識(shí)點(diǎn),而后利用相關(guān)知識(shí)進(jìn)行逐步推理從而得出答案。但模型在作答時(shí),其推理過(guò)程是否與人類(lèi)一致呢?

聚焦于數(shù)學(xué)問(wèn)題,我們發(fā)現(xiàn)模型可以回答出復(fù)雜問(wèn)題,但在一些簡(jiǎn)單問(wèn)題面前卻捉襟見(jiàn)肘。為探究這一現(xiàn)象的原因,受人類(lèi)解題思維模式的啟發(fā),我們首先對(duì)先掌握知識(shí)點(diǎn),再運(yùn)用其進(jìn)行邏輯推理的解題過(guò)程建模如下:

其中 (X, Y) 和 (x_i, y_i) 分別表示數(shù)學(xué)問(wèn)題和每個(gè)子問(wèn)題中的問(wèn)題與答案,P_reason 代表 LMMs 的綜合運(yùn)用能力 (知識(shí)泛化)。基于此,We-Math 首先基于 67 個(gè)原子知識(shí)點(diǎn)構(gòu)建了一個(gè)多層級(jí)樹(shù)狀知識(shí)體系,緊接著以原子知識(shí)及推理答案為依據(jù),通過(guò)將多知識(shí)點(diǎn)的復(fù)雜問(wèn)題拆解為多個(gè)原子知識(shí)點(diǎn)對(duì)應(yīng)的子問(wèn)題來(lái)探究模型的作答機(jī)制。

- 題目:WE-MATH: Does Your Large Multimodal Model Achieve Human-like Mathematical Reasoning?

- 論文:https://arxiv.org/pdf/2407.01284

- 主頁(yè):https://we-math.github.io/

- 代碼:https://github.com/We-Math/We-Math

- 數(shù)據(jù)集:https://huggingface.co/datasets/We-Math/We-Math

目前 We-Math 在當(dāng)日的 HuggingFace Daily Paper 中排名第一,并在推特上的瀏覽量達(dá)到 10K+!

We-Math Benchmark

1. 數(shù)據(jù)構(gòu)成

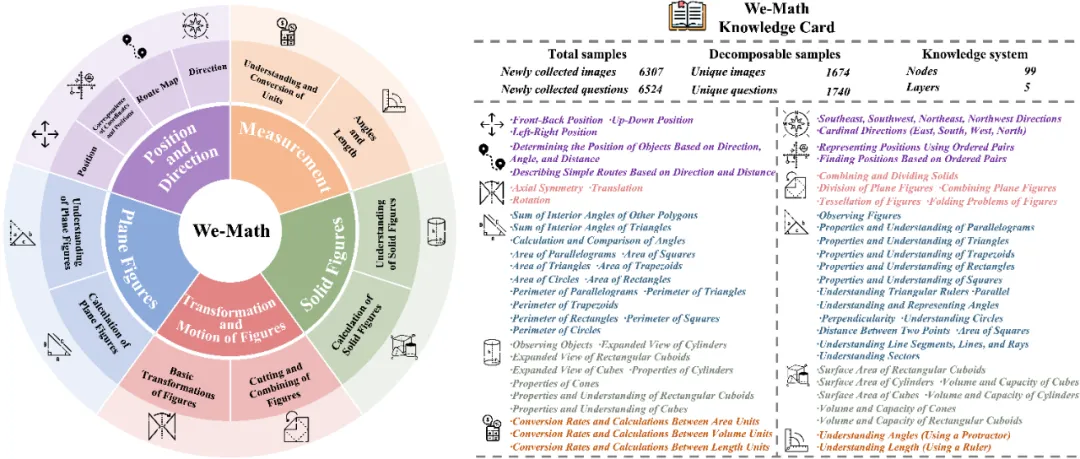

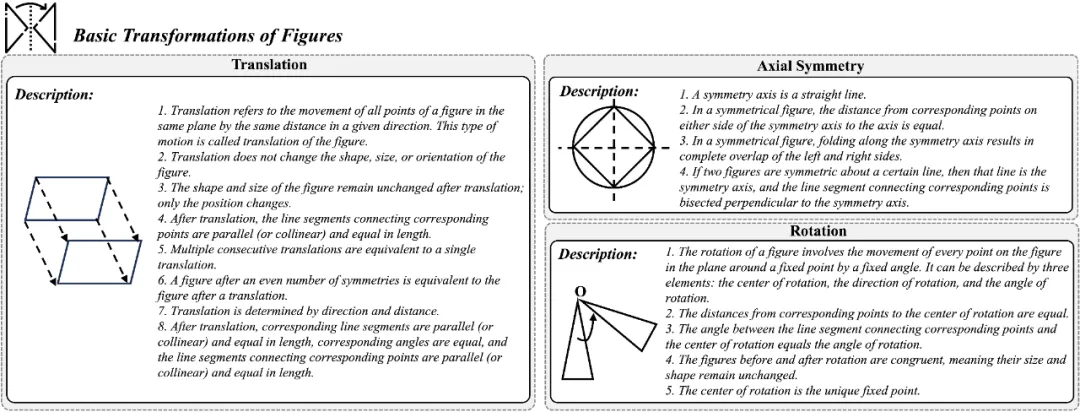

We-Math 測(cè)評(píng)數(shù)據(jù)集共包含 6.5k 個(gè)多模態(tài)小學(xué)數(shù)學(xué)問(wèn)題和一個(gè)多層級(jí)知識(shí)架構(gòu),每一個(gè)數(shù)學(xué)問(wèn)題均有對(duì)應(yīng)的知識(shí)點(diǎn)(1-3 個(gè))。其中所有問(wèn)題的知識(shí)點(diǎn)均被 5 層 99 個(gè)節(jié)點(diǎn)(最后一層包含 67 個(gè)知識(shí)點(diǎn))的知識(shí)架構(gòu)所涵蓋。并且如下圖所示,為了緩解模型在解決問(wèn)題過(guò)程中固有的問(wèn)題,我們參考教材與維基百科,啟發(fā)式的引入了 67 個(gè)知識(shí)點(diǎn)的描述,從而為 LMMs 的推理過(guò)程提供必要的知識(shí)提示。

2. 題目拆解

為了合理的評(píng)估模型的作答機(jī)制,我們嚴(yán)格以人類(lèi)作答的標(biāo)準(zhǔn)答案為依據(jù),按照復(fù)雜問(wèn)題所包含的知識(shí)點(diǎn),將其拆解成了 n 個(gè)子問(wèn)題,其中 n 表示復(fù)雜問(wèn)題包含的知識(shí)點(diǎn)數(shù)量。

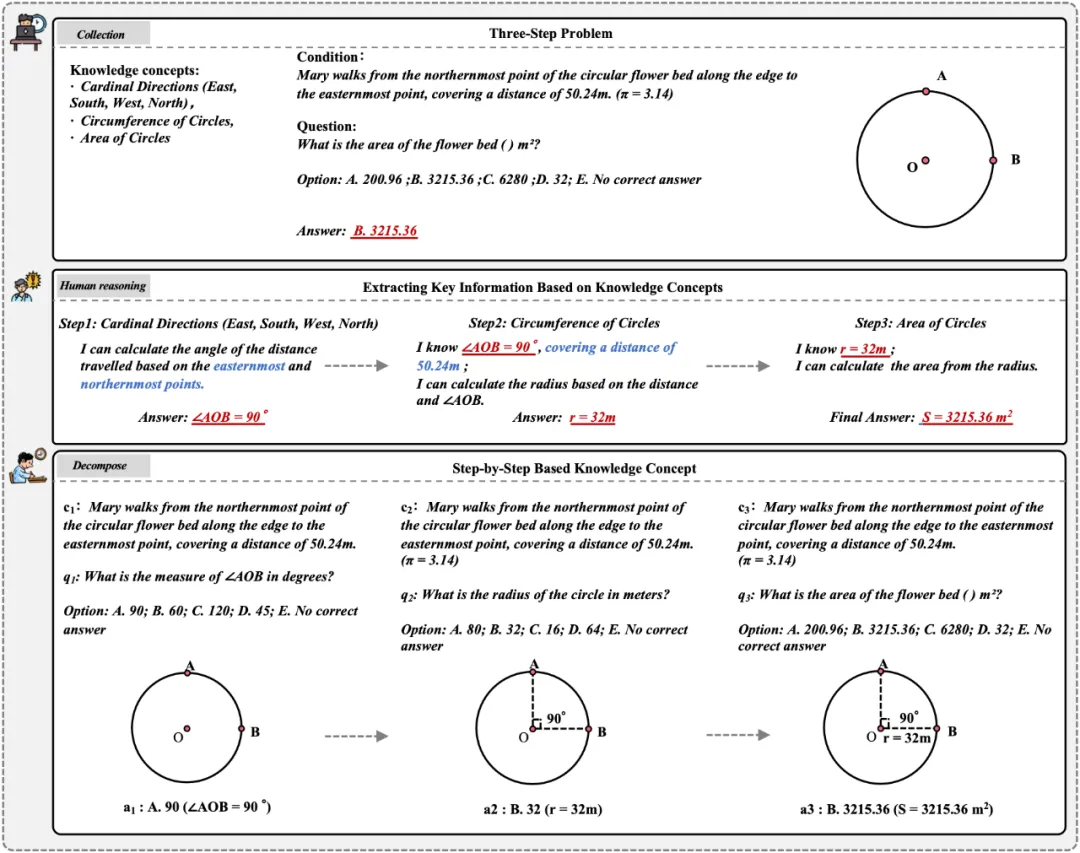

如下圖所示,對(duì)于一道復(fù)雜問(wèn)題:Mary 從一個(gè)圓形花壇的最北端點(diǎn)沿花壇邊緣走到最東端點(diǎn),走過(guò)的距離是 50.24 米,求解圓形花壇的面積。在解題過(guò)程中,首先需要根據(jù) “東南西北方向” 知識(shí)點(diǎn),通過(guò) “最北” 和 “最東” 兩個(gè)方向的條件,求得 Mary 走過(guò)路徑所對(duì)應(yīng)的圓心角大小(“最北” 和 “最東” 的夾角為 90 度)。接著,根據(jù) “圓的周長(zhǎng)” 知識(shí)點(diǎn),通過(guò)圓心角的大小為 90 度和 Mary 走過(guò)的路徑長(zhǎng)度的條件,計(jì)算出圓形花壇的周長(zhǎng),并求得圓形花壇的半徑。最后,根據(jù) “圓的面積” 知識(shí)點(diǎn),通過(guò)求得的半徑的條件,計(jì)算出圓形花壇的面積,至此完成題目的求解。

分析上述解題過(guò)程,為了探究模型的答題機(jī)制以及模型的細(xì)粒度推理表現(xiàn),可以將原題按照其對(duì)應(yīng)的知識(shí)點(diǎn)拆解成三個(gè)子問(wèn)題,具體而言,第一問(wèn):Mary 從一個(gè)圓形花壇的最北端點(diǎn)沿花壇邊緣走到最東端點(diǎn),求她走過(guò)路徑的圓弧所對(duì)應(yīng)的圓心角的度數(shù);第二問(wèn):圓形花壇中,90 度圓心角所對(duì)應(yīng)的圓弧弧長(zhǎng)為 59.24m,求解圓形花壇的半徑;第三問(wèn):求半徑為 32m 的圓形花壇的面積。

3. 度量標(biāo)準(zhǔn)

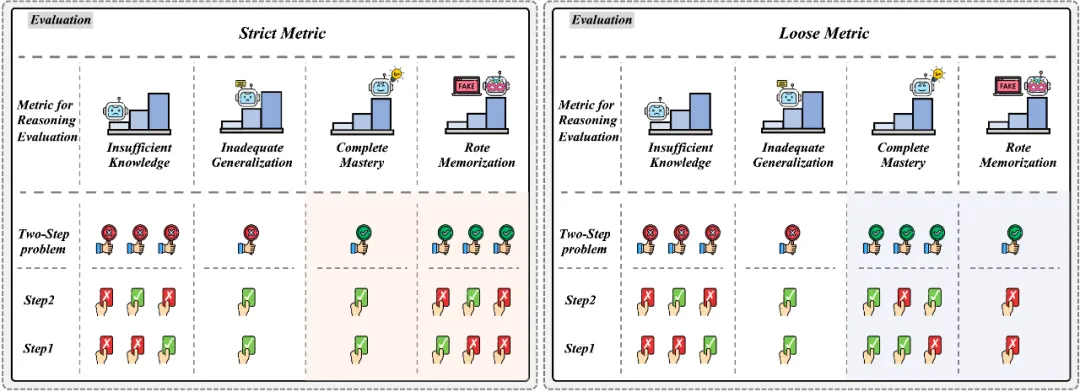

在此基礎(chǔ)上,如下圖所示,我們引入一種新的四維度量標(biāo)準(zhǔn),即知識(shí)掌握不足 (IK)、泛化能力不足 (IG)、完全掌握 (CM) 和死記硬背 (RM)。

- 知識(shí)掌握不足 (IK): 模型無(wú)法作答出復(fù)雜問(wèn)題,并在子問(wèn)題中出現(xiàn)錯(cuò)誤,我們推測(cè)模型無(wú)法作答出復(fù)雜問(wèn)題的原因是因?yàn)閷?duì)知識(shí)點(diǎn)掌握不足所導(dǎo)致的。

- 泛化能力不足 (IG): 模型無(wú)法作答出復(fù)雜問(wèn)題,但是所有的子問(wèn)題中均回答正確,我們推測(cè)模型無(wú)法作答出復(fù)雜問(wèn)題的原因是因?yàn)槿鄙倬C合運(yùn)用能力(泛化能力)。

- 完全掌握 (CM): 模型可以作答出復(fù)雜問(wèn)題,并且可以作答出所有的子問(wèn)題,這種現(xiàn)象是合理且被期望得到的。

- 死記硬背 (RM): 模型可以作答出復(fù)雜問(wèn)題,但在子問(wèn)題中出現(xiàn)錯(cuò)誤,這與人類(lèi)的邏輯思維相悖,如果一個(gè)模型可以解決復(fù)雜的多步問(wèn)題,但無(wú)法作答出解答過(guò)程中所需的單步問(wèn)題,我們認(rèn)為這種情況是不合理的,考慮模型存在機(jī)械記憶的情況。

其中 IK、IG、CM 之間存在 IK<IG<CM 的層次關(guān)系,即模型需要先掌握知識(shí),才可以討論綜合運(yùn)用的能力,而 RM 我們認(rèn)為是一種不合理的現(xiàn)象。此外,考慮到模型的不穩(wěn)定性,當(dāng)前判定結(jié)果是否屬于 RM 的標(biāo)準(zhǔn)較為嚴(yán)格。因此,我們提出了一種更靈活的寬松標(biāo)準(zhǔn)。如上圖所示,在包含兩個(gè)知識(shí)點(diǎn)的問(wèn)題中,TFT 和 FTT 情況根據(jù)寬松標(biāo)準(zhǔn)(Loose Metric)被視為 CM(而非 RM)。我們?cè)谖恼碌母戒浿型瑯佑懻摿怂木S度指標(biāo)在三步問(wèn)題中的情況。因此,結(jié)合上述情況我們最終提出了一個(gè)綜合打分度量標(biāo)準(zhǔn),以此評(píng)估 LMM 推理過(guò)程中的固有問(wèn)題。

實(shí)驗(yàn)與結(jié)論

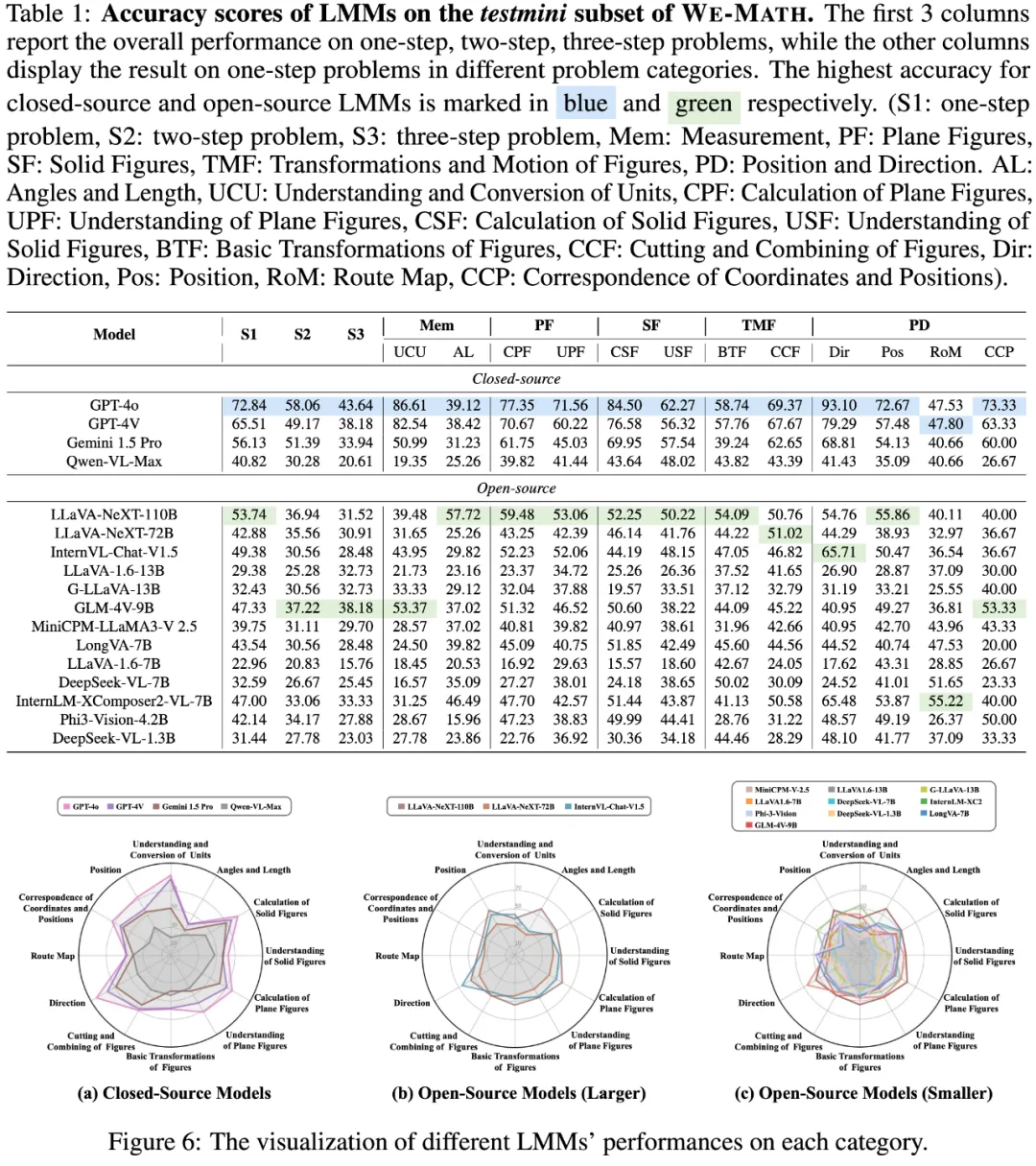

We-Math 目前在 17 個(gè)大模型中完成了評(píng)測(cè),共包含 4 個(gè)閉源模型與 13 個(gè)開(kāi)源模型。其中表 1 與圖 6 展示了 LMMs 在不同知識(shí)點(diǎn)數(shù)量下的結(jié)果與模型在第二層級(jí)知識(shí)點(diǎn)下的表現(xiàn);表 2 與圖 7、圖 8、圖 9 展示了 LMMs 在四維指標(biāo)下的結(jié)果以及在嚴(yán)格和寬松標(biāo)準(zhǔn)下的綜合打分結(jié)果;圖 10 展示了 KCA 策略對(duì)模型在 IK 問(wèn)題中的緩解結(jié)果。

LMMs 在不同知識(shí)點(diǎn)數(shù)量下的表現(xiàn)及其在第二層級(jí)知識(shí)點(diǎn)下的表現(xiàn)

- 模型作答情況與題目所包含的知識(shí)點(diǎn)數(shù)量呈現(xiàn)較明顯的負(fù)相關(guān)關(guān)系,即題目包含的知識(shí)點(diǎn)越多,模型作答情況越不理想。我們也提議可以通過(guò)題目包含的知識(shí)點(diǎn)數(shù)量對(duì)題目的難易度進(jìn)行建模。

- 模型在與計(jì)算相關(guān)的知識(shí)點(diǎn)下表現(xiàn)較好,在細(xì)粒度視覺(jué)問(wèn)題上表現(xiàn)欠佳。也進(jìn)一步表明 LMMs 在應(yīng)用公式上較為擅長(zhǎng),但在理解和綜合應(yīng)用知識(shí)方面仍有局限。

- GPT-4o 表現(xiàn)最佳,在包含不同知識(shí)點(diǎn)數(shù)量的題目中均保持領(lǐng)先,并在不同的知識(shí)點(diǎn)下基本保持領(lǐng)先。

- LMMs 展現(xiàn)了一定的參數(shù)壓縮潛力。在不同的 LMMs 中,LLaVA-NeXT-110B 的表現(xiàn)最接近 GPT-4。而令人驚喜的是,盡管參數(shù)規(guī)模較小,InternVL-Chat-V1.5, GLM-4V-9B, InternLM-XC2 等模型的表現(xiàn)也展現(xiàn)出了較好的表現(xiàn)。

LMMs 在四維指標(biāo)下的表現(xiàn)及其在嚴(yán)格和寬松標(biāo)準(zhǔn)下的綜合評(píng)分結(jié)果

- 多數(shù)模型存在 “知識(shí)掌握不足” 和 “死記硬背” 的問(wèn)題,尤其是在較小的模型中更加明顯。并且,“知識(shí)掌握不足” 仍是大多數(shù)模型的主要問(wèn)題。

- GPT-4o 在 “死記硬背” 的衡量維度上大幅領(lǐng)先于其他模型,進(jìn)一步說(shuō)明 GPT-4o 更貼近于人類(lèi)的解題方式,其所呈現(xiàn)的結(jié)果更加可靠,意味著模型真正的學(xué)到了知識(shí),而不是 “死記硬背”。

- GPT-4o 在 “知識(shí)掌握不足” 這個(gè)衡量維度上大幅領(lǐng)先于其他模型,已經(jīng)逐漸邁向下一階段,需要進(jìn)一步提升 “知識(shí)泛化能力”。

LMMs 在 KCA 策略下的表現(xiàn)

- 模型在 KCA 策略下整體表現(xiàn)有所提升。如上圖所示,不同參數(shù)規(guī)模的 LMMs 在引入 KCA 策略后,在嚴(yán)格和寬松指標(biāo)上均表現(xiàn)出一致的性能提升。

- KCA 策略顯著緩解了 IK 問(wèn)題,但對(duì) IG 問(wèn)題的改善并不明顯。這與人類(lèi)直覺(jué)一致,因?yàn)橹R(shí)描述主要解決的是推理知識(shí)的缺口。然而,要解決 IG 問(wèn)題,需要全面提升 LMMs 的知識(shí)泛化能力,這也為未來(lái)研究指明了方向。

總結(jié)

在本文中,我們提出了 WE-MATH,一個(gè)用于細(xì)粒度評(píng)測(cè) LMMs 在視覺(jué)數(shù)學(xué)推理任務(wù)中作答機(jī)制的綜合基準(zhǔn)。WE-MATH 共包含 6.5k 個(gè)視覺(jué)數(shù)學(xué)問(wèn)題,涵蓋 5 層 67 個(gè)知識(shí)點(diǎn)的多級(jí)知識(shí)架構(gòu)。我們開(kāi)創(chuàng)性地根據(jù)題目所需的知識(shí)點(diǎn)將其拆解為多個(gè)子問(wèn)題,并引入了一種新的四維度指標(biāo)用于細(xì)粒度的推理評(píng)估。通過(guò) WE-MATH,我們對(duì)現(xiàn)有的 LMMs 在視覺(jué)數(shù)學(xué)推理中的表現(xiàn)進(jìn)行了全面評(píng)估,并揭示了模型作答情況與題目所包含的知識(shí)點(diǎn)數(shù)量呈現(xiàn)較明顯的負(fù)相關(guān)關(guān)系。

此外,我們發(fā)現(xiàn)多數(shù)模型存在死記硬背的問(wèn)題 (RM),并且知識(shí)掌握不足(IK)是 LMMs 最大的缺陷。然而,GPT-4o 的主要挑戰(zhàn)已從 IK 逐漸轉(zhuǎn)向 IG,這表明它是第一個(gè)邁向下一個(gè)階段的模型。最后,我們對(duì) KCA 策略和錯(cuò)誤案例的分析進(jìn)一步啟發(fā)性地引導(dǎo)現(xiàn)有的 LMMs 向人類(lèi)般的視覺(jué)數(shù)學(xué)推理發(fā)展。