超過所有視覺方案!HTCL:分層時間上下文問鼎OCC(ECCV'24)

本文經自動駕駛之心公眾號授權轉載,轉載請聯系出處。

本文是對ECCV2024接受的文章 HTCL: 的介紹,HTCL在SemanticKITTI基準測試中超過了所有基于相機的方法,甚至在和OpenOccupancy基準測試中超過了LiDAR,實現了最先進的性能。代碼已開源,歡迎大家試用和Star~

代碼鏈接:https://github.com/Arlo0o/HTCL

論文鏈接:https://arxiv.org/abs/2407.02077

Demo video 展示:

我們對比了同樣采用時序雙目圖像輸入的VoxFormer-T,并用更少的輸入幀數(3 vs. 4)取得了更好的預測效果,在場景整體布局、相機視野外區域、遠距離動態物體等的預測中表現出明顯優勢。

Motivation

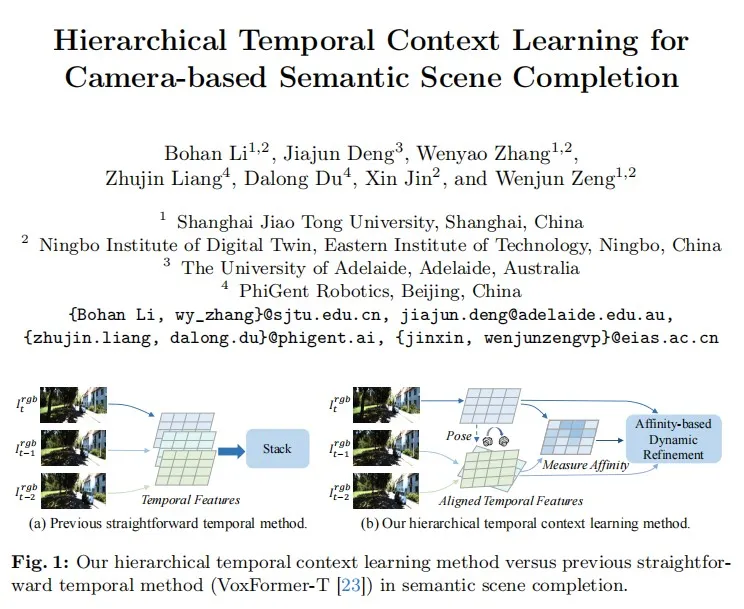

基于相機的三維語義場景補全(SSC)對于從有限的二維圖像觀測中預測復雜的三維場景信息至關重要。現有的主流解決方案通過對歷史幀信息的粗略堆疊來試圖補充當前視角下的不完整觀測,這種簡單的時序建模方式不可避免地減少了有效的視覺線索,增加了模型學習難度。

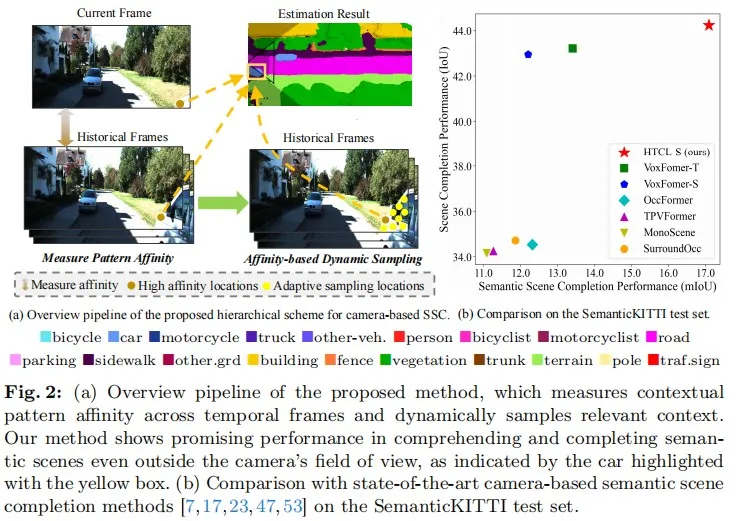

為了解決上述問題,我們提出了HTCL,一種新穎的分層時序上下文學習范式,用于改進基于相機的語義場景補全。HTCL將時序上下文學習分解為兩個層次步驟:(a)跨幀親和度測量;(b)基于親和度的動態細化。首先,為了從冗余信息中分離關鍵相關上下文,我們提出了尺度感知隔離策略,用于構建多個獨立的學習模塊,進而建模細粒度上下文對應關系。隨后,為了動態補償不完整的觀測結果,我們基于識別出的具有高親和度特征的空間位置及其鄰近的相關區域,自適應地細化特征采樣位置。

Method

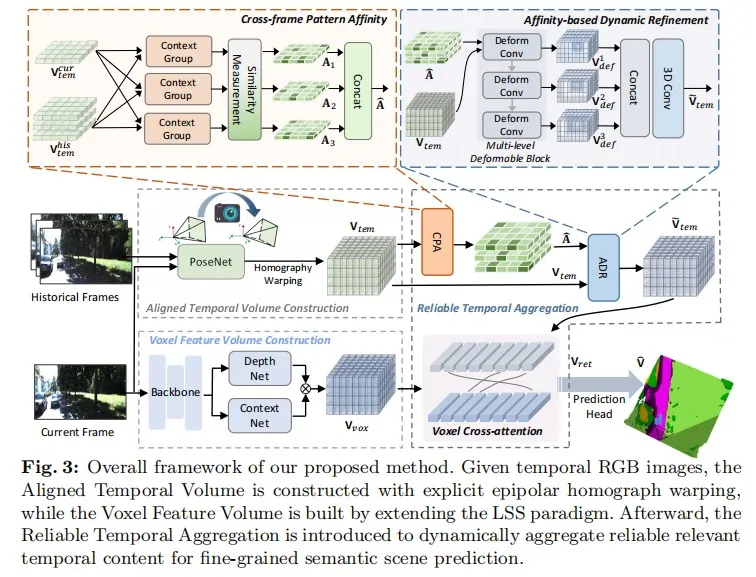

我們提出的分層時序上下文學習(HTCL)范式可以有效改進時序特征聚合的可靠性,從而實現精確的三維語義場景補全。HTCL從不同時間幀的RGB圖像中分層地推斷三維語義Occupancy,以實現細粒度的場景理解。如下圖所示,我們提出的分層時時序下文建模包括兩個順序步驟:(1)顯式地測量當前幀和歷史幀之間的上下文特征親和力,提取最相關的高親和度特征;(2)基于高親和力特征的空間位置及其附近的相關上下文自適應地細化采樣位置,以動態補償不完整的觀測。HTCL在創新性方面主要做出了以下貢獻:

- 提出了一種時序上下文學習范式,以用于動態和可靠的三維語義場景補全。

- 提出了一種具有尺度感知隔離和多個獨立學習模塊的親和度測量策略,用于細粒度的上下文對應關系建模。

- 提出了一個基于親和度的動態細化方案,以重新分配時序上下文信息,并自適應地補償不完整的觀測結果。

- HTCL在SemanticKITTI基準測試中超過了所有基于相機的方法,甚至在和OpenOccupancy基準測試中超過了LiDAR,實現了最先進的性能。

如上圖所示,我們提出的方法整體框架主要由三個部分組成:Aligned Temporal Volume Construction,Voxel Feature Volume Construction,以及Reliable Temporal Aggregation。

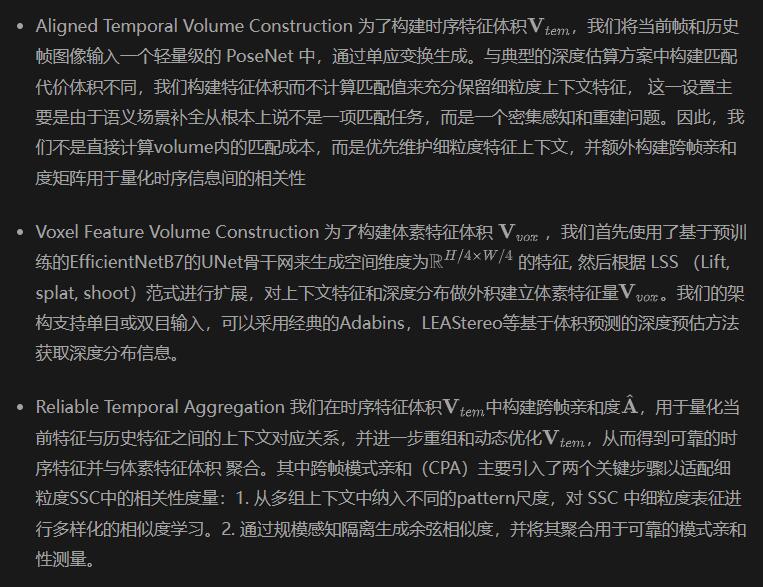

效果如下圖所示,跨幀模式親和(CPA)有效地表示了時間內容中的上下文對應關系。

鑒于我們的目標是完成并理解與當前幀相對應的三維場景,因此必須為最相關的位置分配更大的權重,同時也需要調查其鄰近的相關區域以彌補不完整的觀察結果。為此,我們提出基于親和力的動態細化(ADR),根據已確定的高親和性位置及其鄰近相關區域,用三維可變形卷積自適應地改進特征采樣位置。具體來說,我們通過引入基于親和力的對應權重和可變形位置偏移來實現動態細化:

為了進一步通過分層上下文推理動態建模,我們通過考慮級聯的不同特征層上下文信息 :

Experiment

實驗表明,我們的方法在SemanticKITTI Benchmark上排名第一,并在OpenOccupancy BenchMark中取得了超過基于LiDAR方法的mIoU。

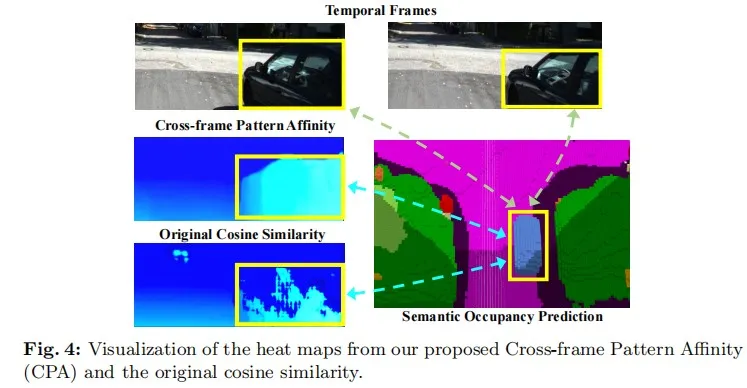

- 定量實驗結果:

在SemanticKITTI基準測試中,我們提出的方法明顯優于所有其他方法。與VoxFomer-T相比,我們的方法即使在較少的歷史輸入(3 vs. 4)中也取得了顯著的相對增益。在OpenOccupancy基準測試中,盡管基于LiDAR的在IoU方面具有固有的優勢,但我們的HTCL在mIoU方面超過了所有其他方法(包括基于LiDAR的LMSCNet和JS3C-Net ),證明了我們的方法在語義場景補全方面的有效性。

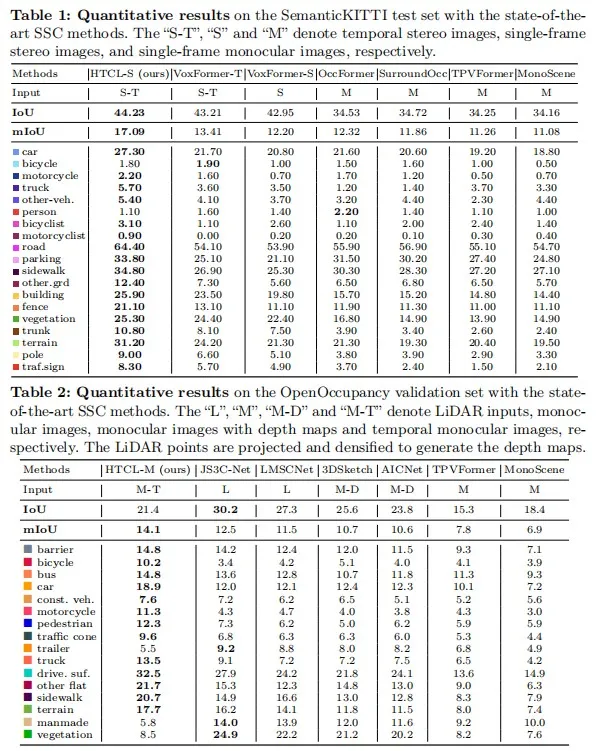

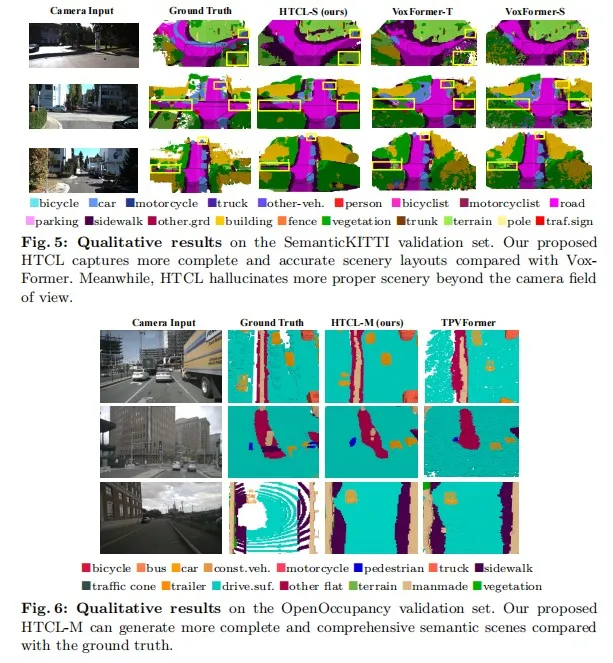

- 定性試驗結果:

圖5展示了我們提出的方法與VoxFormer在SemanticKITTI上的定性比較。可以觀察到,真實世界的場景非常復雜,而注釋的地面實況相對稀少,這給從有限的視覺線索中完全重建語義場景帶來了挑戰。與 VoxFormer 相比,我們的方法能捕捉到更完整、更準確的場景布局(如第二行和第三行的十字路口)。此外,我們的方法還能有效地補全攝像機視野外更多合適的景物(如第一行和第二行中的陰影區域),并在移動物體(如第二行中的卡車)方面表現出明顯的優勢。圖6展示了我們的方法在 OpenOccupancy 上的預測結果,我們提出的方法與GT相比,可以生成的結果更密集、更真實的Semantic Occupancy。