LeCun新作:分層世界模型,數(shù)據(jù)驅(qū)動(dòng)的人型機(jī)器人控制

有了大模型作為智能上的加持,人型機(jī)器人已然成為新的風(fēng)口。

科幻電影中「安能辨我不是人」的機(jī)器人似乎已經(jīng)越來(lái)越近了。

不過(guò),要想像人類一樣思考和行動(dòng),對(duì)于機(jī)器人,特別是人型機(jī)器人來(lái)說(shuō),仍是個(gè)艱巨的工程問(wèn)題。

就拿簡(jiǎn)單的學(xué)走路來(lái)說(shuō),利用強(qiáng)化學(xué)習(xí)來(lái)訓(xùn)練可能會(huì)演變成下面這樣:

道理上沒(méi)什么問(wèn)題(遵循獎(jiǎng)勵(lì)機(jī)制),上樓梯的目標(biāo)也達(dá)到了,除了過(guò)程比較抽象,跟大部分人類的行為模式可能不太一樣。

機(jī)器人之所以很難像人一樣「自然」行動(dòng),原因在于觀察和行動(dòng)空間的高維性質(zhì),以及雙足動(dòng)物形態(tài)固有的不穩(wěn)定性。

對(duì)此,LeCun參與的一項(xiàng)工作給出了基于數(shù)據(jù)驅(qū)動(dòng)的全新解決方案。

論文地址:https://arxiv.org/pdf/2405.18418

項(xiàng)目介紹:https://nicklashansen.com/rlpuppeteer

先看療效:

對(duì)比右邊的效果,新的方法訓(xùn)練出了更接近于人類的行為,雖然有點(diǎn)「喪尸」的意味,但抽象度降低了不少,至少在大部分人類的能力范圍之內(nèi)。

當(dāng)然了,也有來(lái)?yè)v亂的網(wǎng)友表示,「還是之前那個(gè)看著更有意思」。

在這項(xiàng)工作中,研究人員探索了基于強(qiáng)化學(xué)習(xí)的、高度數(shù)據(jù)驅(qū)動(dòng)的、視覺(jué)全身人形控制方法,沒(méi)有任何簡(jiǎn)化的假設(shè)、獎(jiǎng)勵(lì)設(shè)計(jì)或技能原語(yǔ)。

作者提出了一個(gè)分層世界模型,訓(xùn)練高級(jí)和低級(jí)兩個(gè)智能體,高級(jí)智能體根據(jù)視覺(jué)觀察生成命令,供低級(jí)智能體執(zhí)行。

開(kāi)源代碼:https://github.com/nicklashansen/puppeteer

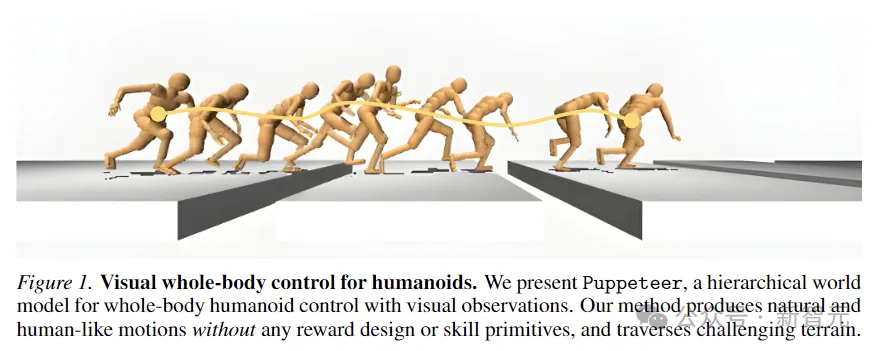

這個(gè)模型被命名為Puppeteer,利用一個(gè)模擬的56-DoF人形機(jī)器人,在8個(gè)任務(wù)中生成了高性能的控制策略,同時(shí)合成了自然的類似人類的動(dòng)作,并具有穿越挑戰(zhàn)性地形的能力。

高維控制的分層世界模型

在物理世界中學(xué)習(xí)訓(xùn)練出通用的智能體,一直是AI領(lǐng)域研究的目標(biāo)之一。

而人形機(jī)器人通過(guò)集成全身控制和感知,能夠執(zhí)行各種任務(wù),于是作為多功能平臺(tái)脫穎而出。

不過(guò)要模仿咱們這種高級(jí)動(dòng)物,代價(jià)還是很大的。

比如下圖中,人型機(jī)器人為了不踩坑,就需要準(zhǔn)確地感知迎面而來(lái)的地板縫隙的位置和長(zhǎng)度,同時(shí)仔細(xì)協(xié)調(diào)全身運(yùn)動(dòng),使其有足夠的動(dòng)量和范圍來(lái)跨越每個(gè)縫隙。

Puppeteer基于LeCun在2022年提出的分層JEPA世界模型,是一種數(shù)據(jù)驅(qū)動(dòng)的RL方法。

它由兩個(gè)不同的智能體組成:一個(gè)負(fù)責(zé)感知和跟蹤,通過(guò)關(guān)節(jié)級(jí)控制跟蹤參考運(yùn)動(dòng);另一個(gè)「視覺(jué)木偶」(puppeteer),通過(guò)合成低維參考運(yùn)動(dòng)來(lái)學(xué)習(xí)執(zhí)行下游任務(wù),為前者的跟蹤提供支持。

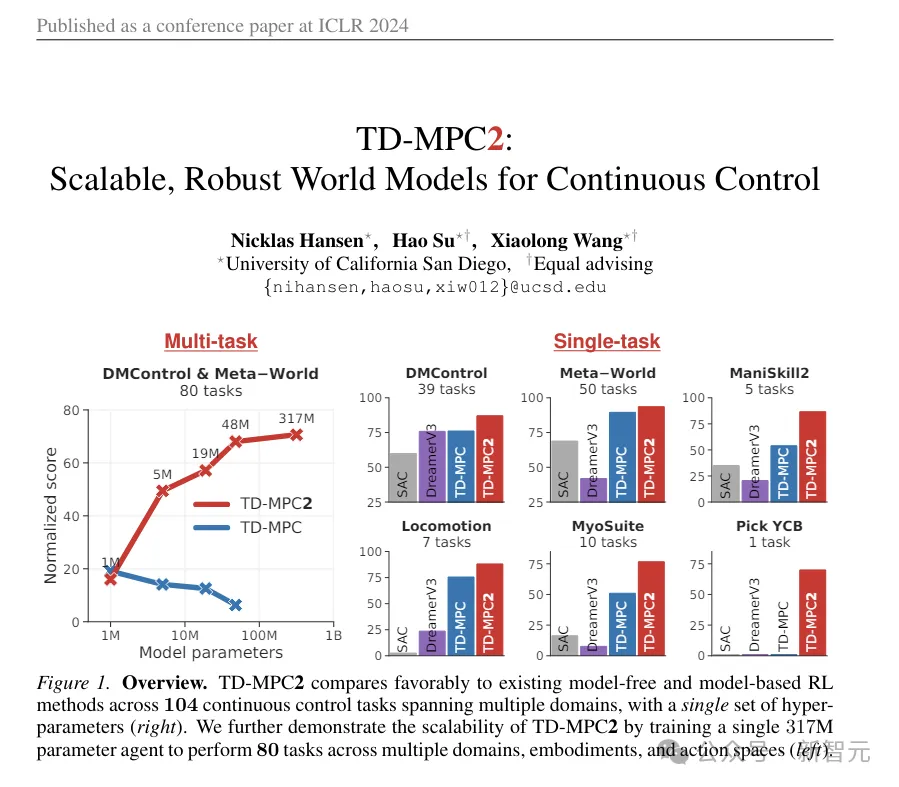

Puppeteer使用基于模型的RL算法——TD-MPC2,在兩個(gè)不同的階段獨(dú)立訓(xùn)練兩個(gè)智能體。

(ps:這個(gè)TD-MPC2就是文章開(kāi)篇用來(lái)比較的那個(gè)動(dòng)圖,別看有點(diǎn)抽象,那實(shí)際上是之前的SOTA,發(fā)表在今年的ICLR,一作同樣也是本文的一作。)

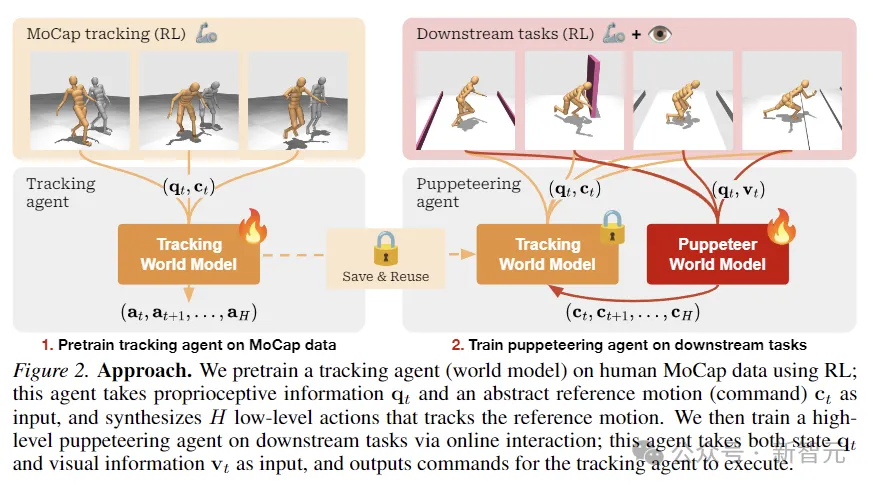

第一階段,首先對(duì)用于跟蹤的世界模型進(jìn)行預(yù)訓(xùn)練,使用預(yù)先存在的人類動(dòng)作捕捉數(shù)據(jù)作為參考,將運(yùn)動(dòng)轉(zhuǎn)換為物理上可執(zhí)行的動(dòng)作。這個(gè)智能體可以保存起來(lái),在所有下游任務(wù)中重復(fù)使用。

在第二階段,訓(xùn)練一個(gè)木偶世界模型,該模型以視覺(jué)觀察為輸入,并根據(jù)指定的下游任務(wù),整合另一個(gè)智能體提供的參考運(yùn)動(dòng)作為輸出。

這個(gè)框架看上去大道至簡(jiǎn):兩個(gè)世界模型在算法上是相同的,只是在輸入/輸出上不同,并且使用RL進(jìn)行訓(xùn)練,無(wú)需其他任何花里胡哨的東西。

與傳統(tǒng)的分層RL設(shè)置不同的是,「木偶」輸出的是末端執(zhí)行器關(guān)節(jié)的幾何位置,而不是目標(biāo)的嵌入。

這使得負(fù)責(zé)跟蹤的智能體易于在任務(wù)之間共享和泛化,節(jié)省整體計(jì)算占用的空間。

研究方法

研究人員將視覺(jué)全身人形控制,建模為一個(gè)由馬爾可夫決策過(guò)程(MDP)控制的強(qiáng)化學(xué)習(xí)問(wèn)題,該過(guò)程以元組(S,A,T,R,γ,?)為特征,

其中S是狀態(tài),A是動(dòng)作,T是環(huán)境轉(zhuǎn)換函數(shù), R是標(biāo)量獎(jiǎng)勵(lì)函數(shù), γ是折扣因子,?是終止條件。

如上圖所示,研究人員使用RL在人類MoCap數(shù)據(jù)上預(yù)訓(xùn)練跟蹤智能體,用于獲取本體感覺(jué)信息和抽象參考運(yùn)動(dòng)輸入,并合成跟蹤參考運(yùn)動(dòng)的低級(jí)動(dòng)作。

然后通過(guò)在線互動(dòng),對(duì)負(fù)責(zé)下游任務(wù)的高級(jí)木偶智能體進(jìn)行訓(xùn)練,木偶接受狀態(tài)和視覺(jué)信息輸入,并輸出命令供跟蹤智能體執(zhí)行。

TD-MPC2

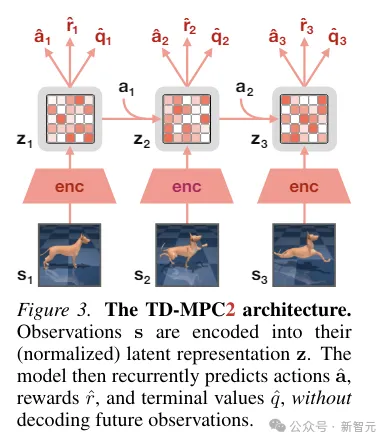

TD-MPC2從環(huán)境交互中學(xué)習(xí)一個(gè)潛在的無(wú)解碼器世界模型,并使用學(xué)習(xí)到的模型進(jìn)行規(guī)劃。

世界模型的所有組件都是使用聯(lián)合嵌入預(yù)測(cè)、獎(jiǎng)勵(lì)預(yù)測(cè)和時(shí)間差異 損失的組合端到端學(xué)習(xí)的,而無(wú)需解碼原始觀察結(jié)果。

在推理過(guò)程中,TD-MPC2遵循模型預(yù)測(cè)控制(MPC)框架,使用模型預(yù)測(cè)路徑積分(MPPI)作為無(wú)導(dǎo)數(shù)(基于采樣)的優(yōu)化器進(jìn)行局部軌跡優(yōu)化。

為了加快規(guī)劃速度,TD-MPC2還事先學(xué)習(xí)了一個(gè)無(wú)模型策略,用于預(yù)啟動(dòng)采樣程序。

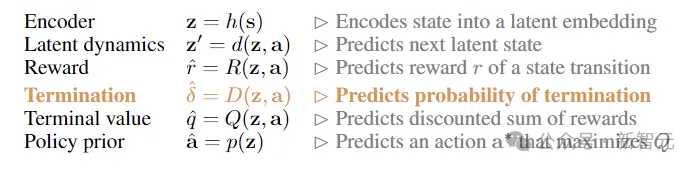

兩個(gè)智能體在算法上是相同的,都由以下6個(gè)組件組成:

實(shí)驗(yàn)

為了評(píng)估方法的有效性,研究人員提出了一種新的任務(wù)套件,使用模擬的56自由度人形機(jī)器人進(jìn)行視覺(jué)全身控制,總共包含8個(gè)具有挑戰(zhàn)性的任務(wù),用于對(duì)比的方法包括SAC、DreamerV3以及TD-MPC2。

8個(gè)任務(wù)如下圖所示,包括5個(gè)視覺(jué)條件全身運(yùn)動(dòng)任務(wù),以及另外3個(gè)沒(méi)有視覺(jué)輸入的任務(wù)。

任務(wù)的設(shè)計(jì)具有高度的隨機(jī)性,包括沿著走廊奔跑、跳過(guò)障礙物和縫隙、走上樓梯以及繞過(guò)墻壁。

5個(gè)視覺(jué)控制任務(wù)都使用與線性前進(jìn)速度成正比的獎(jiǎng)勵(lì)函數(shù),而非視覺(jué)任務(wù)則獎(jiǎng)勵(lì)任何方向的位移。

上圖繪制了學(xué)習(xí)曲線。結(jié)果表明,SAC和DreamerV3在這些任務(wù)上無(wú)法實(shí)現(xiàn)有意義的性能。

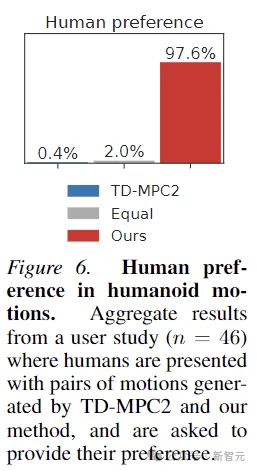

TD-MPC2在獎(jiǎng)勵(lì)方面的性能與本文的方法相當(dāng),但會(huì)產(chǎn)生不自然的行為(參見(jiàn)下圖中的抽象動(dòng)作)。

此外,為了證明Puppeteer生成的動(dòng)作確實(shí)更「自然」,本文還進(jìn)行了人類偏好的實(shí)驗(yàn),對(duì)46名參與者的測(cè)試表明,人類普遍喜歡本文方法生成的運(yùn)動(dòng)。