李飛飛「空間智能」系列新進展,吳佳俊團隊新「BVS」套件評估計算機視覺模型

在不久之前的 2024 TED 演講中,李飛飛詳細解讀了 空間智能(Spatial Intelligence)概念。她對計算機視覺領域在數年間的快速發展感到欣喜并抱有極大熱忱,并為此正在創建初創公司

在此演講中,曾提到斯坦福團隊的一個研究成果 BEHAVIOR,這是他們「創建」的一個用來訓練計算機和機器人如何在三維世界中行動的行為和動作數據集。

如今,吳佳俊帶領團隊發表了后續研究——「BEHAVIOR Vision Suite(BVS)」。論文也獲得 CVPR 2024 Highlight。

在計算機視覺領域,系統評估和理解模型在不同條件下的表現需要?量數據和全?、定制的標簽。然?,現實世界中的視覺數據集往往難以滿?這些需求。盡管?前的合成數據?成器為具? AI 任務提供了有前景的替代?案,但在資產和渲染質量、數據多樣性及物理屬性的真實性??,仍存在諸多不?。

為了解決這些問題,研究團隊推出了 「BEHAVIOR Vision Suite(BVS)」。

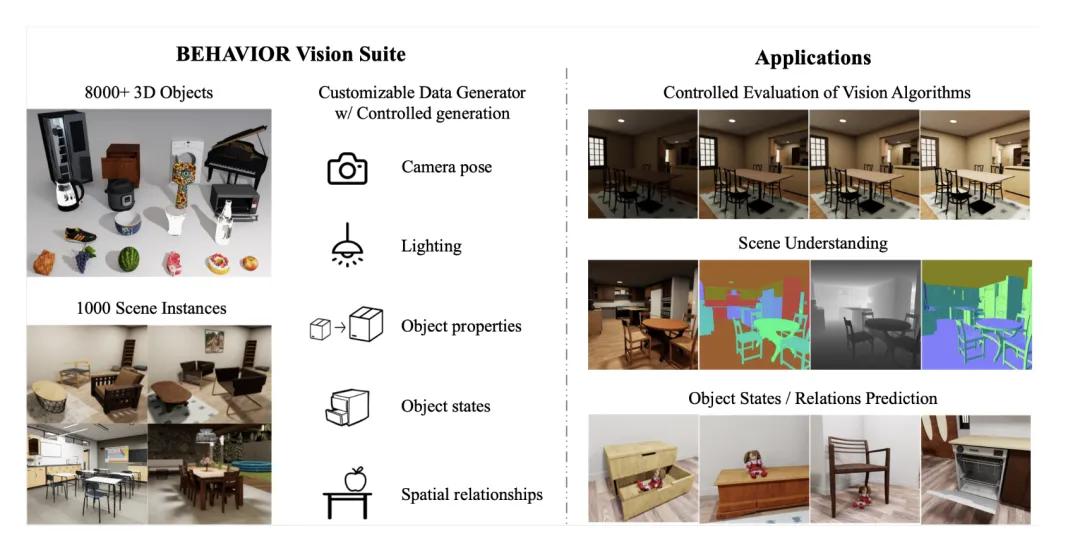

BVS 是?套專為系統評估計算機視覺模型?設計的?具和資源集。基于新開發的具? AI 基準BEHAVIOR-1K,BVS ?持?量可調參數,涵蓋場景級別(如光照、物體擺放)、物體級別(如關節配置、屬性)和相機級別(如視野、焦距)。研究?員可以在數據?成過程中?由調整這些參數,以進?精確的控制實驗。

此?作還展?了 BVS 在不同模型評估和訓練應?中的優勢,包括參數可控地評估視覺模型在環境參數連續變化時的魯棒性,系統評估場景理解模型(豐富的視覺標注),以及對新視覺任務的模型訓練。

- 項目鏈接:https://behavior-vision-suite.github.io/

- 論文鏈接:https://arxiv.org/pdf/2405.09546

- 代碼鏈接:https://github.com/behavior-vision-suite/behavior-vision-suite.github.io

BEHAVIOR Vision Suite

BVS 包括兩?部分:數據部分和基于此的可定制數據?成器。

數據部分

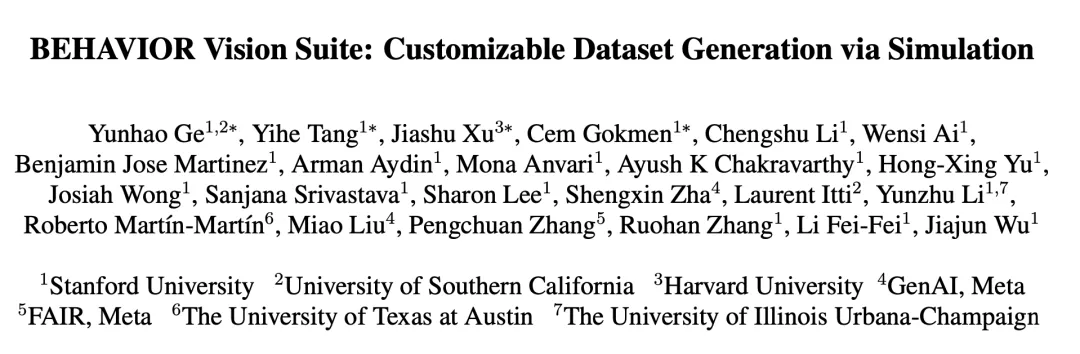

BVS 的數據部分基于 BEHAVIOR-1K 的資產拓展?成,共包括 8841個 3D 物體模型和由 51 位藝術家設計的室內場景,擴充為 1000 個場景實例。這些模型和場景均具備逼真的外觀,并涵蓋了豐富的語義類別。研究團隊同時提供了一個腳本,讓用戶可以自動生成更多的增強場景實例。

BEHAVIOR-1K的資產拓展

可定制數據?成器

可定制數據?成器可以讓?戶?便地利? BVS 的數據部分來?成滿?他們需求的圖?數據集,例如暗光下的室內場景。

BVS 可以讓?成的數據集在滿?需求的同時,具備較?的語義多樣性,同時確保其逼真性和物理合理性。具體來說,?戶可以控制以下五個??:相機位置、光照、物體屬性(如??)、物體狀態(如開、關)和物體之間的空間關系。

應?場景

研究者展?了在三個應?場景下 BVS 所?成數據的作?,包括:

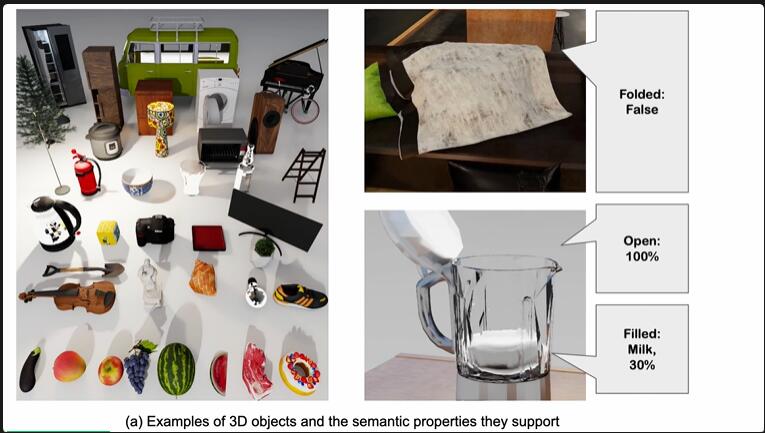

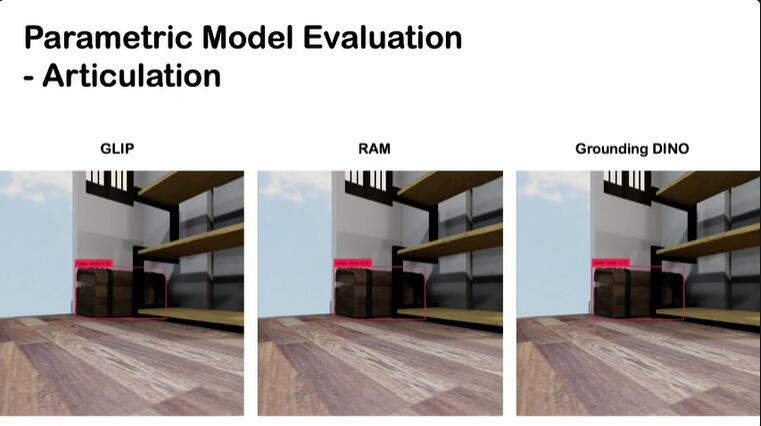

- 參數可控地評估視覺模型在環境參數連續變化時的魯棒性:探究模型在不同環境參數(遮擋程度,環境亮度,拍攝角度,物體關節移動,視野)連續變化情況下的表現,例如評估物體檢測模型在冰箱門從完全關閉到完全打開過程中,模型能正確檢測出存在冰箱的準確率,確保模型在實際應?中能夠應對各種環境變化。還可以探究模型在不同極限參數條件的能力邊界。

- 評估場景理解模型:使?擁有全?標注的圖像,系統評估各種場景理解模型的性能。

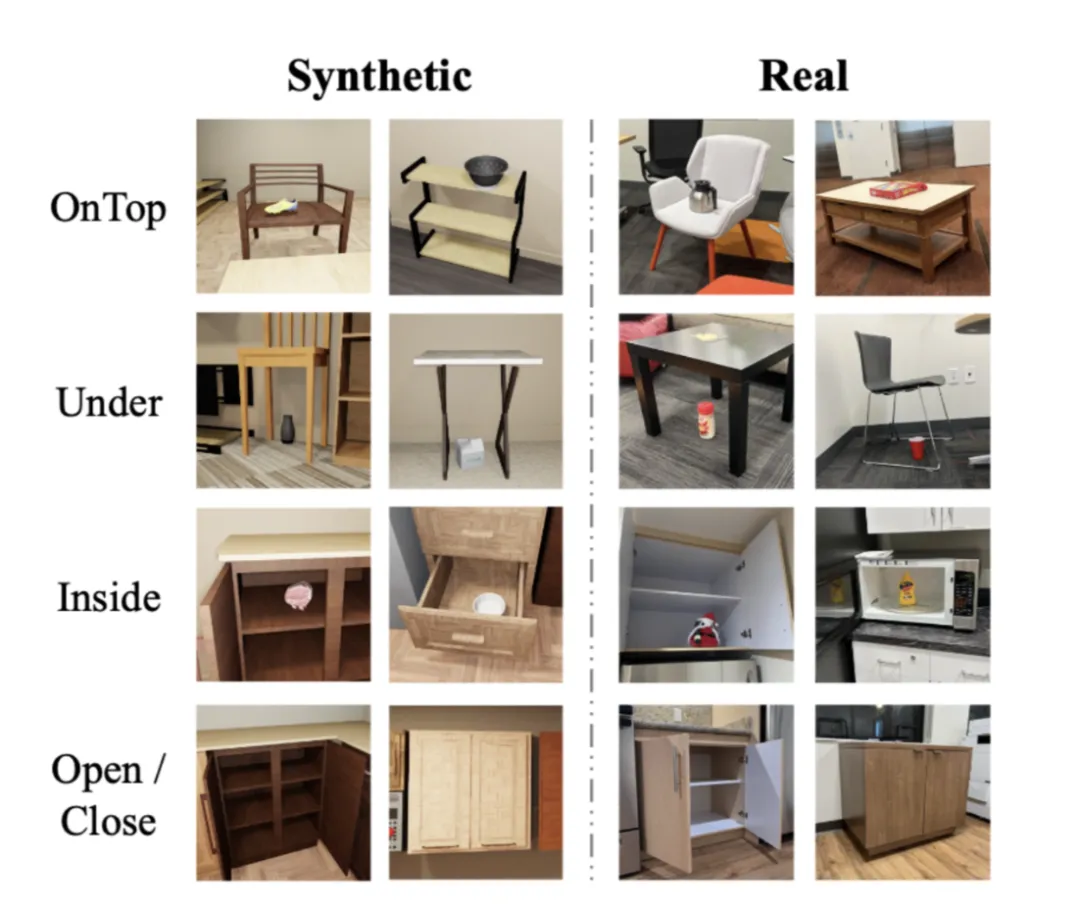

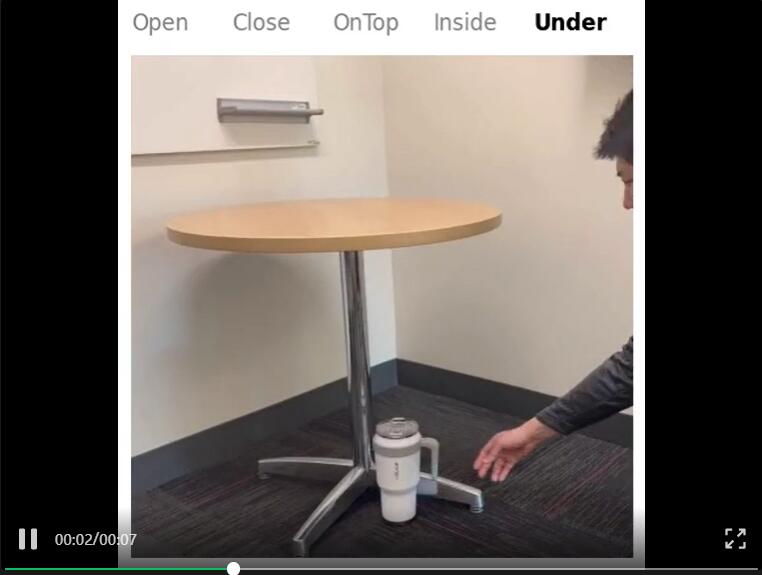

- 訓練新視覺任務模型:在合成數據上訓練對象狀態和關系預測的新視覺任務模型,并評估其從模擬到真實應?的轉移能?,確保模型在真實環境中的有效性。

參數可控地評估視覺模型在環境參數連續變化時的魯棒性

通過?成在某?維度上連續變化的數據,研究?員系統評估視覺模型在此變化下的魯棒性。例如,?成同?場景中物體遮擋程度逐漸增加的數據,以評估視覺模型在部分遮擋物件下的表現。

通過評估不同 SOTA 模型,研究者發現,現有模型在常見分布之外的數據上的表現仍有不?。由于這些數據在現實世界中難以獲得或標注,這些結論很難直接從真實圖?數據集中得出。因此,BVS 可以幫助研究者評估模型在他們感興趣的條件下的魯棒性,從?更好地開發和提升模型。

現有SOTA模型在條件變化下(例如相機仰?)仍有魯棒性上的提升空間

不同檢測模型在五種環境參數連續變化時的表現

評估場景理解模型

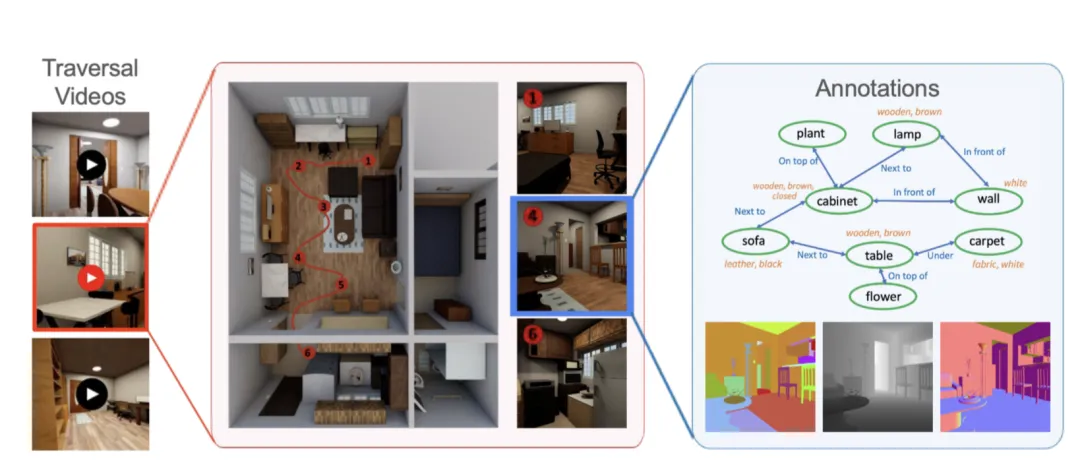

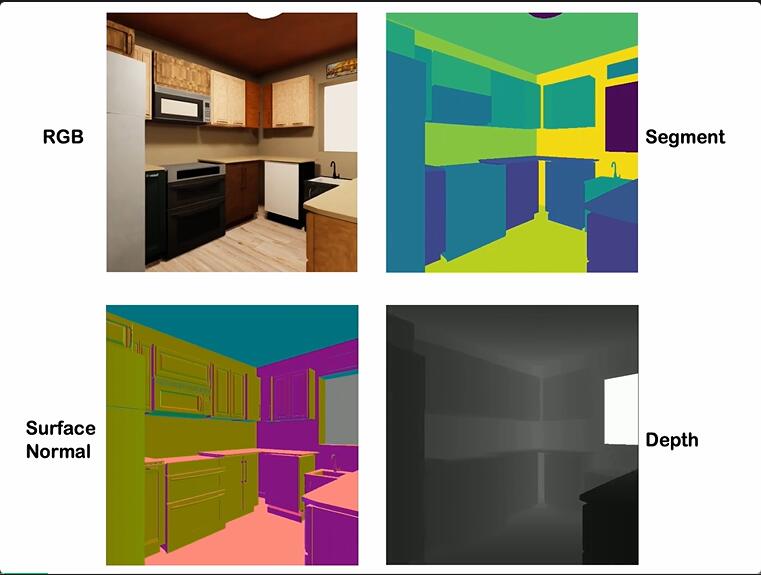

BVS 所?成的數據集的另??特征是其包含多模態的真實標簽,如深度、語義分割、?標邊界框等。這使得研究者可以利? BVS ?成的數據在同?圖像上評估不同任務的預測模型。

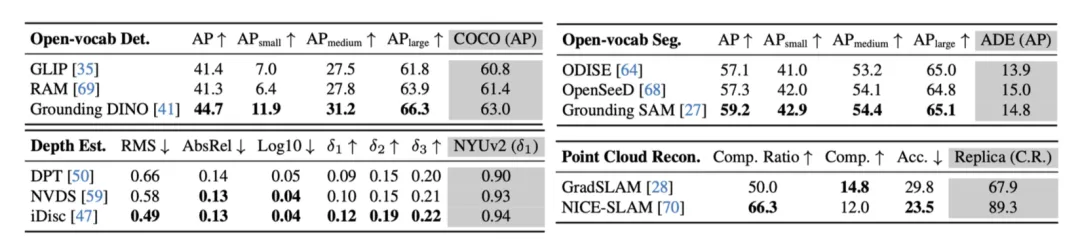

研究團隊評估了開放詞匯檢測和分割、深度估計和點云重建四個任務的 SOTA 模型,并發現模型在 BVS 數據集上的表現順序與在對應任務真實數據基準上的表現?致。這表明 BVS 生成的高質量數據真實地反映和代表了現實數據,研究者希望這樣的數據集可以促進多任務預測模型的發展。

在開源的代碼中,研究團隊也提供了一個腳本,方便用戶在場景中采樣軌跡。

研究者收集了許多場景瀏覽視頻?于評估場景理解模型

整體場景理解數據集。研究者在具有代表性的場景中生成了大量遍歷視頻,每個場景包含10多個攝像機軌跡。對于每個圖像,BVS生成了各種標簽(例如,場景圖、分割掩碼、深度圖)

SOTA模型在BVS數據上的相對表現順序與真實任務基準相符

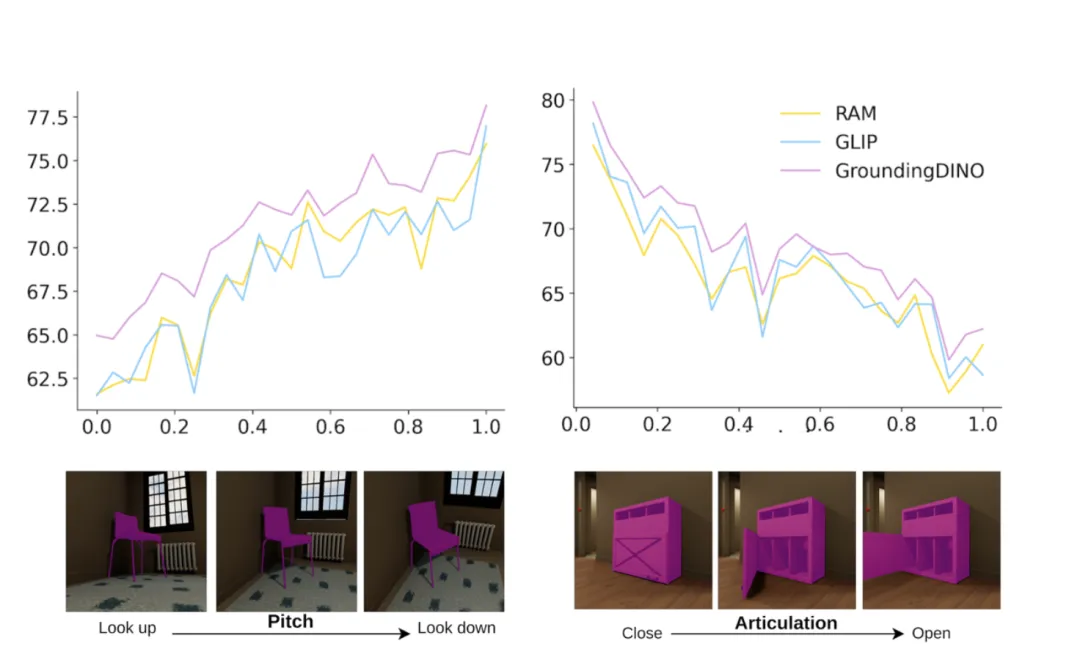

訓練新視覺任務模型

BVS 的數據?成不僅限于模型評估,對于難以在現實場景中收集或標注數據的任務, BVS 數據也可?于模型訓練。

作者利? BVS ?成了 12.5k 張圖?,僅?其訓練了?個物體空間關系和狀態預測模型。該模型在未使?真實數據訓練的情況下,仍在真實場景下達到了 0.839 的 F1 得分,體現了優秀的仿真到現實的轉移能?(sim-to-real transfer)。

仿真?成訓練數據集與真實測試數據集例圖

使用BVS生成的數據訓練的物體空間關系和狀態預測模型

總結

BVS 提供了?套強?的?具和資源集,為計算機視覺研究者?成定制的合成數據集提供了新的?法。

通過系統地控制和調整數據?成過程中的各項參數,研究?員可以更全?地評估和改進計算機視覺模型的性能,為未來的研究和應?奠定堅實基礎。