AlphaGo核心算法增強(qiáng),7B模型數(shù)學(xué)能力直逼GPT-4,阿里大模型新研究火了

把AlphaGo的核心算法用在大模型上,“高考”成績直接提升了20多分。

在MATH數(shù)據(jù)集上,甚至讓7B模型得分超過了GPT-4。

一項來自阿里的新研究引發(fā)關(guān)注:

研究人員用蒙特卡洛樹搜索(MCTS)給大語言模型來了把性能增強(qiáng),無需人工標(biāo)注解題步驟,也能生成高質(zhì)量數(shù)據(jù),有效提升大模型的數(shù)學(xué)成績。

論文發(fā)布,讓不少網(wǎng)友重新關(guān)注到了蒙特卡洛樹搜索這個在前大模型時代的明星算法。

有人直言:

蒙特卡洛樹搜索+LLM是通往超級智能之路。

因為“樹搜索本身更接近人類思維”。

用蒙特卡洛樹搜索增強(qiáng)大模型

具體來說,阿里的研究人員提出了一種名為AlphaMath的方法,用大語言模型+MCTS來自動生成數(shù)學(xué)推理數(shù)據(jù),并提升大模型在完成數(shù)學(xué)推理任務(wù)時的性能表現(xiàn)。

嗯,名字就很有蒙特卡洛樹搜索內(nèi)味兒了。

這里有個前情提要:

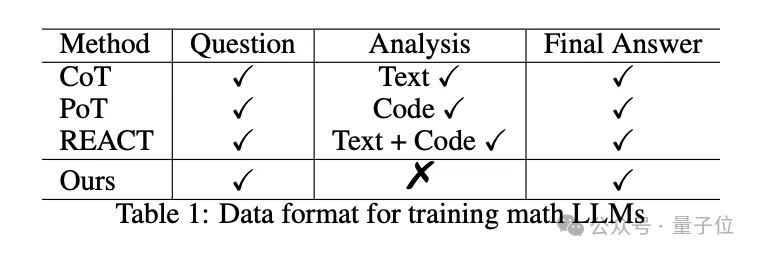

思維鏈(CoT)、思維程序(PoT)等方法已經(jīng)被證明能夠有效提高大模型的數(shù)學(xué)能力,但問題在于,它們都需要人類手動喂詳細(xì)的解題步驟,即訓(xùn)練當(dāng)中需要用到人工標(biāo)注的高質(zhì)量數(shù)學(xué)推理數(shù)據(jù)。

AlphaMath的一個核心目的就在于,在這個步驟中去人工化——數(shù)據(jù)格式就是簡單的數(shù)學(xué)問題-答案對。

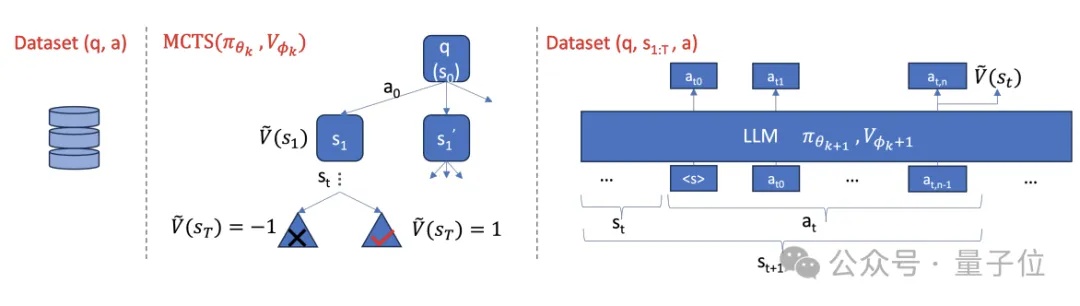

AlphaMath的技術(shù)路線主要涵蓋三個階段:

首先,研究人員收集了一個數(shù)學(xué)數(shù)據(jù)集,其中包含數(shù)學(xué)問題及其對應(yīng)的正確答案。

然后,利用預(yù)訓(xùn)練的大模型(即策略模型)根據(jù)問題生成初始的解題路徑,并通過MCTS對解題路徑進(jìn)行探索和改進(jìn),搜索更優(yōu)的解題思路。

在MCTS過程中,同時訓(xùn)練一個價值模型來預(yù)測解題路徑的質(zhì)量,引導(dǎo)搜索方向。

最后,第二階段獲得的數(shù)據(jù)會被用來優(yōu)化策略模型和價值模型。

這三個階段會通過迭代優(yōu)化地方式執(zhí)行,以實現(xiàn)無需人工標(biāo)注的自動數(shù)據(jù)生成和模型數(shù)學(xué)能力優(yōu)化。

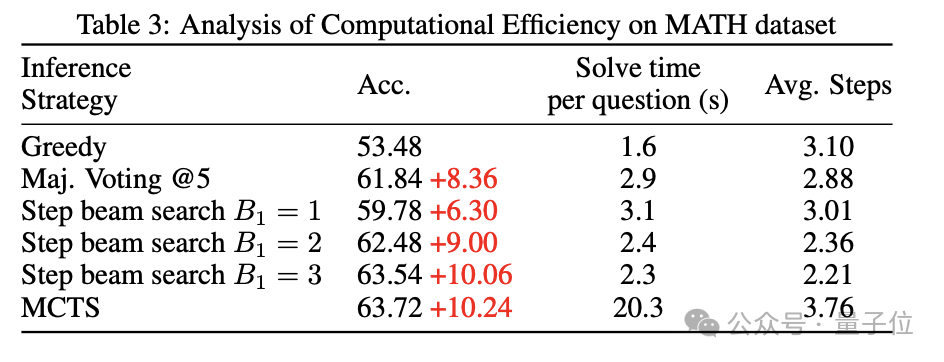

另外,研究人員還基于價值模型提出了Step-level Beam Search方法,以提高大模型的數(shù)學(xué)推理效率,平衡推理時的解題質(zhì)量和運(yùn)行時間。

簡單來說,Step-level Beam Search是將MCTS推理過程做了個簡化:

- 利用價值模型對候選路徑進(jìn)行評估,以更準(zhǔn)確地選擇高質(zhì)量的解題路徑。

- 通過逐步擴(kuò)展和剪枝,在搜索過程中動態(tài)調(diào)整候選路徑集合,提高搜索效率。

- 搜索過程中考慮了完整的解題路徑,而不僅僅是局部的下一步動作,可以得到更全局優(yōu)化的解題方案。

MATH成績超GPT-4

為了驗證AlphaMath的效果,研究人員設(shè)計了這樣的實驗:

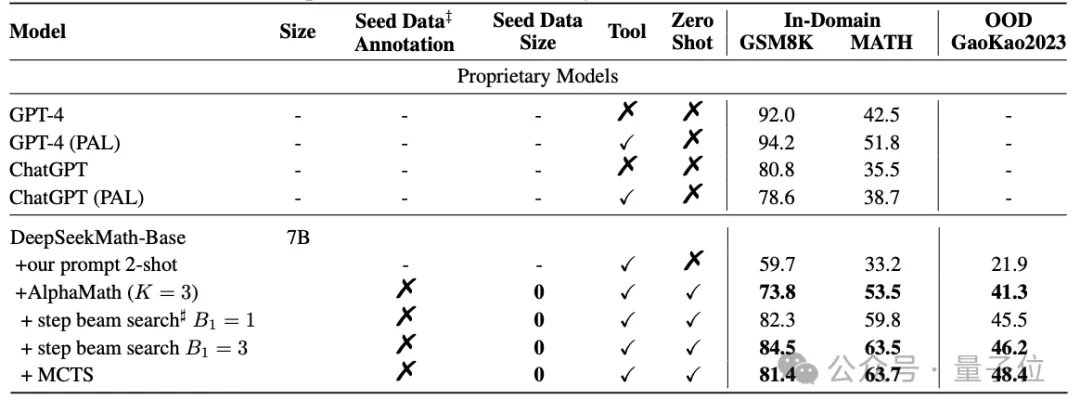

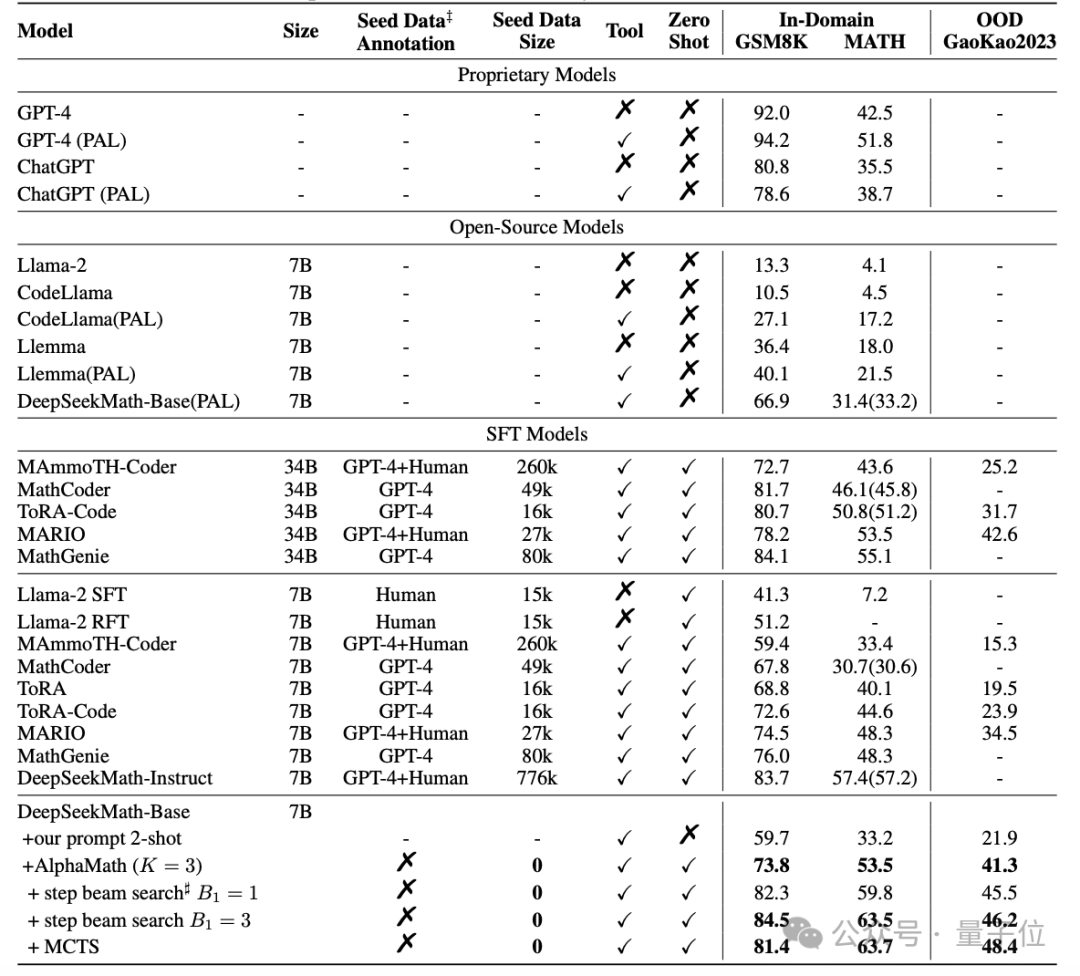

對開源的數(shù)學(xué)大模型DeepSeekMath-Base-7B,用AlphaMath方法進(jìn)行訓(xùn)練,并在GSM8K、MATH和Gaokao2023基準(zhǔn)上,與GPT-4為代表的閉源模型、Llama2為代表的開源模型,以及專門做過數(shù)學(xué)SFT的MathCoder等模型進(jìn)行對比。

結(jié)果顯示,不依賴于人類(或GPT-4)標(biāo)注的高質(zhì)量數(shù)據(jù),AlphaMath調(diào)教下的7B數(shù)學(xué)大模型,已經(jīng)能在MATH上取得63%的分?jǐn)?shù),超過了GPT-4原版的42.5%和外掛代碼解釋器版的51.8%。

另外,在執(zhí)行3輪MCTS并訓(xùn)練策略模型和價值模型的情況下,AlphaMath能讓大模型在涵蓋小學(xué)數(shù)學(xué)題的GSM8K上提升10多分,在MATH和Gaokao2023上提升20多分。

還可以看到,Step-level Beam Search在MATH數(shù)據(jù)集上取得了良好的效率和準(zhǔn)確率平衡。

論文的共同一作是Guoxin Chen、Mingpeng liao、Chengxi Li和Kai Fan。

通訊作者Kai Fan本碩畢業(yè)于北京大學(xué),2017年從杜克大學(xué)博士畢業(yè),2018年加入阿里巴巴達(dá)摩院。

論文地址:https://arxiv.org/abs/2405.03553。