OWASP發布大語言模型網絡安全與治理清單

當前人工智能技術面臨的最大風險是大語言模型(LLM)和生成式人工智能技術的發展和應用速度已經遠遠超過了安全和治理的速度。

OpenAI、Anthropic、谷歌和微軟等公司的生成式人工智能和大語言模型產品的使用正呈指數級增長。與此同時,開源大語言模型方案也在高速成長,HuggingFace等開源人工智能社區為技術社區提供了大量開源模型、數據集和AI應用。

為了追趕人工智能的發展腳步,OWASP、OpenSSF、CISA等行業組織正在積極開發和提供人工智能安全與治理關鍵資源,例如OWASP AI Exchange、AI安全和隱私指南以及大語言模型十大風險清單(LLMTop10)。

近日,OWASP發布了大語言模型網絡安全與治理清單,填補了生成式人工智能安全治理的空白,具體內容如下:

OWASP對AI類型與威脅的定義

OWASP大語言模型網絡安全與治理清單對人工智能、機器學習、生成式人工智能和大語言模型之間的區別給出了定義。

例如,OWASP對生成式人工智能的定義是:一種專注于創建新數據的機器學習,而大語言模型是一種用于處理和生成類人文本的人工智能模型——它們根據所提供的輸入進行預測,并且輸出是類似人類產生的“自然內容”。

對于此前發布的“大語言模型十大威脅清單”,OWASP認為它可以幫助網絡安全從業者跟上快速發展的AI技術,識別關鍵威脅并確保企業擁有基本的安全控制措施來保護和支持采用生成式人工智能和大語言模型的業務。但OWASP認為該清單并不詳盡,而且需要根據生成式人工智能的發展而不斷完善。

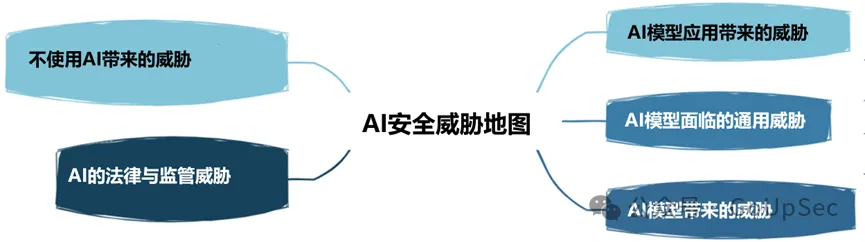

OWASP將AI安全威脅分為以下五種:

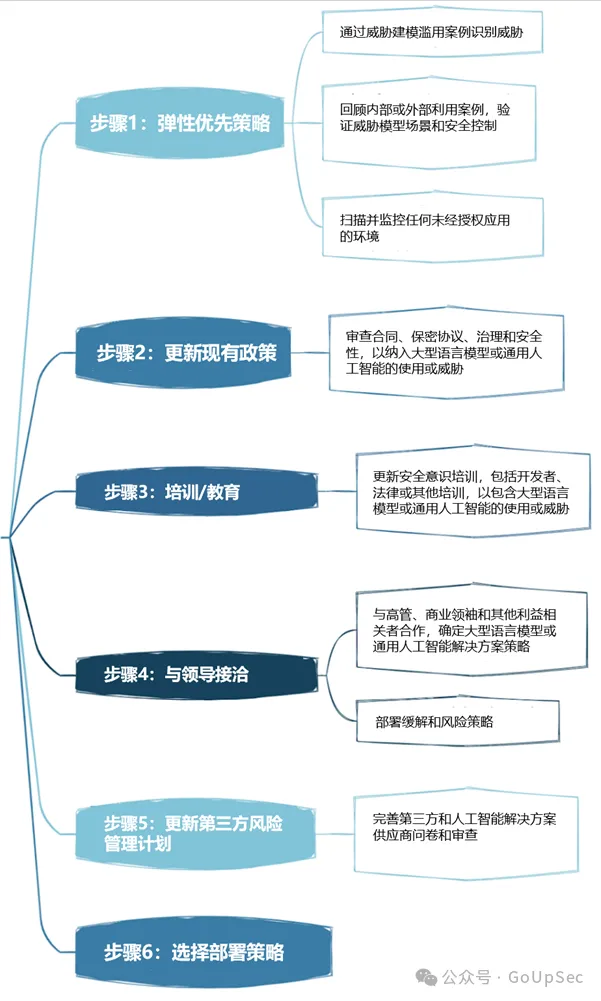

OWASP的大語言模型安全治理策略部署分為六步:

以下是OWASP大語言模型網路安全與治理清單:

1.對手風險

大語言模型的對手風險不僅涉及競爭對手,還涉及攻擊者,其關注點不僅是攻擊態勢,還包括商業態勢。這包括了解競爭對手如何使用人工智能來推動業務成果,以及更新內部流程和政策(例如事件響應計劃(IRP)),以應對生成式人工智能攻擊和事件。

2.威脅建模

威脅建模是一種日益流行的安全技術,隨著安全設計系統理念的推廣而獲得越來越多的關注,得到了美國網絡安全和基礎設施安全局(CISA)等權威機構的認可。威脅建模需要思考攻擊者如何利用大型語言模型和生成式人工智能來加速漏洞利用,企業檢測惡意大型語言模型的能力,以及組織是否能夠保護大型語言模型和生成式人工智能平臺與內部系統和環境的連接。

3.人工智能資產清單

“你無法保護未知的資產”這句格言也適用于生成式人工智能和大語言模型領域。OWASP清單的這部分內容涉及對內部開發的人工智能解決方案以及外部工具和平臺進行人工智能資產清單編制。

OWASP強調,企業不僅要了解內部使用了哪些工具和服務,還要了解其所有權,即誰對這些工具和服務的使用負責。清單還建議將人工智能組件包含在軟件材料清單(SBOM)中,并記錄人工智能數據源及其各自的敏感性。

除了對現有人工智能工具進行清單編制之外,企業還應該建立一個安全流程將未來的AI工具和服務添加到清單中。

4.人工智能安全和隱私意識培訓

人們常說“人是最大的安全漏洞”,企業只有將人工智能安全和隱私培訓合理集成到其生成式人工智能和大語言模型的應用過程中,才能極大緩解人的風險。

這包括幫助員工了解現有生成式人工智能/大語言模型計劃、技術及其功能,以及關鍵的安全注意事項,例如數據泄漏。此外,建立信任和透明的安全文化至關重要。

企業內部的信任和透明文化也有助于避免影子AI威脅,否則,員工將“偷偷“使用影子AI而不告訴IT和安全團隊。

5.人工智能項目的商業論證

就像云計算一樣,大多數企業實際上并沒有為生成式人工智能和大語言模型等新技術應用制定連貫的戰略性商業論證,很容易盲目跟風,陷入炒作。沒有合理的商業論證,企業的人工智能應用很可能會產生糟糕結果并增加風險。

6.治理

沒有治理,企業就無法建立人工智能的責任機制和明確目標。OWASP清單建議企業為人工智能應用制定RACI圖表(責任分配矩陣),記錄并分配風險責任和治理任務,建立全企業范圍的人工智能政策和流程。

7.法律

隨著人工智能技術的飛速發展,其法律影響不容低估,并可能在給企業帶來財務和聲譽的重大風險。

人工智能法務涉及一系列活動,例如人工智能產品質保、人工智能最終用戶許可協議(EULA)、使用人工智能工具開發的代碼的所有權、知識產權風險和合同賠償條款等。簡而言之,請確保企業的法律團隊或專家了解企業使用生成式人工智能和大語言模型時應該開展的各種配套法律活動。

8.監管

人工智能監管法規也在迅速發展,例如歐盟的人工智能法案,其他國家和地區的法規也將很快出臺。企業應該了解所在國家的人工智能合規要求,例如員工監控,并清楚地了解其人工智能供應商如何存儲和刪除數據以及如何監管其使用。

9.使用或實施大語言模型解決方案

使用大型語言模型解決方案需要考慮特定的風險和控制措施。OWASP清單列出了諸如訪問控制、訓練管道安全、映射數據工作流以及了解大型語言模型模型和供應鏈中存在的或潛在的漏洞等項目。此外,還需要對供應商進行第三方審計、滲透測試甚至代碼審查,這些工作既要初始進行,也要持續進行。

10.測試、評估、驗證和確認(TEVV)

TEVV流程是NIST在其人工智能框架中特別推薦的流程。這涉及在整個人工智能模型生命周期中建立持續的測試、評估、驗證和驗證,以及提供有關人工智能模型功能、安全性和可靠性的執行指標。

11.模型卡和風險卡

為了合乎道德地部署大語言模型,OWASP清單要求企業使用模型和風險卡,這些卡可用于讓用戶理解和信任人工智能系統,并公開解決偏見和隱私等潛在的負面后果。

這些卡片可以包含模型詳細信息、架構、訓練數據方法和性能指標等項目。還強調考慮負責任的人工智能所需要考慮的因素以及對公平和透明度的關注。

12RAG:大語言模型優化

檢索增強生成(RAG)是一種優化大語言模型從特定來源檢索相關數據能力的方法。它是優化預訓練模型或根據新數據重新訓練現有模型提高性能的方法之一。OWASP建議企業實施RAG,以最大限度地提高大語言模型的價值和有效性。

13.AI紅隊

最后,OWASP清單強調了人工智能紅隊的重要性,后者模擬人工智能系統的對抗性攻擊,以識別漏洞并驗證現有的控制和防御。OWASP強調,紅隊應該是生成式人工智能和大語言模型的綜合安全解決方案不可或缺的一部分。

值得注意的是,企業還需要清楚地了解外部生成式人工智能和大語言模型供應商的紅隊服務和系統要求與能力,以避免違反政策,甚至陷入法律麻煩。