阿里開源的32B大模型到底強在哪里?

阿里巴巴最近開源了一個320億參數的大語言模型Qwen1.5-32B,網上都說很強很強,那么它到底強在哪里呢?

更高的性價比

Qwen1.5-32B中的B是billion的意思,也就是10億,32B就代表320億參數量。

阿里之前還開源過一個大模型Qwen-1.5-72B,72B就代表720億參數量。

相比之前開源的Qwen-1.5-72B,Qwen1.5-32B參數少了一多半,但是測試表現并沒有相差多少。

大語言模型文件中的主要內容就是參數,參數少了一半,模型的文件大小也會小一半,那么加載到顯存時占用的空間也會小一半。大家可能都知道現在顯卡比較緊俏,我特地到京東查了一下,消費級的3090在8K左右,4090已經飆升到了1.5個W左右。

圖片

圖片

顯存占用小一半就可以使用更少數量的顯卡或者更低顯存的顯卡,這無疑會節省很多成本,而且模型的表現相比之前的大塊頭也沒有多少明顯的損失,所以用戶能獲得更高的性價比。

性能測試優良

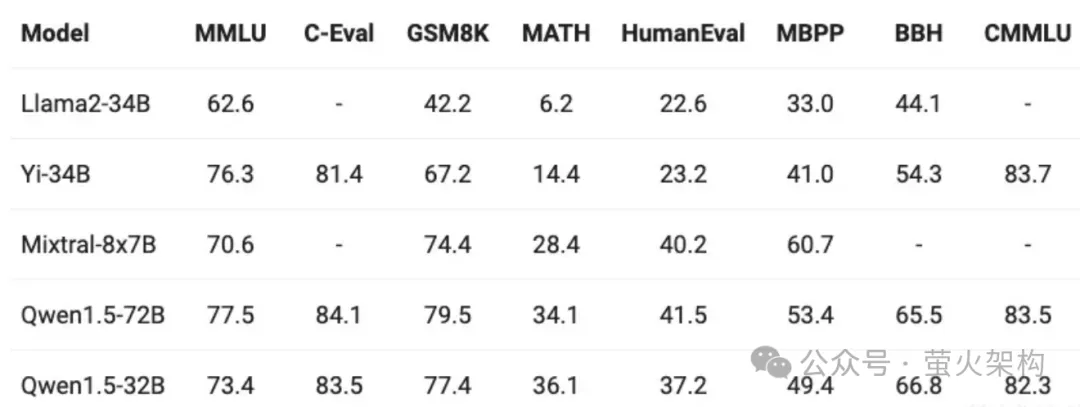

上邊提到Qwen1.5-32B的性能測試表現還不錯,那么這個不錯到底表現在哪里呢?

這里我找到一張測試結果的圖表:

圖片

圖片

之前我看這些圖表時都比較懵逼,主要就看誰的分數高,分高就是好,但是具體好在哪里也說不清楚。

這次我特地去查詢了這些指標代表的含義,總算是搞明白了,特別分享給大家。

這些分數對應的每一列都是一個數據集,所謂數據集就是一些問題的集合,用它們來考察大模型應對各種問題的處理能力。這些數據集通常是知名大語言模型研究機構發布的,比較權威。

- MMLU(Massive Multitask Language Understanding): 多領域知識理解,考察的是綜合能力。涵蓋57個不同領域的多項選擇題,包括歷史、文學、科學、工程技術等多個學科。使用這個數據集能評估模型的泛化能力,就是用它解決沒有訓練過的問題,或者說新問題,看看它的表現如何。

- CMMLU: 中文場景的多領域知識理解。由MBZUAI、上海交通大學、微軟亞洲研究院共同推出,包含67個主題,涉及自然科學、社會科學、工程、人文以及常識等,專門用于評估語言模型在中文語境下的知識和推理能力。

- C-Eval: 中文能力評估。由上海交通大學、清華大學和愛丁堡大學的研究人員在2023年5月聯合推出。包含13948個多項選擇題,涵蓋了52個不同的學科和四個難度級別。

- GSM8K (Google's Standard Math Dataset 8K): 解決數學問題的能力。Google開發的一個數學問題求解數據集,包含大約8,000個高中到大學水平的數學問題。

- MATH: 解決數學問題的能力,類似于GSM8K。包含初等代數,代數,數論,計數和概率,幾何,中等代數和微積分等領域的多種數學問題,用LaTeX格式編寫。

- MBPP (Mathematics Benchmarks for Pretrained Models): 數學推理和問題解決能力。包含一系列需要模型生成數學表達式或文字解答的數學問題。

- HumanEval: 編程能力。由OpenAI創建,專為評估代碼生成模型的有效性。包含數百個編程題目及其解決方案。

- BBH (Big-Bench Hard): 復雜語言理解能力。由Google、斯坦福等研究人員開發的數據集,包含大量復雜語言理解任務的集合,可能包含需要深度推理、常識運用或復雜認知技能的任務。

有了對這幾個指標的理解,我們可以看到Qwen1.5-32B和Qwen1.5-72B的能力相差無幾,在理解復雜語言的能力上還略勝一籌,不知道是不是學習了百度弱智吧的問題。

在這個對比圖表上還有幾個模型,我特別介紹下:

- Llama2-34B:Llama是Meta公司(也就是facebook)開源的一個大預言模型,有了Llama的開源,才有了國內大模型的百花齊放,否則大家還得摸索一陣。不過從這張圖表上可以看出,Llama的這個模型已經落后了,普遍落后于其他模型,真是青出于藍而勝于藍。

- Yi-34B:這個據稱是自研成功的開源大語言模型,也是在Llama開源后推出的,自然是借鑒了Llama,只不過不清楚借鑒了多少。這個模型是李開復老師投資的零一萬物開發出來的,也是300多億的參數,綜合能力還不錯,只是數學能力和解決復雜問題的能力比Qwen差一點。

- Mixtral-8x7B:一款高質量的稀疏專家混合模型,是一個歐洲公司開發的。這里的混合模型說的是其內部有多個子模型,比如有的擅長數學,有的擅長法語,有的擅長代碼生成,等等。在生成Token時,Mixtral-8x7B會選擇兩個內部的專家子模型進行生成,每個專家子模型的參數是6B,所以它會比普通的300億參數處理的更快。從圖表對比可以看出其在數學和編程方面的能力還是挺不錯的。

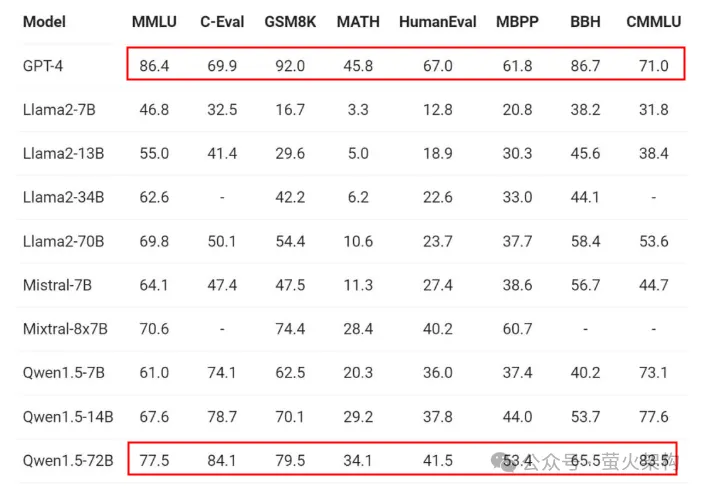

很多同學對國內大語言模型與GPT的差距也比較關心,我找到了一個Qwen1.5-72B和GPT-4的能力對比圖,如下所示,可以看到差距還是很明顯的,在數學、編程、復雜問題處理等方面都有著很大的提升空間。當然我們一直在追趕,只是別人也在進步,有人說這個差距是1年,也有人說是2年,你怎么看呢?

圖片

圖片

實測體驗

指標上的表現并不能代表全部,我們用最近熱議的“弱智吧”問題來測試一下。

“弱智吧”是一個百度貼吧,里邊充滿荒謬、離奇、不合常理的發言,研究者發現使用這里邊的問題訓練大語言模型能獲得比較好的邏輯能力。

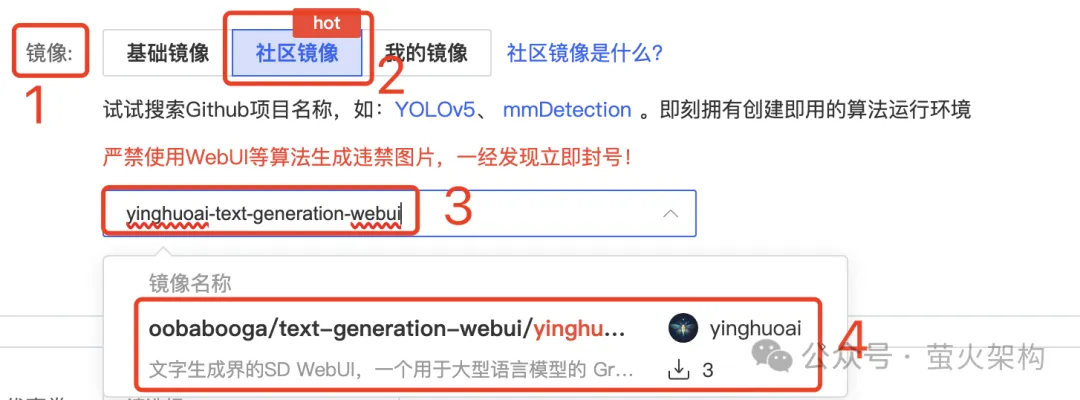

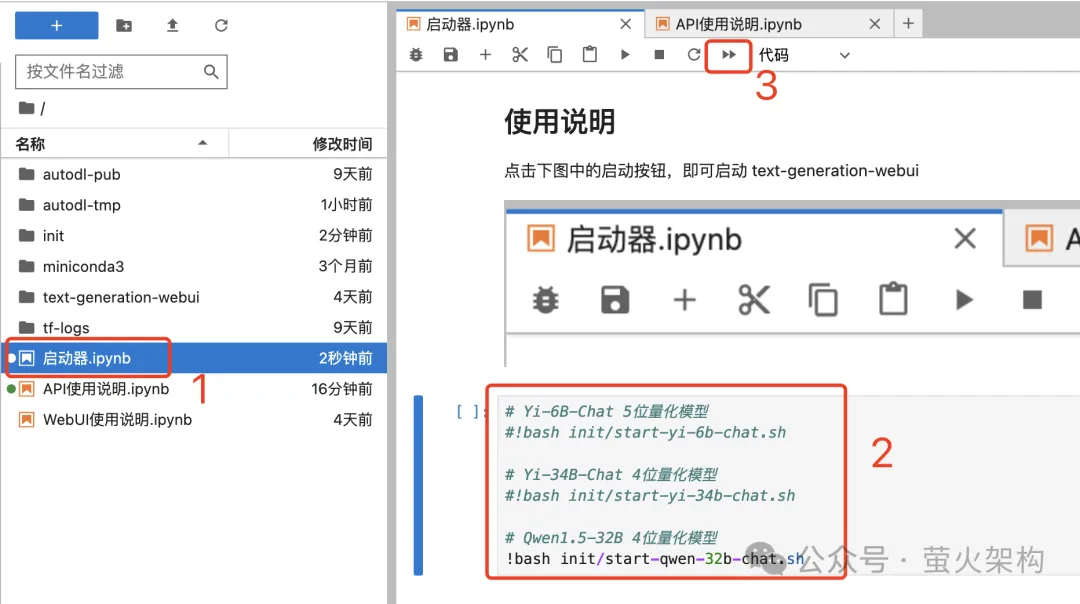

這里使用的工具是我在AutoDL上分享的一個鏡像實例,這個鏡像基于開源項目 text-generation webui,在這個webui中可以體驗多種大語言模型。

創建實例

如果你也想實際測試一下,可以按照下面的步驟創建一個容器實例。

首先注冊一個賬號,AutoDL的訪問地址:https://www.autodl.com

創建實例時:地區選擇“西北B區”,網絡比較穩定;因為鏡像安裝的大模型需要24G顯存,所以顯卡需要選擇3090或者4090;GPU數量只需要1個就能跑起來。

圖片

圖片

鏡像選擇“社區鏡像”,輸入 yinghuoai-text-generation-webui ,即可找到這個鏡像。

圖片

圖片

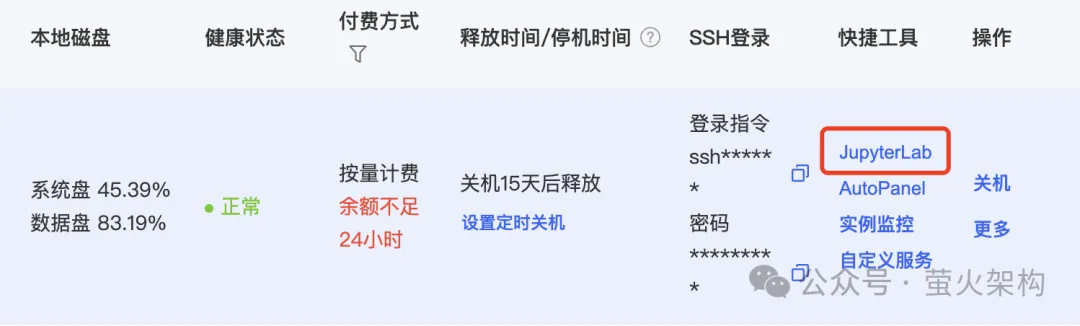

實例啟動后,在服務器實例列表中點擊“JupyterLab”,進入一個Web頁面。

圖片

圖片

在JupyterLab頁面中打開“啟動器”,這個鏡像會安裝3個大模型,默認啟動的是Qwen-32B,這實際上是一個4bit的量化模型,只需要24G的顯存就能跑起來,但是相比原版的32B性能略有下降,不過也夠用了。原版的32B需要數倍的顯存,AutoDL上跑起來成本太高。

圖片

圖片

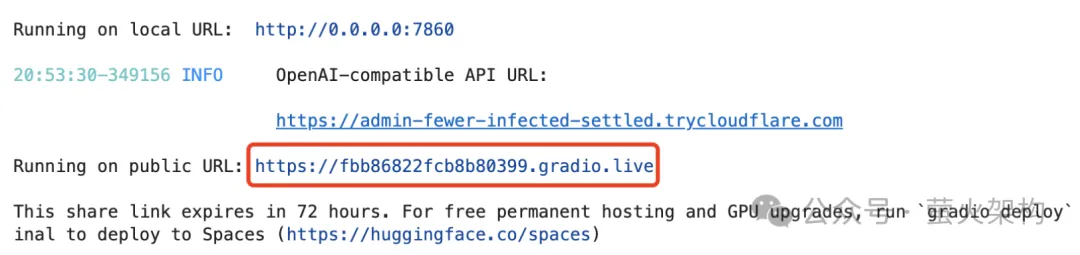

啟動成功后,我們可以看到一個Gradio的鏈接,點擊就會在瀏覽器打開 text-generation-webui。

圖片

圖片

另外 text-generation-webui 還支持通過API訪問大模型,API定義兼容OpenAI協議,有興趣的可以體驗下。

體驗Qwen-32B

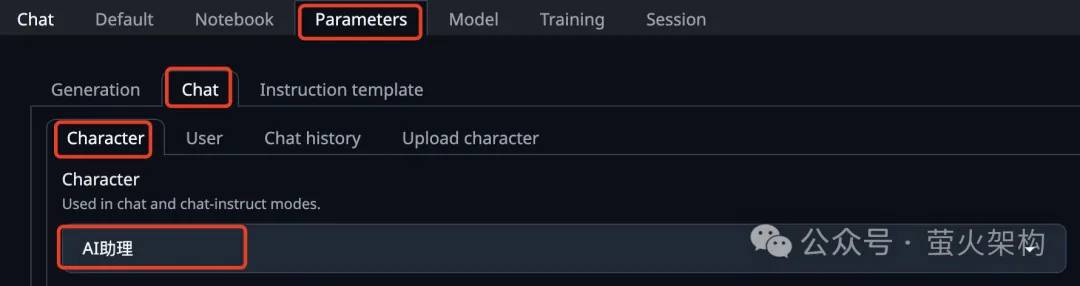

進入后需要先設置一下角色,在參數(Parameters)頁簽中,選擇“AI助理”。這個AI助理是我創建的,方便進行中文對話。

圖片

圖片

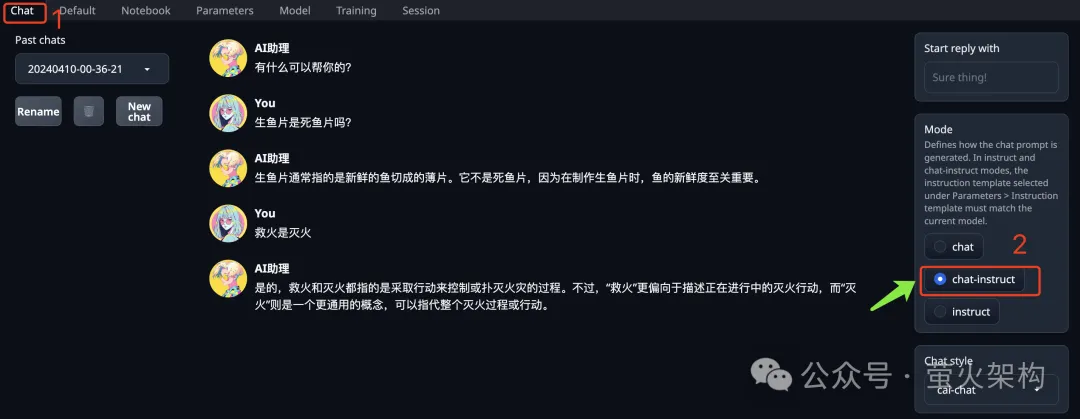

在聊天(Chat)頁簽的右側,有一個“Mode”,定義了大模型處理提示詞的模式,需要選擇“chat-instruct”。

圖片

圖片

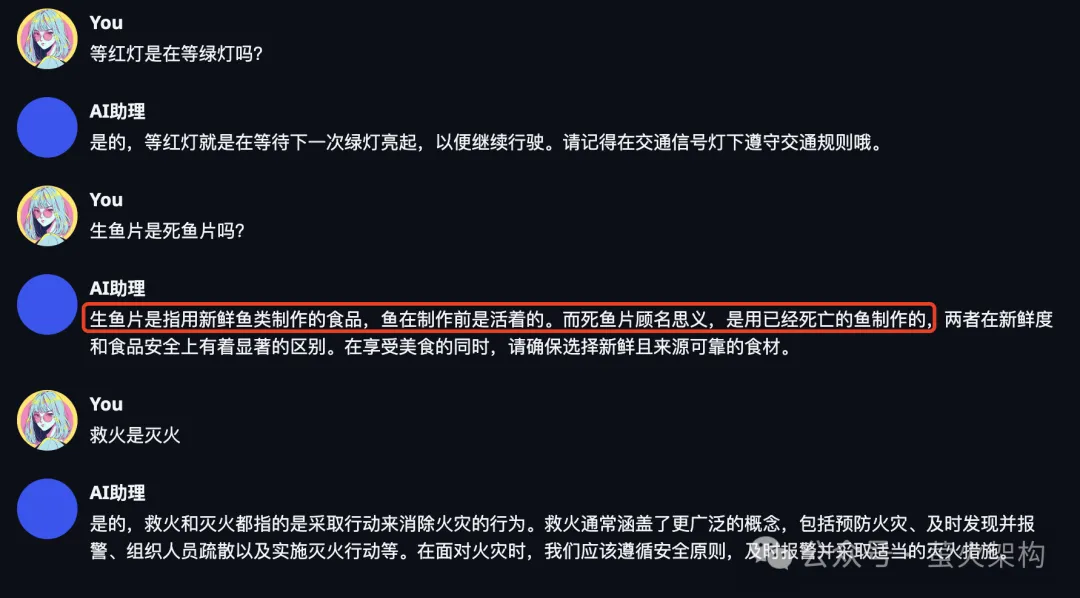

然后我們就可以和它聊天了,如下是弱智吧的3個經典問題。可以看到,只有“生魚片是死魚片”這個問題回答的不太好,大模型好像不太能理解生魚片的生到底是什么意思。

圖片

圖片

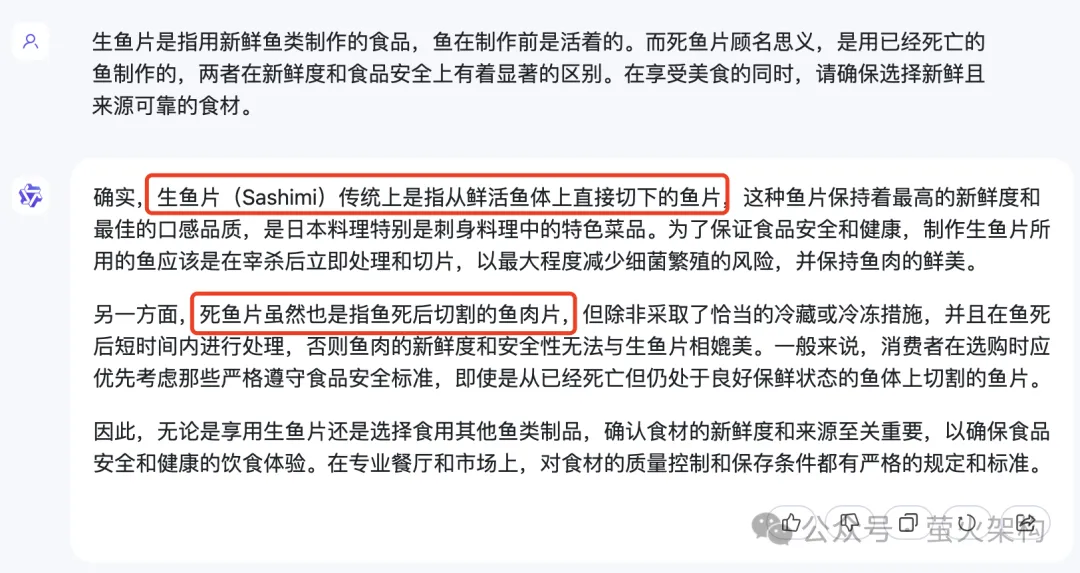

正常應該怎么回答呢?我先到阿里的“通義千問”上問了一下,感覺也沒太能回答到點上,畢竟師出同門,訓練用的語料應該都差不多。

圖片

圖片

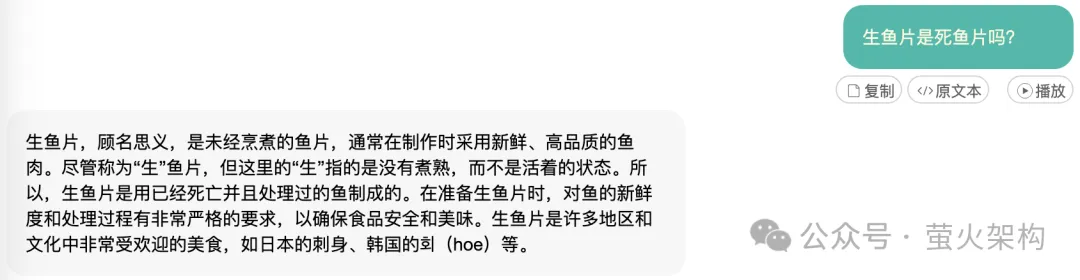

然后我又找了一個GPT-4的應用問了一下。GPT-4倒是準確把握住了“生”和“死”的含義,只是它回答的不是那么直接,大家看圖片中的內容吧。

圖片

圖片

在測試數據集的評測中,Qwen1.5-32B的中文處理能力是明顯高于GPT-4的,但是“生魚片是死魚片”這個問題的確沒有回答好,這是模型的泛化能力不足,還是訓練語料的問題呢?對于這個問題,你怎么看?

模型下載

Huggingface:

Huggingface鏡像站:

AI快站: