『拯救』開放異構場景 | HEAL:最新可擴展協作感知框架

本文經自動駕駛之心公眾號授權轉載,轉載請聯系出處。

協同感知技術能夠有效解決自動駕駛車輛單體感知中存在的障礙物遮擋、視角受限、以及遠距離感知能力弱等問題。然而,現有的工作都做了一個過分簡單的假設,即參與協作的智能體使用相同的傳感器,部署相同的感知模型。在現實情況下,發生協作的智能體極有可能異構的,并且傳感器模態和感知模型的類別將不斷增加。新出現的異構智能體的模態和模型會和已有的智能體存在顯著的域差異(domain gap),難以實現協作。

為了解決這一實際挑戰,ICLR 2024的最新研究文章 《An Extensible Framework for Open Heterogeneous Collaborative Perception》定義了開放異構協作感知問題(Open Heterogeneous Collaborative Perception):如何將不斷出現的新異構智能體類型加入已有協作感知系統,同時確保高感知性能和低加入成本?來自上海交通大學、南加州大學和上海人工智能實驗室的研究者們在本文中提出了HEAL(HEterogeneous ALliance):一種可擴展的異構智能體協作框架,有效解決了開放異構協作感知問題的兩大痛點。

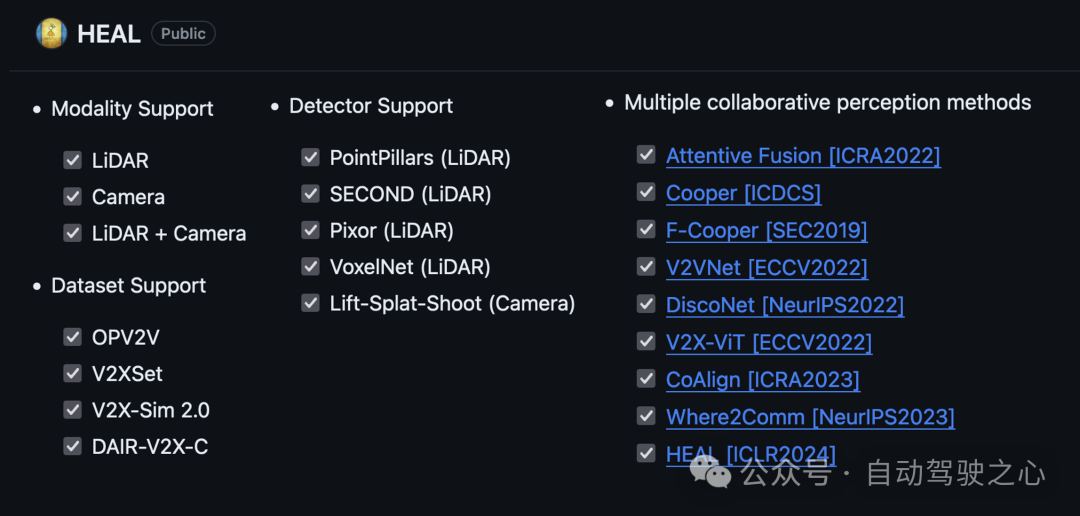

同時,他們搭建了一個集成了多個協作感知數據集、多個協作感知算法、支持多模態的代碼框架,目前已經跟隨HEAL完全開源。論文作者表示這是當前最完整的協作感知代碼框架,相信能讓更多人快速上手多模態、異構的協作感知研究。

- 論文鏈接:https://arxiv.org/abs/2401.13964

- 代碼鏈接:https://github.com/yifanlu0227/HEAL

研究背景和意義

近年來,自動駕駛領域在學術界和工業界都受到了極大的關注。但真實世界中道路情況復雜多變,加上單車傳感器可能被周圍車輛遮擋,給單車的自動駕駛感知帶來極大挑戰(如下圖)。多智能體之間的協作感知為單體感知存在的這些問題提供了解決方案。隨著通信技術的發展,多個智能體之間可以利用通信共享彼此的感知信息,結合自身傳感器信息與其他智能體的信息,對周圍環境進行感知。通過智能體之間的協作,每個智能體可以獲取自身視野盲區與可視距離以外的信息,有助于提升每個智能體的感知以及決策能力。

圖 1. 視線遮擋造成的“鬼探頭”問題,單車感知受限

在這一研究領域,大多數當前工作基于一個看似合理但過于簡化的假設:所有智能體必須是同構的;即所有智能體的感知系統都使用相同的傳感器,并共享相同的檢測模型。然而,在現實世界中,不同智能體的模態和模型很可能是異構的,且新的模態、模型可能會不斷出現。由于傳感器技術和算法的快速迭代,從一開始就確定所有參與協作的智能體類別(包括模態和模型)是不切實際的。當一個從未出現在訓練集中的異構智能體希望加入協作時,它不可避免地會遇到與現有智能體之間的域差異(domain gap)。這一差異將阻礙其與現有智能體進行特征融合的能力,并顯著限制了協作感知的可擴展性。

因此,開放異構協作感知問題隨之而生:如何將不斷出現的新智能體類型加入到現有的協作感知系統,同時確保高感知性能和低集成成本?

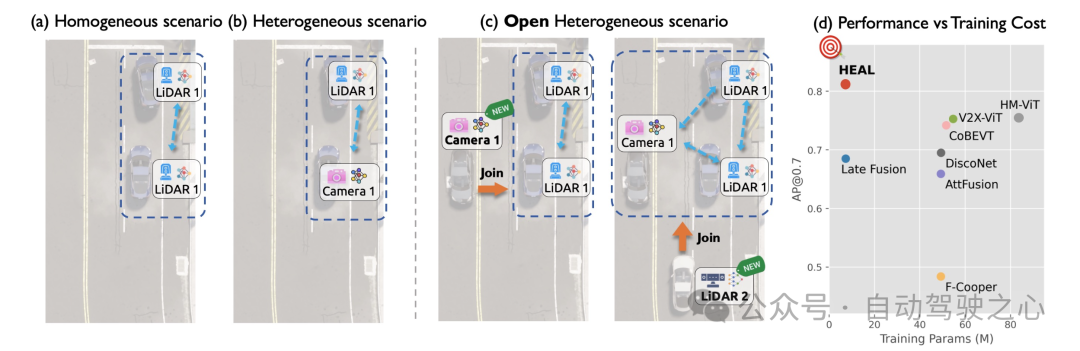

圖 2. (a) 同構協作感知 (b) 異構協作感知 (c) 考慮新異構智能體加入的開放異構協作感知 (d) HEAL在使用最少訓練成本的同時達到了最佳的協作感知性能

為了解決這個問題,一個可行的解決方案是后融合。通過融合每個智能體的感知輸出(如3D包圍框),后融合繞過了新智能體和現有智能體之間的異構性,且訓練只需要發生在單智能體類別上。然而,后融合的性能并不理想,并被證明特別容易受到定位噪聲和通信延遲等干擾因素等影響。另一種潛在的方法是完全集體培訓,它匯總了協作中的所有智能體類型進行協作訓練,以克服領域差異。然而,每次引入新的智能體類型時,這種方法都需要重新訓練所有模型。隨著新異構智能體的不斷出現,訓練的代價急劇上升。HEAL提出了一個全新的開放異構協作框架,同時具有完全集體訓練的高性能和后融合的低訓練成本。

問題定義

開放異構協作感知問題考慮如下場景:將具有先前未出現的模態或者模型的異構智能體類別加入到已有的協作系統中。不失一般性的,我們考慮場景初始由個同構的智能體組成,他們配備了相同類別的傳感器、部署了相同的檢測模型,并且都具有相互通信的能力。這些同構的智能體構成了一個已有的協作系統。隨后,場景中從未出現過的模態或感知模型的異構智能體加入到協作系統當中。這種動態特性是在現實世界中部署協作感知的一個顯著特征:智能體類別不會在開始時被完全確定,其類型數量可能會隨著時間的推移而增加。它與先前的異構協作感知問題(其中異構的類別是提前確定好并固定的)也截然不同。

方法介紹

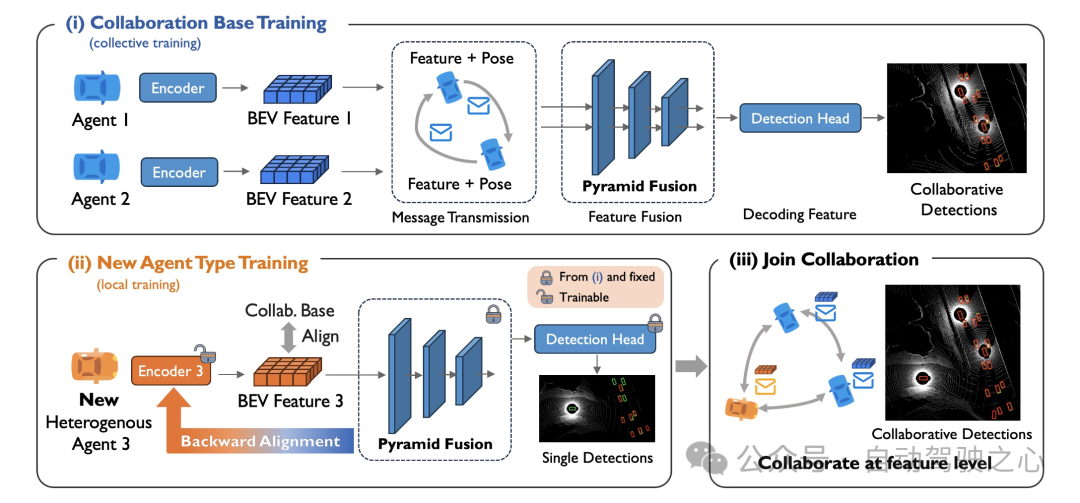

本文提出的開放異構協作感知框架HEAL(HEterogeneous ALliance),設計了兩階段的方法來將新的異構智能體加入到協作中,以實現不斷增長的異構聯盟:i)協作基類訓練,令初始智能體訓練一個特征融合協作網絡并創建統一的特征空間;ii)新智能體訓練,將新智能體的特征與之前建立的統一特征空間對齊,從而允許新智能體和已有智能體進行特征層面的協作。

對于每個新智能體類型加入協作,只需要第二階段的訓練。值得注意的是,第二階段的訓練可以由智能體所有者獨立進行,不涉及與已有智能體的集體訓練。這允許新智能體的加入有較低的訓練成本,同時還能保護新智能體的模型細節不被暴露。

圖 3. HEAL的整體框架

一階段:協作基類訓練

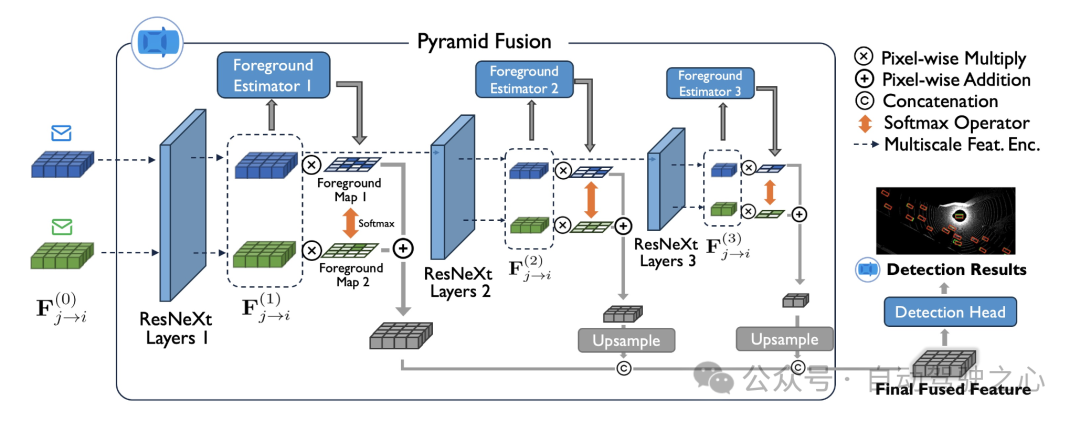

我們將場景中一開始存在的個同構智能體作為協作基類,并且訓練一個基于特征融合的協作感知網絡。我們提出一個新穎的金字塔融合網絡來提取并融合多智能體的特征,具體在于:對于每個同構智能體的編碼器編碼出來的BEV特征,我們讓他經過多層不同尺度的ResNeXt網絡,以提取粗粒度和細粒度的特征信息。對于不同尺度的特征圖,我們都對其應用前景預測器網絡,估計BEV每個特征位置存在車輛等前景的概率。在協作者之間,前景的概率圖會被歸一化,作為將特征圖逐像素加權融合的權重分布。獲得不同尺度下的融合特征圖以后,我們利用一系列上采樣網絡,將其轉化到相同的特征圖尺寸,并且得到最終融合的特征圖。

圖 4. 金字塔融合網絡

融合后的特征圖會經過一個檢測頭,轉為最終的協作檢測結果。協作檢測結果和前景的概率圖都受到ground-truth的監督。經過訓練后,協作網絡(金字塔融合網絡)的參數保存了協作基類的相關特征信息,構建了一個共享的特征空間,用于后續新異構智能體的對齊。

二階段:新智能體訓練

我們考慮加入一種新的異構智能體類型。我們提出一種新穎的后向對齊方法。核心想法是利用上一階段的金字塔融合網絡和檢測頭作為新智能體的檢測器后端,并僅更新前端編碼器相關的參數。

值得注意的是,我們對新的異構類別的單個智能體進行單體訓練,不涉及智能體之間的協作。因此,金字塔融合網絡的輸入是單張特征圖,而不是一階段中的多智能體特征圖。隨著預訓練的金字塔融合模塊和檢測頭被確立為后端和固定,訓練過程演變為讓前端編碼器適應后端的參數,從而使新智能體編碼的特征與統一特征空間保持一致。由于特征和已有智能體的特征對齊,他們能實現高性能的特征層面的協作。

后向對齊還顯示了一個獨特的優勢:訓練僅在新的單個智能體上進行。這大大降低了每次新智能體加入的訓練成本和時空同步的數據采集成本。此外,它防止新代理的模型細節暴露給他人,并允許新智能體的所有者使用自己的傳感器數據訓練模型。這將顯著解決汽車公司在部署車輛協作感知技術(V2V)時可能存在的許多顧慮。

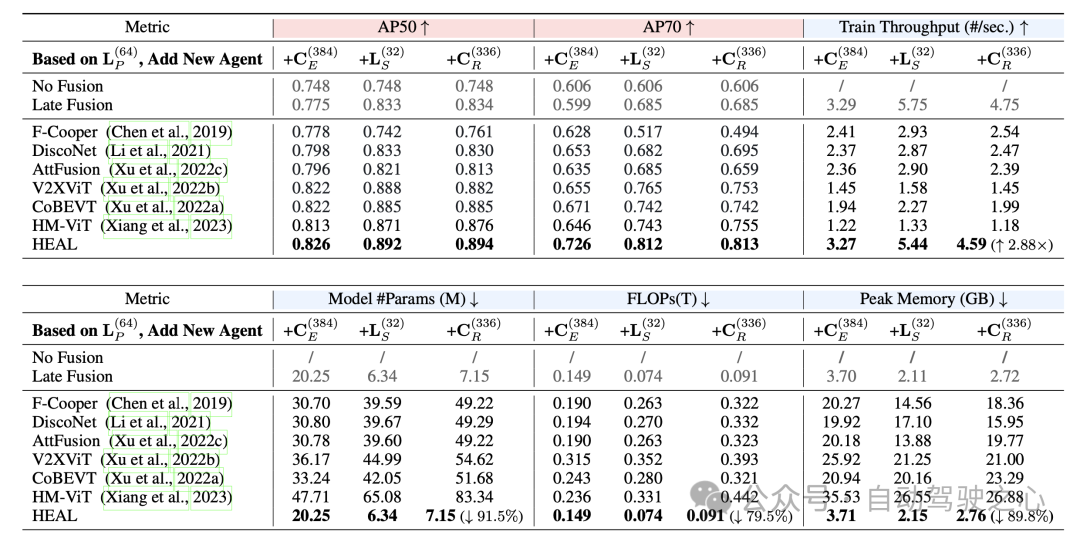

實驗結果

本文在OPV2V數據集的基礎上,提出了一個更加數據異構的OPV2V-H數據集,補充了每輛車輛16線和32線的激光雷達數據,以及4個深度攝像頭的數據。在OPV2V-H數據集和真實數據集DAIR-V2X上的實驗結果表明,HEAL顯著地降低了異構智能體加入協作的一系列訓練成本(訓練參數,FLOPs,訓練時間等等),還保持了極高的協作檢測性能。

圖 5. HEAL同時擁有高性能和低訓練成本

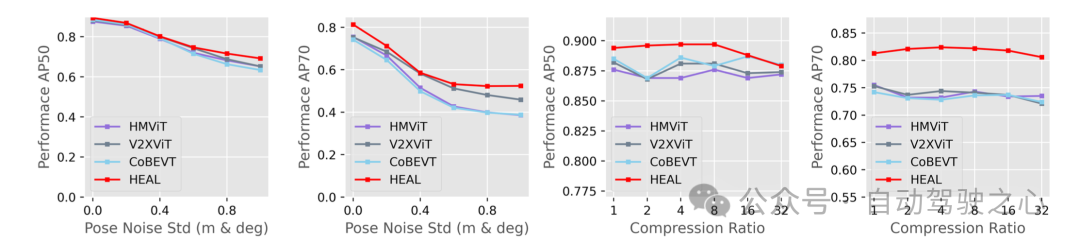

存在定位噪聲和特征壓縮的情況下,HEAL依然保持了最佳的檢測性能,展示了在更加接近現實的設定下,HEAL是目前最有效的協作感知算法。